Источники

погрешностей (инструментальные и

методические погрешности, влияние

помех, субъективные ошибки). Номинальная

и реальная функция преобразования,

абсолютная и относительная погрешность

средства измерений, основная и

дополнительная погрешности. Пределы

допускаемых погрешностей, классы

точности средств измерений. Выявление

и уменьшение систематических погрешностей.

Оценка случайных погрешностей.

Доверительный интервал и доверительная

вероятность. Оценка погрешностей

косвенных измерений. Обработка результатов

измерений. [1:

с.23…35,40,41,53,54,56…61; 2:

с.22…53; 3:

с.48…91; 4:

с.21,22,35…52,63…71, 72…77,85…93].

II.1. Основные сведения и методические указания.

Одним из

основополагающих понятий Метрологии

является понятие погрешности измерений.

Погрешностью

измерения

называют отклонение измеренного

значения физической

величины от её истинного значения.

Погрешность

измерений, в общем случае, может быть

вызвана следующими причинами:

-

Несовершенством

принципа действия и недостаточным

качеством элементов используемого

средства измерения. -

Несовершенством

метода измерений и влиянием используемого

средства измерения на саму измеряемую

величину, зависящим от способа

использования данного средства

измерения. -

Субъективными

ошибками экспериментатора.

Так как истинное

значение измеряемой величины никогда

неизвестно (в противном случае отпадает

необходимость в проведении измерений),

то численное значение погрешности

измерений может быть найдено только

приближенно. Наиболее близким к истинному

значению измеряемой величины является

значение, которое может быть получено

при использовании эталонных средств

измерений (средств измерений наивысшей

точности). Это значение условились

называть действительным

значением измеряемой величины.

Действительное значение также является

неточным, однако, из-за малой погрешности

эталонных средств измерений, погрешностью

определения действительного значения

пренебрегают.

Классификация

погрешностей

-

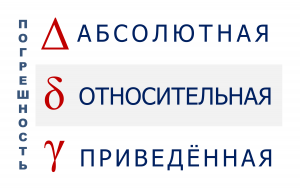

По форме представления

различают понятия абсолютной погрешности

измерений и относительной погрешности

измерений.

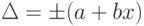

Абсолютной

погрешностью

измерений называют разность между

измеренным и

действительным значениями измеряемой

величины:

![]() ,

,

где ∆ — абсолютная

погрешность,

![]() –измеренное

–измеренное

значение,

![]() –действительное

–действительное

значение измеряемой величины.

Абсолютная

погрешность имеет размерность измеряемой

величины. Знак абсолютной погрешности

будет положительным, если измеренное

значение больше действительного, и

отрицательным в противном случае.

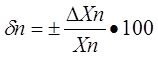

Относительной

погрешностью

называют отношение абсолютной

погрешности к

действительному значению измеряемой

величины:

![]()

где δ – относительная

погрешность.

Чаще всего

относительную погрешность определяют

приближенно в процентах от измеренного

значения:

![]()

Относительная

погрешность показывает, какую часть (в

%) от измеренного значения составляет

абсолютная погрешность. Относительная

погрешность позволяет нагляднее, чем

абсолютная погрешность, судить о точности

измеренного значения.

-

По источникам

происхождения погрешности подразделяют

на следующие виды:

— инструментальные

погрешности;

— методические

погрешности;

— субъективные

погрешности, допущенные экспериментатором

.

Инструментальными

называются погрешности, которые

принадлежат данному типу средств

измерения, могут быть определены при

их испытаниях и занесены в паспорт

средства измерения в виде пределов

допускаемых погрешностей.

Инструментальная

погрешность возникает из-за несовершенства

принципа действия и недостаточно

высокого качества элементов, применяемых

в конструкции средства измерений. По

этой причине реальная передаточная

характеристика каждого экземпляра

средства измерений в большей или меньшей

степени отличается от номинальной

(расчетной) передаточной характеристики.

Отличие реальной характеристики средства

измерений от номинальной (рис.1) определяет

величину инструментальной погрешности

средства измерений.

Рис.1. Иллюстрация

к определению понятия инструментальной

погрешности.

Здесь: 1 – номинальная

характеристика средства измерений;

2 – реальная

характеристика средства измерений.

Как видно из рис.1,

при изменении измеряемой величины,

инструментальная погрешность может

иметь различные значения (как положительные,

так и отрицательные).

При создании

средств измерений какой-либо физической

величины, к сожалению, не удается

полностью избавиться от реакции этого

средства измерений на изменение других

(не измеряемых) величин. Наряду с

чувствительностью средства измерения

к измеряемой величине, оно всегда

реагирует (хотя и существенно в меньшей

степени) на изменение условий эксплуатации.

По этой причине инструментальную

погрешность подразделяют на основную

погрешность и дополнительную

погрешности.

Основной

погрешностью

называют погрешность, имеющую место

в случае применения

средства измерений в нормальных условиях

эксплуатации.

Номенклатура

влияющих на средство измерений величин

и диапазоны их изменений определяются

разработчиками в качестве нормальных

условий для каждого типа средств

измерений. Нормальные условия эксплуатации

всегда указываются в техническом

паспорте средства измерений. Если

эксперимент выполняется в условиях,

отличных от нормальных для данного

средства измерений, его реальная

характеристика искажается сильнее, чем

в нормальных условиях. Погрешности,

которые при этом возникают, называют

дополнительными.

Дополнительной

погрешностью

называют погрешность средств

измерений, которая

возникает в условиях, отличающихся от

нормальных, но

входящих в допустимую рабочую область

условий

эксплуатации.

Рабочие условия

эксплуатации, так же как и нормальные,

в обязательном порядке приводятся в

техническом паспорте средств измерений.

Инструментальная

погрешность средств измерений

определенного типа не должна превышать

некоторого заданного значения – так

называемой предельно допустимой основной

погрешности средств измерений данного

типа. Фактическая основная погрешность

каждого конкретного экземпляра этого

типа является при этом случайной

величиной и может принимать различные

значения, иногда даже равные нулю, но в

любом случае инструментальная погрешность

не должна превышать заданного предельного

значения. Если это условие не выполняется,

средство измерений должно быть изъято

из обращения.

Методическими

называются погрешности, которые возникают

из-за неудачного выбора экспериментатором

средства измерения для решения

поставленной задачи. Они не могут быть

приписаны средству измерения и приведены

в его паспорте.

Методические

погрешности измерения зависят как от

характеристик применяемого средства

измерений, так и во многом от параметров

самого объекта измерения. Неудачно

выбранные средства измерений могут

исказить состояние объекта измерений.

При этом методическая составляющая

погрешности может оказаться существенно

больше инструментальной.

Субъективными

погрешностями

называют погрешности,

допускаемые

самим экспериментатором при проведении

измерений.

Этот тип погрешностей

связан обычно с невнимательностью

экспериментатора: применение прибора

без устранения смещения нуля, неправильное

определение цены деления шкалы, неточный

отсчет доли деления, ошибки в подключении

и т.п.

-

По характеру

проявления погрешности измерений

подразделяют на:

— систематические

погрешности;

— случайные

погрешности;

— промахи (грубые

ошибки).

Систематической

называют погрешность, которая при

повторных измерениях одной и той же

величины остается постоянной, или

изменяется закономерно.

Систематические

погрешности обусловлены как несовершенством

метода измерений и влиянием средства

измерений на измеряемый объект, так и

отклонением реальной передаточной

характеристики применяемого средства

измерений от номинальной характеристики.

Постоянные

систематические погрешности средств

измерений могут быть выявлены и численно

определены в результате сличения их

показаний с показаниями эталонных

средств измерений. Такие систематические

погрешности могут быть уменьшены

регулировкой приборов или введением

соответствующих поправок. Следует

заметить, что полностью исключить

систематические погрешности средств

измерений не удается, так как их реальные

передаточные характеристики изменяются

при изменении условий эксплуатации.

Кроме этого всегда имеют место так

называемые прогрессирующие погрешности

(возрастающие или убывающие), вызванные

старением элементов входящих в состав

средств измерений. Прогрессирующие

погрешности могут быть скорректированы

регулировкой или введением поправок

лишь на некоторое время.

Таким образом,

даже после регулировки или введения

поправок, всегда имеет место так

называемая неисключенная систематическая

погрешность результата измерений.

Случайной

называют погрешность, которая при

повторных измерениях одной и той же

величины принимает различные значения.

Случайные погрешности

обусловлены хаотичным характером

изменений физических величин (помех),

влияющих на передаточную характеристику

средства измерений, суммированием помех

с измеряемой величиной, а также наличием

собственных шумов средства измерений.

При создании средств измерений

предусматриваются специальные меры

защиты от помех: экранирование входных

цепей, использование фильтров, применение

стабилизированных источников питающего

напряжения и т.д. Это позволяет уменьшить

величину случайных погрешностей при

проведении измерений. Как правило, при

повторных измерениях одной и той же

величины результаты измерений либо

совпадают, либо отличаются на одну, две

единицы младшего разряда. В такой

ситуации случайной погрешностью

пренебрегают и оценивают только величину

неисключенной систематической

погрешности.

Наиболее сильно

случайные погрешности проявляются при

измерении малых значений физических

величин. Для повышения точности в таких

случаях производятся многократные

измерения с последующей статистической

обработкой результатов методами теории

вероятности и математической статистики.

Промахами

называют грубые погрешности, существенно

превышающие ожидаемые погрешности при

данных условиях проведения измерений.

Промахи большей

частью возникают из-за субъективных

ошибок экспериментатора или из-за сбоев

в работе средства измерений при резких

изменениях условий эксплуатации (броски

или провалы сетевого напряжения, грозовые

разряды и т.п.) Обычно промахи легко

выявляются при повторных измерениях и

исключаются из рассмотрения.

Оценка погрешностей

косвенных измерений.

При косвенных

измерениях результат измерений

определяется по функциоральной

зависимости от результатов прямых

измерений. Поэтому погрешность косвенных

измерений определяется как полный

дифференциал этой функции от величин,

измеряемых с помощью прямых измерений.

![]() ;

;

![]()

![]()

Где:

![]() —

—

предельные абсолютные погрешности

результатов прямых

измерений;

![]() —

—

предельная абсолютная погрешность

результата косвенного

измерения;

![]() —

—

соответствующие предельные относительные

погрешности.

![]() —

—

функциональная связь между искомой

измеряемой величиной и

величинами,

подвергающимися прямым измерениям.

Статистическая

обработка результатов измерений

Из-за влияния на

средство измерений помех различного

происхождения (изменение температуры

окружающей среды, электромагнитных

полей, вибраций, изменения частоты и

амплитуды сетевого напряжения, изменения

атмосферного давления, влажности и

т.д.), а также из-за наличия собственных

шумов элементов, входящих в состав

измерительных приборов, результаты

повторных измерений одной и той же

физической величины (особенно ее малых

значений) будут в большей или меньшей

степени отличаться друг от друга. В этом

случае результат измерений является

случайной величиной, которая характеризуется

наиболее вероятным значением и разбросом

(рассеянием) результатов повторных

измерений вблизи наиболее вероятного

значения. Если при повторных измерениях

одной и той же величины результаты

измерений не отличаются друг от друга,

то это означает, что разрешающая

способность отсчетного устройства не

позволяет обнаружить это явление. В

этом случае случайная составляющая

погрешности измерений является

несущественной и ею можно пренебречь.

При этом неисключенную систематическую

погрешность результата измерений

оценивают по величине пределов допускаемых

погрешностей применяемых средств

измерений. Если же при повторных

измерениях одной и той же величины

наблюдается разброс показаний, то это

означает, что наряду с большей или

меньшей неисключенной систематической

погрешностью, имеет место и случайная

погрешность, принимающая при повторных

измерениях различные значения.

Для определения

наиболее вероятного значения измеряемой

величины при наличии случайных

погрешностей и для оценки погрешности,

с которой определено это наиболее

вероятное значение, применяется

статистическая обработка результатов

измерений. Статистическая обработка

результатов серии измерений при

проведении экспериментов позволяет

решить следующие задачи.

-

Более точно

определить результат измерения путем

усреднения отдельных наблюдений. -

Оценить область

неопределенности уточненного результата

измерений.

Основной смысл

усреднения результатов измерений

заключается в том, что найденная

усредненная оценка имеет меньшую

случайную погрешность, чем отдельные

результаты, по которым эта усредненная

оценка определяется. Следовательно

усреднение не устраняет полностью

случайного характера усредненного

результата, а лишь уменьшает ширину

полосы его неопределенности.

Таким образом, при

статистической обработке, прежде всего,

определяют наиболее вероятное значение

измеряемой величины путем вычисления

среднего арифметического всех отсчетов:

![]()

где: xi

– результат i

– го измерения;

n

– число проведенных измерений в данной

серии измерений.

После этого

оценивают отклонение результатов

отдельных измерений xi

от этой оценки среднего значения

![]() ;

;![]() .

.

Затем находят

оценку среднеквадратического отклонения

![]() наблюдений, характеризующую степень

наблюдений, характеризующую степень

рассеяния результатов отдельных

наблюдений вблизи![]() ,

,

по формуле:

![]() .

.

Точность оценки

наиболее вероятного значения измеряемой

величины

![]() зависит от числа наблюдений

зависит от числа наблюдений![]() .

.

Нетрудно убедиться в том, что результаты

нескольких оценок![]() по одному и тому же числу

по одному и тому же числу![]() отдельных измерений будут отличаться.

отдельных измерений будут отличаться.

Таким образом, сама оценка![]() также является случайной величиной. В

также является случайной величиной. В

связи с этим вычисляется оценка

среднеквадратического отклонения

результата измерения![]() ,

,

которую обозначают![]() .

.

Эта оценка характеризует степень

разброса значений![]() по отношению к истинному значению

по отношению к истинному значению

результата, т.е. характеризует точность

результата, полученного усреднением

результата многократных измерений.

Следовательно, по![]() может быть оценена систематическая

может быть оценена систематическая

составляющая результата серии измерений.

Для различных![]() она определяется по формуле:

она определяется по формуле:

![]()

Следовательно,

точность результата многократных

измерений увеличивается с ростом числа

последних.

Однако в большинстве

практических случаев нам важно определить

не просто степень рассеивания значения

погрешности при проведении серии

измерений (т.е. величину

![]() ),

),

а оценить вероятность возникновения

погрешности измерения, не превышающую

допустимую, т.е. не выходящую за пределы

некоторого заданного интервала разброса

получаемых погрешностей.

Доверительным

интервалом

![]()

![]() называют

называют

интервал, который с заданной вероятностью,

называемой

доверительной вероятностью

![]() накрывает истинное значение измеряемой

накрывает истинное значение измеряемой

величины.

При определении

доверительных интервалов необходимо,

прежде всего, учитывать, что закон

распределения погрешностей, получаемых

при проведении многократных измерений,

при числе измерений в серии меньше 30,

описывается не нормальным законом

распределения, а так называемым законом

распределения Стьюдента. И, в этих

случаях, величину доверительного

интервала обычно оценивают по формуле:

![]() ,

,

где

![]() — так называемый коэффициент Стьюдента.

— так называемый коэффициент Стьюдента.

В табл.4.1 приведены

значения коэффициентов Стьюдента

![]() в зависимости от заданной доверительной

в зависимости от заданной доверительной

вероятности и числа проведенных

наблюдений![]() .

.

При выполнении измерений обычно задаются

доверительной вероятностью 0,95 или 0,99.

Таблица 4.1

Значения

коэффициентов Стьюдента

![]() .

.

-

n

0,5

0,6

0,7

0,8

0,9

0,95

0,98

0,99

2

1,00

1,38

1,96

3,08

6,31

12,71

31,82

63,66

3

0,82

1,06

1,34

1,89

2,92

4,30

6,97

9,93

4

0,77

0,98

1,25

1,64

2,35

3,18

4,54

5,84

5

0,74

0,94

1,19

1,53

2,13

2,78

3,75

4,60

6

0,73

0,92

1,16

1,48

2,02

2,62

3,37

4,03

7

0,72

0,91

1,13

1,44

1,94

2,45

3,14

3,71

8

0,71

0,90

1,12

1,42

1,90

2,37

3,00

3,50

9

0,71

0,89

1,11

1,40

1,86

2,31

2,90

3,36

10

0,70

0,88

1,10

1,38

1,83

2,26

2,82

3,25

16

0,69

0,87

1,07

1,34

1,75

2,13

2,60

2,95

25

0,69

0,86

1,06

1,32

1,71

2,06

2,49

2,80

При изучении

материалов данного раздела следует

хорошо уяснить, что погрешности

результатов измерений и погрешности

средств измерений – не идентичные

понятия. Погрешность средства измерения

это его свойство, характеристика, для

описания которого используют ряд правил,

закрепленных в стандартах и нормативных

документах. Это та доля погрешности

измерения, которая определяется только

самим средством измерения. Погрешность

же измерений (результата измерений) –

это число, которое характеризует границы

неопределенности значения измеряемой

величины. В нее, кроме погрешности

средства измерений, могут входить

составляющие погрешности, порожденные

применяемым методом измерения

(методические погрешности), действием

влияющих (неизмеряемых) величин,

погрешность отсчета и др.

Нормирование

погрешностей средств измерения.

Точность СИ

определяется предельно-допустимыми

погрешностями, которые могут быть

получены при его использовании.

Нормированием

погрешностей средств измерений называют

процедуру

назначения допустимых границ основной

и

дополнительных

погрешностей, а также выбор формы

указания

этих границ

в нормативно-технической документации.

Пределы допускаемой

основной и дополнительных погрешностей

определяются разработчиками для каждого

типа средств измерений на стадии

подготовки производства. В зависимости

от назначения средства измерений и

характера изменения погрешности в

пределах диапазона измерений нормируется

для средств измерений различного типа

либо предельно-допустимое значение

основной абсолютной погрешности, либо

предельно-допустимое значение основной

приведенной погрешности, либо

предельно-допустимое значение основной

относительной погрешности.

Для каждого типа

средств измерений характер изменения

погрешности в пределах диапазона

измерений зависит от принципа действия

этого средства измерений и может быть

самым разнообразным. Однако, как показала

практика, среди этого многообразия

часто удается выделить три типовых

случая, предопределяющих выбор формы

представления пределов допускаемой

погрешности. Типовые варианты отклонения

реальных передаточных характеристик

средств измерений от номинальной

характеристики и соответствующие им

графики изменения предельных значений

абсолютной и относительной погрешностей

в зависимости от измеряемой величины

приведены на рис 2.

Если реальная

передаточная характеристика средства

измерений смещена по отношению к

номинальной (1-й график на рис.2а),

абсолютная погрешность, возникающая

при этом, (1-й график на рис.2б), не зависит

от измеряемой величины.

Составляющую

погрешности средства измерений, не

зависящую от измеряемой величины,

называют аддитивной

погрешностью.

Если угол наклона

реальной передаточной характеристики

средства измерений отличается от

номинального (2-й график на рис. 2а), то

абсолютная погрешность будет линейно

зависеть от измеряемой величины (2-й

график на рис. 2б).

Составляющую

погрешности средства измерений, линейно

зависящую от измеряемой величины,

называют мультипликативной

погрешностью.

Если реальная

передаточная характеристика средства

измерений смещена по отношению к

номинальной и угол ее наклона отличается

от номинального (3-й график на рис. 2а),

то в этом случае имеет место как

аддитивная, так и мультипликативная

погрешность.

Аддитивная

погрешность возникает из-за неточной

установки нулевого значения перед

началом измерений, ухода нуля в процессе

измерений, из-за наличия трений в опорах

измерительного механизма, из-за наличия

термо-эдс в контактных соединениях и

т.д.

Мультипликативная

погрешность возникает при изменении

коэффициентов усиления или ослабления

входных сигналов (например, при изменении

температуры окружающей среды, или

вследствие старения элементов), из-за

изменения значений, воспроизводимых

мерами, встроенными в измерительные

приборы, из-за изменений жесткости

пружин, создающих противодействующий

момент в электромеханических приборах

и т.д.

Ширина полосы

неопределенности значений абсолютной

(рис.2б) и относительной (рис.2в) погрешностей

характеризует разброс и изменение в

процессе эксплуатации индивидуальных

характеристик множества находящихся

в обращении средств измерений определенного

типа.

А) Нормирование

пределов допускаемой основной погрешности

для

средств

измерений с преобладающей аддитивной

погрешностью.

Для средств

измерений с преобладающей аддитивной

погрешностью (1-й график на рис.2) удобно

нормировать одним числом предельно-допустимое

значение абсолютной погрешности (∆max=

±а). В этом случае фактическая абсолютная

погрешность ∆ каждого экземпляра

средства измерений данного типа на

различных участках шкалы может иметь

различные значения, но не должна превышать

предельно-допустимой величины (∆ ≤

±а). В многопредельных измерительных

приборах с преобладающей аддитивной

погрешностью для каждого предела

измерений пришлось бы указывать свое

значение предельно допустимой абсолютной

погрешности. К сожалению, как видно из

1-го графика на рис.2в, нормировать одним

числом предел допускаемой относительной

погрешности в различных точках шкалы

не представляется возможным. По этой

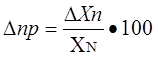

причине для средств измерений с

преобладающей аддитивной погрешностью

часто нормируют одним числом значение

так называемой основной приведенной

относительной

погрешности

![]() ,

,

где XN

– нормирующее значение.

Таким способом,

например, нормируются погрешности

большинства электромеханических и

электронных приборов со стрелочными

индикаторами. В качестве нормирующего

значения XN

обычно используется предел измерений

(XN

= Xmax),

удвоенное значение предела измерений

(если нулевая отметка находится в

середине шкалы), или длина шкалы (для

приборов с неравномерной шкалой). Если

XN

= Xmax,

то значение приведенной погрешности γ

равно пределу допускаемой относительной

погрешности средства измерений в точке,

соответствующей пределу измерений. По

заданному значению предела допускаемой

основной приведенной погрешности легко

определить предел допускаемой основной

абсолютной погрешности для каждого

предела измерений многопредельного

прибора:![]()

![]() .

.

После этого для

любой отметки шкалы X

может быть произведена оценка

предельно-допустимой основной

относительной погрешности:

![]() .

.

Б) Нормирование

пределов допускаемой основной погрешности

для

средств измерений

с преобладающей мультипликативной

погрешностью.

Как видно из рис.2

(2-й график), для средств измерений с

преобладающей мультипликативной

погрешностью, одним числом удобно

нормировать предел допускаемой основной

относительной погрешности (рис.2в) δmax=

± b∙100%.

В этом случае, фактическая относительная

погрешность каждого экземпляра средства

измерений данного типа на различных

участках шкалы может иметь различные

значения, но не должна превышать предельно

допустимой величины (δ ≤ ± b∙100%).

По заданному значению предельно

допустимой относительной погрешности

δmax

для любой точки шкалы может быть

произведена оценка предельно-допустимой

абсолютной погрешности:

![]() .

.

К числу средств

измерений с преобладающей мультипликативной

погрешностью относится большинство

многозначных мер, счетчики электрической

энергии, счетчики воды, расходомеры и

др. Следует отметить, что для реальных

средств измерений с преобладающей

мультипликативной погрешностью не

удается полностью устранить аддитивную

погрешность. По этой причине в технической

документации всегда указывается

наименьшее значение измеряемой величины,

для которого предел допускаемой основной

относительной погрешности ещё не

превышает заданного значения δmax.

Ниже этого наименьшего значения

измеряемой величины погрешность

измерений не нормируется и является

неопределенной.

В) Нормирование

пределов допускаемой основной погрешности

для

средств измерений

с соизмеримой аддитивной и мультипликативной

погрешностью.

Если аддитивная

и мультипликативная составляющая

погрешности средства измерений соизмеримы

(3-й график на рис.2), то задание

предельно-допустимой погрешности одним

числом не представляется возможным. В

этом случае либо нормируется предел

допускаемой абсолютной основной

погрешности (указываются предельно-допустимые

значения a

и b),

либо (чаще всего) нормируется предел

допускаемой относительной основной

погрешности. В последнем случае численные

значения предельно-допустимых

относительных погрешностей в различных

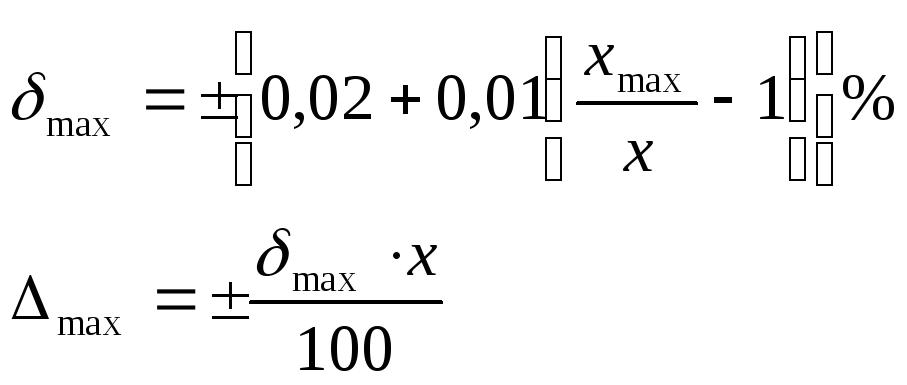

точках шкалы оцениваются по формуле:

,

,

где Xmax

– предел измерений;

X

— измеренное значение;

d

=

![]()

— значение приведенной к пределу измерений

аддитивной

составляющей основной погрешности;

с =

![]() — значение результирующей относительной

— значение результирующей относительной

основной

погрешности в точке, соответствующей

пределу

измерений.

Рассмотренным

выше способом (указанием численных

значений c

и d)

нормируются, в частности, предельно-допустимые

значения относительной основной

погрешности цифровых измерительных

приборов. В этом случае относительные

погрешности каждого экземпляра средств

измерений определенного типа не должны

превышать установленных для этого типа

средств измерений значений

предельно-допустимой погрешности:

.

.

При этом абсолютная

основная погрешность определяется по

формуле

![]() .

.

Г)

Нормирование дополнительных погрешностей.

Наиболее часто

пределы допускаемых дополнительных

погрешностей указывают в технической

документации либо одним значением для

всей рабочей области величины, влияющей

на точность средства измерений (иногда

несколькими значениями для поддиапазонов

рабочей области влияющей величины),

либо отношением предела допускаемой

дополнительной погрешности к интервалу

значений влияющей величины. Пределы

допускаемых дополнительных погрешностей

указываются на каждой , влияющей на

точность средства измерений величине.

При этом, как правило, значения

дополнительных погрешностей устанавливают

в виде дольного или кратного значения

предела допускаемой основной погрешности.

Например, в документации может быть

указано, что при температуре окружающей

среды за пределами нормальной области

температур, предел допускаемой

дополнительной погрешности, возникающей

по этой причине, не должен превышать

![]() 0,2% на 10о С.

0,2% на 10о С.

Классы

точности средств измерений.

Исторически по

точности средства измерений подразделяют

на классы. Иногда их называют классами

точности, иногда классами допуска,

иногда просто классами.

Класс точности

средства измерений

– это его характеристика, отражающая

точностные возможности средств измерений

данного типа.

Допускается

буквенное или числовое обозначение

классов точности. Средствам измерений,

предназначенным для измерения двух и

более физических величин, допускается

присваивать различные классы точности

для каждой измеряемой величины. Средствам

измерений с двумя или более переключаемыми

диапазонами измерений также допускается

присваивать два или более класса

точности.

Если нормируется

предел допускаемой абсолютной основной

погрешности, или в различных поддиапазонах

измерений установлены разные значения

пределов допускаемой относительной

основной погрешности, то , как правило,

применяется буквенное обозначение

классов. Так, например платиновые

термометры сопротивления изготовляют

с классом допуска А

или классом

допуска В.

При этом для

класса А

установлен

предел допускаемой абсолютной основной

погрешности

![]() ,

,

а для классаВ

—

![]() ,

,

где![]() – температура измеряемой среды.

– температура измеряемой среды.

Если для средств

измерений того или иного типа нормируется

одно значение предельно-допустимой

приведенной основной погрешности, или

одно значение предельно-допустимой

относительной основной погрешности,

или указываются значения c

и d,

то для обозначения классов точности

используются десятичные числа. В

соответствии с ГОСТом 8.401-80 для обозначения

классов точности допускается применение

следующих чисел:

1∙10n;

1,5∙10n;

2∙10n;

2,5∙10n;

4∙10n;

5∙10n;

6∙10n,

где n

= 0, -1, -2, и т.д.

Для средств

измерений с преобладающей аддитивной

погрешностью численное значение класса

точности выбирается из указанного ряда

равным предельно-допустимому значению

приведенной основной погрешности,

выраженной в процентах. Для средств

измерений с преобладающей мультипликативной

погрешностью численное значение класса

точности соответствует пределу

допускаемой относительной основной

погрешности также выраженной в процентах.

Для средств измерений с соизмеримыми

аддитивными и мультипликативными

погрешностями числа с

и d

также

выбираются из указанного выше ряда. При

этом класс точности средства измерений

обозначается двумя числами, разделенными

косой чертой, например, 0,05/0,02. В этом

случае с

= 0,05%; d

= 0,02%. Примеры

обозначений классов точности в

документации и на средствах измерений,

а также расчетные формулы для оценки

пределов допускаемой основной погрешности

приведены в Таблице 1.

Правила округления

и записи результата измерений.

Нормирование

пределов допускаемых погрешностей

средств измерений производится указанием

значения погрешностей с одной или двумя

значащими цифрами. По этой причине при

расчете значений погрешностей измерений

также должны быть оставлены только

первые одна или две значащие цифры. Для

округления используются следующие

правила:

-

Погрешность

результата измерения указывается двумя

значащими цифрами, если первая из них

не более 2, и одной цифрой, если первая

из них 3 и более. -

Показание прибора

округляется до того же десятичного

разряда, которым заканчивается

округленное значение абсолютной

погрешности. -

Округление

производится в окончательном ответе,

промежуточные вычисления выполняют с

одной – двумя избыточными цифрами.

Пример 1:

— показание прибора

— 5,361 В;

— вычисленное

значение абсолютной погрешности — ±

0,264 В;

— округленное

значение абсолютной погрешности — ±

0,26 В;

— результат измерения

— (5,36 ± 0,26) В.

Таблица

1

Примеры обозначения

классов точности средств измерений и

расчетные

формулы для оценки

пределов допускаемой основной погрешности.

|

Форма представления нормируемой основной погрешности |

Примеры обозначения класса |

Расчетные формулы для оценки пределов допускаемой основной погрешности |

Примечания |

|

|

В документации |

На средствах измерений |

|||

|

Нормируется предел допускаемой абсолютной основной |

Варианты: — класс B; — класс допуска В; — класс |

В |

|

Значения a иb приводятся в документации на средство измерений. |

|

Нормируется предел допускаемой приведенной основной |

Варианты: — класс точности 1,5 2,5 — не обозначается. |

1,5 |

|

Для приборов с равномерной шкалой и нулевой отметкой в начале шкалы |

|

Варианты: — класс точности 2,5; — не обозначается |

|

|

Для приборов с неравномерной шкалой. Длина шкалы указывается в документации. |

|

|

Нормируется предел допускаемой относительной основной |

Класс точности |

0,5

|

|

Для средств измерений с преобладающей мультипликативной погрешностью. |

|

Варианты: — класс точности 0,02/0,01; -не обозначается. |

0,02/0,01 |

|

Для средств измерений с соизмеримыми аддитивной и мультипликативной погрешностью |

Пример 2:

— показание прибора

– 35,67 мА;

— вычисленное

значение абсолютной погрешности — ±

0,541 мА;

— округленное

значение абсолютной погрешности — ± 0,5

мА;

— результат измерений

– (35,7 ± 0,5) мА.

Пример 3:

— вычисленное

значение относительной погрешности –

± 1,268 %;

— округленное

значение относительной погрешности –

± 1,3 %.

Пример 4:

— вычисленное

значение относительной погрешности —

± 0,367 %;

— округленное

значение относительной погрешности —

± 0,4 %.

II.2.

Вопросы для самопроверки

-

Чем вызываются

погрешности измерений? -

Перечислите

разновидности погрешностей, возникающих

в процессе измерений? -

Какая разница

между абсолютной, относительной и

приведенной погрешностями измерения

и в чем смысл их введения? -

Чем отличается

основная погрешность измерения от

дополнительной? -

Чем отличается

методическая погрешность измерения

от инструментальной? -

Чем отличается

систематическая погрешность измерения

от случайной? -

Что понимается

под аддитивной и мультипликативной

оставляющими погрешности? -

В каких случаях

целесообразно использовать статистическую

обработку результатов измерений? -

Какие статистические

характеристики обработки наиболее

часто используются на практике? -

Как оценивается

неисключенная систематическая

погрешность при статистической обработке

результатов измерений?

11. Что характеризует

величина среднеквадратического

отклонения ?

12. В чем заключается

суть понятий «доверительной вероятности»

и «доверительного интервала», используемых

при статистической обработке результатов

измерений?

13. В чем заключается

разность понятий «погрешность измерения»

и

«погрешность

средства измерения»?

Неотъемлемой частью любого измерения является погрешность измерений. С развитием приборостроения и методик измерений человечество стремиться снизить влияние данного явления на конечный результат измерений. Предлагаю более детально разобраться в вопросе, что же это такое погрешность измерений.

Погрешность измерения – это отклонение результата измерения от истинного значения измеряемой величины. Погрешность измерений представляет собой сумму погрешностей, каждая из которых имеет свою причину.

По форме числового выражения погрешности измерений подразделяются на абсолютные и относительные

Абсолютная погрешность – это погрешность, выраженная в единицах измеряемой величины. Она определяется выражением.

![]() (1.2), где X — результат измерения; Х0 — истинное значение этой величины.

(1.2), где X — результат измерения; Х0 — истинное значение этой величины.

Поскольку истинное значение измеряемой величины остается неизвестным, на практике пользуются лишь приближенной оценкой абсолютной погрешности измерения, определяемой выражением

![]() (1.3), где Хд — действительное значение этой измеряемой величины, которое с погрешностью ее определения принимают за истинное значение.

(1.3), где Хд — действительное значение этой измеряемой величины, которое с погрешностью ее определения принимают за истинное значение.

Относительная погрешность – это отношение абсолютной погрешности измерения к действительному значению измеряемой величины:

(1.4)

(1.4)

По закономерности появления погрешности измерения подразделяются на систематические, прогрессирующие, и случайные.

Систематическая погрешность – это погрешность измерения, остающаяся постоянной или закономерно изменяющейся при повторных измерениях одной и той же величины.

Прогрессирующая погрешность – это непредсказуемая погрешность, медленно меняющаяся во времени.

Систематические и прогрессирующие погрешности средств измерений вызываются:

- первые — погрешностью градуировки шкалы или ее небольшим сдвигом;

- вторые — старением элементов средства измерения.

Систематическая погрешность остается постоянной или закономерно изменяющейся при многократных измерениях одной и той же величины. Особенность систематической погрешности состоит в том, что она может быть полностью устранена введением поправок. Особенностью прогрессирующих погрешностей является то, что они могут быть скорректированы только в данный момент времени. Они требуют непрерывной коррекции.

Случайная погрешность – это погрешность измерения изменяется случайным образом. При повторных измерениях одной и той же величины. Случайные погрешности можно обнаружить только при многократных измерениях. В отличии от систематических погрешностей случайные нельзя устранить из результатов измерений.

По происхождению различают инструментальные и методические погрешности средств измерений.

Инструментальные погрешности — это погрешности, вызываемые особенностями свойств средств измерений. Они возникают вследствие недостаточно высокого качества элементов средств измерений. К данным погрешностям можно отнести изготовление и сборку элементов средств измерений; погрешности из-за трения в механизме прибора, недостаточной жесткости его элементов и деталей и др. Подчеркнем, что инструментальная погрешность индивидуальна для каждого средства измерений.

Методическая погрешность — это погрешность средства измерения, возникающая из-за несовершенства метода измерения, неточности соотношения, используемого для оценки измеряемой величины.

Погрешности средств измерений.

Абсолютная погрешность меры – это разность между номинальным ее значением и истинным (действительным) значением воспроизводимой ею величины:

![]() (1.5), где Xн – номинальное значение меры; Хд – действительное значение меры

(1.5), где Xн – номинальное значение меры; Хд – действительное значение меры

Абсолютная погрешность измерительного прибора – это разность между показанием прибора и истинным (действительным) значением измеряемой величины:

![]() (1.6), где Xп – показания прибора; Хд – действительное значение измеряемой величины.

(1.6), где Xп – показания прибора; Хд – действительное значение измеряемой величины.

Относительная погрешность меры или измерительного прибора – это отношение абсолютной погрешности меры или измерительного прибора к истинному

(действительному) значению воспроизводимой или измеряемой величины. Относительная погрешность меры или измерительного прибора может быть выражена в ( % ).

(1.7)

(1.7)

Приведенная погрешность измерительного прибора – отношение погрешности измерительного прибора к нормирующему значению. Нормирующие значение XN – это условно принятое значение, равное или верхнему пределу измерений, или диапазону измерений, или длине шкалы. Приведенная погрешность обычно выражается в ( % ).

(1.8)

(1.8)

Предел допускаемой погрешности средств измерений – наибольшая без учета знака погрешность средства измерений, при которой оно может быть признано и допущено к применению. Данное определение применяют к основной и дополнительной погрешности, а также к вариации показаний. Поскольку свойства средств измерений зависят от внешних условий, их погрешности также зависят от этих условий, поэтому погрешности средств измерений принято делить на основные и дополнительные.

Основная – это погрешность средства измерений, используемого в нормальных условиях, которые обычно определены в нормативно-технических документах на данное средство измерений.

Дополнительная – это изменение погрешности средства измерений вследствии отклонения влияющих величин от нормальных значений.

Погрешности средств измерений подразделяются также на статические и динамические.

Статическая – это погрешность средства измерений, используемого для измерения постоянной величины. Если измеряемая величина является функцией времени, то вследствие инерционности средств измерений возникает составляющая общей погрешности, называется динамической погрешностью средств измерений.

Также существуют систематические и случайные погрешности средств измерений они аналогичны с такими же погрешностями измерений.

Факторы влияющие на погрешность измерений.

Погрешности возникают по разным причинам: это могут быть ошибки экспериментатора или ошибки из-за применения прибора не по назначению и т.д. Существует ряд понятий которые определяют факторы влияющие на погрешность измерений

Вариация показаний прибора – это наибольшая разность показаний полученных при прямом и обратном ходе при одном и том же действительном значении измеряемой величины и неизменных внешних условиях.

Класс точности прибора – это обобщенная характеристика средств измерений (прибора), определяемая пределами допускаемых основной и дополнительных погрешностей, а также другими свойствами средств измерений, влияющих на точность, значение которой устанавливаются на отдельные виды средств измерений.

Классы точности прибора устанавливают при выпуске, градуируя его по образцовому прибору в нормальных условиях.

Прецизионность — показывает, как точно или отчетливо можно произвести отсчет. Она определяется, тем насколько близки друг к другу результаты двух идентичных измерений.

Разрешение прибора — это наименьшее изменение измеряемого значения, на которое прибор будет реагировать.

Диапазон прибора — определяется минимальным и максимальным значением входного сигнала, для которого он предназначен.

Полоса пропускания прибора — это разность между минимальной и максимальной частотой, для которых он предназначен.

Чувствительность прибора — определяется, как отношение выходного сигнала или показания прибора к входному сигналу или измеряемой величине.

Шумы — любой сигнал не несущий полезной информации.

Аннотация: Рассмотрим подробный порядок операций, выполняемых при обработке результатов измерений. Содержание всех описываемых действий рассмотрено в предыдущих разделах. Проводимые расчеты основываются на предположении о нормальном распределении погрешностей, когда систематические погрешности уже учтены на предыдущих этапах работы с экспериментальными данными.

Нормирование погрешностей средств измерений

Нормирование метрологических характеристик средств измерений и заключается в установлении границ для отклонений реальных значений параметров средств измерений от их номинальных значений.

Каждому средству измерений приписываются некоторые номинальные характеристики. Действительные же характеристики средств измерений не совпадают с номинальными, что и определяет их погрешности.

Обычно нормирующее значение принимают равным:

- большему из пределов измерений, если нулевая отметка расположена на краю или вне диапазона измерения;

- сумме модулей пределов измерения, если нулевая отметка расположена внутри диапазона измерения;

- длине шкалы или её части, соответствующей диапазону измерения, если шкала существенно неравномерна (например, у омметра);

- номинальному значению измеряемой величины, если таковое установлено (например, у частотомера с номинальным значением 50 Гц);

- модулю разности пределов измерений, если принята шкала с условным нулём (например, для температуры), и т.д.

Чаще всего за нормирующее значение принимают верхний предел измерений данного средства измерений.

Отклонения параметров средств измерений от их номинальных значений, вызывающие погрешность измерений, не могут быть указаны однозначно, поэтому для них должны быть установлены предельно допускаемые значения.

Указанное нормирование является гарантией взаимозаменяемости средств измерений.

Нормирование погрешностей средств измерений заключается в установлении предела допускаемой погрешности.

Под этим пределом понимается наибольшая (без учёта знака) погрешность средства измерения, при которой оно может быть признано годным и допущено к применению.

Подход к нормированию погрешностей средств измерений заключается в следующем:

- в качестве норм указывают пределы допускаемых погрешностей, включающие в себя и систематические, и случайные составляющие;

- порознь нормируют все свойства средств измерений, влияющие на их точность.

Стандарт устанавливает ряды пределов допускаемых погрешностей. Этой же цели служит установление классов точности средств измерений.

Классы точности средств измерений

Класс точности – это обобщенная характеристика СИ, выражаемая пределами допускаемых значений его основной и дополнительной погрешностей, а также другими характеристиками, влияющими на точность. Класс точности не является непосредственной оценкой точности измерений, выполняемых этим СИ, поскольку погрешность зависит еще от ряда факторов: метода измерений, условий измерений и т.д. Класс точности лишь позволяет судить о том, в каких пределах находится погрешность СИ данного типа. Общие положения деления средств измерений по классу точности устанавливает ГОСТ 8.401–80.

Пределы допускаемой основной погрешности, определяемые классом точности, – это интервал, в котором находится значение основной погрешности СИ.

Классы точности СИ устанавливаются в стандартах или технических условиях. Средство измерения может иметь два и более класса точности. Например, при наличии у него двух или более диапазонов измерений одной и той же физической величины ему можно присваивать два или более класса точности. Приборы, предназначенные для измерения нескольких физических величин, также могут иметь различные классы точности для каждой измеряемой величины.

Пределы допускаемых основной и дополнительной погрешностей выражают в форме приведенных, относительных или абсолютных погрешностей. Выбор формы представления зависит от характера изменения погрешностей в пределах диапазона измерений, а также от условий применения и назначения СИ.

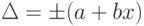

Пределы допускаемой абсолютной основной погрешности устанавливаются по одной из формул:  или

или  , где x – значение измеряемой величины или число делений, отсчитанное по шкале;

, где x – значение измеряемой величины или число делений, отсчитанное по шкале;

a, b – положительные числа, не зависящие от х. Первая формула описывает чисто аддитивную погрешность, а вторая – сумму аддитивной и мультипликативной погрешностей.

В технической документации классы точности, установленные в виде абсолютных погрешностей, обозначают, например, «Класс точности М», а на приборе – буквой «М». Для обозначения используются прописные буквы латинского алфавита или римские цифры, причём меньшие пределы погрешностей должны соответствовать буквам, находящимся ближе к началу алфавита, или меньшим цифрам. Пределы допускаемой приведенной основной погрешности определяются по формуле  , где xN – нормирующее значение, выраженное в тех же единицах, что и

, где xN – нормирующее значение, выраженное в тех же единицах, что и  ; p – отвлеченное положительное число, выбираемое из ряда значений:

; p – отвлеченное положительное число, выбираемое из ряда значений:

Нормирующее значение xN устанавливается равным большему из пределов измерений (или модулей) для СИ с равномерной, практически равномерной или степенной шкалой и для измерительных преобразователей, для которых нулевое значение выходного сигнала находится на краю или вне диапазона измерений. Для СИ, шкала которых имеет условный нуль, равно модулю разности пределов измерений.

Для приборов с существенно неравномерной шкалой xN принимают равным всей длине шкалы или ее части, соответствующей диапазону измерении. В этом случае пределы абсолютной погрешности выражают, как и длину шкалы, в единицах длины, а на средстве измерений класс точности условно обозначают, например, в виде значка  , где 0,5 – значение числа р (рис. 3.1).

, где 0,5 – значение числа р (рис. 3.1).

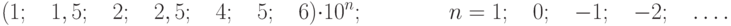

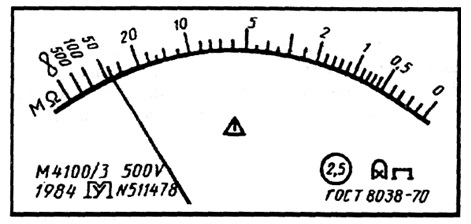

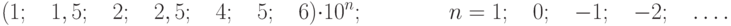

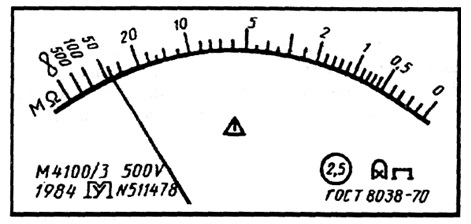

Рис.

3.1.

Лицевая панель фазометра класса точности 0,5 с существенно неравномерной нижней шкалой

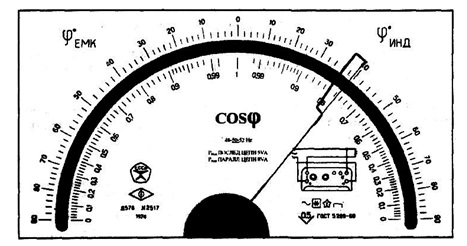

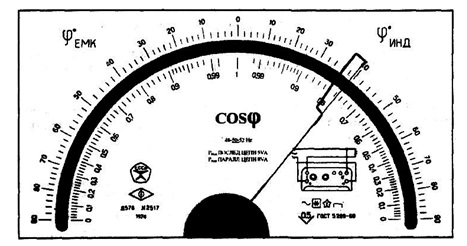

В остальных рассмотренных случаях класс точности обозначают конкретным числом р, например 1,5. Обозначение наносится на циферблат, щиток или корпус прибора (рис. 3.2).

Рис.

3.2.

Лицевая панель амперметра класса точности 1,5 с равномерной шкалой

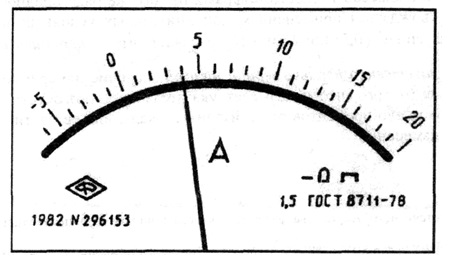

В том случае если абсолютная погрешность задается формулой  , пределы допускаемой относительной основной погрешности

, пределы допускаемой относительной основной погрешности

![delta=Delta/x=pm[c+d(|x_{k}/x|-1)]](https://intuit.ru/sites/default/files/tex_cache/3898a996678dab895193a1773d11ffc8.png) |

( 3.1) |

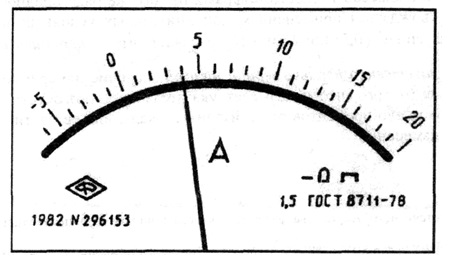

где с, d – отвлеченные положительные числа, выбираемые из ряда:  ; – больший (по модулю) из пределов измерений. При использовании формулы 3.1 класс точности обозначается в виде «0,02/0,01», где числитель – конкретное значение числа с, знаменатель – числа d (рис. 3.3).

; – больший (по модулю) из пределов измерений. При использовании формулы 3.1 класс точности обозначается в виде «0,02/0,01», где числитель – конкретное значение числа с, знаменатель – числа d (рис. 3.3).

Рис.

3.3.

Лицевая панель ампервольтметра класса точности 0,02/0,01с равномерной шкалой

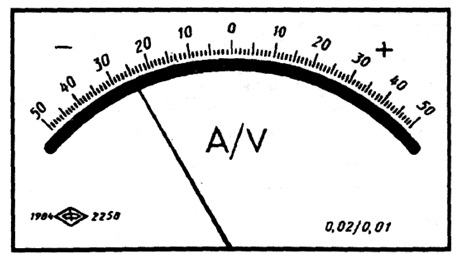

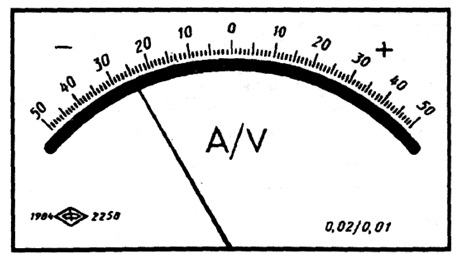

Пределы допускаемой относительной основной погрешности определяются по формуле  , если

, если  . Значение постоянного числа q устанавливается так же, как и значение числа p. Класс точности на прибор обозначается в виде

. Значение постоянного числа q устанавливается так же, как и значение числа p. Класс точности на прибор обозначается в виде  , где 0,5 – конкретное значение q (рис. 3.4).

, где 0,5 – конкретное значение q (рис. 3.4).

Рис.

3.4.

Лицевая панель мегаомметра класса точности 2,5 с неравномерной шкалой

В стандартах и технических условиях на СИ указывается минимальное значение x0, начиная с которого применим принятый способ выражения пределов допускаемой относительной погрешности. Отношение xk/x0 называется динамическим диапазоном измерения.

Правила построения и примеры обозначения классов точности в документации и на средствах измерений приведены в таблице 3.1.

Контрольные вопросы

- Поясните, что такое класс точности СИ.

- Является ли класс точности СИ непосредственной оценкой точности измерений, выполняемых этим СИ?

- Перечислите основные принципы, лежащие в основе выбора нормируемых метрологических характеристик средств измерений.

- Как нормируются приборы по классам точности?

- Какие метрологические характеристики описывают погрешность средств измерений?

- Как осуществляется нормирование метрологических характеристик средств измерений?

Текст работы размещён без изображений и формул.

Полная версия работы доступна во вкладке «Файлы работы» в формате PDF

Погрешность измерения — отклонение измеренного значения величины от её истинного (действительного) значения. Погрешность измерения является характеристикой точности измерения.

Бывает три видов погрешности:

Абсолютная

Относительная

Приведенная

Погрешности средств измерения

Школьные средства измерения имеют вполне нормированные основные погрешности. Включенные в новый «Перечень оборудования», эти средства делятся на стрелочные приборы (амперметры, вольтметры, динамометры и др.), цифровые приборы (мультиметры демонстрационные и лабораторные, счетчик-секундомер и др.), многопредельные меры (линейка, мерная лента, мерный цилиндр), наборы мер (набор грузов по механике и набор гирь, набор резисторов).Несколько особняком в этой номенклатуре оказываются весы для фронтальных работ и практикума. Весы с точки зрения принципа действия можно отнести к нуль-индикаторам, в которых измерение сводится к прямому сравниванию массы взвешиваемого тела с массой гирь. Особенность погрешностей многопредельных мер состоит в том, что они линейно нарастают вдоль шкалы. Именно поэтому либо указано значение погрешностей номинальных значений (т.е. всей длины), либо значение на 100 мм шкалы. Обратим внимание на то, что погрешности деревянных инструментов меньше, чем пластмассовых. Все инструменты, маркированные знаком «ГОСТ», имеют погрешности меньшие, чем погрешности инструментов, не имеющих этих знаков.

В чем метрологический смысл погрешности меры? Она показывает интервал, внутри которого с вероятностью, близкой к 100% находится неизвестное истинное значение меры. Например, каждый груз из набора грузов имеет номинальное значение массы 100 г, погрешность меры ± 2 г. Следовательно, истинное значение груза находится в интервале (100 – 2) г < m < (100 + 2) г.

Если номинальное значение сопротивления резистора равно 4,0 Ом, а погрешность 0,12 Ом, следовательно, истинное значение сопротивления содержится в интервале (4,00 – 0,12) Ом Ј R Ј (4,00 + 0,12) Ом.

Погрешности стрелочных электроизмерительных приборов чаще всего задаются специальной величиной, которая называется классом точности и обозначается символом g. Класс точности g показывает значение допускаемой погрешности в процентах от предела измерения (или суммы пределов для приборов, нуль которых находится внутри шкалы). Например, если класс точности амперметра равен g = 2,5, то основная погрешность равна

Если миллиамперметр имеет ноль посередине шкалы, его основная погрешность равна

В чем смысл основной погрешности стрелочных приборов? Она показывает интервал, внутри которого с вероятностью равной 100% находится истинное значение измеряемой величины, если стрелка прибора совпадает со штрихом шкалы. Например, пусть стрелка амперметра совпадает со штрихом 1,6 А. Следовательно, истинное значение силы тока находится в интервале

(1,60 – 0,05) А Ј I Ј (1,60 + 0,05) А.

Основная погрешность весов складывается из погрешности гирь и чувствительности. Например, если на весах находится взвешиваемое тело и две гири номинальными значениями 100 г и 50 г, то погрешность весов складывается из погрешностей гирь (40 + 30) мг.

Погрешность мультиметра указана двумя числами. Например, для диапазона 700 В записано: «± 1,2% ± 3». Эта запись означает, что погрешность мультиметра в диапазоне от 200 В до 700 В равна сумме единицы младшего разряда считываемого показания U. Пусть считываемое показание равно U = 237 В. Следовательно, погрешность измерения равна

Истинное значение напряжения находится в интервале (237 – 6) В < U < (237 + 6) В.

Отметим, что погрешности измерений определяются, главным образом, погрешностями средств измерений, но они не тождественны им.

В общем случае погрешность средства измерений(меры измерительного преобразователя, измерительного прибора) — это отклонение его реальной функции преобразования от номинальной.

Отклонения реальной характеристики от номинальной, отсчитанные вдоль оси Х или оси У, т. е. разности вида y = Ур— Унилиx = Хр— Хн, естьабсолютные погрешности преобразования, выраженные в единицах величин Х или У (рис. 1).

Мерой точности абсолютная погрешность быть не может, т. к., например, Х = 0.5 мм при измерении высоты пенного слоя пульпы, равной Х = 200 мм, достаточно мала, а при измерении толщины листа стали, при Х = 1 мм, эта погрешность очень велика.

Абсолютная погрешность измерительного прибора XП— это разность между показанием прибора ХПи истинным (действительным) ХДзначением измеряемой величины:

XП= ХП– ХД.

Рис. 1. К пояснению понятия абсолютной погрешности

При этом за действительное значение физической величины при оценке погрешности рабочего средства измерений принимают показания образцового средства измерений, при оценке погрешности образцового средства — показания, полученные с помощью эталонного средства измерений.

Абсолютная погрешность измерительного преобразователя по входу— это разность между значением величины на входе преобразователя ХВи истинным (действительным) значением этой величины на входе ХВД. При этом значение величины на входе ХВопределяется по истинному (действительному) значению величины на выходе преобразователя с помощью градуировочной характеристики, приписанной преобразователю. Таким образом,

ХВ=Х*ВД – ХВД,

где ХВ— погрешность измерительного преобразователя по входу;

Х*ВД — истинное (действительное) значение величины на выходе, найденное по градировочной характеристике преобразователя;

ХВД— истинное (действительное) значение преобразуемой величины на входе.

Абсолютная погрешность измерительного преобразователя по выходу— это разность между истинным (действительным) значением величины преобразователя на выходеDХВЫХ.Д и значением величины на выходе Х*ВЫХ.Д, определяемым по истинному (действительному) значению величины на входе с помощью градуировочной характеристики, приписанной преобразователю. Таким образом,

DХВЫХ.П = ХВЫХ.Д — Х*ВЫХ.Д ,

где DХВЫХ.П— погрешность измерительного преобразователя по выходу;

ХВЫХ.Д — действительное значение преобразуемой величины на выходе преобразователя;

Х*ВЫХ.Д — действительное значение преобразуемой величины на выходе, определяемое по действительному значению ее на входе с помощью градуировочной характеристики.

Абсолютная погрешность— это разность между номинальным значением меры ХН и истинным (действительным) ХД воспроизводимой ею величины, т. е.

ХМ= ХН– ХД,

где ХМ— абсолютная погрешность мepы;

ХН— номинальное значение мepы;

ХД— действительное значение воспроизводимой мерой величины.

Пример. Погрешность меры длины (линейки) с номинальным значением 100 мм и действительным значением 100,0006 мм равна 0,6 мкм; погрешность меры сопротивления с номинальным значением 1 Ом и действительным значением 1,0001 Ом равна 0,0001 Ом.

Относительная погрешность меры или измерительного прибора(П) — это отношение абсолютной погрешности меры или измерительного прибора к истинному (действительному) значению воспроизводимой или измеряемой величины.

Относительная погрешность меры или измерительного прибора, в процентах, может быть выражена как:

.

Относительная погрешность измерительного преобразователя по входу (выходу) — это отношение абсолютной погрешности измерительного преобразователя по входу (выходу) к истинному (действительному) значению величины на входе (выходе), определяемому по истинному значению величины на входе (выходе) с помощью номинальной характеристики, приписанной преобразователю.

Итак, относительная погрешность средства измерений, выражаемая в процентах или в относительных единицах, не остается постоянной вследствие изменения величин Х или Y по шкале измерительного устройства.

С учетом того, что относительная погрешность средства измерений не остается постоянной, то вводится понятие приведенной погрешности, в общем виде определяемой:

,

где - приведенная погрешность средства измерений;

XN- нормирующее значение измеряемой величины.

Приведенная погрешность измерительного прибора— это отношение абсолютной погрешности измерительного прибораХПк нормирующему значению.Нормирующее значение XN- это условно принятое значение, равное или верхнему пределу измерений, или диапазону измерений**, или длине шкалы***.

Приведенную погрешность обычно выражают в процентах:

.

Приведенная погрешность позволяет сравнивать по точности приборы, имеющие разные пределы точности.

Пример. Определить абсолютную, относительную и приведенную погрешности амперметра с диапазоном измерения 0 -15 А при показании его ХП= 12 А и действительном значении измеряемой силы тока ХД= 12,6 А. За нормирующее значение примем верхний предел измерения Xv = 15 А.

Абсолютная погрешность амперметра

ХП= ХП– ХД= 12 — 12,6 = -0,6 А.

Относительная погрешность амперметра

Приведенная погрешность

При характеристике погрешностей средств измерений часто пользуются понятием предела допускаемой погрешности измерений.

Предел допускаемой погрешности средства измерений— это наибольшая, без учета знака, погрешность средства измерений, при котором оно может быть признано и допущено к применению. Определение применимо к основной и дополнительной погрешности средств измерений.

Пример. Одинаков ли предел допускаемой относительной погрешности измерения во всех точках шкалы автоматического потенциометра?

Для всех точек шкалы одинаков предел допускаемой абсолютной погрешности, определяемой классом точности средства измерений и диапазоном измерений, а предел допускаемой относительной погрешности измерения зависит от конкретной отметки шкалы, т. е. чем меньше показания прибора по шкале, тем больше относительная погрешность. Вследствие этого верхний предел показаний прибора нужно выбирать таким образом, чтобы значение измеряемой величины находилось в конце шкалы.

По происхождению различают инструментальные и методические погрешности средств измерений.

Инструментальные погрешности— это погрешности, вызываемые особенностями свойств средств измерений. Они возникают вследствие недостаточно высокого качества элементов средств измерений, К этим погрешностям можно отнести изготовление и сборку элементов средств измерений; погрешности из-за трения в механизме прибора, недостаточной жесткости его элементов и деталей и др. Подчеркнем, что инструментальная погрешность индивидуальна для каждого средства измерений

Методическая погрешность— это погрешность средства измерения, возникающая из-за несовершенства метода измерения, неточности соотношения, используемого для оценки измеряемой величины.

Основная и дополнительная погрешности.Деление это чисто условно. Погрешность средств измерений, определяемую для работающих в нормальных условиях, называютосновной погрешностью. Нормальными условиями принято считать условия, когда температура окружающего воздуха t = (20 ± 5) 0C, относительная влажность W = 30 – 80 %, атмосферное давление Р = 630 — 795 мм рт. ст., напряжение питающей сети (U = (220 ± 4,4) В, частота питающей сети f = (50 ± 0,5) Гц. Такие условия выдерживаются в лабораторных условиях при градуировке средств измерений.

В реальных условиях производства эти параметры отличаются от лабораторных. Средства измерения помимо чувствительности к измеряемой величине обладают и некоторой чувствительностью к изменяющимся величинам окружающей среды, что приводит к искажению результатов измерения. Погрешность, появляющуюся у средств измерений, работающих в реальных производственных условиях, называют дополнительной погрешностью. Так же, как основная, дополнительная погрешность нормируется путем указания коэффициентов влияния изменения отдельных влияющих величин на изменение показаний в виде

α = , α =· Uпит.

Систематические и прогрессирующие погрешности средств измерений вызываются: первые — погрешностью градуировки шкалы или ее небольшим сдвигом, вторые — старением элементов средства измерения. Систематическая погрешность остается постоянной или закономерно изменяющейся при многократных измерениях одной и той же величины. Особенность систематической погрешности состоит в том, что она может быть полностью устранена введением поправок. Особенностью прогрессирующих погрешностей является то, что они могут быть скорректированы только в данный момент времени. Они требуют непрерывной коррекции.

Аддитивные и мультипликативные погрешности. Аддитивная погрешность не зависит от чувствительности прибора и является постоянной для всех значений входной (измеряемой) величины в пределах диапазона измерений (рис.2).

Если реальная характеристика 1 средства измерения смещена относительно номинальной 2 (см. рис. 2) так, что при всех значениях преобразуемой величины Х выходная величина У оказывается больше (или меньше) на одну и ту же величину Δ, то такая погрешность называется аддитивной погрешностью нуля.

Рис. 2. К пояснению понятия аддитивной погрешности средства измерения

К аддитивным погрешностям средств измерений можно отнести погрешности, вызванные трением в опорах электроизмерительных приборов, погрешность дискретности (квантования) в цифровых приборах. Аддитивная погрешность может носить систематический характер. В этом случае она может быть скорректирована смещением шкалы или нулевого положения указателя.

В случае же, если аддитивная погрешность является случайной, то она не может быть скорректирована, и реальная характеристика средства измерения, смещаясь произвольным образом, но, оставаясь параллельной самой себе, образует полосу погрешностей, ширина которой остается постоянной для любых значений измеряемой величины Х (см. рис. 4.2, б).

Мультипликативная погрешность– это погрешность чувствительности средства измерения. Она может иметь систематическую и случайную составляющие.

Сущность мультипликативной погрешности заключается в том, что если абсолютная погрешность возникает от некоторого независимого от Х изменения чувствительности преобразователя (изменение коэффициента деления делителя, добавочного сопротивления вольтметра и т. д.), то реальная характеристика 1 преобразователя отклоняется от номинальной 2 так, как это показано на рис. 4.3, а, или образует полосу погрешностей (рис. 4.3, б), если это отклонение является случайным.

Рис. 4.3. К пояснению понятия мультипликативной погрешности измерений

Список использованной литературы:

http://fiz.1september.ru/2001/16/no16_01.htm

https://studfiles.net/preview/6269920/page:2/

Погрешность является одной из наиболее важных метрологических характеристик средства измерений (технического средства, предназначенного для измерений). Она соответствует разнице между показаниями средства измерений и истинным значением измеряемой величины. Чем меньше погрешность, тем более точным считается средство измерений, тем выше его качество. Наибольшее возможное значение погрешности для определенного типа средств измерений при определенных условиях (например, в заданном диапазоне значений измеряемой величины) называется пределом допускаемой погрешности. Обычно устанавливают пределы допускаемой погрешности, т.е. нижнюю и верхнюю границы интервала, за которые не должна выходить погрешность.

Как сами погрешности, так и их пределы, принято выражать в форме абсолютных, относительных или приведенных погрешностей. Конкретная форма выбирается в зависимости от характера изменения погрешностей в пределах диапазона измерений, а также от условий применения и назначения средств измерений. Абсолютную погрешность указывают в единицах измеряемой величины, а относительную и приведённую — обычно в процентах. Относительная погрешность может характеризовать качество средства измерения гораздо более точно, чем приведённая, о чем будет рассказано далее более подробно.

Связь между абсолютной (Δ), относительной (δ) и приведённой (γ) погрешностями определяется по формулам:

δ=Δ/Х

(1)

γ=Δ/ХN

(2)

где X — значение измеряемой величины, XN — нормирующее значение, выраженное в тех же единицах, что и Δ. Критерии выбора нормирующего значения XN устанавливаются ГОСТ 8.401-80 в зависимости от свойств средства измерений, и обычно оно должно быть равно пределу измерений (XK), т.е.

γ=Δ/ХK

(3)

Пределы допускаемых погрешностей рекомендуется выражать в форме приведённых в случае, если границы погрешностей можно полагать практически неизменными в пределах диапазона измерений (например, для стрелочных аналоговых вольтметров, когда границы погрешности определяются в зависимости от цены деления шкалы, независимо от значения измеряемого напряжения). В противном случае рекомендуется выражать пределы допускаемых погрешностей в форме относительных согласно ГОСТ 8.401-80.

Однако на практике выражение пределов допускаемых погрешностей в форме приведённых погрешностей ошибочно используется в случаях, когда границы погрешностей никак нельзя полагать неизменными в пределах диапазона измерений. Это либо вводит пользователей в заблуждение (когда они не понимают, что заданная таким образом в процентах погрешность считается вовсе не от измеряемой величины), либо существенно ограничивает область применения средства измерений, т.к. формально в этом случае погрешность по отношению к измеряемой величине возрастает, например, в десять раз, если измеряемая величина составляет 0,1 от предела измерений.

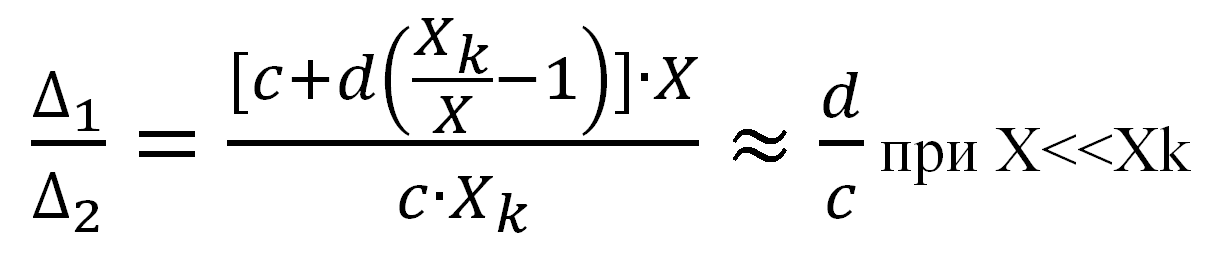

Выражение пределов допускаемых погрешностей в форме относительных погрешностей позволяет достаточно точно учесть реальную зависимость границ погрешностей от значения измеряемой величины при использовании формулы вида

δ = ± [c+d(Xk/X-1)]

(4)

где с и d — коэффициенты, d<c.

При этом в точке X=Xk пределы допускаемой относительной погрешности, рассчитанные по формуле (4), будут совпадать с пределами допускаемой приведенной погрешности

γ = ±c

(5)

В точках X<Xk нельзя сравнивать непосредственно в процентах относительную и приведённую погрешности, потому что они считаются по отношению к разным значениям, но можно сравнить абсолютные значения погрешностей, выраженные в единицах измеряемой величины. Пределы допускаемой абсолютной погрешности (Δ1), рассчитанные по формуле (6), исходя из формул (1) и (4) для относительной погрешности, будут стремиться к значению, которое составляет (d/c)-ю часть от пределов допускаемой абсолютной погрешности (Δ2), рассчитанных по формуле (7), исходя из формул (3) и (5) для приведённой погрешности.

Δ1=δ·X=[c+d(Xk/X-1)]·X

(6)

Δ2=γ·ХK= c·Xk

(7)

(8)

Т.е. в большом диапазоне значений измеряемой величины может быть обеспечена гораздо более высокая точность измерений, если нормировать не пределы допускаемой приведённой погрешности по формуле (5), а пределы допускаемой относительной погрешности по формуле (4).

Это означает, например, что для измерительного преобразователя на основе АЦП с большой разрядностью и большим динамическим диапазоном сигнала выражение пределов погрешности в форме относительной адекватнее описывает реальные границы погрешности преобразователя, по сравнению с формой приведённой.

Использование терминологии

Данная терминология широко используется при описании метрологических характеристик различных Средств измерения, например, перечисленных ниже производства ООО «Л Кард»:

Измерительная система LTR

Модуль АЦП/ЦАП

16/32 каналов, 16 бит, 2 МГц, USB, Ethernet

E-502

Плата АЦП/ЦАП

16/32 каналов, 16 бит, 2 МГц, PCI Express

L-502

Модуль АЦП/ЦАП

16/32 каналов, 14 бит, 200 кГц, USB

E14-140M

Модуль АЦП/ЦАП

16/32 каналов, 14 бит, 400 кГц, USB

E14-440

Модуль АЦП/ЦАП

4 канала, 14 бит, 10 МГц, USB

E20-10

Прибор контроля качества электроэнергии

LPW-305

Прибор контроля качества электроэнергии

LPW-305-7

Источники

погрешностей (инструментальные и

методические погрешности, влияние

помех, субъективные ошибки). Номинальная

и реальная функция преобразования,

абсолютная и относительная погрешность

средства измерений, основная и

дополнительная погрешности. Пределы

допускаемых погрешностей, классы

точности средств измерений. Выявление

и уменьшение систематических погрешностей.

Оценка случайных погрешностей.

Доверительный интервал и доверительная

вероятность. Оценка погрешностей

косвенных измерений. Обработка результатов

измерений. [1:

с.23…35,40,41,53,54,56…61; 2:

с.22…53; 3:

с.48…91; 4:

с.21,22,35…52,63…71, 72…77,85…93].

II.1. Основные сведения и методические указания.

Одним из

основополагающих понятий Метрологии

является понятие погрешности измерений.

Погрешностью

измерения

называют отклонение измеренного

значения физической

величины от её истинного значения.

Погрешность

измерений, в общем случае, может быть

вызвана следующими причинами:

-

Несовершенством

принципа действия и недостаточным

качеством элементов используемого

средства измерения. -

Несовершенством

метода измерений и влиянием используемого

средства измерения на саму измеряемую

величину, зависящим от способа

использования данного средства

измерения. -

Субъективными

ошибками экспериментатора.

Так как истинное

значение измеряемой величины никогда

неизвестно (в противном случае отпадает

необходимость в проведении измерений),

то численное значение погрешности

измерений может быть найдено только