From Wikipedia, the free encyclopedia

Error level analysis (ELA) is the analysis of compression artifacts in digital data with lossy compression such as JPEG.

Principles[edit]

When used, lossy compression is normally applied uniformly to a set of data, such as an image, resulting in a uniform level of compression artifacts.

Alternatively, the data may consist of parts with different levels of compression artifacts. This difference may arise from the different parts having been repeatedly subjected to the same lossy compression a different number of times, or the different parts having been subjected to different kinds of lossy compression. A difference in the level of compression artifacts in different parts of the data may therefore indicate that the data has been edited.

In the case of JPEG, even a composite with parts subjected to matching compressions will have a difference in the compression artifacts.[1]

In order to make the typically faint compression artifacts more readily visible, the data to be analyzed is subjected to an additional round of lossy compression, this time at a known, uniform level, and the result is subtracted from the original data under investigation. The resulting difference image is then inspected manually for any variation in the level of compression artifacts. In 2007, N. Krawetz denoted this method «error level analysis».[1]

Additionally, digital data formats such as JPEG sometimes include metadata describing the specific lossy compression used. If in such data the observed compression artifacts differ from those expected from the given metadata description, then the metadata may not describe the actual compressed data, and thus indicate that the data have been edited.

-

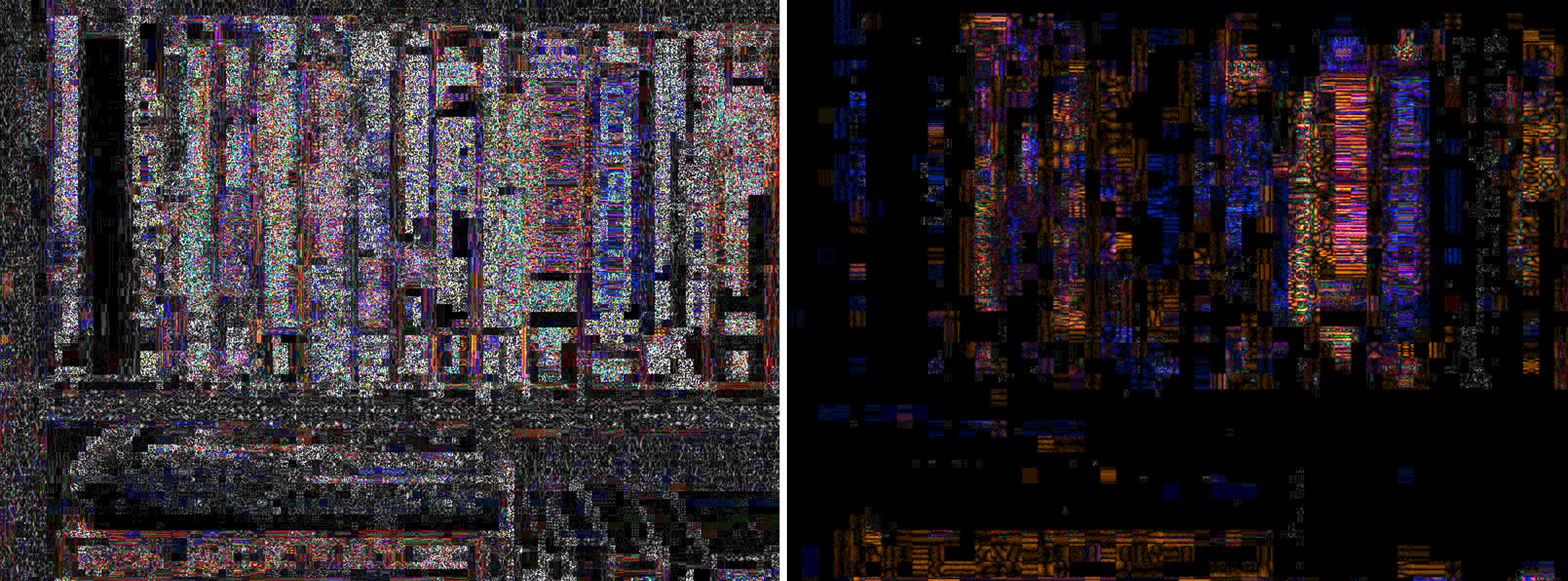

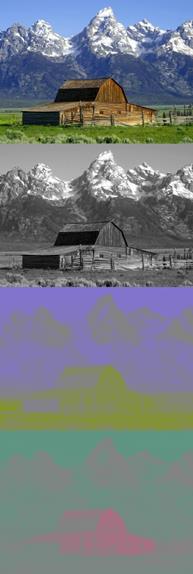

A composite image, where the different parts have different JPEG compression levels

-

The same image with a uniform 90% quality JPEG compression

-

The difference between the two images shows a variation of the JPEG compression artifacts

Limitations[edit]

By its nature, data without lossy compression, such as a PNG image, cannot be subjected to error level analysis. Consequently, since editing could have been performed on data without lossy compression with lossy compression applied uniformly to the edited, composite data, the presence of a uniform level of compression artifacts does not rule out editing of the data.

Additionally, any non-uniform compression artifacts in a composite may be removed by subjecting the composite to repeated, uniform lossy compression.[2] Also, if the image color space is reduced to 256 colors or less, for example, by conversion to GIF, then error level analysis will generate useless results.[3]

More significant, the actual interpretation of the level of compression artifacts in a given segment of the data is subjective, and the determination of whether editing has occurred is therefore not robust.[1]

Controversy[edit]

In May 2013, Dr Neal Krawetz used error level analysis on the 2012 World Press Photo of the Year and concluded on his Hacker Factor blog that it was «a composite» with modifications that «fail to adhere to the acceptable journalism standards used by Reuters, Associated Press, Getty Images, National Press Photographer’s Association, and other media outlets». The World Press Photo organizers responded by letting two independent experts analyze the image files of the winning photographer and subsequently confirmed the integrity of the files. One of the experts,

Hany Farid, said about error level analysis that «It incorrectly labels altered images as original and incorrectly labels original images as altered with the same likelihood». Krawetz responded by clarifying that «It is up to the user to interpret the results. Any errors in identification rest solely on the viewer».[4]

In May 2015, the citizen journalism team Bellingcat wrote that error level analysis revealed that the Russian Ministry of Defense had edited satellite images related to the Malaysia Airlines Flight 17 disaster.[5] In a reaction to this, image forensics expert Jens Kriese said about error level analysis: «The method is subjective and not based entirely on science», and that it is «a method used by hobbyists».[6] On his Hacker Factor Blog, the inventor of error level analysis Neal Krawetz criticized both Bellingcat’s use of error level analysis as «misinterpreting the results» but also on several points Jens Kriese’s «ignorance» regarding error level analysis.[7]

See also[edit]

- Image analysis

References[edit]

- ^ a b c Wang, W.; Dong, J.; Tan, T. (October 2010). «Tampered Region Localization of Digital Color Images». Digital Watermarking: 9th International Workshop, IWDW 2010. Seoul, Korea: Springer. pp. 120–133. ISBN 9783642184048.

We are hardly able to tell the tampered region from the unchanged one sometimes just by human visual perception of JPEG compression noise

- ^ «FotoForensics». fotoforensics.com. Retrieved 2015-09-20.

If an image is resaved multiple times, then it may be entirely at a minimum error level, where more resaves do not alter the image. In this case, the ELA will return a black image and no modifications can be identified using this algorithm

- ^ «FotoForensics — FAQ». fotoforensics.com. Retrieved 2015-09-20.

- ^ Steadman, Ian (2013-05-16). «‘Fake’ World Press Photo isn’t fake, is lesson in need for forensic restraint». Wired UK. Retrieved 2015-09-11.

- ^ «bellingcat — MH17 — Forensic Analysis of Satellite Images Released by the Russian Ministry of Defence». bellingcat.com. 2015-05-31. Retrieved 2015-09-29.

Error level analysis of the images also reveal the images have been edited

- ^ Bidder, Benjamin (2015-06-04). «‘Bellingcat Report Doesn’t Prove Anything’: Expert Criticizes Allegations of Russian MH17 Manipulation». Spiegel Online. Retrieved 2015-07-23.

- ^ «Image Analysis — The Hacker Factor Blog». hackerfactor.com. Retrieved 2015-10-17.

- «Tutorial: Error Level Analysis». fotoforensic.com. Retrieved 2015-07-23.

External links[edit]

- Image Forensics : Error Level Analysis

- FotoForensics

From Wikipedia, the free encyclopedia

Error level analysis (ELA) is the analysis of compression artifacts in digital data with lossy compression such as JPEG.

Principles[edit]

When used, lossy compression is normally applied uniformly to a set of data, such as an image, resulting in a uniform level of compression artifacts.

Alternatively, the data may consist of parts with different levels of compression artifacts. This difference may arise from the different parts having been repeatedly subjected to the same lossy compression a different number of times, or the different parts having been subjected to different kinds of lossy compression. A difference in the level of compression artifacts in different parts of the data may therefore indicate that the data has been edited.

In the case of JPEG, even a composite with parts subjected to matching compressions will have a difference in the compression artifacts.[1]

In order to make the typically faint compression artifacts more readily visible, the data to be analyzed is subjected to an additional round of lossy compression, this time at a known, uniform level, and the result is subtracted from the original data under investigation. The resulting difference image is then inspected manually for any variation in the level of compression artifacts. In 2007, N. Krawetz denoted this method «error level analysis».[1]

Additionally, digital data formats such as JPEG sometimes include metadata describing the specific lossy compression used. If in such data the observed compression artifacts differ from those expected from the given metadata description, then the metadata may not describe the actual compressed data, and thus indicate that the data have been edited.

-

A composite image, where the different parts have different JPEG compression levels

-

The same image with a uniform 90% quality JPEG compression

-

The difference between the two images shows a variation of the JPEG compression artifacts

Limitations[edit]

By its nature, data without lossy compression, such as a PNG image, cannot be subjected to error level analysis. Consequently, since editing could have been performed on data without lossy compression with lossy compression applied uniformly to the edited, composite data, the presence of a uniform level of compression artifacts does not rule out editing of the data.

Additionally, any non-uniform compression artifacts in a composite may be removed by subjecting the composite to repeated, uniform lossy compression.[2] Also, if the image color space is reduced to 256 colors or less, for example, by conversion to GIF, then error level analysis will generate useless results.[3]

More significant, the actual interpretation of the level of compression artifacts in a given segment of the data is subjective, and the determination of whether editing has occurred is therefore not robust.[1]

Controversy[edit]

In May 2013, Dr Neal Krawetz used error level analysis on the 2012 World Press Photo of the Year and concluded on his Hacker Factor blog that it was «a composite» with modifications that «fail to adhere to the acceptable journalism standards used by Reuters, Associated Press, Getty Images, National Press Photographer’s Association, and other media outlets». The World Press Photo organizers responded by letting two independent experts analyze the image files of the winning photographer and subsequently confirmed the integrity of the files. One of the experts,

Hany Farid, said about error level analysis that «It incorrectly labels altered images as original and incorrectly labels original images as altered with the same likelihood». Krawetz responded by clarifying that «It is up to the user to interpret the results. Any errors in identification rest solely on the viewer».[4]

In May 2015, the citizen journalism team Bellingcat wrote that error level analysis revealed that the Russian Ministry of Defense had edited satellite images related to the Malaysia Airlines Flight 17 disaster.[5] In a reaction to this, image forensics expert Jens Kriese said about error level analysis: «The method is subjective and not based entirely on science», and that it is «a method used by hobbyists».[6] On his Hacker Factor Blog, the inventor of error level analysis Neal Krawetz criticized both Bellingcat’s use of error level analysis as «misinterpreting the results» but also on several points Jens Kriese’s «ignorance» regarding error level analysis.[7]

See also[edit]

- Image analysis

References[edit]

- ^ a b c Wang, W.; Dong, J.; Tan, T. (October 2010). «Tampered Region Localization of Digital Color Images». Digital Watermarking: 9th International Workshop, IWDW 2010. Seoul, Korea: Springer. pp. 120–133. ISBN 9783642184048.

We are hardly able to tell the tampered region from the unchanged one sometimes just by human visual perception of JPEG compression noise

- ^ «FotoForensics». fotoforensics.com. Retrieved 2015-09-20.

If an image is resaved multiple times, then it may be entirely at a minimum error level, where more resaves do not alter the image. In this case, the ELA will return a black image and no modifications can be identified using this algorithm

- ^ «FotoForensics — FAQ». fotoforensics.com. Retrieved 2015-09-20.

- ^ Steadman, Ian (2013-05-16). «‘Fake’ World Press Photo isn’t fake, is lesson in need for forensic restraint». Wired UK. Retrieved 2015-09-11.

- ^ «bellingcat — MH17 — Forensic Analysis of Satellite Images Released by the Russian Ministry of Defence». bellingcat.com. 2015-05-31. Retrieved 2015-09-29.

Error level analysis of the images also reveal the images have been edited

- ^ Bidder, Benjamin (2015-06-04). «‘Bellingcat Report Doesn’t Prove Anything’: Expert Criticizes Allegations of Russian MH17 Manipulation». Spiegel Online. Retrieved 2015-07-23.

- ^ «Image Analysis — The Hacker Factor Blog». hackerfactor.com. Retrieved 2015-10-17.

- «Tutorial: Error Level Analysis». fotoforensic.com. Retrieved 2015-07-23.

External links[edit]

- Image Forensics : Error Level Analysis

- FotoForensics

From Wikipedia, the free encyclopedia

Error level analysis (ELA) is the analysis of compression artifacts in digital data with lossy compression such as JPEG.

Principles[edit]

When used, lossy compression is normally applied uniformly to a set of data, such as an image, resulting in a uniform level of compression artifacts.

Alternatively, the data may consist of parts with different levels of compression artifacts. This difference may arise from the different parts having been repeatedly subjected to the same lossy compression a different number of times, or the different parts having been subjected to different kinds of lossy compression. A difference in the level of compression artifacts in different parts of the data may therefore indicate that the data has been edited.

In the case of JPEG, even a composite with parts subjected to matching compressions will have a difference in the compression artifacts.[1]

In order to make the typically faint compression artifacts more readily visible, the data to be analyzed is subjected to an additional round of lossy compression, this time at a known, uniform level, and the result is subtracted from the original data under investigation. The resulting difference image is then inspected manually for any variation in the level of compression artifacts. In 2007, N. Krawetz denoted this method «error level analysis».[1]

Additionally, digital data formats such as JPEG sometimes include metadata describing the specific lossy compression used. If in such data the observed compression artifacts differ from those expected from the given metadata description, then the metadata may not describe the actual compressed data, and thus indicate that the data have been edited.

-

A composite image, where the different parts have different JPEG compression levels

-

The same image with a uniform 90% quality JPEG compression

-

The difference between the two images shows a variation of the JPEG compression artifacts

Limitations[edit]

By its nature, data without lossy compression, such as a PNG image, cannot be subjected to error level analysis. Consequently, since editing could have been performed on data without lossy compression with lossy compression applied uniformly to the edited, composite data, the presence of a uniform level of compression artifacts does not rule out editing of the data.

Additionally, any non-uniform compression artifacts in a composite may be removed by subjecting the composite to repeated, uniform lossy compression.[2] Also, if the image color space is reduced to 256 colors or less, for example, by conversion to GIF, then error level analysis will generate useless results.[3]

More significant, the actual interpretation of the level of compression artifacts in a given segment of the data is subjective, and the determination of whether editing has occurred is therefore not robust.[1]

Controversy[edit]

In May 2013, Dr Neal Krawetz used error level analysis on the 2012 World Press Photo of the Year and concluded on his Hacker Factor blog that it was «a composite» with modifications that «fail to adhere to the acceptable journalism standards used by Reuters, Associated Press, Getty Images, National Press Photographer’s Association, and other media outlets». The World Press Photo organizers responded by letting two independent experts analyze the image files of the winning photographer and subsequently confirmed the integrity of the files. One of the experts,

Hany Farid, said about error level analysis that «It incorrectly labels altered images as original and incorrectly labels original images as altered with the same likelihood». Krawetz responded by clarifying that «It is up to the user to interpret the results. Any errors in identification rest solely on the viewer».[4]

In May 2015, the citizen journalism team Bellingcat wrote that error level analysis revealed that the Russian Ministry of Defense had edited satellite images related to the Malaysia Airlines Flight 17 disaster.[5] In a reaction to this, image forensics expert Jens Kriese said about error level analysis: «The method is subjective and not based entirely on science», and that it is «a method used by hobbyists».[6] On his Hacker Factor Blog, the inventor of error level analysis Neal Krawetz criticized both Bellingcat’s use of error level analysis as «misinterpreting the results» but also on several points Jens Kriese’s «ignorance» regarding error level analysis.[7]

See also[edit]

- Image analysis

References[edit]

- ^ a b c Wang, W.; Dong, J.; Tan, T. (October 2010). «Tampered Region Localization of Digital Color Images». Digital Watermarking: 9th International Workshop, IWDW 2010. Seoul, Korea: Springer. pp. 120–133. ISBN 9783642184048.

We are hardly able to tell the tampered region from the unchanged one sometimes just by human visual perception of JPEG compression noise

- ^ «FotoForensics». fotoforensics.com. Retrieved 2015-09-20.

If an image is resaved multiple times, then it may be entirely at a minimum error level, where more resaves do not alter the image. In this case, the ELA will return a black image and no modifications can be identified using this algorithm

- ^ «FotoForensics — FAQ». fotoforensics.com. Retrieved 2015-09-20.

- ^ Steadman, Ian (2013-05-16). «‘Fake’ World Press Photo isn’t fake, is lesson in need for forensic restraint». Wired UK. Retrieved 2015-09-11.

- ^ «bellingcat — MH17 — Forensic Analysis of Satellite Images Released by the Russian Ministry of Defence». bellingcat.com. 2015-05-31. Retrieved 2015-09-29.

Error level analysis of the images also reveal the images have been edited

- ^ Bidder, Benjamin (2015-06-04). «‘Bellingcat Report Doesn’t Prove Anything’: Expert Criticizes Allegations of Russian MH17 Manipulation». Spiegel Online. Retrieved 2015-07-23.

- ^ «Image Analysis — The Hacker Factor Blog». hackerfactor.com. Retrieved 2015-10-17.

- «Tutorial: Error Level Analysis». fotoforensic.com. Retrieved 2015-07-23.

External links[edit]

- Image Forensics : Error Level Analysis

- FotoForensics

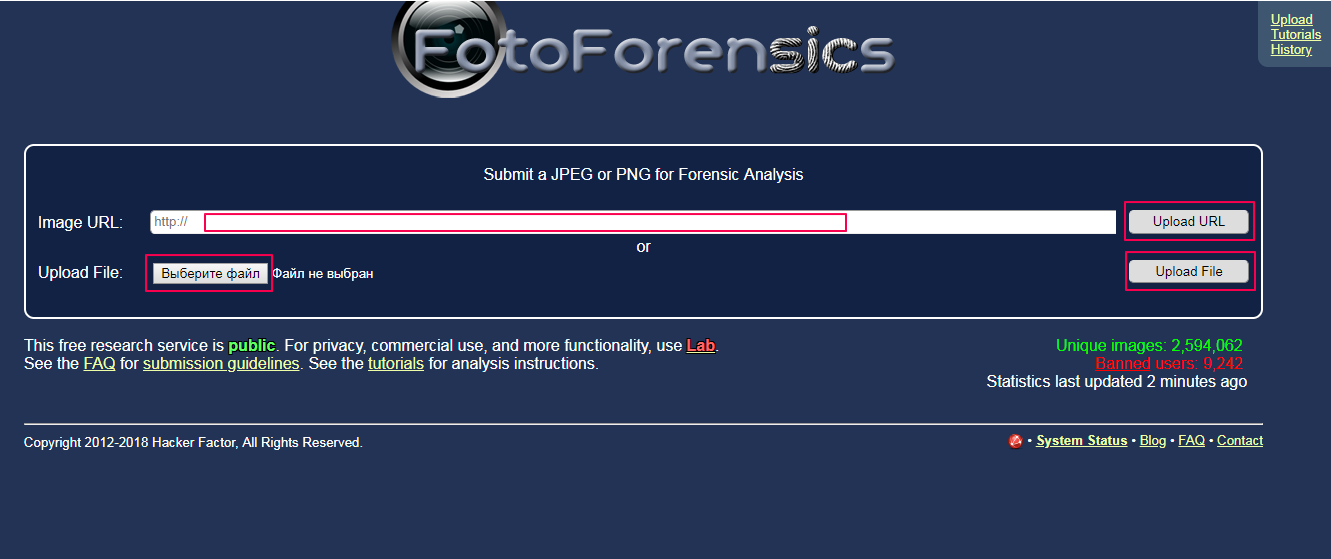

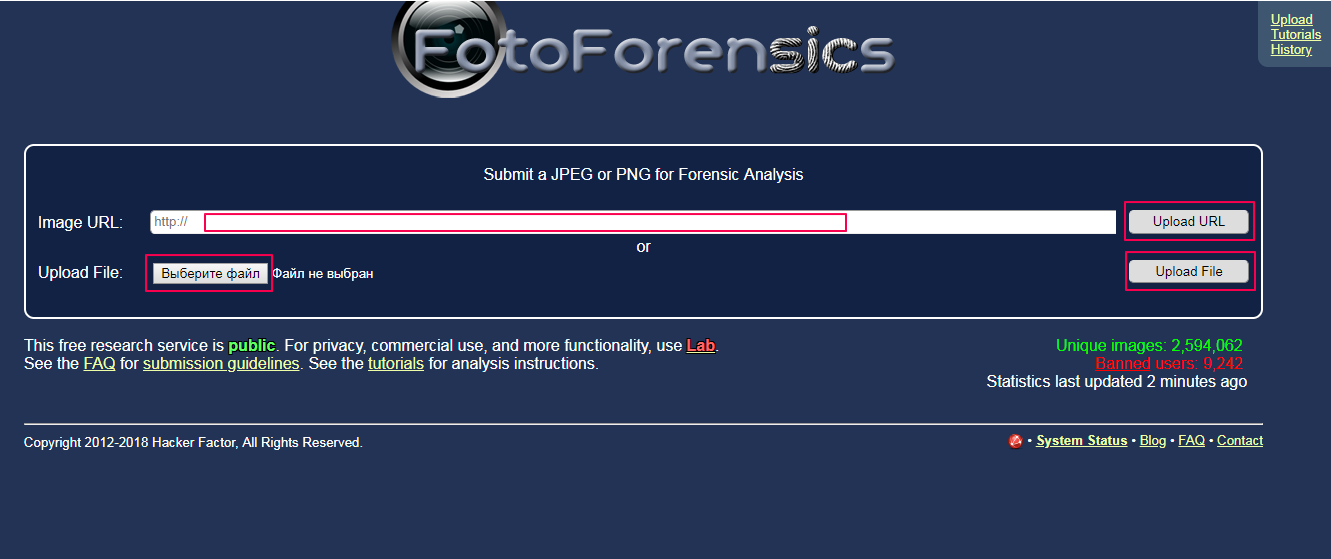

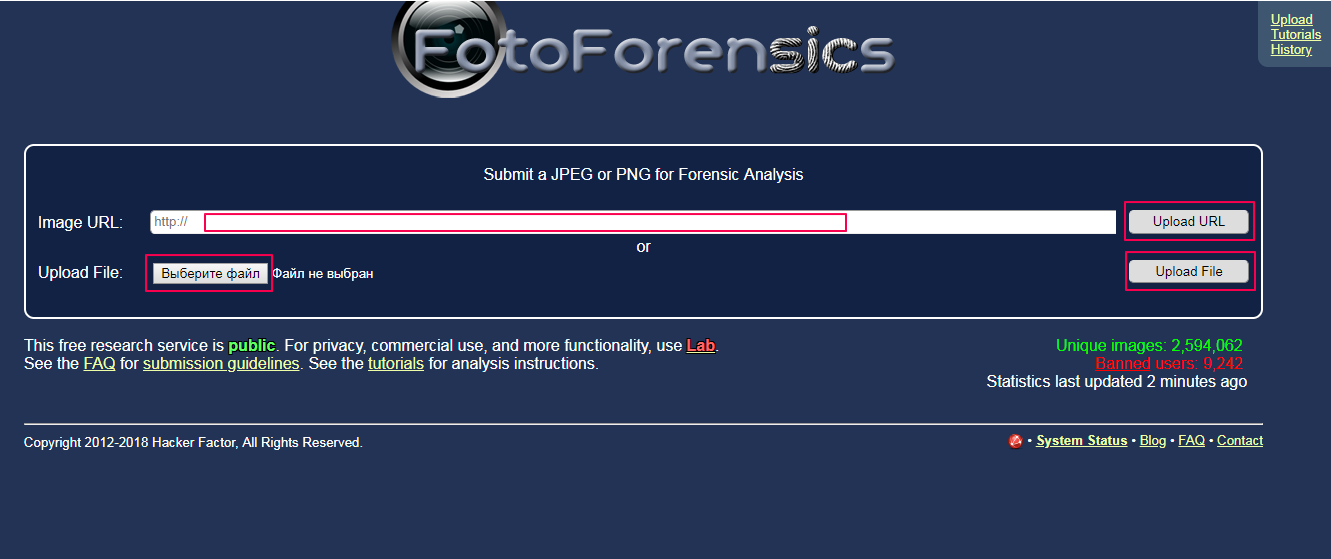

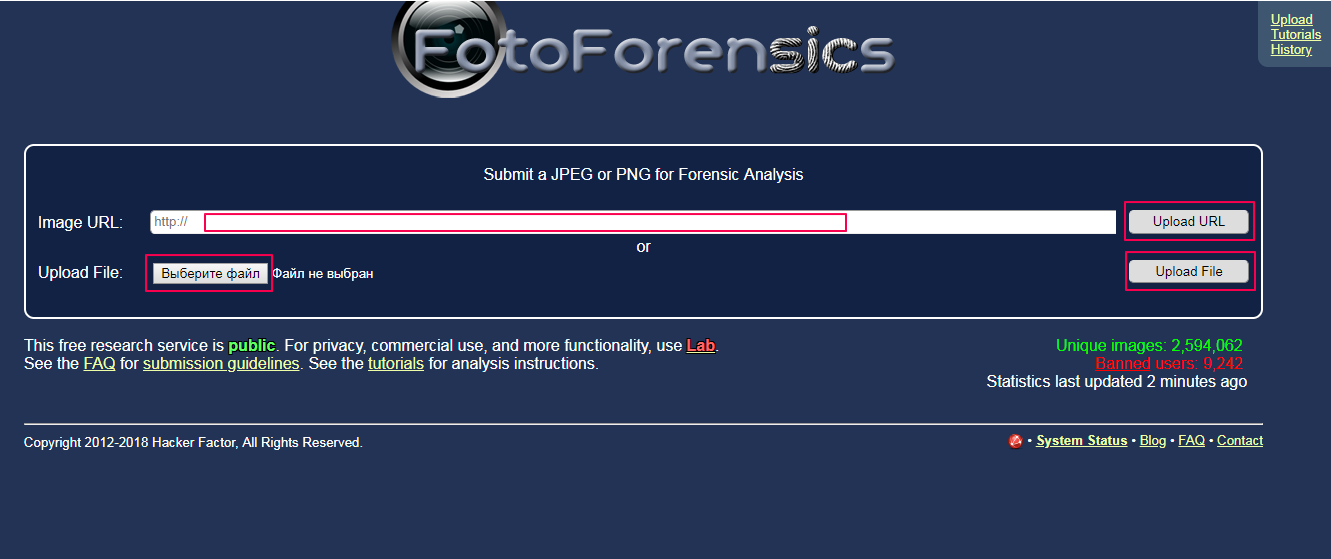

FotoForensics не разрешает загружать фотографии из России. Чтобы работать в сервисе, используйте VPN.

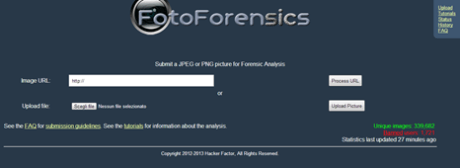

Сервис FotoForensics разрабатывался для судебных экспертов и переводится на русский как фотокриминалистика. Инструмент будет полезен всем, кто работает с пользовательским контентом: редакциям, журналистам, фактчекерам, блогерам, SMMщикам.

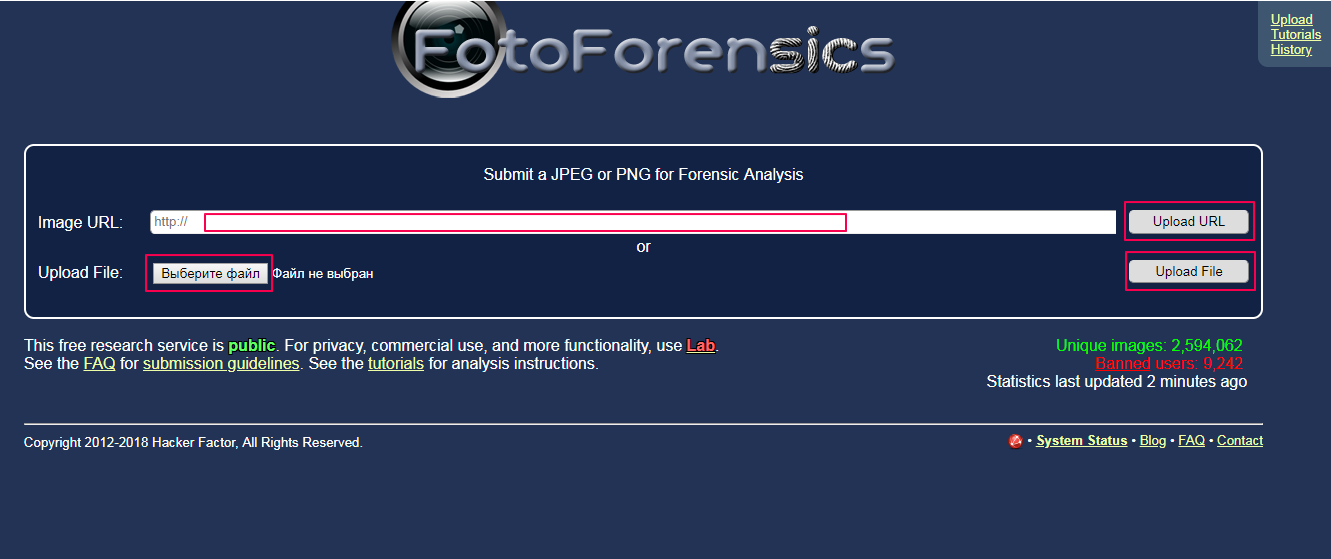

FotoForensics использует метод ELA (error level analysis — анализ уровня ошибок), который разработал Нил Кравец в 2007 году. Пит Рингвуд в 2010 году создал сервис для анализа изображений, сразу ставший популярным среди криминалистов. В 2012 Рингвуд уволился, сайт переименовали в FotoForensics и оставили бесплатный доступ для некоммерческого использования.

С жесткого или по URL

Чтобы проанализировать фотоснимок, укажите URL опубликованного в Сети изображения или загрузите его с жесткого диска, затем нажмите кнопку Upload File («Загрузить файл»).

Требования к снимкам:

- Сервис воспринимает файлы с расширениями: JPEG, PNG или WebP.

- Максимальный размер файла 8 Мб.

- Размер фотографий — не менее 100×100 и не более 10 000×10 000 пикселей.

Разработчики предупреждают: сайт публичный и его используют судебные эксперты, поэтому не стоит загружать незаконный контент. Нарушителям запретят доступ на три месяца и могут привлечь к ответственности. Заблокируют и тех, кто загружает слишком много фото за короткое время — если вы хотите проверить сразу много снимков вам нужна версия сайта для коммерческого использования.

Cервис поддерживает все современные браузеры. Сложности возникают с Apple Mobile Safari, который модифицирует изображение, загружаемое с устройства, — в этом случае выбирайте первый способ загрузки фото c помощью URL.

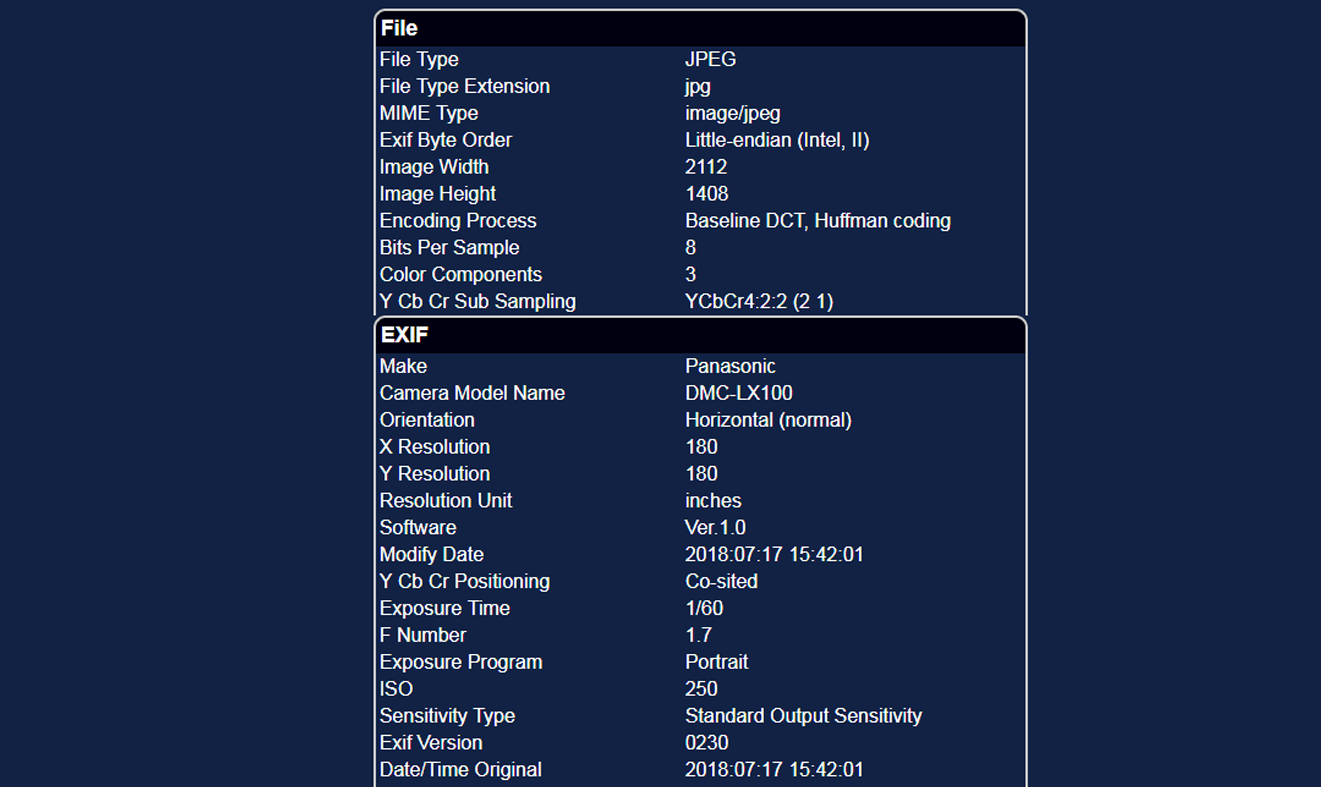

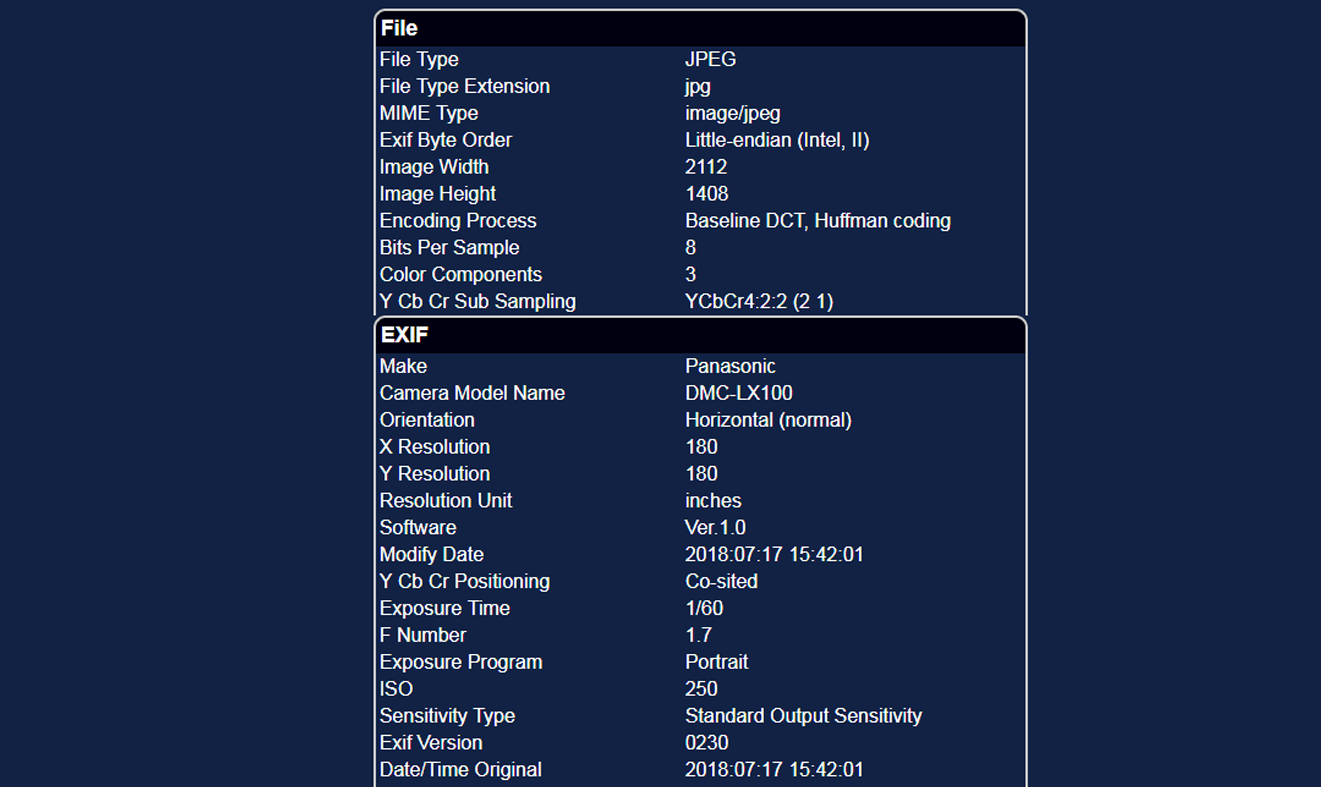

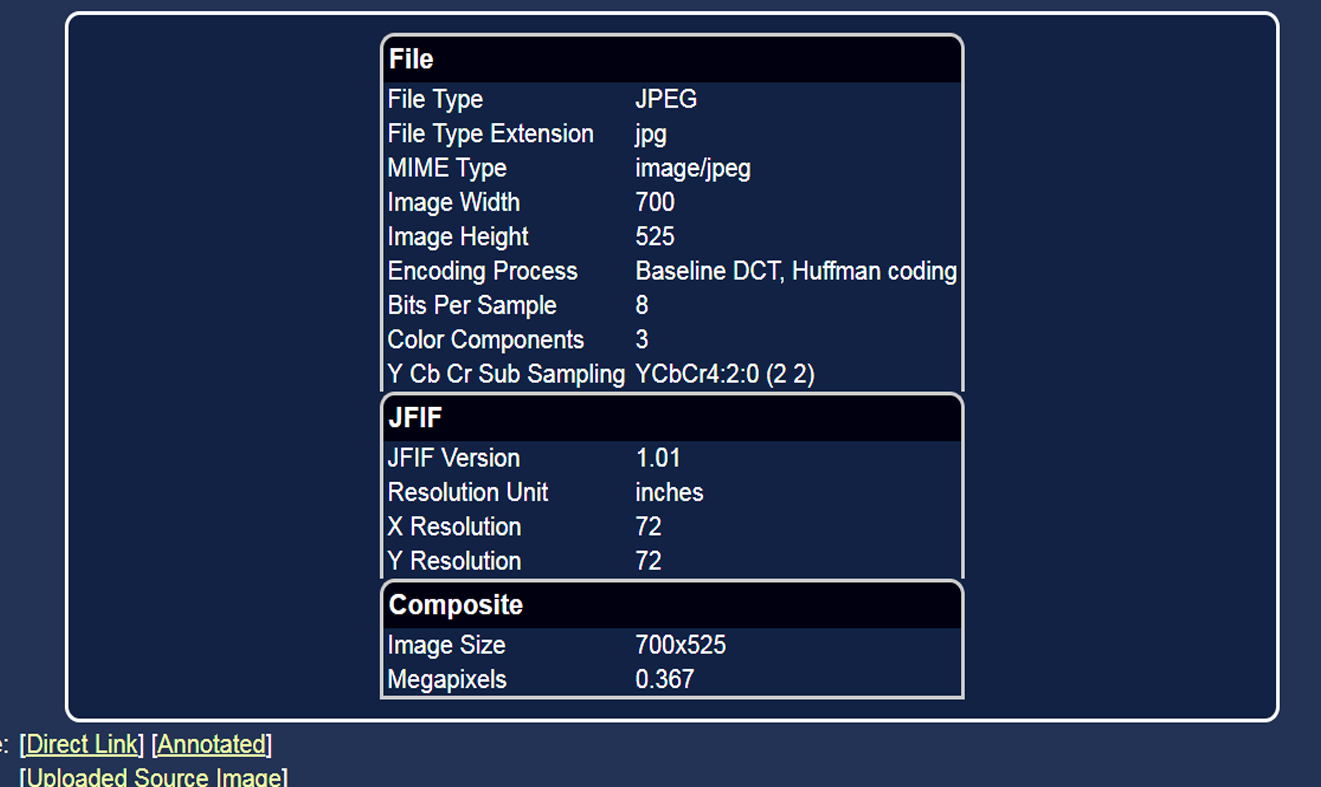

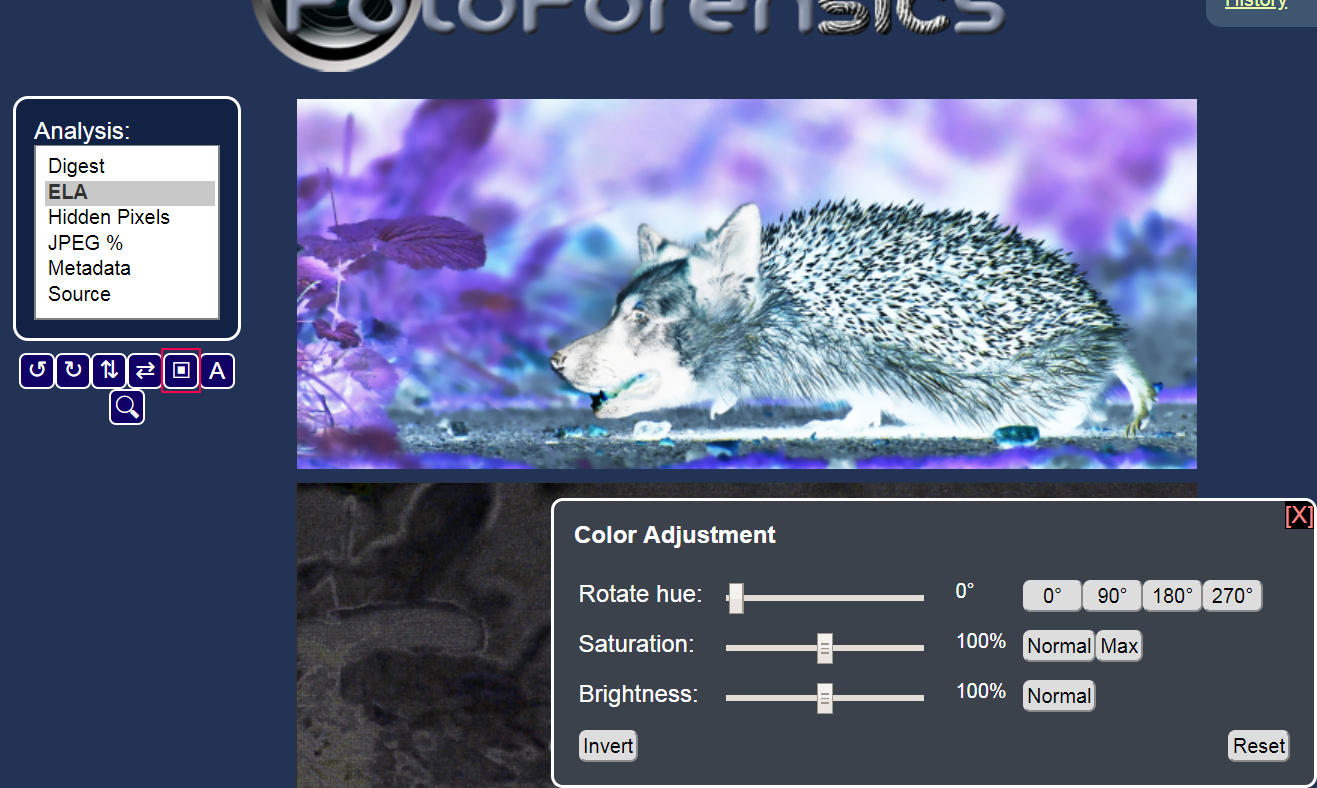

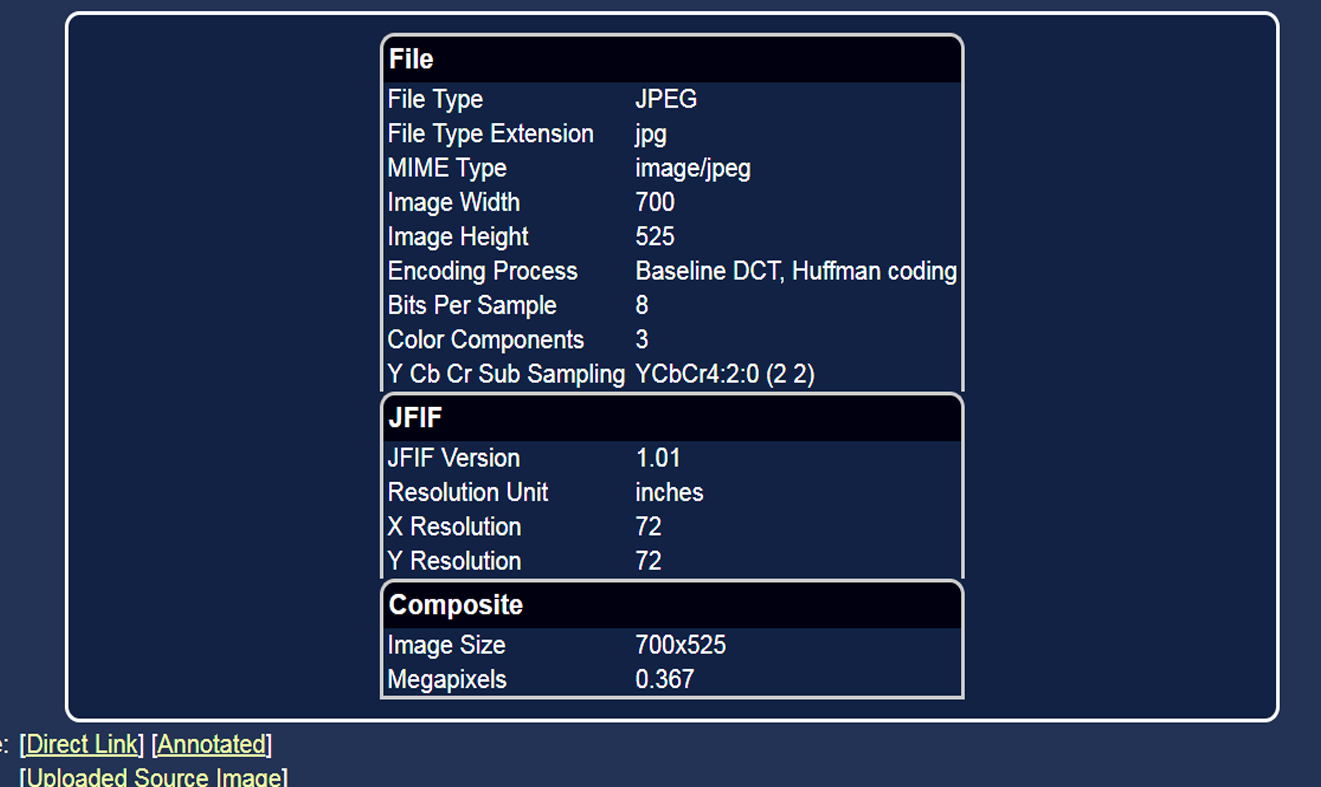

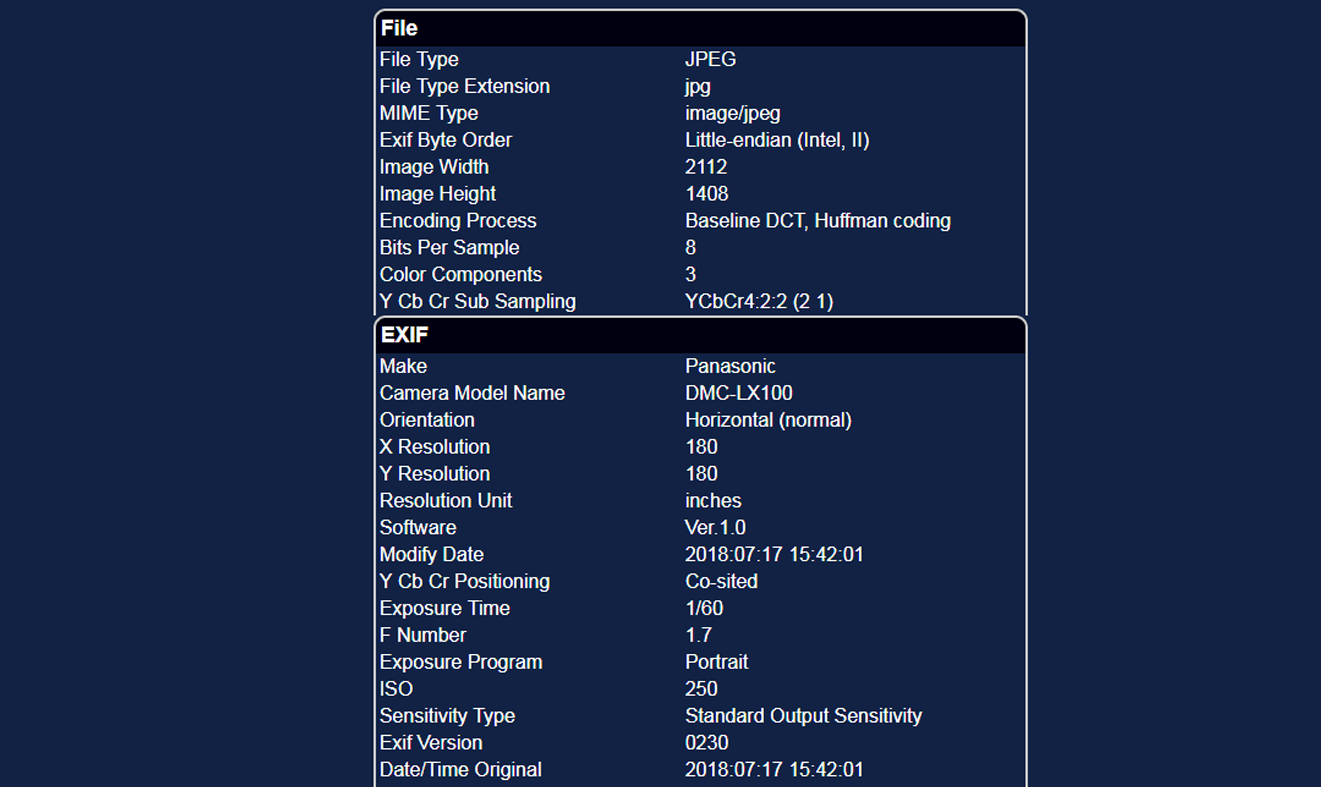

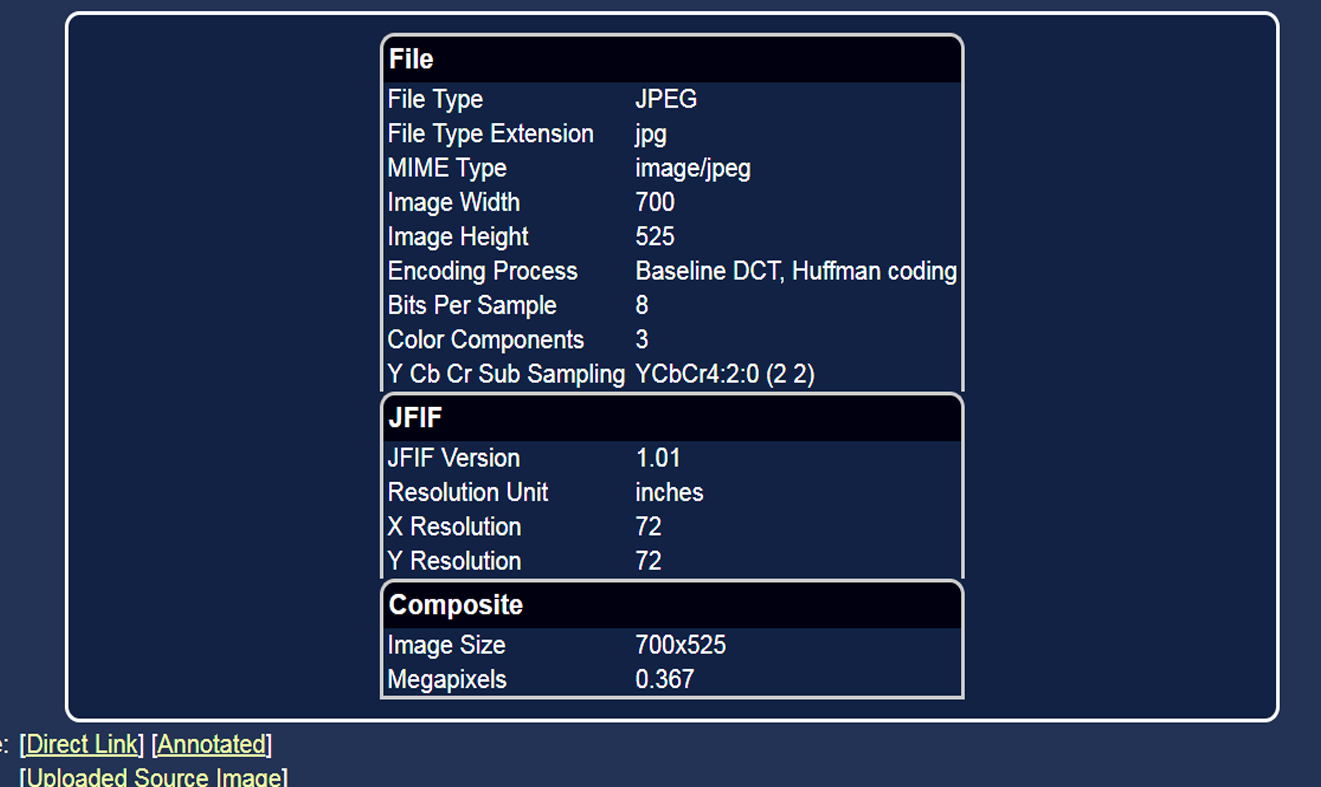

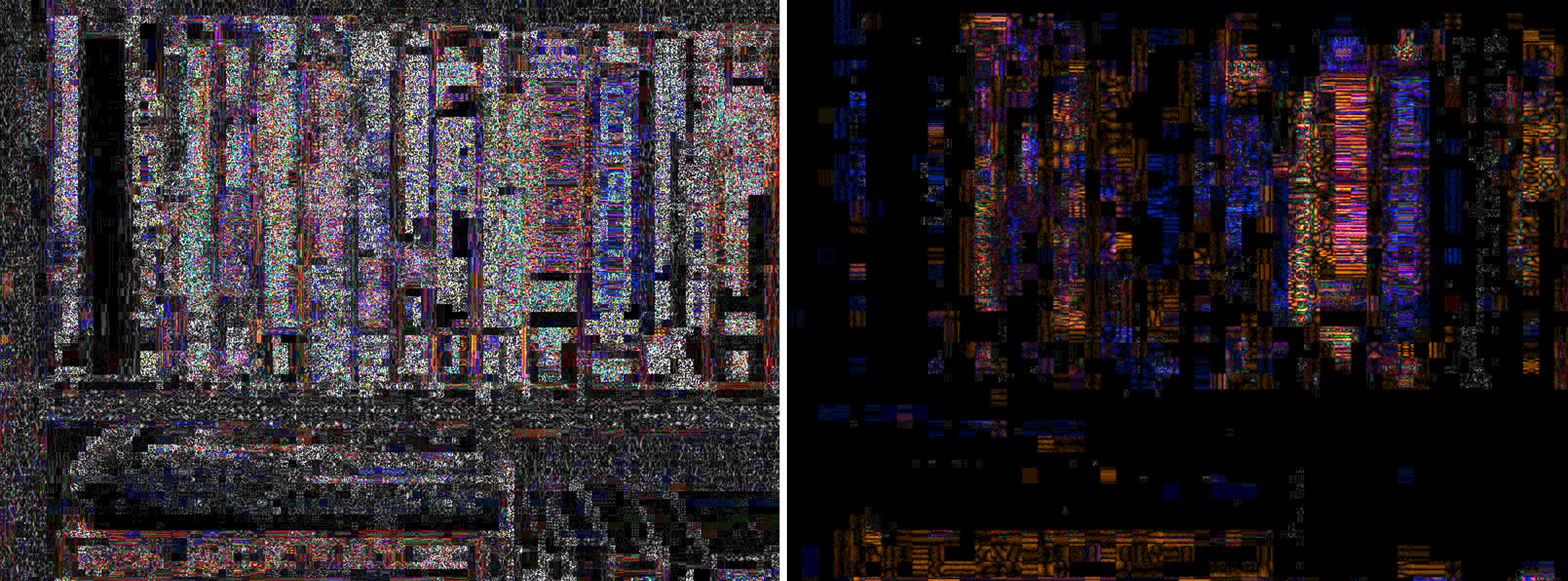

Подноготная снимка

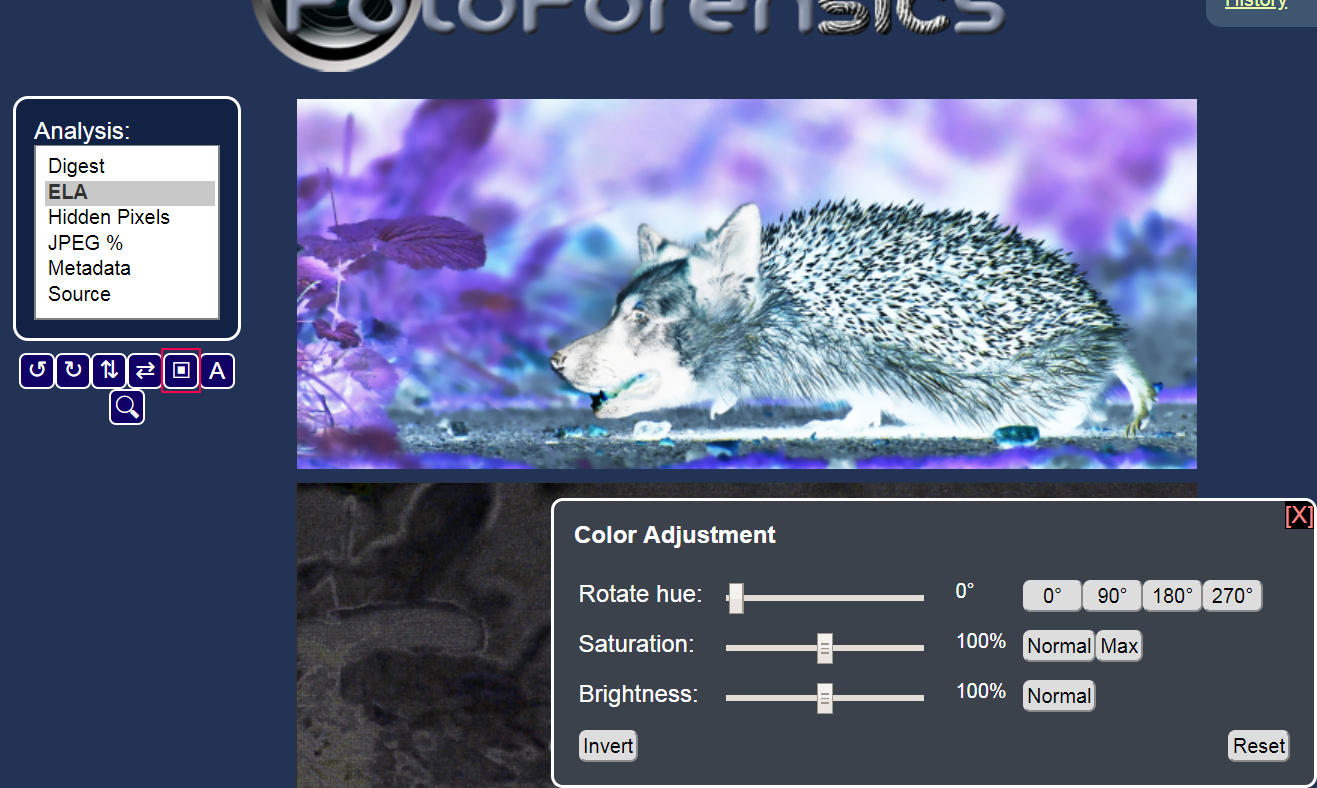

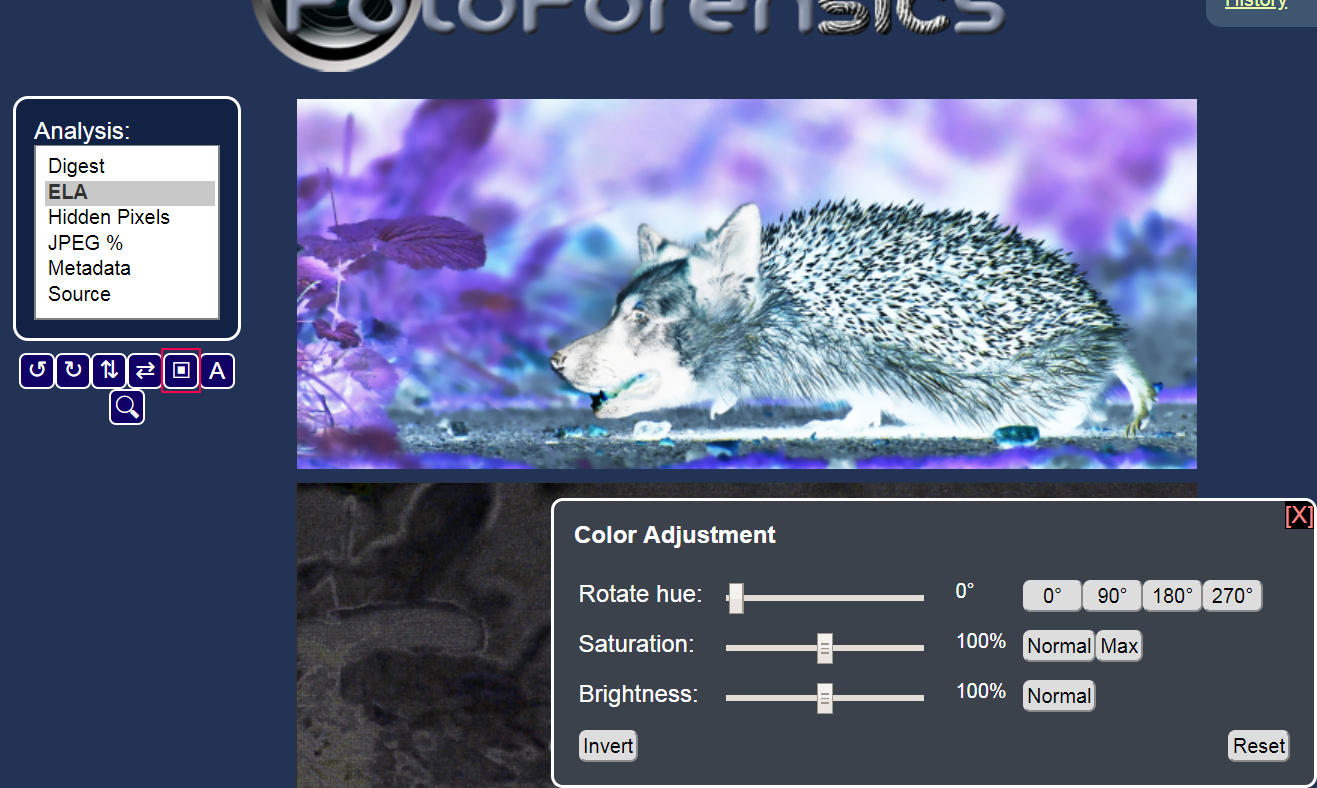

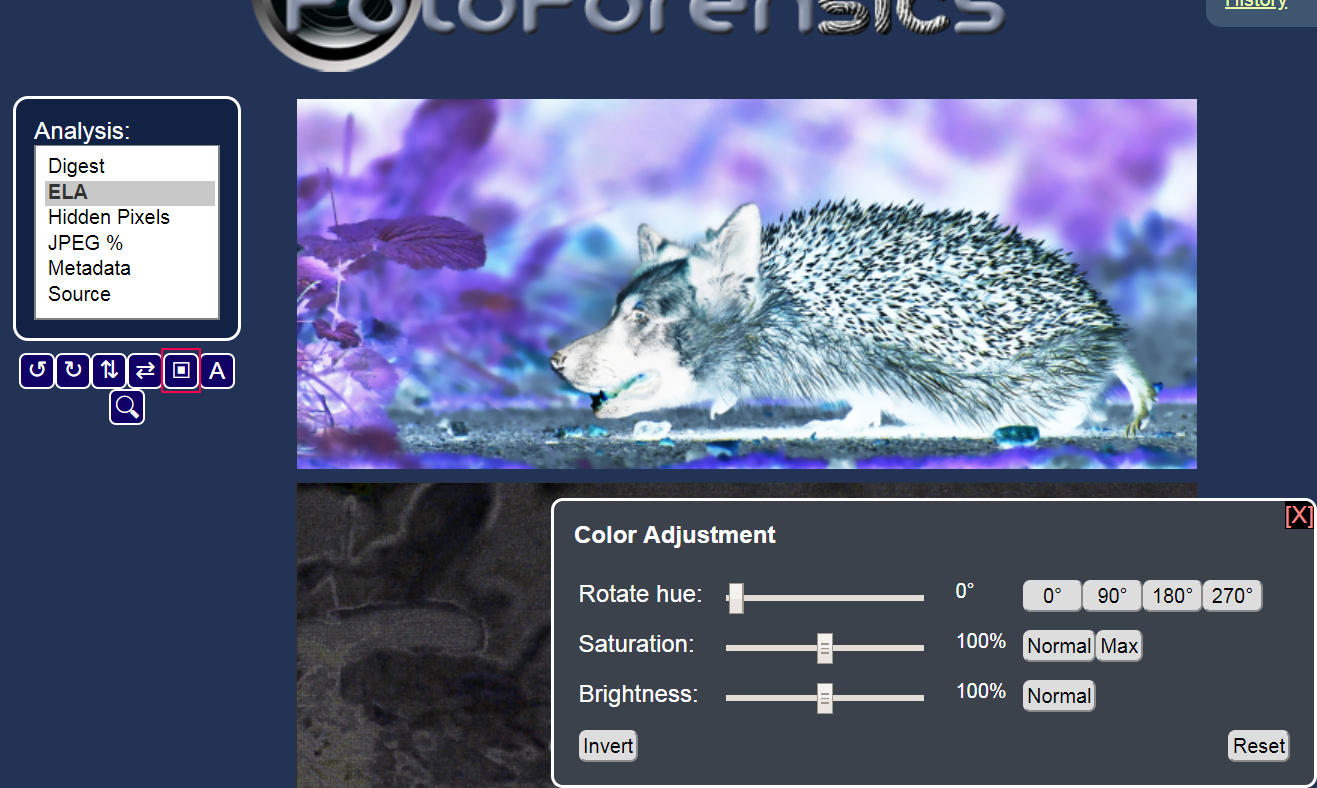

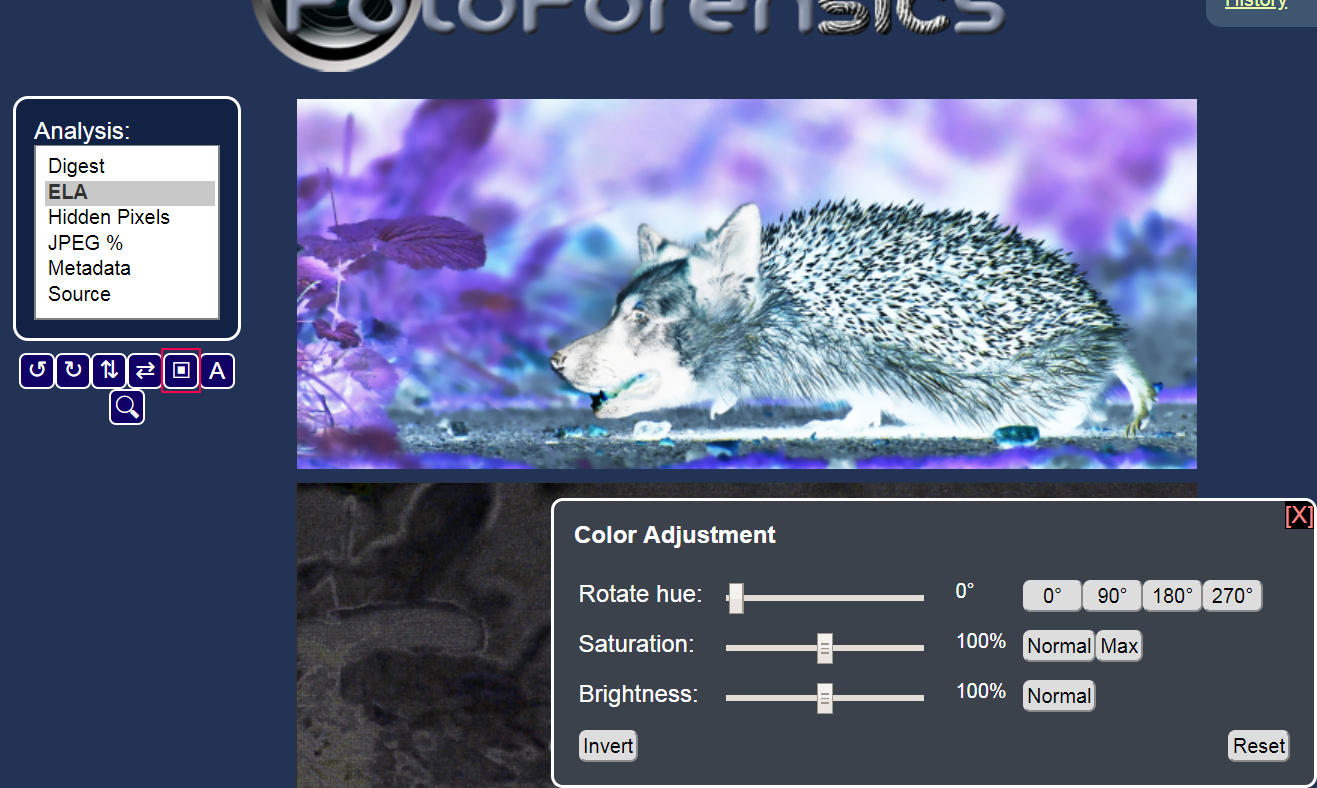

После того, как вы загрузили изображение, сервис его проанализирует и в открывшемся окне покажет оригинал (сверху) и загруженное фото (под оригиналом). В качестве примера я взяла явно отфотошопленный снимок и бесплатного фотостока.

Меню данных, которые можно отследить при помощи сервиса, располагается слева:

Digest («Дайджест») — базовое описание файла. Отображается название документа, размер, тип, дата последнего изменения.

ELA («Анализ уровня ошибок») — фильтр указывает наиболее измененные фрагменты изображения. Области, которые откорректированы больше всего, отмечены на нижнем фото белыми областями. В нашем случае видно, что кто-то добавил к изображению голову собаки.

Можете самостоятельно изучить данные этого фотоколлажа.

Если изображение не подвергалось постобработке, оно будет однородным, без ярко выраженных светлых, темных или радужных областей:

Сервис определяет не только наложение изображений. Если изменились настройки яркости снимка или контраст, фильтр ELA отобразит их как белые точки. Например, на этой фотографии улучшения коснулись головного убора, лямок костюма, а также глаз модели:

Обычно края предметов на изображениях имеют более высокий уровень ELA из-за более высокого контраста. Руки на фоне белой бумаги, текст в книге, светоотражающая полоска на куртке — у этих объектов высокий контраст и в фильтре ELA они будут отмечены белыми областями. При анализе разработчики советуют сопоставлять оригинал с проанализированным снимком. Если все подобные поверхности кроме одной имеют примерно одинаковый уровень ELA, то это должно вызвать подозрения.

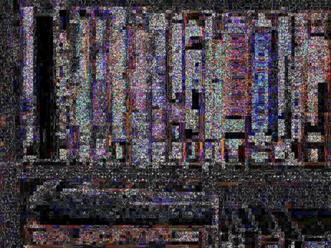

Края объекта, если бы он находился изначально на снимке, были бы однородными. Сильный шум на ELA (синие и красные полоски) признак того, что снимок был несколько раз пересохранен:

Каждый раз, когда фотографию сохраняют на жесткий диск, она теряет часть информации. Если фото много раз пересохранить на компьютере и вновь загрузить в FotoForensics, откорректированная область станет менее заметной. По этой причине проследить судьбу вирусного фото непросто: из-за многократного сохранения следы постобработки замыливаются. В таком случае попробуйте найти оригинал снимка или его самую старую версию.

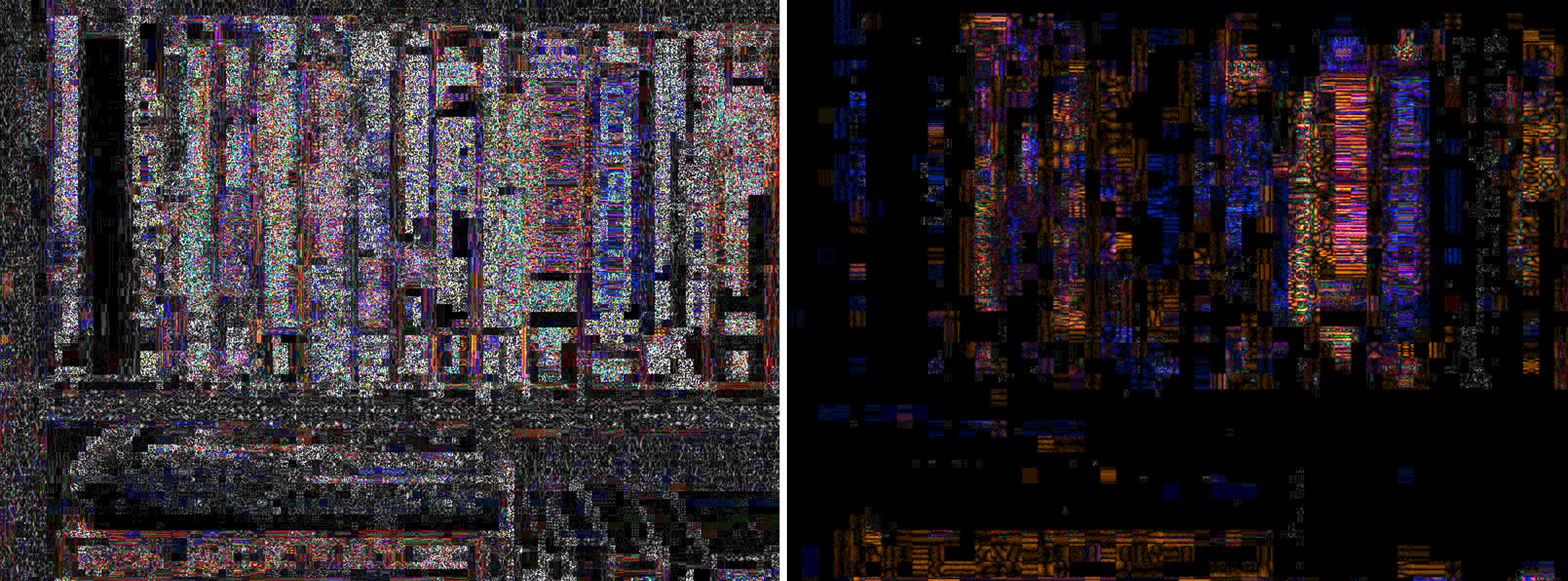

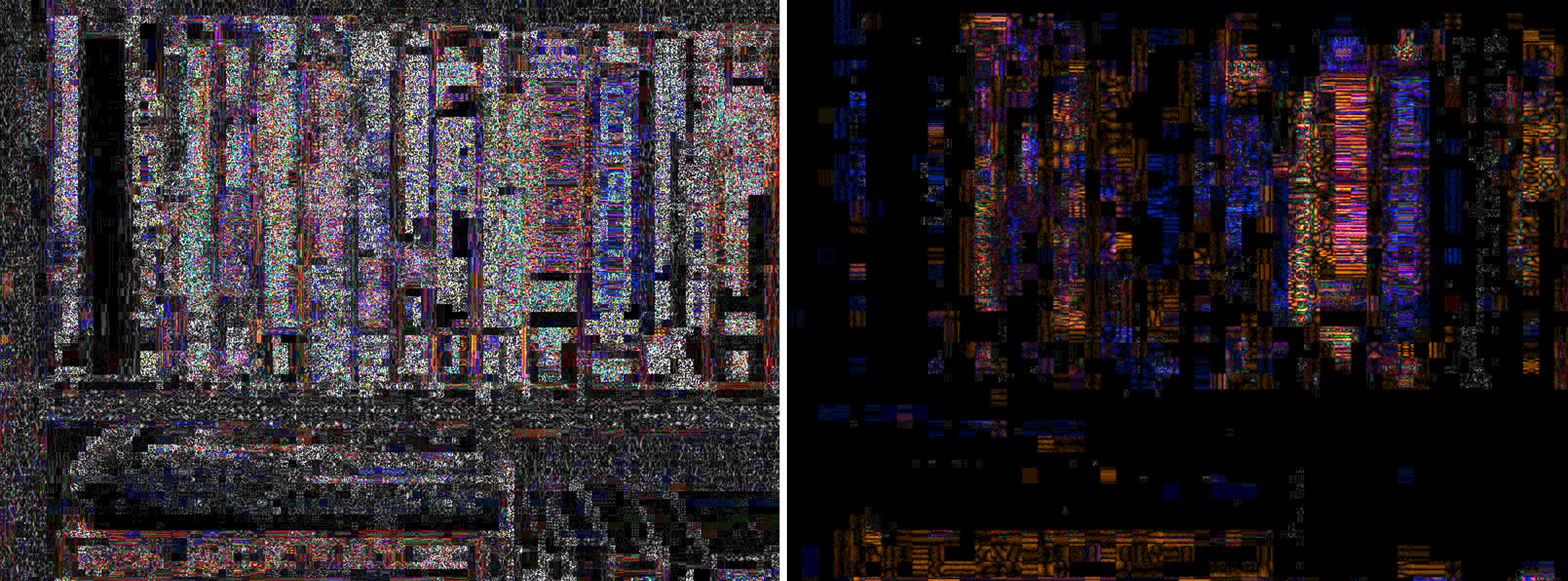

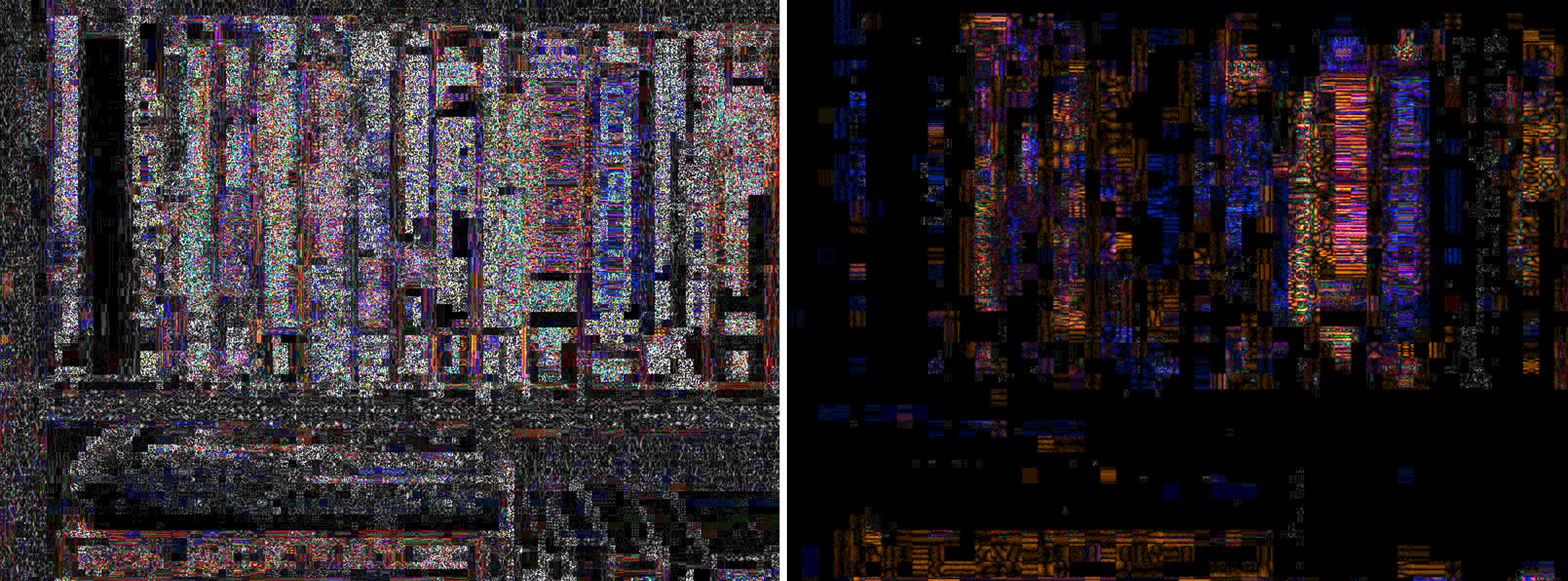

Мы взяли фото книжной полки, сохранили его несколько раз на компьютере и снова загрузили в сервис. На левом снимке (оригинал) предметы выглядят одинаковыми. На правом — часть информации утеряна, контрастные края предметов смазаны, много шумов.

Уменьшать размер фото могут и сами сайты, на которых изображения распространяются. Например, анализ снимка из Фейсбука или из Твиттера, которые сильно сжимают снимки, скажет о постобработке немного.

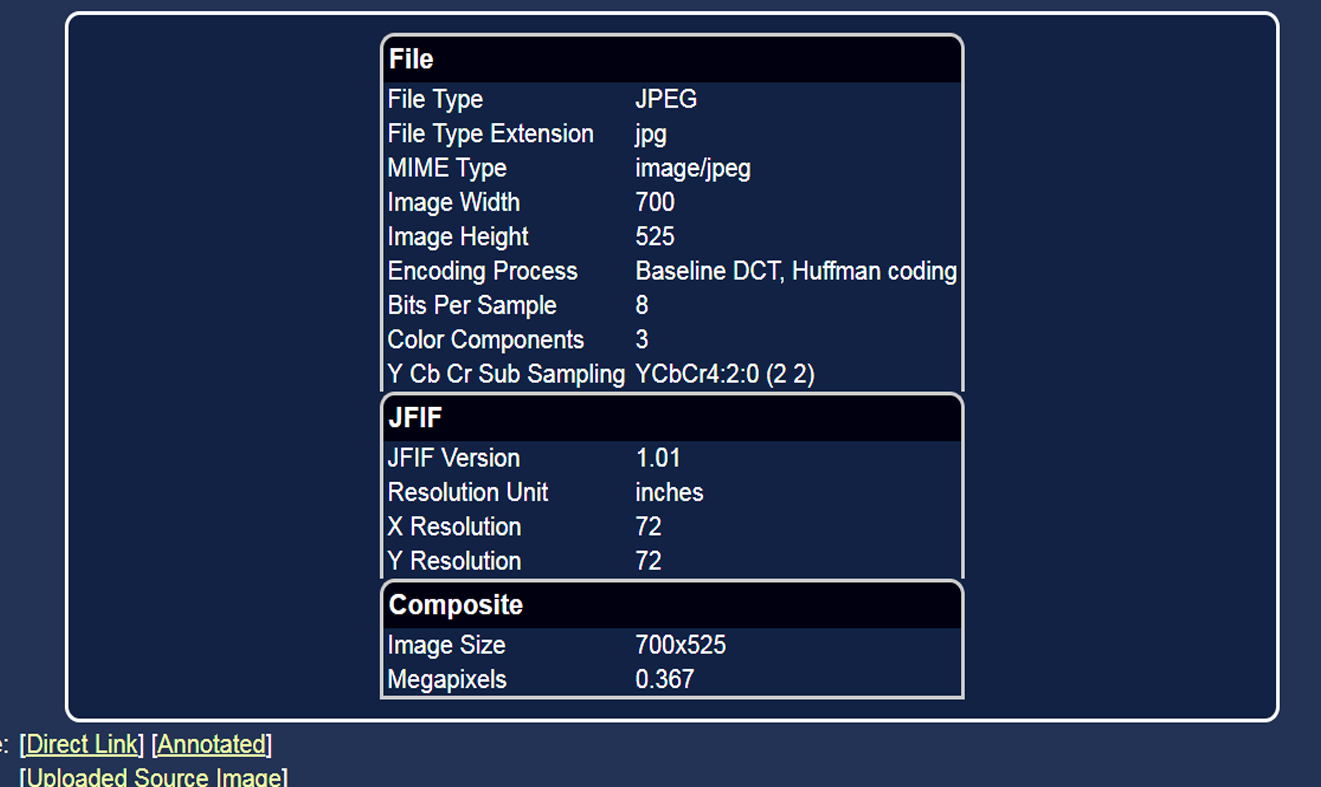

Hidden Pixels («Скрытые пиксели») — отображает скрытые пиксели, например, если на фото с расширением PNG есть прозрачный слой. Такие пиксели помогают косвенно идентифицировать приложения, в которых обрабатывалось фото: например, Gimp и PicMonkey окрашивают скрытые пиксели в черный, а Фотошоп — в белый.

JPEG% — объём сжатия JPEG. Этот параметр измеряется в процентах от уровня качества. Уровень 90% или выше считается высоким качеством, 80–89% — среднего качества, а 70–79% — низкого качества.

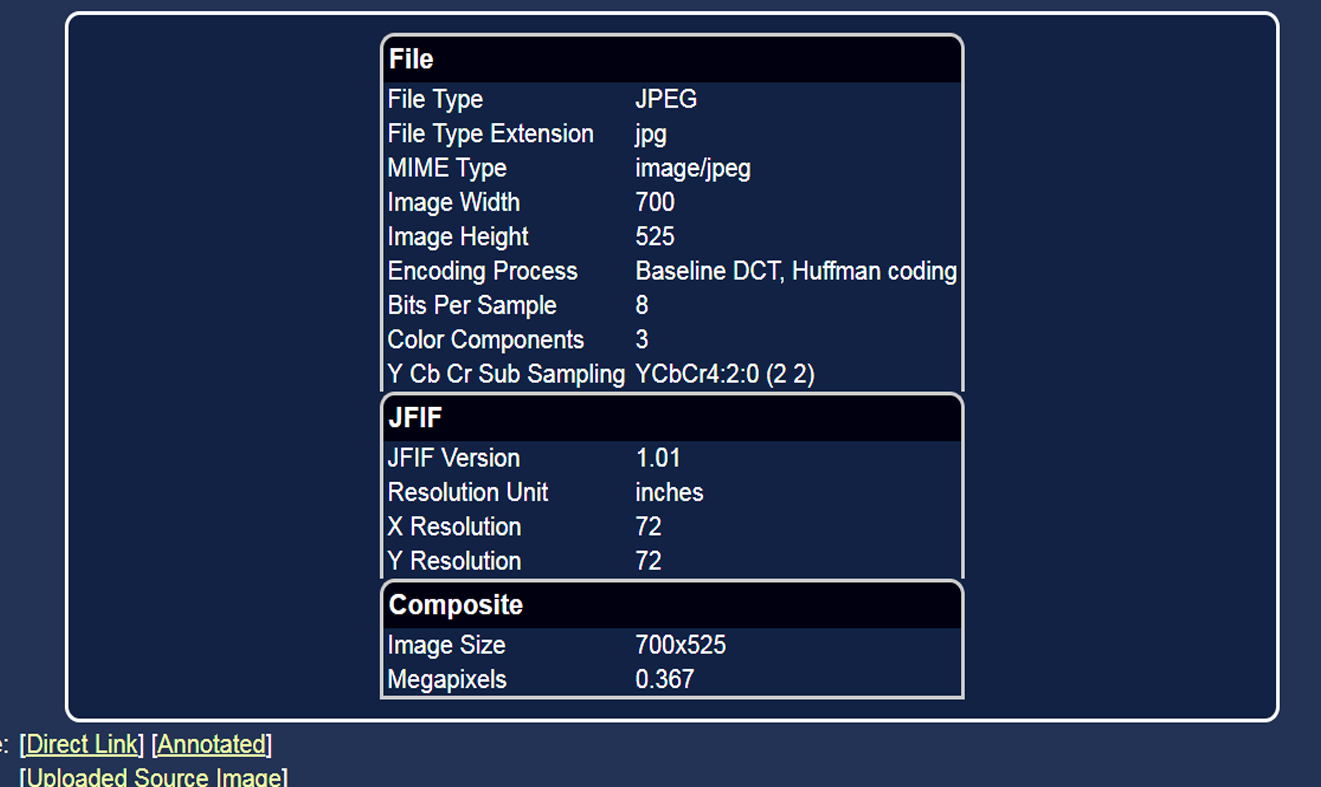

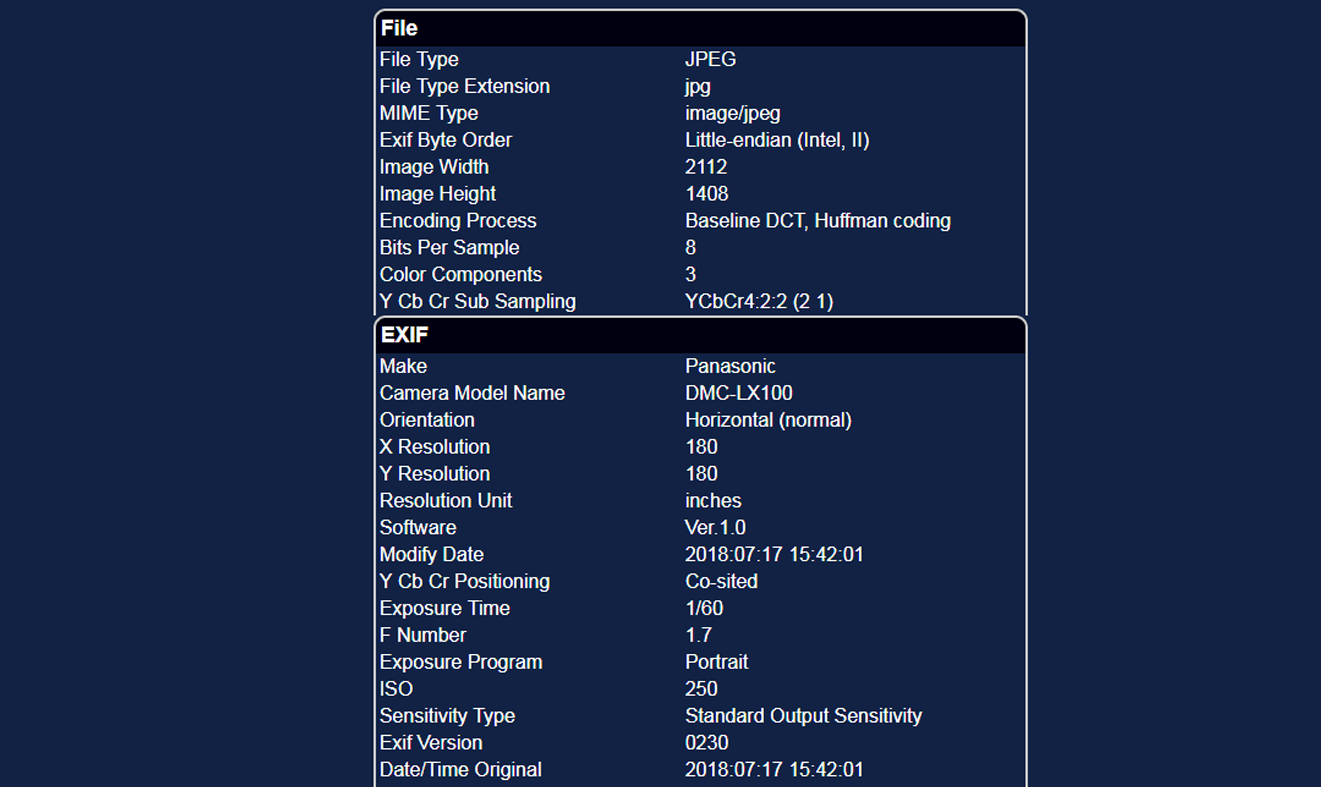

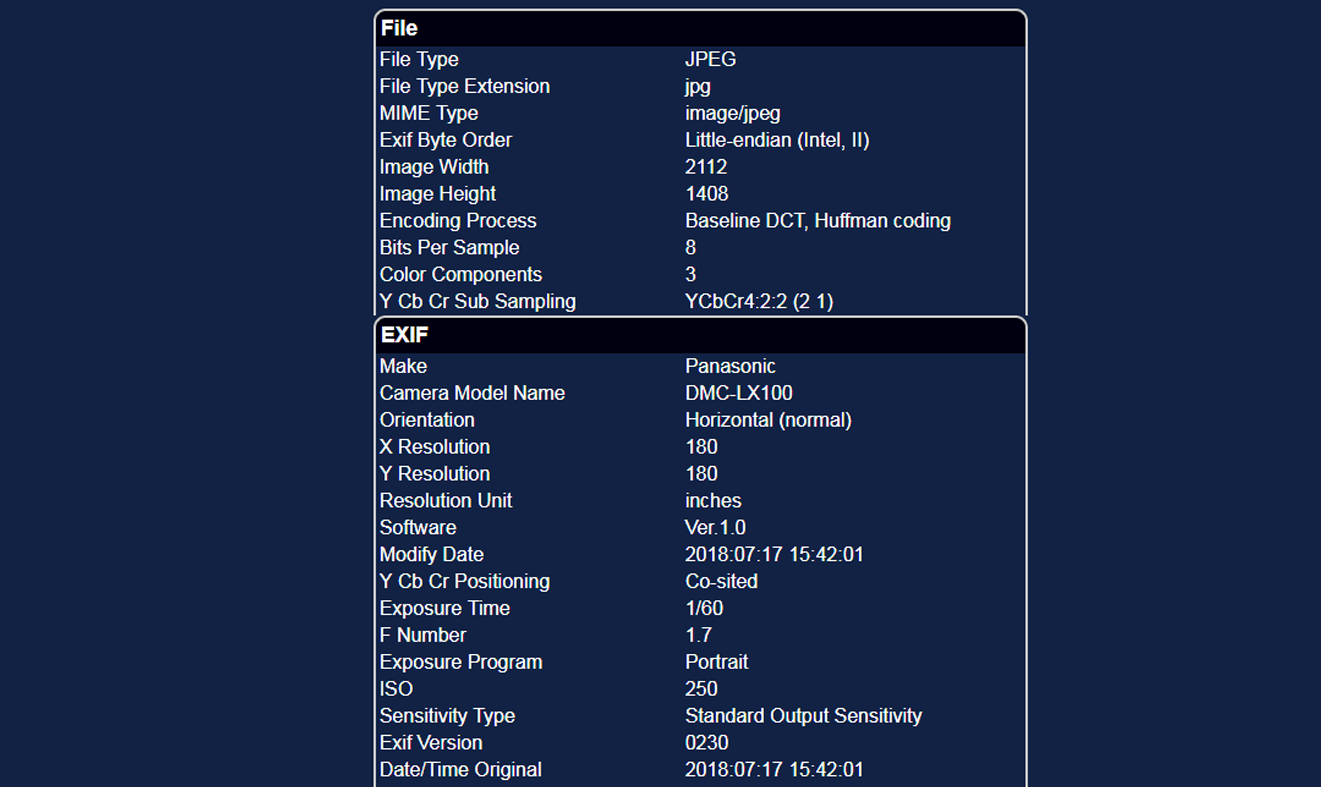

Metadata («Метаданные») — информация о снимке. Можно узнать на какое устройство, какой марки был сделан снимок, настройки фотокамеры (ISO, экспозицию, режим съемки и др.), время создания снимка, включая секунды, расстояние до объекта. Если фото сделано на мобильное устройство, то можно получить GPS-данные. Точное время и место съемки — важная информация для фактчекинга.

Если конкретных метаданных нет, то, скорее всего, перед вами не оригинальная фотография.

Source («Источник») — отображает загруженный вами снимок.

Как найти первоисточник

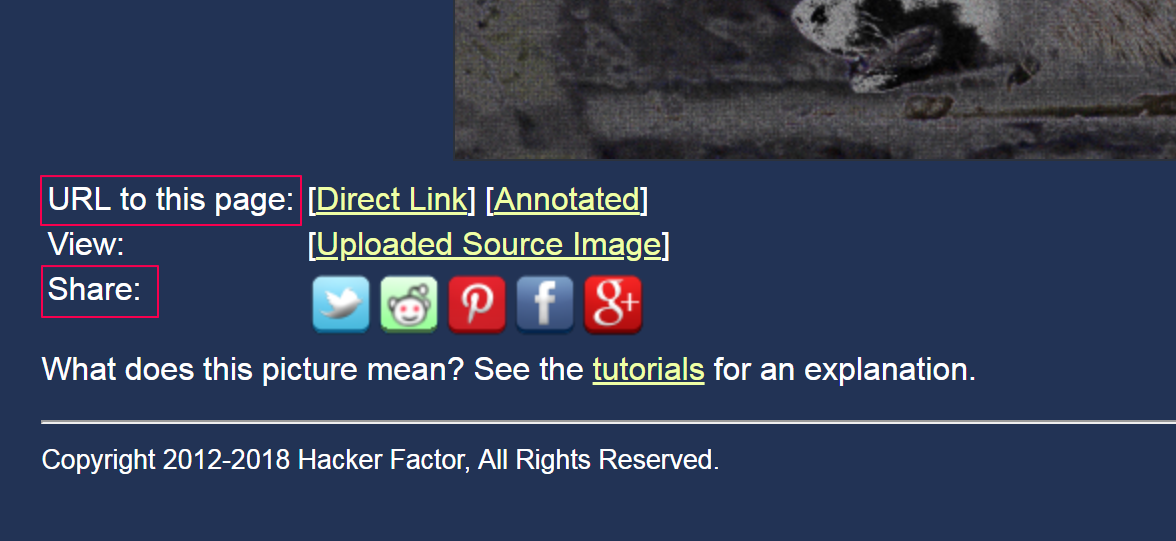

Ниже меню данных располагается панель обработки фото. Изображение можно поворачивать на 90 градусов вправо или влево, отображать по горизонтали или вертикали, работать с оттенком, яркостью, насыщенностью и инвертировать цвета.

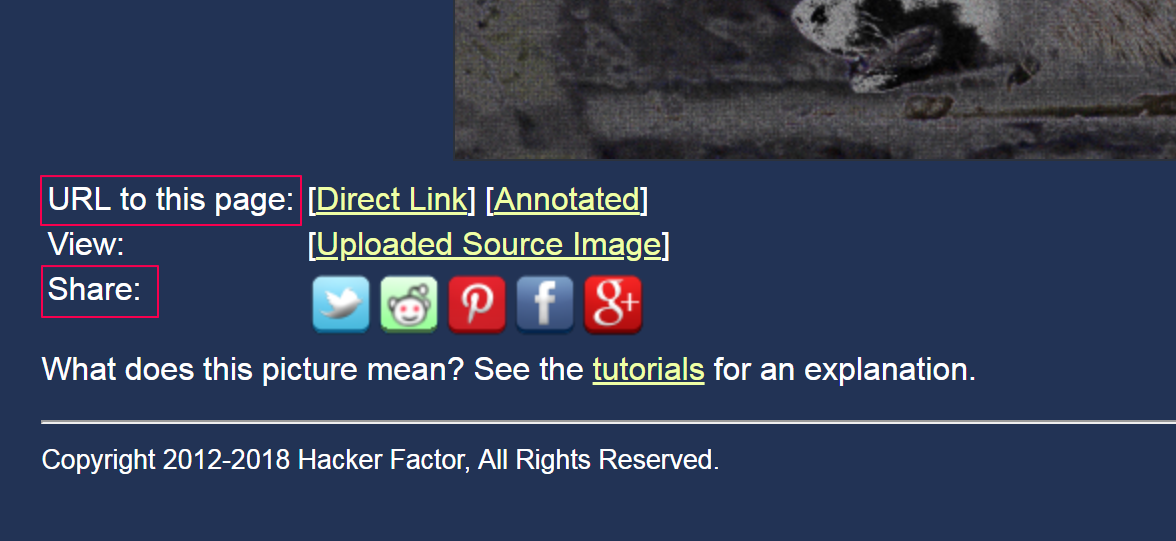

В десктопной версии сервис позволяет оставлять аннотации на проанализированном снимке — отмечать подозрительные или измененные области.

Изображение с такими отметками можно скачать на компьютер или сразу поделиться в соцсетях с помощью прямой ссылки. Эти кнопки расположены под рабочей областью.

Еще одна доступная функция — поиск по картинке. Кликните по кнопке с лупой, а затем выберите один из четырех сервисов, в которых можно поискать дополнительные сведения об изображении — сервис автоматически перенаправит на нужный сайт и сам загрузит картинку.

В TinEye ищите изображение с наибольшим расширением или загруженное раньше всего, чтобы установить первоисточник снимка.

Сервис поиска по картинке от Гугла не сможет вам помочь найти фото со значительными изменениями, зато обнаружит снимки, которые опубликованы в интернете всего несколько часов назад.

RootAbout — это коллекция общедоступных изображений, включая снимки НАСА, исторические фото, произведения искусства, обложки книг. Тут можно найти картинки с лицензией Creative Commons.

Сервис Karma Decay обнаружит снимки в социальной новостной сети Redddit (этот вариант поиска плохо работает с российскими IP).

Радужные овцы и три обезьяны

На FotoForensics есть интересная подборка примеров известных снимков, которые оказались фейками. Установить это удалось с помощью анализа ELA и изучения метаданных. Сайт предлагает их в качестве обучающих примеров для пользователей.

В 2014 году по новостным лентам разлетелось фото, где экс-президент Польши Бронислав Коморовский целует руку бывшему лидеру Войцеху Ярузельскому. Анализ снимка показал, что фигура склонившего Коморовского была вырезана из другого снимка и искусственно помещена на новое изображение. Обратите внимание на тень, которая падает на человека, стоящего за Ярузельским: на обработанном фото установить, кто ее отбрасывает нельзя. Эти несоответствия помогли найти оригинал снимка.

Легенда фотографии с цветными овцами гласила, что снимок сделан в 2007 году в Шотландии: один из фермеров покрасил животных нетоксичной краской, чтобы развлекать приезжих. Анализ FotoForensics выявил неоднородную текстуру изображения на шерсти овец. Кроме того, покрасить животное так, чтобы краска не опала на морду и сохранила четкие границы — практически невозможно. Дальнейший поиск по размеру изображения с помощью TinEye позволил найти необработанный снимок с теми же самыми овцами — их сфотографировали в 2003 году в американском штате Айдахо, а не в Шотландии.

Еще один пример — фотография из метро. Автор сравнил пассажиров с тремя обезьянами, олицетворяющими фразу «Ничего не вижу, ничего не слышу, ничего не скажу». Анализ с помощью ELA указывает на яркую белую область на медицинской маске у третьего слева пассажира.

Это говорит о том, что снимок подвергся постобработке, а элемент был добавлен на изображение цифровым способом.

Сервис FotoForensics позволяет установить подлинность фотографий, но не дает стопроцентную гарантию: кто-то случайно или нарочно мог нивелировать следы постобработки или изменить метаданные. Разработчики сервиса предупреждают, что не несут ответственности за выводы о постобработке, которые делают пользователи. Они призывают при анализе собирать как можно больше информации, обращать внимание на детали и сопоставлять оригинал снимка с проанализированным изображением.

Анализ уровня ошибки (ELA ) есть анализ артефактов сжатия в цифровых данных с сжатием с потерями, например, JPEG.

Содержание

- 1 Принципы

- 2 Ограничения

- 3 Споры

- 4 См. Также

- 5 Ссылки

- 6 Внешние ссылки

Принципы

При использовании сжатие с потерями обычно применяется единообразно к набору данных, например к изображению, что приводит к единообразному уровню артефактов сжатия.

В качестве альтернативы данные могут состоять из частей с разными уровнями артефактов сжатия. Это различие может возникать из-за того, что разные части неоднократно подвергались одному и тому же сжатию с потерями разное количество раз, или разные части подвергались разным видам сжатия с потерями. Следовательно, разница в уровне артефактов сжатия в разных частях данных может указывать на то, что данные были отредактированы.

В случае JPEG даже композит с частями, подвергнутыми одинаковому сжатию, будет иметь различие в артефактах сжатия.

Чтобы сделать обычно слабые артефакты сжатия более заметными, данные, подлежащие анализу, подвергаются дополнительному циклу сжатия с потерями, на этот раз на известном, однородном уровне, и результат вычитается из исходных исследуемых данных. Полученное разностное изображение затем проверяется вручную на предмет любых изменений в уровне артефактов сжатия. В 2007 г. Н. Кравец назвал этот метод «анализом уровня ошибок».

Кроме того, форматы цифровых данных, такие как JPEG, иногда включают метаданные, описывающие конкретное используемое сжатие с потерями. Если в таких данных наблюдаемые артефакты сжатия отличаются от ожидаемых из данного описания метаданных, то метаданные могут не описывать фактические сжатые данные и, таким образом, указывать на то, что данные были отредактированы.

Составное изображение, в котором разные части имеют разные уровни сжатия JPEG

Одно и то же изображение с равномерным сжатием JPEG качества 90%

Разница между двумя изображениями показывает различия в артефактах сжатия JPEG

Ограничения

По своей природе данные без сжатия с потерями, такие как изображение PNG, не могут подвергаться анализу уровня ошибок. Следовательно, поскольку редактирование могло быть выполнено с данными без сжатия с потерями, со сжатием с потерями, применяемым единообразно к редактируемым составным данным, наличие однородного уровня артефактов сжатия не исключает редактирования данных.

Кроме того, любые неоднородные артефакты сжатия в композите можно удалить, подвергая композит многократному равномерному сжатию с потерями. Кроме того, если цветовое пространство изображения уменьшается до 256 цветов или меньше, например, путем преобразования в GIF, тогда анализ уровня ошибок приведет к бесполезным результатам.

Более важно то, что фактическая интерпретация Уровень артефактов сжатия в данном сегменте данных является субъективным, и поэтому определение того, произошло ли редактирование, не является надежным.

Таким образом, артефакты сжатия JPEG, независимо от того, считаются они однородными или нет, не связаны с Манипуляции с фотографиями советской эпохи

Противоречие

В мае 2013 года доктор использовал анализ уровня ошибок на фото года World Press за 2012 год и заключил в своем блоге Hacker Factor, что это было «составной» с модификациями, которые «не соответствуют приемлемым стандартам журналистики, используемым Reuters, Associated Press, Getty Images, National Press Photographer’s Ассоциация и другие СМИ ». Организаторы World Press Photo в ответ позволили двум независимым экспертам проанализировать файлы изображений победившего фотографа и впоследствии подтвердили целостность файлов. Один из экспертов, Хани Фарид, сказал об анализе уровня ошибок, что «он неправильно маркирует измененные изображения как оригинальные и неправильно маркирует исходные изображения как измененные с той же вероятностью». Кравец ответил, пояснив, что «пользователь должен интерпретировать результаты. Любые ошибки в идентификации зависят исключительно от зрителя».

В мае 2015 года команда гражданской журналистики Bellingcat пишет, что анализ уровня ошибок показал, что Министерство обороны России редактировало спутниковые изображения, связанные с катастрофой рейса 17 Malaysia Airlines. В ответ на это эксперт по криминалистике изображений сказал об анализе уровня ошибок: «Метод субъективен и не полностью основан на науке», и что это «метод, используемый любителями». В своем блоге «Hacker Factor Blog» изобретатель анализа уровня ошибок Нил Кравец раскритиковал как использование Bellingcat анализа уровня ошибок как «неверное толкование результатов», так и по нескольким пунктам «незнание» Йенса Кризе в отношении анализа уровня ошибок.

См. также

- Анализ изображения

Ссылки

- «Учебное пособие: анализ уровня ошибок». fotoforensic.com. Проверено 23 июля 2015 г.

Внешние ссылки

- Image Forensics: Error Level Analysis

- FotoForensics

Как узнать, отфотошоплена ли картинка

Вам помогут наблюдательность, критическое мышление и пара специальных сервисов.

Если полагаете, что фото перед вами подвергалось монтажу, опробуйте приведённые способы — от простых к сложным.

Учтите, что не существует универсального метода отличить фотомонтаж от настоящего снимка. Опытный фотошопер может обойти любой способ и сделать фейк невероятно реалистичным. Кроме того, часто фотожабы попадаются вам на глаза после того, как их многократно сохранили и урезали, и распознать обман на такой картинке гораздо сложнее.

Осмотрите фотографию

Обратите внимание на следующие моменты.

1. Нереалистичность картинки

Самые грубые фейки можно отличить безо всяких инструментов — достаточно наблюдательности. Просто посмотрите на снимок в целом. Если на нём группа людей, посчитайте, сколько у них рук и ног, и удостоверьтесь, что у всех конечностей есть хозяева.

Прикиньте пропорции тел и голов людей на фото: часто неопытные фотожаберы вставляют на снимки чужие лица чересчур неаккуратно.

2. Деформированный фон

Когда начинающий фотошопер изменяет форму и размер объекта на снимке, то искривление может затронуть и фон. Например, некоторые мужчины на фото увеличивают свои мускулы, а женщины — грудь и бедра.

Однако если рядом с изменяемым объектом есть прямые линии, стены, дверные проёмы, то они тоже часто деформируются. И это сразу бросается в глаза. Например, вот целая галерея фотографий таких атлетов: эти парни реально пугают.

3. Отсутствие пор и морщин на лице

Даже самая идеальная кожа при ближайшем рассмотрении вовсе не гладкая: на ней есть морщинки, родинки, поры и пятна. Поэтому если лицо на фотографии напоминает мордашку фарфоровой куклы или модельки из видеоигры — перед вами монтаж.

4. Следы клонирования на картинке

Самый простой способ удалить что-либо с картинки — воспользоваться функцией «Штамп» в Photoshop или каком-нибудь другом редакторе изображений. Инструмент копирует участки фотографии, находящиеся рядом с обрабатываемой областью, и использует их, чтобы замазать нежелательные объекты.

Неумелые фотошоперы злоупотребляют этой функцией, в результате чего на картинке появляются абсолютно одинаковые кусочки, бросающиеся в глаза.

5. Неполадки с тенями и светом

Обратите внимание на свет и тени. Убедитесь, что всё объекты отбрасывают тень, причём в правильном направлении. Посмотрите, нет ли на снимке, наоборот, бесхозных теней. И если таковые имеются, значит, какой-то объект был удалён с картинки, а про тень ретушёр забыл.

Также проверьте свет. Если два человека или предмета на фото освещены по-разному, как будто у каждого свой источник света, — значит, снимок подвергся редактированию.

Поищите оригинал картинки

Просто загрузите картинку в поисковик и попробуйте найти похожие изображения. Если ваш снимок отфотошоплен, есть вероятность, что вы сможете обнаружить оригинал и увидеть, что именно ретушировалось.

Кроме того, полезно посмотреть на даты появления изображения в Сети — это тоже можно узнать с помощью поисковиков. Если вы видите снимок якобы с места недавнего события, но есть идентичные фото, датированные прошлым месяцем, — очевидно, что вас пытаются обмануть.

Можно воспользоваться Google, «Яндексом» или специализированным поисковиком TinEye. А лучше искать и там, и там — для надёжности.

- Поиск по картинке в Google →

- Поиск по картинке в «Яндекс» →

- Поиск по картинке в TinEye →

Посмотрите метаданные картинки

Это очень простой, хотя и не самый достоверный способ. Откройте метаданные EXIF вашего изображения и просмотрите их. Это можно сделать в свойствах файла: щёлкните по нему правой кнопкой мыши в «Проводнике» Windows или Finder в macOS.

Если повезёт, вы сможете увидеть модель камеры, дату съёмки и дату редактирования изображения. К снимкам, у которых заполнены поля с моделью фотоаппарата и временем съёмки, доверия чуть больше.

Когда изображение подвергается коррекции в Photoshop или другом редакторе, приложение может сохранить в метаданных картинки информацию о своей версии и операционной системе, в которой выполнялась ретушь.

Правда, таким образом можно подловить только неопытного ретушёра, ведь данные EXIF легко отредактировать. Кроме того, если фотограф просто подкрутил яркость, цвета и контраст, но больше ничего не менял, в метаданных всё равно будет указано, что снимок отфотошоплен.

Произведите цветокоррекцию

Некоторые фейки сделаны не так грубо, чтобы можно было распознать их невооружённым взглядом. И в этом случае вам на помощь придёт любой графический редактор или просмотрщик изображений, позволяющий осуществлять цветокоррекцию.

В Windows для изучения фото можно воспользоваться FastStone Image Viewer. Откройте в нём изображение и нажмите «Цвета» → «Коррекция цветов».

В macOS — встроенным «Просмотром». Щёлкните «Инструменты» → «Настроить цвет…».

Поиграйте с ползунками и, возможно, заметите на фотографии какие-то детали, которые не бросаются в глаза сразу.

- Подкрутите яркость и контраст. Тёмные области станут ярче, а яркие — темнее. Это позволит увидеть артефакты и склейки на фото.

- Увеличьте уровень насыщенности. Так тоже можно заметить на фото границы склейки рядом с объектами, добавленными при помощи монтажа.

- Увеличьте резкость. Возможно, обнаружите то, что пытались скрыть инструментом Blur, на размытых областях.

- Обратите цвета. В FastStone Image Viewer нажмите «Цвета» → «Негатив». В «Просмотре» macOS воспользуйтесь функцией «Инструменты» → «Настроить цвет…» и перетащите ползунки на гистограмме так, чтобы правый оказался слева, а левый — справа. Инвертирование цветов на снимке поможет рассмотреть замазанные области на однотонном фоне.

Проанализируйте шумы на фотографии

Это уже более сложный метод. Вряд ли новичку удастся с первого раза распознать, что не так в шумах на снимке, однако попробовать стоит.

Настоящие фотографии из-за несовершенства фототехники всегда имеют довольно высокий уровень шума. Графические же редакторы его практически не создают. Таким образом, изучив шумы на снимке, вы сможете выявить вставленный объект.

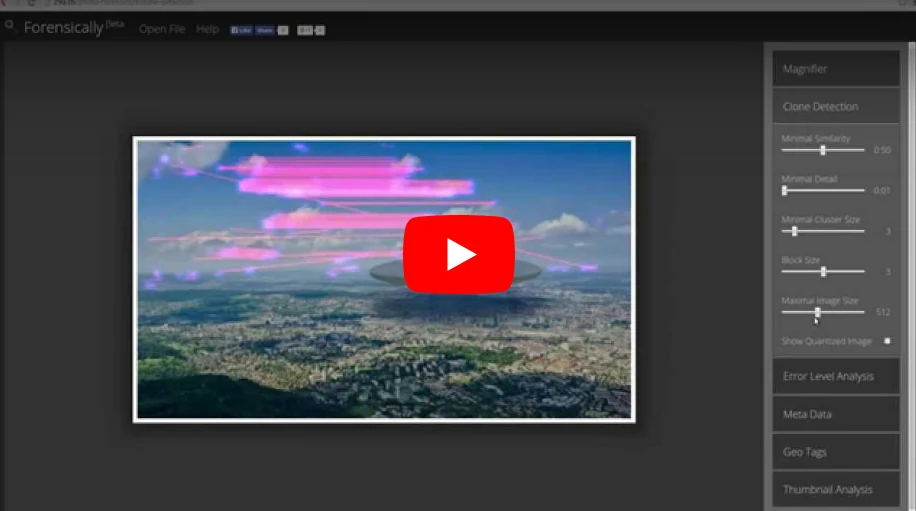

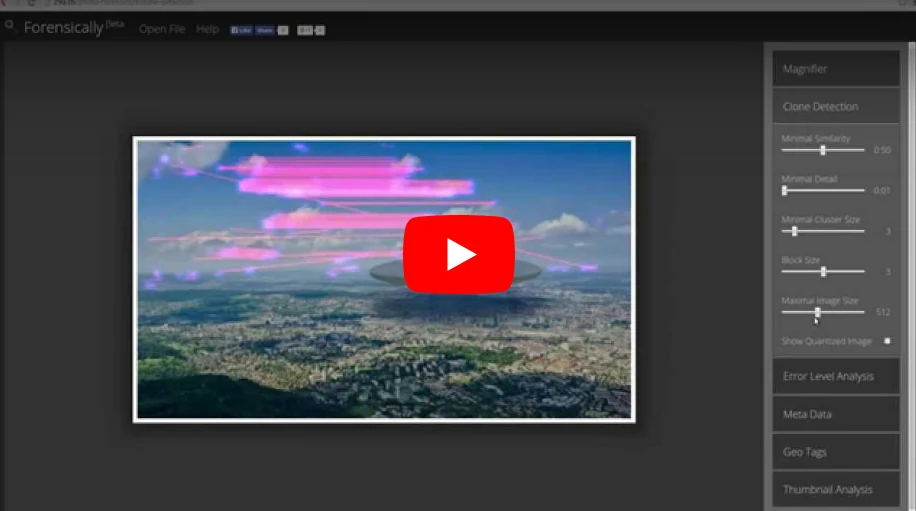

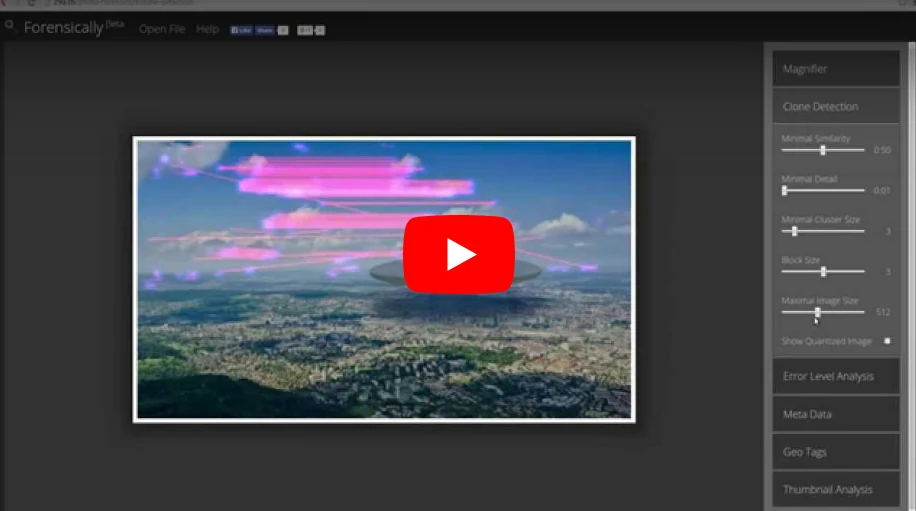

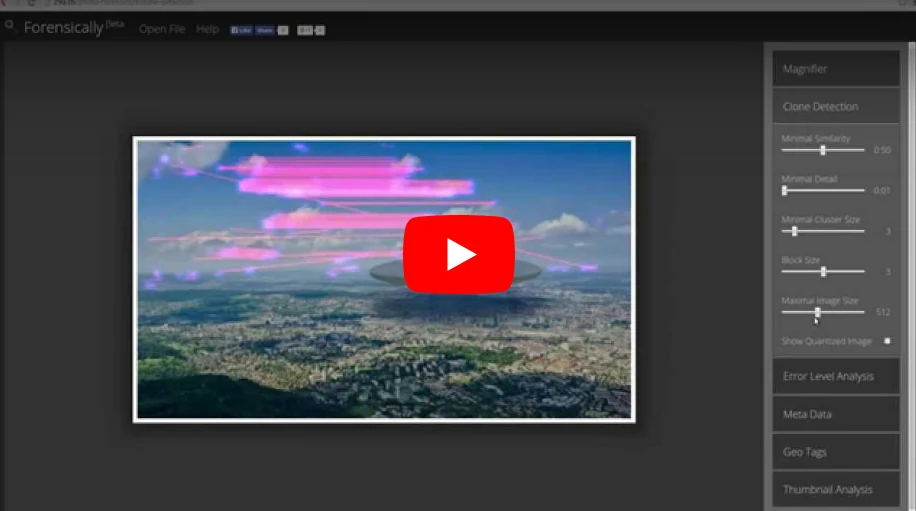

Для этого воспользуйтесь онлайн-инструментом Forensically. Откройте его, загрузите нужное изображение, а затем выберите вкладку Noise Analysis справа. Можете покрутить ползунки туда-сюда, чтобы изменить чувствительность. Чужеродные объекты будут выделяться на общем фоне.

Но учтите, что и этот метод можно обмануть. Так, если фотошопер вручную добавит шумы на фейк, отличить посторонние элементы будет в разы сложнее.

- Forensically →

Проанализируйте уровень ошибок

Error Level Analysis, то есть анализ уровня ошибок — это метод, который позволяет обнаружить артефакты при наложении одного изображения на другое. Посмотрев на снимок через фильтр ELA, вы увидите, что подвергшиеся коррекции области кажутся белее остальных. Если же фото не редактировалось, то оно выглядит однородным: ни один участок не будет темнее или светлее.

Forensically поддерживает и этот метод. Чтобы исследовать подозрительную картинку через фильтр ELA, загрузите её в сервис и выберите пункт Error Level Analysis справа.

Однако если фотография была много раз пересохранена или её размер изменяли, то следы монтажа замылятся и ELA не поможет их найти.

Читайте также 🧐

- Как понять, что вам врут в новостях: 7 распространённых уловок

- Как опубликовать резкое и качественное фото в Instagram*

- Как сделать хорошее фото: 6 базовых принципов

*Деятельность Meta Platforms Inc. и принадлежащих ей социальных сетей Facebook и Instagram запрещена на территории РФ.

Как определить монтаж на фото

Разоблачаем фейки, фотошоп и ретушь

02 апреля 2017 — 40 комментариев — 188942 просмотра — 3300 слов

В 1855 году пионер портретной фотографии Оскар Рейландер сфотографировал себя несколько раз и наложил негативы друг на друга при печати. Получившееся двойное селфи считается первым фотомонтажом в истории. Наверное лайков тогда собрал, уух…

Теперь же каждый подросток с фотошопом, смартфоном и интернетом сможет даже лучше. Правда чаще всего эти коллажи неимоверно доставляют. А вот профессионалы научились скрывать свою работу весьма качественно. Это был вызов.

Совокупность методов анализа модифицированных изображений назвали Image Forensics, что можно перевести как «криминалистика изображений». В интернете существует куча сервисов, заявляющих, что они за два клика помогут определить подлинность фото. Особенно доставляют самые тупые, которые идут смотреть EXIF и если там нет оригинальных метаданных камеры начинают громко вопить «вероятно фото было модифицировано». И про них даже в New York Times пишут (а про тебя нет).

Я пересмотрел около десятка сервисов и остановился на одном: Forensically. В нём реализовано большинство описанных в статье алгоритмов, я буду часто на него ссылаться. Все описанные методы названы оригинальными английскими названиями, чтобы не было путаницы.

Однако возможность загрузить свою фотку в какой-то сервис и посмотреть на красивые шумы не сделает из вас сыщика. Поначалу может быть трудно и непонятно, а первые эксперименты точно окажутся неудачными. У меня так же было. Тут как в спорте — нужен намётанный глаз и опыт как должно и не должно быть. Умение не просто смотреть на шумные картинки, а видеть еле заметные искажения в них.

Не существует 100% метода, позволяющего определить фейк. Но есть человеческие ошибки.

Найдет самые глупые косяки

Главный инструмент — наши глаза. Так что первым делом стоит открыть фото в любимом графическом редакторе или просмотрщике, поставить зум в 1000% внимательно втыкать в предположительное место монтажа. С этого начинается любой анализ. Чем более неопытный монтажер попался — тем проще будет найти косяки, артефакты и склейки. Иногда фейки настолько кривые, что можно нагуглить оригинал используя поиск по изображениям или заметив несоответствия в EXIF.

Помимо этого, в любом уважающем себя редакторе есть инструменты для цветокоррекции. В Preview.app на маке они спрятаны в меню Tools > Adjust Color… Вытягивание различных ползунков поможет лучше разглядеть детали.

Brightness and contrast. Сделать темные области ярче, а яркие темнее. Теоретически поможет лучше разглядеть артефакты, склейки и другие места, которые неопытный фотошопер просто замазюкал темненьким и посчитал, что не заметят.

Color adjustment. Увеличивая насыщенность или яркость разных цветов, можно заметить неестественные переливы и границы склейки.

Invert. Часто помогает увидеть скрытую информацию в однотонных объектах.

Sharpen and blur. Добавление резкости поможет прочитать надписи на табличках, есть целые сервисы, которые могут побороть заблюренные области.

Normalization and histograms. Работа с гистограммой по сути объединяет сразу несколько методов в один. Если вы прошарены в графике — гистограммы будут серьезным оружием.

Даже если определить фейковость сразу не удалось, у вас уже могли появиться полезные наблюдения, чтобы перейти к следующим методам с страшными математическими названиями.

Найдет свежую кисть, деформацию, клонирование и вставку чужеродных частей

Реальные фотографии полны шума. От матрицы камеры или фотосканера, от алгоритмов сжатия или по естественным природным причинам. Графические редакторы же этот шум не создают, их инструменты живут в «идеальном мире», потому чаще всего «размазывают» шум оригинального изображения. Кроме того, два изображения чаще всего обладают разной степенью зашумленности.

Заметить шум глазом не так-то просто, но можно взять любой инструмент Noise Reduction и инвертировать его действие, оставив от фотографии только шум. Хорошо работает для свежеобработанных изображений и в случаях, когда автор решил, что нашел очень подходящие на вид изображения. Но легко обманывается, если знать как.

Поиграть самому можно здесь.

Добавить своего шума. Самый очевидный вариант. Хочешь скрыть свои косяки — навали на фото столько шума, чтобы забить оригинальный.

Пережать JPEG. Уменьшение качества изображение в два раза делает шумы неразличимыми (вот исследование).

Найдет свежие артефакты наложения изображений или текста

Каждый раз при сохранении картинки ваш редактор заново прогоняет её через кучу преобразований — конвертирует цвета, делит на блоки, усредняет значения пикселей, и.т.д. Он занимается этим даже если вы выбрали 100% качество при сохранении, так уж устроен алгоритм JPEG. Интересующиеся могут почитать про него глубокую статью полную косинусных преобразований.

Так как JPEG — формат сжатия с потерями, то при каждом сохранении растет количество математических усреднений, ошибок или более популярный термин — «артефактов». Два сохранения с 90% сжатием примерно эквивалентно одному с 81% по количеству этих самых артефактов. На практике это может принести пользу. Даже если зоркий глаз не видит разницы между 80% и 85% сжатием, то наверное есть инструменты, которые наглядно покажут это различие? Да, Error Level Analysis или ELA.

Фейки с наложениями чаще всего делают подыскав нужные изображения где-нибудь в гугле. Вероятность, что найденные изображения будут с одинаковым уровнем артефактов, ну, крайне мала. Социальные сети или даже специализированные хранилища фотографий всё равно пережимают изображения под себя при загрузке, чтобы не платить за хранение гигабайтов ваших селфи из отпуска. Обратное тоже верно — если вы накладываете на найденное в интернете изображение свежую фотографию со своей камеры, она будет заметно выделяться по качеству. Заметно не для глаза, а для ELA — он покажет разительно меньше артефактов на вашей новой фотографии.

Простота и известность делает ELA самым популярным методом работы мамкиных интернет-сыщиков, от чего его начинают пихать везде, где только могут. Как будто других методов просто не существует и ELA может объяснить всё. Тот же Bellingcat использует его чуть ли не в каждом втором своём расследовании. Хотелось немного остудить пыл всех услышавших новую умную аббревиатуру.

ELA — не панацея. Сфотографируйте летящую чайку на фоне ровного синего неба (ага, особенно в Москве), сохраните её в jpg и прогоните через анализатор ошибок. Результат покажет просто огромное количество артефактов на чайке и их полное отсутствие на фоне, из чего начинающие сразу сделают вывод — чайка прифотошоплена. Да что там начинающие, сама команда Bellingcat с этим бывало глупо и по-детски наёбывалась. Алгоритм JPEG достаточно чисто работает на ровных цветовых областях и градиентах, и куда больше ошибается на резких переходах — отсюда такой результат, а не из-за ваших домыслов.

Из-за растущей популярности Error Level Analysis я уже слышал призывы запретить и не принимать его всерьез. Не буду столь категоричен, лишь посоветую не бежать писать разоблачения, если ELA показал вам какие-то шумы на краях. ОН НЕ ТАК РАБОТАЕТ. Думайте головой и помните как JPEG устроен внутри. Вот если ELA очертил четкий квадрат там, где его не должно быть, либо заметил разительную разницу в шумах при неотличимости на глаз — наверное стоит задуматься. Не уверены — проверяйте другими методами.

Поиграть с ELA можно тут.

Много раз пересохранить. Все свои манипуляции алгоритм JPEG делает внутри блоков максимум 8×8 пикселей. В теории нужно 64 раза пересохранить изображение, чтобы уровни ошибок стали неотличимы друг от друга. На практике же это происходит гораздо раньше, достаточно пересохранить картинку раз 10 и ELA, да и некоторые другие методы, больше не увидят ничего полезного.

Изменить размер. Чтобы не напрягаться с пересохранением можно поступить еще проще — отресайзить изображение на какой-нибудь коэффициент не кратный степени двойки. То есть в 2 раза (50%) уменьшить не подойдет, а вот что-нибудь типа на 83% — уже всё, никакой ELA больше не поможет.

Смонтировать из одного источника или из lossless-формата. Вы сфотографировали двух людей на свой фотоаппарат, или скачали фотографии из какого-нибудь блога, где автор скорее всего пересохранял их всего раз-два. Либо наложили друг на друга две PNG’шки. Во всех этих случаях ELA не покажет ничего интересного.

Найдет ретушь, компьютерную графику, хромакей, Liquify, Blur

В жизни свет никогда не падает на объекты абсолютно равномерно. Области ближе к источнику всегда ярче, дальше — темнее. Никакого расизма, только физика. Если разбить изображения на небольшие блоки, скажем 3×3 пикселя, то внутри каждого можно будет заметить переход от более темных пикселей к светлым. Примерно так:

Направление этого перехода так и называется — градиент освещенности. Можно попробовать нарисовать кучу маленьких стрелочек на изображении и понаблюдать за их направлением.

На первом изображении свет падает сверху и стрелочки направлены хаотически — это характеризует рассеянный свет. Второе изображение — компьютерная графика, на ней свет падает слишком идеально, никаких шумов и отклонений как на настоящем фото. Третье изображение — фотография с резким переходом, в центре стрелочки массово смотрят в самую яркую сторону, а на фоне — рассеяны так же, как на первом фото.

Рисовать стрелочки хоть и наглядно, но мы физически не сможем изобразить все градиенты освещенности для каждого блока поверх картинки. Стрелочки займут всё изображение и мы не увидим ничего. Потому для большей наглядности придумали не рисовать их, а использовать цветовое кодирование. Для направления вектора понадобится две координаты, и еще одна для его длины — а у нас как раз есть для этого три цветовых компоненты — R, G, B. В итоге получатся вот такие карты освещенности.

В реальной жизни нас окружает ограниченное число источников света. В помещении это лампы, вспышки, окна. В ясный день на улице чаще всего источник света только один — это Иисус, спаситель наш солнце. Если на карте освещенности находящиеся рядом объекты сильно отличаются по направлению падения света — у нас есть главный кандидат на монтаж.

Но еще лучше карты освещенности справляются с определением ретуши. Surface Blur, Liquify, Clone Stamp и другие любимые инструменты фотографов начинают светиться на картах освещенности как урановые ломы тихой весенней ночью. Нагляднее всего выглядит анализ фотографий из журналов или рекламных плакатов — там ретушеры не жалеют блюра и морфинга, а это непаханное поле для практики.

Лично я считаю карты освещенности одним из самых полезных методов, потому что он чаще всего срабатывает и мало кто знает как его обмануть. Поиграться можно здесь.

Не знаю. Говорят помогает изменение яркости и насыщенности цветов по отдельности, но на бытовых фотографиях такие вещи всегда будут заметны глазу. Если вы знаете простой и действующий метод — расскажите в комментах под этим абзацем, всем будет интересно.

Найдет копипаст, вытягивание и несоотвествие цветов, Healing Brush, Clone Stamp

Метод PCA или на русском «метод главных компонент». Чтобы ко мне не придрались, мол, слишком просто всё рассказываешь и наверное не шаришь, вот описание PCA для рептилоидов.

Метод главных компонент осуществляет переход к новой системе координат y1,…,ур в исходном пространстве признаков x1,…,xp которая является системой ортонормированных линейных комбинаций. Линейные комбинации выбираются таким образом, что среди всех возможных линейных нормированных комбинаций исходных признаков первая главная компонента обладает наибольшей дисперсией. Геометрически это выглядит как ориентация новой координатной оси у1 вдоль направления наибольшей вытянутости эллипсоида рассеивания объектов исследуемой выборки в пространстве признаков x1,…,xp. Вторая главная компонента имеет наибольшую дисперсию среди всех оставшихся линейных преобразований, некоррелированных с первой главной компонентой. Она интерпретируется как направление наибольшей вытянутости эллипсоида рассеивания, перпендикулярное первой главной компоненте. Следующие главные компоненты определяются по аналогичной схеме.

А теперь для людей: представьте, что цветовые компоненты R, G и B мы взяли как оси координат — каждая от 0 до 255. И на этом трехмерном графике точками отметили все пиксели, которые есть на нашем изображении. Получится что-то похожее на картинку ниже.

Можно заметить, что наши пиксели не рассосались по графику равномерно, а вытянулись в округлую колбасятину. Все реальные изображения так устроены, потому что science, bitches. Теперь мы можем построить новые оси — вдоль колбасятины (это самая главная) и две поперек — это и будут те самые «главные компоненты». Для каждого изображения набор цветов будет разным, колбасятина и главные компоненты будут направлены по-своему.

Так что вся эта математика нам дает? Дело в том, что если какие-то цвета на изображении стоят «не на своих местах» — они будут сильно выделяться из этого облака пикселей, то есть на карте PCA начнут светиться ярким белым цветом. Это может означать локальную цветокоррекцию или же полную вклейку. Диаграммы PCA может построить тот же Forensically. На них будет изображено расстояние от каждого пикселя картинки до плоскости 1, 2 и 3 главной компоненты. Так как расстояние — это число, то изображения будут черно-белыми.

Но еще более полезным свойством PCA является то, что он превращает JPEG-артефакты в очень заметные «квадраты». Даже если вы обманули ELA из предыдущего пункта пережатиями и ресайзом, то PCA этим не проведешь — он работает с цветом. Иногда артефакты сразу видно, например если исходное изображение увеличивали для вклейки. В других случаях сматриваться придется чуть более внимательно, чтобы заметить разницу в квадратах на изображении.

Как видно из примеров, PCA не очень наглядный и требует ну уж очень сильно присматриваться к таким мелким косякам, которые вполне могут оказаться случайностями. Потому PCA редко используется в одиночку, его применяют как дополнение к другим.

Самому поиграться можно здесь.

Заблюрить. Любой блюр смазывает соседние цвета и делает «колбасятину» более округлой. Хороший блюр сильно затруднит исследование по методу PCA.

Еще хитрее изменить размер. Хотя PCA и более устойчив к изменение размеров изображения, говорят можно попробовать подобрать такой процент, чтобы обмануть даже его.

Найдет различия в резкости, отклонения в фокусе, ресайз

Дискретное вейвлет-преобразование очень чувствительно к резкости объектов в кадре. Если фотографии сняты на разные объективы, использовался зум или просто немного отличалась точка фокусировки — после DWT эти отличия будут намного виднее. То же самое произойдет, если у какого-то объекта в кадре изменяли размер — резкость таких частей будет заметно ниже.

Без лишних погружений в теорию сигналов, вейвлет — это такая простенькая волнушка, как на картинке ниже.

Их придумали лет 100 назад, чтобы приблизительно описывать аналоговые сигналы. Одну большую длинную волну представляли набором мелких вейвлетов, тогда некоторые её характеристики внезапно становилось проще анализировать, да и места чтобы хранить надо было меньше. На вейвлет-сжатии например был построен формат JPEG-2000, который к нашему времени (к счастью) сдох.

Картинка — это тоже двухмерный сигнал из цветных пикселей, а значит её можно разложить на вейвлеты. Для достаточно точного приближения изображения 800×600 требуется до 480000 вейвлетов на цветовой канал. Если уменьшать это количество — будет сильно падать резкость и цветопередача. Но что это даёт, кроме сжатия?

А вот что: вейвлеты приближают области с разной резкостью по-разному. Чем плавнее переходы — тем проще плавному по своей природе вейвлету его воспроизвести, а чтобы приблизить резкий переход — надо больше вейвлетов. Это как пытаться сделать из кучи шариков идеальный куб.

Если части изображения были смонтированы с изначально разной резкостью — это можно будет заметить. Увеличили картинку — проиграли в резкости, уменьшили — наоборот всё стало слишком резким. Даже если взять две фотографии снятые на камеру с автофокусом из одной точки — они будут отличаться по резкости из-за погрешности автофокуса. DWT устойчив даже перед блюром, ведь редакторы ничего не знают про резкость исходных частей изображения.

На практике полезно рассматривать приближения с помощью 1%, 3% или 5% вейвлетов. На этом количестве перепады в резкости становятся достаточно заметны глазу, как видно на примере одного из участников соревнования по фотомонтажу, который не определяется другими методами, но заметен при вейвлет-преобразовании.

Сделать фотографии с одной точки, одним объективом с фиксированным фокусом и сразу обработать в RAW. Редкие студийные условия, но всё может быть. Сколько вон лет разбирали всякие видео с Усамой Бен-Ладеном, целые книги писали.

Изображение очень маленькое. Чем меньше изображение — тем сложнее его анализировать вейвлетами. Картинки меньше 200х200 пикселей можно даже не пытаться прогонять через DWT.

Погружаясь в тему Image Forensics начинаешь понимать, что любой из методов можно обмануть. Одни легко обходятся с помощью пережатых до 10 шакалов JPEG’ов, другие цветокоррекцией, блюром, ресайзом или поворотом изображения на произвольные углы. Оцифровка журнала или TV-сигнала тоже добавляет ошибок в исходник, усложняя анализ. И тут вы начинаете понимать:

Вполне возможно отфотошопить изображение так, что никто не докажет обратное. Но для этого надо не быть глупеньким.

Зная эти методы, можно скрыть монтаж настолько, чтобы потом сказать в стиле пресс-секретаря президента: «эти картинки — лишь домыслы ангажированной кучки людей, мы не видим на них ничего нового». И такое вполне вероятно.

Но это не значит, что занятие полностью бесполезно. Здесь как в криптографии: пока те, кто делает фейки не знают матчасти так же глубоко — сила на стороне знаний, математики и анализа.

Приглашаю экспертов высказаться в комментарии. При подготовке поста я написал нескольким разбирающимся в теме профессионалам в лички, но ответа до сих пор не получил.

_Ну а чтобы стимулировать новые посты, подпишитесь на рассылку или пошарьте этот пост у себя. Специльно сделал удобные кнопочки чуть ниже. Так я буду видеть, что всё это хоть кому-то интересно.

Forensically is a set of free tools for digital image forensics. It includes clone detection, error level analysis, meta data extraction and more. It is made by Jonas Wagner.

You can read a bit more about it in this blog post.

You should think of forensically as a kind of magnifying glass.

It helps you to see details that would otherwise be hidden.

Just like a magnifying glass it can’t tell true from false or good from evil,

but it might just help you to uncover the truth.

Also absence of evidence is still not evidence of absence

and Extraordinary claims require extraordinary evidence.

Tutorial Video

The Tools

Magnifier

The magnifier allows you to see small hidden details in an image.

It does this by magnifying the size of the pixels and the contrast within the window.

MagnificationAlso known as the zoom factor.

EnhancementThere are three different enhancements available at the moment. Histogram Equalization, Auto Contrast and Auto Contrast by Channel. Auto Contrast mostly keeps the colors intact, the others can cause color shifts. Histogram Equalization is the most robost option. You can also set this to none.

Clone Detection

The clone detector highlights similar regions within an image. These can be a good indicator that a picture

has been manipulated using the clone tool. Note that this tool is a first attempt and not yet very refined.

Regions that are similar are marked in blue and connected with a red line.

If a lot of regions overlap the result can look white.

Minimal SimilarityDetermines how similar the cloned pixels need to be to the original.

Minimal DetailBlocks with less detail than this are not considered when searching for clones.

Minimal Cluster SizeDetermines how many clones of a similar region need to be found in order for them to show up as results.

Blocksize (2n)Determines how big the blocks used for the clone detection are.

You generally don’t want to touch this.

Maximal Image SizeThe maximal width or height of the image used to perform the clone search. Bigger images take longer to analyze.

Show Quantized ImageShows the image after it has been compressed. Can be useful to tweak Minimal Similarity and Minimal Detail. Blocks that have been rejected because they do not have enough detail show up as black.

Error Level Analysis

This tool compares the original image to a recompressed version.

This can make manipulated regions stand out in various ways.

For example they can be darker or brighter than similar regions which

have not been manipulated.

There is a good tutorial on ELA on fotoforensics.com.

The results of this tool can be misleading, watch the video and read the tutoria for details.

JPEG QualityThis should match the original quality of the image that has been photoshopped.

Error ScaleMakes the differences between the original and the recompressed image bigger

Magnifier EnhancementThere are three different enhancements available at the moment. Histogram Equalization, Auto Contrast and Auto Contrast by Channel. Auto Contrast mostly keeps the colors intact, the others can cause color shifts. Histogram Equalization is the most robost option. You can also set this to none.

OpacityThe opacity of the differences layer. If you lower it you will see more of the original image.

Noise Analysis

This is tool is basically a reverse denoising algorithm. Rather than

removing the noise it removes the rest of the image.

It is using a super simple separable median filter to isolate the noise.

It can be useful for identifying manipulations to the image like

airbrushing, deformations, warping and perspective corrected cloning.

It works best on high quality images. Smaller images tend to contain to

little information for this to work.

You can read more about noise analysis in my blog post Noise Analysis for Image Forensics.

Noise AmplitudeMakes the noise brighter.

Equalize HistogramApplies histogram equalization to the noise.

This can reveal things but it can also hide them.

You should try both histogram equalization and scale

to analyze to noise.

Magnifier EnhancementThere are three different enhancements available at the moment. Histogram Equalization, Auto Contrast and Auto Contrast by Channel. Auto Contrast mostly keeps the colors intact, the others can cause color shifts. Histogram Equalization is the most robost option. You can also set this to none.

OpacityThe opacity of the noise layer. If you lower it you will see more of the original image.

Level Sweep

This tool allows you to quicky sweep through the histogram of an image.

It magnifies the contrast of certain brightness levels.

On use of this tool is to make edges that were introduced when copy pasting content more visible.

To use this tool simple move your mouse over the image and scroll with your mouse wheel.

Look for interesting discontinuities in the image.

A position of 0.5 and a width of 32 would mean that

127-32/2 would be the equal to 0 in the output. 127+32/2 would be equal to 256.

SweepThe position in the histogram to be inspected.

You can quickly change this parameter by using the mouse wheel while hovering over the image,

this allows you to sweep through the histogram.

WidthThe amount of values (or width of the slice of the histogram) to be inspected.

You the default should be fine.

OpacityThe opacity of the sweep layer. If you lower it you will see more of the original image.

Luminance Gradient

The luminance gradient tool analyses the changes in brightness along the x and y axis of the image.

It’s obvious use is to look at how different parts of the image are illuminated in order to find anomalies.

Parts of the image which are at a similar angle (to the light source) and under similar illumination should have a similar color;

Another use is to check edges. Similar edges should have similar gradients.

If the gradients at one edge are significantly sharpe than the rest it’s a sign that the image could have been copy pasted.

It does also reveal noise and compression artifacts quite well.

PCA

This tool performs principal component analysis on the image.

This provides a different angle to view the image data which makes discovering

certain manipulations & details easier. This tool is currently single threaded and quite

slow when running on big images.

I have provided an example of how this tool can be used in my short article Principal Component Analysis for Photo Forensics.

InputThe data to run the PCA on.

Mode

- Projection: projection of the value in the image onto the principal component.

- Difference: Difference between the input and the closest point on the selected principal component.

- Distance: Distance between the input and the closest point on the selected principal component.

- Component: The closest point on the selected principal component.

ComponentThe component of the PCA you want to inspect.

The first component contains the most variance.

The later components can reveal more hidden details.

LinearizeEnables operation in linear space rather than in gamma space. Slower.

InvertInverts the output data.

EnhancementThere are three different enhancements available at the moment. Histogram Equalization, Auto Contrast and Auto Contrast by Channel. Auto Contrast mostly keeps the colors intact, the others can cause color shifts. Histogram Equalization is the most robost option. You can also set this to none.

OpacityThe opacity of the sweep layer. If you lower it you will see more of the original image.

Meta Data

This tool displays the hidden exif meta data in the image, if there is any.

Geo Tags

This tool shows the GPS location where the image was taken, if it is stored in the image.

Thumbnail Analysis

This tool shows the hidden preview image inside of the original image if there is one.

The preview can reveal details of the original image or the camera it was taken with.

Opacityopacity of the preview image on top of the original image.

Show Differencesenabled this will show the differences between the original image and the preview stored within it.

JPEG Analysis

This tool extracts meta data out of JPEG Files. You can learn more about it in my post JPEG Forensics in Forensically.

Comments

Some applications store interesting data in the comments of a JPEG file.

Quantization Tables

The quantization matrices used to compress a JPEG file

reveals information about what software was last used to save the file in question.

Forensically currently recognizes three types of quantization matrices:

- Standard JPEG

- Adobe (latest CC should be complete, the rest is still incomplete)

- Non Standard

I’m missing a complete set of sample images for older photoshop versions using the 0-12 quality scale. If you happen to have one and would be willing to share it please let me know.

Most software and internet services save their files using the quantization matrices defined by the standard.

The exception to this rule are Adobe products, which use their own custom quantization tables.

Jpegs produces by digital cameras often use non standard color matrices.

So if you know that the camera that an image was supposedly taken with uses one type of quantization matrix

and the image you are trying to verify uses a different type of quantization matrix this can be a good indicator

that the file has been edited or at least resaved.

From what I have seen iPhones use non standard quantization tables with qualities around 92.

Android phones tend to use the standard quantization matrices, but there are exceptions to this.

For more information about this technique please look at the presentation

Using JPEG Quantization Tables to Identify Imagery Processed by Software

by Jesse Kornblum.

Structure

The sequence of markers in a JPEG file.

In general JPEG images taken with a camera with the same settings should result in the same sequence.

String Extraction

This tool scans for binary contents of the image looking for sequences of ascii characters.

It is a great fallback to view meta data that is in an image in a format that Forensically does not understand yet.

It will output sequences of alpha numeric characters longer than 4, or sequences of 8 or more non control ascii characters.

This allows you to discover meta data that is hidden or not recognized by forensically.

The relevant data is genreally stored at the beginning or end of the file.

An interesting string to look for is bFBMD followed by a sequence of numbers and letters a-f (hex encoding).

This string is added to (some) images by facebook.

It is inspired by the classic unix strings command.

You can find some more information about how to use this tool in my post JPEG Forensics in Forensically.

FAQ

Are my images uploaded to your server?

No! I respect your privacy. All of your images stay on your computer. They are never uploaded to any cloud or server.

Can I open RAW images using this app?

No, RAW images are not supported. The highest

quality format you can use is 24-bit PNG.

Can I use this app offline?

Yes you can if you are using a modern web browser like firefox or chrome.

Offline mode is enabled. You can open this application even if you are offline.Offline mode is not working with your current setup.

What other similar software can you recommend?

Ghiro looks pretty cool and is open source. You can try it online on imageforensic.org.

Changelog

2017-06-14

Fixed a typo in the JPEG module which recognized progressive JPEGs as lossless. Updated help page.

2017-02-05

Added JPEG Analysis and String Extraction tools. See JPEG Forensics in Forensically.

2016-07-14

Added PCA tool.

2016-07-02

Added luminance gradient tool. Tweaked clone detection default settings.

2016-06-30

Added offline support for modern browsers via service workers.

2015-08-21

Added noise analysis tool.

2015-08-20

Added a new enhancement option to the magnifier (histogram equalization). Added magnifier to Error Level Analysis.

2015-08-16

Initial Public release

Credits

Clone Detection

The clone detection tool was inspired by the paper Detection of Copy-Move Forgery in Digital Images by Jessica Fridrich, David Soukal, and Jan Lukáš. But the actual algorithm used is my own.

Error Level Analysis

I got the concept out of the presentation A Picture’s Worth… Digital Image Analysis and Forensics by Neal Krawetz

Luminance gradient

This is another tecnique inspired by Neal Krawetz

Open Source Libraries

This software was built using the following open source components.

I want to thank all of their authors for making my life easier, and projects like this possible.

- babel

- babel-polyfill

- babel-preset-es2015

- babelify

- bluebird

- canvas-to-blob

- chai

- chai-as-promised

- chai-spies

- console-polyfill

- exif-parser

- grunt

- grunt-autoprefixer

- grunt-browserify

- grunt-contrib-compress

- grunt-contrib-connect

- grunt-contrib-copy

- grunt-contrib-cssmin

- grunt-contrib-jade

- grunt-contrib-uglify

- grunt-contrib-watch

- grunt-rsync

- grunt-sass

- grunt-shell

- hammerjs

- jquery

- ml-matrix

- ml-pca

- mocha

- natural-sort

- sass

- sinon

- sinon-chai

- source-map-support

- sw-precache

- underscore

- yargs

JPEG Error Level Analysis for the GIMP

The JPEG-compression is a lossy technique. Using this kind of compression on digital images introduces an error on each block of 8×8 pixels that composes the resulting picture. Nevertheless, when an image is modified, the 8×8 cells containing the modifications have no longer the same error level of the rest of the unmodified image.

The Error Level Analysis (ELA) aims to discover areas within a JPEG image that are at different compression levels, so that a possible manipulation of the highlighted portions could be clued. In order to succeed in this operation the original image is intentionally saved again at a known error rate — such as 70% — and then the difference between the resulted image and the original one is computed. If an area of the image has been compressed multiple times one could suppose that the image has possibly been manipulated.

Installation

In order to install this Python plugin in GIMP (tested with GIMP 2.8+) you must save plugin-ela.py under the plug-ins directory and then start the GIMP. The new Forensics submenu would be disposable under Filters.

Usage

After selecting the JPEG ELA plugin from Filters on a saved JPEG image it is possible to specify the amount of compression of the resaved image and an HTML report.

Requirements

- GIMP 2.8+

- Python

JPEG Error Level Analysis for the GIMP

The JPEG-compression is a lossy technique. Using this kind of compression on digital images introduces an error on each block of 8×8 pixels that composes the resulting picture. Nevertheless, when an image is modified, the 8×8 cells containing the modifications have no longer the same error level of the rest of the unmodified image.

The Error Level Analysis (ELA) aims to discover areas within a JPEG image that are at different compression levels, so that a possible manipulation of the highlighted portions could be clued. In order to succeed in this operation the original image is intentionally saved again at a known error rate — such as 70% — and then the difference between the resulted image and the original one is computed. If an area of the image has been compressed multiple times one could suppose that the image has possibly been manipulated.

Installation

In order to install this Python plugin in GIMP (tested with GIMP 2.8+) you must save plugin-ela.py under the plug-ins directory and then start the GIMP. The new Forensics submenu would be disposable under Filters.

Usage

After selecting the JPEG ELA plugin from Filters on a saved JPEG image it is possible to specify the amount of compression of the resaved image and an HTML report.

Requirements

- GIMP 2.8+

- Python

FotoForensics не разрешает загружать фотографии из России. Чтобы работать в сервисе, используйте VPN.

Сервис FotoForensics разрабатывался для судебных экспертов и переводится на русский как фотокриминалистика. Инструмент будет полезен всем, кто работает с пользовательским контентом: редакциям, журналистам, фактчекерам, блогерам, SMMщикам.

FotoForensics использует метод ELA (error level analysis — анализ уровня ошибок), который разработал Нил Кравец в 2007 году. Пит Рингвуд в 2010 году создал сервис для анализа изображений, сразу ставший популярным среди криминалистов. В 2012 Рингвуд уволился, сайт переименовали в FotoForensics и оставили бесплатный доступ для некоммерческого использования.

С жесткого или по URL

Чтобы проанализировать фотоснимок, укажите URL опубликованного в Сети изображения или загрузите его с жесткого диска, затем нажмите кнопку Upload File («Загрузить файл»).

Требования к снимкам:

- Сервис воспринимает файлы с расширениями: JPEG, PNG или WebP.

- Максимальный размер файла 8 Мб.

- Размер фотографий — не менее 100×100 и не более 10 000×10 000 пикселей.

Разработчики предупреждают: сайт публичный и его используют судебные эксперты, поэтому не стоит загружать незаконный контент. Нарушителям запретят доступ на три месяца и могут привлечь к ответственности. Заблокируют и тех, кто загружает слишком много фото за короткое время — если вы хотите проверить сразу много снимков вам нужна версия сайта для коммерческого использования.

Cервис поддерживает все современные браузеры. Сложности возникают с Apple Mobile Safari, который модифицирует изображение, загружаемое с устройства, — в этом случае выбирайте первый способ загрузки фото c помощью URL.

Подноготная снимка

После того, как вы загрузили изображение, сервис его проанализирует и в открывшемся окне покажет оригинал (сверху) и загруженное фото (под оригиналом). В качестве примера я взяла явно отфотошопленный снимок и бесплатного фотостока.

Меню данных, которые можно отследить при помощи сервиса, располагается слева:

Digest («Дайджест») — базовое описание файла. Отображается название документа, размер, тип, дата последнего изменения.

ELA («Анализ уровня ошибок») — фильтр указывает наиболее измененные фрагменты изображения. Области, которые откорректированы больше всего, отмечены на нижнем фото белыми областями. В нашем случае видно, что кто-то добавил к изображению голову собаки.

Можете самостоятельно изучить данные этого фотоколлажа.

Если изображение не подвергалось постобработке, оно будет однородным, без ярко выраженных светлых, темных или радужных областей:

Сервис определяет не только наложение изображений. Если изменились настройки яркости снимка или контраст, фильтр ELA отобразит их как белые точки. Например, на этой фотографии улучшения коснулись головного убора, лямок костюма, а также глаз модели:

Обычно края предметов на изображениях имеют более высокий уровень ELA из-за более высокого контраста. Руки на фоне белой бумаги, текст в книге, светоотражающая полоска на куртке — у этих объектов высокий контраст и в фильтре ELA они будут отмечены белыми областями. При анализе разработчики советуют сопоставлять оригинал с проанализированным снимком. Если все подобные поверхности кроме одной имеют примерно одинаковый уровень ELA, то это должно вызвать подозрения.

Края объекта, если бы он находился изначально на снимке, были бы однородными. Сильный шум на ELA (синие и красные полоски) признак того, что снимок был несколько раз пересохранен: