-

-

May 8 2015, 14:46

Абсолютные ,относительные и приведенные погрешности измерений

Абсолютная погрешность – это разница между измеренной датчиком величиной Хизм и действительным значением Хд этой величины.

Действительное значение Хд измеряемой величины это найденное экспериментально значение измеряемой величины максимально близкое к ее истинному значению. Говоря простым языком действительное значение Хд это значение, измеренное эталонным прибором, или сгенерированное калибратором или задатчиком высокого класса точности. Абсолютная погрешность выражается в тех же единицах измерения, что и измеряемая величина (например, в м3/ч, мА, МПа и т.п.). Так как измеренная величина может оказаться как больше, так и меньше ее действительного значения, то погрешность измерения может быть как со знаком плюс (показания прибора завышены), так и со знаком минус (прибор занижает).

См.Абсолютная погрешность микрокомпьютерного расходомера скоростемера МКРС

Относительная погрешность – это отношение абсолютной погрешности измерения Δ к действительному значению Хд измеряемой величины.

Относительная погрешность выражается в процентах, либо является безразмерной величиной, а также может принимать как положительные, так и отрицательные значения.

См.Относительная погрешность ультразвукового уровнемера ЭХО-АС-01

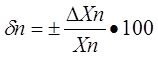

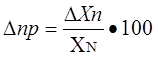

Приведенная погрешность – это отношение абсолютной погрешности измерения Δ к нормирующему значению Хn, постоянному во всем диапазоне измерения или его части.

Нормирующее значение Хn зависит от типа шкалы датчика КИП:

- Если шкала датчика односторонняя и нижний предел измерения равен нулю (например, шкала датчика от 0 до 150 м3/ч), то Хn принимается равным верхнему пределу измерения (в нашем случае Хn = 150 м3/ч).

- Если шкала датчика односторонняя, но нижний предел измерения не равен нулю (например, шкала датчика от 30 до 150 м3/ч), то Хn принимается равным разности верхнего и нижнего пределов измерения (в нашем случае Хn = 150-30 = 120 м3/ч).

- Если шкала датчика двухсторонняя (например, от -50 до +150 ˚С), то Хn равно ширине диапазона измерения датчика (в нашем случае Хn = 50+150 = 200 ˚С).

Приведенная погрешность выражается в процентах, либо является безразмерной величиной, а также может принимать как положительные, так и отрицательные значения.

Довольно часто в описании на тот или иной датчик указывается не только диапазон измерения, например, от 0 до 50 мг/м3, но и диапазон показаний, например, от 0 до 100 мг/м3. Приведенная погрешность в этом случае нормируется к концу диапазона измерения, то есть к 50 мг/м3, а в диапазоне показаний от 50 до 100 мг/м3 погрешность измерения датчика не определена вовсе – фактически датчик может показать все что угодно и иметь любую погрешность измерения. Диапазон измерения датчика может быть разбит на несколько измерительных поддиапазонов, для каждого из которых может быть определена своя погрешность как по величине, так и по форме представления. При этом при поверке таких датчиков для каждого поддиапазона могут применяться свои образцовые средства измерения, перечень которых указан в методике поверки на данный прибор.

При

анализе значений, полученных в ходе

измерений, необходимо дифференцировать

такие понятия, как: истинные значения

физических величин и результаты

измерений.

Истинные

значения физических величин

— это значения, идеально отражающие

свойства данного объекта как в

количественном, так и в качественном

отношении.

Результаты

измерений

представляют собой приближенные оценки

значений физической величины, определенных

путем измерения. Степень приближения

зависит от многих факторов: метода

измерения, технических средств, с помощью

которых проводятся измерения, восприятия

наблюдателя, осуществляющего измерения.

Погрешность

измерения

— количественная характеристика

качества измерения, определяемая

разностью между истинным значением

измеряемой величины и результатами

измерения.

Если

истинное значение измеряемой величины

неизвестно, для получения приближенных

сведений используют действительное

значение.

Действительным

значением

физической величины называют значение,

найденное экспериментально и настолько

приближающееся к истинному значению,

что при необходимости может быть

использовано вместо него.

Погрешность

меры

характеризует отличие номинального

значения меры от истинного значения

воспроизводимой ею величины.

Погрешность

средства измерений

— погрешность, вызванная отклонением

влияющих величин от нормального значения

или их выходом за пределы областей

нормальных значений. Чтобы результат

измерения был максимально приближен к

истинному значению измеряемой величины,

необходимо четко определить вопросы,

связанные с выбором метода измерения,

средства измерения, исполнителя. При

неправильном выборе появляются

методические, инструментальные или

субъективные погрешности измерений.

Главными

причинами

возникновения погрешностей

являются:

—

несовершенство методов измерений;

—

несовершенство технических средств,

используемых для измерения физических

величин;

—

несовершенство органов чувств наблюдателя;

—

влияние индивидуальных особенностей

наблюдателя на восприятие результатов

измерения;

—

влияние условий проведения измерений.

Погрешность

измерения в связи с этим имеет следующую

структуру:

∆и

— инструментальная погрешность

(вследствие несовершенства СИ);

∆м

— методическая погрешность (вследствие

несовершенства метода измерения);

∆отс

— погрешность отсчета (из-за неправильной

оценки шкалы);

∆ст

— статическая погрешность;

∆дин

— динамическая погрешность;

∆0

— основная погрешность;

∆д

— дополнительная погрешность;

∆вз

— погрешность взаимодействия (обмен

мощностью между источником сигнала и

СИ).

Инструментальные

погрешности измерений

— это погрешности применяемых средств

измерений.

Методическая

погрешность

— погрешность за счет либо неточного

описания модели физического процесса,

на основе которых строятся средства

измерений, либо неправильного процесса

эксплуатации.

Погрешность

прибора

— это отличие показаний прибора от

истинного или действительного значения

измеряемой величины.

Приведенная

погрешность прибора

— отношение (в процентах) абсолютной

погрешности прибора к нормирующему

значению: у = 100 / Хнорм; это понятие

используется для сравнительной оценки

точности измерительных устройств. В

соответствии с ГОСТ 8 401—80 Хнорм

принимается равным:

—

арифметической сумме модулей пределов

измерений (если нулевая отметка находится

внутри диапазона измерений);

—

установленному номинальному значению

для СИ с установленным номинальным

значением измеряемой величины;

—

большему из пределов измерений и большему

из модулей пределов измерений для СИ с

равномерной или степенной шкалой (если

нулевая отметка находится на краю или

вне диапазона измерений);

—

всей длине шкалы для приборов с существенно

неравномерной шкалой, при этом абсолютные

погрешности также выражают в единицах

длины;

—

установленному стандартами для

соответствующих видов системы единиц

(СИ) в остальных случаях.

Классификация

погрешностей СИ.

Признаки

классификации:

1.

По способу выражения

— абсолютные, относительные;

Абсолютная

погрешность

измерительного прибора — разность

между показанием прибора и действительным

значением измеряемой величины.

Абсолютная

погрешность, взятая с обратным знаком,

называется поправкой

измерительного прибора.

Относительная

погрешность

измерительного прибора — отношение

абсолютной погрешности прибора к

действительному значению величины,

выраженное в процентах.

Пределы

допускаемой абсолютной погрешности

определяются

по

формуле:

∆=

±α или ∆= ± (α + вх), где х — значение

измеряемой величины; α, в — положительные

числа, не зависящие от х.

Пределы

допускаемой приведенной основной

погрешности определяют по формуле:

γ

= 100 ∆/ Хн = ±р %,

где

Хн — нормирующее значение, выраженное

в тех же единицах, что и х; р — отвлеченное

положительное число, выбираемое из

стандартизованного ряда значений.

Значение

относительной погрешности зависит от

значения измеряемой величины, и

максимальная точность измерений

обеспечивается, если показание прибора

находится во второй половине диапазона

измерений.

Диапазоном

измерения

называется область значений измеряемой

величины, для которой нормированы

допустимые погрешности прибора.

Допускаемой

погрешностью

считается погрешность прибора, при

которой он может быть признан годным и

допущен к применению.

Пределы

допускаемых дополнительных погрешностей

устанавливают в виде дольного значения

предела допускаемой основной погрешности.

Пределы

допускаемой основной погрешности,

которые выражают в форме приведенной

или относительной погрешности,

обозначаются числами, равными этим

пределам в процентах. Для того чтобы

отличить от приведенной относительную

погрешность — класс точности, его

обозначение обводят кружком. Если

погрешность нормирована в процентах

от длины шкалы, то под обозначением

класса ставится знак точности.

Суммарная

погрешность

измерения складывается под влиянием

большого количества факторов из

систематической и случайной составляющих.

2.

По характеру проявления

— систематические, случайные;

Систематической

погрешностью

измерения называют составляющие

суммарной погрешности, определяемые

действием постоянных или закономерно

изменяющихся факторов в процессе

измерительного эксперимента, например

плавных изменений влияющих величин или

погрешностей применяемых при измерениях

образцовых мер. Отличительная ее

особенность заключается в том, что она

остается постоянной или закономерно

изменяется при повторных измерениях

одной и той же величины. До тех пор пока

систематические погрешности больше

случайных, последние можно исключить

из результатов измерений соответствующей

постановкой опыта.

Случайной

погрешностью

измерения называют составляющую

суммарной погрешности измерения,

определяемую действием нерегулярно

проявляющихся факторов, неожиданно

исчезающих или появляющихся с

интенсивностью, которую трудно предвидеть,

например перекосы элементов приборов,

нерегулярные изменения моментов трения

в опорах, флуктуации влияющих величин,

изменения внимания операторов и др. Ее

отличительная особенность состоит в

том, что она случайно изменяется при

повторных измерениях одной и той же

величины.

Интенсивность

проявления большинства случайных

факторов удается свести к общему уровню,

поэтому они примерно одинаково влияют

на формирование случайной погрешности.

Но некоторые из них, например падение

напряжения в сети электропитания, могут

проявиться неожиданно сильно, в результате

чего погрешность выйдет за границы

допустимых значений. Такого рода

случайные погрешности называют грубыми

погрешностями.

Субъективная

погрешность

— погрешность, связанная с квалификацией

оператора и его психологическим

состоянием, а также с несовершенством

зрительной системы человека. Промахи

— это погрешности, связанные с человеческим

фактором, например вызванные неправильным

обращением наблюдателя со средствами

измерений, неверным отсчетом показаний

или ошибками при регистрации результатов.

Такие погрешности нельзя скорректировать.

В

процессе измерения физической величины

систематические и случайные погрешности

проявляются одновременно.

Результаты,

максимально приближенные к истинным

значениям физической величины, получают,

осуществляя многократные наблюдения

за измеряемой величиной и проводя

последующую математическую обработку

опытных данных. Поэтому наиболее важно

изучение погрешности как функции

времени.

В

общем случае погрешность является

случайной функцией времени, но в отличие

от классических функций математического

анализа нельзя сказать, какое значение

она примет в момент времени, можно

указать лишь вероятность появления ее

значений в том или ином интервале.

Сечением

случайной функции

называется погрешность измерений,

соответствующая каждому моменту времени.

В каждом сечении можно найти среднее

значение погрешности, относительно

которого группируются погрешности

различных форм.

Систематические

погрешности можно тем или иным способом

исключить из результатов наблюдений и

рассматривать только случайные

погрешности, средние значения которых

равны нулю в каждом сечении, предположив,

что случайные погрешности в различных

сечениях не зависят друг от друга. Тогда

случайную погрешность можно рассматривать

как случайную величину, а ее значения

при каждом из многократных наблюдений

одной и той же физической величины —

как результаты независимых наблюдений

над ней. Поэтому, как правило, для оценки

случайной погрешности пользуются

статистическими методами.

-

По

отношению к условиям применения

— основные, определяемые в нормальных

условиях

применения, и дополнительные, возникающие

вследствие отклонения какой-либо из

влияющих величин (температуры,

относительной влажности, напряжения

сети переменного тока и т.п.) от ее

нормального значения. Если прибор

работает в нормальных условиях, то

дополнительная погрешность равна нулю

и присутствует только основная

погрешность. Статической

называют погрешность,

возникающую при измерении постоянной

во времени величины.

Динамической

погрешностью

называют разность между погрешностью

в динамическом режиме, т.е. погрешностью

при измерении переменной во времени

величины, и статической погрешностью,

которая соответствует значению измеряемой

величины в данный момент времени.

Аддитивная

погрешность

— погрешность, которая искажает результат

за счет арифметического суммирования

и не зависит от абсолютного значения

измеряемой величины. Абсолютные

аддитивные погрешности не зависят от

чувствительности измерительного прибора

и постоянны для всего диапазона измерений.

От значений абсолютной аддитивной

погрешности зависит наименьшее значение

величины, которое может быть определено

измерительным прибором.

Мультипликативная

погрешность

— погрешность, которая изменяется с

изменением значений измеряемых величин,

например при изменении чувствительности

средства измерения.

Мультипликативные

погрешности пропорциональны значению

измеряемой величины и чувствительности

прибора. Источники мультипликативной

погрешности — действие влияющих величин

на параметры элементов и узлов средств

измерений.

Качество

измерительных приборов.

Качество

— это степень соответствия изделия

своему назначению. Соответственно о

качестве измерительного прибора следует

судить по тому, насколько полно исполняется

и реализуется цель измерения — получение

информации об объекте измерения,

необходимой для его управления.

Представление о цели измерения связывает

задачи измерения и задачи создания

методов и СИ с использованием результатов

измерений для управления реальными

объектами, следовательно, эффективность

управления объектами во многом

определяется качественными показателями

СИ.

Обобщающими

показателями качества СИ можно считать:

предел допускаемой погрешности,

долговечность, допуск на долговечность,

значения ограничений.

Метрологические

характеристики

являются основными характеристиками

свойств СИ, оказывающими определяющее

влияние на их обобщенные показатели

качества.

Метрологические

характеристики разделяются на шесть

групп (в соответствии с ГОСТ 8.009—84):

—

динамические характеристики (полные,

частные);

—

характеристики влияния на инструментальную

составляющую погрешности измерений

(входной импеданс, выходной импеданс);

—

характеристики погрешностей СИ

(систематическая и случайная составляющие,

вариация выходного сигнала, погрешности

СИ, функция распределения погрешностей);

—

характеристики для определения

результатов измерения (функция

преобразования, значения меры, цена

деления шкалы, кодовые характеристики);

—

характеристики чувствительности СИ к

влияющим величинам (функция влияния,

изменение МХ при изменении влияющих

величин);

—

неинформативные параметры выходных

сигналов.

Метрологическая

надежность

— свойство средства измерений сохранять

его метрологическую исправность в

течение заданного интервала времени,

т.е. сохранять соответствие нормируемых

метрологических характеристик

установленным нормам.

Понятие

метрологической надежности неразрывно

связано с понятием метрологического

отказа средства измерения.

Метрологическим

отказом

средства измерения называют выход

показаний измерений за установленные

метрологическими характеристиками

нормы.

Существуют

следующие виды

отказа:

—

внезапный отказ, в результате которого

средство измерений полностью теряет

работоспособность;

—

постоянный отказ, в результате которого

с течением времени метрологические

характеристики выходят за допустимые

пределы.

Главными

показателями

метрологической надежности СИ

являются:

—

безотказность — наработка на отказ;

—

ремонтопригодность — среднее время

восстановления средства измерения;

—

долговечность (средний срок службы, или

средний ресурс) — календарная

продолжительность эксплуатации СИ и

его наработка от ее начала до наступления

такого предельного состояния, при

котором эксплуатация СИ должна быть

прекращена.

Полученное из опыта значение измеряемой величины может

отличаться от ее действительного (истинного) значения.

Погрешность измерения – отклонение результата измерения от истинного (действительного) значения измеряемой

величины.

Это может быть обусловлено конструктивными недостатками прибора, несовершенством технологии его

изготовления, а также влиянием различных внешних факторов.

Таким образом, погрешности классифицируют:

-

По источнику возникновения (метод, инструмент, субъект)

-Методические (зависят от метода измерения и способа включения приборов в электрическую цепь)

-Инструментальные (зависят от средства измерения)

-Субъективные (зависят от измерителя)

-

По условиям проведения измерений (температура, давление, влажность)

-Основные (измерения проводятся в нормальных условиях — при нормальной температуре, давлении,

влажности)-Дополнительные (условия отличны от нормальных)

-

По характеру проявления (систематические, случайные, промахи)

Систематические – погрешности, остающиеся постоянными или закономерно изменяющимися при повторных

измерениях тем же способом и средствами. Т.е. они заранее известны и их легко исключить.Случайные – погрешности, изменяющиеся случайным образом при повторных измерениях одной и той же

величины. Обычно выявляются в результате многократных измерений (не менее 10).Промах – грубая ошибка, обусловленная неправильным отсчетом или расчетом, небрежностью измеряющего,

поломки прибора, неправильно собранной схемы, невнимательности и т.д. Такие данные необходимо исключать. -

По временному поведению измеряемой величины (статическая, динамическая)

Статическая – когда измеряемая величина не меняется за время измерения

Динамическая – когда прибор не успевает реагировать на изменения измеряемой величины.

-

По способу выражения измеряемой величины

-

абсолютная;

-

относительная;

-

приведенная.

Абсолютной погрешностью

DХ называется разность между измеренным и действительным значениями.– измеренное значение;

– действительное значение измеряемой величины.

Выражается

DХ в единицах измеряемой величины.Относительная погрешность

– отношение абсолютной погрешности к действительному значению измеряемой величины.

Выражается в процентах или относительных единицах. Относительная погрешность характеризует

точность измерений.Приведенная погрешность

gпр – отношение абсолютной погрешности к номинальному (нормированному) значению – верхнему пределу диапазона

или поддиапазона измерения прибора.Пределом измерения прибора называется наибольшая величина, на которую рассчитан данный

прибор.Прибор может иметь несколько пределов измерений (например, вольтметр).

Чем меньшую погрешность дает прибор, тем он точнее.

-

Выражается в процентах.

Максимальная приведенная погрешность определяет класс точности прибора.

-

Электроизмерительные приборы изготавливаются нескольких классов точности

-

|

0,01 |

||

|

0,02 |

0,2 |

1,5 |

|

0,05 |

0,5 |

2,5 |

|

0,1 |

1,0 |

4 |

Эти числа определяют максимальную погрешность прибора при полном отклонении указателя (стрелки).

Определяют также среднеквадратическую погрешность результата измерения по формуле:

Выражается в единицах измеряемой величины.

За действительное значение измеряемой величины принимается обычно среднее арифметическое из ряда

измерений.

Хд = ХСР = (Х1 + Х2 +

Х3 + … + Хn)/n,

где Х1, Х2,… , Хn – результаты измерений

n – количество измерений

ЛАБОРАТОРНАЯ РАБОТА № 3

по дисциплине «Управление, сертификация и инноватика

(Метрология, стандартизация и сертификация)»

ПОГРЕШНОСТИ ИЗМЕРЕНИЙ И ПОГРЕШНОСТИ СРЕДСТВ ИЗМЕРЕНИЯ

СОДЕРЖАНИЕ ЛАБОРАТОРНОЙ РАБОТЫ

1. Погрешности измерений

2. Погрешности средств измерений

- Контрольные вопросы Пример решения задачи Варианты задач

РЕКОМЕНДАЦИИ ПО ВЫПОЛНЕНИЮ ЛАБОРАТОРНОЙ РАБОТЫ

Законспектировать:

- Ответить на все контрольные вопросы, приведенные в конце лабораторной работы; Составить классификации погрешностей измерений и погрешностей средств измерений.

Знать:

- Основные виды погрешностей измерений; основные положения теории погрешностей; Погрешности средств измерений;

Решить:

· индивидуально каждый студент должен решить все варианты задач.

Оформление отчета:

· отчет выполняется индивидуально каждым студентом в отдельной тетрадке рукописным способом. Тетрадь начинается с титульного листа, где указаны ФИО студента и группа. Отчет по лабораторной работе начинается с названия и даты выполнения.

1. Погрешности измерений

Рассмотрим основные виды погрешностей измерения. В зависимости от формы выражения различают абсолютную и относительную погрешности.

Абсолютной называют погрешность измерений, выраженную в тех же единицах, что и измеряемая величина. Её определяют как:

D = А — Хист

или

D @ А – Хд

где А — результат измерения;

Хист — истинное значение измеряемой физической величины;

Хд — действительное значение измеряемой величины.

Относительная погрешность измерения (d) представляет собой отношение абсолютной погрешности измерений к истинному (действительному) значению измеряемой величины. Относительную погрешность в % определяют по формуле:

или

Пример. В результате измерения силы электрического тока в цепи I получен ряд значений: i1 = 0.55 A; i2 = 0.58 A; …in = 0.54 А. Вычислено среднее значение i = 0.56 А.

Погрешности D1 = i1 – i = 0,55-0,56 = -0,01 А; D2= i2 — i=0,58 -0,56=0,02 A;

Dn= in – i = 0,54-0,56 = -0,02 А являются абсолютными погрешностями измерений.

Приняв в качестве действительного значения среднее значение, т. е. iД = i, определим относительную погрешность отдельного измерения в ряду измерений:

В зависимости от условий и режимов измерения различают статические и динамические погрешности.

Статической называют погрешность, не зависящую от скорости изменения измеряемой величины во времени.

Динамической называют погрешность, зависящую от скорости изменения измеряемой величины во времени. Динамическая погрешность обусловлена инерционностью элементов измерительной цепи средства измерения.

В зависимости от характера проявления, возможностей устранения и причин возникновения различают систематические и случайные погрешности.

Систематической (Dc) называют составляющую погрешности измерения, остающуюся постоянной или закономерно изменяющейся при повторных измерениях одной и той же величины.

Причинами систематической погрешности могут быть:

— отклонение параметров реального средства измерения от расчетных значений, предусмотренных схемой;

— неуравновешенность деталей средства измерений относительно их оси вращения;

— погрешность градуировки или небольшой сдвиг шкалы и др.

Ряд постоянных систематических погрешностей в процессе измерения внешне себя не проявляют. Обнаружить их можно в процессе поверки путем сравнения результатов измерения рабочими средствами и образцовыми.

Случайной ![]() называют погрешность измерений, изменяющуюся случайным образом при повторных измерениях одной и той же величины.

называют погрешность измерений, изменяющуюся случайным образом при повторных измерениях одной и той же величины.

Случайная погрешность возникает при одновременном воздействии многих источников, каждый из которых сам по себе оказывает незаметное влияние на результаты измерений, но суммарное воздействие всех источников может оказаться достаточно сильным.

Как правило, при выполнении измерений случайная и систематическая погрешности проявляются одновременно, поэтому погрешность измерения равна:

.

.

Заметим, что случайные погрешности представляют собой погрешности, в появлении каждой из которых не наблюдается какой-либо закономерности. Случайные погрешности неизбежны и неустранимы. Они всегда присутствуют в результате измерения. Они вызывают рассеяние результатов при многократном и достаточно точном измерении одной и той же величины при неизменных условиях, вызывая различие их в последних значащих цифрах.

В основе теории погрешностей лежат два положения, подтвержденные практикой:

· при большом числе измерений случайные погрешности одинакового значения, но разного знака встречаются одинаково часто;

· большие по абсолютному значению погрешности встречаются реже, чем малые.

Из первого положения следует важный для практики вывод, что при увеличении числа измерений случайная погрешность результата, полученного из ряда измерений, уменьшается вследствие того, что сумма погрешностей отдельных измерений данного ряда измерений стремится к нулю, т. е.

.

.

В ряду измерений выделяют также грубые погрешности и промахи, которые возникают из-за ошибок и неправильных действий оператора, а также при кратковременных, резких изменениях условий проведения измерений (появление вибрации, поступление холодного воздуха и т. д.).

При автоматических измерениях грубые погрешности и промахи автоматически исключаются в процессе обработки измерительной информации.

2. Погрешности средств измерений.

Отметим, что погрешности измерений определяются, главным образом, погрешностями средств измерений, но они не тождественны им.

В общем случае погрешность средства измерений (меры измерительного преобразователя, измерительного прибора) — это отклонение его реальной функции преобразования от номинальной.

Отклонения реальной характеристики от номинальной, отсчитанные вдоль оси Х или оси У, т. е. разности вида Dy = Ур — Ун или Dx = Хр — Хн, есть абсолютные погрешности преобразования, выраженные в единицах величин Х или У (рис. 1).

Мерой точности абсолютная погрешность быть не может, т. к., например, DХ = 0.5 мм при измерении высоты пенного слоя пульпы, равной Х = 200 мм, достаточно мала, а при измерении толщины листа стали, при Х = 1 мм, эта погрешность очень велика.

Абсолютная погрешность измерительного прибора DXП — это разность между показанием прибора ХП и истинным (действительным) ХД значением измеряемой величины:

DXП = ХП – ХД.

Рис. 1. К пояснению понятия абсолютной погрешности

При этом за действительное значение физической величины при оценке погрешности рабочего средства измерений принимают показания образцового средства измерений, при оценке погрешности образцового средства — показания, полученные с помощью эталонного средства измерений.

Абсолютная погрешность измерительного преобразователя по входу — это разность между значением величины на входе преобразователя ХВ и истинным (действительным) значением этой величины на входе ХВД. При этом значение величины на входе ХВ определяется по истинному (действительному) значению величины на выходе преобразователя с помощью градуировочной характеристики, приписанной преобразователю. Таким образом,

DХВ =Х*ВД – ХВД,

где DХВ — погрешность измерительного преобразователя по входу;

Х*ВД — истинное (действительное) значение величины на выходе, найденное по градировочной характеристике преобразователя;

ХВД — истинное (действительное) значение преобразуемой величины на входе.

Абсолютная погрешность измерительного преобразователя по выходу — это разность между истинным (действительным) значением величины преобразователя на выходе DХВЫХ. Д и значением величины на выходе Х*ВЫХ. Д, определяемым по истинному (действительному) значению величины на входе с помощью градуировочной характеристики, приписанной преобразователю. Таким образом,

DХВЫХ. П = ХВЫХ. Д — Х*ВЫХ. Д,

где DХВЫХ. П — погрешность измерительного преобразователя по выходу;

ХВЫХ. Д — действительное значение преобразуемой величины на выходе преобразователя;

Х*ВЫХ. Д — действительное значение преобразуемой величины на выходе, определяемое по действительному значению ее на входе с помощью градуировочной характеристики.

Абсолютная погрешность — это разность между номинальным значением меры ХН и истинным (действительным) ХД воспроизводимой ею величины, т. е.

DХМ = ХН – ХД,

где DХМ — абсолютная погрешность мepы;

ХН — номинальное значение мepы;

ХД — действительное значение воспроизводимой мерой величины.

Пример. Погрешность меры длины (линейки) с номинальным значением 100 мм и действительным значением 100,0006 мм равна 0,6 мкм; погрешность меры сопротивления с номинальным значением 1 Ом и действительным значением 1,0001 Ом равна 0,0001 Ом.

Относительная погрешность меры или измерительного прибора (dП) — это отношение абсолютной погрешности меры или измерительного прибора к истинному (действительному) значению воспроизводимой или измеряемой величины.

Относительная погрешность меры или измерительного прибора, в процентах, может быть выражена как:

.

.

Относительная погрешность измерительного преобразователя по входу (выходу) — это отношение абсолютной погрешности измерительного преобразователя по входу (выходу) к истинному (действительному) значению величины на входе (выходе), определяемому по истинному значению величины на входе (выходе) с помощью номинальной характеристики, приписанной преобразователю.

Итак, относительная погрешность средства измерений, выражаемая в процентах или в относительных единицах, не остается постоянной вследствие изменения величин Х или Y по шкале измерительного устройства.

С учетом того, что относительная погрешность средства измерений не остается постоянной, то вводится понятие приведенной погрешности, в общем виде определяемой:

,

,

где g — приведенная погрешность средства измерений;

XN — нормирующее значение измеряемой величины.

Приведенная погрешность g измерительного прибора — это отношение абсолютной погрешности измерительного прибора DХП к нормирующему значению. Нормирующее значение XN — это условно принятое значение, равное или верхнему пределу измерений*, или диапазону измерений**, или длине шкалы***.

Приведенную погрешность обычно выражают в процентах:

.

.

Приведенная погрешность позволяет сравнивать по точности приборы, имеющие разные пределы точности.

Пример. Определить абсолютную, относительную и приведенную погрешности амперметра с диапазоном измерения 0 -15 А при показании его ХП = 12 А и действительном значении измеряемой силы тока ХД = 12,6 А. За нормирующее значение примем верхний предел измерения Xv = 15 А.

Абсолютная погрешность амперметра

DХП = ХП – ХД = 12 — 12,6 = -0,6 А.

Относительная погрешность амперметра

Приведенная погрешность

При характеристике погрешностей средств измерений часто пользуются понятием предела допускаемой погрешности измерений.

Предел допускаемой погрешности средства измерений — это наибольшая, без учета знака, погрешность средства измерений, при котором оно может быть признано и допущено к применению. Определение применимо к основной и дополнительной погрешности средств измерений.

Пример. Одинаков ли предел допускаемой относительной погрешности измерения во всех точках шкалы автоматического потенциометра?

Для всех точек шкалы одинаков предел допускаемой абсолютной погрешности, определяемой классом точности средства измерений и диапазоном измерений, а предел допускаемой относительной погрешности измерения зависит от конкретной отметки шкалы, т. е. чем меньше показания прибора по шкале, тем больше относительная погрешность. Вследствие этого верхний предел показаний прибора нужно выбирать таким образом, чтобы значение измеряемой величины находилось в конце шкалы.

По происхождению различают инструментальные и методические погрешности средств измерений.

Инструментальные погрешности — это погрешности, вызываемые особенностями свойств средств измерений. Они возникают вследствие недостаточно высокого качества элементов средств измерений, К этим погрешностям можно отнести изготовление и сборку элементов средств измерений; погрешности из-за трения в механизме прибора, недостаточной жесткости его элементов и деталей и др. Подчеркнем, что инструментальная погрешность индивидуальна для каждого средства измерений

Методическая погрешность — это погрешность средства измерения, возникающая из-за несовершенства метода измерения, неточности соотношения, используемого для оценки измеряемой величины.

Основная и дополнительная погрешности. Деление это чисто условно. Погрешность средств измерений, определяемую для работающих в нормальных условиях, называют основной погрешностью. Нормальными условиями принято считать условия, когда температура окружающего воздуха t = (20 ± 5) 0C, относительная влажность W = 30 – 80 %, атмосферное давление Р = 630 — 795 мм рт. ст., напряжение питающей сети (U = (220 ± 4,4) В, частота питающей сети f = (50 ± 0,5) Гц. Такие условия выдерживаются в лабораторных условиях при градуировке средств измерений.

В реальных условиях производства эти параметры отличаются от лабораторных. Средства измерения помимо чувствительности к измеряемой величине обладают и некоторой чувствительностью к изменяющимся величинам окружающей среды, что приводит к искажению результатов измерения. Погрешность, появляющуюся у средств измерений, работающих в реальных производственных условиях, называют дополнительной погрешностью. Так же, как основная, дополнительная погрешность нормируется путем указания коэффициентов влияния изменения отдельных влияющих величин на изменение показаний в виде

α =  , α =

, α =  · Uпит.

· Uпит.

Систематические и прогрессирующие погрешности средств измерений вызываются: первые — погрешностью градуировки шкалы или ее небольшим сдвигом, вторые — старением элементов средства измерения. Систематическая погрешность остается постоянной или закономерно изменяющейся при многократных измерениях одной и той же величины. Особенность систематической погрешности состоит в том, что она может быть полностью устранена введением поправок. Особенностью прогрессирующих погрешностей является то, что они могут быть скорректированы только в данный момент времени. Они требуют непрерывной коррекции.

Аддитивные и мультипликативные погрешности. Аддитивная погрешность не зависит от чувствительности прибора и является постоянной для всех значений входной (измеряемой) величины в пределах диапазона измерений (рис.2).

Если реальная характеристика 1 средства измерения смещена относительно номинальной 2 (см. рис. 2) так, что при всех значениях преобразуемой величины Х выходная величина У оказывается больше (или меньше) на одну и ту же величину Δ, то такая погрешность называется аддитивной погрешностью нуля.

Рис. 2. К пояснению понятия аддитивной погрешности средства измерения

К аддитивным погрешностям средств измерений можно отнести погрешности, вызванные трением в опорах электроизмерительных приборов, погрешность дискретности (квантования) в цифровых приборах. Аддитивная погрешность может носить систематический характер. В этом случае она может быть скорректирована смещением шкалы или нулевого положения указателя.

В случае же, если аддитивная погрешность является случайной, то она не может быть скорректирована, и реальная характеристика средства измерения, смещаясь произвольным образом, но, оставаясь параллельной самой себе, образует полосу погрешностей, ширина которой остается постоянной для любых значений измеряемой величины Х (см. рис. 4.2, б).

Мультипликативная погрешность – это погрешность чувствительности средства измерения. Она может иметь систематическую и случайную составляющие.

Сущность мультипликативной погрешности заключается в том, что если абсолютная погрешность возникает от некоторого независимого от Х изменения чувствительности преобразователя (изменение коэффициента деления делителя, добавочного сопротивления вольтметра и т. д.), то реальная характеристика 1 преобразователя отклоняется от номинальной 2 так, как это показано на рис. 4.3, а, или образует полосу погрешностей (рис. 4.3, б), если это отклонение является случайным.

Рис. 4.3. К пояснению понятия мультипликативной

погрешности измерений

КОНТРОЛЬНЫЕ ВОПРОСЫ К ЛАБОРАТОРНОЙ РАБОТЕ:

1. Что такое абсолютная погрешность измерений?

2. Что такое относительная погрешность измерений?

3. Что такое систематическая погрешность измерений?

4. Что такое случайная погрешность измерений?

5. Что такое промах?

6. В чем заключается отличие погрешности измерения от погрешности средства измерения?

7. Что такое абсолютная погрешность средства измерения?

8. Что такое относительная погрешность средства измерения?

9. Что такое приведенная погрешность? Для каких целей она рассчитывается?

10. Что такое относительная погрешность средства измерения по входу и по выходу?

11. Что такое инструментальная погрешность средства измерения?

12. Что такое методическая погрешность?

13. Что такое систематическая и прогрессирующая погрешности средств измерений?

14. Что такое аддитивная погрешность средства измерения?

15. Чем вызывается мультипликативная погрешность средства измерения?

ПРИМЕР РЕШЕНИЯ ЗАДАЧИ:

Амперметром с диапазоном измерения от 0 до 50 А произведен ряд измерений (табл. 1):

Таблица 1

|

Порядковый наблюдений |

Значение величины тока |

Порядковый наблюдений |

Значение величины тока |

|

1 |

20,5 |

9 |

20,5 |

|

2 |

20,1 |

10 |

20,7 |

|

3 |

20,5 |

11 |

20,5 |

|

4 |

20,5 |

12 |

20,3 |

|

5 |

20,2 |

13 |

20,9 |

|

6 |

20,6 |

14 |

20,1 |

|

7 |

20,3 |

15 |

20,6 |

|

8 |

20,7 |

· Произвести оценку результатов измерений (найти абсолютную, относительную и приведенные погрешности);

· За нормирующее значение принять верхний предел шкалы.

Решение:

|

№ |

Значение величины тока |

Истинное значение величины тока I , А |

Абсолютная погрешность(Δ) I , А |

Относительная погрешность(δ) % |

Приведенная погрешность (γ) % |

|

1 |

20,50 |

20,47 |

0,03 |

0,0015 |

0,0006 |

|

2 |

20,10 |

-0,37 |

-0,0184 |

-0,0074 |

|

|

3 |

20,50 |

0,03 |

0,0015 |

0,0006 |

|

|

4 |

20,50 |

0,03 |

0,0015 |

0,0006 |

|

|

5 |

20,20 |

-0,27 |

-0,0134 |

-0,0054 |

|

|

6 |

20,60 |

0,13 |

0,0063 |

0,0026 |

|

|

7 |

20,30 |

-0,17 |

-0,0084 |

-0,0034 |

|

|

8 |

20,70 |

0,23 |

0,0111 |

0,0046 |

|

|

9 |

20,50 |

0,03 |

0,0015 |

0,0006 |

|

|

10 |

20,70 |

0,23 |

0,0111 |

0,0046 |

|

|

11 |

20,50 |

0,03 |

0,0015 |

0,0006 |

|

|

12 |

20,30 |

-0,17 |

-0,0084 |

-0,0034 |

|

|

13 |

20,90 |

0,43 |

0,0206 |

0,0086 |

|

|

14 |

20,10 |

-0,37 |

-0,0184 |

-0,0074 |

|

|

15 |

20,60 |

0,13 |

0,0063 |

0,0026 |

Истинное значение:

Абсолютная погрешность: Δ = ХД – Хист

Относительная погрешность:

Приведенная погрешность:

ВАРИАНТЫ ЗАДАЧ:

Задача 1:

Вольтметром с диапазоном измерения от 0 до 250 В произведен ряд измерений (табл. 1):

Таблица 1

|

Порядковый наблюдений |

Значение величины напряжения |

Порядковый наблюдений |

Значение величины напряжения |

|

1 |

220 |

9 |

220 |

|

2 |

219 |

10 |

220 |

|

3 |

220 |

11 |

222 |

|

4 |

218 |

12 |

221 |

|

5 |

221 |

13 |

219 |

|

6 |

220 |

14 |

219 |

|

7 |

219 |

15 |

220 |

|

8 |

220 |

· Произвести оценку результатов измерений (найти абсолютную, относительную и приведенные погрешности);

· За нормирующее значение принять верхний предел шкалы.

Задача 2:

Омметром с диапазоном измерения от 0 до 300 МОм произведен ряд измерений (табл. 1):

Таблица 1

|

Порядковый наблюдений |

Значение величины сопротивления |

Порядковый наблюдений |

Значение величины сопротивления |

|

1 |

125 |

9 |

123 |

|

2 |

126 |

10 |

125 |

|

3 |

124 |

11 |

126 |

|

4 |

125 |

12 |

124 |

|

5 |

126 |

13 |

123 |

|

6 |

125 |

14 |

127 |

|

7 |

125 |

15 |

122 |

|

8 |

124 |

· Произвести оценку результатов измерений (найти абсолютную, относительную и приведенные погрешности);

· За нормирующее значение принять верхний предел шкалы.

* Верхний предел измерений. Значения величины, ограничивающие диапазон измерений снизу и сверху (слева и справа), называют соответственно «нижним пределом измерений» или «верхним пределом измерений».

* * Диапазон измерений — это область значений величины, в пределах которой нормированы допускаемые пределы погрешности средства измерений.

* * * Длина шкалы — это длина линии, проходящей через центры всех коротких отметок шкалы средства измерений и ограниченной начальной и конечной отметками. Она выражается в единицах длины, независимо от единиц, указанных на шкале.

Неотъемлемой частью любого измерения является погрешность измерений. С развитием приборостроения и методик измерений человечество стремиться снизить влияние данного явления на конечный результат измерений. Предлагаю более детально разобраться в вопросе, что же это такое погрешность измерений.

Погрешность измерения – это отклонение результата измерения от истинного значения измеряемой величины. Погрешность измерений представляет собой сумму погрешностей, каждая из которых имеет свою причину.

По форме числового выражения погрешности измерений подразделяются на абсолютные и относительные

Абсолютная погрешность – это погрешность, выраженная в единицах измеряемой величины. Она определяется выражением.

![]() (1.2), где X — результат измерения; Х0 — истинное значение этой величины.

(1.2), где X — результат измерения; Х0 — истинное значение этой величины.

Поскольку истинное значение измеряемой величины остается неизвестным, на практике пользуются лишь приближенной оценкой абсолютной погрешности измерения, определяемой выражением

![]() (1.3), где Хд — действительное значение этой измеряемой величины, которое с погрешностью ее определения принимают за истинное значение.

(1.3), где Хд — действительное значение этой измеряемой величины, которое с погрешностью ее определения принимают за истинное значение.

Относительная погрешность – это отношение абсолютной погрешности измерения к действительному значению измеряемой величины:

(1.4)

(1.4)

По закономерности появления погрешности измерения подразделяются на систематические, прогрессирующие, и случайные.

Систематическая погрешность – это погрешность измерения, остающаяся постоянной или закономерно изменяющейся при повторных измерениях одной и той же величины.

Прогрессирующая погрешность – это непредсказуемая погрешность, медленно меняющаяся во времени.

Систематические и прогрессирующие погрешности средств измерений вызываются:

- первые — погрешностью градуировки шкалы или ее небольшим сдвигом;

- вторые — старением элементов средства измерения.

Систематическая погрешность остается постоянной или закономерно изменяющейся при многократных измерениях одной и той же величины. Особенность систематической погрешности состоит в том, что она может быть полностью устранена введением поправок. Особенностью прогрессирующих погрешностей является то, что они могут быть скорректированы только в данный момент времени. Они требуют непрерывной коррекции.

Случайная погрешность – это погрешность измерения изменяется случайным образом. При повторных измерениях одной и той же величины. Случайные погрешности можно обнаружить только при многократных измерениях. В отличии от систематических погрешностей случайные нельзя устранить из результатов измерений.

По происхождению различают инструментальные и методические погрешности средств измерений.

Инструментальные погрешности — это погрешности, вызываемые особенностями свойств средств измерений. Они возникают вследствие недостаточно высокого качества элементов средств измерений. К данным погрешностям можно отнести изготовление и сборку элементов средств измерений; погрешности из-за трения в механизме прибора, недостаточной жесткости его элементов и деталей и др. Подчеркнем, что инструментальная погрешность индивидуальна для каждого средства измерений.

Методическая погрешность — это погрешность средства измерения, возникающая из-за несовершенства метода измерения, неточности соотношения, используемого для оценки измеряемой величины.

Погрешности средств измерений.

Абсолютная погрешность меры – это разность между номинальным ее значением и истинным (действительным) значением воспроизводимой ею величины:

![]() (1.5), где Xн – номинальное значение меры; Хд – действительное значение меры

(1.5), где Xн – номинальное значение меры; Хд – действительное значение меры

Абсолютная погрешность измерительного прибора – это разность между показанием прибора и истинным (действительным) значением измеряемой величины:

![]() (1.6), где Xп – показания прибора; Хд – действительное значение измеряемой величины.

(1.6), где Xп – показания прибора; Хд – действительное значение измеряемой величины.

Относительная погрешность меры или измерительного прибора – это отношение абсолютной погрешности меры или измерительного прибора к истинному

(действительному) значению воспроизводимой или измеряемой величины. Относительная погрешность меры или измерительного прибора может быть выражена в ( % ).

(1.7)

(1.7)

Приведенная погрешность измерительного прибора – отношение погрешности измерительного прибора к нормирующему значению. Нормирующие значение XN – это условно принятое значение, равное или верхнему пределу измерений, или диапазону измерений, или длине шкалы. Приведенная погрешность обычно выражается в ( % ).

(1.8)

(1.8)

Предел допускаемой погрешности средств измерений – наибольшая без учета знака погрешность средства измерений, при которой оно может быть признано и допущено к применению. Данное определение применяют к основной и дополнительной погрешности, а также к вариации показаний. Поскольку свойства средств измерений зависят от внешних условий, их погрешности также зависят от этих условий, поэтому погрешности средств измерений принято делить на основные и дополнительные.

Основная – это погрешность средства измерений, используемого в нормальных условиях, которые обычно определены в нормативно-технических документах на данное средство измерений.

Дополнительная – это изменение погрешности средства измерений вследствии отклонения влияющих величин от нормальных значений.

Погрешности средств измерений подразделяются также на статические и динамические.

Статическая – это погрешность средства измерений, используемого для измерения постоянной величины. Если измеряемая величина является функцией времени, то вследствие инерционности средств измерений возникает составляющая общей погрешности, называется динамической погрешностью средств измерений.

Также существуют систематические и случайные погрешности средств измерений они аналогичны с такими же погрешностями измерений.

Факторы влияющие на погрешность измерений.

Погрешности возникают по разным причинам: это могут быть ошибки экспериментатора или ошибки из-за применения прибора не по назначению и т.д. Существует ряд понятий которые определяют факторы влияющие на погрешность измерений

Вариация показаний прибора – это наибольшая разность показаний полученных при прямом и обратном ходе при одном и том же действительном значении измеряемой величины и неизменных внешних условиях.

Класс точности прибора – это обобщенная характеристика средств измерений (прибора), определяемая пределами допускаемых основной и дополнительных погрешностей, а также другими свойствами средств измерений, влияющих на точность, значение которой устанавливаются на отдельные виды средств измерений.

Классы точности прибора устанавливают при выпуске, градуируя его по образцовому прибору в нормальных условиях.

Прецизионность — показывает, как точно или отчетливо можно произвести отсчет. Она определяется, тем насколько близки друг к другу результаты двух идентичных измерений.

Разрешение прибора — это наименьшее изменение измеряемого значения, на которое прибор будет реагировать.

Диапазон прибора — определяется минимальным и максимальным значением входного сигнала, для которого он предназначен.

Полоса пропускания прибора — это разность между минимальной и максимальной частотой, для которых он предназначен.

Чувствительность прибора — определяется, как отношение выходного сигнала или показания прибора к входному сигналу или измеряемой величине.

Шумы — любой сигнал не несущий полезной информации.