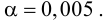

Решение:

-

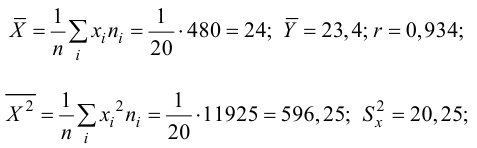

Рассчитаем

средние арифметические.

Средняя арифметическая

– это типовой размер признака,

количественно варьирующего в качественно

однородной совокупности. Для определения

такого размера признака необходимо

рассчитать объем явления, приходящийся

на 1 единицу выборки:

-

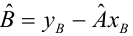

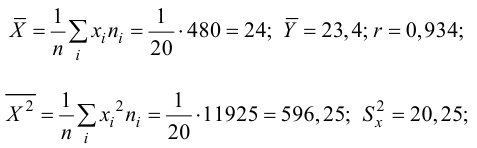

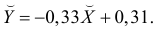

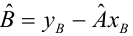

Определим

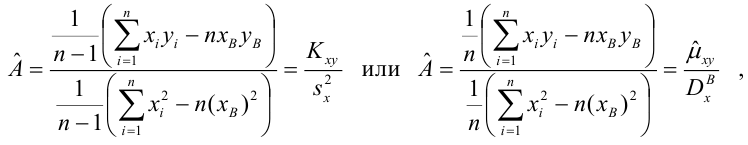

коэффициент регрессии.

Величина коэффициента

регрессии показывает среднее изменение

результата с изменением фактора на

одну единицу.

-

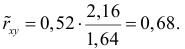

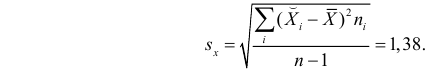

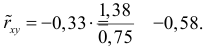

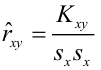

Рассчитаем

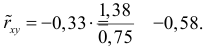

коэффициент корреляции.

Уравнение

регрессии всегда дополняется показателем

тесноты связи. При использовании

линейной регрессии в качестве такого

показателя выступает линейный коэффициент

корреляции.

-

Рассчитаем

t-критерии

Стьюдента для коэффициентов регрессии

и корреляции.

Оценка

параметров уравнения регрессии

осуществляется с помощью t-критерия

Стьюдента. t-критерий Стьюдента —

общее название для класса

методов статистической проверки гипотез,

основанных

на распределении

Стьюдента.

-

Вычислим

стандартную ошибку для коэффициентов

регрессии и корреляции.

Величина

стандартной ошибки применяется для

проверки существенности коэффициента

регрессии и для расчета его доверительных

интервалов.

-

Определим

доверительный интервал коэффициента

регрессии.

-

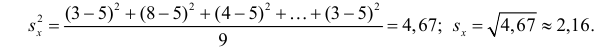

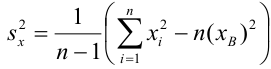

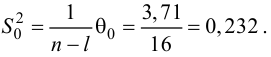

Вычислим величину

исправленной дисперсии

Выборочная

дисперсия — это оценка теоретической

дисперсии распределения на основе

выборки. Несмещённая (исправленная)

дисперсия — это случайная величина.

S2=1.85

-

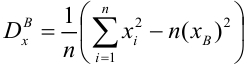

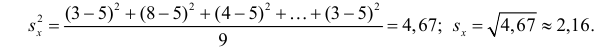

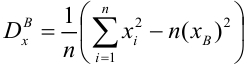

Вычислим

дисперсию.

Дисперсия признака

определяется как средний квадрат

отклонений от их средних значений.

Дисперсию используют для определения

показателей тесноты корреляционной

связи при анализе результатов выборочных

наблюдений.

-

Определим

доверительный интервал коэффициента

дисперсии.

-

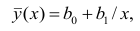

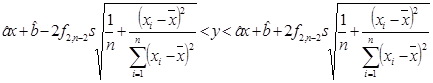

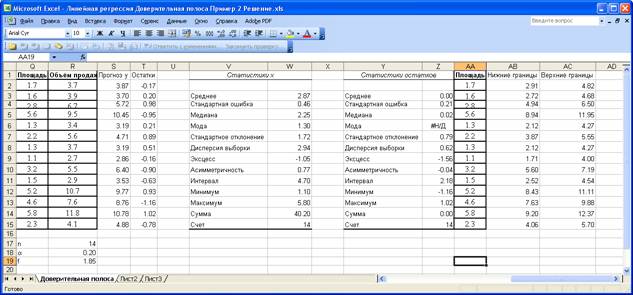

Вычислим полосу

регрессии.

Линейная

регрессия —

это индикатор статистического анализа.

Этот инструмент используется для

предсказания будущих значений по уже

имеющимся данным.

Прежде

всего это очень эффективный индикатор

для определения тренда.

-

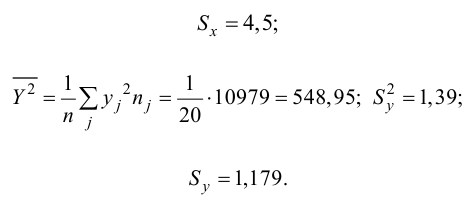

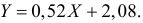

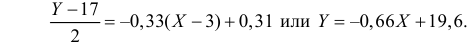

Вычислим

параметры уравнения линейной регрессии.

-

Определим

коридор регрессии.

На

основании изученной информации построим

график, на котором изобразим полосу и

коридор регрессии.

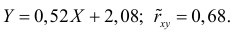

Ответ

Регрессия

для представленной выборки составляет

2,89.

Данная величина показывает среднее

изменение результата с изменением

фактора на одну единицу. Одна

из характеристик связи между зависимой

у и независимой переменной х. То есть,

можно сделать вывод, что среднее

изменение факторного признака х на

одну единицу, приводит к изменению

результативного признака у на 2,89 единиц.

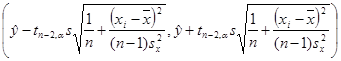

Доверительные

интервалы коэффициентов регрессии и

дисперсии соответственно равны:

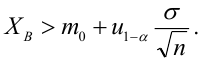

Обратим

внимание на следующую закономерность:

при заданной доверительной вероятности

с ростом объема выборки ширина

доверительного интервала уменьшается

и стремится к нулю. При заданном объеме

выборки с ростом доверительной

вероятности ширина доверительного

интервала тоже растет. Это означает,

что, чем надежнее оценка, тем меньше

точность этой оценки. И, наоборот, чем

выше точность оценки, тем меньше ее

надежность (достоверность).

Были

построены полоса (

)

и коридор регрессии.

Доверительный

коридор не является доверительной

областью для всей линии регрессии —

он определяет только концы доверительных

интервалов для y при каждом

значении x. С помощью коридора

регрессии нельзя, например, построить

одновременно два доверительных интервала

в различных точках x0 и x1.

Такие доверительные интервалы можно

построить с помощью доверительной

полосы всей линии регрессии.

С

помощью доверительной полосы можно,

например, построить одновременно

доверительные интервалы для нескольких

различных значений переменной x.

Задание

3

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Содержание:

Регрессионный анализ:

Регрессионным анализом называется раздел математической статистики, объединяющий практические методы исследования корреляционной зависимости между случайными величинами по результатам наблюдений над ними. Сюда включаются методы выбора модели изучаемой зависимости и оценки ее параметров, методы проверки статистических гипотез о зависимости.

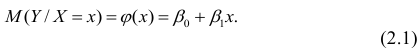

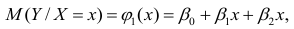

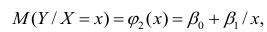

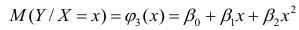

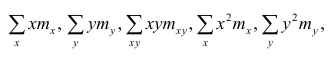

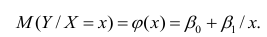

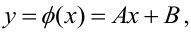

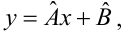

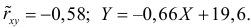

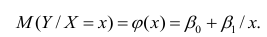

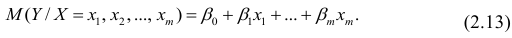

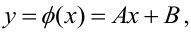

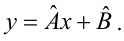

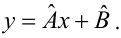

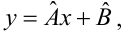

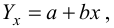

Пусть между случайными величинами X и Y существует линейная корреляционная зависимость. Это означает, что математическое ожидание Y линейно зависит от значений случайной величины X. График этой зависимости (линия регрессии Y на X) имеет уравнение

Линейная модель пригодна в качестве первого приближения и в случае нелинейной корреляции, если рассматривать небольшие интервалы возможных значений случайных величин.

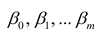

Пусть параметры линии регрессии  неизвестны, неизвестна и величина коэффициента корреляции

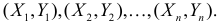

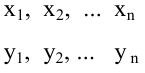

неизвестны, неизвестна и величина коэффициента корреляции  Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:

Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:  Эти результаты могут служить источником информации о неизвестных значениях

Эти результаты могут служить источником информации о неизвестных значениях  надо только уметь эту информацию извлечь оттуда.

надо только уметь эту информацию извлечь оттуда.

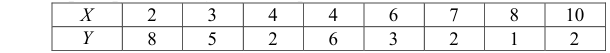

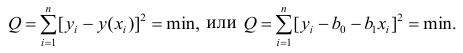

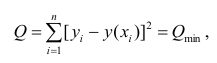

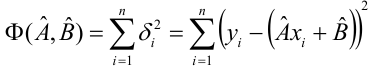

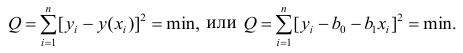

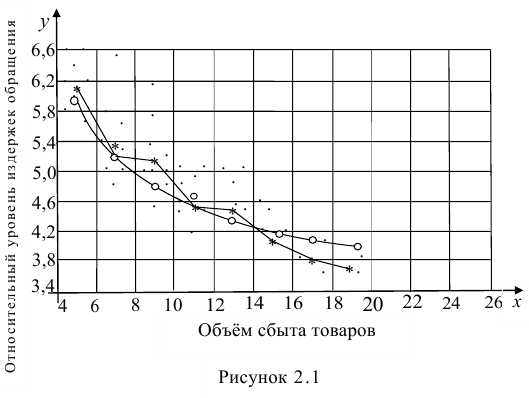

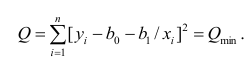

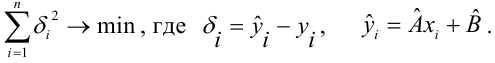

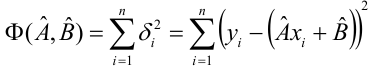

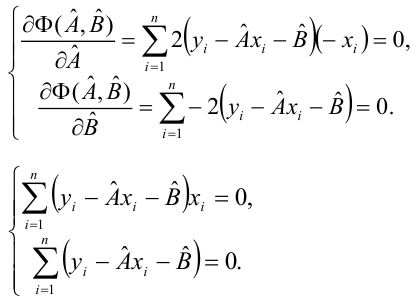

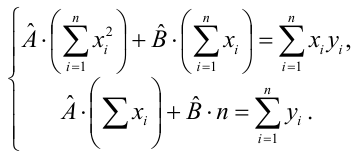

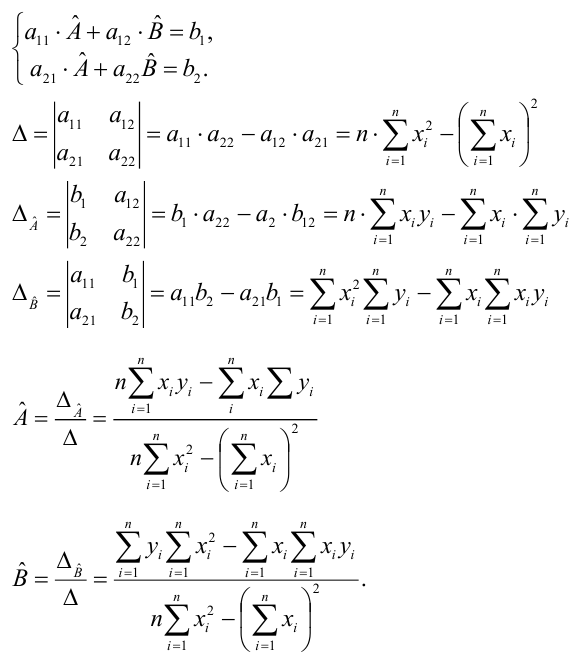

Неизвестная нам линия регрессии  как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для

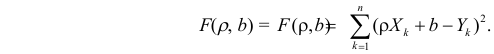

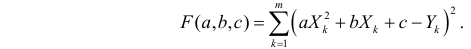

как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для  можно принять те их значения, при которых имеет минимум функция

можно принять те их значения, при которых имеет минимум функция

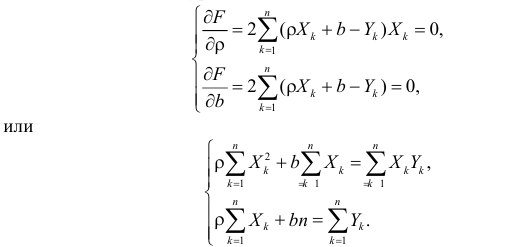

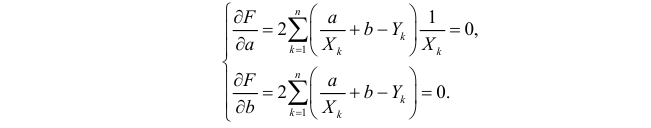

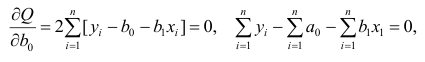

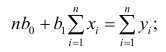

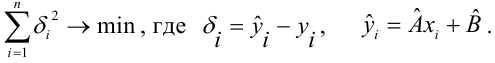

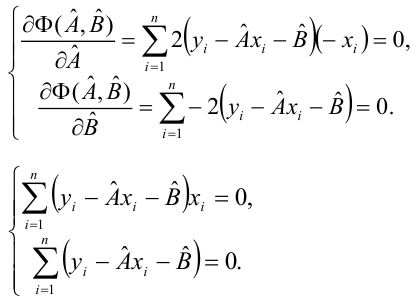

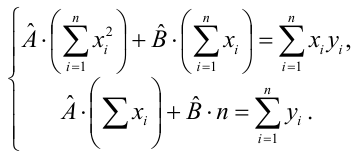

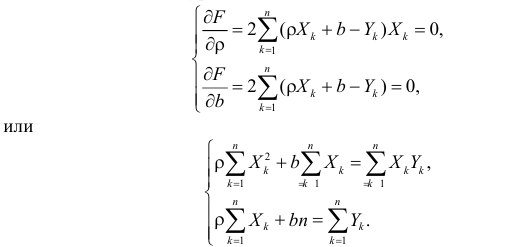

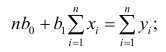

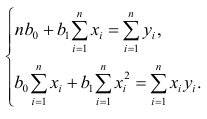

Такие значения  , согласно необходимым условиям экстремума, находятся из системы уравнений:

, согласно необходимым условиям экстремума, находятся из системы уравнений:

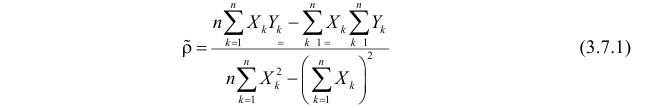

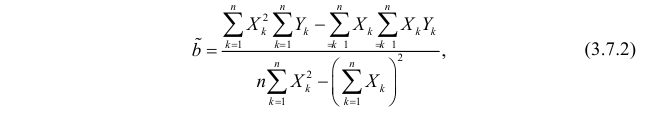

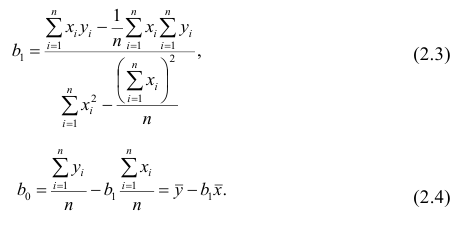

Решения этой системы уравнений дают оценки называемые оценками по методу наименьших квадратов.

и

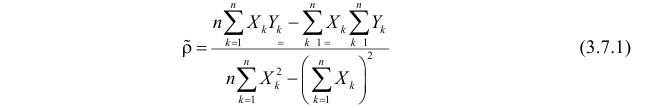

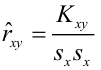

Известно, что оценки по методу наименьших квадратов являются несмещенными и, более того, среди всех несмещенных оценок обладают наименьшей дисперсией. Для оценки коэффициента корреляции можно воспользоваться тем, что  где

где  средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через

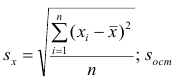

средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через  оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

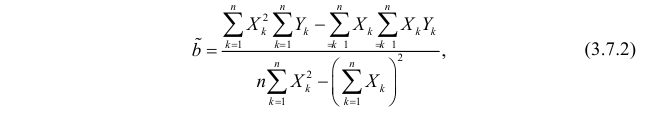

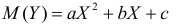

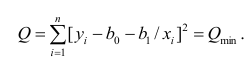

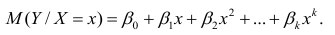

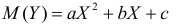

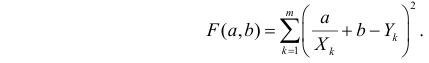

По методу наименьших квадратов можно находить оценки параметров линии регрессии и при нелинейной корреляции. Например, для линии регрессии вида  оценки параметров

оценки параметров  находятся из условия минимума функции

находятся из условия минимума функции

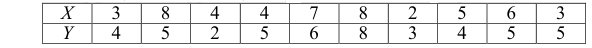

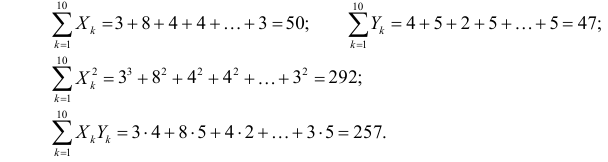

Пример:

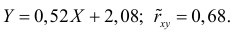

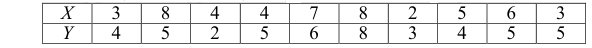

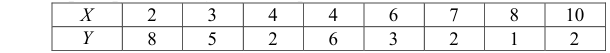

По данным наблюдений двух случайных величин найти коэффициент корреляции и уравнение линии регрессии Y на X

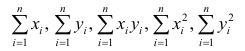

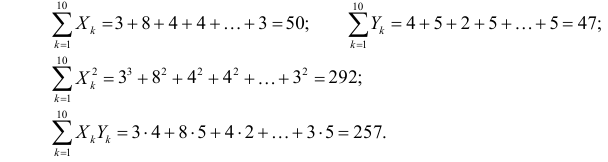

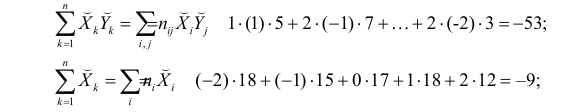

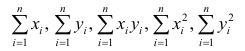

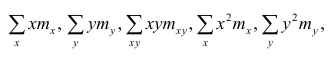

Решение. Вычислим величины, необходимые для использования формул (3.7.1)–(3.7.3):

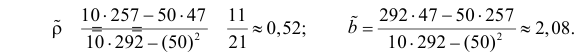

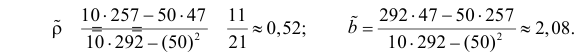

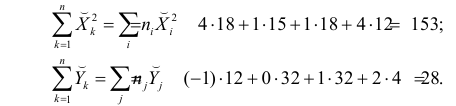

По формулам (3.7.1) и (3.7.2) получим

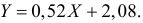

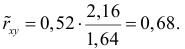

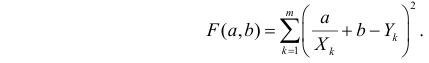

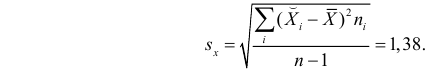

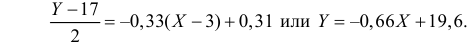

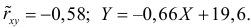

Итак, оценка линии регрессии имеет вид  Так как

Так как  то по формуле (3.1.3)

то по формуле (3.1.3)

Аналогично,  Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Ответ.

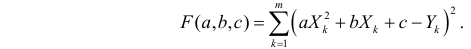

Пример:

Получена выборка значений величин X и Y

Для представления зависимости между величинами предполагается использовать модель  Найти оценки параметров

Найти оценки параметров

Решение. Рассмотрим сначала задачу оценки параметров этой модели в общем виде. Линия  играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

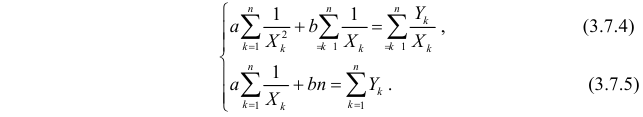

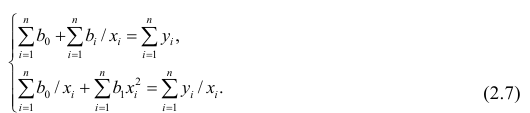

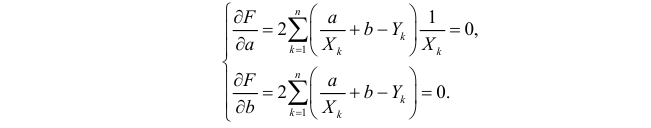

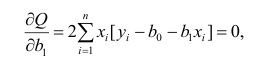

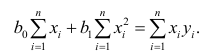

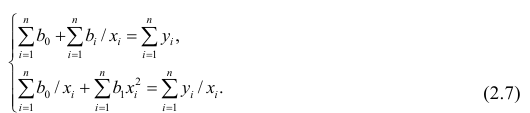

Необходимые условия экстремума приводят к системе из двух уравнений:

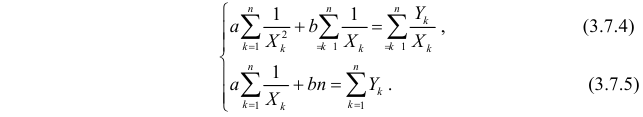

Откуда

Решения системы уравнений (3.7.4) и (3.7.5) и будут оценками по методу наименьших квадратов для параметров

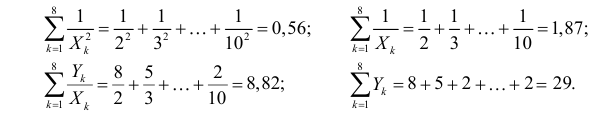

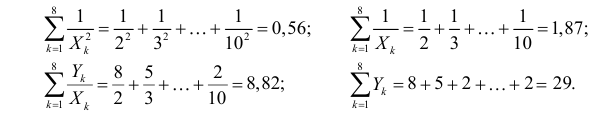

На основе опытных данных вычисляем:

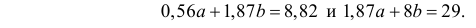

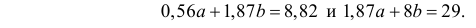

В итоге получаем систему уравнений (?????) и (?????) в виде

Эта система имеет решения

Ответ.

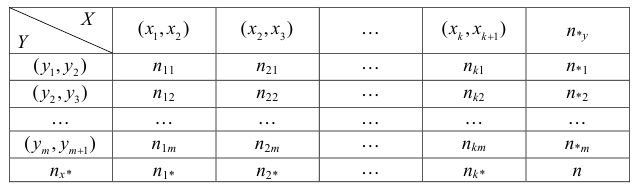

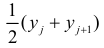

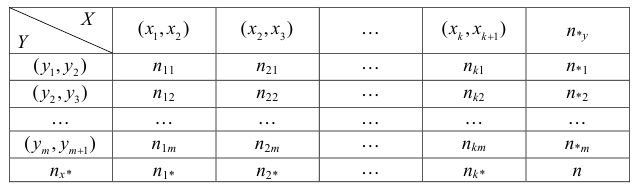

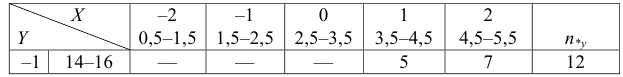

Если наблюдений много, то результаты их обычно группируют и представляют в виде корреляционной таблицы.

В этой таблице  равно числу наблюдений, для которых X находится в интервале

равно числу наблюдений, для которых X находится в интервале  а Y – в интервале

а Y – в интервале  Через

Через  обозначено число наблюдений, при которых

обозначено число наблюдений, при которых  а Y произвольно. Число наблюдений, при которых

а Y произвольно. Число наблюдений, при которых  а X произвольно, обозначено через

а X произвольно, обозначено через

Если величины дискретны, то вместо интервалов указывают отдельные значения этих величин. Для непрерывных случайных величин представителем каждого интервала считают его середину и полагают, что  и

и  наблюдались

наблюдались  раз.

раз.

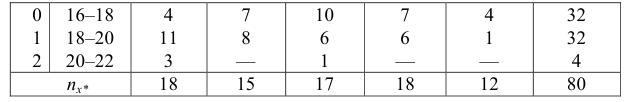

При больших значениях X и Y можно для упрощения вычислений перенести начало координат и изменить масштаб по каждой из осей, а после завершения вычислений вернуться к старому масштабу.

Пример:

Проделано 80 наблюдений случайных величин X и Y. Результаты наблюдений представлены в виде таблицы. Найти линию регрессии Y на X. Оценить коэффициент корреляции.

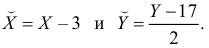

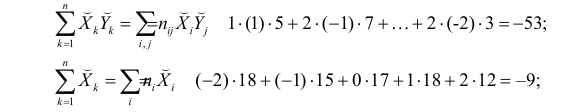

Решение. Представителем каждого интервала будем считать его середину. Перенесем начало координат и изменим масштаб по каждой оси так, чтобы значения X и Y были удобны для вычислений. Для этого перейдем к новым переменным  Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

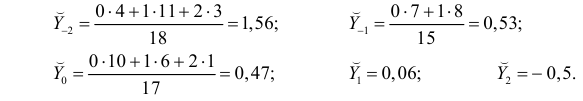

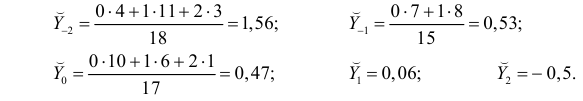

Чтобы иметь представление о виде линии регрессии, вычислим средние значения  при фиксированных значениях

при фиксированных значениях  :

:

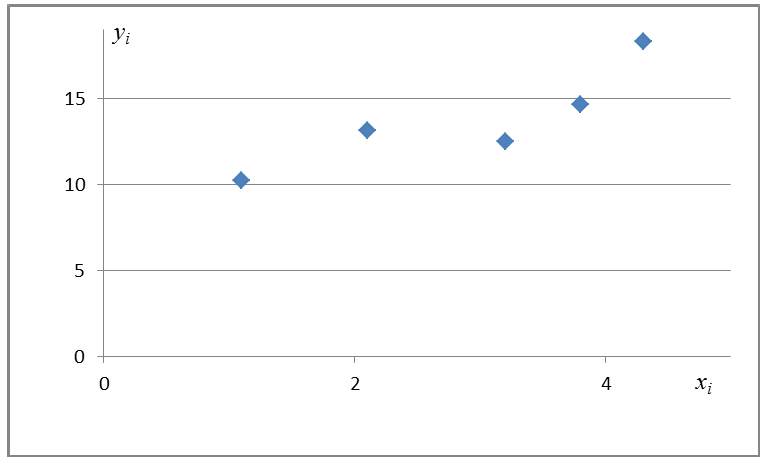

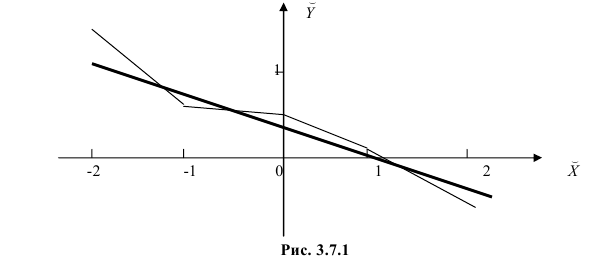

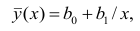

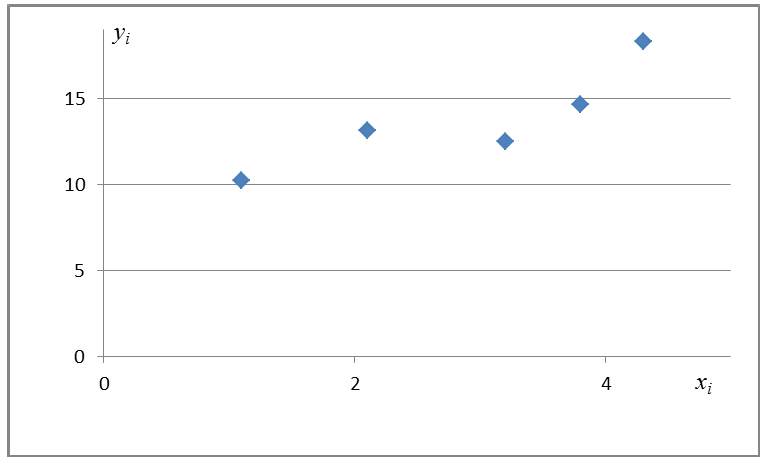

Нанесем эти значения на координатную плоскость, соединив для наглядности их отрезками прямой (рис. 3.7.1).

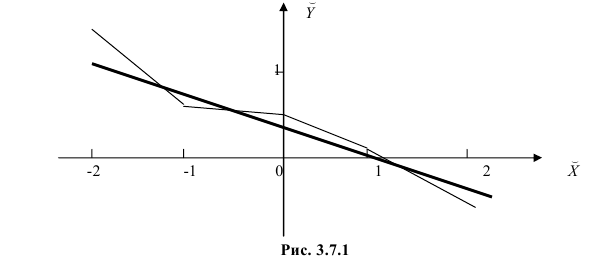

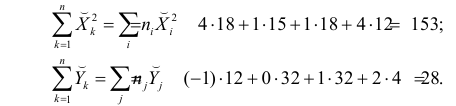

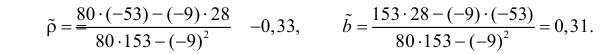

По виду полученной ломанной линии можно предположить, что линия регрессии Y на X является прямой. Оценим ее параметры. Для этого сначала вычислим с учетом группировки данных в таблице все величины, необходимые для использования формул (3.31–3.33):

Тогда

В новом масштабе оценка линии регрессии имеет вид  График этой прямой линии изображен на рис. 3.7.1.

График этой прямой линии изображен на рис. 3.7.1.

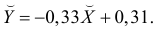

Для оценки  по корреляционной таблице можно воспользоваться формулой (3.1.3):

по корреляционной таблице можно воспользоваться формулой (3.1.3):

Подобным же образом можно оценить  величиной

величиной  Тогда оценкой коэффициента корреляции может служить величина

Тогда оценкой коэффициента корреляции может служить величина

Вернемся к старому масштабу:

Коэффициент корреляции пересчитывать не нужно, так как это величина безразмерная и от масштаба не зависит.

Ответ.

Пусть некоторые физические величины X и Y связаны неизвестной нам функциональной зависимостью  Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то

Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то  играет роль линии регрессии и все свойства линии регрессии приложимы к

играет роль линии регрессии и все свойства линии регрессии приложимы к  . В частности,

. В частности,  обычно находят по методу наименьших квадратов.

обычно находят по методу наименьших квадратов.

Регрессионный анализ

Основные положения регрессионного анализа:

Основная задача регрессионного анализа — изучение зависимости между результативным признаком Y и наблюдавшимся признаком X, оценка функции регрессий.

Предпосылки регрессионного анализа:

- Y — независимые случайные величины, имеющие постоянную дисперсию;

- X— величины наблюдаемого признака (величины не случайные);

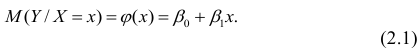

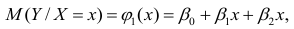

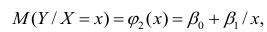

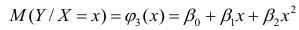

- условное математическое ожидание

можно представить в виде

можно представить в виде

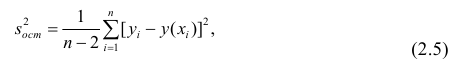

Выражение (2.1), как уже упоминалось в п. 1.2, называется функцией регрессии (или модельным уравнением регрессии) Y на X. Оценке в этом выражении подлежат параметры  называемые коэффициентами регрессии, а также

называемые коэффициентами регрессии, а также  — остаточная дисперсия.

— остаточная дисперсия.

Остаточной дисперсией называется та часть рассеивания результативного признака, которую нельзя объяснить действием наблюдаемого признака; Остаточная дисперсия может служить для оценки точности подбора вида функции регрессии (модельного уравнения регрессии), полноты набора признаков, включенных в анализ. Оценки параметров функции регрессии находят, используя метод наименьших квадратов.

В данном вопросе рассмотрен линейный регрессионный анализ. Линейным он называется потому, что изучаем лишь те виды зависимостей которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

линейны относительно параметров

линейны относительно параметров

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости  выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

Важное место в линейном регрессионном анализе занимает так называемая «нормальная регрессия». Она имеет место, если сделать предположения относительно закона распределения случайной величины Y. Предпосылки «нормальной регрессии»:

- Y — независимые случайные величины, имеющие постоянную дисперсию и распределенные по нормальному закону;

- X— величины наблюдаемого признака (величины не случайные);

- условное математическое ожидание

можно представить в виде (2.1).

можно представить в виде (2.1).

В этом случае оценки коэффициентов регрессии — несмещённые с минимальной дисперсией и нормальным законом распределения. Из этого положения следует что при «нормальной регрессии» имеется возможность оценить значимость оценок коэффициентов регрессии, а также построить доверительный интервал для коэффициентов регрессии и условного математического ожидания M(YX=x).

Линейная регрессия

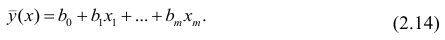

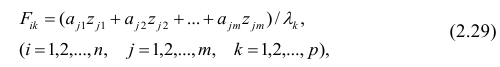

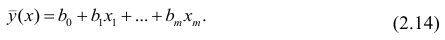

Рассмотрим простейший случай регрессионного анализа — модель вида (2.1), когда зависимость  линейна и по оцениваемым параметрам, и

линейна и по оцениваемым параметрам, и

по переменным. Оценки параметров модели (2.1)  обозначил

обозначил  Оценку остаточной дисперсии

Оценку остаточной дисперсии  обозначим

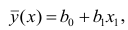

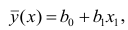

обозначим  Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии

Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии  коэффициенты которого

коэффициенты которого  находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака

находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака от вычисленных по уравнению регрессии

от вычисленных по уравнению регрессии

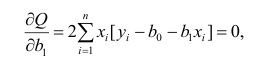

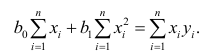

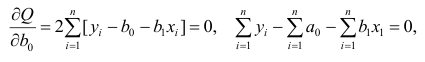

Составим систему нормальных уравнений: первое уравнение

откуда

второе уравнение

откуда

Итак,

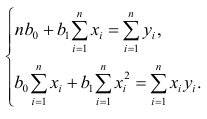

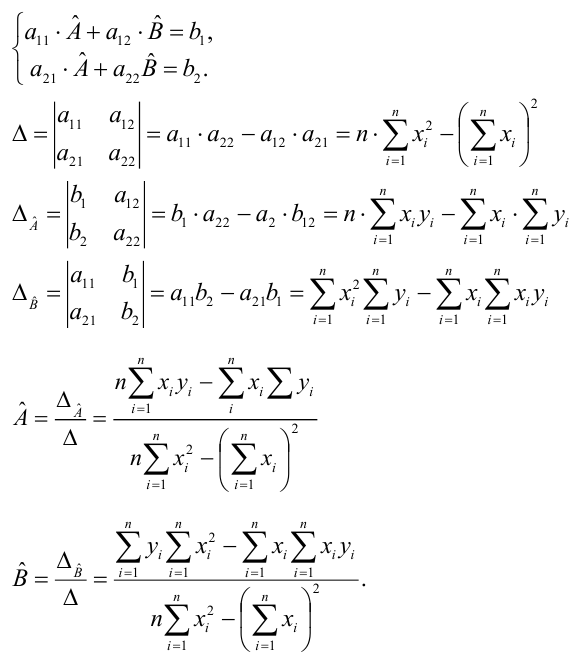

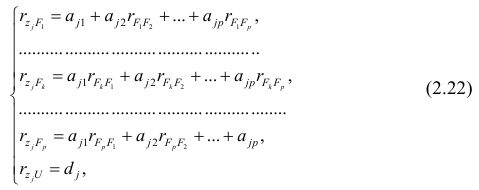

Оценки, полученные по способу наименьших квадратов, обладают минимальной дисперсией в классе линейных оценок. Решая систему (2.2) относительно найдём оценки параметров

найдём оценки параметров

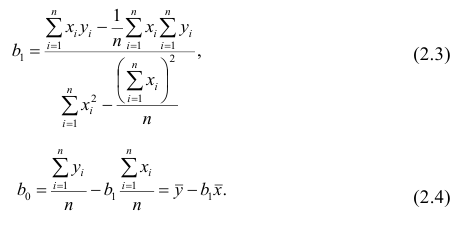

Остаётся получить оценку параметра  . Имеем

. Имеем

где т — количество наблюдений.

Еслит велико, то для упрощения расчётов наблюдавшиеся данные принята группировать, т.е. строить корреляционную таблицу. Пример построения такой таблицы приведен в п. 1.5. Формулы для нахождения коэффициентов регрессии по сгруппированным данным те же, что и для расчёта по несгруппированным данным, но суммы заменяют на

заменяют на

где  — частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

— частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

Нелинейная регрессия

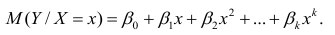

Рассмотрим случай, когда зависимость нелинейна по переменным х, например модель вида

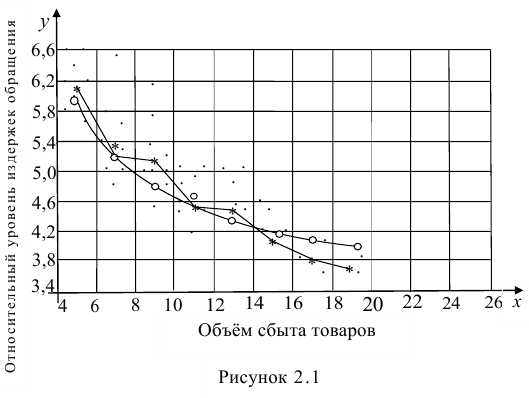

На рис. 2.1 изображено поле корреляции. Очевидно, что зависимость между Y и X нелинейная и её графическим изображением является не прямая, а кривая. Оценкой выражения (2.6) является уравнение регрессии

где  —оценки коэффициентов регрессии

—оценки коэффициентов регрессии

Принцип нахождения коэффициентов тот же — метод наименьших квадратов, т.е.

или

Дифференцируя последнее равенство по  и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

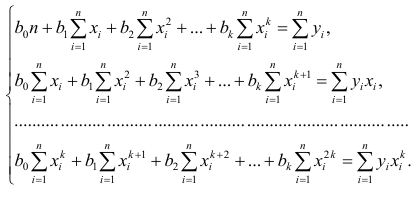

В общем случае нелинейной зависимости между переменными Y и X связь может выражаться многочленом k-й степени от x:

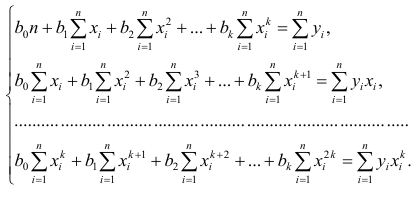

Коэффициенты регрессии определяют по принципу наименьших квадратов. Система нормальных уравнений имеет вид

Вычислив коэффициенты системы, её можно решить любым известным способом.

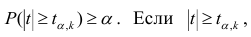

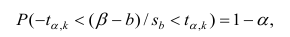

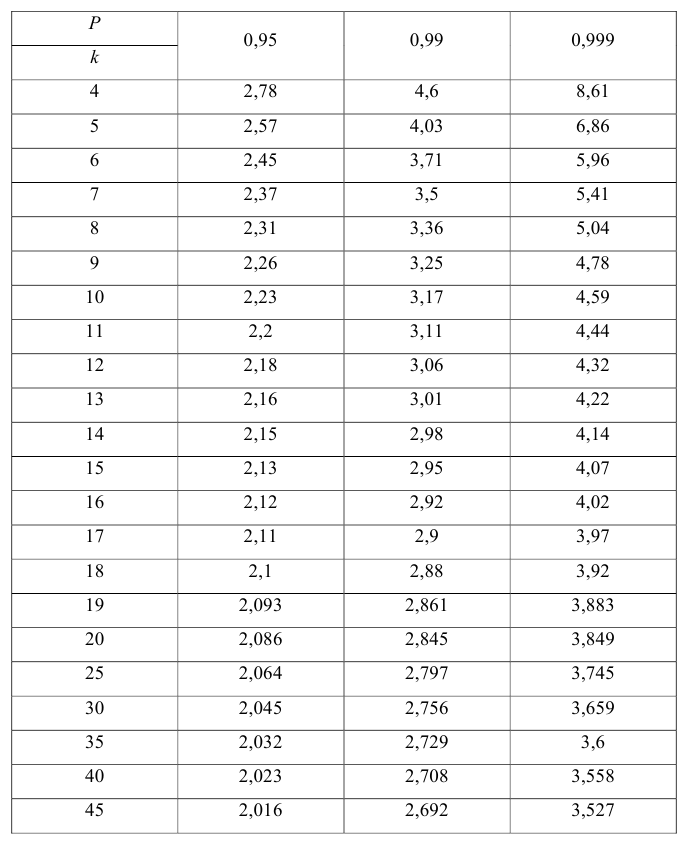

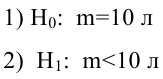

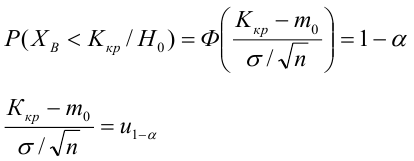

Оценка значимости коэффициентов регрессии. Интервальная оценка коэффициентов регрессии

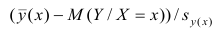

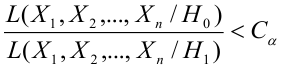

Проверить значимость оценок коэффициентов регрессии — значит установить, достаточна ли величина оценки для статистически обоснованного вывода о том, что коэффициент регрессии отличен от нуля. Для этого проверяют гипотезу о равенстве нулю коэффициента регрессии, соблюдая предпосылки «нормальной регрессии». В этом случае вычисляемая для проверки нулевой гипотезы  статистика

статистика

имеет распределение Стьюдента с к= n-2 степенями свободы (b — оценка коэффициента регрессии,  — оценка среднеквадратического отклонения

— оценка среднеквадратического отклонения

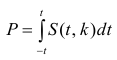

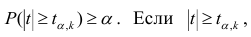

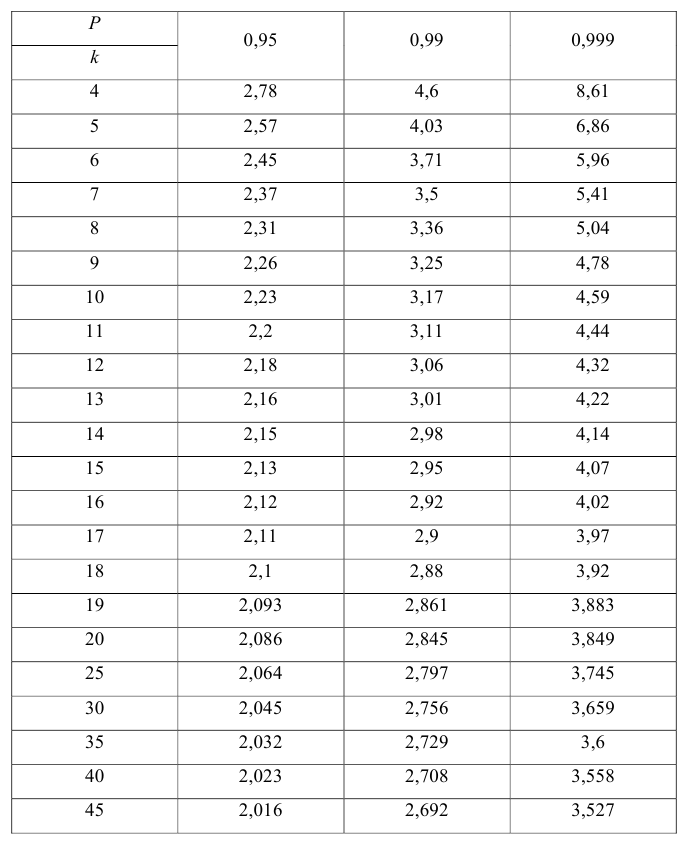

коэффициента регрессии, иначе стандартная ошибка оценки). По уровню значимости а и числу степеней свободы к находят по таблицам распределения Стьюдента (см. табл. 1 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При нет оснований отвергать нулевую гипотезу.

нет оснований отвергать нулевую гипотезу.

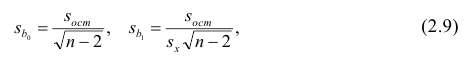

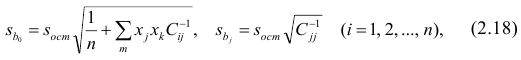

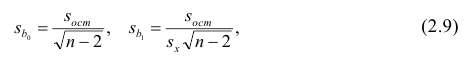

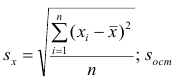

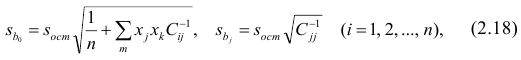

Оценки среднеквадратического отклонения коэффициентов регрессии вычисляют по следующим формулам:

где  — оценка остаточной дисперсии, вычисляемая по

— оценка остаточной дисперсии, вычисляемая по

формуле (2.5).

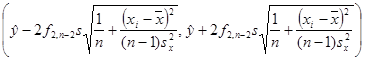

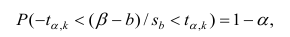

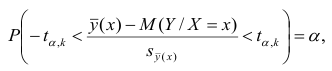

Доверительный интервал для значимых параметров строят по обычной схеме. Из условия

где а — уровень значимости, находим

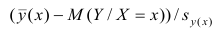

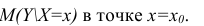

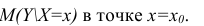

Интервальная оценка для условного математического ожидания

Линия регрессии характеризует изменение условного математического ожидания результативного признака от вариации остальных признаков.

Точечной оценкой условного математического ожидания  является условное среднее

является условное среднее  Кроме точечной оценки для

Кроме точечной оценки для  можно

можно

построить доверительный интервал в точке

Известно, что  имеет распределение

имеет распределение

Стьюдента с k=n—2 степенями свободы. Найдя оценку среднеквадратического отклонения для условного среднего, можно построить доверительный интервал для условного математического ожидания

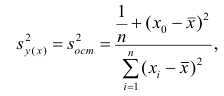

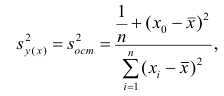

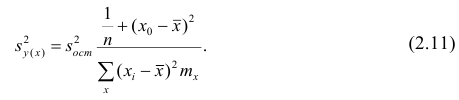

Оценку дисперсии условного среднего вычисляют по формуле

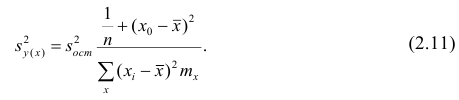

или для интервального ряда

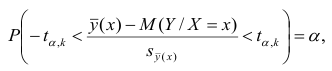

Доверительный интервал находят из условия

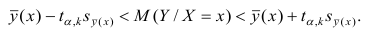

где а — уровень значимости. Отсюда

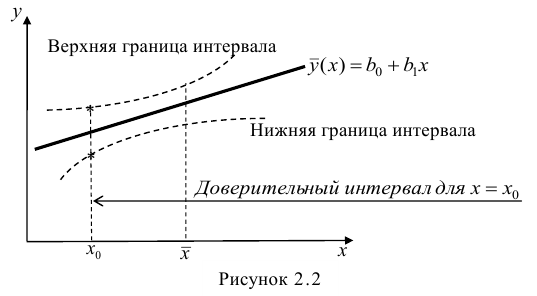

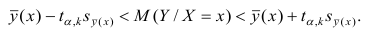

Доверительный интервал для условного математического ожидания можно изобразить графически (рис, 2.2).

Из рис. 2.2 видно, что в точке  границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

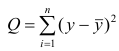

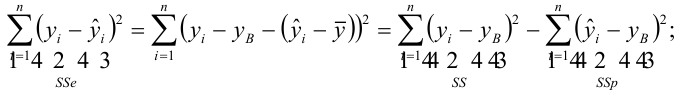

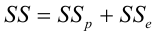

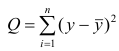

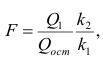

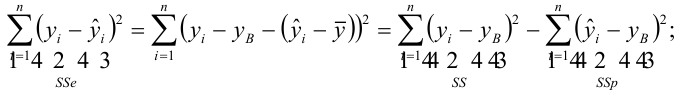

Проверка значимости уравнения регрессии

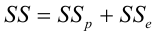

Оценить значимость уравнения регрессии — значит установить, соответствует ли математическая, модель, выражающая зависимость между Y и X, экспериментальным данным. Для оценки значимости в предпосылках «нормальной регрессии» проверяют гипотезу  Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением

Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением  — Общая сумма квадратов отклонений результативного признака

— Общая сумма квадратов отклонений результативного признака

разлагается на

разлагается на  (сумму, характеризующую влияние признака

(сумму, характеризующую влияние признака

X) и  (остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

(остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

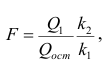

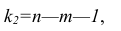

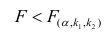

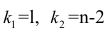

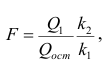

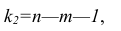

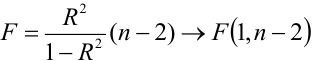

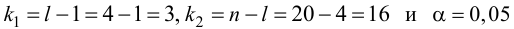

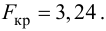

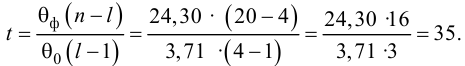

Для проверки нулевой гипотезы вычисляют статистику  которая имеет распределение Фишера-Снедекора с А

которая имеет распределение Фишера-Снедекора с А степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы

степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы  находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение

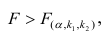

находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  . Если

. Если  нулевую гипотезу отвергают, уравнение считают значимым. Если

нулевую гипотезу отвергают, уравнение считают значимым. Если  то нет оснований отвергать нулевую гипотезу.

то нет оснований отвергать нулевую гипотезу.

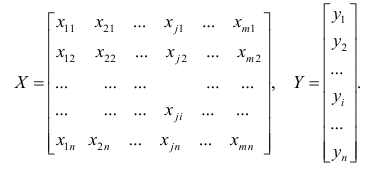

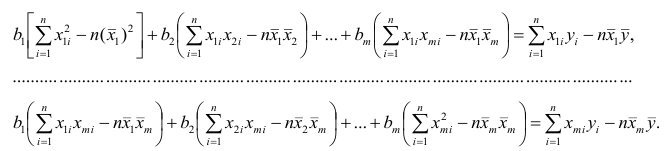

Многомерный регрессионный анализ

В случае, если изменения результативного признака определяются действием совокупности других признаков, имеет место многомерный регрессионный анализ. Пусть результативный признак У, а независимые признаки  Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним

Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним  и постоянной дисперсией

и постоянной дисперсией  — линейно независимые векторы

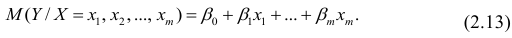

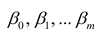

— линейно независимые векторы  . Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

. Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

Оценке подлежат параметры  и остаточная дисперсия.

и остаточная дисперсия.

Заменив параметры их оценками, запишем уравнение регрессии

Коэффициенты в этом выражении находят методом наименьших квадратов.

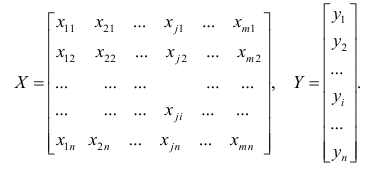

Исходными данными для вычисления коэффициентов  является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

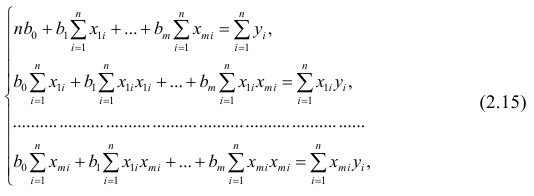

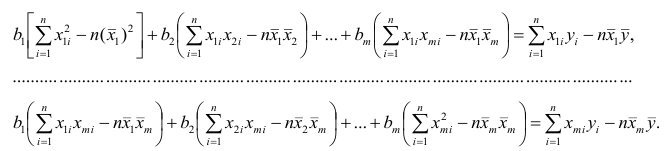

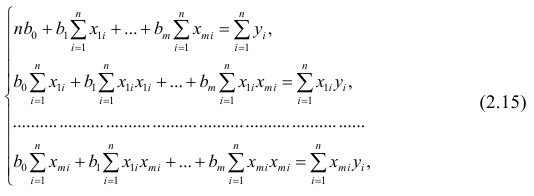

Как и в двумерном случае, составляют систему нормальных уравнений

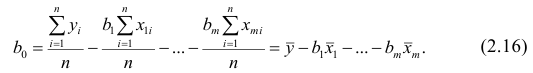

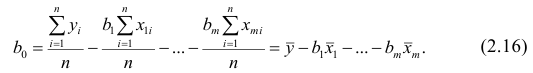

которую можно решить любым способом, известным из линейной алгебры. Рассмотрим один из них — способ обратной матрицы. Предварительно преобразуем систему уравнений. Выразим из первого уравнения значение  через остальные параметры:

через остальные параметры:

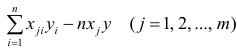

Подставим в остальные уравнения системы вместо  полученное выражение:

полученное выражение:

Пусть С — матрица коэффициентов при неизвестных параметрах

— матрица, обратная матрице С;

— матрица, обратная матрице С;  — элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы

— элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы — выражение

— выражение

. Тогда, используя формулы линейной алгебры,

. Тогда, используя формулы линейной алгебры,

запишем окончательные выражения для параметров:

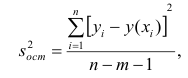

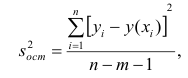

Оценкой остаточной дисперсии является

является

где  — измеренное значение результативного признака;

— измеренное значение результативного признака; значение результативного признака, вычисленное по уравнению регрессий.

значение результативного признака, вычисленное по уравнению регрессий.

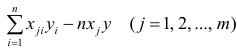

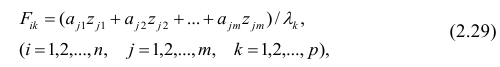

Если выборка получена из нормально распределенной генеральной совокупности, то, аналогично изложенному в п. 2.4, можно проверить значимость оценок коэффициентов регрессии, только в данном случае статистику вычисляют для каждого j-го коэффициента регрессии

вычисляют для каждого j-го коэффициента регрессии

где  —элемент обратной матрицы, стоящий на пересечении i-й строки и j-

—элемент обратной матрицы, стоящий на пересечении i-й строки и j-

го столбца; —диагональный элемент обратной матрицы.

—диагональный элемент обратной матрицы.

При заданном уровне значимости а и числе степеней свободы к=n— m—1 по табл. 1 приложений находят критическое значение  Если

Если то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

Для значимых коэффициентов регрессии целесообразно построить доверительные интервалы по формуле (2.10). Для оценки значимости уравнения регрессии следует проверить нулевую гипотезу о том, что все коэффициенты регрессии (кроме свободного члена) равны нулю:

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики  , где

, где  — сумма квадратов, характеризующая влияние признаков X;

— сумма квадратов, характеризующая влияние признаков X;  — остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

— остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

Для уровня значимости а и числа степеней свободы

Для уровня значимости а и числа степеней свободы  по табл. 3 приложений находят критическое значение

по табл. 3 приложений находят критическое значение  Если

Если  то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При

то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При  нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

Факторный анализ

Основные положения. В последнее время всё более широкое распространение находит один из новых разделов многомерного статистического анализа — факторный анализ. Первоначально этот метод

разрабатывался для объяснения многообразия корреляций между исходными параметрами. Действительно, результатом корреляционного анализа является матрица коэффициентов корреляций. При малом числе параметров можно произвести визуальный анализ этой матрицы. С ростом числа параметра (10 и более) визуальный анализ не даёт положительных результатов. Оказалось, что всё многообразие корреляционных связей можно объяснить действием нескольких обобщённых факторов, являющихся функциями исследуемых параметров, причём сами обобщённые факторы при этом могут быть и неизвестны, однако их можно выразить через исследуемые параметры.

Один из основоположников факторного анализа Л. Терстоун приводит такой пример: несколько сотен мальчиков выполняют 20 разнообразных гимнастических упражнений. Каждое упражнение оценивают баллами. Можно рассчитать матрицу корреляций между 20 упражнениями. Это большая матрица размером 20><20. Изучая такую матрицу, трудно уловить закономерность связей между упражнениями. Нельзя ли объяснить скрытую в таблице закономерность действием каких-либо обобщённых факторов, которые в результате эксперимента непосредственно, не оценивались? Оказалось, что обо всех коэффициентах корреляции можно судить по трём обобщённым факторам, которые и определяют успех выполнения всех 20 гимнастических упражнений: чувство равновесия, усилие правого плеча, быстрота движения тела.

Дальнейшие разработки факторного анализа доказали, что этот метод может быть с успехом применён в задачах группировки и классификации объектов. Факторный анализ позволяет группировать объекты со сходными сочетаниями признаков и группировать признаки с общим характером изменения от объекта к объекту. Действительно, выделенные обобщённые факторы можно использовать как критерии при классификации мальчиков по способностям к отдельным группам гимнастических упражнений.

Методы факторного анализа находят применение в психологии и экономике, социологии и экономической географии. Факторы, выраженные через исходные параметры, как правило, легко интерпретировать как некоторые существенные внутренние характеристики объектов.

Факторный анализ может быть использован и как самостоятельный метод исследования, и вместе с другими методами многомерного анализа, например в сочетании с регрессионным анализом. В этом случае для набора зависимых переменных наводят обобщённые факторы, которые потом входят в регрессионный анализ в качестве переменных. Такой подход позволяет сократить число переменных в регрессионном анализе, устранить коррелированность переменных, уменьшить влияние ошибок и в случае ортогональности выделенных факторов значительно упростить оценку значимости переменных.

Представление, информации в факторном анализе

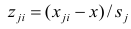

Для проведения факторного анализа информация должна быть представлена в виде двумерной таблицы чисел размерностью  аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений

аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений  столбцы — признакам

столбцы — признакам таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных

таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных  переходят к переменным

переходят к переменным  В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

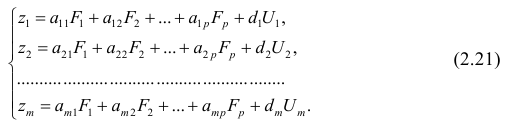

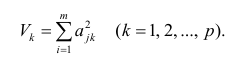

Основная модель факторного анализа. Основная модель факторного анализа имеет вид

где  -j-й признак (величина случайная);

-j-й признак (величина случайная);  — общие факторы (величины случайные, имеющие нормальный закон распределения);

— общие факторы (величины случайные, имеющие нормальный закон распределения);  — характерный фактор;

— характерный фактор;  — факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению);

— факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению); — нагрузка характерного фактора.

— нагрузка характерного фактора.

Модель предполагает, что каждый из j признаков, входящих в исследуемый набор и заданных в стандартной форме, может быть представлен в виде линейной комбинации небольшого числа общих факторов  и характерного фактора

и характерного фактора

Термин «общий фактор» подчёркивает, что каждый такой фактор имеет существенное значение для анализа всех признаков , т.е.

, т.е.

Термин «характерный фактор» показывает, что он относится только к данному j-му признаку. Это специфика признака, которая не может быть, выражена через факторы

Факторные нагрузки  . характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

. характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

Для j-го признака и i-го объекта модель (2.19) можно записать в. виде

где  значение k-го фактора для i-го объекта.

значение k-го фактора для i-го объекта.

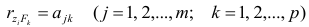

Дисперсию признака  можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность

можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность  и часть, обусловленную действием j-го характера фактора, характерность

и часть, обусловленную действием j-го характера фактора, характерность  Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака

Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака  Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Если общие и характерные факторы не коррелируют между собой, то дисперсию j-го признака можно представить в виде

где  —доля дисперсии признака

—доля дисперсии признака  приходящаяся на k-й фактор.

приходящаяся на k-й фактор.

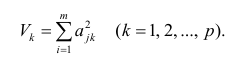

Полный вклад k-го фактора в суммарную дисперсию признаков

Вклад общих факторов в суммарную дисперсию

Факторное отображение

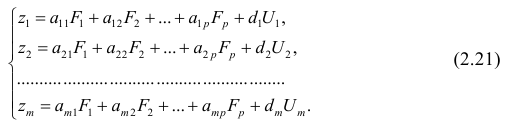

Используя модель (2.19), запишем выражения для каждого из параметров:

Коэффициенты системы (2,21) — факторные нагрузки — можно представить в виде матрицы, каждая строка которой соответствует параметру, а столбец — фактору.

Факторный анализ позволяет получить не только матрицу отображений, но и коэффициенты корреляции между параметрами и

факторами, что является важной характеристикой качества факторной модели. Таблица таких коэффициентов корреляции называется факторной структурой или просто структурой.

Коэффициенты отображения можно выразить через выборочные парные коэффициенты корреляции. На этом основаны методы вычисления факторного отображения.

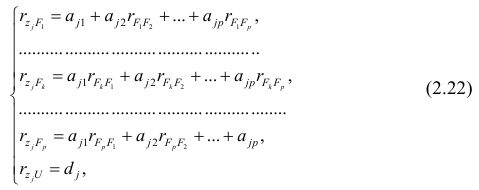

Рассмотрим связь между элементами структуры и коэффициентами отображения. Для этого, учитывая выражение (2.19) и определение выборочного коэффициента корреляции, умножим уравнения системы (2.21) на соответствующие факторы, произведём суммирование по всем n наблюдениям и, разделив на n, получим следующую систему уравнений:

где — выборочный коэффициент корреляции между j-м параметром и к-

— выборочный коэффициент корреляции между j-м параметром и к-

м фактором; — коэффициент корреляции между к-м и р-м факторами.

— коэффициент корреляции между к-м и р-м факторами.

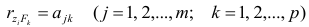

Если предположить, что общие факторы между собой, не коррелированы, то уравнения (2.22) можно записать в виде

, т.е. коэффициенты отображения равны

, т.е. коэффициенты отображения равны

элементам структуры.

Введём понятие, остаточного коэффициента корреляции и остаточной корреляционной матрицы. Исходной информацией для построения факторной модели (2.19) служит матрица выборочных парных коэффициентов корреляции. Используя построенную факторную модель, можно снова вычислить коэффициенты корреляции между признаками и сравнись их с исходными Коэффициентами корреляции. Разница между ними и есть остаточный коэффициент корреляции.

В случае независимости факторов имеют место совсем простые выражения для вычисляемых коэффициентов корреляции между параметрами: для их вычисления достаточно взять сумму произведений коэффициентов отображения, соответствующих наблюдавшимся признакам:

где  —вычисленный по отображению коэффициент корреляции между j-м

—вычисленный по отображению коэффициент корреляции между j-м

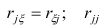

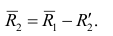

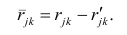

и к-м признаком. Остаточный коэффициент корреляции

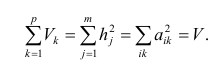

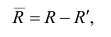

Матрица остаточных коэффициентов корреляции называется остаточной матрицей или матрицей остатков

где  — матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

— матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

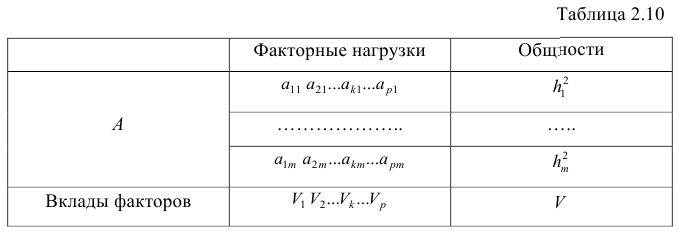

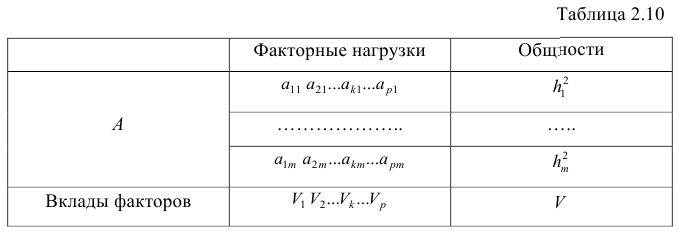

Результаты факторного анализа удобно представить в виде табл. 2.10.

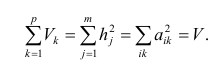

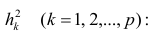

Здесь суммы квадратов нагрузок по строкам — общности параметров, а суммы квадратов нагрузок по столбцам — вклады факторов в суммарную дисперсию параметров. Имеет место соотношение

Определение факторных нагрузок

Матрицу факторных нагрузок можно получить различными способами. В настоящее время наибольшее распространение получил метод главных факторов. Этот метод основан на принципе последовательных приближений и позволяет достичь любой точности. Метод главных факторов предполагает использование ЭВМ. Существуют хорошие алгоритмы и программы, реализующие все вычислительные процедуры.

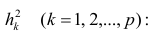

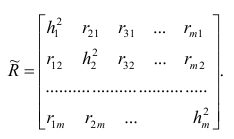

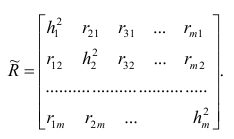

Введём понятие редуцированной корреляционной матрицы или просто редуцированной матрицы. Редуцированной называется матрица выборочных коэффициентов корреляции у которой на главной диагонали стоят значения общностей

у которой на главной диагонали стоят значения общностей  :

:

Редуцированная и полная матрицы связаны соотношением

где D — матрица характерностей.

Общности, как правило, неизвестны, и нахождение их в факторном анализе представляет серьезную проблему. Вначале определяют (хотя бы приближённо) число общих факторов, совокупность, которых может с достаточной точностью аппроксимировать все взаимосвязи выборочной корреляционной матрицы. Доказано, что число общих факторов (общностей) равно рангу редуцированной матрицы, а при известном ранге можно по выборочной корреляционной матрице найти оценки общностей. Числа общих факторов можно определить априори, исходя из физической природы эксперимента. Затем рассчитывают матрицу факторных нагрузок. Такая матрица, рассчитанная методом главных факторов, обладает одним интересным свойством: сумма произведений каждой пары её столбцов равна нулю, т.е. факторы попарно ортогональны.

Сама процедура нахождения факторных нагрузок, т.е. матрицы А, состоит из нескольких шагов и заключается в следующем: на первом шаге ищут коэффициенты факторных нагрузок при первом факторе так, чтобы сумма вкладов данного фактора в суммарную общность была максимальной:

Максимум  должен быть найден при условии

должен быть найден при условии

где  —общность

—общность параметра

параметра

Затем рассчитывают матрицу коэффициентов корреляции с учётом только первого фактора Имея эту матрицу, получают первую матрицу остатков:

Имея эту матрицу, получают первую матрицу остатков:

На втором шаге определяют коэффициенты нагрузок при втором факторе так, чтобы сумма вкладов второго фактора в остаточную общность (т.е. полную общность без учёта той части, которая приходится на долю первого фактора) была максимальной. Сумма квадратов нагрузок при втором факторе

Максимум  находят из условия

находят из условия

где  — коэффициент корреляции из первой матрицы остатков;

— коэффициент корреляции из первой матрицы остатков;  — факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

— факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

Факторный анализ учитывает суммарную общность. Исходная суммарная общность Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на

Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на  — наперёд заданное малое число).

— наперёд заданное малое число).

Адекватность факторной модели оценивается по матрице остатков (если величины её коэффициентов малы, то модель считают адекватной).

Такова последовательность шагов для нахождения факторных нагрузок. Для нахождения максимума функции (2.24) при условии (2.25) используют метод множителей Лагранжа, который приводит к системе т уравнений относительно m неизвестных

Метод главных компонент

Разновидностью метода главных факторов является метод главных компонент или компонентный анализ, который реализует модель вида

где m — количество параметров (признаков).

Каждый из наблюдаемых, параметров линейно зависит от m не коррелированных между собой новых компонент (факторов)  По сравнению с моделью факторного анализа (2.19) в модели (2.28) отсутствует характерный фактор, т.е. считается, что вся вариация параметра может быть объяснена только действием общих или главных факторов. В случае компонентного анализа исходной является матрица коэффициентов корреляции, где на главной диагонали стоят единицы. Результатом компонентного анализа, так же как и факторного, является матрица факторных нагрузок. Поиск факторного решения — это ортогональное преобразование матрицы исходных переменных, в результате которого каждый параметр может быть представлен линейной комбинацией найденных m факторов, которые называют главными компонентами. Главные компоненты легко выражаются через наблюдённые параметры.

По сравнению с моделью факторного анализа (2.19) в модели (2.28) отсутствует характерный фактор, т.е. считается, что вся вариация параметра может быть объяснена только действием общих или главных факторов. В случае компонентного анализа исходной является матрица коэффициентов корреляции, где на главной диагонали стоят единицы. Результатом компонентного анализа, так же как и факторного, является матрица факторных нагрузок. Поиск факторного решения — это ортогональное преобразование матрицы исходных переменных, в результате которого каждый параметр может быть представлен линейной комбинацией найденных m факторов, которые называют главными компонентами. Главные компоненты легко выражаются через наблюдённые параметры.

Если для дальнейшего анализа оставить все найденные т компонент, то тем самым будет использована вся информация, заложенная в корреляционной матрице. Однако это неудобно и нецелесообразно. На практике обычно оставляют небольшое число компонент, причём количество их определяется долей суммарной дисперсии, учитываемой этими компонентами. Существуют различные критерии для оценки числа оставляемых компонент; чаще всего используют следующий простой критерий: оставляют столько компонент, чтобы суммарная дисперсия, учитываемая ими, составляла заранее установленное число процентов. Первая из компонент должна учитывать максимум суммарной дисперсии параметров; вторая — не коррелировать с первой и учитывать максимум оставшейся дисперсии и так до тех пор, пока вся дисперсия не будет учтена. Сумма учтённых всеми компонентами дисперсий равна сумме дисперсий исходных параметров. Математический аппарат компонентного анализа полностью совпадает с аппаратом метода главных факторов. Отличие только в исходной матрице корреляций.

Компонента (или фактор) через исходные переменные выражается следующим образом:

где  — элементы факторного решения:

— элементы факторного решения: — исходные переменные;

— исходные переменные;  .— k-е собственное значение; р — количество оставленных главных

.— k-е собственное значение; р — количество оставленных главных

компонент.

Для иллюстрации возможностей факторного анализа покажем, как, используя метод главных компонент, можно сократить размерность пространства независимых переменных, перейдя от взаимно коррелированных параметров к независимым факторам, число которых р

Следует особо остановиться на интерпретации результатов, т.е. на смысловой стороне факторного анализа. Собственно факторный анализ состоит из двух важных этапов; аппроксимации корреляционной матрицы и интерпретации результатов. Аппроксимировать корреляционную матрицу, т.е. объяснить корреляцию между параметрами действием каких-либо общих для них факторов, и выделить сильно коррелирующие группы параметров достаточно просто: из корреляционной матрицы одним из методов

факторного анализа непосредственно получают матрицу нагрузок — факторное решение, которое называют прямым факторным решением. Однако часто это решение не удовлетворяет исследователей. Они хотят интерпретировать фактор как скрытый, но существенный параметр, поведение которого определяет поведение некоторой своей группы наблюдаемых параметров, в то время как, поведение других параметров определяется поведением других факторов. Для этого у каждого параметра должна быть наибольшая по модулю факторная нагрузка с одним общим фактором. Прямое решение следует преобразовать, что равносильно повороту осей общих факторов. Такие преобразования называют вращениями, в итоге получают косвенное факторное решение, которое и является результатом факторного анализа.

Приложения

Значение t — распределения Стьюдента

Понятие о регрессионном анализе. Линейная выборочная регрессия. Метод наименьших квадратов (МНК)

Основные задачи регрессионного анализа:

- Вычисление выборочных коэффициентов регрессии

- Проверка значимости коэффициентов регрессии

- Проверка адекватности модели

- Выбор лучшей регрессии

- Вычисление стандартных ошибок, анализ остатков

Построение простой регрессии по экспериментальным данным.

Предположим, что случайные величины  связаны линейной корреляционной зависимостью

связаны линейной корреляционной зависимостью  для отыскания которой проведено

для отыскания которой проведено  независимых измерений

независимых измерений

Диаграмма рассеяния (разброса, рассеивания)

— координаты экспериментальных точек.

— координаты экспериментальных точек.

Выборочное уравнение прямой линии регрессии  имеет вид

имеет вид

Задача: подобрать  таким образом, чтобы экспериментальные точки как можно ближе лежали к прямой

таким образом, чтобы экспериментальные точки как можно ближе лежали к прямой

Для того, что бы провести прямую  воспользуемся МНК. Потребуем,

воспользуемся МНК. Потребуем,

чтобы

Постулаты регрессионного анализа, которые должны выполняться при использовании МНК.

подчинены нормальному закону распределения.

подчинены нормальному закону распределения.- Дисперсия

постоянна и не зависит от номера измерения.

постоянна и не зависит от номера измерения. - Результаты наблюдений

в разных точках независимы.

в разных точках независимы. - Входные переменные

независимы, неслучайны и измеряются без ошибок.

независимы, неслучайны и измеряются без ошибок.

Введем функцию ошибок  и найдём её минимальное значение

и найдём её минимальное значение

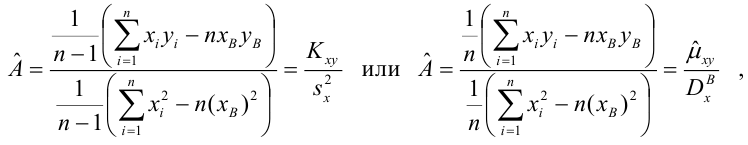

Решив систему, получим искомые значения

является несмещенными оценками истинных значений коэффициентов

является несмещенными оценками истинных значений коэффициентов

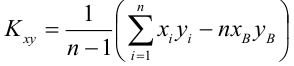

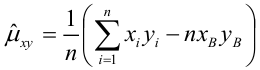

где

где

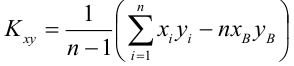

несмещенная оценка корреляционного момента (ковариации),

несмещенная оценка корреляционного момента (ковариации),

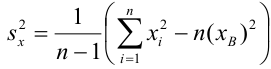

несмещенная оценка дисперсии

несмещенная оценка дисперсии

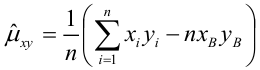

выборочная ковариация,

выборочная ковариация,

выборочная дисперсия

выборочная дисперсия

— выборочный коэффициент корреляции

— выборочный коэффициент корреляции

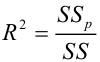

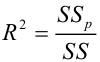

Коэффициент детерминации

— наблюдаемое экспериментальное значение

— наблюдаемое экспериментальное значение  при

при

— предсказанное значение

— предсказанное значение  удовлетворяющее уравнению регрессии

удовлетворяющее уравнению регрессии

— средневыборочное значение

— средневыборочное значение

— коэффициент детерминации, доля изменчивости

— коэффициент детерминации, доля изменчивости  объясняемая рассматриваемой регрессионной моделью. Для парной линейной регрессии

объясняемая рассматриваемой регрессионной моделью. Для парной линейной регрессии

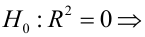

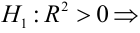

Коэффициент детерминации принимает значения от 0 до 1. Чем ближе значение коэффициента к 1, тем сильнее зависимость. При оценке регрессионных моделей это используется для доказательства адекватности модели (качества регрессии). Для приемлемых моделей предполагается, что коэффициент детерминации должен быть хотя бы не меньше 0,5 (в этом случае коэффициент множественной корреляции превышает по модулю 0,7). Модели с коэффициентом детерминации выше 0,8 можно признать достаточно хорошими (коэффициент корреляции превышает 0,9). Подтверждение адекватности модели проводится на основе дисперсионного анализа путем проверки гипотезы о значимости коэффициента детерминации.

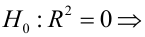

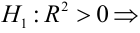

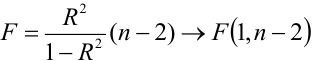

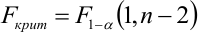

регрессия незначима

регрессия незначима

регрессия значима

регрессия значима

— уровень значимости

— уровень значимости

— статистический критерий

— статистический критерий

Критическая область — правосторонняя;

Если  то нулевая гипотеза отвергается на заданном уровне значимости, следовательно, коэффициент детерминации значим, следовательно, регрессия адекватна.

то нулевая гипотеза отвергается на заданном уровне значимости, следовательно, коэффициент детерминации значим, следовательно, регрессия адекватна.

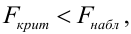

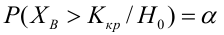

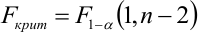

Мощность статистического критерия. Функция мощности

Определение. Мощностью критерия  называют вероятность попадания критерия в критическую область при условии, что справедлива конкурирующая гипотеза.

называют вероятность попадания критерия в критическую область при условии, что справедлива конкурирующая гипотеза.

Задача: построить критическую область таким образом, чтобы мощность критерия была максимальной.

Определение. Наилучшей критической областью (НКО) называют критическую область, которая обеспечивает минимальную ошибку второго рода

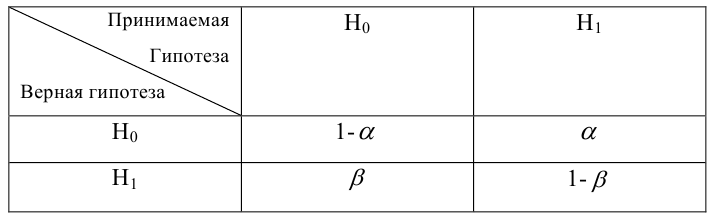

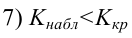

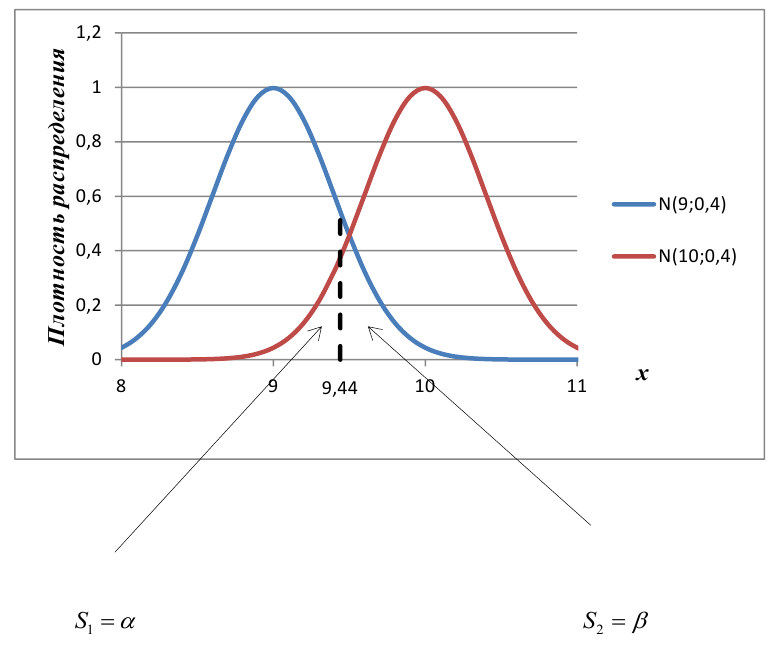

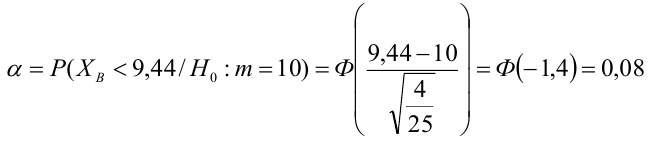

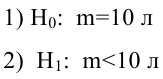

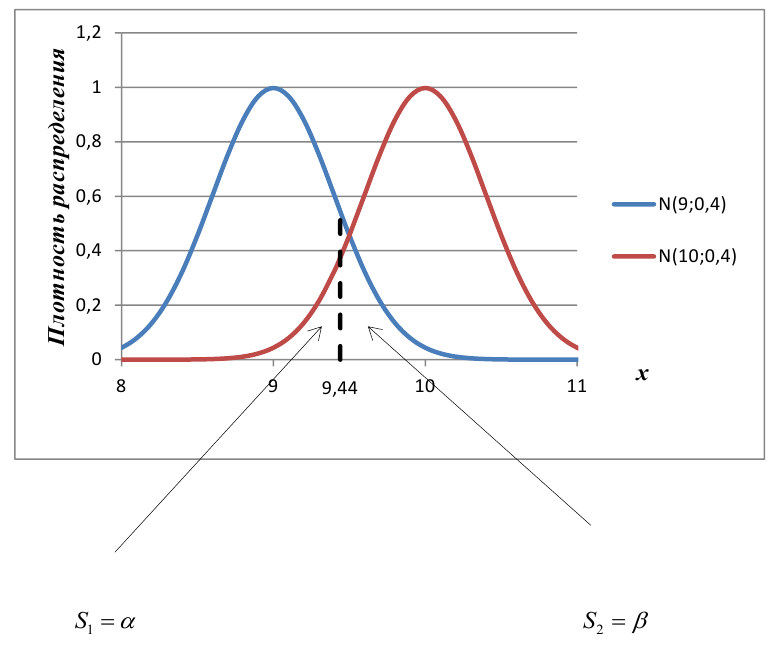

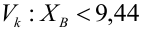

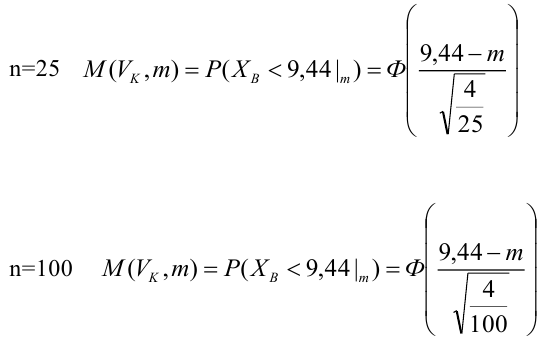

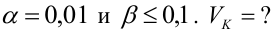

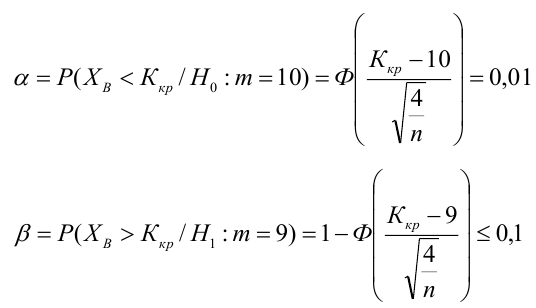

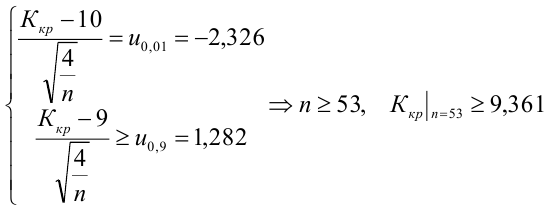

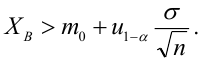

Пример:

По паспортным данным автомобиля расход топлива на 100 километров составляет 10 литров. В результате измерения конструкции двигателя ожидается, что расход топлива уменьшится. Для проверки были проведены испытания 25 автомобилей с модернизированным двигателем; выборочная средняя расхода топлива по результатам испытаний составила 9,3 литра. Предполагая, что выборка получена из нормально распределенной генеральной совокупности с математическим ожиданием  и дисперсией

и дисперсией  проверить гипотезу, утверждающую, что изменение конструкции двигателя не повлияло на расход топлива.

проверить гипотезу, утверждающую, что изменение конструкции двигателя не повлияло на расход топлива.

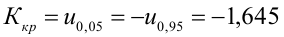

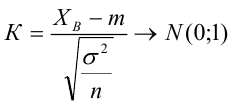

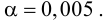

3) Уровень значимости

4) Статистический критерий

5) Критическая область — левосторонняя

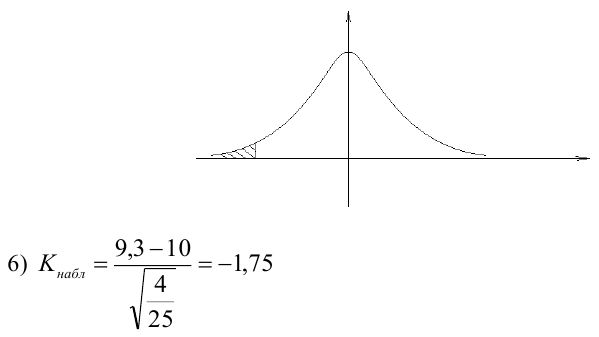

следовательно

следовательно  отвергается на уровне значимости

отвергается на уровне значимости

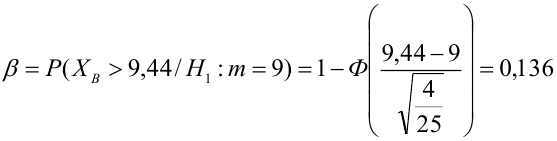

Пример:

В условиях примера 1 предположим, что наряду с  рассматривается конкурирующая гипотеза

рассматривается конкурирующая гипотеза  а критическая область задана неравенством

а критическая область задана неравенством  Найти вероятность ошибок I рода и II рода.

Найти вероятность ошибок I рода и II рода.

автомобилей имеют меньший расход топлива)

автомобилей имеют меньший расход топлива)

автомобилей, имеющих расход топлива 9л на 100 км, классифицируются как автомобили, имеющие расход 10 литров).

автомобилей, имеющих расход топлива 9л на 100 км, классифицируются как автомобили, имеющие расход 10 литров).

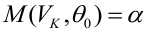

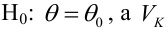

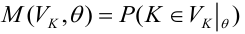

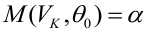

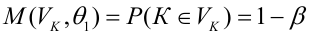

Определение. Пусть проверяется  — критическая область критерия с заданным уровнем значимости

— критическая область критерия с заданным уровнем значимости  Функцией мощности критерия

Функцией мощности критерия  называется вероятность отклонения

называется вероятность отклонения  как функция параметра

как функция параметра  т.е.

т.е.

— ошибка 1-ого рода

— ошибка 1-ого рода

— мощность критерия

— мощность критерия

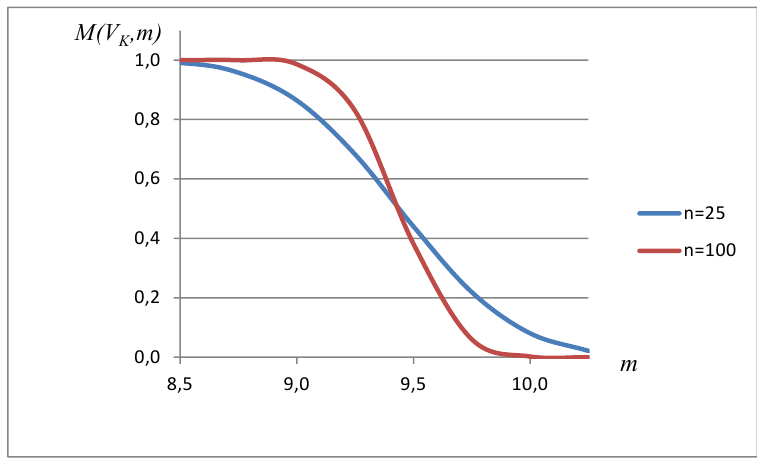

Пример:

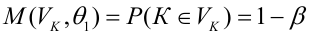

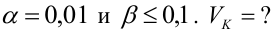

Построить график функции мощности из примера 2 для

попадает в критическую область.

попадает в критическую область.

Пример:

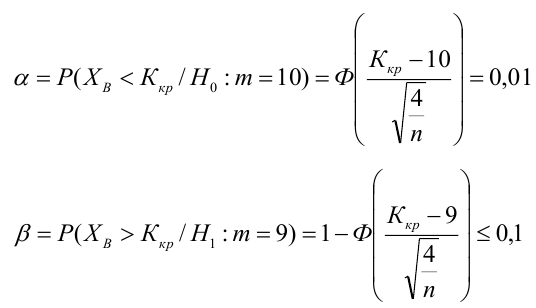

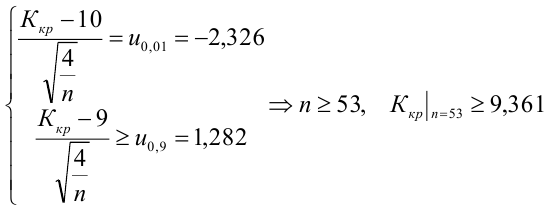

Какой минимальный объем выборки следует взять в условии примера 2 для того, чтобы обеспечить

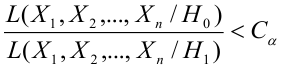

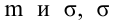

Лемма Неймана-Пирсона.

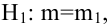

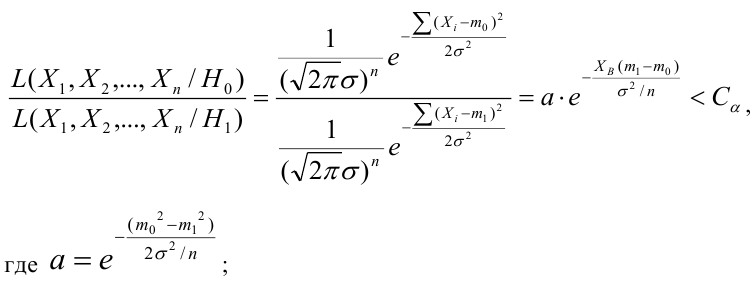

При проверке простой гипотезы  против простой альтернативной гипотезы

против простой альтернативной гипотезы  наилучшая критическая область (НКО) критерия заданного уровня значимости

наилучшая критическая область (НКО) критерия заданного уровня значимости  состоит из точек выборочного пространства (выборок объема

состоит из точек выборочного пространства (выборок объема  для которых справедливо неравенство:

для которых справедливо неравенство:

— константа, зависящая от

— константа, зависящая от

— элементы выборки;

— элементы выборки;

— функция правдоподобия при условии, что соответствующая гипотеза верна.

— функция правдоподобия при условии, что соответствующая гипотеза верна.

Пример:

Случайная величина  имеет нормальное распределение с параметрами

имеет нормальное распределение с параметрами  известно. Найти НКО для проверки

известно. Найти НКО для проверки  против

против  причем

причем

Решение:

Ошибка первого рода:

НКО:

Пример:

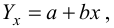

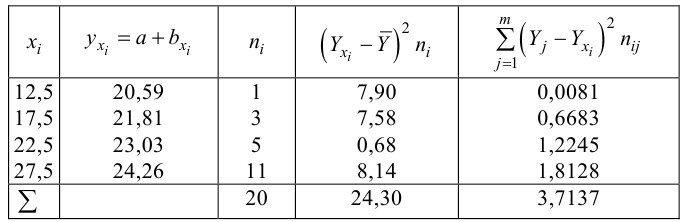

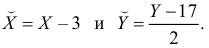

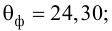

Для зависимости заданной корреляционной табл. 13, найти оценки параметров

заданной корреляционной табл. 13, найти оценки параметров  уравнения линейной регрессии

уравнения линейной регрессии  остаточную дисперсию; выяснить значимость уравнения регрессии при

остаточную дисперсию; выяснить значимость уравнения регрессии при

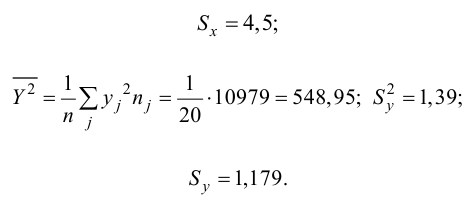

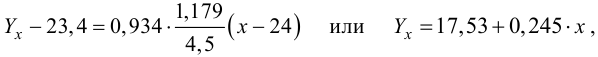

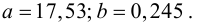

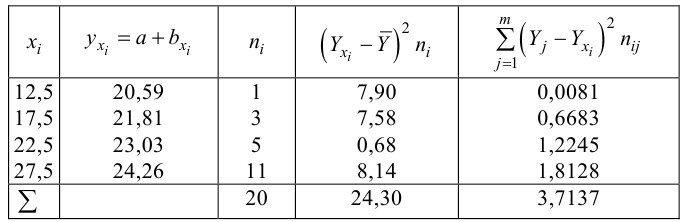

Решение. Воспользуемся предыдущими результатами

Согласно формуле (24), уравнение регрессии будет иметь вид  тогда

тогда

Для выяснения значимости уравнения регрессии вычислим суммы  Составим расчетную таблицу:

Составим расчетную таблицу:

Из (27) и (28) по данным таблицы получим

по табл. П7 находим

по табл. П7 находим

Вычислим статистику

Так как  то уравнение регрессии значимо. Остаточная дисперсия равна

то уравнение регрессии значимо. Остаточная дисперсия равна

- Корреляционный анализ

- Статистические решающие функции

- Случайные процессы

- Выборочный метод

- Проверка гипотезы о равенстве вероятностей

- Доверительный интервал для математического ожидания

- Доверительный интервал для дисперсии

- Проверка статистических гипотез

Основы линейной регрессии

Что такое регрессия?

Линия регрессии

Метод наименьших квадратов

Предположения линейной регрессии

Аномальные значения (выбросы) и точки влияния

Гипотеза линейной регрессии

Оценка качества линейной регрессии: коэффициент детерминации R2

Применение линии регрессии для прогноза

Простые регрессионные планы

Пример: простой регрессионный анализ

Рассмотрим две непрерывные переменные x=(x1, x2, .., xn), y=(y1, y2, …, yn).

Разместим точки на двумерном графике рассеяния и скажем, что мы имеем линейное соотношение, если данные аппроксимируются прямой линией.

Если мы полагаем, что y зависит от x, причём изменения в y вызываются именно изменениями в x, мы можем определить линию регрессии (регрессия y на x), которая лучше всего описывает прямолинейное соотношение между этими двумя переменными.

Статистическое использование слова «регрессия» исходит из явления, известного как регрессия к среднему, приписываемого сэру Френсису Гальтону (1889).

Он показал, что, хотя высокие отцы имеют тенденцию иметь высоких сыновей, средний рост сыновей меньше, чем у их высоких отцов. Средний рост сыновей «регрессировал» и «двигался вспять» к среднему росту всех отцов в популяции. Таким образом, в среднем высокие отцы имеют более низких (но всё-таки высоких) сыновей, а низкие отцы имеют сыновей более высоких (но всё-таки довольно низких).

Линия регрессии

Математическое уравнение, которое оценивает линию простой (парной) линейной регрессии:

Y=a+bx.

x называется независимой переменной или предиктором.

Y – зависимая переменная или переменная отклика. Это значение, которое мы ожидаем для y (в среднем), если мы знаем величину x, т.е. это «предсказанное значение y»

- a – свободный член (пересечение) линии оценки; это значение Y, когда x=0 (Рис.1).

- b – угловой коэффициент или градиент оценённой линии; она представляет собой величину, на которую Y увеличивается в среднем, если мы увеличиваем x на одну единицу.

- a и b называют коэффициентами регрессии оценённой линии, хотя этот термин часто используют только для b.

Парную линейную регрессию можно расширить, включив в нее более одной независимой переменной; в этом случае она известна как множественная регрессия.

Рис.1. Линия линейной регрессии, показывающая пересечение a и угловой коэффициент b (величину возрастания Y при увеличении x на одну единицу)

Метод наименьших квадратов

Мы выполняем регрессионный анализ, используя выборку наблюдений, где a и b – выборочные оценки истинных (генеральных) параметров, α и β , которые определяют линию линейной регрессии в популяции (генеральной совокупности).

Наиболее простым методом определения коэффициентов a и b является метод наименьших квадратов (МНК).

Подгонка оценивается, рассматривая остатки (вертикальное расстояние каждой точки от линии, например, остаток = наблюдаемому y – предсказанный y, Рис. 2).

Линию лучшей подгонки выбирают так, чтобы сумма квадратов остатков была минимальной.

Рис. 2. Линия линейной регрессии с изображенными остатками (вертикальные пунктирные линии) для каждой точки.

Предположения линейной регрессии

Предположения линейной регрессии

Итак, для каждой наблюдаемой величины остаток равен разнице

и соответствующего предсказанного

Каждый остаток может быть положительным или отрицательным.

Можно использовать остатки для проверки следующих предположений, лежащих в основе линейной регрессии:

- Остатки нормально распределены с нулевым средним значением;

Если допущения линейности, нормальности и/или постоянной дисперсии сомнительны, мы можем преобразовать или

и рассчитать новую линию регрессии, для которой эти допущения удовлетворяются (например, использовать логарифмическое преобразование или др.).

Аномальные значения (выбросы) и точки влияния

«Влиятельное» наблюдение, если оно опущено, изменяет одну или больше оценок параметров модели (т.е. угловой коэффициент или свободный член).

Выброс (наблюдение, которое противоречит большинству значений в наборе данных) может быть «влиятельным» наблюдением и может хорошо обнаруживаться визуально, при осмотре двумерной диаграммы рассеяния или графика остатков.

И для выбросов, и для «влиятельных» наблюдений (точек) используют модели, как с их включением, так и без них, обращают внимание на изменение оценки (коэффициентов регрессии).

При проведении анализа не стоит отбрасывать выбросы или точки влияния автоматически, поскольку простое игнорирование может повлиять на полученные результаты. Всегда изучайте причины появления этих выбросов и анализируйте их.

Гипотеза линейной регрессии

Гипотеза линейной регрессии

При построении линейной регрессии проверяется нулевая гипотеза о том, что генеральный угловой коэффициент линии регрессии β равен нулю.

Если угловой коэффициент линии равен нулю, между и

нет линейного соотношения: изменение

не влияет на

Для тестирования нулевой гипотезы о том, что истинный угловой коэффициент равен нулю можно воспользоваться следующим алгоритмом:

Вычислить статистику критерия, равную отношению , которая подчиняется

распределению с

степенями свободы, где

стандартная ошибка коэффициента

,

— оценка дисперсии остатков.

Обычно если достигнутый уровень значимости нулевая гипотеза отклоняется.

Можно рассчитать 95% доверительный интервал для генерального углового коэффициента :

где процентная точка

распределения со степенями свободы

что дает вероятность двустороннего критерия

Это тот интервал, который содержит генеральный угловой коэффициент с вероятностью 95%.

Для больших выборок, скажем, мы можем аппроксимировать

значением 1,96 (то есть статистика критерия будет стремиться к нормальному распределению)

Оценка качества линейной регрессии: коэффициент детерминации R2

Из-за линейного соотношения и

мы ожидаем, что

изменяется, по мере того как изменяется

, и называем это вариацией, которая обусловлена или объясняется регрессией. Остаточная вариация должна быть как можно меньше.

Если это так, то большая часть вариации будет объясняться регрессией, а точки будут лежать близко к линии регрессии, т.е. линия хорошо соответствует данным.

Долю общей дисперсии , которая объясняется регрессией называют коэффициентом детерминации, обычно выражают через процентное соотношение и обозначают R2 (в парной линейной регрессии это величина r2, квадрат коэффициента корреляции), позволяет субъективно оценить качество уравнения регрессии.

Разность представляет собой процент дисперсии который нельзя объяснить регрессией.

Нет формального теста для оценки мы вынуждены положиться на субъективное суждение, чтобы определить качество подгонки линии регрессии.

Применение линии регрессии для прогноза

Можно применять регрессионную линию для прогнозирования значения по значению

в пределе наблюдаемого диапазона (никогда не экстраполируйте вне этих пределов).

Мы предсказываем среднюю величину для наблюдаемых, которые имеют определенное значение

путем подстановки этого значения

в уравнение линии регрессии.

Итак, если прогнозируем

как

Используем эту предсказанную величину и ее стандартную ошибку, чтобы оценить доверительный интервал для истинной средней величины

в популяции.

Повторение этой процедуры для различных величин позволяет построить доверительные границы для этой линии. Это полоса или область, которая содержит истинную линию, например, с 95% доверительной вероятностью.

Подобным образом можно рассчитать более широкую область, внутри которой, как мы ожидаем, лежит наибольшее число (обычно 95%) наблюдений.

Простые регрессионные планы

Простые регрессионные планы содержат один непрерывный предиктор. Если существует 3 наблюдения со значениями предиктора P, например, 7, 4 и 9, а план включает эффект первого порядка P, то матрица плана X будет иметь вид

а регрессионное уравнение с использованием P для X1 выглядит как

Y = b0 + b1P

Если простой регрессионный план содержит эффект высшего порядка для P, например квадратичный эффект, то значения в столбце X1 в матрице плана будут возведены во вторую степень:

а уравнение примет вид

Y = b0 + b1P2

Сигма-ограниченные и сверхпараметризованные методы кодирования не применяются по отношению к простым регрессионным планам и другим планам, содержащим только непрерывные предикторы (поскольку, просто не существует категориальных предикторов). Независимо от выбранного метода кодирования, значения непрерывных переменных увеличиваются в соответствующей степени и используются как значения для переменных X. При этом перекодировка не выполняется. Кроме того, при описании регрессионных планов можно опустить рассмотрение матрицы плана X, а работать только с регрессионным уравнением.

Пример: простой регрессионный анализ

Этот пример использует данные, представленные в таблице:

Рис. 3. Таблица исходных данных.

Данные составлены на основе сравнения переписей 1960 и 1970 в произвольно выбранных 30 округах. Названия округов представлены в виде имен наблюдений. Информация относительно каждой переменной представлена ниже:

Рис. 4. Таблица спецификаций переменных.

Задача исследования

Для этого примера будут анализироваться корреляция уровня бедности и степень, которая предсказывает процент семей, которые находятся за чертой бедности. Следовательно мы будем трактовать переменную 3 (Pt_Poor) как зависимую переменную.

Можно выдвинуть гипотезу: изменение численности населения и процент семей, которые находятся за чертой бедности, связаны между собой. Кажется разумным ожидать, что бедность ведет к оттоку населения, следовательно, здесь будет отрицательная корреляция между процентом людей за чертой бедности и изменением численности населения. Следовательно мы будем трактовать переменную 1 (Pop_Chng) как переменную-предиктор.

Просмотр результатов

Коэффициенты регрессии

Рис. 5. Коэффициенты регрессии Pt_Poor на Pop_Chng.

На пересечении строки Pop_Chng и столбца Парам. не стандартизованный коэффициент для регрессии Pt_Poor на Pop_Chng равен -0.40374. Это означает, что для каждого уменьшения численности населения на единицу, имеется увеличение уровня бедности на .40374. Верхний и нижний (по умолчанию) 95% доверительные пределы для этого не стандартизованного коэффициента не включают ноль, так что коэффициент регрессии значим на уровне p<.05. Обратите внимание на не стандартизованный коэффициент, который также является коэффициентом корреляции Пирсона для простых регрессионных планов, равен -.65, который означает, что для каждого уменьшения стандартного отклонения численности населения происходит увеличение стандартного отклонения уровня бедности на .65.

Распределение переменных

Коэффициенты корреляции могут стать существенно завышены или занижены, если в данных присутствуют большие выбросы. Изучим распределение зависимой переменной Pt_Poor по округам. Для этого построим гистограмму переменной Pt_Poor.

Рис. 6. Гистограмма переменной Pt_Poor.

Как вы можете заметить, распределение этой переменной заметно отличается от нормального распределения. Тем не менее, хотя даже два округа (два правых столбца) имеют высокий процент семей, которые находятся за чертой бедности, чем ожидалось в случае нормального распределения, кажется, что они находятся «внутри диапазона.»

Рис. 7. Гистограмма переменной Pt_Poor.

Это суждение в некоторой степени субъективно. Эмпирическое правило гласит, что выбросы необходимо учитывать, если наблюдение (или наблюдения) не попадают в интервал (среднее ± 3 умноженное на стандартное отклонение). В этом случае стоит повторить анализ с выбросами и без, чтобы убедиться, что они не оказывают серьезного эффекта на корреляцию между членами совокупности.

Диаграмма рассеяния

Если одна из гипотез априори о взаимосвязи между заданными переменными, то ее полезно проверить на графике соответствующей диаграммы рассеяния.

Рис. 8. Диаграмма рассеяния.

Диаграмма рассеяния показывает явную отрицательную корреляцию (-.65) между двумя переменными. На ней также показан 95% доверительный интервал для линии регрессии, т.е., с 95% вероятностью линия регрессии проходит между двумя пунктирными кривыми.

Критерии значимости

Рис. 9. Таблица, содержащая критерии значимости.

Критерий для коэффициента регрессии Pop_Chng подтверждает, что Pop_Chng сильно связано с Pt_Poor, p<.001.

Итог

На этом примере было показано, как проанализировать простой регрессионный план. Была также представлена интерпретация не стандартизованных и стандартизованных коэффициентов регрессии. Обсуждена важность изучения распределения откликов зависимой переменной, продемонстрирована техника определения направления и силы взаимосвязи между предиктором и зависимой переменной.

Связанные определения:

Линейная регрессия

Матрица плана

Общая линейная модель

Регрессия

В начало

Содержание портала

Все курсы > Оптимизация > Занятие 5

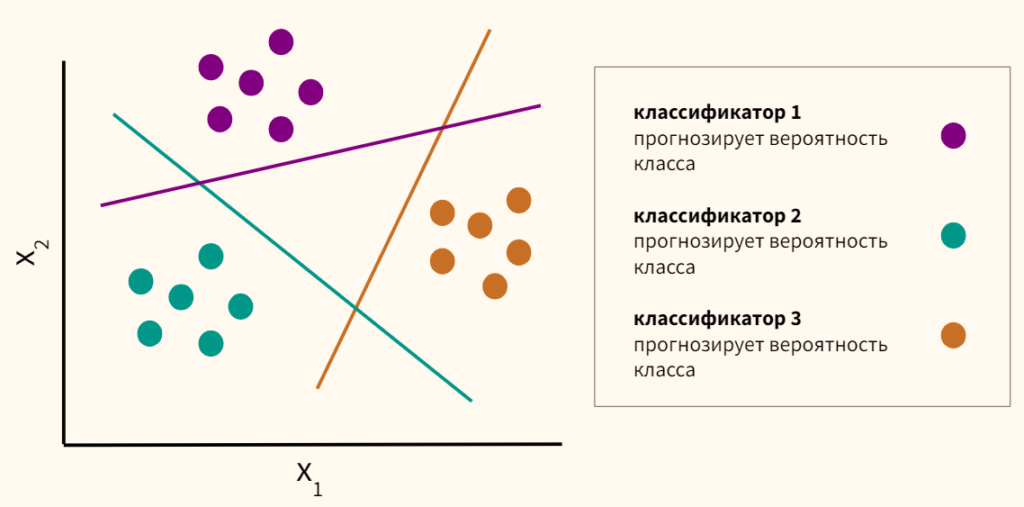

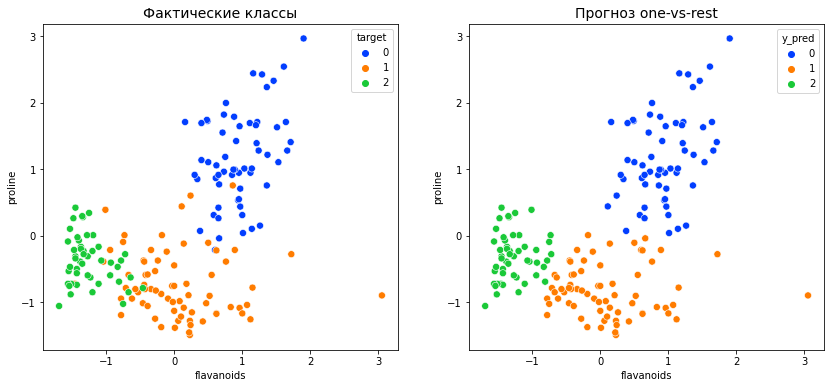

Как мы уже знаем, несмотря на название, логистическая регрессия решает задачу классификации. Сегодня мы подробно разберем принцип работы и составные части алгоритма логистической регрессии, а также построим модели с одной и несколькими независимыми переменными.

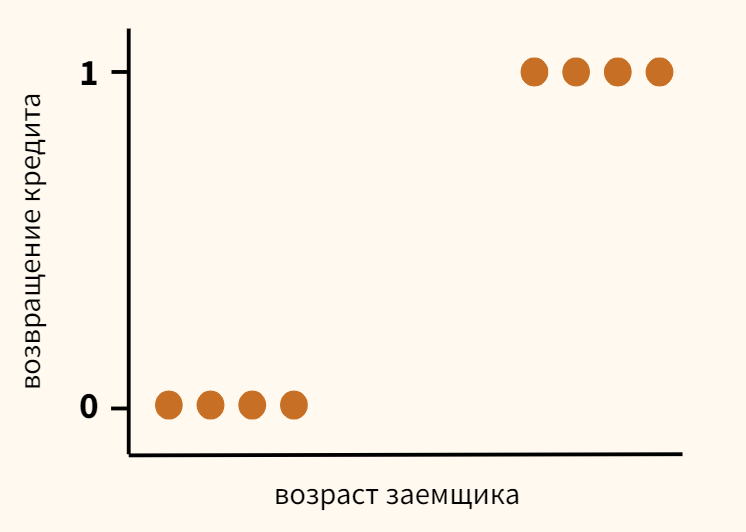

Бинарная логистическая регрессия

Задача бинарной классификации

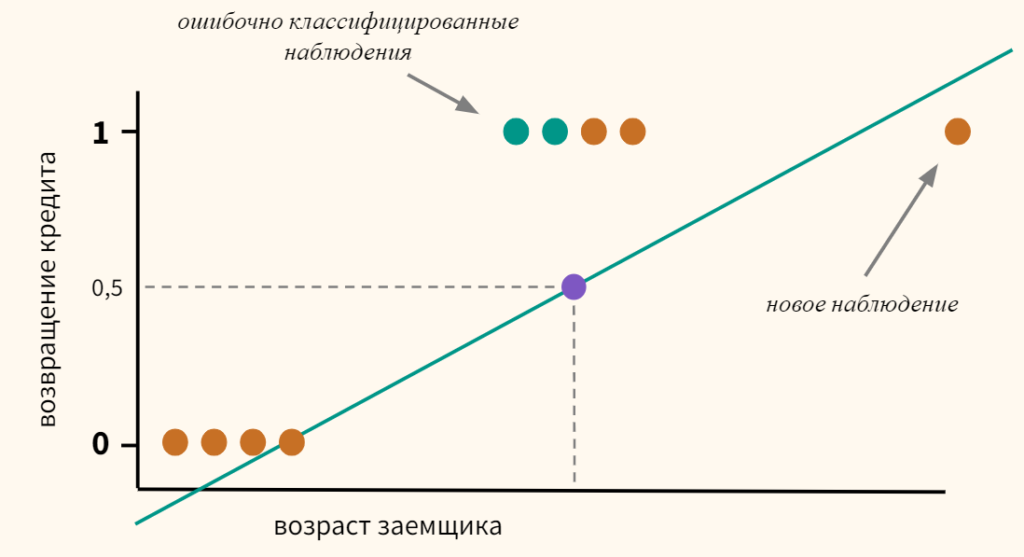

Вернемся к задаче кредитного скоринга, про которую мы говорили, когда обсуждали принцип машинного обучения. Предположим, что мы собрали данные и выявили зависимость возвращения кредита (ось y) от возраста заемщика (ось x).

Как мы видим, в среднем более молодые заемщики реже возвращают кредит. Возникает вопрос, с помощью какой модели можно описать эту зависимость? Казалось бы, можно построить линейную регрессию таким образом, чтобы она выдавала некоторое значение и, если это значение окажется ниже 0,5 — отнести наблюдение к классу 0, если выше — к классу 1.

- Если $ f_w(x) < 0,5 rightarrow hat{y} = 0 $

- Если $ f_w(x) geq 0,5 rightarrow hat{y} = 1 $

Однако, даже если предположить, что мы удачно провели линию регрессии (а на графике выше мы действительно провели ее вполне удачно), и наша модель может делать качественный прогноз, появление новых данных сместит эту границу, и, как следствие, ничего не добавит, а только ухудшит точность модели.

Теперь часть наблюдений, принадлежащих к классу 1, будет ошибочно отнесено моделью к классу 0.

Кроме этого, линейная регрессия по оси y выдает значения, сильно выходящие за пределы интересующего нас интервала от нуля до единицы.

Откроем ноутбук к этому занятию⧉

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

# помимо стандартных библиотек мы также импортируем библиотеку warnings # она позволит скрыть предупреждения об ошибках import numpy as np import pandas as pd import matplotlib.pyplot as plt import seaborn as sns import warnings # кроме того, импортируем датасеты библиотеки sklearn from sklearn import datasets # а также функции для расчета метрики accuracy и построения матрицы ошибок from sklearn.metrics import accuracy_score, confusion_matrix # построенные нами модели мы будем сравнивать с результатом # класса LogisticRegression библиотеки sklearn from sklearn.linear_model import LogisticRegression # среди прочего, мы построим модели полиномиальной логистической регрессии from sklearn.preprocessing import PolynomialFeatures |

Функция логистической регрессии

Сигмоида

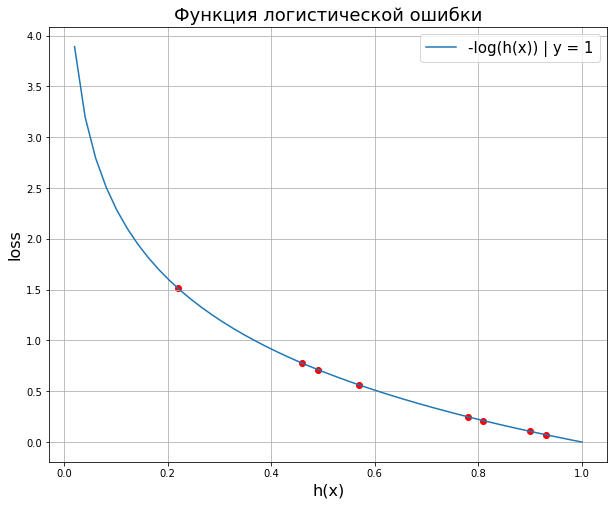

Возможно решение упомянутых выше сложностей — пропустить значение линейной регрессии через сигмоиду (sigmoid function), которая при любом значении X не выйдет из необходимого нам диапазона $0 leq h(x) leq 1 $. Напомню формулу и график сигмоиды.

$$ g(z) = frac{1}{1+e^{-z}} $$

Примечание: обратие внимание, когда z представляет собой большое отрицательное число, знаменатель становится очень большим $ 1 + e^{-(-5)} approx 148, 413 $ и значение сигмоиды стремится к нулю; когда z является большим положительным числом, знаменатель, а вместе с ним и все выражение стремятся к единице $ 1 + e^{-(5)} approx 0,0067 $.

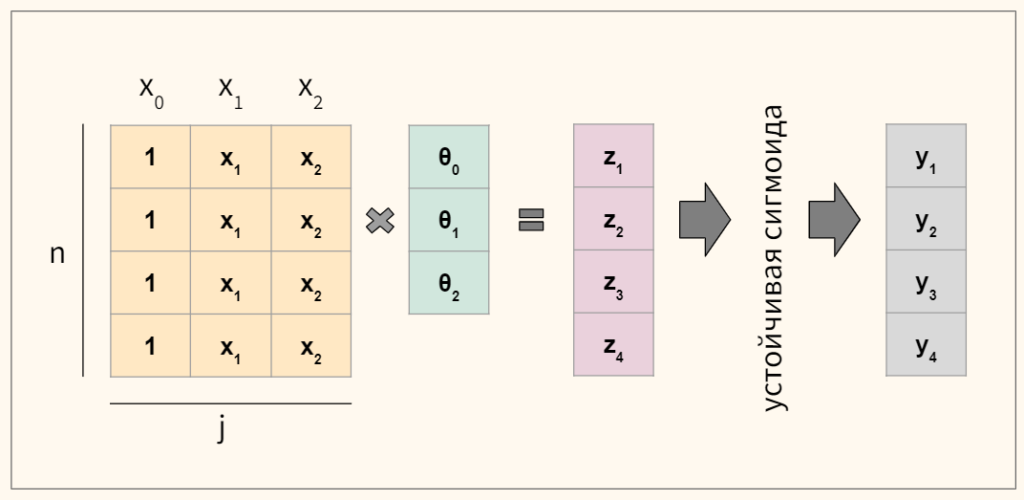

Тогда мы можем построить линейную модель, значение которой будет подаваться в сигмоиду.

$$ z = Xtheta rightarrow h_{theta}(x) = frac{1}{1+e^{-(Xtheta)}} $$

В этом смысле никакой ошибки в названии «логистическая регрессия». Этот алгоритм решает задачу классификации через модель линейной регрессии.

Если вы не помните, почему мы записали множественную линейную функцию как $theta x$, посмотрите предыдущую лекцию.

Приведем код на Питоне.

|

def h(x, thetas): z = np.dot(x, thetas) return 1.0 / (1 + np.exp(—z)) |

Теперь посмотрим, как интерпретировать коэффициенты.

Интерпретация коэффициентов

Для любого значения x через $ h_{theta}(x) $ мы будем получать вероятность от 0 до 1, что объект принадлежит к классу y = 1. Например, если класс 1 означает, что заемщик вернул кредит, то $ h_{theta}(x) = 0,8 $ говорит о том, что согласно нашей модели (с параметрами $theta$), для данного заемщика (x) вероятность возвращения кредита состаляет 80 процентов.

В общем случае мы можем записать вероятность вот так.

$$ h_{theta}(x) = P(y = 1 | x; theta) $$

Это выражение можно прочитать как вероятность принадлежности к классу 1 при условии x с параметрами $theta$ (probability of y = 1 given x, parameterized by $theta$).

Поскольку, как мы помним, сумма вероятностей событий, образующих полную группу, всегда равна единице, вероятность принадлежности к классу 0 будет равна

$$ P(y = 0 | x; theta) = 1-P(y = 1 | x; theta) $$

Решающая граница

Решающая граница (decision boundary) — это порог, который определяет к какому классу отнести то или иное наблюдение. Если выбрать порог на уровне 0,5, то все что выше или равно этому порогу мы отнесем к классу 1, все что ниже — к классу 0.

$$ y = 1, h_{theta}(x) geq 0,5 $$

$$ y = 0, h_{theta}(x) < 0,5 $$

Теперь обратите внимание на сигмоиду. Сигмоида $ g(z) $ принимает значения больше 0,5, если $ z geq 0 $, а так как $ z = Xtheta $, то можно сказать, что

- $h_{theta}(x) geq 0,5$ и $ y = 1$, когда $ Xtheta geq 0 $, и соответственно

- $h_{theta}(x) < 0,5 $ и $ y = 0$, когда $ Xtheta < 0 $.

Уравнение решающей границы

Предположим, что у нас есть два признака $x_1$ и $x_2$. Вместе они образуют так называемое пространство ввода (input space), то есть все имеющиеся у нас наблюдения. Мы можем представить его на координатной плоскости, дополнительно выделив цветом наблюдения, относящиеся к разным классам.

Кроме того, представим, что мы уже построили модель логистической регрессии, и она провела для нас соответствующую границу между двумя классами.

Возникает вопрос. Как, зная коэффициенты $theta_0$, $theta_1$ и $theta_2$ модели, найти уравнение линии решающей границы? Для начала договоримся, что уравнение решающией границы будет иметь вид $x_2 = mx_1 + c$, где m — наклон прямой, а c — сдвиг.

Теперь вспомним, что модель с двумя признаками (до подачи в сигмоиду) имеет вид

$$ z = theta_0 + theta_1 x_1 + theta_2 x_2 $$

Также не забудем, что граница проходит там, где $ h_{theta}(x) = 0,5 $, а значит z = 0. Значит,

$$ 0 = theta_0 + theta_1 x_1 + theta_2 x_2 $$

Чтобы найти с (то есть сдвиг линии решающей границы вдоль оси $x_2$) приравняем $x_1$ к нулю и решим для $x_2$ (именно эта точка и будет сдвигом c).

$$ 0 = theta_0 + 0 + theta_2 x_2 rightarrow x_2 = -frac{theta_0}{theta_2} rightarrow c = -frac{theta_0}{theta_2} $$

Теперь займемся наклоном m. Возьмем некоторую точку на линии решающей границы с координатами $(x_1^a, x_2^a)$, $(x_1^b, x_2^b)$. Тогда наклон m будет равен

$$ m = frac{x_2^b-x_2^a}{x_1^b-x_1^a} $$

Так как эти точки расположены на решающей границе, то справедливо, что

$$ 0 = theta_1x_1^b + theta_2x_2^b + theta_0-(theta_1x_1^a + theta_2x_2^a + theta_0) $$

$$ -theta_2(x_2^b-x_2^a) = theta_1(x_1^b-x_1^a) $$

А значит,

$$ frac{x_2^b-x_2^a}{x_1^b-x_1^a} = -frac{theta_1}{theta_2} rightarrow m = -frac{theta_1}{theta_2} $$

Вычислительная устойчивость сигмоиды