-

Обнаружение и исправление ошибок

-

Общие понятия

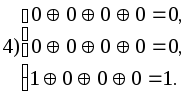

-

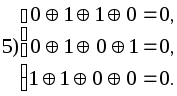

Для

защиты полезной информации от помех

необходимо в том или ином виде вводить

избыточность: увеличивать число символов

и время их передачи, повторять целые

сообщения, повышать мощность сигнала

— все это ведет к усложнению и удорожанию

аппаратуры. В качестве исследуемой

модели достаточно рассмотреть канал

связи с помехами, потому что к этому

случаю легко сводятся остальные.

Например, запись на диск можно рассматривать

как передачу данных в канал, а чтение с

диска – как прием данных из канала.

Коды

без избыточности обнаружить, а тем более

исправлять

ошибки не могут.

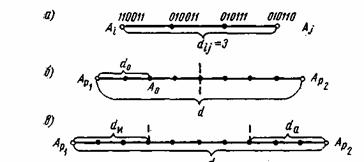

Количество символов, в которых любые

две комбинации кода отличаются друг от

друга, называется кодовым

расстоянием.

Минимальное

количество символов, в которых все

комбинации кода отличаются друг от

друга, называется минимальным

кодовым расстоянием.

Минимальное кодовое расстояние —

параметр, определяющий помехоустойчивость

кода и заложенную в коде избыточность,

т.е. корректирующие свойства кода.

В

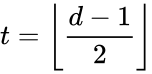

общем случае для обнаружения t

ошибок минимальное кодовое расстояние

d0

= t

+ 1.

Минимальное

кодовое расстояние, необходимое для

одновременного обнаружения t

и исправления

ошибок,

d0

= t

+

+ 1.,

Для

кодов, только исправляющих

ошибок,

d0

= 2

+ 1.

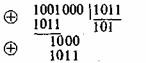

Для

того чтобы определить кодовое расстояние

между двумя комбинациями двоичного

кода, достаточно просуммировать эти

комбинации по модулю 2 и подсчитать

число единиц полученной комбинации.

Для

обнаружения и исправления одиночной

ошибки соотношение между числом

информационных разрядив k

и числом корректирующих разрядов

должно удовлетворять следующим условиям:

![]() ,

,

![]() ,

,

при

этом подразумевается, что общая длина

кодовой комбинации

n

= k + ρ

Для

практических расчетов при определении

числа контрольных разрядов кодов с

минимальным кодовым расстоянием d0

= 3 удобно

пользоваться выражениями

ρ1(2)

= [ log2

( n + 1

) ],

если

известна длина полной кодовой комбинации

n,

и

ρ

1(2) =

[log2 {

( k

+ 1 ) + [ log2

(

k + 1) ] } ],

если

при расчетах удобнее исходить из

заданного числа информационных символов

k

.

Для

кодов, обнаруживающих все трехкратные

ошибки (d0

= 4),

ρ

1(3)

1

+ log2

(

n + 1

),

или

ρ

1(3)

1 + log2

[ (

k + 1

) + log2

(

k + 1

) ].

Для

кодов длиной в n

символов, исправляющих одну или две

ошибки (d0

= 5),

ρ

2

log2

(Cn2

+ Cn1

+ 1).

Для практических

расчетов можно пользоваться выражением:

![]() .

.

Для

кодов, исправляющих 3 ошибки (d0

= 7),

![]() .

.

-

Линейные групповые коды

Линейными

называются коды, в которых проверочные

символы представляют собой линейные

комбинации информационных символов.

Для

двоичных кодов в качестве линейной

операции используется сложение по

модулю 2.

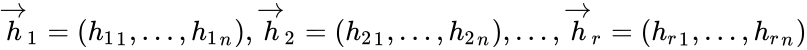

Последовательность

нулей и единиц, принадлежащих данному

коду, будем называть кодовым

вектором.

Свойство

линейных кодов:

сумма

(разность) кодовых векторов линейного

кода дает вектор, принадлежащий данному

коду.

Линейные

коды образуют алгебраическую группу

по отношению к операции сложения по

модулю 2. В этом смысле они являются

групповыми

кодами.

Свойство

группового кода:

минимальное кодовое

расстояние между кодовыми векторами

группового кода равно минимальному

весу ненулевых кодовых векторов.

Вес

кодового вектора

(кодовой комбинации) равен числу его

ненулевых компонент.

Расстояние

между двумя кодовыми векторами

равно весу вектора, полученного в

результате сложения исходных векторов

по модулю 2. Таким образом, для данного

группового кода

Wmin

=d0.

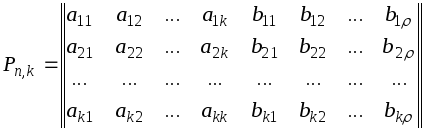

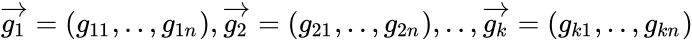

Групповые

коды удобно задавать матрицами,

размерность которых определяется

параметрами кода k

и .

Число строк матрицы равно k,

число столбцов равно

n

= k +

:

Коды,

порождаемые этими матрицами, известны

как (n,k)-коды,

соответствующие им матрицы называют

порождающими

(производящими, образующими).

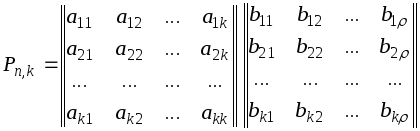

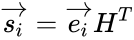

Порождающая

матрица P

может быть представлена двумя матрицами

Uk

и H

(информационной и проверочной). Число

столбцов матрицы H

равно ,

число столбцов матрицы Uk

равно k

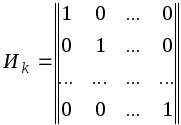

Теорией

и практикой установлено, что в качестве

матрицы Uk

удобно брать единичную матрицу в

канонической форме

![]()

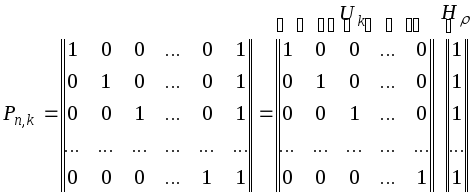

Для

кодов с d0

= 2

производящая матрица P

имеет вид

Во всех комбинациях

кода построенного при помощи такой

матрицы, четное число единиц.

Для

кодов с d0

3 порождающая

матрица не может быть представлена в

форме, общей для всех кодов с данным

d0.

Вид матрицы

зависит от конкретных требований к

порождающему коду. Этими требованиями

могут быть либо минимум корректирующих

разрядов, либо максимальная простота

аппаратуры.

Корректирующие

коды с минимальным количеством избыточных

разрядов называют плотно

упакованными

или

совершенными

кодами.

Для

кодов d0

= 3

соотношения n

и k

следующие: (3; 1), (7; 4),

(15; 11), (31; 26), (63; 57)

и так далее.

Строчки

образующей матрицы P

представляют собой k

комбинаций искомого кода. Остальные

комбинации кода строятся при помощи

образующей матрицы по следующему

правилу: корректирующие символы,

предназначенные для обнаружения и

исправления ошибки в информационной

части кода, находятся путем суммирования

по модулю 2 тех строк матрицы H,

номера которых совпадают с номерами

разрядов, содержащих единицы в кодовом

векторе, представляющем информационную

часть кода. Полученную комбинацию

приписывают справа к информационной

части кода и получают полный вектор

корректирующего кода. Аналогичную

процедуру проделывают со второй, третьей

и последующими информационными кодовыми

комбинациями, пока не будет построен

корректирующий код для передачи всех

символов первичного алфавита.

Алгоритм

образования проверочных символов по

известной информационной части кода

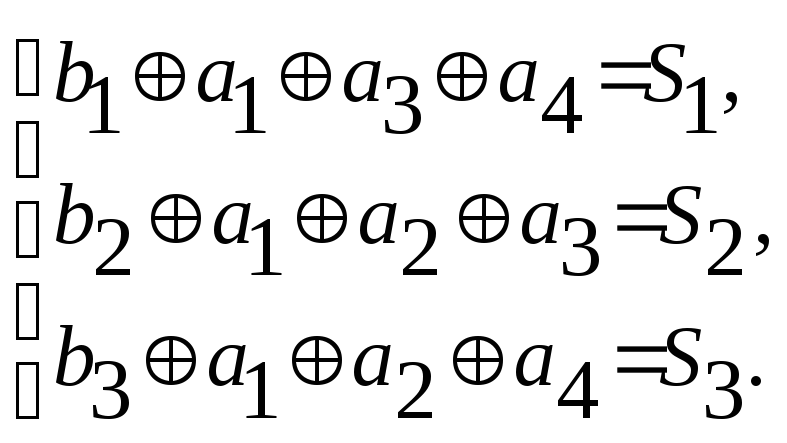

может быть записан следующим образом

или

![]() .

.

В процессе

декодирования осуществляются проверки,

идея которых в общем виде может быть

представлена следующим образом

![]()

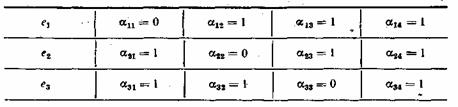

Для

каждой конкретной матрицы существует

своя, одна-единственная система проверок.

Проверки производятся по следующему

правилу : в первую проверку вместе с

проверочным рядом b1

входят информационные разряды, которые

соответствуют единицам первого столбца

проверочной матрицы H;

во вторую проверку входит второй

проверочный разряд b2

и информационные

разряды, и т. д. Число проверок равно

числу проверочных разрядов корректирующего

кода .

В

результате осуществления проверок

образуется проверочный

вектор

S1,

S2,

…, S,

который называется синдромом.

Если вес синдрома равен нулю, то принятая

комбинация считается безошибочной.

Если хотя бы один разряд проверочного

вектора содержит единицу, то принятая

комбинация содержит ошибку. Исправление

ошибки производится по виду синдрома,

так как каждому ошибочному разряду

соответствует один единственный

проверочный вектор.

Вид

синдрома для каждой конкретной матрицы

может быть определен при помощи

проверочной матрицы Н’,

которая представляет собой транспонированную

матрицу H,

дополненной единичной матрицей I,

число столбцов которой равно число

проверочных разрядов кода

Н’

= HТI.

Столбцы

такой матрицы представляют собой

значение синдрома для разряда,

соответствующего номеру столбца матрицы

Н’.

Процедура исправления

ошибок в процессе декодирования групповых

кодов сводится к следующему.

Строится

кодовая таблица. В первой строке таблицы

располагаются все кодовые векторы Ai.

В первом столбце второй строки размещается

вектор a1,

вес которого равен 1.

Остальные

позиции второй строки заполняются

векторами, полученными в результате

суммирования по модулю 2 вектора a1

с Аi,

расположенным в соответствующем столбце

первой строки. В первом столбце третьей

строки записывается вектор a2,

вес которого также равен 1, однако , если

вектор a1

содержит единицу в первом разряде, то

a2

— во втором. В остальные позиции третьей

строки записывают суммы Аi

и a2

.

Аналогично

поступают до тех пор, пока не будут

просуммированы с векторами Аi

все векторы

aj

весом 1, с единицей в каждом из n

разрядов. Затем суммируются по модулю

2 векторы aj,

весом 2, с последовательным перекрытием

всех возможных разрядов. Вес вектора

aj

определяет число исправляемых ошибок.

Число векторов aj

определяется возможным числом

неповторяющихся синдромов и равно 2-1

(нулевая комбинация говорит об отсутствии

ошибки). Условие неповторяемости синдрома

позволяет по его виду определять

один-единственный соответствующий ему

вектор aj.

Векторы aj

есть векторы

ошибок, которые могут быть исправлены

данным групповым кодом.

По

виду синдрома принятая комбинация может

быть отнесена к тому или иному смежному

классу, образованному сложением по

модулю 2 кодовой комбинации Аi

с вектором ошибки aj,

т. е. к определенной строке кодовой

таблицы 3.2.1.

Таблица 3.2.1-

Кодовая таблица групповых кодов

|

a |

A1 |

A2 |

… |

A(2k-1) |

|

a1 |

a1A1 |

a2A2 |

… |

a1A(2k-1) |

|

a2 |

a2A1 |

a2A2 |

… |

a2A(2k-1) |

|

… |

… |

… |

… |

… |

|

a(2-1) |

a(2 |

a(2-1)A2 |

… |

a(2-1)A(2k-1) |

Принятая

кодовая комбинация Axn

сравнивается

с векторами, записанными в строке,

соответствующей полученному в результате

проверок синдрому. Истинный код будет

расположен в строке той же колонки

таблицы. Процесс исправления ошибки

заключается в замене на обратное значение

разрядов.

Векторы

a1,

a2,

…,a(2-1)

не должны

быть равными ни одному из векторов А1,

А2,

…, А(2-1),

в противном случае в таблице появились

бы нулевые векторы.

Пример.

Построить

кодовую таблицу, при помощи которой

обнаруживаются и исправляются все

одиночные ошибки и некоторые ошибки

кратностью r

+ 1,

в информационной

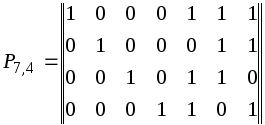

части кода (11,7), построенного по матрице

Решение.

Используя

таблицу 3.2.1, строим кодовую таблицу

3.2.2 для кодов, построенных по данной

матрице P,

кодовые комбинации строятся путем

добавления к четырехразрядным комбинациям

натурального двоичного кода корректирующих

разрядов по правилу, описанному выше.

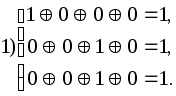

Определяем

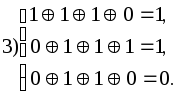

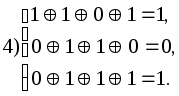

систему проверок исходя из матрицы H

Находим

вид синдрома для каждой строки таблицы.

Для этого достаточно произвести проверки

для кодовых комбинаций любого столбца

кодовой таблицы.

Для

нашего примера возьмем столбец A3

.

Таблица 3.2.1 – Пример таблицы

для столбца А3

|

№ |

e |

A1 1000111 |

A2 0100011 |

A3 1100100 |

A4 0010110 |

A5 1010001 |

A6 0110101 |

A7 1110010 |

|

1 2 3 4 5 6 7 |

1000000 0100000 0010000 0001000 1100000 1001000 1010000 |

0000111 1100111 1010111 1001111 0100111 0001111 0010111 |

1100011 0000011 0110011 0101011 1000011 1101011 1110011 |

0100100 1000100 1110100 1101100 0000100 0101100 0110100 |

1010110 0110110 0000110 0011110 1110110 1011110 1000110 |

0010001 1110001 1000001 1011001 0110001 0011001 0000001 |

1110101 0010101 0100101 0111101 1010101 1111101 1100101 |

0110010 1010010 1100010 1111010 0010010 0111010 0100010 |

|

№ |

A8 0001101 |

A9 1001010 |

A10 0101110 |

A11 1101001 |

A12 0011011 |

A13 1011100 |

A14 0111000 |

A15 1111111 |

|

1 2 3 4 5 6 7 |

1001101 0101101 0011101 0000101 1101101 1000101 1011101 |

0001010 1101010 1011010 1000010 0101010 0000010 0011010 |

1101110 0001110 0111110 0100110 1001110 1100110 1111110 |

0101001 1001001 1111001 1100001 0001001 0100001 0111001 |

1011011 0111011 0001011 0010011 1111011 1010011 1001011 |

0011100 1111100 1001100 1010100 0111100 0010100 0001100 |

1111000 0011000 0101000 0110000 1011000 1110000 1101000 |

0111111 1011111 1101111 1110111 0011111 0110111 0101111 |

-

0

1 0 0 1 0 0 -

1

0 0 0 1 0 0 -

1

1 1 0 1 0 0 -

1

1 0 1 1 0 0 -

0

0 0 0 1 0 0 -

0

1 0 1 1 0 0 -

0

1 1 0 1 0 0

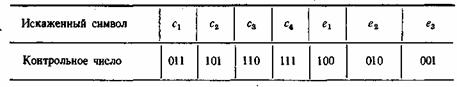

Таким

образом вектору ошибки a1

соответствует синдром 1 1 1

“ a2 “ 0

1 1

“ a3 “ 1

1 0

“ a4 “ 1

0 1

“ a5 “ 1

0 0

“ a6 “ 0

1 0

“ a7 “ 0

0 1

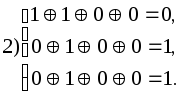

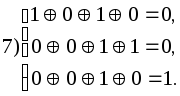

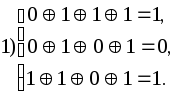

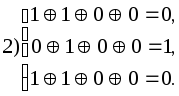

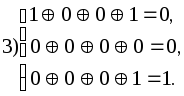

Предположим,

приняты комбинации 1011001, 1000101, 0001100,

0000001 и 1010001. Производим проверки

Синдром

первой принятой комбинации — 101, значит

вектор ошибки а4

= 0001000, исправление ошибки производится

заменой символа в четвертом разряде

принятой комбинации на обратный. Истинная

комбинация — А5,

так как принятая комбинация находится

в шестом столбце таблицы в строке,

соответствующей синдрому 101.

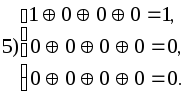

Синдром

второй принятой комбинации — 010, находим

ее в шестой строке (010 соответствует а6)

и в девятом столбце. Истинная комбинация

А8

= 0001101, т.е. исправлена двойная ошибка.

Синдром

третьей принятой комбинации — 001

соответствует а7,

истинная комбинация А13.

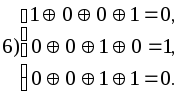

Синдром

четвертой из принятых комбинаций — 001

также соответствует а7,

но принятую комбинацию мы находим в

шестом столбце таблицы , следовательно,

истинная комбинация — А5.

Синдром шестой

принятой комбинации — 000. Ошибки нет.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

From Wikipedia, the free encyclopedia

In coding theory, a linear code is an error-correcting code for which any linear combination of codewords is also a codeword. Linear codes are traditionally partitioned into block codes and convolutional codes, although turbo codes can be seen as a hybrid of these two types.[1] Linear codes allow for more efficient encoding and decoding algorithms than other codes (cf. syndrome decoding).[citation needed]

Linear codes are used in forward error correction and are applied in methods for transmitting symbols (e.g., bits) on a communications channel so that, if errors occur in the communication, some errors can be corrected or detected by the recipient of a message block. The codewords in a linear block code are blocks of symbols that are encoded using more symbols than the original value to be sent.[2] A linear code of length n transmits blocks containing n symbols. For example, the [7,4,3] Hamming code is a linear binary code which represents 4-bit messages using 7-bit codewords. Two distinct codewords differ in at least three bits. As a consequence, up to two errors per codeword can be detected while a single error can be corrected.[3] This code contains 24=16 codewords.

Definition and parameters[edit]

A linear code of length n and dimension k is a linear subspace C with dimension k of the vector space

The weight of a codeword is the number of its elements that are nonzero and the distance between two codewords is the Hamming distance between them, that is, the number of elements in which they differ. The distance d of the linear code is the minimum weight of its nonzero codewords, or equivalently, the minimum distance between distinct codewords. A linear code of length n, dimension k, and distance d is called an [n,k,d] code (or, more precisely, ![[n,k,d]_{q}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5eef76e1d6b74cc535236a6249e75afeea540ee3)

We want to give

Generator and check matrices[edit]

As a linear subspace of

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

A matrix H representing a linear function

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

![{displaystyle {boldsymbol {H}}=[-P^{T}|I_{n-k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf073820dfea39e704650fee6958cf29c59f03c7)

Linearity guarantees that the minimum Hamming distance d between a codeword c0 and any of the other codewords c ≠ c0 is independent of c0. This follows from the property that the difference c − c0 of two codewords in C is also a codeword (i.e., an element of the subspace C), and the property that d(c, c0) = d(c − c0, 0). These properties imply that

In other words, in order to find out the minimum distance between the codewords of a linear code, one would only need to look at the non-zero codewords. The non-zero codeword with the smallest weight has then the minimum distance to the zero codeword, and hence determines the minimum distance of the code.

The distance d of a linear code C also equals the minimum number of linearly dependent columns of the check matrix H.

Proof: Because

Example: Hamming codes[edit]

As the first class of linear codes developed for error correction purpose, Hamming codes have been widely used in digital communication systems. For any positive integer

![[2^{r}-1,2^{r}-r-1,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f4b7099796302beb1cea00796f3d9a67b448e08c)

Example : The linear block code with the following generator matrix and parity check matrix is a ![[7,4,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/499457f6464e18a49d7e72d66681299c4862829a)

Example: Hadamard codes[edit]

Hadamard code is a ![[2^{r},r,2^{r-1}]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e698d84a6a5cfe250e1e1831a36917bc5f6dbc60)

Example: The linear block code with the following generator matrix is a ![[8,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25e2abe070a736c1d85fc3d68f41ad9d65cc9a85)

Hadamard code is a special case of Reed–Muller code. If we take the first column (the all-zero column) out from

![[7,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/61062d9e8384323c74a528929abb584e5c30caba)

Nearest neighbor algorithm[edit]

The parameter d is closely related to the error correcting ability of the code. The following construction/algorithm illustrates this (called the nearest neighbor decoding algorithm):

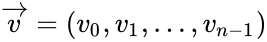

Input: A received vector v in

Output: A codeword

We say that a linear

Popular notation[edit]

Codes in general are often denoted by the letter C, and a code of length n and of rank k (i.e., having k code words in its basis and k rows in its generating matrix) is generally referred to as an (n, k) code. Linear block codes are frequently denoted as [n, k, d] codes, where d refers to the code’s minimum Hamming distance between any two code words.

(The [n, k, d] notation should not be confused with the (n, M, d) notation used to denote a non-linear code of length n, size M (i.e., having M code words), and minimum Hamming distance d.)

Singleton bound[edit]

Lemma (Singleton bound): Every linear [n,k,d] code C satisfies

A code C whose parameters satisfy k+d=n+1 is called maximum distance separable or MDS. Such codes, when they exist, are in some sense best possible.

If C1 and C2 are two codes of length n and if there is a permutation p in the symmetric group Sn for which (c1,…,cn) in C1 if and only if (cp(1),…,cp(n)) in C2, then we say C1 and C2 are permutation equivalent. In more generality, if there is an

Lemma: Any linear code is permutation equivalent to a code which is in standard form.

Bonisoli’s theorem[edit]

A code is defined to be equidistant if and only if there exists some constant d such that the distance between any two of the code’s distinct codewords is equal to d.[4] In 1984 Arrigo Bonisoli determined the structure of linear one-weight codes over finite fields and proved that every equidistant linear code is a sequence of dual Hamming codes.[5]

Examples[edit]

Some examples of linear codes include:

- Repetition codes

- Parity codes

- Cyclic codes

- Hamming codes

- Golay code, both the binary and ternary versions

- Polynomial codes, of which BCH codes are an example

- Reed–Solomon codes

- Reed–Muller codes

- Goppa codes

- Low-density parity-check codes

- Expander codes

- Multidimensional parity-check codes

- Toric codes

- Turbo codes

Generalization[edit]

Hamming spaces over non-field alphabets have also been considered, especially over finite rings, most notably Galois rings over Z4. This gives rise to modules instead of vector spaces and ring-linear codes (identified with submodules) instead of linear codes. The typical metric used in this case the Lee distance. There exist a Gray isometry between

More recently,[when?] some authors have referred to such codes over rings simply as linear codes as well.[9]

See also[edit]

- Decoding methods

References[edit]

- ^ William E. Ryan and Shu Lin (2009). Channel Codes: Classical and Modern. Cambridge University Press. p. 4. ISBN 978-0-521-84868-8.

- ^ MacKay, David, J.C. (2003). Information Theory, Inference, and Learning Algorithms (PDF). Cambridge University Press. p. 9. Bibcode:2003itil.book…..M. ISBN 9780521642989.

In a linear block code, the extra

bits are linear functions of the original

bits; these extra bits are called parity-check bits

- ^ Thomas M. Cover and Joy A. Thomas (1991). Elements of Information Theory. John Wiley & Sons, Inc. pp. 210–211. ISBN 978-0-471-06259-2.

- ^ Etzion, Tuvi; Raviv, Netanel (2013). «Equidistant codes in the Grassmannian». arXiv:1308.6231 [math.CO].

- ^ Bonisoli, A. (1984). «Every equidistant linear code is a sequence of dual Hamming codes». Ars Combinatoria. 18: 181–186.

- ^ Marcus Greferath (2009). «An Introduction to Ring-Linear Coding Theory». In Massimiliano Sala; Teo Mora; Ludovic Perret; Shojiro Sakata; Carlo Traverso (eds.). Gröbner Bases, Coding, and Cryptography. Springer Science & Business Media. ISBN 978-3-540-93806-4.

- ^ «Encyclopedia of Mathematics». www.encyclopediaofmath.org.

- ^ J.H. van Lint (1999). Introduction to Coding Theory (3rd ed.). Springer. Chapter 8: Codes over ℤ4. ISBN 978-3-540-64133-9.

- ^ S.T. Dougherty; J.-L. Kim; P. Sole (2015). «Open Problems in Coding Theory». In Steven Dougherty; Alberto Facchini; Andre Gerard Leroy; Edmund Puczylowski; Patrick Sole (eds.). Noncommutative Rings and Their Applications. American Mathematical Soc. p. 80. ISBN 978-1-4704-1032-2.

Bibliography[edit]

- J. F. Humphreys; M. Y. Prest (2004). Numbers, Groups and Codes (2nd ed.). Cambridge University Press. ISBN 978-0-511-19420-7. Chapter 5 contains a more gentle introduction (than this article) to the subject of linear codes.

External links[edit]

- q-ary code generator program

- Code Tables: Bounds on the parameters of various types of codes, IAKS, Fakultät für Informatik, Universität Karlsruhe (TH)]. Online, up to date table of the optimal binary codes, includes non-binary codes.

- The database of Z4 codes Online, up to date database of optimal Z4 codes.

From Wikipedia, the free encyclopedia

In coding theory, a linear code is an error-correcting code for which any linear combination of codewords is also a codeword. Linear codes are traditionally partitioned into block codes and convolutional codes, although turbo codes can be seen as a hybrid of these two types.[1] Linear codes allow for more efficient encoding and decoding algorithms than other codes (cf. syndrome decoding).[citation needed]

Linear codes are used in forward error correction and are applied in methods for transmitting symbols (e.g., bits) on a communications channel so that, if errors occur in the communication, some errors can be corrected or detected by the recipient of a message block. The codewords in a linear block code are blocks of symbols that are encoded using more symbols than the original value to be sent.[2] A linear code of length n transmits blocks containing n symbols. For example, the [7,4,3] Hamming code is a linear binary code which represents 4-bit messages using 7-bit codewords. Two distinct codewords differ in at least three bits. As a consequence, up to two errors per codeword can be detected while a single error can be corrected.[3] This code contains 24=16 codewords.

Definition and parameters[edit]

A linear code of length n and dimension k is a linear subspace C with dimension k of the vector space

The weight of a codeword is the number of its elements that are nonzero and the distance between two codewords is the Hamming distance between them, that is, the number of elements in which they differ. The distance d of the linear code is the minimum weight of its nonzero codewords, or equivalently, the minimum distance between distinct codewords. A linear code of length n, dimension k, and distance d is called an [n,k,d] code (or, more precisely, ![[n,k,d]_{q}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5eef76e1d6b74cc535236a6249e75afeea540ee3)

We want to give

Generator and check matrices[edit]

As a linear subspace of

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

A matrix H representing a linear function

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

![{displaystyle {boldsymbol {H}}=[-P^{T}|I_{n-k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf073820dfea39e704650fee6958cf29c59f03c7)

Linearity guarantees that the minimum Hamming distance d between a codeword c0 and any of the other codewords c ≠ c0 is independent of c0. This follows from the property that the difference c − c0 of two codewords in C is also a codeword (i.e., an element of the subspace C), and the property that d(c, c0) = d(c − c0, 0). These properties imply that

In other words, in order to find out the minimum distance between the codewords of a linear code, one would only need to look at the non-zero codewords. The non-zero codeword with the smallest weight has then the minimum distance to the zero codeword, and hence determines the minimum distance of the code.

The distance d of a linear code C also equals the minimum number of linearly dependent columns of the check matrix H.

Proof: Because

Example: Hamming codes[edit]

As the first class of linear codes developed for error correction purpose, Hamming codes have been widely used in digital communication systems. For any positive integer

![[2^{r}-1,2^{r}-r-1,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f4b7099796302beb1cea00796f3d9a67b448e08c)

Example : The linear block code with the following generator matrix and parity check matrix is a ![[7,4,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/499457f6464e18a49d7e72d66681299c4862829a)

Example: Hadamard codes[edit]

Hadamard code is a ![[2^{r},r,2^{r-1}]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e698d84a6a5cfe250e1e1831a36917bc5f6dbc60)

Example: The linear block code with the following generator matrix is a ![[8,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25e2abe070a736c1d85fc3d68f41ad9d65cc9a85)

Hadamard code is a special case of Reed–Muller code. If we take the first column (the all-zero column) out from

![[7,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/61062d9e8384323c74a528929abb584e5c30caba)

Nearest neighbor algorithm[edit]

The parameter d is closely related to the error correcting ability of the code. The following construction/algorithm illustrates this (called the nearest neighbor decoding algorithm):

Input: A received vector v in

Output: A codeword

We say that a linear

Popular notation[edit]

Codes in general are often denoted by the letter C, and a code of length n and of rank k (i.e., having k code words in its basis and k rows in its generating matrix) is generally referred to as an (n, k) code. Linear block codes are frequently denoted as [n, k, d] codes, where d refers to the code’s minimum Hamming distance between any two code words.

(The [n, k, d] notation should not be confused with the (n, M, d) notation used to denote a non-linear code of length n, size M (i.e., having M code words), and minimum Hamming distance d.)

Singleton bound[edit]

Lemma (Singleton bound): Every linear [n,k,d] code C satisfies

A code C whose parameters satisfy k+d=n+1 is called maximum distance separable or MDS. Such codes, when they exist, are in some sense best possible.

If C1 and C2 are two codes of length n and if there is a permutation p in the symmetric group Sn for which (c1,…,cn) in C1 if and only if (cp(1),…,cp(n)) in C2, then we say C1 and C2 are permutation equivalent. In more generality, if there is an

Lemma: Any linear code is permutation equivalent to a code which is in standard form.

Bonisoli’s theorem[edit]

A code is defined to be equidistant if and only if there exists some constant d such that the distance between any two of the code’s distinct codewords is equal to d.[4] In 1984 Arrigo Bonisoli determined the structure of linear one-weight codes over finite fields and proved that every equidistant linear code is a sequence of dual Hamming codes.[5]

Examples[edit]

Some examples of linear codes include:

- Repetition codes

- Parity codes

- Cyclic codes

- Hamming codes

- Golay code, both the binary and ternary versions

- Polynomial codes, of which BCH codes are an example

- Reed–Solomon codes

- Reed–Muller codes

- Goppa codes

- Low-density parity-check codes

- Expander codes

- Multidimensional parity-check codes

- Toric codes

- Turbo codes

Generalization[edit]

Hamming spaces over non-field alphabets have also been considered, especially over finite rings, most notably Galois rings over Z4. This gives rise to modules instead of vector spaces and ring-linear codes (identified with submodules) instead of linear codes. The typical metric used in this case the Lee distance. There exist a Gray isometry between

More recently,[when?] some authors have referred to such codes over rings simply as linear codes as well.[9]

See also[edit]

- Decoding methods

References[edit]

- ^ William E. Ryan and Shu Lin (2009). Channel Codes: Classical and Modern. Cambridge University Press. p. 4. ISBN 978-0-521-84868-8.

- ^ MacKay, David, J.C. (2003). Information Theory, Inference, and Learning Algorithms (PDF). Cambridge University Press. p. 9. Bibcode:2003itil.book…..M. ISBN 9780521642989.

In a linear block code, the extra

bits are linear functions of the original

bits; these extra bits are called parity-check bits

- ^ Thomas M. Cover and Joy A. Thomas (1991). Elements of Information Theory. John Wiley & Sons, Inc. pp. 210–211. ISBN 978-0-471-06259-2.

- ^ Etzion, Tuvi; Raviv, Netanel (2013). «Equidistant codes in the Grassmannian». arXiv:1308.6231 [math.CO].

- ^ Bonisoli, A. (1984). «Every equidistant linear code is a sequence of dual Hamming codes». Ars Combinatoria. 18: 181–186.

- ^ Marcus Greferath (2009). «An Introduction to Ring-Linear Coding Theory». In Massimiliano Sala; Teo Mora; Ludovic Perret; Shojiro Sakata; Carlo Traverso (eds.). Gröbner Bases, Coding, and Cryptography. Springer Science & Business Media. ISBN 978-3-540-93806-4.

- ^ «Encyclopedia of Mathematics». www.encyclopediaofmath.org.

- ^ J.H. van Lint (1999). Introduction to Coding Theory (3rd ed.). Springer. Chapter 8: Codes over ℤ4. ISBN 978-3-540-64133-9.

- ^ S.T. Dougherty; J.-L. Kim; P. Sole (2015). «Open Problems in Coding Theory». In Steven Dougherty; Alberto Facchini; Andre Gerard Leroy; Edmund Puczylowski; Patrick Sole (eds.). Noncommutative Rings and Their Applications. American Mathematical Soc. p. 80. ISBN 978-1-4704-1032-2.

Bibliography[edit]

- J. F. Humphreys; M. Y. Prest (2004). Numbers, Groups and Codes (2nd ed.). Cambridge University Press. ISBN 978-0-511-19420-7. Chapter 5 contains a more gentle introduction (than this article) to the subject of linear codes.

External links[edit]

- q-ary code generator program

- Code Tables: Bounds on the parameters of various types of codes, IAKS, Fakultät für Informatik, Universität Karlsruhe (TH)]. Online, up to date table of the optimal binary codes, includes non-binary codes.

- The database of Z4 codes Online, up to date database of optimal Z4 codes.

В области математики и теории информации линейный код — это важный тип блокового кода, использующийся в схемах определения и коррекции ошибок. Линейные коды, по сравнению с другими кодами, позволяют реализовывать более эффективные алгоритмы кодирования и декодирования информации.

Основы

В процессе хранения данных и передачи информации по сетям связи неизбежно возникают ошибки. Контроль целостности данных и исправление ошибок — важные задачи на многих уровнях работы с информацией (в частности, физическом, канальном, транспортном уровнях модели OSI).

В системах связи возможны несколько стратегий борьбы с ошибками:

- обнаружение ошибок в блоках данных и автоматический запрос повторной передачи поврежденных блоков — этот подход применяется в основном на канальном и транспортном уровнях;

- обнаружение ошибок в блоках данных и отбрасывание поврежденных блоков — такой подход иногда применяется в системах потокового мультимедиа, где важна задержка передачи и нет времени на повторную передачу;

- исправление ошибок (англ. forward error correction) применяется на физическом уровне.

Коды обнаружения и исправления ошибок

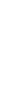

Корректирующие коды — коды, служащие для обнаружения или исправления ошибок, возникающих при передаче информации под влиянием помех, а также при её хранении.

Для этого при записи (передаче) в полезные данные добавляют специальным образом структурированную избыточную информацию, а при чтении (приеме) её используют для того, чтобы обнаружить или исправить ошибки. Естественно, что число ошибок, которое можно исправить, ограничено и зависит от конкретного применяемого кода.

С кодами, исправляющими ошибки, тесно связаны коды обнаружения ошибок. В отличие от первых, последние могут только установить факт наличия ошибки в переданных данных, но не исправить её.

В действительности, используемые коды обнаружения ошибок принадлежат к тем же классам кодов, что и коды, исправляющие ошибки. Фактически, любой код, исправляющий ошибки, может быть также использован для обнаружения ошибок (при этом он будет способен обнаружить большее число ошибок, чем был способен исправить).

По способу работы с данными коды, исправляющие ошибки делятся на блоковые, делящие информацию на фрагменты постоянной длины и обрабатывающие каждый из них в отдельности, и сверточные, работающие с данными как с непрерывным потоком.

Блоковые коды

Пусть кодируемая информация делится на фрагменты длиной

Если исходные

Задать блоковый код можно по-разному, в том числе таблицей, где каждой совокупности из

- способность исправлять как можно большее число ошибок,

- как можно меньшая избыточность,

- простота кодирования и декодирования.

Нетрудно видеть, что приведенные требования противоречат друг другу. Именно поэтому существует большое количество кодов, каждый из которых пригоден для своего круга задач.

Практически все используемые коды являются линейными. Это связано с тем, что нелинейные коды значительно сложнее исследовать, и для них трудно обеспечить приемлемую легкость кодирования и декодирования.

Линейные пространства

Порождающая матрица

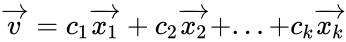

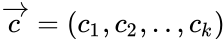

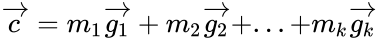

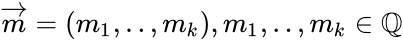

Пусть векторы

либо в матричной форме, как:

где

называется порождающей матрицей линейного пространства.

Это соотношение устанавливает связь между векторами коэффициентов

и векторами

Проверочная матрица

Другим способом задания линейных пространств является описание через проверочную матрицу.

Пусть

Тогда любой вектор

Или в матричной форме:

где

— проверочная матрица.

Приведенную систему линейных уравнений следует рассматривать, как систему проверок для всех векторов линейного пространства, поэтому матрица

Формальное определение

Линейный код длины n и ранга k является линейным подпространством C размерности k векторного пространства

Линейный (блоковый) код — такой код, что множество его кодовых слов образует

Это значит, что операция кодирования соответствует умножению исходного

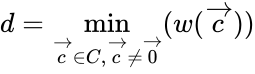

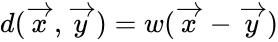

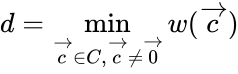

Пусть

.

Свойства и важные теоремы

Минимальное расстояние и корректирующая способность

Расстоянием Хемминга (метрикой Хемминга) между двумя кодовыми словами

Минимальное расстояние

Вес вектора —

Теорема 1:

Минимальное расстояние

Доказательство:

Расстояние между двумя векторами

Минимальное расстояние Хемминга

Корректирующая способность определяет, какое максимальное число ошибок в одном кодовом слове код может гарантированно исправить.

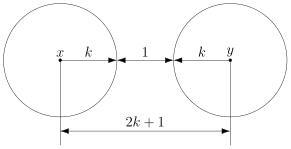

Поясним на примере. Предположим, что есть два кодовых слова A и B, расстояние Хемминга между ними равно 3. Если было передано слово A, и канал внес ошибку в одном бите, она может быть исправлена, так как даже в этом случае принятое слово ближе к кодовому слову A, чем B. Но если каналом были внесены ошибки в двух битах, декодер может посчитать, что было передано слово B.

Число обнаруживаемых ошибок — число ошибок, при котором код может судить об ошибочной ситуации. Это число равно

.

Теорема 2 (без доказательства):

Если любые

Теорема 3 (без доказательства):

Если минимальное расстояние линейного (n, k)-кода равно d, то любые

Коды Хемминга

Коды Хемминга — простейшие линейные коды с минимальным расстоянием 3, то есть способные исправить одну ошибку. Код Хемминга может быть представлен в таком виде, что синдром

, где

— принятый вектор,

будет равен номеру позиции, в которой произошла ошибка. Это свойство позволяет сделать декодирование очень простым.

Код Рида-Малера

Код Рида-Малера [en:Reed-Muller code] — линейный код.

Общий метод кодирования линейных кодов

Линейный код длины n с k информационными символами является k-мерным линейным подпространством, поэтому каждое кодовое слово является линейной комбинацией базисных векторов

Либо с помощью порождающей матрицы:

где

Это соотношение есть правило кодирование, по которому информационное слово

Общий метод обнаружения ошибок в линейном коде

Любой код (в том числе нелинейный) можно декодировать с помощью обычной таблицы, где каждому значению принятого слова

Для линейных кодов этот метод можно существенно упростить. При этом для каждого принятого вектора

Линейные циклические коды

Несмотря на то, что исправление ошибок в линейных кодах уже значительно проще исправления в большинстве нелинейных, для большинства кодов этот процесс все ещё достаточно сложен. Циклические коды, кроме более простого декодирования, обладают и другими важными свойствами.

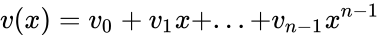

Циклическим кодом является линейный код, обладающий следующим свойством: если

Слова циклического кода удобно представлять в виде многочленов. Например, кодовое слово

В дальнейшем, если не указано иное, мы будем считать, что циклический код является двоичным, то есть

Порождающий полином

Можно показать, что все кодовые слова конкретного циклического кода кратны определенному порождающему полиному

С помощью порождающего полинома осуществляется кодирование циклическим кодом. В частности:

Коды CRC

Коды CRC (cyclic redundancy check — циклическая избыточная проверка) являются систематическими кодами, предназначенными не для исправления ошибок, а для их обнаружения. Они используют способ систематического кодирования, изложенный выше: «контрольная сумма» вычисляется путем деления

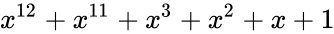

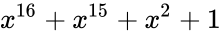

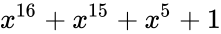

Таким образом, вид полинома g(x) задает конкретный код CRC. Примеры наиболее популярных полиномов:

| название кода | степень | полином |

|---|---|---|

| CRC-12 | 12 |  |

| CRC-16 | 16 |  |

| CRC-CCITT | 16 |  |

| CRC-32 | 32 |  |

Коды БЧХ

Коды Боуза-Чоудхури-Хоквингема (БЧХ) являются подклассом двоичных циклических кодов. Их отличительное свойство — возможность построения кода БЧХ с минимальным расстоянием не меньше заданного. Это важно, потому что, вообще говоря, определение минимального расстояния кода есть очень сложная задача.

Математически построение кодов БЧХ и их декодирование используют разложение порождающего полинома

Коды Рида-Соломона

Коды Рида-Соломона (РС-коды) фактически являются недвоичными кодами БЧХ, то есть элементы кодового вектора являются не битами, а группами битов. Очень распространены коды Рида-Соломона, работающие с байтами (октетами).

Преимущества и недостатки линейных кодов

Хотя линейные коды, как правило, хорошо справляются с редкими, но большими пачками ошибок, их эффективность при частых, но небольших ошибках (например, в канале с АБГШ), менее высока.

Благодаря линейности для запоминания или перечисления всех кодовых слов достаточно хранить в памяти кодера или декодера существенно меньшую их часть, а именно только те слова, которые образуют базис соответствующего линейного пространства. Это существенно упрощает реализацию устройств кодирования и декодирования и делает линейные коды весьма привлекательными с точки зрения практических приложений.

Оценка эффективности

Эффективность кодов определяется количеством ошибок, которые тот может исправить, количеством избыточной информации, добавление которой требуется, а также сложностью реализации кодирования и декодирования (как аппаратной, так и в виде программы для ЭВМ).

Граница Хемминга и совершенные коды

Пусть имеется двоичный блоковый

.

Коды, удовлетворяющие этой границе с равенством, называются совершенными. К совершенным кодам относятся, например, коды Хемминга. Часто применяемые на практике коды с большой корректирующей способностью (такие, как коды Рида-Соломона) не являются совершенными.

Энергетический выигрыш

При передаче информации по каналу связи вероятность ошибки зависит от отношения сигнал/шум на входе демодулятора, таким образом при постоянном уровне шума решающее значение имеет мощность передатчика. В системах спутниковой и мобильной, а также других типов связи остро стоит вопрос экономии энергии. Кроме того, в определенных системах связи (например, телефонной) неограниченно повышать мощность сигнала не дают технические ограничения.

Поскольку помехоустойчивое кодирование позволяет исправлять ошибки, при его применении мощность передатчика можно снизить, оставляя скорость передачи информации неизменной. Энергетический выигрыш определяется как разница отношений с/ш при наличии и отсутствии кодирования.

Применение

Линейные коды применяются:

- в системах цифровой связи, в том числе: спутниковой, радиорелейной, сотовой, передаче данных по телефонным каналам.

- в системах хранения информации, в том числе магнитных и оптических.

Линейные коды применяются в сетевых протоколах различных уровней.

См. также

- Циклический код

Эта страница использует содержимое раздела Википедии на русском языке. Оригинальная статья находится по адресу: Линейный код. Список первоначальных авторов статьи можно посмотреть в истории правок. Эта статья так же, как и статья, размещённая в Википедии, доступна на условиях CC-BY-SA .

From Wikipedia, the free encyclopedia

In coding theory, a linear code is an error-correcting code for which any linear combination of codewords is also a codeword. Linear codes are traditionally partitioned into block codes and convolutional codes, although turbo codes can be seen as a hybrid of these two types.[1] Linear codes allow for more efficient encoding and decoding algorithms than other codes (cf. syndrome decoding).[citation needed]

Linear codes are used in forward error correction and are applied in methods for transmitting symbols (e.g., bits) on a communications channel so that, if errors occur in the communication, some errors can be corrected or detected by the recipient of a message block. The codewords in a linear block code are blocks of symbols that are encoded using more symbols than the original value to be sent.[2] A linear code of length n transmits blocks containing n symbols. For example, the [7,4,3] Hamming code is a linear binary code which represents 4-bit messages using 7-bit codewords. Two distinct codewords differ in at least three bits. As a consequence, up to two errors per codeword can be detected while a single error can be corrected.[3] This code contains 24=16 codewords.

Definition and parameters[edit]

A linear code of length n and dimension k is a linear subspace C with dimension k of the vector space

The weight of a codeword is the number of its elements that are nonzero and the distance between two codewords is the Hamming distance between them, that is, the number of elements in which they differ. The distance d of the linear code is the minimum weight of its nonzero codewords, or equivalently, the minimum distance between distinct codewords. A linear code of length n, dimension k, and distance d is called an [n,k,d] code (or, more precisely, ![[n,k,d]_{q}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5eef76e1d6b74cc535236a6249e75afeea540ee3)

We want to give

Generator and check matrices[edit]

As a linear subspace of

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

A matrix H representing a linear function

![{displaystyle {boldsymbol {G}}=[I_{k}|P]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92a00d2764ceb53abed846d99a766b918f10902a)

![{displaystyle {boldsymbol {H}}=[-P^{T}|I_{n-k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf073820dfea39e704650fee6958cf29c59f03c7)

Linearity guarantees that the minimum Hamming distance d between a codeword c0 and any of the other codewords c ≠ c0 is independent of c0. This follows from the property that the difference c − c0 of two codewords in C is also a codeword (i.e., an element of the subspace C), and the property that d(c, c0) = d(c − c0, 0). These properties imply that

In other words, in order to find out the minimum distance between the codewords of a linear code, one would only need to look at the non-zero codewords. The non-zero codeword with the smallest weight has then the minimum distance to the zero codeword, and hence determines the minimum distance of the code.

The distance d of a linear code C also equals the minimum number of linearly dependent columns of the check matrix H.

Proof: Because

Example: Hamming codes[edit]

As the first class of linear codes developed for error correction purpose, Hamming codes have been widely used in digital communication systems. For any positive integer

![[2^{r}-1,2^{r}-r-1,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f4b7099796302beb1cea00796f3d9a67b448e08c)

Example : The linear block code with the following generator matrix and parity check matrix is a ![[7,4,3]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/499457f6464e18a49d7e72d66681299c4862829a)

Example: Hadamard codes[edit]

Hadamard code is a ![[2^{r},r,2^{r-1}]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e698d84a6a5cfe250e1e1831a36917bc5f6dbc60)

Example: The linear block code with the following generator matrix is a ![[8,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25e2abe070a736c1d85fc3d68f41ad9d65cc9a85)

Hadamard code is a special case of Reed–Muller code. If we take the first column (the all-zero column) out from

![[7,3,4]_{2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/61062d9e8384323c74a528929abb584e5c30caba)

Nearest neighbor algorithm[edit]

The parameter d is closely related to the error correcting ability of the code. The following construction/algorithm illustrates this (called the nearest neighbor decoding algorithm):

Input: A received vector v in

Output: A codeword

We say that a linear

Popular notation[edit]

Codes in general are often denoted by the letter C, and a code of length n and of rank k (i.e., having k code words in its basis and k rows in its generating matrix) is generally referred to as an (n, k) code. Linear block codes are frequently denoted as [n, k, d] codes, where d refers to the code’s minimum Hamming distance between any two code words.

(The [n, k, d] notation should not be confused with the (n, M, d) notation used to denote a non-linear code of length n, size M (i.e., having M code words), and minimum Hamming distance d.)

Singleton bound[edit]

Lemma (Singleton bound): Every linear [n,k,d] code C satisfies

A code C whose parameters satisfy k+d=n+1 is called maximum distance separable or MDS. Such codes, when they exist, are in some sense best possible.

If C1 and C2 are two codes of length n and if there is a permutation p in the symmetric group Sn for which (c1,…,cn) in C1 if and only if (cp(1),…,cp(n)) in C2, then we say C1 and C2 are permutation equivalent. In more generality, if there is an

Lemma: Any linear code is permutation equivalent to a code which is in standard form.

Bonisoli’s theorem[edit]

A code is defined to be equidistant if and only if there exists some constant d such that the distance between any two of the code’s distinct codewords is equal to d.[4] In 1984 Arrigo Bonisoli determined the structure of linear one-weight codes over finite fields and proved that every equidistant linear code is a sequence of dual Hamming codes.[5]

Examples[edit]

Some examples of linear codes include:

- Repetition codes

- Parity codes

- Cyclic codes

- Hamming codes

- Golay code, both the binary and ternary versions

- Polynomial codes, of which BCH codes are an example

- Reed–Solomon codes

- Reed–Muller codes

- Algebraic geometry codes

- Binary Goppa codes

- Low-density parity-check codes

- Expander codes

- Multidimensional parity-check codes

- Toric codes

- Turbo codes

Generalization[edit]

Hamming spaces over non-field alphabets have also been considered, especially over finite rings, most notably Galois rings over Z4. This gives rise to modules instead of vector spaces and ring-linear codes (identified with submodules) instead of linear codes. The typical metric used in this case the Lee distance. There exist a Gray isometry between

More recently,[when?] some authors have referred to such codes over rings simply as linear codes as well.[9]

See also[edit]

- Decoding methods

References[edit]

- ^ William E. Ryan and Shu Lin (2009). Channel Codes: Classical and Modern. Cambridge University Press. p. 4. ISBN 978-0-521-84868-8.

- ^ MacKay, David, J.C. (2003). Information Theory, Inference, and Learning Algorithms (PDF). Cambridge University Press. p. 9. Bibcode:2003itil.book…..M. ISBN 9780521642989.

In a linear block code, the extra

bits are linear functions of the original

bits; these extra bits are called parity-check bits

- ^ Thomas M. Cover and Joy A. Thomas (1991). Elements of Information Theory. John Wiley & Sons, Inc. pp. 210–211. ISBN 978-0-471-06259-2.

- ^ Etzion, Tuvi; Raviv, Netanel (2013). «Equidistant codes in the Grassmannian». arXiv:1308.6231 [math.CO].

- ^ Bonisoli, A. (1984). «Every equidistant linear code is a sequence of dual Hamming codes». Ars Combinatoria. 18: 181–186.

- ^ Marcus Greferath (2009). «An Introduction to Ring-Linear Coding Theory». In Massimiliano Sala; Teo Mora; Ludovic Perret; Shojiro Sakata; Carlo Traverso (eds.). Gröbner Bases, Coding, and Cryptography. Springer Science & Business Media. ISBN 978-3-540-93806-4.

- ^ «Encyclopedia of Mathematics». www.encyclopediaofmath.org.

- ^ J.H. van Lint (1999). Introduction to Coding Theory (3rd ed.). Springer. Chapter 8: Codes over ℤ4. ISBN 978-3-540-64133-9.

- ^ S.T. Dougherty; J.-L. Kim; P. Sole (2015). «Open Problems in Coding Theory». In Steven Dougherty; Alberto Facchini; Andre Gerard Leroy; Edmund Puczylowski; Patrick Sole (eds.). Noncommutative Rings and Their Applications. American Mathematical Soc. p. 80. ISBN 978-1-4704-1032-2.

Bibliography[edit]

- J. F. Humphreys; M. Y. Prest (2004). Numbers, Groups and Codes (2nd ed.). Cambridge University Press. ISBN 978-0-511-19420-7. Chapter 5 contains a more gentle introduction (than this article) to the subject of linear codes.

External links[edit]

- q-ary code generator program

- Code Tables: Bounds on the parameters of various types of codes, IAKS, Fakultät für Informatik, Universität Karlsruhe (TH)]. Online, up to date table of the optimal binary codes, includes non-binary codes.

- The database of Z4 codes Online, up to date database of optimal Z4 codes.

Корректирующие коды «на пальцах»

Время на прочтение

11 мин

Количество просмотров 63K

Корректирующие (или помехоустойчивые) коды — это коды, которые могут обнаружить и, если повезёт, исправить ошибки, возникшие при передаче данных. Даже если вы ничего не слышали о них, то наверняка встречали аббревиатуру CRC в списке файлов в ZIP-архиве или даже надпись ECC на планке памяти. А кто-то, может быть, задумывался, как так получается, что если поцарапать DVD-диск, то данные всё равно считываются без ошибок. Конечно, если царапина не в сантиметр толщиной и не разрезала диск пополам.

Корректирующие (или помехоустойчивые) коды — это коды, которые могут обнаружить и, если повезёт, исправить ошибки, возникшие при передаче данных. Даже если вы ничего не слышали о них, то наверняка встречали аббревиатуру CRC в списке файлов в ZIP-архиве или даже надпись ECC на планке памяти. А кто-то, может быть, задумывался, как так получается, что если поцарапать DVD-диск, то данные всё равно считываются без ошибок. Конечно, если царапина не в сантиметр толщиной и не разрезала диск пополам.

Как нетрудно догадаться, ко всему этому причастны корректирующие коды. Собственно, ECC так и расшифровывается — «error-correcting code», то есть «код, исправляющий ошибки». А CRC — это один из алгоритмов, обнаруживающих ошибки в данных. Исправить он их не может, но часто это и не требуется.

Давайте же разберёмся, что это такое.

Для понимания статьи не нужны никакие специальные знания. Достаточно лишь понимать, что такое вектор и матрица, как они перемножаются и как с их помощью записать систему линейных уравнений.

Внимание! Много текста и мало картинок. Я постарался всё объяснить, но без карандаша и бумаги текст может показаться немного запутанным.

Каналы с ошибкой

Разберёмся сперва, откуда вообще берутся ошибки, которые мы собираемся исправлять. Перед нами стоит следующая задача. Нужно передать несколько блоков данных, каждый из которых кодируется цепочкой двоичных цифр. Получившаяся последовательность нулей и единиц передаётся через канал связи. Но так сложилось, что реальные каналы связи часто подвержены ошибкам. Вообще говоря, ошибки могут быть разных видов — может появиться лишняя цифра или какая-то пропасть. Но мы будем рассматривать только ситуации, когда в канале возможны лишь замены нуля на единицу и наоборот. Причём опять же для простоты будем считать такие замены равновероятными.

Ошибка — это маловероятное событие (а иначе зачем нам такой канал вообще, где одни ошибки?), а значит, вероятность двух ошибок меньше, а трёх уже совсем мала. Мы можем выбрать для себя некоторую приемлемую величину вероятности, очертив границу «это уж точно невозможно». Это позволит нам сказать, что в канале возможно не более, чем ошибок. Это будет характеристикой канала связи.

Для простоты введём следующие обозначения. Пусть данные, которые мы хотим передавать, — это двоичные последовательности фиксированной длины. Чтобы не запутаться в нулях и единицах, будем иногда обозначать их заглавными латинскими буквами (,

,

, …). Что именно передавать, в общем-то неважно, просто с буквами в первое время будет проще работать.

Кодирование и декодирование будем обозначать прямой стрелкой (), а передачу по каналу связи — волнистой стрелкой (

). Ошибки при передаче будем подчёркивать.

Например, пусть мы хотим передавать только сообщения и

. В простейшем случае их можно закодировать нулём и единицей (сюрприз!):

Передача по каналу, в котором возникла ошибка будет записана так:

Цепочки нулей и единиц, которыми мы кодируем буквы, будем называть кодовыми словами. В данном простом случае кодовые слова — это и

.

Код с утроением

Давайте попробуем построить какой-то корректирующий код. Что мы обычно делаем, когда кто-то нас не расслышал? Повторяем дважды:

Правда, это нам не очень поможет. В самом деле, рассмотрим канал с одной возможной ошибкой:

Какие выводы мы можем сделать, когда получили ? Понятно, что раз у нас не две одинаковые цифры, то была ошибка, но вот в каком разряде? Может, в первом, и была передана буква

. А может, во втором, и была передана

.

То есть, получившийся код обнаруживает, но не исправляет ошибки. Ну, тоже неплохо, в общем-то. Но мы пойдём дальше и будем теперь утраивать цифры.

Проверим в деле:

Получили . Тут у нас есть две возможности: либо это

и было две ошибки (в крайних цифрах), либо это

и была одна ошибка. Вообще, вероятность одной ошибки выше вероятности двух ошибок, так что самым правдоподобным будет предположение о том, что передавалась именно буква

. Хотя правдоподобное — не значит истинное, поэтому рядом и стоит вопросительный знак.

Если в канале связи возможна максимум одна ошибка, то первое предположение о двух ошибках становится невозможным и остаётся только один вариант — передавалась буква .

Про такой код говорят, что он исправляет одну ошибку. Две он тоже обнаружит, но исправит уже неверно.

Это, конечно, самый простой код. Кодировать легко, да и декодировать тоже. Ноликов больше — значит передавался ноль, единичек — значит единица.

Если немного подумать, то можно предложить код исправляющий две ошибки. Это будет код, в котором мы повторяем одиночный бит 5 раз.

Расстояния между кодами

Рассмотрим поподробнее код с утроением. Итак, мы получили работающий код, который исправляет одиночную ошибку. Но за всё хорошее надо платить: он кодирует один бит тремя. Не очень-то и эффективно.

И вообще, почему этот код работает? Почему нужно именно утраивать для устранения одной ошибки? Наверняка это всё неспроста.

Давайте подумаем, как этот код работает. Интуитивно всё понятно. Нолики и единички — это две непохожие последовательности. Так как они достаточно длинные, то одиночная ошибка не сильно портит их вид.

Пусть мы передавали , а получили

. Видно, что эта цепочка больше похожа на исходные

, чем на

. А так как других кодовых слов у нас нет, то и выбор очевиден.

Но что значит «больше похоже»? А всё просто! Чем больше символов у двух цепочек совпадает, тем больше их схожесть. Если почти все символы отличаются, то цепочки «далеки» друг от друга.

Можно ввести некоторую величину , равную количеству различающихся цифр в соответствующих разрядах цепочек

и

. Эту величину называют расстоянием Хэмминга. Чем больше это расстояние, тем меньше похожи две цепочки.

Например, , так как все цифры в соответствующих позициях равны, а вот

.

Расстояние Хэмминга называют расстоянием неспроста. Ведь в самом деле, что такое расстояние? Это какая-то характеристика, указывающая на близость двух точек, и для которой верны утверждения:

- Расстояние между точками неотрицательно и равно нулю только, если точки совпадают.

- Расстояние в обе стороны одинаково.

- Путь через третью точку не короче, чем прямой путь.

Достаточно разумные требования.

Математически это можно записать так (нам это не пригодится, просто ради интереса посмотрим):

.

Предлагаю читателю самому убедиться, что для расстояния Хэмминга эти свойства выполняются.

Окрестности

Таким образом, разные цепочки мы считаем точками в каком-то воображаемом пространстве, и теперь мы умеем находить расстояния между ними. Правда, если попытаться сколько нибудь длинные цепочки расставить на листе бумаги так, чтобы расстояния Хэмминга совпадали с расстояниями на плоскости, мы можем потерпеть неудачу. Но не нужно переживать. Всё же это особое пространство со своими законами. А слова вроде «расстояния» лишь помогают нам рассуждать.

Пойдём дальше. Раз мы заговорили о расстоянии, то можно ввести такое понятие как окрестность. Как известно, окрестность какой-то точки — это шар определённого радиуса с центром в ней. Шар? Какие ещё шары! Мы же о кодах говорим.

Но всё просто. Ведь что такое шар? Это множество всех точек, которые находятся от данной не дальше, чем некоторое расстояние, называемое радиусом. Точки у нас есть, расстояние у нас есть, теперь есть и шары.

Так, скажем, окрестность кодового слова радиуса 1 — это все коды, находящиеся на расстоянии не больше, чем 1 от него, то есть отличающиеся не больше, чем в одном разряде. То есть это коды:

Да, вот так странно выглядят шары в пространстве кодов.

А теперь посмотрите. Это же все возможные коды, которые мы получим в канале в одной ошибкой, если отправим ! Это следует прямо из определения окрестности. Ведь каждая ошибка заставляет цепочку измениться только в одном разряде, а значит удаляет её на расстояние 1 от исходного сообщения.

Аналогично, если в канале возможны две ошибки, то отправив некоторое сообщение , мы получим один из кодов, который принадлежит окрестности

радиусом 2.

Тогда всю нашу систему декодирования можно построить так. Мы получаем какую-то цепочку нулей и единиц (точку в нашей новой терминологии) и смотрим, в окрестность какого кодового слова она попадает.

Сколько ошибок может исправить код?

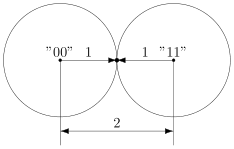

Чтобы код мог исправлять больше ошибок, окрестности должны быть как можно шире. С другой стороны, они не должны пересекаться. Иначе если точка попадёт в область пересечения, непонятно будет, к какой окрестности её отнести.

В коде с удвоением между кодовыми словами и

расстояние равно 2 (оба разряда различаются). А значит, если мы построим вокруг них шары радиуса 1, то они будут касаться. Это значит, точка касания будет принадлежать обоим шарам и непонятно будет, к какому из них её отнести.

Именно это мы и получали. Мы видели, что есть ошибка, но не могли её исправить.

Что интересно, точек касания в нашем странном пространстве у шаров две — это коды и

. Расстояния от них до центров равны единице. Конечно же, в обычно геометрии такое невозможно, поэтому рисунки — это просто условность для более удобного рассуждения.

В случае кода с утроением, между шарами будет зазор.

Минимальный зазор между шарами равен 1, так как у нас расстояния всегда целые (ну не могут же две цепочки отличаться в полутора разрядах).

В общем случае получаем следующее.

Этот очевидный результат на самом деле очень важен. Он означает, что код с минимальным кодовым расстоянием будет успешно работать в канале с

ошибками, если выполняется соотношение

Полученное равенство позволяет легко определить, сколько ошибок будет исправлять тот или иной код. А сколько код ошибок может обнаружить? Рассуждения такие же. Код обнаруживает ошибок, если в результате не получится другое кодовое слово. То есть, кодовые слова не должны находиться в окрестностях радиуса

других кодовых слов. Математически это записывается так:

Рассмотрим пример. Пусть мы кодируем 4 буквы следующим образом.

Чтобы найти минимальное расстояние между различными кодовыми словами, построим таблицу попарных расстояний.

| A | B | C | D | |

|---|---|---|---|---|

| A | — | 3 | 3 | 4 |

| B | 3 | — | 4 | 3 |

| C | 3 | 4 | — | 3 |

| D | 4 | 3 | 3 | — |

Минимальное расстояние , а значит

, откуда получаем, что такой код может исправить до

ошибок. Обнаруживает же он две ошибки.

Рассмотрим пример:

Чтобы декодировать полученное сообщение, посмотрим, к какому символу оно ближе всего.

Минимальное расстояние получилось для символа , значит вероятнее всего передавался именно он:

Итак, этот код исправляет одну ошибку, как и код с утроением. Но он более эффективен, так как в отличие от кода с утроением здесь кодируется уже 4 символа.

Таким образом, основная проблема при построении такого рода кодов — так расположить кодовые слова, чтобы они были как можно дальше друг от друга, и их было побольше.

Для декодирования можно было бы использовать таблицу, в которой указывались бы все возможные принимаемые сообщения, и кодовые слова, которым они соответствуют. Но такая таблица получилась бы очень большой. Даже для нашего маленького кода, который выдаёт 5 двоичных цифр, получилось бы варианта возможных принимаемых сообщений. Для более сложных кодов таблица будет значительно больше.

Попробуем придумать способ коррекции сообщения без таблиц. Мы всегда сможем найти полезное применение освободившейся памяти.

Интерлюдия: поле GF(2)

Для изложения дальнейшего материала нам потребуются матрицы. А при умножении матриц, как известно мы складываем и перемножаем числа. И тут есть проблема. Если с умножением всё более-менее хорошо, то как быть со сложением? Из-за того, что мы работаем только с одиночными двоичными цифрами, непонятно, как сложить 1 и 1, чтобы снова получилась одна двоичная цифра. Значит вместо классического сложения нужно использовать какое-то другое.

Введём операцию сложения как сложение по модулю 2 (хорошо известный программистам XOR):

Умножение будем выполнять как обычно. Эти операции на самом деле введены не абы как, а чтобы получилась система, которая в математике называется полем. Поле — это просто множество (в нашем случае из 0 и 1), на котором так определены сложение и умножение, чтобы основные алгебраические законы сохранялись. Например, чтобы основные идеи, касающиеся матриц и систем уравнений по-прежнему были верны. А вычитание и деление мы можем ввести как обратные операции.

Множество из двух элементов с операциями, введёнными так, как мы это сделали, называется полем Галуа GF(2). GF — это Galois field, а 2 — количество элементов.

У сложения есть несколько очень полезных свойств, которыми мы будем пользоваться в дальнейшем.

Это свойство прямо следует из определения.

А в этом можно убедиться, прибавив к обеим частям равенства. Это свойство, в частности означает, что мы можем переносить в уравнении слагаемые в другую сторону без смены знака.

Проверяем корректность

Вернёмся к коду с утроением.

Для начала просто решим задачу проверки, были ли вообще ошибки при передаче. Как видно, из самого кода, принятое сообщение будет кодовым словом только тогда, когда все три цифры равны между собой.

Пусть мы приняли вектор-строку из трёх цифр. (Стрелочки над векторами рисовать не будем, так как у нас почти всё — это вектора или матрицы.)

Математически равенство всех трёх цифр можно записать как систему:

Или, если воспользоваться свойствами сложения в GF(2), получаем

Или

В матричном виде эта система будет иметь вид

где

Транспонирование здесь нужно потому, что — это вектор-строка, а не вектор-столбец. Иначе мы не могли бы умножать его справа на матрицу.

Будем называть матрицу проверочной матрицей. Если полученное сообщение — это корректное кодовое слово (то есть, ошибки при передаче не было), то произведение проверочной матрицы на это сообщение будет равно нулевому вектору.

Умножение на матрицу — это гораздо более эффективно, чем поиск в таблице, но у нас на самом деле есть ещё одна таблица — это таблица кодирования. Попробуем от неё избавиться.

Кодирование

Итак, у нас есть система для проверки

Её решения — это кодовые слова. Собственно, мы систему и строили на основе кодовых слов. Попробуем теперь решить обратную задачу. По системе (или, что то же самое, по матрице ) найдём кодовые слова.

Правда, для нашей системы мы уже знаем ответ, поэтому, чтобы было интересно, возьмём другую матрицу:

Соответствующая система имеет вид:

Чтобы найти кодовые слова соответствующего кода нужно её решить.

В силу линейности сумма двух решений системы тоже будет решением системы. Это легко доказать. Если и

— решения системы, то для их суммы верно

что означает, что она тоже — решение.

Поэтому если мы найдём все линейно независимые решения, то с их помощью можно получить вообще все решения системы. Для этого просто нужно найти их всевозможные суммы.

Выразим сперва все зависимые слагаемые. Их столько же, сколько и уравнений. Выражать надо так, чтобы справа были только независимые. Проще всего выразить .

Если бы нам не так повезло с системой, то нужно было бы складывая уравнения между собой получить такую систему, чтобы какие-то три переменные встречались по одному разу. Ну, или воспользоваться методом Гаусса. Для GF(2) он тоже работает.

Итак, получаем:

Чтобы получить все линейно независимые решения, приравниваем каждую из зависимых переменных к единице по очереди.

Всевозможные суммы этих независимых решений (а именно они и будут кодовыми векторами) можно получить так:

где равны либо нулю или единице. Так как таких коэффициентов два, то всего возможно

сочетания.

Но посмотрите! Формула, которую мы только что получили — это же снова умножение матрицы на вектор.

Строчки здесь — линейно независимые решения, которые мы получили. Матрица называется порождающей. Теперь вместо того, чтобы сами составлять таблицу кодирования, мы можем получать кодовые слова простым умножением на матрицу:

Найдём кодовые слова для этого кода. (Не забываем, что длина исходных сообщений должна быть равна 2 — это количество найденных решений.)

Итак, у нас есть готовый код, обнаруживающий ошибки. Проверим его в деле. Пусть мы хотим отправить 01 и у нас произошла ошибка при передаче. Обнаружит ли её код?

А раз в результате не нулевой вектор, значит код заподозрил неладное. Провести его не удалось. Ура, код работает!

Для кода с утроением, кстати, порождающая матрица выглядит очень просто:

Подобные коды, которые можно порождать и проверять матрицей называются линейными (бывают и нелинейные), и они очень широко применяются на практике. Реализовать их довольно легко, так как тут требуется только умножение на константную матрицу.

Ошибка по синдрому

Ну хорошо, мы построили код обнаруживающий ошибки. Но мы же хотим их исправлять!

Для начала введём такое понятие, как вектор ошибки. Это вектор, на который отличается принятое сообщение от кодового слова. Пусть мы получили сообщение , а было отправлено кодовое слово

. Тогда вектор ошибки по определению

Но в странном мире GF(2), где сложение и вычитание одинаковы, будут верны и соотношения:

В силу особенностей сложения, как читатель сам может легко убедиться, в векторе ошибки на позициях, где произошла ошибка будет единица, а на остальных ноль.

Как мы уже говорили раньше, если мы получили сообщение с ошибкой, то

. Но ведь векторов, не равных нулю много! Быть может то, какой именно ненулевой вектор мы получили, подскажет нам характер ошибки?

Назовём результат умножения на проверочную матрицу синдромом:

И заметим следующее

Это означает, что для ошибки синдром будет таким же, как и для полученного сообщения.

Разложим все возможные сообщения, которые мы можем получить из канала связи, по кучкам в зависимости от синдрома. Тогда из последнего соотношения следует, что в каждой кучке будут вектора с одной и той же ошибкой. Причём вектор этой ошибки тоже будет в кучке. Вот только как его узнать?

А очень просто! Помните, мы говорили, что у нескольких ошибок вероятность ниже, чем у одной ошибки? Руководствуясь этим соображением, наиболее правдоподобным будет считать вектором ошибки тот вектор, у которого меньше всего единиц. Будем называть его лидером.

Давайте посмотрим, какие синдромы дают всевозможные 5-элементные векторы. Сразу сгруппируем их и подчеркнём лидеров — векторы с наименьшим числом единиц.

В принципе, для корректирования ошибки достаточно было бы хранить таблицу соответствия синдрома лидеру.

Обратите внимание, что в некоторых строчках два лидера. Это значит для для данного синдрома два паттерна ошибки равновероятны. Иными словами, код обнаружил две ошибки, но исправить их не может.

Лидеры для всех возможных одиночных ошибок находятся в отдельных строках, а значит код может исправить любую одиночную ошибку. Ну, что же… Попробуем в этом убедиться.

Вектор ошибки равен , а значит ошибка в третьем разряде. Как мы и загадали.

Ура, всё работает!

Что же дальше?

Чтобы попрактиковаться, попробуйте повторить рассуждения для разных проверочных матриц. Например, для кода с утроением.

Логическим продолжением изложенного был бы рассказ о циклических кодах — чрезвычайно интересном подклассе линейных кодов, обладающим замечательными свойствами. Но тогда, боюсь, статья уж очень бы разрослась.

Если вас заинтересовали подробности, то можете почитать замечательную книжку Аршинова и Садовского «Коды и математика». Там изложено гораздо больше, чем представлено в этой статье. Если интересует математика кодирования — то поищите «Теория и практика кодов, контролирующих ошибки» Блейхута. А вообще, материалов по этой теме довольно много.

Надеюсь, когда снова будет свободное время, напишу продолжение, в котором расскажу про циклические коды и покажу пример программы для кодирования и декодирования. Если, конечно, почтенной публике это интересно.

Лекция №

.

Линейные коды.

Самый

большой класс разделимых блочных кодов

составляют систематические

или линейные коды.

k

r

-

a1

a2

a3

ai

…

ak

b1

b2

bi

br

n

Линейными

называются коды, в которых проверочные

символы представляют собой линейные

комбинации информационных символов.

Для

двоичных кодов в качестве линейной

операции используются сложение по mod

2.

bj

=

ai

(основаны

на применении мат. аппарата алгебры

Жегалкина (

Основное

свойство линейного кода:

сумма(разность) кодовых комбинаций

является также разрешённой кодовой

комбинацией.

Пример:

[

] — разрешённая

[ ] — разрешённая

=

[ ] — разрешённая

Отсюда

– сумма(разность) произвольного числа

разрешённых кодовых комбинаций является

разрешённой

кодовой комбинацией.

Линейные

коды образуют алгебраическую группу

по отношению к операции сложения

по mod 2.

В этом

смысле они являются групповыми

кодами.

Свойство

группового кода:

(dmin)

Минимальное

кодовое расстояние

между векторами линейного кода равно

линейному

весу ненулевых кодовых векторов.

Для

построения групповых кодов (т.е. перехода

от информационных разрядов к полному

кодовому слову, включающему также и

проверочные разряды, целесообразно

использовать специальные матрицы: n

*

k

= (k + r) *

k/

Порождающая

матрица может быть представлена в виде

2х

матриц И(информационной) и П(проверочной)

||G|| = |[И]|

|[П]|

a11

a12

… a1k p11

p12

… p1r

Gn,k

= a21

a22

… a2k p21

p22

… p2r

k

k

……………… ………………..

ak1

ak2

… akk pk1

pk2

… pkr

k

r

n

Получение

кодовой комбинации осуществляется

путём суммирования элементов

||И||

и

параллельного суммирования строк ||П||.

1).

На практике

установлено, что в качестве информационной

матрицы ||И||

удобно

брать единичную матрицу в канонической

форме:

100…0

Iи

= 010…0

………

000…1

2).

Строчки образуют матрицы ||C||

= ||И||

||П|| представляют собой “К”

комбинаций(разрешённых) искомого кода.

Остальные комбинации кода строятся при

помощи образующей матрицы.

Пример