Ошибка базового процента

- Ошибка базового процента (другие названия: заблуждение базового процента или игнорирование базового уровня) — это ошибка в мышлении, когда сталкиваясь с общей информацией о частоте некоторого события (базовый процент) и специфической информацией об этом событии, человек имеет склонность игнорировать первое и фокусироваться на втором.

Источник: Википедия

Связанные понятия

Байесовская игра (англ. Bayesian game) или игра с неполной информацией (англ. incomplete information game) в теории игр характеризуются неполнотой информации о соперниках (их возможных стратегиях и выигрышах), при этом у игроков есть веры относительно этой неопределённости. Байесовскую игру можно преобразовать в игру полной, но несовершенной информации, если принять допущение об общем априорном распределении. В отличие от неполной информации, несовершенная информация включает знание стратегий и выигрышей…

Машина вероятности – математическая модель вычислительного устройства, в работе которого участвует некоторый случайный процесс. Различные варианты понятия «Машины вероятности» являются обобщениями понятий «автомата детерминированного», «Тьюринга машина», «автомата бесконечного». Рассматривались, например, такие понятия «машины вероятности», как: 1)Машина Тьюринга (или другой детерминированный автомат) с входом, к которому присоединен бернуллиевский датчик, выдающий символ 1 и 0 с вероятностью p и…

Парадокс мальчика и девочки также известен в теории вероятностей как «Парадокс девочки и мальчика», «Дети мистера Смита» и «Проблемы миссис Смит». Впервые задача была сформулирована в 1959 году, когда Мартин Гарднер опубликовал один из самых ранних вариантов этого парадокса в журнале Scientific American под названием «The Two Children Problem», где привёл следующую формулировку…

Ложный вызов, ложная тревога — обман или ошибочное сообщение о чрезвычайной ситуации, в результате чего возникает ненужная паника и / или вызов аварийных служб (например скорой медицинской помощи, полиции) к месту, где они не нужны. Ложные вызовы могут возникать также в результате срабатывания сигнализации в жилище, детектора дыма, аварийной сигнализации на предприятии и в теории обнаружения сигнала. Ложные тревоги отвлекают аварийные службы от истинных чрезвычайных ситуаций, которые могли бы в конечном…

Тест на следующий бит (англ. next-bit test) — тест, служащий для проверки генераторов псевдо-случайных чисел на криптостойкость. Тест гласит, что не должно существовать полиномиального алгоритма, который, зная первые k битов случайной последовательности, сможет предсказать k+1 бит с вероятностью, неравной ½.

Эффект социальной желательности (social desirability bias, SDB) — термин в социологических исследованиях, описывающий тип предвзятости в ответах респондентов, что является тенденцией опрашиваемых давать такие ответы, которые, с их точки зрения, выглядят предпочтительнее в глазах окружающих. Такая тенденция может выражается в преувеличении положительных и желательных качеств и поведения и преуменьшении негативных, нежелательных. Этот феномен создает множество проблем в исследованиях, основанных на…

Причинность по Грэнджеру (англ. Granger causality) — понятие, используемое в эконометрике (анализе временных рядов), формализующее понятие причинно-следственной связи между временными рядами. Причинность по Грэнджеру является необходимым, но не достаточным условием причинно-следственной связи.

Безопасность информационных потоков — набор требований и правил, направленных на определение того, какие информационные потоки в системе являются разрешёнными, а какие нет. Данная модель не является самостоятельной, и используется в дополнение к мандатной или дискреционной модели управления доступа.

Теорема о конце света (англ. Doomsday argument, буквально «Аргумент судного дня» — сокращённо далее DA, нет устоявшегося перевода на русский язык, обычно используют английское название или сокращение DA) — это вероятностное рассуждение, которое претендует на то, чтобы предсказывать будущее время существования человеческой расы, исходя только из оценки числа живших до сих пор людей. Исходя из предположения, что живущие сейчас люди находятся в случайном месте всей хронологии человеческой истории, велики…

Теория обнаружения сигнала (ТОС) — современный психофизический метод, учитывающий вероятностный характер обнаружения стимула, в котором наблюдатель рассматривается как активный субъект принятия решения в ситуации неопределённости. Теория обнаружения сигнала описывает сенсорный процесс как двухступенчатый: процесс отображения физической энергии стимула в интенсивность ощущения и процесс принятия решения субъектом.

Социа́льное доказа́тельство (англ. Social proof), или информационное социальное влияние (англ. informational social influence) — психологическое явление, происходящее, когда некоторые люди не могут определить предпочтительный способ поведения в сложных ситуациях. Предполагая, что окружающие лучше знакомы с ситуацией, такие люди считают их поведение предпочтительным. Это явление часто используется для сознательной манипуляции поведением других.

Лемма разветвления (англ. Forking lemma) — лемма в области криптографических исследований.

Эффект Валинса — осознаваемое ощущение физиологических изменений при актуализации эмоциональной реакции.

Системати́ческая оши́бка вы́жившего (англ. survivorship bias) — разновидность систематической ошибки отбора, когда по одной группе («выжившим») есть много данных, а по другой («погибшим») — практически нет, в результате чего исследователи пытаются искать общие черты среди «выживших» и упускают из вида, что не менее важная информация скрывается среди «погибших».

Демпстера-Шафера теория — математическая теория очевидностей (свидетельств) (), основанная на функции доверия (belief functions) и функции правдоподобия (plausible reasoning), которые используются, чтобы скомбинировать отдельные части информации (свидетельства) для вычисления вероятности события. Теория была развита Артуром П. Демпстером и Гленном Шафером.

Эффект опознаваемой жертвы — разновидность когнитивного искажения, суть которого в том, что среди людей существует тенденция оказывать более щедрую помощь отдельному индивиду (жертве), чьи затруднительные жизненные обстоятельства можно наблюдать напрямую, нежели неопределённой группе лиц с аналогичными проблемами. По подобному принципу этот эффект также наблюдается при присвоении большей меры ответственности правонарушителю, чья личность была установлена, даже если его личность не несёт никакой значимой…

Эффект интервьюера — в современной социологии все погрешности, которые связаны с влиянием интервьюера на качество получаемых от респондента данных.

Эффект спящего — психологический феномен, связанный с убеждением. Это отсроченный рост влияния сообщения, которое сопровождалось обесценивающим стимулом (например, контраргументом или получением сообщения из источника, не вызывающего доверия). Суть феномена в отсроченном разделении содержания сообщения и источника информации.

Оккамово обучение в теории вычислительного обучения является моделью алгоритмического обучения, где целью обучения является получение сжатого представления имеющихся тренировочных данных. Метод тесно связан с почти корректным обучением (ПК обучение, англ. Probably Approximately Correct learning, PAC learning), где учитель оценивает прогнозирующую способность тестового набора.

Модель бинарного выбора — применяемая в эконометрике модель зависимости бинарной переменной (принимающей всего два значения — 0 и 1) от совокупности факторов. Построение обычной линейной регрессии для таких переменных теоретически некорректно, так как условное математическое ожидание таких переменных равно вероятности того, что зависимая переменная примет значение 1, а линейная регрессия допускает и отрицательные значения и значения выше 1. Поэтому обычно используются некоторые интегральные функции…

В психологии эвристика беглости — это ментальная эвристика, в которой, если один объект обрабатывается плавнее или быстрее другого,то этот объект имеет более высокое значение в отношении рассматриваемого вопроса. Другими словами, чем более умело или изящно идея передается, тем вероятней, что её следует рассматривать серьезно, независимо от того, логична она или нет.

Субъективная вероятность — степень личной веры агента (субъекта) в возможность наступления некоторого события.

Модель отказов (англ. fault model) представляет собой инженерную модель конструкции или оборудования, которое может работать неправильно. Исходя из модели, разработчик или пользователь могут предсказать последствия конкретных отказов. Модели отказов могут быть использованы практически во всех видах инженерной деятельности.

Робастность (англ. robustness, от robust — «крепкий», «сильный», «твёрдый», «устойчивый») — свойство статистического метода, характеризующее независимость влияния на результат исследования различного рода выбросов, устойчивости к помехам. Выбросоустойчивый (робастный) метод — метод, направленный на выявление выбросов, снижение их влияния или исключение их из выборки.

Приня́тие жела́емого за действи́тельное — формирование убеждений и принятие решений в соответствии с тем, что является приятным человеку, вместо апелляции к имеющимся доказательствам, рациональности или реальности.

Эффект свидетеля, эффект постороннего, синдром Дженовезе — психологический эффект, проявляющийся в том, что люди, оказавшиеся свидетелями чрезвычайной ситуации (ДТП, преступления или других), не пытаются помочь пострадавшим. Установлено, что вероятность того, что кто-нибудь из свидетелей начнёт помогать пострадавшим, тем меньше, чем больше людей станут просто стоять и смотреть. Другими словами, каждый из очевидцев считает, что помочь пострадавшим должен не он, а кто-то другой. Наоборот, единственный…

Эвристика доступности (англ. availability heuristic) — это интуитивный процесс, в котором человек «оценивает частоту или возможность события по легкости, с которой примеры или случаи приходят на ум», т. е. легче вспоминаются. При подобной оценке человек полагается на ограниченное количество примеров или случаев. Это упрощает комплексную задачу оценки вероятности и прогнозирования значимости события до простых суждений, основанных на собственных воспоминаниях, поэтому такой процесс является необъективным…

Шкала Ликерта, или (неверно) Лайкерта (англ. Likert scale (/ˈlɪkərt/ ), шкала суммарных оценок) — психометрическая шкала, которая часто используется в опросниках и анкетных исследованиях (разработана в 1932 году Ренсисом Ликертом). При работе со шкалой испытуемый оценивает степень своего согласия или несогласия с каждым суждением, от «полностью согласен» до «полностью не согласен». Сумма оценок каждого отдельного суждения позволяет выявить установку испытуемого по какому-либо вопросу. Предполагается…

Слепота́ невнима́ния (англ. Inattentional Blindness) или Перцепти́вная слепота (англ. Perceptual blindness), также часто неточно переводится как ложная слепота) — это психологическая неспособность обращать внимание на какой-либо объект, которая не относится к проблемам со зрением и носит исключительно психологический характер. Явление также может быть определено как неспособность индивида увидеть неожиданно возникший в поле зрения раздражитель.

Случайность имеет множество применений в области науки, искусства, статистики, криптографии, игр, азартных игр, и других областях. Например, случайное распределение в рандомизированных контролируемых исследованиях помогает ученым проверять гипотезы, а также случайные и псевдослучайные числа находят применение в видео-играх, таких как видеопокер.

Подробнее: Применения случайности

Коэффициент Байеса — это байесовская альтернатива проверке статистических гипотез. Байесовское сравнение моделей — это метод выбора моделей на основе коэффициентов Байеса. Обсуждаемые модели являются статистическими моделями. Целью коэффициента Байеса является количественное выражение поддержки модели по сравнению с другой моделью, независимо от того, верны модели или нет. Техническое определение понятия «поддержка» в контексте байесовского вывода дано ниже.

Склонность к подтверждению своей точки зрения или предвзятость подтверждения (англ. confirmation bias) — тенденция человека искать и интерпретировать такую информацию или отдавать предпочтение такой информации, которая согласуется с его точкой зрения, убеждением или гипотезой.

Дифференциальная приватность — совокупность методов, которые обеспечивают максимально точные запросы в статистическую базу данных при одновременной минимизации возможности идентификации отдельных записей в ней.

Пять почему — техника, используемая для изучения причинно-следственных связей, лежащих в основе той или иной проблемы. Основной задачей техники является поиск первопричины возникновения дефекта или проблемы с помощью повторения одного вопроса — «Почему?». Каждый последующий вопрос задаётся к ответам на предыдущий вопрос. Количество «5» подобрано эмпирическим путём и считается достаточным для нахождения решения типичных проблем.

Выявленное предпочтение — предпочтение, информация о котором получена в результате наблюдения за поведением экономического агента. Концепция выявленных предпочтений — это один из методов моделирования потребительского поведения в условиях определённости, который был предложен в 1938 году американским экономистом Полом Самуэльсоном. Метод основан на том, что у агентов имеются определённые устойчивые предпочтения, в соответствии с которыми они осуществляют выбор.

Подробнее: Выявленные предпочтения

Задача о разорении игрока — задача из области теории вероятностей. Подробно рассматривалась российским математиком А. Н. Ширяевым в монографии «Вероятность».

Семплирование по Гиббсу — алгоритм для генерации выборки совместного распределения множества случайных величин. Он используется для оценки совместного распределения и для вычисления интегралов методом Монте-Карло. Этот алгоритм является частным случаем алгоритма Метрополиса-Гастингса и назван в честь физика Джозайи Гиббса.

Закон необходимого разнообразия (англ. The Law of Requisite Variety) — кибернетический закон, сформулированный Уильямом Россом Эшби и формально доказанный в работе «Введение в кибернетику».

Нулевая гипотеза — принимаемое по умолчанию предположение о том, что не существует связи между двумя наблюдаемыми событиями, феноменами. Так, нулевая гипотеза считается верной до того момента, пока нельзя доказать обратное. Опровержение нулевой гипотезы, то есть приход к заключению о том, что связь между двумя событиями, феноменами существует, — главная задача современной науки. Статистика как наука даёт чёткие условия, при наступлении которых нулевая гипотеза может быть отвергнута.

В теории информации теорема Шеннона об источнике шифрования (или теорема бесшумного шифрования) устанавливает предел максимального сжатия данных и числовое значение энтропии Шеннона.

Эффе́кт телеско́па — это понятие в когнитивной психологии, означающее временное смещение события, при котором люди воспринимают события, произошедшие недавно более отдаленными, а события, которые случились давно — более близкими. Вначале этот эффект был известен, как «обратный телескоп» (события, являющиеся новыми для определённого периода времени) и уже позже — «прямой телескоп» (события, являющиеся старыми для определённого периода времени). Между «обратным» и «прямым» телескопом существует точка…

Отношение шансов — характеристика, применяемая в математической статистике (на русском обозначается аббревиатурой «ОШ», на английском «OR» от odds ratio) для количественного описания тесноты связи признака А с признаком Б в некоторой статистической популяции.

Игровое заблуждение (англ. Ludic fallacy) — когнитивное искажение, которое выражается как злоупотребление играми и моделями для моделирования реальных ситуаций. Термин введен американским экономистом ливанского происхождения Нассимом Талебом в изданной в 2007 году книге «Чёрный лебедь. Под знаком непредсказуемости». Название ошибки происходит от латинского слова ludus — «игра».

Новостные ценности, также называемые новостными критериями, определяют охват освещения новости средствами массовой информации, а также интерес, проявляемый к новости аудиторией. Новостные ценности не универсальны и могут значительно отличаться в зависимости от культур. На Западе решения о выборе и приоритете тех или иных событий для освещения принимаются редакторами, которые, в свою очередь, опираются на опыт и интуицию. Однако исследования, проведенные Дж. Галтунг и М. Руж показали: существуют факторы…

Реактивное сопротивление — мотивационное состояние, возникающее в ситуации, когда какое-либо внешнее условие (другой человек, предложение, или правило) ограничивает свободу или создает угрозу ограничения проявлений индивида. Главная задача такого поведения — восстановление утраченной или ограниченной свободы.

«Проклятие знания» (англ. curse of knowledge) — одно из когнитивных искажений в мышлении человека (см. их список); термин, предложенный психологом Робином Хогартом для обозначения психологического феномена, заключающегося в том, что более информированным людям чрезвычайно сложно рассматривать какую-либо проблему с точки зрения менее информированных людей.

Алгоритм Петерсона — алгоритм параллельного программирования для взаимного исключения потоков исполнения кода, разработанный Гарри Петерсоном в 1981 г. Хотя изначально был сформулирован для 2-поточного случая, алгоритм может быть обобщён для произвольного количества потоков. Алгоритм условно называется программным, так как не основан на использовании специальных команд процессора для запрета прерываний, блокировки шины памяти и т. д., используются только общие переменные памяти и цикл для ожидания…

Двоичная, бинарная или дихотомическая классификация — это задача классификации элементов заданного множества в две группы (предсказание, какой из групп принадлежит каждый элемент множества) на основе правила классификации. Контекст, в котором требуется решение, имеет ли объект некоторое качественное свойство, некоторые специфичные характеристики или некоторую типичную двоичную классификацию, включает…

Фидуциальный вывод (от лат. fides: вера, доверие), как разновидность статистического вывода, был впервые предложен сэром Р. Э. Фишером.

Иногда мы больше верим догадкам и слухам, чем статистике. К примеру, вы сделали прививку и заболели, ваш знакомый тоже пожаловался на подобное и вот вы уже не доверяете прививкам, хотя по статистике риск заболевания после прививки 10-30%. Так проявляется когнитивное искажение «ошибка базового процента».

Еще пример. Вы видите мужчину в черном с татуировками, из наушников которого слышится тяжелый рок. Скорее всего вы решите, что он приехал на байке, хотя автомобилей на дорогах намного больше. Мужчина же вообще может оказаться велосипедистом.

Суть искажения в том, что мы склонны игнорировать статистику и общие данные, и полагаемся на личный опыт и частные случаи, которые нам реально встречались.

Ученые связывают эту ошибку с эвристикой репрезентативности – человеческим свойством делать выводы на основе стереотипов и личной оценки.

На это искажение могут накладываться другие – склонность к негативу, предвзятость подтверждения.

Вред этого когнитивного искажения:

- Ошибочные выводы о людях. Результаты – неспособность распознать мошенника, вхождение в плохую компанию, отказ от важного знакомства или от приглашения на работу ценного сотрудника.

- Повышение уровня тревожности. Результаты – чрезмерная мнительность, боязнь всего, постоянный стресс.

- Ошибки в важных ситуациях. Результаты – выбор сомнительных вариантов вместо надежных, недоверие к тому, что нас может защитить (пример с прививкой).

Как избежать этой когнитивной ловушки:

- Не спешить с выводами. Заметили, что дали оценку без размышлений, – остановитесь и задумайтесь. Мир не так прост.

- Избегать категоричности. Пришли к заключению – будьте гибкими, в новой ситуации перепроверьте свои выводы, возможно, вводные изменились.

- Собирайте больше данных. Составить полную картину можно только обладая максимумом информации.

- Фильтруйте информацию. Хотите получить точную оценку? Ищите не просто полные, но и достоверные данные. Выбирайте, каким источникам доверять.

- Расширяйте кругозор. Учитесь, интересуйтесь, играйте.

Больше о ловушках мышления и защите от них – в материале «Эффективные способы защиты от ловушек мышления».

Узнать больше »

Когнитивные искажения (от лат. cognitiо «познание») – это то, что касается каждого человека вне зависимости от уровня его образования и социального положения.

Наш мозг – это главный орган центральной нервной системы, загадка которого не разгадана учеными до сих пор. Он содержит около 86 миллиардов нейронов, которые регулируют всю деятельность человека.

Наверное, и неудивительно, что мозг иногда обманывает нас, так что порой кажется, что он живет отдельной жизнью.

Так это или нет – мы, возможно, узнаем в будущем, а пока давайте рассмотрим наиболее частые когнитивные искажения, или ошибки мышления, которые встречаются в жизни каждого.

Это поможет вам не только осознать причины тех или иных своих действий, но и даст понимание некоторых поступков окружающих вас людей.

Ошибки мышления

Данная статья будет интересна не только любителям психологии, но и всем, кому интересно саморазвитие.

-

Ошибка базового процента

Довольно часто мы игнорируем реальную статистику, отдавая предпочтение собственному опыту. Например, вы обратились в автосервис, который, в конечном счете, не смог починить вашу машину.

После этого ваш мозг будет считать данный сервис плохим даже несмотря на то, что вам достоверно известно о сотнях машин, которые были там полностью отремонтированы. Ничего не поделаешь, личный опыт для мозга важнее статистики.

-

Отклонение внимания

Мозгу свойственно замечать только то, что вам нравится, или что вас интересует. Например, если вы парикмахер, то новая прическа вашего коллеги будет тут же детально изучена, в то время как другие даже не обратят на нее внимание.

Если вы любите модные бренды, то любая новая сумка знакомого вызовет у вас интерес. То же самое касается и праздников. Так что если вас кто-то не поздравил, не спешите обижаться, – наверняка это было сделано не намеренно. Все дело в когнитивном искажении под названием «Отклонение внимания».

-

Феномен «Дверь в лицо»

Известный американский психолог Роберт Чалдини рассказывал, как однажды на улице к нему подошёл мальчик и предложил купить билеты на какое-то мероприятие. Один билет стоил 5 долларов.

Чалдини вежливо отказался. Тогда мальчик предложил ему купить плитки шоколада всего лишь по доллару за штуку. После того как Чалдини купил пару плиток, он осознал, что им манипулировали, так как:

- он не любит шоколад и ему нужны деньги;

- он остался с двумя ненужными ему шоколадками и без денег.

Чалдини отправился на встречу с коллегами, с которыми обсудил произошедшее. В результате совещания была разработана серия экспериментов, позже ставшая классической.

Итак, «Дверь в лицо» – это социально-психологический феномен, который заключается в том, что люди склонны идти на уступку и соглашаться с малопривлекательным предложением в том случае, если оно им предлагается сразу после их отказа от другой более тяжелой просьбы.

-

Иллюзия частоты

Мозг не замечает многие вещи, которые нас окружают до тех пор, пока они нас не заинтересуют. Например, вам нужно купить детскую коляску, и вы остановились на каком-то бренде.

Внезапно вы обнаруживаете, что колясок этого бренда начало встречаться очень много. Это иллюзия. На самом деле просто вы начали обращать на них внимание, а не они резко распространились. Таковы результаты когнитивного искажения.

-

Эффект мнимой правды

Это один из самых популярных инструментов пропаганды во всем мире. Давно известно, что если повторять ложь достаточно долго, достаточно громко и достаточно часто – люди начнут верить лжи.

Если человеку 100 раз сказать, что он свинья, то на 101раз он захрюкает.

Умельцы весьма эффективно применяют этот феномен. Приведем безобидный пример. Некто хочет, чтобы его считали умным, поэтому он, цитирует, допустим, древнегреческого философа:

– Как говорил Протагор – «Человек есть мера всех вещей».

В следующий раз он повторяет это несколько иначе:

– Как я говорил в прошлый раз, – «Человек есть мера всех вещей».

И, наконец, в третий раз он заявляет:

– Как я обычно говорю, – «Человек есть мера всех вещей».

Вроде бы все правильно, но используя это когнитивное искажение, вам навязали ложную мысль, будто автором фразы является этот Некто, который хочет, чтобы его считали умным.

-

Эффект знакомства с объектом

Пожалуй, вся реклама, существующая в мире, работает на этот эффект мышления. Дело в том, что из нескольких незнакомых объектов мы обязательно отдадим предпочтение тому, о котором знаем хотя бы что-то.

Например, вам нужен крем для рук. Придя в магазин, вы почти наверняка возьмете тот крем, о котором хотя бы раз где-то слышали (например, в рекламе), чем тот, о котором вы вообще ничего не знаете.

-

Эвристика доступности

Наверняка у многих бывали такие случаи, когда знакомый уезжал в столицу и умело там пристраивался, вследствие чего у вас формировалось убеждение, что все жители столицы – это хорошо обеспеченные люди, работающие в крутых компаниях.

Так вот эта ошибка мышления возникает потому, что наш мозг оценивает частоту или возможность события по легкости, с которой примеры или случаи приходят на ум, т. е. легче вспоминаются.

Или, например, человек оценивает степень риска возникновения инфаркта у людей среднего возраста, припоминая подобные случаи среди своих знакомых.

-

Эффект контекста

Эффект контекста используется маркетологами для того, чтобы спровоцировать вас на покупку чего-то, что вам вовсе не нужно. Именно поэтому выкладка товара в магазине делается не просто для удобства, а с обязательным использованием эффекта контекста.

Одна дама сумела чрезвычайно выгодно продать свою квартиру потому, что перед приездом покупателя она готовила ароматные сдобные булочки. Входя в свою потенциальную квартиру, клиент ощущал тепло и такой приятный домашний аромат, что мозг просто не мог не попасть в ловушку контекста.

Таким образом, при помощи этого нехитрого когнитивного искажения ловкая барышня сумела провернуть выгодную сделку.

-

Склонность к негативу

Мы подсознательно переоцениваем значение отрицательных вещей. Собственно именно по этой причине плохие новости всегда будут иметь гораздо бо́льшую аудиторию, чем хорошие.

Не случайно слова журналистки известной новостной службы «Редакция требует крови!» стали мемом и вовсе не так далеки от действительности. Редакции действительно нужно «больше крови», так как это гарантирует кратное увеличение просмотров.

-

Эффект якоря

Эффект якоря – это особенность оценки числовых значений, которая смещает оценку в сторону начального приближения.

Например, вам нужно купить пальто. Вы заходите в магазин, находите подходящую вам модель, а после примерки узнаете, что она стоит 500$. Для вас это дорого, и вы уже собираетесь уходить, как вдруг к вам подбегает консультант.

Уточнив, подошло ли вам пальто, консультант говорит, что это уникальная серия, состоящая из всего 80 экземпляров. Более того, на эту модель сегодня действует скидка «Минус 50%».

Именно здесь и срабатывает эффект якоря, роль которого в данном случае играет число 500. С большой долей вероятности клиент в такой ситуации совершит покупку, даже не задумываясь о том, что для такого пальто даже 250$ – большая цена.

Интересен факт, что эффект якоря работает вне зависимости от того, знаете вы о нем, или нет. То же самое наблюдается и с правилом взаимного обмена.

-

Эффект фрейминга

Эффект фрейминга (от англ. frame рамка, обрамление) – это когнитивное искажение, при котором форма подачи информации влияет на ее восприятие человеком.

В качестве классического примера данного эффекта нередко приводят выражение: «Стакан наполовину пуст или наполовину полон». Речь идет об одном и том же явлении, но отношение к нему из-за подачи информации меняется.

В одном из экспериментов участникам показывали видеозаписи с автомобильными авариями. После этого им задавали вопрос: «С какой скоростью ехали машины, когда столкнулись друг с другом?».

В каждой группе вопросы немного отличались: глагол «столкнулись» заменялся на «врезались», «налетели», «задели», «ударились».

В результате было установлено, что изменения в постановке вопроса оказывали влияние на оценку скорости автомобилей, несмотря на то, что всем респондентам показывали один и тот же ролик.

-

Восприятие выбора

Замечено, что сначала мы делаем выбор, а потом мозг пытается его оправдать. Причем чем бессмысленнее выбор, тем больше мы его защищаем.

В качестве примера можно привести попытки найти неявные плюсы в покупке и тем самым её оправдать при наличии другого, более подходящего товара, который по каким-то причинам не был приобретён.

К слову сказать, именно по этому принципу работают деструктивные секты и различные финансовые пирамиды. В какой-то степени этот эффект похож на стокгольмский синдром, когда жертва оправдывает агрессора. Кстати, мы уже рассказывали про 10 необычных психических синдромов в отдельной статье.

-

Предпочтение нулевого риска

Это предпочтение контролируемой, но потенциально более вредоносной (вследствие более частого её возникновения) ситуации перед обратной.

Происходит это по причине переоценки возможности контроля. То есть человек со своей стороны считает, что он полностью избавляется от риска (на самом деле не имея полного контроля), в то время как со стороны статистики это является снижением до нуля лишь одного, причем не самого большого риска.

Например, большинство людей предпочли бы уменьшить вероятность терактов до нуля вместо снижения аварийности на дорогах, даже несмотря на то, что второй эффект давал бы гораздо больше сохранённых жизней.

Или другой пример – ятрофобия (боязнь врачей). Многие люди боятся осложнений медицинских вмешательств больше, чем заболевания и смерти в результате самих этих заболеваний, которые возникают из-за отсутствия лечения.

-

Эффект морального доверия

Человек, относительно которого известно, что у него нет предубеждений, имеет в будущем большие шансы проявить эти предубеждения.

Иными словами, если все (в том числе и он сам) считают человека безгрешным, то возникает иллюзия, что любое его действие также будет безгрешным.

-

Селективное восприятие

Селективное восприятие (лат. selectio «выбирать») – это склонность людей уделять внимание тем элементам окружения, которые согласуются с их ожиданиями, и игнорировать остальные.

В классическом эксперименте зрители просматривали видео особо ожесточённого матча по американскому футболу между Принстонским университетом и Дартмутским колледжем.

Зрители из Принстона заметили почти в два раза больше нарушений, совершённых дартмутской командой, чем зрители из Дартмута. Один зритель из Дартмута вовсе не заметил ни одного нарушения со стороны «своей» команды.

Это когнитивное искажение также играет огромную роль в психологии рекламы.

-

Слепое пятно в отношении искажений

Последняя ошибка мышления, или когнитивное искажение, которое мы рассмотрим, – это слепое пятно в отношении искажений.

Это не что иное, как более лёгкое обнаружение недостатков у других людей, нежели у себя. То есть, все перечисленные когнитивные искажения присутствуют у каждого человека, однако мы «в чужом глазу видим соринку, а в своём и бревна не замечаем».

Наверняка и после прочтения этой статьи у большинства зрителей появится ощущение, что я, дескать, знаю все это и так, и, конечно же, меня все эти когнитивные искажения не касаются. На самом же деле они касаются всех.

Но теперь возникает закономерный вопрос: что же делать со всеми этими ошибками? Ответ прост: перечитывайте статью и вникайте в суть перечисленных когнитивных искажений или ошибок мышления.

Чем больше вы будете осознавать факт существования когнитивных искажений, тем больше вероятность, что вы будете принимать правильные решения и делать верный выбор.

Теперь вы знаете, что такое когнитивные искажения и как они влияют на нашу жизнь. Если вам понравилась статья, – поделитесь ею с друзьями и подписывайтесь на сайт interesnyefakty.org. С нами всегда интересно!

Понравился пост? Нажми любую кнопку:

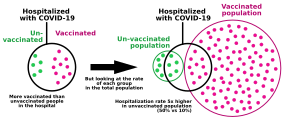

A hospital receiving more vaccinated covid patients than unvaccinated ones might suggest that the vaccine is ineffective, but such an imbalance is to be expected within a highly vaccinated population[1]

The base rate fallacy, also called base rate neglect[2] or base rate bias, is a type of fallacy in which people tend to ignore the base rate (e.g., general prevalence) in favor of the individuating information (i.e., information pertaining only to a specific case).[3]

Base rate neglect is a specific form of the more general extension neglect.

It is also called prosecutor’s fallacy or defense attorney’s fallacy when applied to the results of statistical tests (such as DNA tests) in the context of law proceedings. In this form, the term was introduced by William C. Thompson and Edward Schumann in 1987.[4][5]

False positive paradox[edit]

An example of the base rate fallacy is the false positive paradox (also known as accuracy paradox). This paradox describes situations where there are more false positive test results than true positives. For example, if a facial recognition camera can identify wanted criminals 99% accurately, but analyzes 10,000 people a day, the high accuracy is outweighed by the number of tests, and the program’s list of criminals will likely have far more false positives than true. The probability of a positive test result is determined not only by the accuracy of the test but also by the characteristics of the sampled population.[6] When the prevalence, the proportion of those who have a given condition, is lower than the test’s false positive rate, even tests that have a very low risk of giving a false positive in an individual case will give more false than true positives overall.[7] The paradox surprises most people.[8]

It is especially counter-intuitive when interpreting a positive result in a test on a low-prevalence population after having dealt with positive results drawn from a high-prevalence population.[7] If the false positive rate of the test is higher than the proportion of the new population with the condition, then a test administrator whose experience has been drawn from testing in a high-prevalence population may conclude from experience that a positive test result usually indicates a positive subject, when in fact a false positive is far more likely to have occurred.

Examples[edit]

Example 1: Disease[edit]

High-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

400 (true positive) |

30 (false positive) |

430 |

| Test negative |

0 (false negative) |

570 (true negative) |

570 |

| Total | 400 | 600 | 1000 |

Imagine running an infectious disease test on a population A of 1000 persons, of which 40% are infected. The test has a false positive rate of 5% (0.05) and no false negative rate. The expected outcome of the 1000 tests on population A would be:

- Infected and test indicates disease (true positive)

- 1000 × 40/100 = 400 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 40/100 × 0.05 = 30 people would receive a false positive

- The remaining 570 tests are correctly negative.

So, in population A, a person receiving a positive test could be over 93% confident (400/30 + 400) that it correctly indicates infection.

Low-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

20 (true positive) |

49 (false positive) |

69 |

| Test negative |

0 (false negative) |

931 (true negative) |

931 |

| Total | 20 | 980 | 1000 |

Now consider the same test applied to population B, of which only 2% are infected. The expected outcome of 1000 tests on population B would be:

- Infected and test indicates disease (true positive)

- 1000 × 2/100 = 20 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 2/100 × 0.05 = 49 people would receive a false positive

- The remaining 931 tests are correctly negative.

In population B, only 20 of the 69 total people with a positive test result are actually infected. So, the probability of actually being infected after one is told that one is infected is only 29% (20/20 + 49) for a test that otherwise appears to be «95% accurate».

A tester with experience of group A might find it a paradox that in group B, a result that had usually correctly indicated infection is now usually a false positive. The confusion of the posterior probability of infection with the prior probability of receiving a false positive is a natural error after receiving a health-threatening test result.

Example 2: Drunk drivers[edit]

- A group of police officers have breathalyzers displaying false drunkenness in 5% of the cases in which the driver is sober. However, the breathalyzers never fail to detect a truly drunk person. One in a thousand drivers is driving drunk. Suppose the police officers then stop a driver at random to administer a breathalyzer test. It indicates that the driver is drunk. We assume you do not know anything else about them. How high is the probability they really are drunk?

Many would answer as high as 95%, but the correct probability is about 2%.

An explanation for this is as follows: on average, for every 1,000 drivers tested,

- 1 driver is drunk, and it is 100% certain that for that driver there is a true positive test result, so there is 1 true positive test result

- 999 drivers are not drunk, and among those drivers there are 5% false positive test results, so there are 49.95 false positive test results

Therefore, the probability that one of the drivers among the 1 + 49.95 = 50.95 positive test results really is drunk is

The validity of this result does, however, hinge on the validity of the initial assumption that the police officer stopped the driver truly at random, and not because of bad driving. If that or another non-arbitrary reason for stopping the driver was present, then the calculation also involves the probability of a drunk driver driving competently and a non-drunk driver driving (in-)competently.

More formally, the same probability of roughly 0.02 can be established using Bayes’s theorem. The goal is to find the probability that the driver is drunk given that the breathalyzer indicated they are drunk, which can be represented as

where D means that the breathalyzer indicates that the driver is drunk. Bayes’s theorem tells us that

We were told the following in the first paragraph:

and

As you can see from the formula, one needs p(D) for Bayes’ theorem, which one can compute from the preceding values using the law of total probability:

which gives

Plugging these numbers into Bayes’ theorem, one finds that

Example 3: Terrorist identification[edit]

In a city of 1 million inhabitants, let there be 100 terrorists and 999,900 non-terrorists. To simplify the example, it is assumed that all people present in the city are inhabitants. Thus, the base rate probability of a randomly selected inhabitant of the city being a terrorist is 0.0001, and the base rate probability of that same inhabitant being a non-terrorist is 0.9999. In an attempt to catch the terrorists, the city installs an alarm system with a surveillance camera and automatic facial recognition software.

The software has two failure rates of 1%:

- The false negative rate: If the camera scans a terrorist, a bell will ring 99% of the time, and it will fail to ring 1% of the time.

- The false positive rate: If the camera scans a non-terrorist, a bell will not ring 99% of the time, but it will ring 1% of the time.

Suppose now that an inhabitant triggers the alarm. What is the probability that the person is a terrorist? In other words, what is P(T | B), the probability that a terrorist has been detected given the ringing of the bell? Someone making the ‘base rate fallacy’ would infer that there is a 99% probability that the detected person is a terrorist. Although the inference seems to make sense, it is actually bad reasoning, and a calculation below will show that the probability of a terrorist is actually near 1%, not near 99%.

The fallacy arises from confusing the natures of two different failure rates. The ‘number of non-bells per 100 terrorists’ and the ‘number of non-terrorists per 100 bells’ are unrelated quantities. One does not necessarily equal the other, and they don’t even have to be almost equal. To show this, consider what happens if an identical alarm system were set up in a second city with no terrorists at all. As in the first city, the alarm sounds for 1 out of every 100 non-terrorist inhabitants detected, but unlike in the first city, the alarm never sounds for a terrorist. Therefore, 100% of all occasions of the alarm sounding are for non-terrorists, but a false negative rate cannot even be calculated. The ‘number of non-terrorists per 100 bells’ in that city is 100, yet P(T | B) = 0%. There is zero chance that a terrorist has been detected given the ringing of the bell.

Imagine that the first city’s entire population of one million people pass in front of the camera. About 99 of the 100 terrorists will trigger the alarm—and so will about 9,999 of the 999,900 non-terrorists. Therefore, about 10,098 people will trigger the alarm, among which about 99 will be terrorists. The probability that a person triggering the alarm actually is a terrorist is only about 99 in 10,098, which is less than 1%, and very, very far below our initial guess of 99%.

The base rate fallacy is so misleading in this example because there are many more non-terrorists than terrorists, and the number of false positives (non-terrorists scanned as terrorists) is so much larger than the true positives (terrorists scanned as terrorists).

Multiple practitioners have argued that as the base rate of terrorism is extremely low, using data mining and predictive algorithms to identify terrorists cannot feasibly work due to the false positive paradox.[9][10][11][12] Estimates of the number of false positives for each accurate result vary from over ten thousand[12] to one billion;[10] consequently, investigating each lead would be cost and time prohibitive.[9][11] The level of accuracy required to make these models viable is likely unachievable. Foremost the low base rate of terrorism also means there is a lack of data with which to make an accurate algorithm.[11] Further, in the context of detecting terrorism false negatives are highly undesirable and thus must be minimised as much as possible, however this requires increasing sensitivity at the cost of specificity, increasing false positives.[12] It is also questionable whether the use of such models by law enforcement would meet the requisite burden of proof given that over 99% of results would be false positives.[12]

Example 4: biological testing of a suspect[edit]

A crime is committed. Forensic analysis determines that the perpetrator has a certain blood type shared by 10% of the population. A suspect is arrested, and found to have that same blood type.

A prosecutor might charge the suspect with the crime on that basis alone, and claim at trial that the probability that the defendant is guilty is 90%. However, this conclusion is only close to correct if the defendant was selected as the main suspect based on robust evidence discovered prior to the blood test and unrelated to it. Otherwise, the reasoning presented is flawed, as it overlooks the high prior probability (that is, prior to the blood test) that he is a random innocent person. Assume, for instance, that 1000 people live in the town where the crime occurred. This means that 100 people live there who have the perpetrator’s blood type, of whom only one is the true author; therefore, the true probability that the defendant is guilty – based only on the fact that his blood type matches that of the killer – is only 1%, far less than the 90% argued by the prosecutor.

The prosecutor’s fallacy involves assuming that the prior probability of a random match is equal to the probability that the defendant is innocent. When using it, a prosecutor questioning an expert witness may ask: «The odds of finding this evidence on an innocent man are so small that the jury can safely disregard the possibility that this defendant is innocent, correct?»[13] The claim assumes that the probability that evidence is found on an innocent man is the same as the probability that a man is innocent given that evidence was found on him, which is not true. Whilst the former is usually small (10% in the previous example) due to good forensic evidence procedures, the latter (99% in that example) does not directly relate to it and will often be much higher, since, in fact, it depends on the likely quite high prior odds of the defendant being a random innocent person.

Examples in law[edit]

OJ Simpson trial[edit]

O. J. Simpson was tried and acquitted in 1995 for the murders of his ex-wife Nicole Brown Simpson and her friend Ronald Goldman.

Crime scene blood matched Simpson’s with characteristics shared by 1 in 400 people. However, the defense argued that a football stadium could be filled with Angelenos matching the sample and that the figure of 1 in 400 was useless.[14][15] It would have been incorrect, and an example of prosecutor’s fallacy, to rely solely on the «1 in 400» figure to deduce that a given person matching the sample would be likely to be the culprit.

In the same trial, the prosecution presented evidence that Simpson had been violent toward his wife. The defense argued that there was only one woman murdered for every 2500 women who were subjected to spousal abuse, and that any history of Simpson being violent toward his wife was irrelevant to the trial. However, the reasoning behind the defense’s calculation was fallacious. According to author Gerd Gigerenzer, the correct probability requires additional context: Simpson’s wife had not only been subjected to domestic violence, but rather subjected to domestic violence (by Simpson) and killed (by someone). Gigerenzer writes «the chances that a batterer actually murdered his partner, given that she has been killed, is about 8 in 9 or approximately 90%».[16] While most cases of spousal abuse do not end in murder, most cases of murder where there is a history of spousal abuse were committed by the spouse.

Sally Clark case[edit]

Sally Clark, a British woman, was accused in 1998 of having killed her first child at 11 weeks of age and then her second child at 8 weeks of age. The prosecution had expert witness Sir Roy Meadow, a professor and consultant paediatrician,[17] testify that the probability of two children in the same family dying from SIDS is about 1 in 73 million. That was much less frequent than the actual rate measured in historical data – Meadow estimated it from single-SIDS death data, and the assumption that the probability of such deaths should be uncorrelated between infants.[18]

Meadow acknowledged that 1-in-73 million is not an impossibility, but argued that such accidents would happen «once every hundred years» and that, in a country of 15 million 2-child families, it is vastly more likely that the double-deaths are due to Münchausen syndrome by proxy than to such a rare accident. However, there is good reason to suppose that the likelihood of a death from SIDS in a family is significantly greater if a previous child has already died in these circumstances (a genetic predisposition to SIDS is likely to invalidate that assumed statistical independence[19]) making some families more susceptible to SIDS and the error an outcome of the ecological fallacy.[20] The likelihood of two SIDS deaths in the same family cannot be soundly estimated by squaring the likelihood of a single such death in all otherwise similar families.[21]

1-in-73 million greatly underestimated the chance of two successive accidents, but, even if that assessment were accurate, the court seems to have missed the fact that the 1-in-73 million number meant nothing on its own. As an a priori probability, it should have been weighed against the a priori probabilities of the alternatives. Given that two deaths had occurred, one of the following explanations must be true, and all of them are a priori extremely improbable:

- Two successive deaths in the same family, both by SIDS

- Double homicide (the prosecution’s case)

- Other possibilities (including one homicide and one case of SIDS)

It is unclear whether an estimate of the probability for the second possibility was ever proposed during the trial, or whether the comparison of the first two probabilities was understood to be the key estimate to make in the statistical analysis assessing the prosecution’s case against the case for innocence.

Clark was convicted in 1999, resulting in a press release by the Royal Statistical Society which pointed out the mistakes.[22]

In 2002, Ray Hill (Mathematics professor at Salford) attempted to accurately compare the chances of these two possible explanations; he concluded that successive accidents are between 4.5 and 9 times more likely than are successive murders, so that the a priori odds of Clark’s guilt were between 4.5 to 1 and 9 to 1 against.[23]

After the court found that the forensic pathologist who had examined both babies had withheld exculpatory evidence, a higher court later quashed Clark’s conviction, on 29 January 2003.[24]

Findings in psychology[edit]

In experiments, people have been found to prefer individuating information over general information when the former is available.[25][26][27]

In some experiments, students were asked to estimate the grade point averages (GPAs) of hypothetical students. When given relevant statistics about GPA distribution, students tended to ignore them if given descriptive information about the particular student even if the new descriptive information was obviously of little or no relevance to school performance.[26] This finding has been used to argue that interviews are an unnecessary part of the college admissions process because interviewers are unable to pick successful candidates better than basic statistics.

Psychologists Daniel Kahneman and Amos Tversky attempted to explain this finding in terms of a simple rule or «heuristic» called representativeness. They argued that many judgments relating to likelihood, or to cause and effect, are based on how representative one thing is of another, or of a category.[26] Kahneman considers base rate neglect to be a specific form of extension neglect.[28] Richard Nisbett has argued that some attributional biases like the fundamental attribution error are instances of the base rate fallacy: people do not use the «consensus information» (the «base rate») about how others behaved in similar situations and instead prefer simpler dispositional attributions.[29]

There is considerable debate in psychology on the conditions under which people do or do not appreciate base rate information.[30][31] Researchers in the heuristics-and-biases program have stressed empirical findings showing that people tend to ignore base rates and make inferences that violate certain norms of probabilistic reasoning, such as Bayes’ theorem. The conclusion drawn from this line of research was that human probabilistic thinking is fundamentally flawed and error-prone.[32] Other researchers have emphasized the link between cognitive processes and information formats, arguing that such conclusions are not generally warranted.[33][34]

Consider again Example 2 from above. The required inference is to estimate the (posterior) probability that a (randomly picked) driver is drunk, given that the breathalyzer test is positive. Formally, this probability can be calculated using Bayes’ theorem, as shown above. However, there are different ways of presenting the relevant information. Consider the following, formally equivalent variant of the problem:

- 1 out of 1000 drivers are driving drunk. The breathalyzers never fail to detect a truly drunk person. For 50 out of the 999 drivers who are not drunk the breathalyzer falsely displays drunkenness. Suppose the policemen then stop a driver at random, and force them to take a breathalyzer test. It indicates that they are drunk. We assume you don’t know anything else about them. How high is the probability they really are drunk?

In this case, the relevant numerical information—p(drunk), p(D | drunk), p(D | sober)—is presented in terms of natural frequencies with respect to a certain reference class (see reference class problem). Empirical studies show that people’s inferences correspond more closely to Bayes’ rule when information is presented this way, helping to overcome base-rate neglect in laypeople[34] and experts.[35] As a consequence, organizations like the Cochrane Collaboration recommend using this kind of format for communicating health statistics.[36] Teaching people to translate these kinds of Bayesian reasoning problems into natural frequency formats is more effective than merely teaching them to plug probabilities (or percentages) into Bayes’ theorem.[37] It has also been shown that graphical representations of natural frequencies (e.g., icon arrays, hypothetical outcome plots) help people to make better inferences.[37][38][39][40]

Why are natural frequency formats helpful? One important reason is that this information format facilitates the required inference because it simplifies the necessary calculations. This can be seen when using an alternative way of computing the required probability p(drunk|D):

where N(drunk ∩ D) denotes the number of drivers that are drunk and get a positive breathalyzer result, and N(D) denotes the total number of cases with a positive breathalyzer result. The equivalence of this equation to the above one follows from the axioms of probability theory, according to which N(drunk ∩ D) = N × p (D | drunk) × p (drunk). Importantly, although this equation is formally equivalent to Bayes’ rule, it is not psychologically equivalent. Using natural frequencies simplifies the inference because the required mathematical operation can be performed on natural numbers, instead of normalized fractions (i.e., probabilities), because it makes the high number of false positives more transparent, and because natural frequencies exhibit a «nested-set structure».[41][42]

Not every frequency format facilitates Bayesian reasoning.[42][43] Natural frequencies refer to frequency information that results from natural sampling,[44] which preserves base rate information (e.g., number of drunken drivers when taking a random sample of drivers). This is different from systematic sampling, in which base rates are fixed a priori (e.g., in scientific experiments). In the latter case it is not possible to infer the posterior probability p (drunk | positive test) from comparing the number of drivers who are drunk and test positive compared to the total number of people who get a positive breathalyzer result, because base rate information is not preserved and must be explicitly re-introduced using Bayes’ theorem.

See also[edit]

- Base rate

- Bayesian probability

- Bayes’ theorem

- Data dredging

- Evidence under Bayes’ theorem

- Inductive argument

- List of cognitive biases

- List of paradoxes

- Misleading vividness

- Prevention paradox

- Prosecutor’s fallacy, a mistake in reasoning that involves ignoring a low prior probability

- Simpson’s paradox, another error in statistical reasoning dealing with comparing groups

- Stereotype

- Intuitive statistics

References[edit]

- ^ «COVID-19 Cases, Hospitalizations, and Deaths by Vaccination Status» (PDF). Washington State Department of Health. 2023-01-18. Archived (PDF) from the original on 2023-01-26. Retrieved 2023-02-14.

If the exposure to COVID-19 stays the same, as more individuals are vaccinated, more cases, hospitalizations, and deaths will be in vaccinated individuals, as they will continue to make up more and more of the population. For example, if 100% of the population was vaccinated, 100% of cases would be among vaccinated people.

- ^ Welsh, Matthew B.; Navarro, Daniel J. (2012). «Seeing is believing: Priors, trust, and base rate neglect». Organizational Behavior and Human Decision Processes. 119 (1): 1–14. doi:10.1016/j.obhdp.2012.04.001. hdl:2440/41190. ISSN 0749-5978.

- ^ «Logical Fallacy: The Base Rate Fallacy». Fallacyfiles.org. Retrieved 2013-06-15.

- ^ Thompson, W.C.; Shumann, E.L. (1987). «Interpretation of Statistical Evidence in Criminal Trials: The Prosecutor’s Fallacy and the Defense Attorney’s Fallacy». Law and Human Behavior. 2 (3): 167. doi:10.1007/BF01044641. JSTOR 1393631. S2CID 147472915.

- ^ Fountain, John; Gunby, Philip (February 2010). «Ambiguity, the Certainty Illusion, and Gigerenzer’s Natural Frequency Approach to Reasoning with Inverse Probabilities» (PDF). University of Canterbury. p. 6.[permanent dead link]

- ^ Rheinfurth, M. H.; Howell, L. W. (March 1998). Probability and Statistics in Aerospace Engineering. NASA. p. 16.

MESSAGE: False positive tests are more probable than true positive tests when the overall population has a low prevalence of the disease. This is called the false-positive paradox.

- ^ a b Vacher, H. L. (May 2003). «Quantitative literacy — drug testing, cancer screening, and the identification of igneous rocks». Journal of Geoscience Education: 2.

At first glance, this seems perverse: the less the students as a whole use steroids, the more likely a student identified as a user will be a non-user. This has been called the False Positive Paradox

— Citing: Gonick, L.; Smith, W. (1993). The cartoon guide to statistics. New York: Harper Collins. p. 49. - ^ Madison, B. L. (August 2007). «Mathematical Proficiency for Citizenship». In Schoenfeld, A. H. (ed.). Assessing Mathematical Proficiency. Mathematical Sciences Research Institute Publications (New ed.). Cambridge University Press. p. 122. ISBN 978-0-521-69766-8.

The correct [probability estimate…] is surprising to many; hence, the term paradox.

- ^ a b Munk, Timme Bisgaard (1 September 2017). «100,000 false positives for every real terrorist: Why anti-terror algorithms don’t work». First Monday. 22 (9). doi:10.5210/fm.v22i9.7126.

- ^ a b Schneier, Bruce. «Why Data Mining Won’t Stop Terror». Wired. ISSN 1059-1028. Retrieved 2022-08-30.

- ^ a b c Jonas, Jeff; Harper, Jim (2006-12-11). «Effective Counterterrorism and the Limited Role of Predictive Data Mining». CATO Institute. Retrieved 2022-08-30.

- ^ a b c d Sageman, Marc (2021-02-17). «The Implication of Terrorism’s Extremely Low Base Rate». Terrorism and Political Violence. 33 (2): 302–311. doi:10.1080/09546553.2021.1880226. ISSN 0954-6553. S2CID 232341781.

- ^ Fenton, Norman; Neil, Martin; Berger, Daniel (June 2016). «Bayes and the Law». Annual Review of Statistics and Its Application. 3 (1): 51–77. Bibcode:2016AnRSA…3…51F. doi:10.1146/annurev-statistics-041715-033428. PMC 4934658. PMID 27398389.

- ^ Robertson, B., & Vignaux, G. A. (1995). Interpreting evidence: Evaluating forensic evidence in the courtroom. Chichester: John Wiley and Sons.

- ^ Rossmo, D. Kim (2009). Criminal Investigative Failures. CRC Press Taylor & Francis Group.

- ^ Gigerenzer, G., Reckoning with Risk: Learning to Live with Uncertainty, Penguin, (2003)

- ^ «Resolution adopted by the Senate (21 October 1998) on the retirement of Professor Sir Roy Meadow». Reporter. No. 428. University of Leeds. 30 November 1998. Archived from the original on 2016-04-16. Retrieved 2015-10-17.

- ^ The population-wide probability of a SIDS fatality was about 1 in 1,303; Meadow generated his 1-in-73 million estimate from the lesser probability of SIDS death in the Clark household, which had lower risk factors (e.g. non-smoking). In this sub-population he estimated the probability of a single death at 1 in 8,500. See: Joyce, H. (September 2002). «Beyond reasonable doubt» (pdf). plus.maths.org. Retrieved 2010-06-12.. Professor Ray Hill questioned even this first step (1/8,500 vs 1/1,300) in two ways: firstly, on the grounds that it was biased, excluding those factors that increased risk (especially that both children were boys) and (more importantly) because reductions in SIDS risk factors will proportionately reduce murder risk factors, so that the relative frequencies of Münchausen syndrome by proxy and SIDS will remain in the same ratio as in the general population: Hill, Ray (2002). «Cot Death or Murder? – Weighing the Probabilities».

it is patently unfair to use the characteristics which basically make her a good, clean-living, mother as factors which count against her. Yes, we can agree that such factors make a natural death less likely – but those same characteristics also make murder less likely.

- ^ Sweeney, John; Law, Bill (July 15, 2001). «Gene find casts doubt on double ‘cot death’ murders». The Observer. Archived from the original on 2012-07-11.

- ^ Vincent Scheurer. «Convicted on Statistics?». Retrieved 2010-05-21.

- ^ Hill, R. (2004). «Multiple sudden infant deaths – coincidence or beyond coincidence?» (PDF). Paediatric and Perinatal Epidemiology. 18 (5): 321. doi:10.1111/j.1365-3016.2004.00560.x. PMID 15367318. Archived from the original (PDF) on 2012-08-30. Retrieved 2010-06-13.

- ^ «Royal Statistical Society concerned by issues raised in Sally Clark case» (PDF). 23 October 2001. Archived from the original (PDF) on 24 August 2011.

Society does not tolerate doctors making serious clinical errors because it is widely understood that such errors could mean the difference between life and death. The case of R v. Sally Clark is one example of a medical expert witness making a serious statistical error, one which may have had a profound effect on the outcome of the case

- ^ The uncertainty in this range is mainly driven by uncertainty in the likelihood of killing a second child, having killed a first, see: Hill, R. (2004). «Multiple sudden infant deaths – coincidence or beyond coincidence?» (PDF). Paediatric and Perinatal Epidemiology. 18 (5): 322–323. doi:10.1111/j.1365-3016.2004.00560.x. PMID 15367318. Archived from the original (PDF) on 2012-08-30. Retrieved 2010-06-13.

- ^ «R v Clark. [2003] EWCA Crim 1020 (11 April 2003)». www.bailii.org.

- ^ Bar-Hillel, Maya (1980). «The base-rate fallacy in probability judgments» (PDF). Acta Psychologica. 44 (3): 211–233. doi:10.1016/0001-6918(80)90046-3.

- ^ a b c Kahneman, Daniel; Amos Tversky (1973). «On the psychology of prediction». Psychological Review. 80 (4): 237–251. doi:10.1037/h0034747. S2CID 17786757.

- ^ Kahneman, Daniel; Amos Tversky (1985). «Evidential impact of base rates». In Daniel Kahneman, Paul Slovic & Amos Tversky (ed.). Judgment under uncertainty: Heuristics and biases. Science. Vol. 185. pp. 153–160. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Kahneman, Daniel (2000). «Evaluation by moments, past and future». In Daniel Kahneman and Amos Tversky (ed.). Choices, Values and Frames. ISBN 0-521-62749-4.

- ^ Nisbett, Richard E.; E. Borgida; R. Crandall; H. Reed (1976). «Popular induction: Information is not always informative». In J. S. Carroll & J. W. Payne (ed.). Cognition and social behavior. Vol. 2. pp. 227–236. ISBN 0-470-99007-4.

- ^ Koehler, J. J. (2010). «The base rate fallacy reconsidered: Descriptive, normative, and methodological challenges». Behavioral and Brain Sciences. 19: 1–17. doi:10.1017/S0140525X00041157. S2CID 53343238.

- ^ Barbey, A. K.; Sloman, S. A. (2007). «Base-rate respect: From ecological rationality to dual processes». Behavioral and Brain Sciences. 30 (3): 241–254, discussion 255–297. doi:10.1017/S0140525X07001653. PMID 17963533. S2CID 31741077.

- ^ Tversky, A.; Kahneman, D. (1974). «Judgment under Uncertainty: Heuristics and Biases». Science. 185 (4157): 1124–1131. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Cosmides, Leda; John Tooby (1996). «Are humans good intuitive statisticians after all? Rethinking some conclusions of the literature on judgment under uncertainty». Cognition. 58: 1–73. CiteSeerX 10.1.1.131.8290. doi:10.1016/0010-0277(95)00664-8. S2CID 18631755.

- ^ a b Gigerenzer, G.; Hoffrage, U. (1995). «How to improve Bayesian reasoning without instruction: Frequency formats». Psychological Review. 102 (4): 684. CiteSeerX 10.1.1.128.3201. doi:10.1037/0033-295X.102.4.684.

- ^ Hoffrage, U.; Lindsey, S.; Hertwig, R.; Gigerenzer, G. (2000). «Medicine: Communicating Statistical Information». Science. 290 (5500): 2261–2262. doi:10.1126/science.290.5500.2261. hdl:11858/00-001M-0000-0025-9B18-3. PMID 11188724. S2CID 33050943.

- ^ Akl, E. A.; Oxman, A. D.; Herrin, J.; Vist, G. E.; Terrenato, I.; Sperati, F.; Costiniuk, C.; Blank, D.; Schünemann, H. (2011). Schünemann, Holger (ed.). «Using alternative statistical formats for presenting risks and risk reductions». The Cochrane Database of Systematic Reviews. 2011 (3): CD006776. doi:10.1002/14651858.CD006776.pub2. PMC 6464912. PMID 21412897.

- ^ a b Sedlmeier, P.; Gigerenzer, G. (2001). «Teaching Bayesian reasoning in less than two hours». Journal of Experimental Psychology: General. 130 (3): 380–400. doi:10.1037/0096-3445.130.3.380. hdl:11858/00-001M-0000-0025-9504-E. PMID 11561916.

- ^ Brase, G. L. (2009). «Pictorial representations in statistical reasoning». Applied Cognitive Psychology. 23 (3): 369–381. doi:10.1002/acp.1460. S2CID 18817707.

- ^ Edwards, A.; Elwyn, G.; Mulley, A. (2002). «Explaining risks: Turning numerical data into meaningful pictures». BMJ. 324 (7341): 827–830. doi:10.1136/bmj.324.7341.827. PMC 1122766. PMID 11934777.

- ^ Kim, Yea-Seul; Walls, Logan A.; Krafft, Peter; Hullman, Jessica (2 May 2019). «A Bayesian Cognition Approach to Improve Data Visualization». Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems: 1–14. doi:10.1145/3290605.3300912. ISBN 9781450359702. S2CID 57761146.

- ^ Girotto, V.; Gonzalez, M. (2001). «Solving probabilistic and statistical problems: A matter of information structure and question form». Cognition. 78 (3): 247–276. doi:10.1016/S0010-0277(00)00133-5. PMID 11124351. S2CID 8588451.

- ^ a b Hoffrage, U.; Gigerenzer, G.; Krauss, S.; Martignon, L. (2002). «Representation facilitates reasoning: What natural frequencies are and what they are not». Cognition. 84 (3): 343–352. doi:10.1016/S0010-0277(02)00050-1. PMID 12044739. S2CID 9595672.

- ^ Gigerenzer, G.; Hoffrage, U. (1999). «Overcoming difficulties in Bayesian reasoning: A reply to Lewis and Keren (1999) and Mellers and McGraw (1999)». Psychological Review. 106 (2): 425. doi:10.1037/0033-295X.106.2.425. hdl:11858/00-001M-0000-0025-9CB4-8.

- ^ Kleiter, G. D. (1994). «Natural Sampling: Rationality without Base Rates». Contributions to Mathematical Psychology, Psychometrics, and Methodology. Recent Research in Psychology. pp. 375–388. doi:10.1007/978-1-4612-4308-3_27. ISBN 978-0-387-94169-1.

External links[edit]

- The Base Rate Fallacy The Fallacy Files

Так называется логическая ошибка, происходящая от склонности человека игнорировать частоту некоего события и сосредотачиваться на специфической информации о нём. Другие названия этой логической ошибки — игнорирование базового уровня, заблуждение базового процента).

Например, сейчас 60% всех забастовок — такие, в которых основным требованием является не сокращать производство, чтобы не сокращать рабочие места. Но в самых доступных СМИ об этом не говорится, а говорится, что требуют повышения зарплат. И наш постсоветский обыватель делает неверный вывод — что забастовщики — эгоисты, хотят хорошо жить, когда страна в кризисе.