В ошибка базовой ставки, также называемый пренебрежение базовой ставкой или же систематическая ошибка базовой ставки, это заблуждение. Если представлены связанные базовая ставка информации (т. е. общей информации о распространенности) и конкретной информации (т. е. информации, относящейся только к конкретному случаю), люди склонны игнорировать базовую ставку в пользу индивидуальной информации, вместо того, чтобы правильно их объединять.[1]

Пренебрежение базовой ставкой — это особая форма более общего пренебрежение расширением.

Ложноположительный парадокс

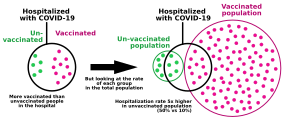

Примером ошибки базовой ставки является ложноположительный парадокс. Этот парадокс описывает ситуации, когда есть больше ложный положительный результат результаты тестов, чем истинно положительные. Например, 50 из 1000 человек дали положительный результат на инфекцию, но только у 10 была инфекция, то есть 40 тестов были ложноположительными. Вероятность положительного результата теста определяется не только точностью теста, но и характеристиками выборки.[2] Когда распространенность, доля тех, у кого есть данное заболевание, ниже, чем в тесте. ложный положительный результат рейтинг, даже тесты, которые имеют очень низкий шанс дать ложноположительный результат в индивидуальном случае даст больше ложных, чем истинных срабатываний общий.[3] Парадокс удивляет большинство людей.[4]

Это особенно противоречит интуиции при интерпретации положительного результата теста на низкую распространенность численность населения после получения положительных результатов, полученных в популяции с высокой распространенностью.[3] Если ложный положительный результат скорость теста выше, чем доля новый популяция с этим заболеванием, то администратор тестирования, чей опыт был взят из тестирования в популяции с высокой распространенностью, может сделать вывод из опыта что положительный результат теста обычно указывает на положительный результат, тогда как на самом деле ложноположительный результат гораздо более вероятен.

Примеры

Пример 1: болезнь

Население с высокой заболеваемостью

| Число людей |

Зараженный | Незараженный | Общий |

|---|---|---|---|

| Тест положительный |

400 (истинно положительный) |

30 (ложный положительный результат) |

430 |

| Тест отрицательный |

0 (ложноотрицательный) |

570 (истинно отрицательный) |

570 |

| Общий | 400 | 600 | 1000 |

Представьте, что вы проводите тест на инфекционные заболевания среди населения. А 1000 человек, из которых 40% инфицированы. Уровень ложноположительных результатов теста составляет 5% (0,05), а количество ложноотрицательных результатов отсутствует. В ожидаемый результат из 1000 тестов на популяции А было бы:

- Заражены и тест указывает на болезнь (истинно положительный )

- 1000 × 40/100 = 400 человек получат истинный позитив

- Неинфицирован, и тест указывает на болезнь (ложноположительный)

- 1000 × 100 – 40/100 × 0,05 = 30 человек получат ложное срабатывание

- Остальные 570 тестов правильно отрицательны.

Итак, в популяции А, человек, получивший положительный результат теста, может быть уверен более 93% (400/30 + 400), что это правильно указывает на инфекцию.

Население с низкой заболеваемостью

| Число людей |

Зараженный | Незараженный | Общий |

|---|---|---|---|

| Тест положительный |

20 (истинно положительный) |

49 (ложный положительный результат) |

69 |

| Тест отрицательный |

0 (ложноотрицательный) |

931 (истинно отрицательный) |

931 |

| Общий | 20 | 980 | 1000 |

Теперь рассмотрим тот же тест, применяемый к населению. B, у которых инфицировано только 2%. В ожидал результат 1000 тестов на популяции B было бы:

- Заражены и тест указывает на болезнь (истинно положительный )

- 1000 × 2/100 = 20 человек получат настоящий позитив

- Неинфицирован, и тест указывает на болезнь (ложноположительный)

- 1000 × 100 – 2/100 × 0,05 = 49 человек получат ложное срабатывание

- Остальные 931 (= 1000 — (49 + 20)) тест положительно отрицательны.

В населении B, только 20 из 69 человек с положительным результатом теста действительно инфицированы. Таким образом, вероятность действительно заразиться после того, как человеку сказали, что он инфицирован, составляет всего 29% (20/20 + 49) для теста, который в противном случае кажется «точным на 95%».

Тестировщик с опытом работы в группе А может показаться парадоксальным, что в группе B, результат, который обычно правильно указывал на инфекцию, теперь обычно ложный положительный результат. Путаница апостериорная вероятность заражения априорная вероятность получения ложного срабатывания — естественное ошибка после получения опасного для здоровья результата теста.

Пример 2: Пьяные водители

- Группа сотрудников полиции алкотестеры проявление ложного опьянения в 5% случаев, когда водитель трезв. Однако алкотестеры всегда обнаруживают по-настоящему пьяного человека. Один из тысячи водителей водит машину в нетрезвом виде. Предположим, полицейские наугад останавливают водителя, чтобы провести тест алкотестера. Это указывает на то, что водитель пьян. Мы предполагаем, что вы ничего о них не знаете. Насколько высока вероятность, что они действительно пьяны?

Многие ответят до 95%, но правильная вероятность составляет около 2%.

Объяснение этому следующее: в среднем на каждую 1000 протестированных водителей

- 1 водитель в нетрезвом виде, и 100% уверенность в том, что для этого водителя существует истинный положительный результат теста, значит есть 1 истинный положительный результат теста

- 999 водителей не пьяны, из них 5%. ложный положительные результаты тестирования, итого 49,95 ложный положительные результаты теста

Следовательно, вероятность того, что один из водителей среди положительных результатов теста 1 + 49,95 = 50,95 действительно пьян, составляет

Однако достоверность этого результата зависит от правильности первоначального предположения, что полицейский остановил водителя действительно случайно, а не из-за плохого вождения. Если присутствовала та или иная непроизвольная причина остановки водителя, то в расчет также включается вероятность того, что водитель в состоянии алкогольного опьянения будет управлять автомобилем грамотно, а водитель в нетрезвом виде водит (не) компетентно.

Более формально такую же вероятность примерно 0,02 можно установить, используя Теорема Байеса. Цель состоит в том, чтобы найти вероятность того, что водитель пьян, учитывая, что алкотестер показал, что он пьян, что может быть представлено как

куда D означает, что алкотестер показывает, что водитель пьян. Теорема Байеса говорит нам, что

В первом абзаце нам сказали следующее:

и

Как видно из формулы, нужно п(D) для теоремы Байеса, которую можно вычислить из предыдущих значений, используя закон полной вероятности:

который дает

Подставляя эти числа в теорему Байеса, мы обнаруживаем, что

Пример 3: идентификация террориста

В 1-миллионном городе пусть будет 100 террористов и 999 900 нетеррористов. Для упрощения примера предполагается, что все люди, присутствующие в городе, являются его жителями. Таким образом, базовая вероятность того, что случайно выбранный житель города является террористом, равна 0,0001, а базовая вероятность того, что этот же житель не является террористом, равна 0,9999. В попытке поймать террористов в городе устанавливают сигнализацию с камерой наблюдения и автоматикой. программное обеспечение для распознавания лиц.

Программное обеспечение имеет два уровня отказов по 1%:

- Уровень ложных отрицательных результатов: если камера сканирует террориста, звонок будет звонить в 99% случаев, а в 1% случаев он не будет звонить.

- Уровень ложных срабатываний: если камера сканирует человека, не являющегося террористом, звонок не будет звонить в 99% случаев, но он будет звонить в 1% случаев.

Предположим теперь, что житель вызывает тревогу. Какова вероятность того, что это террорист? Другими словами, что такое P (T | B), вероятность того, что террорист был обнаружен при звонке в колокол? Кто-то, делающий «ошибку базовой ставки», сделает вывод, что существует 99% -ная вероятность того, что обнаруженный человек является террористом. Хотя такой вывод кажется разумным, на самом деле это неверное рассуждение, и приведенный ниже расчет покажет, что вероятность того, что они террористы, на самом деле составляет около 1%, а не около 99%.

Заблуждение возникает из-за смешения природы двух разных коэффициентов отказов. «Количество не-колоколов на 100 террористов» и «количество нетеррористов на 100 колоколов» не связаны между собой. Один не обязательно равен другому, и они даже не обязательно должны быть почти равными. Чтобы продемонстрировать это, представьте, что произойдет, если во втором городе, где террористов вообще нет, была бы установлена идентичная система сигнализации. Как и в первом городе, сигнал тревоги звучит для 1 из каждых 100 обнаруженных жителей, не являющихся террористами, но, в отличие от первого города, сигнал тревоги никогда не звучит для террористов. Таким образом, 100% всех случаев срабатывания сигнала тревоги относятся к нетеррористам, но ложноотрицательный показатель даже не может быть подсчитан. «Число нетеррористов на 100 колоколов» в этом городе равно 100, но P (T | B) = 0%. При звонке в колокол вероятность того, что террорист был обнаружен, равна нулю.

Представьте себе, что перед камерой проходит весь миллион жителей первого города. Около 99 из 100 террористов вызовут тревогу, равно как и около 9 999 из 999 900 нетеррористов. Таким образом, тревогу сработают около 10 098 человек, среди которых около 99 — террористы. Таким образом, вероятность того, что человек, вызвавший тревогу, на самом деле является террористом, составляет всего около 99 из 10 098, что меньше 1% и очень, очень сильно ниже нашего первоначального предположения в 99%.

Ошибка базовой ставки в этом примере вводит в заблуждение, потому что нетеррористов намного больше, чем террористов, а количество ложных срабатываний (нетеррористов, считающихся террористами) намного больше, чем истинных срабатываний (реальное количество террористов) .

Находки в психологии

В ходе экспериментов было обнаружено, что люди предпочитают индивидуальную информацию общей информации, когда первая доступна.[5][6][7]

В некоторых экспериментах студентов просили оценить средний балл (GPA) гипотетических студентов. Получая соответствующую статистику о распределении среднего балла, учащиеся, как правило, игнорировали ее, если давали описательную информацию о конкретном учащемся, даже если новая описательная информация явно не имела отношения к успеваемости в школе.[6] Этот вывод был использован, чтобы доказать, что интервью — ненужная часть поступление в колледж процесс, потому что интервьюеры не могут выбрать успешных кандидатов лучше, чем базовая статистика.

Психологи Даниэль Канеман и Амос Тверски попытался объяснить этот вывод с точки зрения простое правило или «эвристика» называется представительность. Они утверждали, что многие суждения, касающиеся вероятности или причинно-следственных связей, основаны на том, насколько одна вещь репрезентативна для другой или категории.[6] Канеман считает пренебрежение базовой ставкой особой формой пренебрежение расширением.[8] Ричард Нисбетт утверждал, что некоторые атрибуционные предубеждения словно Основная ошибка атрибуции являются примерами ошибки базовой ставки: люди не используют «консенсусную информацию» («базовую ставку») о том, как другие вели себя в аналогичных ситуациях, и вместо этого предпочитают более простые диспозиционная атрибуция.[9]

В психологии ведутся серьезные споры об условиях, при которых люди ценят или не ценят базовую информацию.[10][11] Исследователи программы эвристики и систематических ошибок подчеркнули эмпирические результаты, показывающие, что люди склонны игнорировать базовые ставки и делать выводы, нарушающие определенные нормы вероятностного рассуждения, такие как Теорема Байеса. Вывод, сделанный на основании этого направления исследований, заключался в том, что вероятностное мышление человека в корне ошибочно и подвержено ошибкам.[12] Другие исследователи подчеркивали связь между когнитивными процессами и информационными форматами, утверждая, что такие выводы обычно необоснованны.[13][14]

Снова рассмотрим пример 2 сверху. Требуемый вывод заключается в оценке (апостериорной) вероятности того, что (случайно выбранный) водитель пьян, при условии, что тест алкотестера положительный. Формально эту вероятность можно рассчитать с помощью Теорема Байеса, как показано выше. Однако существуют разные способы представления соответствующей информации. Рассмотрим следующий формально эквивалентный вариант задачи:

- 1 из 1000 водителей водит машину в нетрезвом виде. Алкотестеры никогда не перестают определять по-настоящему пьяного человека. Для 50 из 999 водителей, не находящихся в состоянии алкогольного опьянения, алкотестер ложно показывает состояние опьянения. Предположим, полицейские наугад останавливают водителя и заставляют его пройти тест алкотестером. Это указывает на то, что они пьяны. Мы предполагаем, что вы ничего о них не знаете. Насколько высока вероятность, что они действительно пьяны?

В этом случае соответствующая числовая информация —п(пьяный), п(D | пьяный), п(D | трезвый) — представлен в терминах собственных частот по отношению к определенному эталонному классу (см. проблема эталонного класса ). Эмпирические исследования показывают, что выводы людей в большей степени соответствуют правилу Байеса, когда информация представлена таким образом, что помогает преодолеть пренебрежение базовой оценкой среди непрофессионалов.[14] и эксперты.[15] Как следствие, организации, подобные Кокрановское сотрудничество рекомендуют использовать такой формат для передачи статистики здоровья.[16] Учить людей переводить подобные байесовские задачи мышления в форматы собственных частот более эффективно, чем просто учить их подставлять вероятности (или проценты) в теорему Байеса.[17] Также было показано, что графические представления собственных частот (например, массивы значков) помогают людям делать более точные выводы.[17][18][19]

Чем полезны форматы собственных частот? Одна из важных причин заключается в том, что этот формат информации облегчает требуемый вывод, поскольку упрощает необходимые вычисления. Это можно увидеть при использовании альтернативного способа вычисления требуемой вероятности п(пьяный |D):

куда N(пьяный ∩ D) обозначает количество пьяных водителей, получивших положительный результат алкотестера, и N(D) обозначает общее количество случаев с положительным результатом алкотестера. Эквивалентность этого уравнения предыдущему следует из аксиом теории вероятностей, согласно которой N(пьяный ∩ D) = N × п (D | пьяный) × п (пьяный). Важно отметить, что хотя это уравнение формально эквивалентно правилу Байеса, психологически оно не эквивалентно. Использование собственных частот упрощает вывод, поскольку требуемая математическая операция может выполняться с натуральными числами, а не с нормализованными дробями (т. Е. Вероятностями), поскольку это делает большое количество ложных срабатываний более прозрачным, и поскольку собственные частоты демонстрируют «вложенный набор» структура».[20][21]

Не каждый частотный формат облегчает байесовские рассуждения.[21][22] Собственные частоты относятся к частотной информации, которая получается из естественная выборка,[23] который сохраняет информацию о базовой ставке (например, количество пьяных водителей при случайной выборке водителей). Это отличается от систематический отбор проб, в котором базовые ставки фиксированы априори (например, в научных экспериментах). В последнем случае невозможно вывести апостериорную вероятность п (пьяный | положительный тест) из сравнения количества пьяных водителей с положительным результатом теста по сравнению с общим количеством людей, получивших положительный результат алкотестера, потому что информация о базовой скорости не сохраняется и должна быть явно повторно введена с использованием теоремы Байеса .

Смотрите также

- Байесовская вероятность

- Теорема Байеса

- Дноуглубительные работы

- Индуктивный аргумент

- Список когнитивных предубеждений

- Список парадоксов

- Вводящая в заблуждение яркость

- Профилактика парадокса

- Ошибка прокурора, ошибка в рассуждениях, включающая игнорирование низкого априорная вероятность

- Парадокс Симпсона, еще одна ошибка в статистических рассуждениях, касающихся сравнения групп

- Стереотип

Рекомендации

- ^ «Логическая ошибка: ошибка базовой ставки». Fallacyfiles.org. Получено 2013-06-15.

- ^ Rheinfurth, M. H .; Хауэлл, Л. У. (март 1998 г.). Вероятность и статистика в аэрокосмической технике (PDF). НАСА. п. 16.

СООБЩЕНИЕ: ложноположительные тесты более вероятны, чем истинно положительные тесты, когда общая популяция имеет низкую распространенность болезни. Это называется ложноположительным парадоксом.

- ^ а б Вашер, Х. Л. (май 2003 г.). «Количественная грамотность — тестирование на наркотики, скрининг рака и идентификация вулканических пород». Журнал геолого-геофизического образования: 2.

На первый взгляд это кажется извращенным: чем меньше учащиеся в целом используют стероиды, тем больше вероятность, что учащийся, идентифицированный как пользователь, не будет пользователем. Это было названо ложноположительным парадоксом.

— Цитирование: Gonick, L .; Смит, В. (1993). Мультяшный гид по статистике. Нью-Йорк: Харпер Коллинз. п. 49. - ^ Мэдисон, Б. Л. (август 2007 г.). «Математические знания для гражданства». В Schoenfeld, A.H. (ред.). Оценка математических навыков. Публикации Института математических наук (Новое изд.). Издательство Кембриджского университета. п. 122. ISBN 978-0-521-69766-8.

Правильная [оценка вероятности …] многих удивляет; следовательно, термин парадокс.

- ^ Бар-Гилель, Майя (1980). «Ошибка базовой ставки в вероятностных суждениях» (PDF). Acta Psychologica. 44 (3): 211–233. Дои:10.1016/0001-6918(80)90046-3.

- ^ а б c Канеман, Даниэль; Амос Тверски (1973). «О психологии предсказания». Психологический обзор. 80 (4): 237–251. Дои:10,1037 / ч0034747. S2CID 17786757.

- ^ Канеман, Даниэль; Амос Тверски (1985). «Доказательное влияние базовых ставок». В книге Даниэля Канемана, Пола Словича и Амоса Тверски (ред.). Суждение в условиях неопределенности: эвристика и предубеждения. Наука. 185. С. 153–160. Дои:10.1126 / science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Канеман, Даниэль (2000). «Оценка моментами, прошлым и будущим». У Даниэля Канемана и Амоса Тверски (ред.). Выбор, ценности и рамки.

- ^ Нисбетт, Ричард Э .; Э. Боргида; Р. Крэндалл; Х. Рид (1976). «Популярная индукция: информация не всегда информативна». В J. S. Carroll & J. W. Payne (ed.). Познание и социальное поведение. 2. С. 227–236.

- ^ Кёлер, Дж. Дж. (2010). «Ошибка базовой ставки пересмотрена: описательные, нормативные и методологические проблемы». Поведенческие науки и науки о мозге. 19: 1–17. Дои:10.1017 / S0140525X00041157. S2CID 53343238.

- ^ Барби, А. К .; Сломан, С. А. (2007). «Базовое уважение: от экологической рациональности к двойственным процессам». Поведенческие науки и науки о мозге. 30 (3): 241–254, обсуждение 255–297. Дои:10.1017 / S0140525X07001653. PMID 17963533. S2CID 31741077.

- ^ Тверски, А .; Канеман, Д. (1974). «Суждение в условиях неопределенности: эвристика и предубеждения». Наука. 185 (4157): 1124–1131. Bibcode:1974Научный … 185.1124Т. Дои:10.1126 / science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Космидес, Леда; Джон Туби (1996). «Являются ли люди в конце концов хорошими интуитивными статистиками? Переосмысление некоторых литературных выводов о суждениях в условиях неопределенности». Познание. 58: 1–73. CiteSeerX 10.1.1.131.8290. Дои:10.1016/0010-0277(95)00664-8. S2CID 18631755.

- ^ а б Gigerenzer, G .; Хоффраге, У. (1995). «Как улучшить байесовское рассуждение без инструкции: частотные форматы». Психологический обзор. 102 (4): 684. CiteSeerX 10.1.1.128.3201. Дои:10.1037 / 0033-295X.102.4.684.

- ^ Hoffrage, U .; Lindsey, S .; Hertwig, R .; Гигеренцер, Г. (2000). «Медицина: передача статистической информации». Наука. 290 (5500): 2261–2262. Дои:10.1126 / science.290.5500.2261. PMID 11188724. S2CID 33050943.

- ^ Akl, E. A .; Oxman, A.D .; Herrin, J .; Vist, G.E .; Терренато, I .; Sperati, F .; Костинюк, Ц .; Бланк, Д .; Шюнеманн, Х. (2011). Шюнеманн, Хольгер (ред.). «Использование альтернативных статистических форматов для представления рисков и снижения рисков». Кокрановская база данных систематических обзоров (3): CD006776. Дои:10.1002 / 14651858.CD006776.pub2. ЧВК 6464912. PMID 21412897.

- ^ а б Sedlmeier, P .; Гигеренцер, Г. (2001). «Обучение байесовскому мышлению менее чем за два часа». Журнал экспериментальной психологии: Общие. 130 (3): 380. Дои:10.1037/0096-3445.130.3.380. HDL:11858 / 00-001M-0000-0025-9504-E.

- ^ Брасе, Г. Л. (2009). «Иллюстрированные представления в статистических рассуждениях». Прикладная когнитивная психология. 23 (3): 369–381. Дои:10.1002 / acp.1460. S2CID 18817707.

- ^ Эдвардс, А .; Elwyn, G .; Малли, А. (2002). «Объяснение рисков: превращение числовых данных в значимые картинки». BMJ. 324 (7341): 827–830. Дои:10.1136 / bmj.324.7341.827. ЧВК 1122766. PMID 11934777.

- ^ Girotto, V .; Гонсалес, М. (2001). «Решение вероятностно-статистических задач: вопрос структуры информации и формы вопроса». Познание. 78 (3): 247–276. Дои:10.1016 / S0010-0277 (00) 00133-5. PMID 11124351. S2CID 8588451.

- ^ а б Hoffrage, U .; Gigerenzer, G .; Krauss, S .; Мартиньон, Л. (2002). «Представление облегчает рассуждение: что такое собственные частоты, а чем нет». Познание. 84 (3): 343–352. Дои:10.1016 / S0010-0277 (02) 00050-1. PMID 12044739. S2CID 9595672.

- ^ Gigerenzer, G .; Хоффраге, У. (1999). «Преодоление трудностей в байесовских рассуждениях: ответ Льюису и Керену (1999) и Меллерсу и МакГроу (1999)». Психологический обзор. 106 (2): 425. Дои:10.1037 / 0033-295X.106.2.425. HDL:11858 / 00-001M-0000-0025-9CB4-8.

- ^ Клейтер, Г. Д. (1994). «Естественная выборка: рациональность без базовых ставок». Вклад в математическую психологию, психометрию и методологию. Последние исследования в области психологии. С. 375–388. Дои:10.1007/978-1-4612-4308-3_27. ISBN 978-0-387-94169-1.

внешняя ссылка

- Ошибка базовой ставки Файлы ошибок

Когнитивные искажения (от лат. cognitiо «познание») – это то, что касается каждого человека вне зависимости от уровня его образования и социального положения.

Наш мозг – это главный орган центральной нервной системы, загадка которого не разгадана учеными до сих пор. Он содержит около 86 миллиардов нейронов, которые регулируют всю деятельность человека.

Наверное, и неудивительно, что мозг иногда обманывает нас, так что порой кажется, что он живет отдельной жизнью.

Так это или нет – мы, возможно, узнаем в будущем, а пока давайте рассмотрим наиболее частые когнитивные искажения, или ошибки мышления, которые встречаются в жизни каждого.

Это поможет вам не только осознать причины тех или иных своих действий, но и даст понимание некоторых поступков окружающих вас людей.

Ошибки мышления

Данная статья будет интересна не только любителям психологии, но и всем, кому интересно саморазвитие.

-

Ошибка базового процента

Довольно часто мы игнорируем реальную статистику, отдавая предпочтение собственному опыту. Например, вы обратились в автосервис, который, в конечном счете, не смог починить вашу машину.

После этого ваш мозг будет считать данный сервис плохим даже несмотря на то, что вам достоверно известно о сотнях машин, которые были там полностью отремонтированы. Ничего не поделаешь, личный опыт для мозга важнее статистики.

-

Отклонение внимания

Мозгу свойственно замечать только то, что вам нравится, или что вас интересует. Например, если вы парикмахер, то новая прическа вашего коллеги будет тут же детально изучена, в то время как другие даже не обратят на нее внимание.

Если вы любите модные бренды, то любая новая сумка знакомого вызовет у вас интерес. То же самое касается и праздников. Так что если вас кто-то не поздравил, не спешите обижаться, – наверняка это было сделано не намеренно. Все дело в когнитивном искажении под названием «Отклонение внимания».

-

Феномен «Дверь в лицо»

Известный американский психолог Роберт Чалдини рассказывал, как однажды на улице к нему подошёл мальчик и предложил купить билеты на какое-то мероприятие. Один билет стоил 5 долларов.

Чалдини вежливо отказался. Тогда мальчик предложил ему купить плитки шоколада всего лишь по доллару за штуку. После того как Чалдини купил пару плиток, он осознал, что им манипулировали, так как:

- он не любит шоколад и ему нужны деньги;

- он остался с двумя ненужными ему шоколадками и без денег.

Чалдини отправился на встречу с коллегами, с которыми обсудил произошедшее. В результате совещания была разработана серия экспериментов, позже ставшая классической.

Итак, «Дверь в лицо» – это социально-психологический феномен, который заключается в том, что люди склонны идти на уступку и соглашаться с малопривлекательным предложением в том случае, если оно им предлагается сразу после их отказа от другой более тяжелой просьбы.

-

Иллюзия частоты

Мозг не замечает многие вещи, которые нас окружают до тех пор, пока они нас не заинтересуют. Например, вам нужно купить детскую коляску, и вы остановились на каком-то бренде.

Внезапно вы обнаруживаете, что колясок этого бренда начало встречаться очень много. Это иллюзия. На самом деле просто вы начали обращать на них внимание, а не они резко распространились. Таковы результаты когнитивного искажения.

-

Эффект мнимой правды

Это один из самых популярных инструментов пропаганды во всем мире. Давно известно, что если повторять ложь достаточно долго, достаточно громко и достаточно часто – люди начнут верить лжи.

Если человеку 100 раз сказать, что он свинья, то на 101раз он захрюкает.

Умельцы весьма эффективно применяют этот феномен. Приведем безобидный пример. Некто хочет, чтобы его считали умным, поэтому он, цитирует, допустим, древнегреческого философа:

– Как говорил Протагор – «Человек есть мера всех вещей».

В следующий раз он повторяет это несколько иначе:

– Как я говорил в прошлый раз, – «Человек есть мера всех вещей».

И, наконец, в третий раз он заявляет:

– Как я обычно говорю, – «Человек есть мера всех вещей».

Вроде бы все правильно, но используя это когнитивное искажение, вам навязали ложную мысль, будто автором фразы является этот Некто, который хочет, чтобы его считали умным.

-

Эффект знакомства с объектом

Пожалуй, вся реклама, существующая в мире, работает на этот эффект мышления. Дело в том, что из нескольких незнакомых объектов мы обязательно отдадим предпочтение тому, о котором знаем хотя бы что-то.

Например, вам нужен крем для рук. Придя в магазин, вы почти наверняка возьмете тот крем, о котором хотя бы раз где-то слышали (например, в рекламе), чем тот, о котором вы вообще ничего не знаете.

-

Эвристика доступности

Наверняка у многих бывали такие случаи, когда знакомый уезжал в столицу и умело там пристраивался, вследствие чего у вас формировалось убеждение, что все жители столицы – это хорошо обеспеченные люди, работающие в крутых компаниях.

Так вот эта ошибка мышления возникает потому, что наш мозг оценивает частоту или возможность события по легкости, с которой примеры или случаи приходят на ум, т. е. легче вспоминаются.

Или, например, человек оценивает степень риска возникновения инфаркта у людей среднего возраста, припоминая подобные случаи среди своих знакомых.

-

Эффект контекста

Эффект контекста используется маркетологами для того, чтобы спровоцировать вас на покупку чего-то, что вам вовсе не нужно. Именно поэтому выкладка товара в магазине делается не просто для удобства, а с обязательным использованием эффекта контекста.

Одна дама сумела чрезвычайно выгодно продать свою квартиру потому, что перед приездом покупателя она готовила ароматные сдобные булочки. Входя в свою потенциальную квартиру, клиент ощущал тепло и такой приятный домашний аромат, что мозг просто не мог не попасть в ловушку контекста.

Таким образом, при помощи этого нехитрого когнитивного искажения ловкая барышня сумела провернуть выгодную сделку.

-

Склонность к негативу

Мы подсознательно переоцениваем значение отрицательных вещей. Собственно именно по этой причине плохие новости всегда будут иметь гораздо бо́льшую аудиторию, чем хорошие.

Не случайно слова журналистки известной новостной службы «Редакция требует крови!» стали мемом и вовсе не так далеки от действительности. Редакции действительно нужно «больше крови», так как это гарантирует кратное увеличение просмотров.

-

Эффект якоря

Эффект якоря – это особенность оценки числовых значений, которая смещает оценку в сторону начального приближения.

Например, вам нужно купить пальто. Вы заходите в магазин, находите подходящую вам модель, а после примерки узнаете, что она стоит 500$. Для вас это дорого, и вы уже собираетесь уходить, как вдруг к вам подбегает консультант.

Уточнив, подошло ли вам пальто, консультант говорит, что это уникальная серия, состоящая из всего 80 экземпляров. Более того, на эту модель сегодня действует скидка «Минус 50%».

Именно здесь и срабатывает эффект якоря, роль которого в данном случае играет число 500. С большой долей вероятности клиент в такой ситуации совершит покупку, даже не задумываясь о том, что для такого пальто даже 250$ – большая цена.

Интересен факт, что эффект якоря работает вне зависимости от того, знаете вы о нем, или нет. То же самое наблюдается и с правилом взаимного обмена.

-

Эффект фрейминга

Эффект фрейминга (от англ. frame рамка, обрамление) – это когнитивное искажение, при котором форма подачи информации влияет на ее восприятие человеком.

В качестве классического примера данного эффекта нередко приводят выражение: «Стакан наполовину пуст или наполовину полон». Речь идет об одном и том же явлении, но отношение к нему из-за подачи информации меняется.

В одном из экспериментов участникам показывали видеозаписи с автомобильными авариями. После этого им задавали вопрос: «С какой скоростью ехали машины, когда столкнулись друг с другом?».

В каждой группе вопросы немного отличались: глагол «столкнулись» заменялся на «врезались», «налетели», «задели», «ударились».

В результате было установлено, что изменения в постановке вопроса оказывали влияние на оценку скорости автомобилей, несмотря на то, что всем респондентам показывали один и тот же ролик.

-

Восприятие выбора

Замечено, что сначала мы делаем выбор, а потом мозг пытается его оправдать. Причем чем бессмысленнее выбор, тем больше мы его защищаем.

В качестве примера можно привести попытки найти неявные плюсы в покупке и тем самым её оправдать при наличии другого, более подходящего товара, который по каким-то причинам не был приобретён.

К слову сказать, именно по этому принципу работают деструктивные секты и различные финансовые пирамиды. В какой-то степени этот эффект похож на стокгольмский синдром, когда жертва оправдывает агрессора. Кстати, мы уже рассказывали про 10 необычных психических синдромов в отдельной статье.

-

Предпочтение нулевого риска

Это предпочтение контролируемой, но потенциально более вредоносной (вследствие более частого её возникновения) ситуации перед обратной.

Происходит это по причине переоценки возможности контроля. То есть человек со своей стороны считает, что он полностью избавляется от риска (на самом деле не имея полного контроля), в то время как со стороны статистики это является снижением до нуля лишь одного, причем не самого большого риска.

Например, большинство людей предпочли бы уменьшить вероятность терактов до нуля вместо снижения аварийности на дорогах, даже несмотря на то, что второй эффект давал бы гораздо больше сохранённых жизней.

Или другой пример – ятрофобия (боязнь врачей). Многие люди боятся осложнений медицинских вмешательств больше, чем заболевания и смерти в результате самих этих заболеваний, которые возникают из-за отсутствия лечения.

-

Эффект морального доверия

Человек, относительно которого известно, что у него нет предубеждений, имеет в будущем большие шансы проявить эти предубеждения.

Иными словами, если все (в том числе и он сам) считают человека безгрешным, то возникает иллюзия, что любое его действие также будет безгрешным.

-

Селективное восприятие

Селективное восприятие (лат. selectio «выбирать») – это склонность людей уделять внимание тем элементам окружения, которые согласуются с их ожиданиями, и игнорировать остальные.

В классическом эксперименте зрители просматривали видео особо ожесточённого матча по американскому футболу между Принстонским университетом и Дартмутским колледжем.

Зрители из Принстона заметили почти в два раза больше нарушений, совершённых дартмутской командой, чем зрители из Дартмута. Один зритель из Дартмута вовсе не заметил ни одного нарушения со стороны «своей» команды.

Это когнитивное искажение также играет огромную роль в психологии рекламы.

-

Слепое пятно в отношении искажений

Последняя ошибка мышления, или когнитивное искажение, которое мы рассмотрим, – это слепое пятно в отношении искажений.

Это не что иное, как более лёгкое обнаружение недостатков у других людей, нежели у себя. То есть, все перечисленные когнитивные искажения присутствуют у каждого человека, однако мы «в чужом глазу видим соринку, а в своём и бревна не замечаем».

Наверняка и после прочтения этой статьи у большинства зрителей появится ощущение, что я, дескать, знаю все это и так, и, конечно же, меня все эти когнитивные искажения не касаются. На самом же деле они касаются всех.

Но теперь возникает закономерный вопрос: что же делать со всеми этими ошибками? Ответ прост: перечитывайте статью и вникайте в суть перечисленных когнитивных искажений или ошибок мышления.

Чем больше вы будете осознавать факт существования когнитивных искажений, тем больше вероятность, что вы будете принимать правильные решения и делать верный выбор.

Теперь вы знаете, что такое когнитивные искажения и как они влияют на нашу жизнь. Если вам понравилась статья, – поделитесь ею с друзьями и подписывайтесь на сайт interesnyefakty.org. С нами всегда интересно!

Понравился пост? Нажми любую кнопку:

Статистическая формальная ошибка

Ошибка базовой ставки, также называемая базовой пренебрежение оценкой или отклонение базовой ставки, является ошибкой. При представлении связанной информации базовой ставки (т. Е. Общей информации о распространенности) и конкретной информации (т. Е. Информации, относящейся только к конкретному случаю) люди склонны игнорировать базовую ставку в пользу индивидуальной информации, вместо правильного объединения двух.

Пренебрежение базовой скоростью — это конкретная форма более общего пренебрежения расширением.

Содержание

- 1 Ложноположительный парадокс

- 2 Примеры

- 2.1 Пример 1: Болезнь

- 2.1.1 Население с высокой заболеваемостью

- 2.1.2 Население с низкой заболеваемостью

- 2.2 Пример 2: Водители в нетрезвом виде

- 2.3 Пример 3: Идентификация террористов

- 2.1 Пример 1: Болезнь

- 3 Выводы по психологии

- 4 См. Также

- 5 Ссылки

- 6 Внешние ссылки

Парадокс ложных срабатываний

Примером ошибки базовой ставки является то, насколько удивлены люди парадоксом ложных срабатываний, ситуации, когда имеется больше ложноположительных результатов теста, чем истинно-положительных. Например, это может быть так, что из 1000 человек, прошедших тестирование на инфекцию, 50 из них дали положительный результат на наличие инфекции, но это связано с тем, что у 10 действительно она была и у 40 ошибочных результатов тестов, потому что только 10 человек из тех, кто прошел тестирование, действительно инфицированы. но тест иногда дает ложные результаты. Вероятность положительного результата теста определяется не только точностью теста, но и характеристиками выборки. Когда распространенность, доля тех, у кого есть данное заболевание, ниже, чем уровень ложноположительных результатов теста, даже тесты, которые имеют очень низкий шанс дать ложноположительный результат в отдельном случае, будут давать больше ложных результатов. чем истинных положительных результатов в целом. Парадокс удивляет большинство людей.

Это особенно противоречит интуиции при интерпретации положительного результата теста на низкой распространенности популяции после того, как имеешь дело с положительными результатами, полученными из высокой распространенности. численность населения. Если ложноположительный уровень теста выше, чем доля новой популяции с заболеванием, то администратор теста, чей опыт был получен в результате тестирования в популяции с высокой распространенностью, может сделать вывод из Опыт, что положительный результат теста обычно указывает на положительный результат, тогда как на самом деле ложноположительный результат гораздо более вероятен.

Примеры

Пример 1: Болезнь

Население с высокой заболеваемостью

| Количество. людей | Инфицированные | Незараженные | Всего |

|---|---|---|---|

| Тест. положительный | 400. (истинно положительный) | 30. (ложноположительный) | 430 |

| Тест. отрицательный | 0. (ложноотрицательный) | 570. (истинно отрицательный) | 570 |

| Всего | 400 | 600 | 1000 |

Представьте, что вы проводите тест на инфекционное заболевание в популяции A из 1000 человек, 40% из которых инфицированы. Уровень ложноположительных результатов теста составляет 5% (0,05), а количество ложноотрицательных результатов отсутствует. ожидаемый результат из 1000 тестов в популяции A будет:

- инфицировано, и тест указывает на болезнь (истинно положительный )

- 1000 × 40/100 = 400 человек получат истинно положительный результат

- Незараженные и тест указывает на болезнь (ложноположительный)

- 1000 × 100 — 40/100 × 0,05 = 30 человек получат ложноположительный результат

- Остальные 570 тестов правильно отрицательны.

Итак, в популяции A человек, получивший положительный результат теста, может быть уверен более чем на 93% (400/30 + 400), что он правильно указывает на инфекцию.

Население с низкой заболеваемостью

| Количество. людей | Зараженные | Неинфицированные | Всего |

|---|---|---|---|

| Тест. положительный | 20. (истинно положительный) | 49. (ложноположительный) | 69 |

| Тест. отрицательный | 0. (ложноотрицательный) | 931. (истинно отрицательный) | 931 |

| Итого | 20 | 980 | 1000 |

Теперь рассмотрим тот же тест, примененный к популяции B, в которой инфицировано только 2%. ожидаемый результат 1000 тестов в популяции B будет:

- Заражено a -й тест указывает на болезнь (истинно положительный )

- 1000 × 2/100 = 20 человек получат истинно положительный результат

- Неинфицированные, а тест указывает на болезнь (ложноположительный)

- 1000 × 100 — 2 / 100 × 0,05 = 49 человек получат ложноположительный результат

- Остальные 931 (= 1000 — (49 + 20)) теста являются правильно отрицательными.

В популяции B только 20 из 69 человек с положительным результатом теста результат действительно заражены. Таким образом, вероятность действительно заразиться после того, как кому-то сказали, что он инфицирован, составляет всего 29% (20/20 + 49) для теста, который в противном случае кажется «точным на 95%».

Тестировщик, имеющий опыт работы с группой A, может найти парадокс в том, что в группе B результат, который обычно правильно указывал на инфекцию, теперь обычно является ложноположительным. Смешение апостериорной вероятности заражения с априорной вероятностью получения ложноположительного результата является естественной ошибкой после получения угрожающего здоровью результата теста.

Пример 2: Пьяные водители

- У группы полицейских есть алкотестеры, показывающие ложное опьянение в 5% случаев, когда водитель трезв. Однако алкотестеры всегда обнаруживают по-настоящему пьяного человека. Один из тысячи водителей водит машину в нетрезвом виде. Предположим, полицейские наугад останавливают водителя, чтобы провести тест алкотестера. Это указывает на то, что водитель пьян. Мы предполагаем, что вы ничего о них не знаете. Насколько высока вероятность того, что они действительно пьяны?

Многие ответят как 95%, но правильная вероятность составляет около 2%.

Объяснение этому следующее: в среднем на каждую 1000 протестированных водителей

- 1 водитель находится в состоянии алкогольного опьянения, и 100% уверенности в том, что для этого драйвера существует истинно положительный результат теста, поэтому имеется 1 истинно положительный результат теста

- 999 водителей не находятся в состоянии алкогольного опьянения, и среди этих водителей имеется 5% ложноположительных результатов испытаний, поэтому имеется 49,95 ложноположительных результатов испытаний

Следовательно, вероятность того, что один из водители среди положительных результатов теста 1 + 49,95 = 50,95 действительно пьяны 1 / 50,95 ≈ 0,019627 { displaystyle 1 / 50.95 приблизительно 0,019627}

Однако достоверность этого результата зависит от достоверности Из первоначального предположения, что полицейский остановил водителя действительно случайно, а не из-за плохого вождения. Если присутствовала та или иная непроизвольная причина остановки водителя, то в расчет также включается вероятность того, что водитель в состоянии алкогольного опьянения будет управлять автомобилем грамотно, а водитель в нетрезвом виде водит (не) компетентно.

Более формально такая же вероятность примерно 0,02 может быть установлена с помощью теоремы Байеса. Цель состоит в том, чтобы найти вероятность того, что водитель пьян, учитывая, что алкотестер показал, что он пьян, что может быть представлено как

- p (пьяный ∣ D) { displaystyle p ( mathrm {drunk} mid D)}

где D означает, что алкотестер показывает, что водитель пьян. Теорема Байеса говорит нам, что

- p (d r u n k ∣ D) = p (D ∣ d r u n k) p (d r u n k) p (D). { displaystyle p ( mathrm {drunk} mid D) = { frac {p (D mid mathrm {drunk}) , p ( mathrm {drunk})} {p (D)}}.}.

В первом абзаце нам сказали следующее:

- p (пьяный) = 0,001, { displaystyle p ( mathrm {drunk}) = 0,001,}

- p (трезвый) = 0,999, { displaystyle p ( mathrm {sober}) = 0,999,}

- p (D ∣ drunk) = 1,00, { displaystyle p (D mid mathrm {drunk}) = 1,00,}

и

- p (D трезвый) = 0,05. { displaystyle p (D mid mathrm {sober}) = 0,05.}

Как видно из формулы, для теоремы Байеса требуется p (D), которую можно вычислить из предыдущих значений с помощью закон полной вероятности :

- p (D) = p (D ∣ пьяный) p (пьяный) + p (D ∣ трезвый) p (трезвый) { displaystyle p (D) = p (D mid mathrm {drunk}) , p ( mathrm {drunk}) + p (D mid mathrm {sober}) , p ( mathrm {sober})}

, что дает

- p (D) = (1,00 × 0,001) + (0,05 × 0,999) = 0,05095. { displaystyle p (D) = (1,00 times 0,001) + (0,05 times 0,999) = 0,05095.}

Подставляя эти числа в теорему Байеса, мы получаем, что

- p (drunk ∣ D) = 1,00 × 0,001 0,05095 = 0,019627. { displaystyle p ( mathrm {drunk} mid D) = { frac {1,00 times 0,001} {0,05095}} = 0,019627.}

Пример 3: идентификация террориста

В городе 1 миллион жителей пусть будет 100 террористов и 999 900 нетеррористов. Для упрощения примера предполагается, что все люди, присутствующие в городе, являются его жителями. Таким образом, базовая вероятность того, что случайно выбранный житель города является террористом, равна 0,0001, а базовая вероятность того, что этот же житель не является террористом, равна 0,9999. В попытке поймать террористов город устанавливает систему сигнализации с камерой наблюдения и автоматическим программным обеспечением для распознавания лиц.

. Программное обеспечение имеет два уровня отказов по 1%:

- Уровень ложных отрицательных результатов: если камера сканирует террориста, звонок будет звонить в 99% случаев, и он не будет звонить в 1% случаев.

- Частота ложных срабатываний: если камера сканирует человека, не являющегося террористом, звонок не будет звонит 99% времени, но он будет звонить 1% времени.

Предположим теперь, что житель вызывает тревогу. Какова вероятность того, что это террорист? Другими словами, что такое P (T | B), вероятность того, что террорист был обнаружен при звонке в колокол? Кто-то, делающий «ошибку базовой ставки», сделает вывод о том, что с вероятностью 99% обнаруженный человек является террористом. Хотя этот вывод кажется логичным, на самом деле это неверное рассуждение, и приведенный ниже расчет покажет, что вероятность того, что они террористы, на самом деле составляет около 1%, а не около 99%.

Заблуждение возникает из-за смешения природы двух разных уровней отказов. «Количество не-колоколов на 100 террористов» и «количество нетеррористов на 100 колоколов» не связаны между собой. Один не обязательно равен другому, и они даже не обязательно должны быть почти равными. Чтобы продемонстрировать это, представьте, что произойдет, если во втором городе, где террористов вообще нет, была бы установлена идентичная система сигнализации. Как и в первом городе, тревога звучит для 1 из каждых 100 обнаруженных жителей, не являющихся террористами, но, в отличие от первого города, тревога никогда не звучит для террористов. Таким образом, 100% всех случаев срабатывания сигнализации относятся к нетеррористам, но ложноотрицательный показатель даже не может быть подсчитан. «Число нетеррористов на 100 колоколов» в этом городе равно 100, но P (T | B) = 0%. При звонке в колокол вероятность того, что террорист был обнаружен, равна нулю.

Представьте себе, что перед камерой проходит весь миллион жителей первого города. Около 99 из 100 террористов вызовут тревогу, равно как и около 9 999 из 999 900 нетеррористов. Таким образом, тревогу сработают около 10 098 человек, среди которых около 99 — террористы. Таким образом, вероятность того, что человек, вызвавший тревогу, на самом деле является террористом, составляет всего около 99 из 10 098, что меньше 1% и очень, очень сильно ниже нашего первоначального предположения в 99%.

Ошибка базовой ставки в этом примере вводит в заблуждение, потому что нетеррористов намного больше, чем террористов, а количество ложных срабатываний (нетеррористы сканируются как террористы) намного больше, чем истинных срабатываний ( реальное количество террористов).

Выводы по психологии

В ходе экспериментов было обнаружено, что люди предпочитают индивидуальную информацию общей информации, когда первая доступна.

В некоторых экспериментах студентов просили оценить средний балл (GPA) гипотетических студентов. Получая соответствующую статистику о распределении среднего балла, учащиеся, как правило, игнорировали ее, если давали описательную информацию о конкретном учащемся, даже если новая описательная информация явно не имела отношения к успеваемости в школе или не имела никакого отношения к ней. Этот вывод был использован, чтобы доказать, что собеседования являются ненужной частью процесса поступления в колледж, потому что интервьюеры не могут выбрать успешных кандидатов лучше, чем базовая статистика.

Психологи Дэниел Канеман и Амос Тверски попытались объяснить это открытие с помощью простого правила или «эвристики», называемого репрезентативностью.. Они утверждали, что многие суждения, касающиеся вероятности или причины и следствия, основаны на том, насколько одно репрезентативно для другого или для категории. Канеман считает, что пренебрежение базовой ставкой является особой формой пренебрежения расширением. Ричард Нисбетт утверждал, что некоторые предубеждения при атрибуции, такие как фундаментальная ошибка атрибуции являются примерами ошибки базовой ставки: люди не используют «консенсусную информацию» («базовую оценку») о том, как другие вели себя в аналогичных ситуациях, а вместо этого предпочитают более простые диспозиционные атрибуции.

В психологии ведутся серьезные споры об условиях, при которых люди ценят или не ценят информацию о базовой ставке. Исследователи программы эвристики и систематических ошибок подчеркнули эмпирические данные, показывающие, что люди склонны игнорировать базовые ставки и делать выводы, нарушающие определенные нормы вероятностного рассуждения, такие как теорема Байеса. Вывод, сделанный на основании этого направления исследований, заключался в том, что вероятностное мышление человека в корне ошибочно и подвержено ошибкам. Другие исследователи подчеркнули связь между когнитивными процессами и форматами информации, утверждая, что такие выводы обычно не являются обоснованными.

Еще раз рассмотрим пример 2, приведенный выше. Требуемый вывод заключается в оценке (апостериорной) вероятности того, что (случайно выбранный) водитель находится в состоянии алкогольного опьянения, при условии, что тест алкотестера положительный. Формально эту вероятность можно рассчитать с помощью теоремы Байеса, как показано выше. Однако существуют разные способы представления соответствующей информации. Рассмотрим следующий формально эквивалентный вариант проблемы:

- 1 из 1000 водителей водит машину в нетрезвом виде. Алкотестеры никогда не перестают определять по-настоящему пьяного человека. Для 50 из 999 водителей, не находящихся в состоянии алкогольного опьянения, алкотестер ложно показывает состояние опьянения. Предположим, полицейские наугад останавливают водителя и заставляют его пройти тест алкотестера. Это указывает на то, что они пьяны. Мы предполагаем, что вы ничего о них не знаете. Насколько высока вероятность, что они действительно пьяны?

В этом случае соответствующая числовая информация — p (пьяный), p (D | пьяный), p (D | трезвый) — представлена в виде собственных частот относительно к определенному эталонному классу (см. проблема эталонного класса ). Эмпирические исследования показывают, что выводы людей в большей степени соответствуют правилу Байеса, когда информация представлена таким образом, что помогает преодолеть пренебрежение базовой оценкой со стороны непрофессионалов и экспертов. Как следствие, такие организации, как Cochrane Collaboration, рекомендуют использовать такой формат для передачи статистики здравоохранения. Учить людей переводить подобные байесовские задачи мышления в форматы собственных частот более эффективно, чем просто учить их подставлять вероятности (или проценты) в теорему Байеса. Также было показано, что графическое представление собственных частот (например, массив значков) помогает людям делать более точные выводы.

Почему полезны форматы собственных частот? Одна из важных причин заключается в том, что этот формат информации облегчает требуемый вывод, поскольку упрощает необходимые вычисления. Это можно увидеть, используя альтернативный способ вычисления требуемой вероятности p (пьяный | D):

- p (пьян ∣ D) = N (пьян ∩ D) N (D) = 1 51 = 0,0196 { displaystyle p ( mathrm {drunk} mid D) = { frac {N ( mathrm {drunk} cap D)} {N (D)}} = { frac {1} {51}} = 0,0196}

где N (пьяный ∩ D) обозначает количество пьяных водителей, получивших положительный результат алкотестера, а N (D) обозначает общее количество случаев с положительным результатом алкотестера. Эквивалентность этого уравнения предыдущему следует из аксиом теории вероятностей, согласно которой N (drunk ∩ D) = N × p (D | drunk) × p (drunk). Важно отметить, что хотя это уравнение формально эквивалентно правилу Байеса, психологически оно не эквивалентно. Использование собственных частот упрощает вывод, поскольку требуемая математическая операция может выполняться с натуральными числами, а не с нормализованными дробями (т. Е. Вероятностями), поскольку это делает большое количество ложных срабатываний более прозрачным, и поскольку собственные частоты демонстрируют «вложенный набор» структура «.

Не каждый частотный формат позволяет использовать байесовские рассуждения. Собственные частоты относятся к информации о частоте, которая является результатом естественной выборки, которая сохраняет информацию о базовой скорости (например, количество пьяных водителей при выборке случайной выборки водителей). Это отличается от систематической выборки, в которой базовые ставки фиксируются априори (например, в научных экспериментах). В последнем случае невозможно вывести апостериорную вероятность p (пьяный | положительный тест) из сравнения количества пьяных водителей с положительным результатом теста по сравнению с общим количеством людей, получивших положительный результат алкотестера, потому что информация о базовой скорости не сохраняется и должен быть явно повторно введен с использованием теоремы Байеса.

См. Также

- Байесовская вероятность

- Теорема Байеса

- Извлечение данных

- Индуктивный аргумент

- Список когнитивных предубеждений

- Список парадоксов

- Вводящая в заблуждение яркость

- Парадокс предотвращения

- Заблуждение прокурора, ошибка в рассуждениях, включающая игнорирование низкой априорной вероятности

- парадокса Симпсона, еще одна ошибка в статистических рассуждениях, касающихся сравнения групп

- стереотип

Ссылки

Внешние ссылки

- Ошибка базовой ставки Файлы ошибок

Пару дней назад я опубликовал в группе RationalAnswer ВКонтакте несложную, казалось бы, задачку. Привожу ее здесь целиком:

Давайте представим, что в вашей инвестиционной вселенной есть только два доступных инструмента – условно безрисковые облигации и условно рискованные акции. Облигации каждый год гарантированно приносят доходность 5%. Акции же обычно приносят доход в размере 30%, но не всегда: в 5% случаев (то есть, примерно раз в 20 лет) наступает кризис, и акции падают в цене на те же 30%.

Перед вами стоит выбор – в какой из инструментов вложить накопленный миллион рублей. Внезапно вам звонит друг – известный финансовый аналитик – и говорит, что по его прогнозу в этом году ожидается крах рынка акций. Вы знаете, что ваш друг – умный человек, но на всякий случай решаете проверить точность его прогнозов (к счастью, их архив доступен аж за сто последних лет). Проверив все его предыдущие предсказания, вы обнаруживаете, что средняя их точность составляет 80%: то есть, если взять все годы, когда рынок в итоге падал, то он правильно предсказал 80% из них; аналогично, если рассмотреть все годы роста рынка акций, то из них аналитик предугадал так же 80%.

Внимание, вопрос: в какой из двух инструментов вы вложитесь в этом году? В дополнение к этому, посчитайте пожалуйста ожидаемую доходность рынка акций на год вперед, исходя из всей имеющейся информации.

Прежде чем читать дальше, потратьте одну-две минуты на то, чтобы прикинуть, какой ответ вам кажется наиболее логичным.

Парадокс незадачливого предсказателя

На первый взгляд, правильное решение кажется очевидным. Если эксперт предсказывает крах фондового рынка, и он оказывается прав в 80% случаев – то от акций нужно держаться как можно дальше. В конце концов, математическое ожидание их доходности получается отрицательным: –30% х 0,8 + 30% х 0,2 = –18%. Несмотря на то, что в целом рынок акций по условиям задачи является довольно стабильным (падает всего в 5% случаев), новая полученная информация про конкретный год заставляет нас предпочесть более безопасный (хоть и гораздо менее доходный в среднем) актив. Логично?

Не совсем. Давайте разбираться на примере исторического «послужного списка» нашего аналитика. По условиям задачи, за прошедшие 100 лет должно было произойти 5 крахов и 95 успешных для акций лет. Из 5 крахов аналитик предсказал 4 (80%), и для 1 случая ошибся. Из 95 доходных лет эксперт предсказал 76 (тоже 80%), и для 19 доходных периодов он ошибочно предрекал падение рынка. Чуете, куда дует ветер? Если сложить вместе все периоды, когда аналитик предсказывал падение рынка (4 + 19 = 23), то правильными из этих предсказаний окажется всего 17% (4 из 23).

То есть, аналитик легко мог добиться точности своих предсказаний в 95%, если все 100 лет всегда предсказывал бы неизменную доходность рынка на уровне +30%. Но это показалось ему неинтересным, поэтому он периодически пытался спрогнозировать крах – он действительно смог поймать большинство из них (4 из 5), но ценой того, что множество раз (19) предсказывал крах, которого не происходило. Общая же совокупная точность всех его прогнозов в результате снизилась с 95% до 80%.

Таким образом, даже зная отрицательный прогноз нашего «умного» аналитика, вероятность убыточного ближайшего года поднимается с 5% до всего лишь 17%, а не 80%, как хочется предположить интуитивно. И ожидаемая доходность рынка акций составляет –30% х 0,17 + 30% х 0,83 = 20%. В четыре раза больше, чем доходность по облигациям в размере 5%! Мне кажется, выбор инвестиционного актива в данном случае напрашивается довольно однозначный.

Что такое ошибка базового уровня

Если вы решили задачу выше неправильно, не расстраивайтесь: человеческий мозг очень плохо интуитивно понимает статистику и вероятности, поэтому большинство людей ошибаются в подобных ситуациях. Даже среди практикующих врачей (уж точно проходивших курс статистики в колледже) согласно некоторым исследованиям только примерно 20% могут найти правильный ответ.

В общем случае ошибка базового уровня формулируется следующим образом: это ошибка в мышлении, когда сталкиваясь с общей информацией о частоте некоторого события (базовый уровень) и специфической информацией об этом событии, человек имеет склонность игнорировать первое и фокусироваться на втором.

Мы этого чаще всего не замечаем, но ошибка базового уровня может мешать вам принимать правильные решения в целом ряде областей, которые так или иначе связаны со случайностью и вероятностями. Назову лишь несколько примеров:

- Медицина: если вы проходили скрининг на выявление какого-либо заболевания, которое встречается примерно в 1% случаев (базовый уровень), и тест с точностью 90% показал положительный результат (наличие болезни), то еще не все пропало. Вероятность того, что вы действительно больны, составляет всего 10% (необходимо делать дополнительные, более точные тесты).

- ЗОЖ: если курение сокращает продолжительность жизни в среднем на 10 лет, то не стоит считать, что к вам это не будет относиться, так как ваш дед «курил до 80 лет, и ему всё было нипочем».

- Азартные игры: игрок в рулетку, который выиграл несколько раз подряд, начинает верить в свою «полосу везения» – вместо того, чтобы действовать в соответствии с базовой вероятностью выиграть у казино (увы, крайне невысокой).

- Инвестиции: люди склонны игнорировать тот факт, что акции приносят наибольшую долгосрочную доходность, и вкладывают деньги либо в то, что росло в последние несколько лет (биткоины?), либо в более безопасные, но низкодоходные активы («в этом году рынок акций упадет, уж лучше пусть мои деньги на депозите полежат»).

Как избежать ошибки?

Жизнь, к сожалению, гораздо сложнее любых задач – вам практически никогда не выдадут в разделе «дано» все необходимые данные, чтобы «вычислить» правильный ответ исходя из теории вероятностей. Поэтому я не буду советовать вам изучать статистику, учиться применять теорему Байеса и всякие другие вещи (делать которые вы все равно, конечно, не будете).

Но попробовать немного поменять свое мышление, мне кажется, будет полезным. В следующий раз, когда вы будете рассматривать какую-либо ситуацию, требующую принятия решения в условиях неопределенности, начните с другого конца: не со специфической информации, а с базового уровня. Попробуйте выяснить, чего стоит ожидать по данному вопросу на очень больших выборках, на очень длинных промежутках времени. И примите это как базовую точку прогноза того, чего стоит ожидать лично вам.

Если у вас есть какая-либо дополнительная специфическая информация – ее тоже можно учесть, но чаще всего она не должна кардинально поменять ситуацию по сравнению с базовым уровнем. Помните, что люди всегда склонны переоценивать влияние специфических факторов – поэтому, если вам хочется на их основании не чуть-чуть сдвинуть чашу весов, а полностью поменять их баланс, то в этот момент нужно проявить особую ментальную бдительность.

(Visited 4 170 times, 1 visits today)

Ошибка базовой ставки , также называемая пренебрежением базовой ставкой [1] или предвзятостью базовой ставки , является типом ошибки . При представлении связанной базовой информации (т. е. общей информации о распространенности) и конкретной информации (т. е. информации, относящейся только к конкретному случаю) люди, как правило, игнорируют базовую частоту в пользу индивидуализирующей информации, вместо того чтобы правильно интегрировать две эти информации. . [2]

Пренебрежение базовой ставкой является особой формой более общего пренебрежения расширением .

Ложноположительный парадокс

Примером ошибки базовой ставки является парадокс ложного срабатывания . Этот парадокс описывает ситуации, когда ложноположительных результатов теста больше, чем истинно положительных. Например, если камера распознавания лиц может идентифицировать разыскиваемых преступников с точностью 99%, но анализирует 10 000 человек в день, высокая точность перевешивается количеством тестов, и в списке преступников программы, вероятно, будет гораздо больше ложных срабатываний, чем истинных. Вероятность положительного результата теста определяется не только точностью теста, но и характеристиками выборочной совокупности. [3] Когда распространенность, доля тех, у кого есть данное заболевание, ниже, чем ложноположительный результат теста .скорость, даже тесты, которые имеют очень низкую вероятность дать ложноположительный результат в отдельном случае , в целом дадут больше ложноположительных результатов, чем истинноположительных . [4] Этот парадокс удивляет большинство людей. [5]

Это особенно нелогично при интерпретации положительного результата теста в популяции с низкой распространенностью после того, как вы имели дело с положительными результатами, полученными в популяции с высокой распространенностью. [4] Если частота ложноположительных результатов теста выше, чем доля новой популяции с этим заболеванием, то администратор теста, имеющий опыт тестирования в популяции с высокой распространенностью, может на основании своего опыта сделать вывод , что положительный результат теста обычно указывает на положительный объект, когда на самом деле гораздо более вероятно, что ложный положительный результат имел место.

Примеры

Пример 1: Болезнь

высокой

| Количество человек |

Зараженный | Незараженный | Всего |

|---|---|---|---|

Положительный тест |

400 (истинно положительный) |

30 (ложноположительный результат) |

430 |

| Тест отрицательный |

0 (ложноотрицательный) |

570 (истинно отрицательный) |

570 |

| Всего |

400 | 600 |

1000 |

Представьте себе проведение теста на инфекционное заболевание в популяции А из 1000 человек, из которых 40% инфицированы. Тест имеет ложноположительный уровень 5% (0,05) и не имеет ложноотрицательного результата. Ожидаемый результат 1000 тестов на популяции А будет следующим:

- Инфицирован и тест указывает на заболевание ( истинно положительный )

- 1000 ×40/100= 400 человек получили бы настоящий положительный результат

- Неинфицированный и тест указывает на заболевание (ложноположительный)

- 1000 ×100 – 40/100× 0,05 = 30 человек получат ложноположительный результат

- Остальные 570 тестов правильно отрицательные.

Таким образом, в популяции А человек, получивший положительный результат теста, может быть уверен более чем на 93% (400/30 + 400), что это правильно указывает на инфекцию.

низкой

| Количество человек |

Зараженный | Незараженный | Всего |

|---|---|---|---|

Положительный тест |

20 (истинно положительный) |

49 (ложноположительный) |

69 |

| Тест отрицательный |

0 (ложноотрицательный) |

931 (истинно отрицательный) |

931 |

| Всего |

20 | 980 |

1000 |

Теперь рассмотрим тот же тест, примененный к популяции B , в которой инфицировано только 2%. Ожидаемый результат 1000 тестов на популяции B будет следующим:

- Инфицирован и тест указывает на заболевание ( истинно положительный )

- 1000 ×2/100= 20 человек получат истинно положительный

- Неинфицированный и тест указывает на заболевание (ложноположительный)

- 1000 ×100 – 2/100× 0,05 = 49 человек получат ложноположительный результат

- Остальные 931 (= 1000 — (49 + 20)) тесты правильно отрицательные.

В популяции B только 20 из 69 человек с положительным результатом теста действительно инфицированы. Таким образом, вероятность действительно заразиться после того, как человеку сказали, что он заражен, составляет всего 29% (20/20 + 49) для теста, который в противном случае кажется «95% точным».

Тестер, имеющий опыт работы с группой А , может счесть парадоксом то, что в группе В результат, который обычно правильно указывал на инфекцию, теперь обычно оказывается ложноположительным . Смешение апостериорной вероятности заражения с априорной вероятностью получения ложноположительного результата является естественной ошибкой после получения опасного для здоровья результата теста.

Пример 2: Пьяные водители

- У группы полицейских есть алкотестер , показывающий ложное опьянение в 5% случаев, когда водитель трезв. Тем не менее, алкотестеры всегда обнаруживают действительно пьяного человека. Один из тысячи водителей ездит пьяным. Предположим, что полицейские затем останавливают водителя наугад, чтобы провести тест на алкотестер. Это говорит о том, что водитель пьян. Мы предполагаем, что вы больше ничего о них не знаете. Насколько высока вероятность того, что они действительно пьяны?

Многие ответили бы, что 95 %, но правильная вероятность составляет около 2 %.

Объяснение этому следующее: в среднем на каждую 1000 протестированных водителей

- 1 водитель пьян, и на 100% уверен, что для этого водителя действительно положительный результат теста, поэтому есть 1 истинно положительный результат теста

- 999 водителей не пьяны, и среди этих водителей 5% ложноположительных результатов тестов, то есть 49,95 ложноположительных результатов тестов

Следовательно, вероятность того, что один из водителей среди 1 + 49,95 = 50,95 положительных результатов теста действительно пьян, равна.

Однако достоверность этого результата зависит от достоверности первоначального предположения о том, что полицейский остановил водителя действительно наугад, а не из-за плохого вождения. Если та или иная непроизвольная причина остановки водителя присутствовала, то в расчет также включается вероятность того, что водитель в нетрезвом виде управлял транспортным средством грамотно, а водитель в нетрезвом виде управлял (не)грамотно.

Более формально ту же вероятность примерно 0,02 можно установить с помощью теоремы Байеса . Цель состоит в том, чтобы найти вероятность того, что водитель пьян, учитывая, что алкотестер показал, что он пьян, что можно представить в виде

где D означает, что алкотестер показывает, что водитель пьян. Теорема Байеса говорит нам, что

В первом абзаце нам сказали следующее:

- а также

Как видно из формулы, для теоремы Байеса требуется p ( D ), которую можно вычислить из предыдущих значений, используя закон полной вероятности :

который дает

Подставляя эти числа в теорему Байеса, можно обнаружить, что

Пример 3: Идентификация террориста

Пусть в городе с миллионным населением будет 100 террористов и 999 900 нетеррористов. Для упрощения примера предполагается, что все люди, присутствующие в городе, являются его жителями. Таким образом, базовая вероятность того, что случайно выбранный житель города окажется террористом, равна 0,0001, а базовая вероятность того, что тот же житель не является террористом, равна 0,9999. Пытаясь поймать террористов, город устанавливает систему сигнализации с камерой наблюдения и программным обеспечением для автоматического распознавания лиц .

Программное обеспечение имеет две частоты отказов по 1%:

- Частота ложноотрицательных результатов: если камера сканирует террориста, в 99% случаев прозвенит звонок, а в 1% случаев он не прозвонит.

- Частота ложных срабатываний: если камера сканирует нетеррориста, звонок не будет звонить в 99% случаев, но он будет звонить в 1% случаев.

Предположим теперь, что житель включает тревогу. Какова вероятность того, что этот человек террорист? Другими словами, какова вероятность P(T | B) обнаружения террориста при звонке в колокол? Кто-то, делающий «ошибку базовой ставки», сделает вывод, что с вероятностью 99% обнаруженный человек является террористом. Хотя вывод кажется логичным, на самом деле это ошибочное рассуждение, и приведенный ниже расчет покажет, что вероятность того, что они террористы, на самом деле составляет около 1%, а не около 99%.

Заблуждение возникает из-за смешения природы двух разных коэффициентов отказов. «Количество незвонков на 100 террористов» и «количество нетеррористов на 100 колоколов» — не связанные между собой величины. Одно не обязательно равно другому, и они даже не обязательно должны быть почти равными. Чтобы показать это, представьте, что произойдет, если идентичная система сигнализации будет установлена во втором городе, где вообще нет террористов. Как и в первом городе, тревога звучит для 1 из каждых 100 обнаруженных нетеррористических жителей, но, в отличие от первого города, для террориста тревога не звучит никогда. Таким образом, 100% всех случаев срабатывания сигнализации приходится на нетеррористов, а процент ложных срабатываний даже не подсчитывается. «Количество нетеррористов на 100 колоколов» в этом городе равно 100, но P(T | B) = 0%.

Представьте, что перед камерой проходит весь первый город с населением в один миллион человек. Около 99 из 100 террористов поднимут тревогу, как и около 9 999 из 999 900 нетеррористов. Таким образом, тревогу вызовут около 10 098 человек, среди которых около 99 будут террористами. Таким образом, вероятность того, что человек, поднявший тревогу, на самом деле является террористом, составляет всего около 99 из 10 098, что составляет менее 1% и очень, очень много ниже нашего первоначального предположения в 99%.

Ошибка базового уровня в этом примере настолько вводит в заблуждение, потому что нетеррористов гораздо больше, чем террористов, а количество ложных срабатываний (нетеррористов, отсканированных как террористы) намного больше, чем истинных срабатываний (террористов, отсканированных как террористы).

Находки в психологии

В экспериментах было обнаружено, что люди предпочитают индивидуальную информацию общей информации, когда первая доступна. [6] [7] [8]

В некоторых экспериментах студентов просили оценить средние баллы (GPA) гипотетических студентов. Когда учащиеся получали релевантные статистические данные о распределении среднего балла, они, как правило, игнорировали их, если им давали описательную информацию о конкретном учащемся, даже если новая описательная информация явно не имела никакого отношения к успеваемости в школе. [7] Этот вывод использовался для утверждения, что собеседования являются ненужной частью процесса приема в колледж , потому что интервьюеры не могут выбрать успешных кандидатов лучше, чем базовая статистика.

Психологи Дэниел Канеман и Амос Тверски попытались объяснить это открытие с помощью простого правила или «эвристики» , называемой репрезентативностью . Они утверждали, что многие суждения, касающиеся вероятности или причины и следствия, основаны на том, насколько одна вещь репрезентативна для другой или категории. [7] Канеман считает пренебрежение базовой ставкой особой формой пренебрежения расширением . [9] Ричард Нисбетт утверждал, что некоторые предубеждения атрибуции , такие как фундаментальная ошибка атрибуцииявляются примерами ошибки базовой нормы: люди не используют «консенсусную информацию» («базовую норму») о том, как другие вели себя в подобных ситуациях, и вместо этого предпочитают более простые диспозиционные атрибуции . [10]

В психологии ведутся серьезные споры об условиях, при которых люди ценят или не ценят информацию о базовой норме. [11] [12] Исследователи программы «Эвристика и предубеждения» подчеркивают эмпирические данные, показывающие, что люди склонны игнорировать базисные нормы и делать выводы, нарушающие определенные нормы вероятностных рассуждений, такие как теорема Байеса . Вывод, сделанный из этого направления исследований, заключался в том, что человеческое вероятностное мышление в корне ошибочно и подвержено ошибкам. [13] Другие исследователи подчеркивали связь между когнитивными процессами и информационными форматами, утверждая, что такие выводы обычно необоснованны. [14] [15]

Рассмотрим снова Пример 2 сверху. Требуемый вывод состоит в том, чтобы оценить (апостериорную) вероятность того, что (выбранный случайным образом) водитель пьян, при условии, что тест алкотестера положительный. Формально эту вероятность можно вычислить с помощью теоремы Байеса , как показано выше. Однако существуют различные способы представления соответствующей информации. Рассмотрим следующий формально эквивалентный вариант задачи:

- 1 из 1000 водителей ездит пьяным. Алкотестеры всегда обнаруживают действительно пьяного человека. У 50 из 999 непьющих водителей алкотестер ложно показывает состояние опьянения. Предположим, что затем полицейские наугад останавливают водителя и заставляют его пройти тест на содержание алкоголя в крови. Это указывает на то, что они пьяны. Мы предполагаем, что вы больше ничего о них не знаете. Насколько высока вероятность того, что они действительно пьяны?

В этом случае соответствующая числовая информация — p (пьяный), p ( D | пьяный), p ( D | трезвый) — представлена в терминах собственных частот по отношению к определенному эталонному классу (см . Проблема эталонного класса ). Эмпирические исследования показывают, что выводы людей более точно соответствуют правилу Байеса, когда информация представлена таким образом, что помогает преодолеть игнорирование базовых показателей у неспециалистов [15] и экспертов. [16] Как следствие, такие организации, как Cochrane Collaboration , рекомендуют использовать такой формат для передачи статистики здравоохранения. [17]Научить людей переводить такого рода байесовские логические задачи в форматы с естественной частотой более эффективно, чем просто научить их подставлять вероятности (или проценты) в теорему Байеса. [18] Также было показано, что графическое представление собственных частот (например, массивы значков) помогает людям делать более точные выводы. [18] [19] [20]

Чем полезны форматы собственных частот? Одна важная причина заключается в том, что этот формат информации облегчает требуемый вывод, поскольку упрощает необходимые вычисления. Это можно увидеть при использовании альтернативного способа вычисления искомой вероятности p (пьяный | D ):

где N (пьяный ∩ D ) обозначает количество пьяных водителей с положительным результатом алкотестера, а N ( D ) обозначает общее количество случаев с положительным результатом алкотестера. Эквивалентность этого уравнения приведенному выше следует из аксиом теории вероятностей, согласно которым N (пьяный ∩ D ) = N × p ( D | пьяный) × p(пьяный). Важно отметить, что хотя это уравнение формально эквивалентно правилу Байеса, психологически оно не эквивалентно ему. Использование собственных частот упрощает вывод, потому что требуемая математическая операция может выполняться над натуральными числами вместо нормализованных дробей (т. структура». [21] [22]

Не каждый частотный формат облегчает байесовские рассуждения. [22] [23] Собственные частоты относятся к информации о частоте, полученной в результате естественной выборки , [24] которая сохраняет информацию о базовой частоте (например, количество пьяных водителей при взятии случайной выборки водителей). Это отличается от систематической выборки , в которой базовые уровни фиксированы априори (например, в научных экспериментах). В последнем случае невозможно вывести апостериорную вероятность p(пьяный | положительный тест) из сравнения количества пьяных водителей с положительным результатом теста по сравнению с общим количеством людей, получивших положительный результат алкотестера, поскольку информация о базовом уровне не сохраняется и должна быть явно повторно введена с использованием теоремы Байеса. .

Смотрите также

- Базовая ставка

- Байесовская вероятность

- теорема Байеса

- Выемка данных

- Индуктивный аргумент

- Список когнитивных искажений

- Список парадоксов

- Обманчивая яркость

- Парадокс предотвращения

- Ошибка прокурора , ошибка в рассуждениях, связанная с игнорированием низкой априорной вероятности .

- Парадокс Симпсона , еще одна ошибка в статистических рассуждениях при сравнении групп .

- Стереотип

- Интуитивная статистика

Ссылки

- ^ Валлийский, Мэтью Б.; Наварро, Дэниел Дж. (2012). «Видеть — значит верить: Приоры, доверие и пренебрежение базовой ставкой» . Организационное поведение и процессы принятия решений человеком . 119 (1): 1–14. doi : 10.1016/j.obhdp.2012.04.001 . hdl : 2440/41190 . ISSN 0749-5978 .

- ^ «Логическая ошибка: ошибка базовой ставки» . Fallacyfiles.org . Проверено 15 июня 2013 г. .

- ^ Райнфурт, Массачусетс; Хауэлл, LW (март 1998 г.). Вероятность и статистика в аэрокосмической технике (PDF) . НАСА . п. 16.

СООБЩЕНИЕ: Ложноположительные тесты более вероятны, чем истинно положительные тесты, когда распространенность заболевания в общей популяции низкая.

Это называется ложноположительным парадоксом.

- ^ a b Vacher, HL (май 2003 г.). «Количественная грамотность — тестирование на наркотики, скрининг рака и идентификация магматических пород» . Journal of Geoscience Education : 2.

На первый взгляд, это кажется извращенным: чем меньше студентов в целом используют

стероиды

, тем больше вероятность того, что студент, идентифицированный как пользователь, не будет их употреблять.

Это было названо парадоксом ложных срабатываний.

— Цитирование: Гоник, Л.; Смит, В. (1993). Карикатурный путеводитель по статистике . Нью-Йорк: Харпер Коллинз. п. 49.

- ↑ Мэдисон, Б.Л. (август 2007 г.). «Математические способности для гражданства» . В Schoenfeld, AH (ред.). Оценка математических способностей . Публикации Научно-исследовательского института математических наук (новое изд.). Издательство Кембриджского университета. п. 122. ISBN 978-0-521-69766-8.

Правильная [оценка вероятности…] многих удивляет; отсюда и термин парадокс .

- ^ Бар-Хиллель, Майя (1980). «Ошибка базовой нормы в вероятностных суждениях» (PDF) . Acta Psychologica . 44 (3): 211–233. doi : 10.1016/0001-6918(80)90046-3 .

- ^ a b c Канеман, Дэниел; Амос Тверски (1973). «О психологии предсказания». Психологический обзор . 80 (4): 237–251. дои : 10.1037/h0034747 . S2CID 17786757 .