Привет, Хабр!

Мы, в компании NtechLab, занимаемся исследованиями и разработкой продуктов в области распознавания лиц. В процессе внедрения наших решений мы часто сталкиваемся с тем, что заказчики не очень ясно представляют себе требования к точности алгоритма, поэтому и тестирование того или иного решения для их задачи даётся с трудом. Чтобы исправить ситуацию, мы разработали краткое пособие, описывающее основные метрики и подходы к тестированию, которыми хотелось бы поделиться с сообществом Хабра.

В последнее время распознавание лиц вызывает все больше интереса со стороны коммерческого сектора и государства. Однако корректное измерение точности работы таких систем – задача непростая и содержит массу нюансов. К нам постоянно обращаются с запросами на тестирование нашей технологии и пилотными проектами на ее основе, и мы заметили, что часто возникают вопросы с терминологией и методами тестирования алгоритмов применительно к бизнес-задачам. В результате для решения задачи могут быть выбраны неподходящие инструменты, что приводит к финансовым потерям или недополученной прибыли. Мы решили опубликовать эту заметку, чтобы помочь людям освоиться в среде специализированных терминов и сырых данных, окружающих технологии распознавания лиц. Нам хотелось рассказать об основных понятиях в этой области простым и понятным языком. Надеемся, это позволит людям технического и предпринимательского склада говорить на одном языке, лучше понимать сценарии использования распознавания лиц в реальном мире и принимать решения, подтвержденные данными.

Задачи распознавания лиц

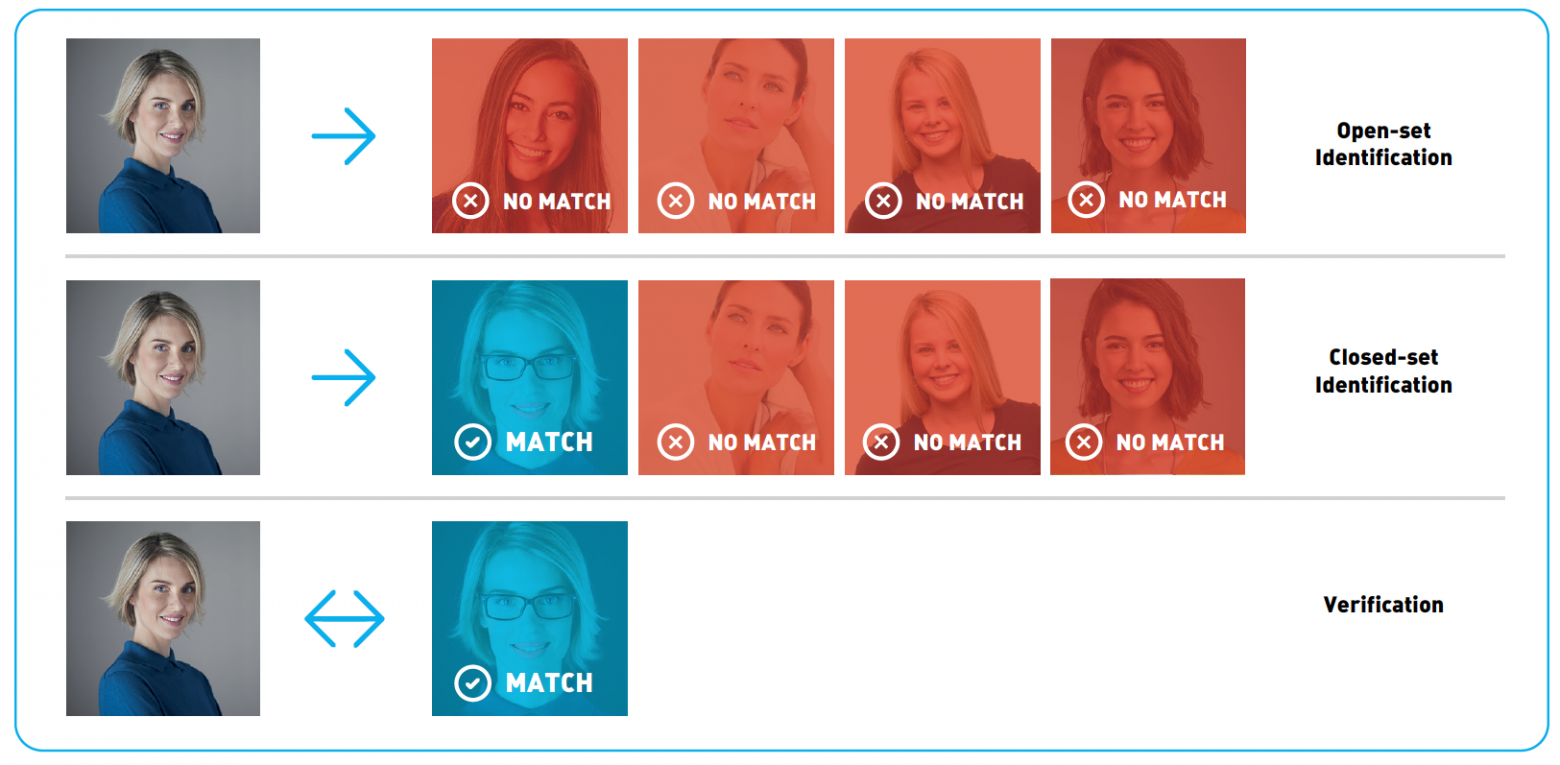

Распознаванием лиц часто называют набор различных задач, например, детектирование лица на фотографии или в видеопотоке, определение пола и возраста, поиск нужного человека среди множества изображений или проверка того, что на двух изображениях один и тот же человек. В этой статье мы остановимся на последних двух задачах и будем их называть, соответственно, идентификация и верификация. Для решения этих задач из изображений извлекаются специальные дескрипторы, или векторы признаков. В этом случае задача идентификации сводится к поиску ближайшего вектора признаков, а верификацию можно реализовать с помощью простого порога расстояний между векторами. Комбинируя эти два действия, можно идентифицировать человека среди набора изображений или принимать решение о том, что его нет среди этих изображений. Такая процедура называется open-set identification (идентификацией на открытом множестве), см. Рис.1.

Рис.1 Open-set identification

Для количественной оценки схожести лиц можно использовать расстояние в пространстве векторов признаков. Часто выбирают евклидово или косинусное расстояние, но существуют и другие, более сложные, подходы. Конкретная функция расстояния часто поставляется в составе продукта по распознаванию лиц. Идентификация и верификация возвращают разные результаты и, соответственно, разные метрики применяются для оценки их качества. Мы подробно рассмотрим метрики качества в последующих разделах. Помимо выбора адекватной метрики, для оценки точности алгоритма понадобится размеченный набор изображений (датасет).

Оценка точности

Датасеты

Почти всё современное ПО для распознавания лиц построено на машинном обучении. Алгоритмы обучаются на больших датасетах (наборах данных) с размеченными изображениями. И качество, и природа этих датасетов оказывают существенное влияние на точность. Чем лучше исходные данные, тем лучше алгоритм будет справляться с поставленной задачей.

Естественный способ проверить, что точность алгоритма распознавания лиц соответствует ожиданиям, это измерить точность на отдельном тестовом датасете. Очень важно правильно выбрать этот датасет. В идеальном случае организации стоит обзавестись собственным набором данных, максимально похожим на те изображения, с которыми система будет работать при эксплуатации. Обратите внимание на камеру, условия съемки, возраст, пол и национальность людей, которые попадут в тестовый датасет. Чем более похож тестовый датасет на реальные данные, тем более достоверными будут результаты тестирования. Поэтому часто имеет смысл потратить время и средства для сбора и разметки своего набора данных. Если же это, по какой-то причине, не представляется возможным, можно воспользоваться публичными датасетами, например, LFW и MegaFace. LFW содержит только 6000 пар изображений лиц и не подходит для многих реальных сценариев: в частности, на этом датасете невозможно измерить достаточно низкие уровни ошибок, как мы покажем далее. Датасет MegaFace содержит намного больше изображений и подходит для тестирования алгоритмов распознавания лиц на больших масштабах. Однако и обучающее, и тестовое множество изображений MegaFace’a есть в открытом доступе, поэтому использовать его для тестирования следует с осторожностью.

Альтернативный вариант заключается в использовании результатов тестирования третьим лицом. Такие тестирования проводятся квалифицированными специалистами на больших закрытых датасетах, и их результатам можно доверять. Одним из примеров может служить NIST Face Recognition Vendor Test Ongoing. Это тест, проводимый Национальным Институтом Стандартов и Технологий (NIST) при Министерстве торговли США. “Минус” данного подхода заключается в том, что датасет организации, проводящей тестирование, может существенно отличаться от интересующего сценария использования.

Переобучение

Как мы говорили, машинное обучение лежит в основе современного ПО для распознавания лиц. Одним из распространенных феноменов машинного обучения является т.н. переобучение. Проявляется он в том, что алгоритм показывает хорошие результаты на данных, которые использовались при обучении, но результаты на новых данных получаются значительно хуже.

Рассмотрим конкретный пример: представим себе клиента, который хочет установить пропускную систему с распознаванием лиц. Для этих целей он собирает набор фотографий людей, которым будет разрешен доступ, и обучает алгоритм отличать их от других людей. На испытаниях система показывает хорошие результаты и внедряется в эксплуатацию. Через некоторое время список людей с допуском решают расширить и обнаруживается, что система отказывает новым людям в доступе. Алгоритм тестировался на тех же данных, что и обучался, и никто не проводил измерения точности на новых фотографиях. Это, конечно, утрированный пример, но он позволяет понять проблему.

В некоторых случаях переобучение проявляется не так явно. Допустим, алгоритм обучался на изображениях людей, где превалировала определенная этническая группа. При применении такого алгоритма к лицам другой национальности его точность наверняка упадет. Излишне оптимистичная оценка точности работы алгоритма из-за неправильно проведенного тестирования – очень распространенная ошибка. Всегда следует тестировать алгоритм на новых данных, которые ему предстоит обрабатывать в реальном применении, а не на тех данных, на которых проводилось обучение.

Резюмируя вышесказанное, составим список рекомендаций: не используйте данные, на которых обучался алгоритм при тестировании, используйте специальный закрытый датасет для тестирования. Если это невозможно и вы собираетесь воспользоваться публичным датасетом, убедитесь, что вендор не использовал его в процессе обучения и/или настройки алгоритма. Изучите датасет перед тестированием, подумайте, насколько он близок к тем данным, которые будут поступать при эксплуатации системы.

Метрики

После выбора датасета, следует определиться с метрикой, которая будет использоваться для оценки результатов. В общем случае метрика – это функция, которая принимает на вход результаты работы алгоритма (идентификации или верификации), а на выходе возвращает число, которое соответствует качеству работы алгоритма на конкретном датасете. Использование одного числа для количественного сравнения разных алгоритмов или вендоров позволяет сжато представлять результаты тестирования и облегчает процесс принятия решений. В этом разделе мы рассмотрим метрики, наиболее часто применяемые в распознавании лиц, и обсудим их значение с точки зрения бизнеса.

Верификация

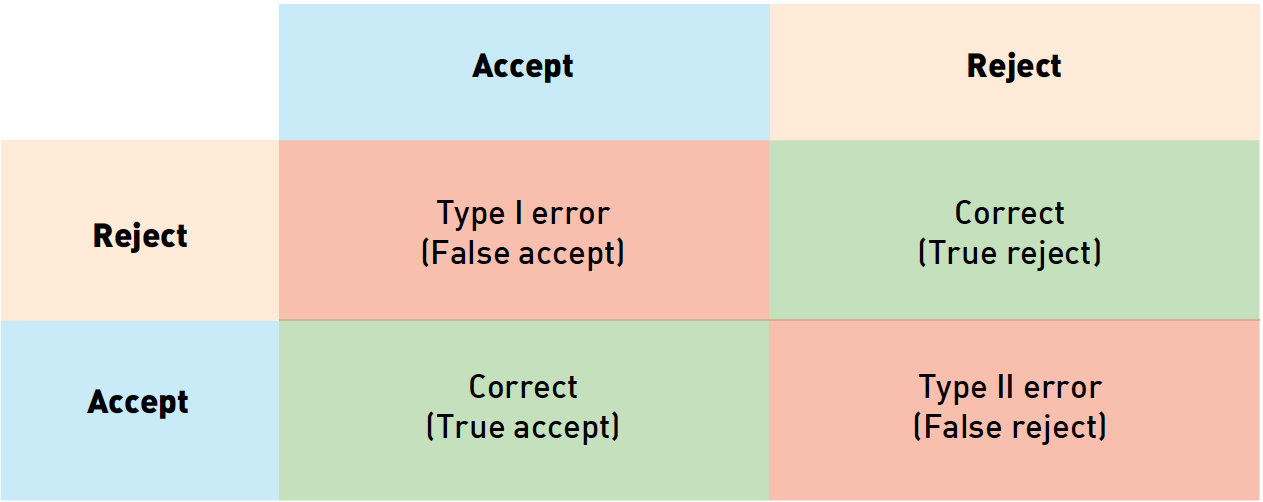

Верификацию лиц можно рассматривать как процесс принятия бинарного решения: “да” (два изображения принадлежат одному человеку), “нет” (на паре фотографий изображены разные люди). Прежде чем разбираться с метриками верификации, полезно понять, как мы можем классифицировать ошибки в подобных задачах. Учитывая, что есть 2 возможных ответа алгоритма и 2 варианта истинного положения вещей, всего возможно 4 исхода:

Рис. 2 Типы ошибок. Цвет фона кодирует истинное отношение между картинками (синий означает “принять”, желтый – “отвергнуть”), цвет рамки соответствует предсказанию алгоритма (синий – “принять”, желтый – “отвергнуть”

В таблице выше столбцы соответствуют решению алгоритма (синий – принять, желтый – отвергнуть), строки соответствуют истинным значениям (кодируются теми же цветами). Правильные ответы алгоритма отмечены зеленым фоном, ошибочные – красным.

Из этих исходов два соответствуют правильным ответам алгоритма, а два – ошибкам первого и второго рода соответственно. Ошибки первого рода называют «false accept», «false positive» или «false match» (неверно принято), а ошибки второго рода – «false reject», «false negative» или «false non-match» (неверно отвергнуто).

Просуммировав количество ошибок разного рода среди пар изображений в датасете и поделив их на количество пар, мы получим false accept rate (FAR) и false reject rate (FRR). В случае с системой контроля доступа «false positive» соответствует предоставлению доступа человеку, для которого этот доступ не предусмотрен, в то время как «false negative» означает, что система ошибочно отказала в доступе авторизованной персоне. Эти ошибки имеют разную стоимость с точки зрения бизнеса и поэтому рассматриваются отдельно. В примере с контролем доступа «false negative» приводит к тому, что сотруднику службы безопасности надо перепроверить пропуск сотрудника. Предоставление неавторизованного доступа потенциальному нарушителю (false positive) может привести к гораздо худшим последствиям.

Учитывая, что ошибки разного рода связаны с различными рисками, производители ПО для распознавания лиц зачастую дают возможность настроить алгоритм так, чтобы минимизировать один из типов ошибок. Для этого алгоритм возвращает не бинарное значение, а вещественное число, отражающее уверенность алгоритма в своем решении. В таком случае пользователь может самостоятельно выбрать порог и зафиксировать уровень ошибок на определенных значениях.

Для примера рассмотрим «игрушечный» датасет из трех изображений. Пусть изображения 1 и 2 принадлежат одному и тому же человеку, а изображение 3 кому-то еще. Допустим, что программа оценила свою уверенность для каждой из трех пар следующим образом:

Мы специально выбрали значения таким образом, чтобы ни один порог не классифицировал все три пары правильно. В частности, любой порог ниже 0.6 приведет к двум false accept (для пар 2-3 и 1-3). Разумеется, такой результат можно улучшить.

Выбор порога из диапазона от 0.6 до 0.85 приведет к тому, что пара 1-3 будет отвергнута, пара 1-2 по-прежнему будет приниматься, а 2-3 будет ложно приниматься. Если увеличить порог до 0.85-0.9, то пара 1-2 станет ложно отвергаться. Значения порога выше 0.9 приведут к двум true reject (пары 1-3 и 2-3) и одному false reject (1-2). Таким образом, лучшими вариантами выглядят пороги из диапазона 0.6-0.85 (один false accept 2-3) и порог выше 0.9 (приводит к false reject 1-2). Какое значение выбрать в качестве финального, зависит от стоимости ошибок разных типов. В этом примере порог варьируется в широких диапазонах, это связано, в первую очередь, с очень маленьких размеров датасетом и с тем, как мы выбрали значения уверенности алгоритма. Для больших, применяемых для реальных задач датасетов, получились бы существенно более точные значения порога. Зачастую вендоры ПО для распознавания лиц поставляют значения порога по умолчанию для разных FAR, которые вычисляются похожим образом на собственных датасетах вендора.

Также нетрудно заметить, что по мере того как интересующий FAR снижается, требуется все больше и больше положительных пар изображений, чтобы точно вычислить значение порога. Так, для FAR=0.001 нужно по меньшей мере 1000 пар, а для FAR= потребуется уже 1 миллион пар. Собрать и разметить такой датасет непросто, поэтому клиентам, заинтересованным в низких значениях FAR, имеет смысл обратить внимание на публичные бенчмарки, такие как NIST Face Recognition Vendor Test или MegaFace. К последнему следует относиться с осторожностью, так как и обучающая, и тестовая выборки доступны всем желающим, что может привести к излишне оптимистичной оценке точности (см. раздел «Переобучение»).

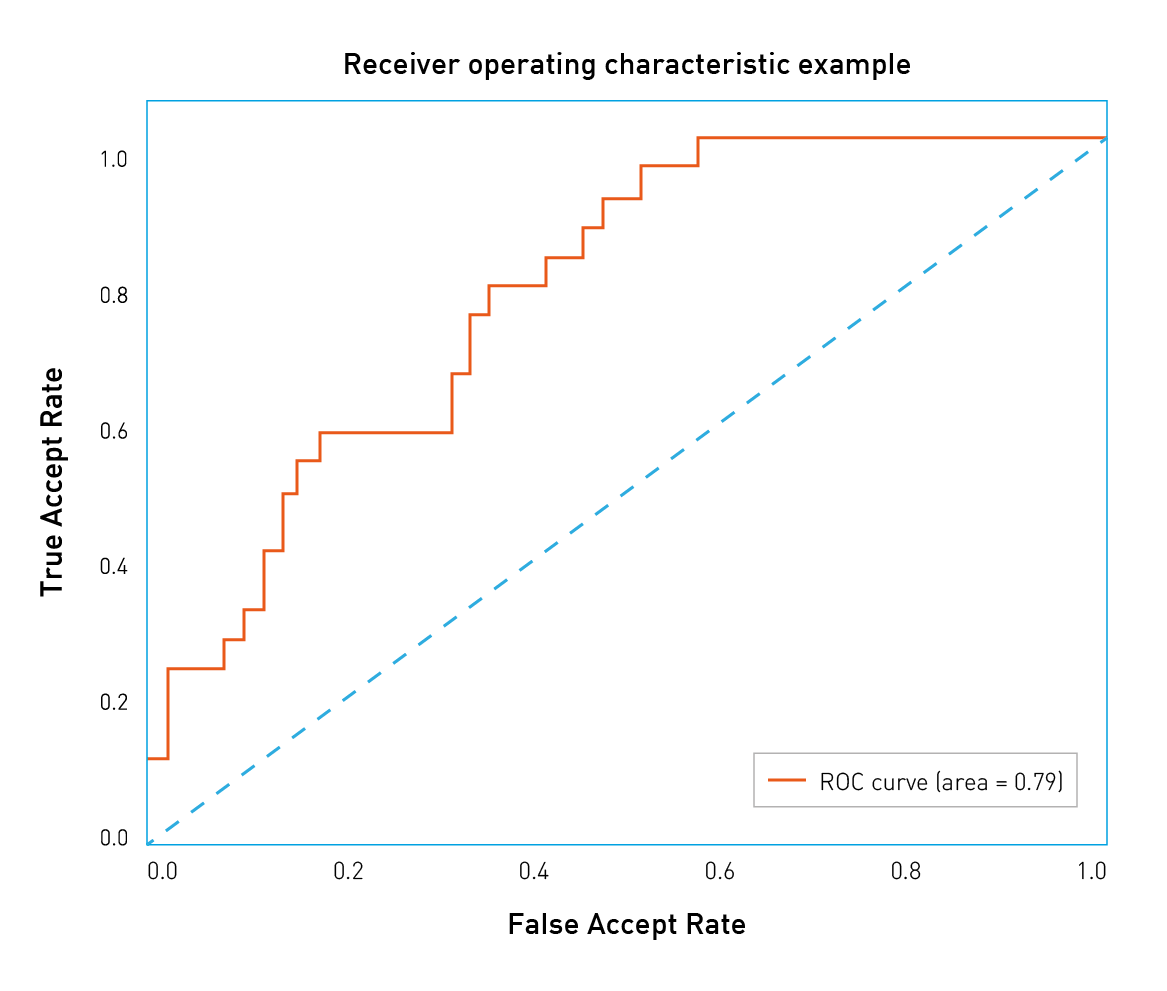

Типы ошибок различаются по связанной с ними стоимости, и у клиента есть способ смещать баланс в сторону тех или иных ошибок. Для этого надо рассмотреть широкий диапазон значений порога. Удобный способ визуализации точности алгоритма при разных значениях FAR заключается в построении ROC-кривых (англ. receiver operating characteristic, рабочая характеристика приёмника).

Давайте разберемся, как строятся и анализируются ROC-кривые. Уверенность алгоритма (а следовательно, и порог) принимают значения из фиксированного интервала. Другими словами, эти величины ограничены сверху и снизу. Предположим, что это интервал от 0 до 1. Теперь мы можем измерить количество ошибок, варьируя значение порога от 0 до 1 с небольшим шагом. Так, для каждого значения порога мы получим значения FAR и TAR (true accept rate). Далее мы будет рисовать каждую точку так, чтобы FAR соответствовал оси абсцисс, а TAR – оси ординат.

Рис.3 Пример ROC-кривой

Легко заметить, что первая точка будет иметь координаты 1,1. При пороге равном 0 мы принимаем все пары и не отвергаем ни одной. Аналогично, последняя точка будет 0,0: при пороге 1 мы не принимаем ни одной пары и отвергаем все пары. В остальных точках кривая обычно выпуклая. Также можно заметить, что наихудшая кривая лежит примерно на диагонали графика и соответствует случайному угадыванию исхода. С другой стороны, наилучшая возможная кривая образует треугольник с вершинами (0,0) (0,1) и (1,1). Но на датасетах разумного размера такое трудно встретить.

Рис.4 ROC-кривые NIST FRVT

Можно построить подобие RОС-кривых с различными метриками/ошибками на оси. Рассмотрим, например, рисунок 4. На нем видно, что организаторы NIST FRVT по оси Y нарисовали FRR (на рисунке – False non-match rate), а по оси X – FAR (на рисунке – False match rate). В данном конкретном случае лучшие результаты достигнуты кривыми, которые расположены ниже и смещены влево, что соответствует низким показателям FRR и FAR. Поэтому стоит обращать внимание на то, какие величины отложены по осям.

Такой график позволяет легко судить о точности алгоритма при заданном FAR: достаточно найти точку на кривой с координатой Х равной нужному FAR и соответствующее значение TAR. «Качество» ROC-кривой также можно оценить одним числом, для этого надо посчитать площадь под ней. При этом лучшее возможное значение будет 1, а значение 0.5 соответствует случайному угадыванию. Такое число называют ROC AUC (Area Under Curve). Однако следует заметить, что ROC AUC неявно предполагает, что ошибки первого и второго рода однозначны, что не всегда так. В случае если цена ошибок различается, следует обратить внимание на форму кривой и те области, где FAR соответствует бизнес-требованиям.

Идентификация

Второй популярной задачей распознавания лиц является идентификация, или поиск человека среди набора изображений. Результаты поиска сортируются по уверенности алгоритма, и наиболее вероятные совпадения попадают в начало списка. В зависимости от того, присутствует или нет искомый человек в поисковой базе, идентификацию разделяют на две подкатегории: closed-set идентификация (известно, что искомый человек есть в базе) и open-set идентификация (искомого человека может не быть в базе).

Точность (accuracy) является надежной и понятной метрикой для closed-set идентификации. По сути, точность измеряет количество раз, когда нужная персона была среди результатов поиска.

Как это работает на практике? Давайте разбираться. Начнем с формулировки бизнес-требований. Допустим, у нас есть веб-страница, которая может разместить десять результатов поиска. Нам нужно измерить количество раз, которое искомый человек попадает в первые десять ответов алгоритма. Такое число называется Top-N точностью (в данном конкретном случае N равно 10).

Для каждого испытания мы определяем изображение человека, которого будем искать, и галерею, в которой будем искать, так, чтобы галерея содержала хотя бы еще одно изображение этого человека. Мы просматриваем первые десять результатов работы алгоритма поиска и проверяем, есть ли среди них искомый человек. Чтобы получить точность, следует просуммировать все испытания, в которых искомый человек был в результатах поиска, и поделить на общее число испытаний.

Рис 5. Пример идентификации. В этом примере искомый человек появляется в позиции 2, поэтому точность Top-1 равна 0, а Top-2 и далее равна 1.

Open-set идентификация состоит из поиска людей, наиболее похожих на искомое изображение, и определения, является ли кто-то из них искомым человеком на основании уверенности алгоритма. Open-set идентификацию можно рассматривать как комбинацию closed-set идентификации и верификации, поэтому на этой задаче можно применять все те же метрики, что и в задаче верификации. Также нетрудно заметить, что open-set идентификацию можно свести к попарным сравнениям искомого изображения со всеми изображениями из галереи. На практике это не используется из соображений скорости вычислений. ПО для распознавания лиц часто поставляется с быстрыми алгоритмами поиска, которые могут находить среди миллионов лиц похожие за миллисекунды. Попарные сравнения заняли бы намного больше времени.

Практические примеры

В качестве иллюстрации давайте рассмотрим несколько распространенных ситуаций и подходов к тестированию алгоритмов распознавания лиц.

Розничный магазин

Допустим, что средний по размеру розничный магазин хочет улучшить свою программу лояльности или уменьшить количество краж. Забавно, но с точки зрения распознавания лиц это примерно одно и то же. Главная задача этого проекта заключается в том, чтобы как можно раньше идентифицировать постоянного покупателя или злоумышленника по изображению с камеры и передать эту информацию продавцу или сотруднику службы безопасности.

Пусть программа лояльности охватывает 100 клиентов. Данную задачу можно рассматривать как пример open-set идентификации. Оценив расходы, отдел маркетинга пришел в выводу, что приемлемый уровень ошибки – принимать одного посетителя за постоянного покупателя за день. Если в день магазин посещает 1000 посетителей, каждый из которых должен быть сверен со списком 100 постоянных клиентов, то необходимый FAR составит .

Определившись с допустимым уровнем ошибки, следует выбрать подходящий датасет для тестирования. Хорошим вариантом было бы разместить камеру в подходящем месте (вендоры могут помочь с конкретным устройством и расположением). Сопоставив транзакции держателей карт постоянного покупателя с изображениями с камеры и проведя ручную фильтрацию, сотрудники магазина могут собрать набор позитивных пар. Также имеет смысл собрать набор изображений случайных посетителей (по одному изображению на человека). Общее количество изображений должно примерно соответствовать количеству посетителей магазина в день. Объединив оба набора, можно получить датасет как «позитивных», так и «негативных» пар.

Для проверки желаемой точности должно хватить около тысячи «позитивных» пар. Комбинируя различных постоянных клиентов и случайных посетителей, можно собрать около 100 000 «негативных» пар.

Следующим шагом будет запустить (или попросить вендора запустить) ПО и получить уверенность алгоритма для каждой пары из датасета. Когда это будет сделано, можно построить ROC-кривую и удостовериться, что количество правильно идентифицированных постоянных клиентов при FAR=соответствует бизнес-требованиям.

E-Gate в аэропорту

Современные аэропорты обслуживают десятки миллионов пассажиров в год, а процедуру паспортного контроля ежедневно проходит около 300 000 человек. Автоматизация этого процесса позволит существенно сократить расходы. С другой стороны, пропустить нарушителя крайне нежелательно, и администрация аэропорта хочет минимизировать риск такого события. FAR= соответствует десяти нарушителям в год и кажется разумным в этой ситуации. Если при данном FAR, FRR составляет 0.1 (что соответствует результатам NtechLab на бенчмарке NIST visa images), то затраты на ручную проверку документов можно будет сократить в десять раз. Однако для того чтобы оценить точность при данном уровне FAR, понадобятся десятки миллионов изображений. Сбор такого большого датасета требует значительных средств и может потребовать дополнительного согласования обработки личных данных. В результате инвестиции в подобную систему могут окупаться чересчур долго. В таком случае имеет смысл обратиться к отчету о тестировании NIST Face Recognition Vendor Test, который содержит датасет с фотографиями с виз. Администрации аэропорта стоит выбирать вендора на основе тестирования на этом датасете, приняв во внимание пассажиропоток.

Таргетированная почтовая рассылка

До сих пор мы рассматривали примеры, в которых заказчик был заинтересован в низких FAR, однако это не всегда так. Представим себе оборудованный камерой рекламный стенд в крупном торговом центре. Торговый центр имеет собственную программу лояльности и хотел бы идентифицировать ее участников, остановившихся у стенда. Далее этим покупателям можно было бы рассылать таргетированные письма со скидками и интересными предложениями на основании того, что их заинтересовало на стенде.

Допустим, что эксплуатация такой системы обходится в 10 $, при этом около 1000 посетителей в день останавливаются у стенда. Отдел маркетинга оценил прибыль от каждого таргетированного email в 0.0105 $. Нам хотелось бы идентифицировать как можно больше постоянных покупателей и не слишком беспокоить остальных. Чтобы такая рассылка окупилась, точность должна быть равна затратам на стенд, поделенным на количество посетителей и ожидаемый доход от каждого письма. Для нашего примера точность равна . Администрация торгового центра могла бы собрать датасет способом, описанным в разделе «Розничный магазин», и измерить точность, как описано в разделе «Идентификация». На основании результатов тестирования можно принимать решение, получится ли извлечь ожидаемую выгоду с помощью системы распознавания лиц.

Поддержка видео

В этой заметке мы обсуждали преимущественно работу с изображениями и почти не касались потокового видео. Видео можно рассматривать как последовательность статичных изображений, поэтому метрики и подходы к тестированию точности на изображениях применимы и к видео. Стоит отметить, что обработка потокового видео гораздо более затратна с точки зрения производимых вычислений и накладывает дополнительные ограничения на все этапы распознавания лиц. При работе с видео следует проводить отдельное тестирование производительности, поэтому детали этого процесса не затрагиваются в настоящем тексте.

Частые ошибки

В этом разделе мы хотели бы перечислить распространенные проблемы и ошибки, которые встречаются при тестировании ПО для распознавания лиц, и дать рекомендации, как их избежать.

Тестирование на датасете недостаточного размера

Всегда следует быть аккуратным при выборе датасета для тестирования алгоритмов распознавания лиц. Одним из важнейших свойств датасета является его размер. Размер датасета нужно выбирать, исходя из требований бизнеса и значений FAR/TAR. «Игрушечные» датасеты из нескольких изображений людей из вашего офиса дадут возможность «поиграть» с алгоритмом, измерить его производительность или протестировать нестандартные ситуации, но на их основании нельзя делать выводы о точности алгоритма. Для тестирования точности следует использовать датасеты разумных размеров.

Тестирование при единственном значении порога

Иногда люди тестируют алгоритм распознавания лиц при одном фиксированном пороге (часто выбранном производителем «по умолчанию») и принимают во внимание лишь один тип ошибок. Это неправильно, так как значения порога «по умолчанию» у разных вендоров различаются или выбираются на основе различных значений FAR или TAR. При тестировании следует обращать внимание на оба типа ошибок.

Сравнение результатов на разных датасетах

Датасеты различаются по размерам, качеству и сложности, поэтому результаты работы алгоритмов на разных датасетах невозможно сравнивать. Можно запросто отказаться от лучшего решения только потому, что оно тестировалось на более сложном, чем у конкурента, датасете.

Делать выводы на основе тестирования на единственном датасете

Следует стараться проводить тестирование на нескольких наборах данных. При выборе единственного публичного датасета нельзя быть уверенным, что он не использовался при обучении или настройке алгоритма. В этом случае точность алгоритма будет переоценена. К счастью, вероятность этого события можно снизить, сравнив результаты на разных датасетах.

Выводы

В этой заметке мы описали основные составные части тестирования алгоритмов распознавания лиц: наборы данных, задачи, соответствующие метрики и распространенные сценарии.

Конечно, это далеко не всё, что хотелось бы рассказать о тестировании, и наилучший порядок действий может отличаться при многочисленных исключительных сценариях (команда NtechLab с радостью поможет с ними разобраться). Но мы очень надеемся, что этот текст поможет правильно спланировать тестирование алгоритма, оценить его сильные и слабые стороны и интерпретировать метрики качества с точки зрения бизнес-задач.

Текст работы размещён без изображений и формул.

Полная версия работы доступна во вкладке «Файлы работы» в формате PDF

В 21 веке не редкостью стало использование биометрических данных вместо обычных паролей, подписей и СМС. Это просто, удобно и практично. Но настолько ли надежны биометрические данные? Для начала стоит разобраться, что же такое биометрия и биометрическая идентификация.

В широком смысле биометрия – это наука о применении математических методов в биологии. Биометрия как наука сложилась чем-то средним между биологией и математикой. Ее развитие связано с превращением биологии как науки описательной в науку точную, основанную на измерениях, на применении количественных оценок. Основными методами биометрии, первоначально заимствованными из математики, были математическая статистика и теория вероятности.

Биометрическая идентификация – использование уникальных признаков человека для его идентификации. Примерами биометрических признаков могут выступать: отпечатки пальцев, лицо, радужная оболочка глаза, геометрия руки, узор вен в ладони, волос и многое другое.

Общие свойства биометрической идентификации:

Плюсы:

идентификатор невозможно забыть, потерять и так далее

затруднена передача идентификатора другому лицу

Минусы:

не 100% результат, ошибки в работе

высокая цена

низкая вандалостойкость, сложнее защитить

низкая скорость работы, процесса считывания (не во всех случаях)

Вероятностный характер работы биометрии:

невозможность достижения 100% достоверности результата

вероятность возникновения ошибки зависит от конкретной системы

Биометрические идентификаторы обеспечивают очень высокие показатели (вероятность несанкционированного доступа – 0,1…0,0001 %, вероятность ложного задержания – доли процентов, время идентификации – единицы секунд), но имеют более высокую стоимость по сравнению со средствами атрибутной идентификации.

Любая система не идеальна и имеет свойство ошибаться. Существует множество разных ситуаций, при которых, система даёт сбои. В качестве примера, рассмотри одну из самых простых ситуаций – верификация. Верификация работает по такому принципу: происходит сравнивание полученного биометрического признака (например, фотография) с уже имеющимся в базе данных. В данном случае она может ошибаться двумя разными способами:

Может сказать: «нет, это не он», но это будет правильный человек

Может сказать: «да, это он», но это будет совершенно другой человек

Ошибки первого и второго рода

Существует 4 разных ситуации реагирования системы на полученные данные:

Первые 2 происходят при нормальном положении дел.

Системе предъявлено изображение правильного человека, и она ответила: «да», это он;

Системе предъявлено изображение другого человека, и она ответила: «нет», это не он;

Системе предъявлено изображение другого человека, и она ответила: «да», это он. Эта ситуация называется ложный допуск, если говорить про контроль доступа. Также её называют ошибка первого рода, а вероятность возникновения такой ситуации обычно именуют FalseAcceptRate (FAR) и измеряют в процентах. Если написано в характеристиках FAR = 1%, это значит, что 1 раз из 100 такая ошибка возникнет;

Системе предъявлено изображение правильного человека, и она ответила: «нет», это не он. Эта ситуация называется ложный отказ. Также её называют ошибка второго рода, а вероятность ситуации обычно именуют FalseRejectRat (FRR) и измеряют в процентах.

Например, при FRR 1% FAR 0,1%. Читается данная запись так: При данном наборе параметров системы с вероятность 1 из 100 будет возникать ситуация ложного отказа, и с вероятностью 1 из 1000 будет возникать ситуация предоставления ложного доступа человеку.

FRR и FAR тесно связаны друг с другом, именно поэтому их пишут вместе.

Степень сходства

Степень сходства — безразмерный показатель сходства сравниваемых объектов. Существует несколько крайних положений, которые она может принимать: 0% — вообще не похож и 100% — очень похож. Но возникает вопрос, что же делать со средними значениями? Тут, в том или ином виде можно задать порог сходства, который определенным способом можно двигать, меняя настройки считывателя. Двигая его влево (к 0%) мы можем добиться того, что система будет менее склонна отказывать доступ, т.е. допускать ситуаций ошибок второго рода. Двигая его вправо (к 100%) мы можем добиться уменьшения количества ошибок первого рода.

У этого параметра нет какого-то идеально правильного единственного положения. Надо понимать, что существуют разные задачи и у каждой свои требования.

Соотношение ошибок FAR и FRR

Их соотношение можно представить в виде гиперболы. Каждая точка этой кривой соответствует определенному положению вещей. Каждая точка ее горизонтальной координаты означает ошибку второго рода (FRR), а вертикальной координаты – ошибку первого рода (FAR).

Чтобы добиться маленькой ошибки второго рода, приходиться платить большой ошибкой первого рода, и наоборот. Существует разные требования и применения соотношения ошибок FAR и FRR.

Например: Для систем с высоким требованием безопасности категорически нельзя дать ложный допуск. Тем самым, приходится платить большим процентом ложных отказов. Проще говоря: мы увеличиваем строгость системы. Она начинает часто отказывать, но тем самым не пропустит чужого.

Совершенно другое применение: для криминальных расследований. Мы должны понять, кто из представленных людей разыскивается, выловить его из толпы. Нам категорически не хочется его случайно пропустить. Для этого, нам нужно сделать низкую вероятность ошибки второго рода, т.е. ложного отказа. Тем самым, приходится платить большой ошибкой первого рода, т.е. система будет отфильтровывать людей, которые ей показались похожими. Для этого применения — это нормально, т.к. потом этих людей уже анализируют вручную. Системе нужно лишь сократить количество рассматриваемых людей.

Идентификация

Идентификация – мы не знаем наперед кто перед нами. Предъявлен какой-то биометрический признак; нужно понять кто из нескольких представленных вариантов, нужный нам человек. При этом от системы ожидается один из ответов:

Кому именно из N числа принадлежит предъявленный признак

Таких признаков нет в базе данных

В идентификации существенную роль играет ошибка первого рода. При сравнении с одним человеком вероятность 1 из 1000 нас устраивает, но, когда людей в базе данных много, большая вероятность, что эта ошибка может возникнуть для каждого из них.

Пример расчета: FRR = 2% FRR = 2%

N = 1 N = 5000

FAR = 0,0001% FAR = 0,5%

Подводя итоги можно сказать:

Для верификации:

нужен низкий FRR

FAR практически не имеет значение

Для идентификации:

нужен низкий FAR

высокий FRR нежелателен

В целом, надо признать, что для идентификации требования намного выше, чем для верификации.

Вывод

Нужно хорошо понимать ограничения и особенности систем биометрической идентификации. Такие системы не являются универсальными решениями, но требуется понимать разницу верификации и идентификации, уметь считать ошибки FAR и FRR. Возможно, в будущем данная технология претерпит значительные изменения и найдет способ снизить процентное соотношение ошибок до минимума.

Оценка качества Биометрических систем

Работа

биометрической системы идентификации

пользователя (БСИ) описывается техническими

и ценовыми параметрами. Качество работы

БСИ характеризуется процентом ошибок

при прохождении процедуры допуска. В

БСИ различают ошибки трех видов:

-

FRR

(False Rejection Rate)ошибка первого рода—

вероятность принять «своего» за

«чужого». Обычно в коммерческих

системах эта ошибка выбирается равной

примерно 0,01, поскольку считается, что,

разрешив несколько касаний для «своих»,

можно искусственным способом улучшить

эту ошибку. В ряде случаев (скажем, при

большом потоке, чтобы не создавать

очередей) требуется улучшение FRR до

0,001-0,0001. В системах, присутствующих на

рынке, FRR обычно находится в диапазоне

0,025-0,01. -

FAR

(False Acceptance Rate)ошибка второго рода— вероятность принять «чужого» за

«своего». В представленных на рынке

системах эта ошибка колеблется в

основном от 10-3до 10-6, хотя

есть решения и с FAR = 10-9. Чем больше

данная ошибка, тем грубее работает

система и тем вероятнее проникновение

«чужого»; поэтому в системах с

большим числом пользователей или

транзакций следует ориентироваться

на малые значения FAR.

-

EER

(Equal Error Rates)– равная вероятность

(норма) ошибок первого и второго рода.

Биометрические

технологии

основаны на биометрии, измерении

уникальных характеристик отдельно

взятого человека. Это могут быть как

уникальные признаки, полученные им с

рождения, например: ДНК, отпечатки

пальцев, радужная оболочка глаза; так

и характеристики, приобретённые со

временем или же способные меняться с

возрастом или внешним воздействием,

например: почерк, голос или походка.

Все

биометрические системы работают

практически по одинаковой схеме.

Во-первых, система запоминает образец

биометрической характеристики (это и

называется процессом записи). Во время

записи некоторые биометрические системы

могут попросить сделать несколько

образцов для того, чтобы составить

наиболее точное изображение биометрической

характеристики. Затем полученная

информация обрабатывается и

преобразовывается в математический

код. Кроме того, система может попросить

произвести ещё некоторые действия для

того, чтобы «приписать» биометрический

образец к определённому человеку.

Например, персональный идентификационный

номер (PIN) прикрепляется к определённому

образцу, либо смарт-карта, содержащая

образец, вставляется в считывающее

устройство. В таком случае, снова делается

образец биометрической характеристики

и сравнивается с представленным образцом.

Идентификация по любой биометрической

системе проходит четыре стадии:

-

Запись

– физический или поведенческий образец

запоминается системой; -

Выделение

– уникальная информация выносится из

образца и составляется биометрический

образец; -

Сравнение

– сохраненный образец сравнивается с

представленным; -

Совпадение/несовпадение

— система решает, совпадают ли

биометрические образцы, и выносит

решение.

Подавляющее

большинство людей считают, что в памяти

компьютера хранится образец отпечатка

пальца, голоса человека или картинка

радужной оболочки его глаза. Но на самом

деле в большинстве современных систем

это не так. В специальной базе данных

хранится цифровой код длиной до 1000 бит,

который ассоциируется с конкретным

человеком, имеющим право доступа. Сканер

или любое другое устройство, используемое

в системе, считывает определённый

биологический параметр человека. Далее

он обрабатывает полученное изображение

или звук, преобразовывая их в цифровой

код. Именно этот ключ и сравнивается с

содержимым специальной базы данных для

идентификации личности [19].

Преимущества

биометрической идентификации состоит

в том, что биометрическая защита дает

больший эффект по сравнению, например,

с использованием паролей, смарт-карт,

PIN-кодов, жетонов или технологии

инфраструктуры открытых ключей. Это

объясняется возможностью биометрии

идентифицировать не устройство, но

человека.

Обычные

методы защиты чреваты потерей или кражей

информации, которая становится открытой

для незаконных пользователей.

Исключительный биометрический

идентификатор, например, отпечатки

пальцев, является ключом, не подлежащим

потере [18].

Соседние файлы в папке ГОСЫ

- #

- #

- #

- #

- #

- #

- #

- #

- #

Развитие интернета наряду с множеством положительных перемен в жизни людей увеличило угрозы вредоносных атак, вторжений в корпоративную сеть, краж конфиденциальной информации. Одним из способов минимизировать данные риски является аутентификация пользователей по клавиатурному почерку. В данной работе мы рассмотрим основные тенденции развития методов распознавания клавиатурного почерка, основанных на исследовании временных характеристик.

Ключевые слова: клавиатурный почерк, биометрическая аутентификация личности, временные характеристики, статистические методы оценки

Keywords: typing dynamics, biometric person authentication, time characteristics, statistical methods of evaluation

Идея использовать клавиатурный почерк для аутентификации личности не нова. Известно, что в годы Второй мировой войны спецслужбы разных стран учитывали «почерк радиста» при оценке достоверности источника полученных разведданных. Компьютеризация, стартовавшая в конце 70-х годов прошлого века, привела к началу систематических исследований в данном направлении. В 1979 году специалисты SRI International (до этого — Stanford Research Institute) представили чип со встроенным алгоритмом распознавания клавиатурного почерка. В 1984 году Национальное бюро стандартов США признало технологию эффективной на 98 %.

- Эффективность клавиатурного почерка как инструмента аутентификации

Клавиатурный почерк — это поведенческая биометрическая характеристика, состоящая из паттернов ритма и динамики, характерных для данного оператора при наборе текста. Клавиатурный почерк описывается следующими параметрами:

– скорость ввода — отношение количества введенных символов ко времени набора;

– динамика ввода — отрезки времени между нажатиями клавиш и их удержанием;

– частота возникновения ошибок при вводе;

– характерное использование клавиш — например, какие функциональные клавиши нажимает оператор при вводе заглавных букв.

Эффективность аутентификации по клавиатурному почерку, как и любого другого биометрического метода, определяется с помощью трех основных критериев:

– FAR (False Acceptance Rate) — процентный порог, определяющий вероятность того, что один человек может быть принят за другого (коэффициент ложного доступа). FAR также называют «ошибкой 2 рода»;

– FRR (False Rejection Rate) — вероятность того, что человек может быть не распознан системой (коэффициент ложного отказа в доступе). FRR также называют «ошибкой 1 рода»;

– CER (Crossover Error Rate) — точка, в которой калибровка системы приводит к равенству FAR = FRR.

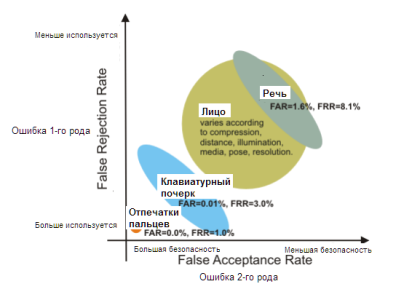

На рис.1 показана диаграмма, характеризующая эффективность аутентификации по клавиатурному почерку в сравнении с другими методами биометрии: распознаванием по отпечаткам пальцев или по чертам лица — физическая биометрия, и еще одним методом поведенческой биометрии — распознаванием по речи.

Рис. 1. Ошибки 1-го и 2-го рода при использовании разных методов биометрии [1]

Мы видим, что распознавание по клавиатурному почерку имеет хорошие показатели эффективности и уступает только аутентификации по отпечаткам пальцев. Вместе с тем, методы поведенческой биометрии могут быть «подогнаны» под конкретную задачу за счет компромисса между большей используемостью и большей безопасностью [5]. Поэтому FAR и FRR для клавиатурного почерка являются переменными величинами даже в рамках одного и того же алгоритма. Соответственно, в большем диапазоне меняется и величина CER.

Использование клавиатурного почерка для аутентификации личности имеет ряд несомненных преимуществ:

– алгоритмы относительно просты и могут быть реализованы как в виде ПО, так и прошиты в чипе;

– относительная дешевизна: реализация алгоритма не требует больших вложений, из «железа» фактически используется только клавиатура;

– скрытость использования, например, злоумышленник может и не подозревать о такой возможности;

– относительно высокая степень эффективности.

Однако, недостатки данного метода также очевидны:

– обязательный этап обучения приложения;

– при замене клавиатуры, скорее всего, понадобится переобучение;

– при изменении физического состояния оператора (болезнь, травма), он просто не сможет войти в систему.

- Данные для анализа ввода склавиатуры

Анализ клавиатурного почерка, наверное, самый дешевый метод аутентификации по используемому «железу»: нам необходима только клавиатура, которая и так представлена в любой конфигурации компьютера, ноутбука, мобильных устройств.

Конечно, каждый вид клавиатуры будет отличаться по ряду характеристик:

– Форма (прямоугольная, изогнутая, эргономическая);

– Необходимая сила нажима на клавишу;

– Расположение клавиш (AZERTY, QWERTY,…).

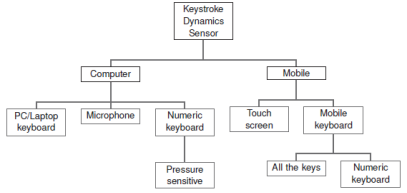

На рис. 2. представлено дерево различных топологий клавиатур в современных устройствах.

Рис. 2. Дерево различных топологий клавиатур по Дж. Янгу [14, c.164]

Биометрические данные о клавиатурном почерке — это список хронологически упорядоченных событий, содержащий следующую информацию:

– События, которые генерируются при работе с клавиатурой. Различают два вида событий: нажатие клавиш и их отпускание.

– Код клавиш. Код клавиши более интересен, чем значение символа, поскольку предоставляет дополнительную информацию о местонахождении клавиши на клавиатуре и позволяет дифференцировать различные ключи, что можно использовать при разработке приложений. Код клавиши зависит от платформы и используемого языка.

– Временные характеристики, соответствующие времени длительности событий.

Эффективность аутентификации существенно зависит от выбранного набора характеристик. В простейших случаях — и довольно часто — используются только лишь два основных параметра: длительность и задержка.

- Статистический подход кклассификации иидентификации по клавиатурному почерку

Задача распознавания — принадлежит ли данный образец набора текста конкретному человеку — решается либо путем перебора большой базы данных, либо с помощью сравнения с неким шаблоном аутентификации.

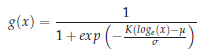

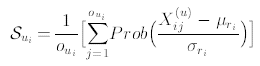

Как правило, биометрические данные нормализуются, учитывая, что временные характеристики распределены по логарифмически нормальному закону [14, c.168]:

(1)

(1)

В своей классической работе Джойс и Гупта [2] предложили использовать вектор средних характеристик почерка оператора M = {Musername, Mpassword, Mfirstname, Mlastname}. Верификация заключается в сравнении тестовой подписи Т (полученной во время входа в систему) и М по величине отклонения, равной норме разницы L1 = ||M — T||. Положительное решение принимается в случае, если разница не превышает принятое пороговое значение. Среднее значение и стандартное отклонение нормы ||M-Si||, где Si — одна из восьми эталонных подписей, используется для определения порогового значения для допустимой разницы между Т и М.

Хотя данные по верификации были обнадеживающими, Джойс и Гупта использовали методику замещения, при которой распределение эталонного множества обязательно является репрезентативным для обучающего множества. Использование нескольких множеств данных, полученных в разное время, было бы более надежным.

Исследование классификаторов, основанных на данных, полученных от пользователей в разное время, исследовано в работе Монроуза [5]. Профайлы пользователей были представлены как N-мерные вектора характеристик, данные были разделены на обучающие и эталонные множества. Для распознавания использовался следующие классификаторы:

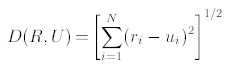

– Эвклидово расстояние между двумя N-мерными векторами U и R

(2)

(2)

Для U из тестового множества проводился перебор по величинам D(Rj, U), j = 1,…m — где m — количество эталонных векторов (профайлов) в базе данных. В результате выбирался профайл с минимальным эвклидовым расстоянием к U.

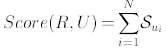

– Невзвешенная вероятность: пусть U и R — N-мерные вектора, определенные выше.

Каждая компонента векторов является квадрупольной и включает в себя набор ![]() , состоящий из средней величины, стандартного отклонения, частоты события и значения для i-ой характеристики. Допустим, что каждая характеристика пользователя распределена нормально, тогда баллы в пользу профайла R при введенном U определяются как

, состоящий из средней величины, стандартного отклонения, частоты события и значения для i-ой характеристики. Допустим, что каждая характеристика пользователя распределена нормально, тогда баллы в пользу профайла R при введенном U определяются как

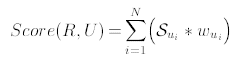

(3)

(3)

где

(4)

(4)

![]() — j-ое появление i-ой характеристики в U.

— j-ое появление i-ой характеристики в U.

Другими словами, баллы для каждого ui зависят от вероятности наблюдения величины ui в профайле R при средней (μri) и стандартном отклонении (σri) для данной характеристики в R. Большую вероятность имеют значения ui, которые находятся ближе к μri, меньшую — те, что дальше. Вектор U тогда ассоциируется с ближайшим соседом в базе данных, т. е. с оператором, для которого вектор характеристик будет максимальным.

– Взвешенная вероятность: некоторые характеристики являются более надежными

в сравнении с другими просто потому, что они представлены в большем количестве профайлов или имеют относительно большую частоту использования: например, er, th, reванглийском языке получат большие веса, чем qu или ts. Таким образом, можно ввести весовые множители, и баллы в пользу профайла R при введенном U будут рассчитываться как:

(5)

(5)

где вес характеристики ui определяется как соотношение частоты её появления к частоте появления всех характеристик в U. Характеристики с большим весом рассматриваются как более надежные. Допустим, что каждая характеристика пользователя распределена нормально, тогда баллы в пользу профайла R при введенном U определяются максимальными баллами и ближайшим вектором характеристик.

Монроуз обращает внимание на тот факт, что распознавание почерка по произвольному тексту является более сложной задачей в сравнении с распознаванием по фиксированному набору символов [5]. Проблемы при анализе произвольно введенного текста связаны с большим разнообразием физического и эмоционального состояния оператора, дополнительными неконтролируемыми внешними факторами.

При решении задачи распознавания клавиатурного почерка хорошо зарекомендовали себя байесовские классификаторы [6]. При этом распределение характеристик в векторе ввода считается Гауссовым, и U ассоциируется с вектором пользователя, который максимизирует вероятность R. Классификатор определяется следующим образом.

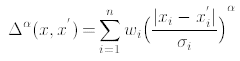

– Пусть xi — вектор характеристик, σi — вектор межклассовых дисперсий, wi — весовой вектор. Тогда расстояние между двумя векторами характеристик имеет вид

(6)

(6)

Вектора характеристик определяются на основе факторного анализа, целью которого является представление минимальной размерности, сохраняющее корреляцию между характеристиками. Существующая база данных разделяется на подклассы, члены которых подобны с точки зрения ритма набора и/или других временных факторов, при этом члены различных классов заметно отличаются по тем же факторам. Например, члены класса i связаны с индивидуальными особенностями набора символов S = {th, ate, st, ion}, в то время как члены класса j определяют набор T = {ere, on, wy}. Результат факторного анализа — иерархическая система кластеров, на основе которой идентифицируется пользователь.

Величина α в (6) подбирается для получения большей жесткости оценок: эффект сети лучше работает при α ближе к 1, чем к 2, что связано с распределением Гаусса.

Эффективность распознавания с байесовскими классификаторами достигает 92,14 %. Дополнительного улучшения на 5 % можно добиться при вводе весовых коэффициентов [5].

Литература:

- Checco John C. Keystroke Dynamics And Corporate Security // http://www.checcoservices.com/publications/2003_Keystroke_Biometrics_Intro.pdf

- Joyce R., Gupta G. Identity Authentication Based on Keystroke Latencies. — http://www.cs.cmu.edu/~maxion/courses/JoyceGupta90.pdf

- Loy C. C., Lim C. P., Lai W. K. Pressure-Based Typing Biometrics User Authentication Using the Fuzzy ARTMAP Neural Network. — http://www.eecs.qmul.ac.uk/~ccloy/files/iconip_2005.pdf

- Meloun M., Militky J. Statistical Data Analysis: A Practical Guide. — Woodhead Publishing, 2011. — 800 p.

- Monrose Fabian. Keystroke Dynamics as a Biometric for Authentication. — http://avirubin.com/fgcs.pdf

- Roth J., Liu X., Ross A.. Biometric Authentication via Keystroke Sound. — http://www.cse.msu.edu/~liuxm/publication/Roth_Liu_Ross_Metaxas_ICB2013.pdf

- Scott M. L. et al. Continuous Identity Verification through Keyboard Biometrics. — https://sa.rochester.edu/jur/issues/fall2005/ordal.pdf

Основные термины (генерируются автоматически): клавиатурный почерк, FAR, FRR, CER, вектор характеристик, характеристика, баз данных, польза профайла, поведенческая биометрия, стандартное отклонение.

Использование биометрических систем в СКУД. Часть 2

Оценить эффективность биометрических технологий можно не только стоимостными показателями и удобством использования, но и на основе использования некоторых вероятностных характеристик. В этой статье мы обсудим ключевые из этих харктеристик.

Основные вероятностные характеристики:

• Отказы в регистрации (FER — Failure to Enrol)

При проверке этой характеристики определяется, как часто пользователям отказано при внесении своих биометрических данных в систему. Такое бывает, к примеру, при катаракте глаза или же когда какое-нибудь заболевание кожи «размывает» отпечаток пальца.

• Отказы в идентификации (FTA — Failure to Acquire)

Система не способна идентифицировать пользователя при том, что его биометрические данные зарегистрированы в базе данных. Обычно это случается не по вине системы и не является какой-то её недоработкой или ошибкой. Это происходит по всевозможным причинам, влияющим на конкретную биометрическую характеристику пользователя, например это нарушение стабильности подписи из-за сломанной руки, пластырь или бинт на пальце и т.п.

• Степень ложного отказа (FRR — False Rejection Rate)

Этот показатель указывает на то, насколько часто система не может опознать по биометричской характеристике пользователя, имеющего право на проход. Эта ошибка имеет название «ошибка первого рода» — когда «свой» признается системой «чужим». Дословный перевод аббревиатуры FRR — False Rejection Rate — вероятность ошибочного отказа, то есть вероятность отказа в доступе пользователю, имеющему право на проход. При этом существует обратная величина для ошибки первого рода: GAR (Genuine Acceptance Rate) = 1 — FRR, вероятность пропуска «своего».

• Степень ложного акцептования (FAR — False Acceptance Rate)

Величина этой характеристики показывает, насколько часто пользователь, который не обладает правом доступа к объекту, принимается системой контроля как человек, имеющий такое право и получает таким образом разрешение на прохождение системы контроля доступа. Это называется «ошибкой второго рода» — проявляется, когда «чужой» признается системой контроля «своим».

• Величина равенства ошибок (Equal Error Rate)

Точка на графике, в которой степень ложного акцептования (FAR) равняется степени ложного отказа (FRR). Эта величина часто используется как стандарт для комплексной оценки биометрической системы контроля доступа.

Для проведения экспериментов с целью получения графиков FAR, FRR, GAR и точки EER, необходимо заранее подготовить специальную базу данных с собираемой биометрической характеристикой. От объёма собранной базы зависит та точность, с какой эти характеристики будут определены. Такая база данных должна состоять из n человек, у которых «бралась» биометрическая характеристика, и m вариантов этой характеристики, взятых у одного и того же человека. При этом получается, что общее число элементов в базе будет равно (n*m). Для упрощения процедуры вычисления ошибок, можно применить ряд определённых алгоритмов, которые могут заметно уменьшить объемы тестовых баз данных. Например, чтобы получить статистику ошибок первого рода (FRR-степень ложного отказа), необходимо сравнить попарно каждую характеристику одного ряда с каждой характеристикой этого же ряда.

Чтобы получить статистические данные по ошибкам второго рода (FAR), нужно сравнить попарно биометрические характеристики разных рядов, для обеспечения сравнений типа «чужой к чужому».

Применение данного способа позволяет получить необходимое количество вариантов сравнений — достаточное для построения характеристик при значительно меньших количествах элементов в тестовой базе.

После подготовки тестовой базы данных с биометрическими характеристиками и определения возможного количества сравнений, наступает следующий этап — определение ошибок первого и второго рода. Для этого, после выполнения ряда сравнений «свой к своему» и «чужой к чужому», по уже имеющейся базе данных, используя описанный выше алгоритм, мы получаем два массива степеней соответствия — оценок. Первый — M₁, содержит в себе n₁ оценок сравнения «своих» со «своими», а во втором — M₂ находятся n₂ оценок сравнения «чужих» с «чужими». Допустим, что оценка сравнения двух характеристик может принимать значения от «0» до «1», другими словами, «0» — это абсолютне различие двух взятых для сравнения характеристик (это условная величина, которую практически нельзя получить в реальности), а «1» соответствует полной идентичности двух характеристик (такого можно добиться на практике лишь при сравнении изображений характеристики одного и того же человека). Имеющийся диапазон значений оценок сравнений можно разделить на n частей, после чего получится (n+1) порогов сравнения: 0, 1/n, 2/n… (n-1)/n, 1.

На следующем этапе необходимо задать некоторый пороговый уровень оценки A. И если оценка конкретной характеристики больше или равна этому пороговому значению A, то даётся разрешение на проход. Если же меньше, то в проходе будет отказано.

При установленном пороге A = 0, любые сравнения характеристик дадут значение оценки выше или равное порогу, откуда следует, что при такой установке значения, все «свои» безошибочно признаются «своими», всвязи с чем, у нас число ошибок первого рода будет равняться нулю: FRR = 0. Но с другой стороны — любая «чужая» характеристика, не имеющаяся в базе, будет ошибочно принята как «своя», и как следствие, в такой ситуации получается FAR = 100%, что категорически неприемлемо, хотя мы здесь рассматривали «крайнюю» ситуацию. Ещё одна крайность, обратная предыдущей, для примера — это установление порога A = 1. Здесь получается следующее: Количество ошибок второго рода равняется 0 (FAR = 0), то есть все «чужие» безошибочно признаются системой таковыми. А вот характеристика FRR = 100%, то есть ни один человек из тех, кому должен быть разрешён проход, не сможет преодолеть этот барьер, потому что в любом случае, значение его биометрической характеристики, при сравнении с пороговой, будет меньше.

Ну и, отходя от «крайних» вариантов, рассмотрим, что же будет, если взять некое среднее значение порога A: 0 < A <1 . При этом у нас получится, что часть значений n₁ из массива M₁ будет меньше значений порогового уровня A, что даст нам количество ошибок первого рода (отказ в проходе «своему»): FRR= (M₁/n₁)*100%. Так же, определённое количество значений n₂ из массива M₂ будет больше порога A, что приведёт к образованию ошибок второго рода (ошибочный пропуск «чужого») в количестве: FAR= (M₂/n₂)*100%. Таким образом, замеряя весь ряд порогов, можно построить графики FAR и FRR.

Настраивая далее алгоритм распознавания, уже после вычисления вероятностных характеристик — Вы должны выбрать «рабочую точку», другими словами, Вам необходимо задать значение порога сравнения для идентификации и верификации . Любая биометрическая система распознавания, присеняемая в системах контроля доступа, стремится свести к минимуму оба коэффициента ошибок: и ложного отказа «своему», и ложного допуска «чужого», но на практике встречаются только определённые компромиссные значения коэффициентов. Суть здесь заключается в том, что если снижать один из этих коэффициентов, то при этом неизбежно возрастёт другой, и наоборот. Значение порогового уровня необходимо подбирать таким образом, чтобы свести к минимуму все возможные последствия от вероятных ошибок. Как правило, наиболее серьезными ошибками считаются ложные допуски, потому что в этой ситуации пройти через систему контроля доступа может злоумышленник (ну или получить доступ к системе, в зависимомти от того, для чего используются биометрические технологии). А в зависимости от места применения биометрической системы контроля доступа, и, что особо важно, от наличия альтернативной или резервной системы допуска, последствиями ложного отказа могут быть не только простые неудобства, но и создавать серьёзные угрозы жизни.