Экология ресурсов пилота. «Человеческий фактор».

Летная деятельность основана на квалификации специалистов, принимающих решения. Процедуры и действия сопровождаются влиянием факторов внутренней и внешней среды воздушного транспорта. Умышленные и непреднамеренные действия, ведущие к нежелательным последствиями результатам, получили название феномена «человеческого фактора». Исследование природы ошибочных действий приводит к выводам о глубинном происхождении в структурах психики человека в процессе намерений, суждений и волеизъявления. Оценка последствий происходит на фоне изменяющейся среды и сознания индивида. Результаты чаще воспринимаются как не соответствующие первоначальным намерениям.

Исследование данного предмета в технократической деятельности общества ведется в узко прагматическом плане. Существующие классификации ошибочных действий пилотов имеют практическую ценность, но слабо связаны между собой. По нашему убеждению, доля реальных ошибок пилота в общем числе происшествий меньше на порядок от приписываемых и составляет единицы процентов. Это – ошибки некомпетентности, неопытности и в последнюю очередь — небрежения. Предлагаемая в нашей работе концепция цепей и сфер факторов ошибочных действий может основной синтезированной моделью иного понимания природы ошибок операторов летного труда и подобных профессий.

Основными сферами происхождения ошибок является процесс полета, правила и процедуры, техника и окружение. Процессные эмпирические модели, по нашему мнению, являются наиболее перспективным направлением изучения и управления ресурсами пилотов и транспортного комплекса. Исследование экологии пилота и ресурсная концепция продвигает нас и дает ответы на вопросы и рекомендации для практических действий. Вместе с тем, возникает иной спектр вопросов. Летный экипаж — это критический участок всей системы воздушного транспорта. «Каждый служащий авиакомпании одной ногой стоит в кабине» — гласит принцип авиационного менеджмента. Любое происшествие можно рассматривать как неудавшийся организационный процесс.

Ресурсы пилота в процессе конкретного полета – это концентрация деятельности и ресурсов всех участников транспортного комплекса. Адаптация пилота и потребителей к внешней среде может длиться тысячелетия, если мы не найдем иные концепции перемещения в пространстве или иные способы удовлетворения аэромотивации. Основным источником аэромотивации являются требования общественного развития, императивы разума: необходимость полетов и, предположительно, архетипы биогенеза — желание полета. Определение количественных механизмов аэромотивации — это реальный путь разработки методик профессионального отбора.

Разработка и стандартизация систем отбора по исходным характеристикам кандидатов в летную профессию в будущем, вероятно, будет претерпевать серьезные изменения. И не исключено, что традиционно считавшиеся характеристики пилота, такие как флегматичность, спокойствие, устойчивость психомоторики, окажутся в будущих системах отбора менее предпочтительными. Поскольку обнаружено, что именно эти качества являются препятствием в управлении ресурсами экипажа. Кроме того, они благоприятствуют отрицательному переносу навыков при переучивании.

Психофизиологическая перегрузка летного персонала происходит из-за неадекватности режимов человеческого организма и технических систем. Автоматизированные системы воздушного судна должны выдавать экипажу не всю имеющуюся равномерно распределенную информацию обо всех системах, а разную, с акцентом по степени важности в соответствии с этапом полета в данный момент времени. В этом – смысл процессного управления ресурсами пилота и полета.

Знания и сознательное управление операционной энергетикой пилота – являются ключевым императивом профессионализма пилота. Кардинальное изменение режима экологии пилота и снижение утомления в настоящее время принципиально не преодолимо из-за больших пространственно-временных перемещений и характера операторского труда.

Набор разработанных моделей летного профессионализма может быть одной из исходных позиций стандартизации профессиональной деятельности. Разработанная модель профессионального профиля пилота является материалом для разработки конкретных количественных методик и тостов оценки персонала авиакомпании. Возможно создание банка эмпирических стандартов, который будет источником формализованных стандартов летного профессионализма и одновременно необходимым контрольным материалом для исследовательской работы.

Исследование «человеческого фактора», по самой постановке предмета исследования, эквивалентно онтологии и бессмысленно для предметной области воздушного транспорта. «Ошибка пилота» — следствие всевозможных наборов ослабления, неконгруэнтности ресурсных состояний – цепей, процессов всех участников транспортного комплекса. Реальная ошибка пилота не превышает единиц процентов от общего числа причин происшествий.

На протяжении длительного периода времени безопасность полётов в СССР, и позже была на уровне и выдерживала сравнение со средней мировой статистикой происшествий. Помнится, это было козырем авиационных чиновников. Возникает вопрос — как же нам удавалось сохранить уровень безопасности, который выдерживал сравнение со средним международным? Ответ очень прост: только за счет бездумного, хищнического расточительства собственных ресурсов. Прежде всего, людских, точнее — летно-технических. Продолжительность жизни наших профессионалов, по разным оценкам – на 10-15 лет меньше, чем за рубежом.

Полезные ссылки:

-

Классификации и подходы в исследованиях факторов ошибок пилотов

-

Идентификации ошибок пилота

-

Определение и классификация ошибок пилота

-

Решения принимаемые оператором и пилотом. (формулы)

-

Экология ресурсов пилота. «Человеческий фактор».

-

Психологическая характеристика ошибочный действий пилота

-

Слабоволие пилота

-

Индикативное состояние пилота. Виртуальное состояние пилота.

-

Коллизия образов у пилота самолета

-

Консуетальное состояние пилота

-

Психическое состояние пилота

-

Разбор инцидента типа посадки с невыпущенным шасси

-

Разбор инцидента — уход на второй круг

-

Инцидент типа — уборка шасси на пробеге

-

Экспериментально-психологическое моделирование ошибок пилота

-

Принцип операционализации — принцип в борьбы с ошибками в авиации

-

Операционализация за счет субъективных средств в авиации. Пример.

-

Принцип усложненных элементов управления самолета. Научно.

-

Примеры операционализации в авиационном мире.

Avia.pro

Самолеты считаются самым безопасным видом транспорта. Но, несмотря на это, трагических случаев избежать удается не всегда. Причиной катастрофы может стать и техническая неполадка, и попадание птиц в двигатель. Но большая часть авиапроисшествий происходит по вине человеческого фактора. Это может быть ошибка пилотов, их плохое самочувствие или психологическое состояние.

По вине экипажа разбился самолет Boeing 737-800 авиакомпании Flydubai, выполняющий рейс из Дубая в Ростов-на Дону. Экипаж, который в экстремальных погодных условиях принял неверное решение, не смог с первого раза посадить самолет. Выполняя вторую попытку посадки, пилоты совершили противоречивые действия, которые привели к резкому падению самолета. Авиалайнер спикировал на взлетно-посадочную полосу аэропорта и разбился, унеся с собой 62 человеческие жизни. Позднее стало известно, что командир корабля испытывал хроническую усталость и даже засыпал за штурвалом.

«Конечно, человеческий фактор — это основа основ. Но человек должен управлять. Техника есть техника. Это тупой металл, вода, воздух, кислород, азот, метан. Но для чего человек? Человек должен обладать не только просто умом, но и мужественным характером принятия решения, окончательного решения», — уверен заслуженный летчик-испытатель РФ, генерал-майор, Герой России Магомед Толбоев.

Весь мир потрясла трагедия, которая произошла во французских Альпах в 2015 году. 24 марта самолет авиакомпании German Wings Airbus A320 потерпел крушение в Прованских Альпах. Через 30 минут после взлета самолет внезапно перешел в быстрое снижение и еще через 10 минут врезался в горный склон и полностью разрушился. Все находившиеся на его борту 150 человек погибли. Причиной катастрофы стало самоубийство 28-летнего пилота Андреаса Лубицы.

Известно, что до катастрофы он несколько лет наблюдался у психиатров. В 2009 году Лубиц на полтора года прервал обучение в бременской школе пилотов Lufthansa из-за глубокой депрессии. А в 2013 году он сдал летные экзамены и был принят на работу в дочернюю компанию Lufthansa — German Wings. Лубиц прошел все тесты и был признан комиссией годным. Но он по-прежнему, страдая от депрессии, связанной с проблемами в личных отношениях, наблюдался в университетской клинике Дюссельдорфа и еще у нескольких психиатров.

24 марта 2015 года в 10:00 взлетел самолет. На борту находились командир воздушного судна, 34-летний опытнейший пилот Патрик Зондерхаймер и второй пилот — Андреас Лубиц. В 10:30 командир вышел из кабины в туалет, предлагая второму пилоту взять управление на себя. Второй пилот заблокировал дверь кабины пилотов и вручную переставил автопилот самолета с высоты 11,5 километров на 30 метров.

Лайнер пересек французский берег рядом с городом Тулон и начал снижение. Сначала на 100 метров, а спустя минуту — еще на 550 метров. Диспетчеры пытались связаться с самолетом, но он не отвечал.

В 10:35 командир вернулся к кабине. Он схватил лом и попытался взломать дверь. Среди пассажиров самолета началась паника.

В 10:40 лайнер снизился до 2 000 метров, исчезая с экранов радаров наземных служб, и задел правым крылом гору. В 10:41 самолет врезался в склон горы и взорвался. Никто из пассажиров и членов экипажа не выжил.

Позже в квартире Лубица следователи найдут в мусорной корзине разорванные больничные листы, выписанные пилоту двумя психиатрами за день до трагедии.

Как такое могло произойти и почему врачи не сообщили о болезни пилота авиационным властям — остается загадкой. Известно лишь, что в Европе стартовые медицинские осмотры до недавнего времени были отменены по настоянию профсоюзов. Решение о возможности лететь принимал командир корабля. А в Германии проверки психического состояния пилотов законодательно не были вообще предусмотрены.

Но можно ли предугадать, как поведет себя пилот в момент жесточайшего нервного напряжения? Кто же знал, что капитан пропавшего в 2013 году малазийского Boeing тоже окажется самоубийцей? Следователи, которые пытаются разгадать загадку исчезновения самолета над индийским океаном, приходят к шокирующим выводам. Оказывается, пилот намеренно разгерметизировал салон и после того, как все пассажиры и экипаж погибли, продолжил вести самолет с мертвыми пассажирами — так продолжалось на протяжении нескольких часов. И только когда у него стало заканчиваться топливо, он направил самолет в Индийский океан. Однако следствие еще не закончено, и какие будут окончательные выводы — мы сможем узнать позже.

Под влиянием колоссального стресса и психологической нагрузки во время полета может обостриться любое расстройство организма, считают психиатры. В России во врачебно-летную экспертную комиссию психологи были включены еще в конце 90-х годов. Благодаря им пилотов с выявленными расстройствами психики немедленно отстраняют от полетов. Кроме того, все пилоты проходят обязательный стартовый медицинский контроль. Он позволяет проверить экипаж не только на наличие в крови алкоголя и наркотических средств, но также обнаружить признаки простого ОРВИ, даже если сам пилот пока чувствует себя хорошо.

Череда инцидентов в воздухе заставляет всерьез задуматься о том, что же происходит на большой высоте, за закрытыми дверями кабин экипажа на борту самолетов, переполненных пассажирами, которые доверяют пилотам свою жизнь?

Пилот авиакомпании United Airlines опоздала на рейс и явилась в гражданской одежде и спортивной кепке. Выйдя к пассажирам, женщина сообщила всем по громкой связи, что если они не чувствуют себя в безопасности, то могут уходить.

Большой популярностью в Сети пользовалось видео, героями которого стали пилоты и стюардесса, которая демонстрировала стриптиз прямо во время полета из Европы в Великобританию.

А недавно новостные агентства облетела новость, что во время посадки самолета в Шотландии второй пилот компании EasyJet запаниковал и покинул кабину воздушного судна. Инцидент произошел , когда самолет пошел на снижение. Командир корабля был вынужден самостоятельно совершать посадку. На борту лайнера находилось 148 человек. И это не единственный случай нервного срыва. Например, пилот авиакомпании Jet2 упал в обморок во время рейса.

Кто отвечает сегодня за безопасность наших полетов? И чем причина авиакатастроф последних лет? Не пропустите новый выпуск программы «Скрытые угрозы» на телеканале «Звезда».

-

Человеческий фактор

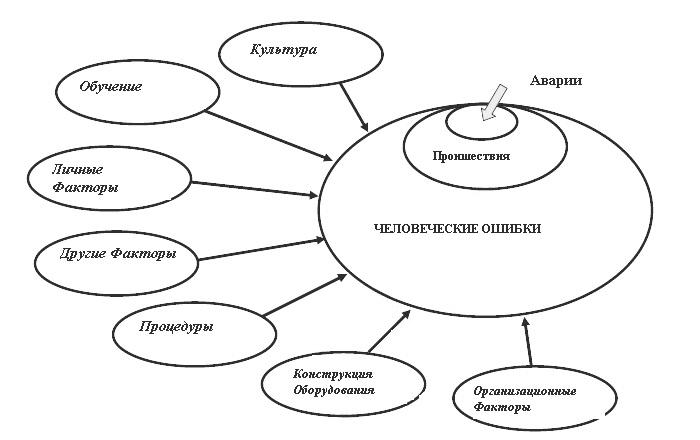

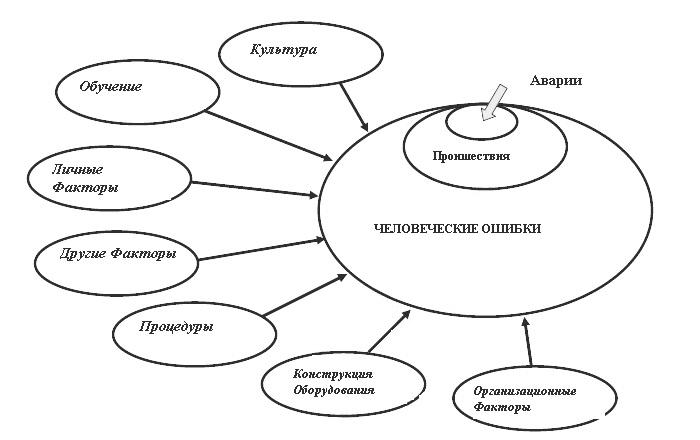

Человеческая

ошибка считается причиной или одним из

основных факторов в большинстве

авиааварий. Слишком часто компетентный

персонал совершает такие ошибки, хотя,

безусловно, они не планировали попадать

в аварию. Ошибки не являются неким типом

отклонений в поведении, они- естественный

продукт виртуальности всех усилий

человека. Ошибки должны быть приняты

как нормальный компонент любой системы,

в которой взаимодействуют техника и

человек.

Факторы, о которых

говорилось ранее, создают условия, в

которых люди допускают ошибки. Описанные

типы взаимодействия компонентов

авиасистемы (модель SHEL) дают представление

о том, что рамки для ошибок в авиации

очень широки[3]. Понимание того,

как нормальные люди

допускают ошибки является ключом к

руководству по безопасности. Только

тогда могут быть внедрены эффективные

способы уменьшения влияния человеческих

ошибок на безопасность.

Даже если человеческих

ошибок невозможно избежать, с ними можно

справиться с помощью внедрения

усовершенствованных технологий,

соответствующей тренировки и необходимых

уставов и процедур. Большинство средств

направлены на менеджмент ошибок,

включающих действия ведущего персонала.

Тем не менее, на действия пилотов,

контролеров, техников и т.д., могут

повлиять организационные, регуляторные,

культурные и окруженческие факторы,

влияющие и на рабочее место. Например,

организационные процессы составляют

питательную среду для многих предсказуемых

ошибок человека, такие как неадекватные

возможности коммуникаций, двусмысленные

процедуры, неудовлетворительное

планирование, недостаточность ресурсов,

нереальный бюджет – практически все

процесс, которые может контролировать

организация. Рисунок 1.1. подытоживает

некоторые факторы, вносящие свой вклад

в человеческие ошибки – и в аварии.

Рисунок 1.1. Факторы,

вносящие свой вклад в человеческие

ошибки

Типы ошибок

Ошибки могут

случаться уже на стадии планирования

или выполнения плана. Погрешности в

планировании ведут к ошибкам, либо

человек следует несоответствующим

процедурам разрешения рутинной проблемы,

или планирует несоответствующую

последовательность действий в выполнении

плана. Литература по человеческому

фактору обычно различает между промахами

и погрешностями в выполнении запланированных

действий.

Промах –

это незапланированное действие, тем не

менее заметное.

Погрешность –

это ошибка памяти, не заметная ни для

кого, кроме человека подзабывшего

необходимое действие.

a) Запланированные

ошибки

Во время решения

проблемы, мы интуитивно опираемся на

свод правил (стандартные процедуры

операций, правило большого пальца и

т.д.), известные нам и уже использованные

ранее, которые подходят к данной проблеме.

Ошибки могут случаться двумя путями:

использование правила не подходящего

к ситуации и правильное использование

правила с дефектом.

Неправильное

использование нужных правил. Такое

обычно происходит, когда оператор

встречается с ситуацией, имеющей много

общего с той, для которой правило

предназначено, но с некоторыми

существенными различиями. Если различия

не были распознаны, может быть использовано

не то правило.

Использование

неподходящих правил. это

включает в себя использование процедуры,

которая, как показывает опыт, срабатывала

ранее, но содержит нераспознанные

дефекты. Если такое решение сработало

в ситуации, когда было использовано

впервые, оно может стать частью

индивидуального подхода к решению

подобных проблем.

Когда у человека

нет готового решения, основанного на

предыдущем опыте и/или образовании, он

обращается к личным знаниям и опыту.

Принятие решения таким способом займет

большее количество времени, чем

применение, основанного на правиле

решения, так как оно требует обоснования

знаний по базовым принципам. Ошибки

возникают из-за недостатка знаний или

неправильного обоснования. Применение

знаний, основанных на личном опыте будет

особенно затруднено, так как человек в

это время будет занят, или его внимание

будет отвлечено от процесса обоснования

другими обстоятельствами. В таких

ситуациях возможность совершения ошибки

возрастает.

б) Ошибки

при выполнении (промахи и погрешности)

Действия опытного

человека рутинны и доведены до автоматизма,

человек только следит за прогрессом

промахи и погрешности возникают в

результате:

— Погрешности

внимания возникают

в результате невозможности проследить

за процессом выполнения рутинного

действия определенный критический

момент такое случается, когда

запланированная процедура сходна с

рутинным действием, выполнявшимся

ранее, но не идентична ему. Если внимание

рассеяно или в критический момент, когда

процедура отличается от привычного

действия, отвлечено, человек скорее

выполнит обычное действие, чем-то,

которое нужно в данный момент.

— Погрешности

памяти возникают,

когда ми либо забываем то, что намеревались

сделать, либо пропускаем элемент цепи

запланированных действий.

— Погрешности

восприятия –

ошибки в узнавании. Они возникают тогда,

когда мы уверены, что слышали или видели

что-то ранее, на самом деле отличное от

данных обстоятельств.

в) Ошибки

и грубые нарушения

Ошибки (являющиеся

нормальными человеческими действиями)

вполне отличны от нарушений. Оба действия

ведут к сбою в работе системы. Различия

лежат в намерении.

Нарушение – это

преднамеренный акт, тогда как ошибка

непреднамеренна. Например, возьмем

ситуацию, когда контролер позволяет

самолету снизиться до уровня самолета,

летящего с крейсерской скоростью, когда

расстояние дальномерного оборудования

между ними составляет 18 морских миль и

это случается в обстоятельствах, когда

необходимый минимум составляет 20 морских

миль. Если контролер допустил ошибку в

подсчете разницы расстояний дальномерного

оборудования, рекомендованных пилотами,

это будет погрешность. Если же контролер

все рассчитал правильно, и позволил

снижающемуся самолету снизиться до

уровня самолета, идущего с крейсерной

скоростью, зная, что условие необходимого

минимума не соблюдено, это будет грубым

нарушением.

Некоторые нарушения

являются результатом недостаточных

или нереальных действий, когда люди

выработали привычек «приблизительной

работы» во время выполнения задания. В

этом случае очень видно уведомить об

их выявлении, чтобы незамедлительно

исправить процедуры. В любой случае к

нарушениям не будут относиться терпимо.

Произошел ряд аварий, в которых

корпоративная культура толерантно

относящаяся к коротким путям вместо

следования опубликованным процедурам,

была названа среди причин возникновения

аварий.

Контроль над

человеческими ошибками

Счастью лишь

некоторые ошибки ведут к неблагоприятным

последствиям, не говоря уже об авариях.

Обычно ошибки выявляются и исправляются

без нежелательных результатов,

например, выбор неправильной частоты

или неисправность прибора определения

отметки высоты над уровнем моря, приводит

к неправильному выбору высоты. Понимание

того, что ошибка – это нормальное

человеческое поведение приводит к

невозможности устранения ошибки. В

таком случае цель состоит не в том, чтобы

избавиться от ошибки, но научиться

справляться с неизбежными погрешностями.

Стратегии менеджмента

человеческих ошибок кратко описаны

нижет такие стратегии применимы в

полете, контроле воздушно пространства

или ремонте самолета[4].

a) Сокращение

количества ошибок. Стратегия

имеет дело непосредственно с источником

возникновения ошибки, уменьшая или

устраняя факторы, приводящие к ошибке.

Она нацелена на устранение любых

неблагоприятных условий приводящих к

ошибке. Примеры данной стратегии включают

в себя улучшение доступа к самолету для

ремонта, улучшение освещения, при котором

выполняется задание, уменьшение

отвлекающих помех и обеспечение лучшей

тренировкой.

б) Выявление

ошибок предполагает,

что ошибка уже была допущена. Стратегия

направлена на ее выявление до того как

произойдут неблагоприятные последствия.

Выявление ошибок отличается от сокращения

ошибок тем, что стратегия не направлена

на непосредственное уменьшение или

избавление от ошибок. Примером стратегии

выявления ошибок может быть перепроверка

для подтверждения правильности выполнения

задания, функциональные тестовые полеты

и т.д.

в) Допустимые

отклонения относятся

к возможности системы принять ошибку

без неблагоприятных последствий примером

способов повышения допустимости ошибки

является взаимодействия множественной

гидравлической или электрической

системы, вырабатывающей избыток, или

программы структурной инспекции, дающий

множественные возможности прохудившиеся

места до того как те дадут значительные

трещины.

Цикл безопасности

Эффективная система

руководства безопасности требует

данного количества и потенциальных

взаимодействий факторов, влияющих на

безопасность. Необходимый пример типа

систематического процесса показан на

рисунке 1.2., Цикл безопасности. За ним

следует краткое описание цикла.

Рисунок 1.2. Цикл

безопасности

Выявление нарушений

– первый шаг в руководстве по безопасности.

Доказательство существования нарушений

может быть найдено рядом способов по

различным источникам, например:

a)

Нарушения и происшествия в работе

системы уведомления;

б) Расследование

и последующее уведомление о нарушениях

и происшествиях;

в) Анализ отклонений;

г) Обратная связь

от тренировок;

д) Анализ данных

полета;

е) Инспектирование

системы безопасности и аудит наблюдения

за безопасностью;

ж) Контроль за

нормальными операциями;

з) Государственное

расследование аварий и серьезных

происшествий; и

и) Системы по обмену

информацией.

Каждое выявленное

нарушение должно быть идентифицировано

и и приоритетно. Эта оценка требует

нахождения и анализа всей доступной

информации. Информация оценивается,

чтобы определить размеры нарушений в

работе, являются ли они «единственными

в своем роде» или системными? База данных

может потребоваться для облегчения

хранения и поиск информации. В этом

случае необходимы соответствующие

инструменты.

Обнаружив дефекты

в системе безопасности, должны быть

приняты решения о том, как избежать или

устранить нарушение, или уменьшить

сопряженный с ним риск. Решение должно

принимать во внимание локальные условия,

так как «один размер» не подходит ко

всем ситуациям. Нужно быть осторожным,

чтобы решение не повлекло за собой новых

нарушений. Это процесс менеджмента

риска.

Используется уже

однажды применимое действие по

безопасности, процесс контролируется,

чтобы быть уверенным, что результат был

достигнут, например:

a) Нарушение было

устранено (или, хотя бы, связанный с ним

риск был уменьшен в возможности и

серьезности);

б) Производятся

действия, позволяющие удовлетворительно

справиться с нарушениями; и

в) Никаких новых

неполадок не проникло в систему.

Если результаты

неудовлетворительные, весь процесс

повторяется сначала.

Вопросы безопасности

Управление

портативной, но надежной авиалинией

или поставщиком услуг требует постоянной

балансировки между необходимостью

следовать целям производства (такими

как, отправление во время) и целями

безопасности (дополнительное время,

которое требуется для проверки

безопасности закрытого выхода). Рабочее

пространство авиации наполнено

небезопасными условиями, которых нельзя

избежать, тем не мене операции должны

продолжаться.

Некоторые операции

берут на себя обязательство «нулевой

аварийности» и

утверждают, что «безопасность

их цель номе один».

Реальность состоит в том, что операторам

(так же как и некоторым коммерческим

авиационным организациям) необходимо

получать доход, чтобы выжить. Доход или

убыток – немедленный показатель

успешности в следовании своим

производительным целям. Как бы то ни

было, безопасность является необходимой

предпосылкой для стойкого авиабизнеса,

так как соблазн срезать углы будет

постепенно расти. Для многих компаний,

понятие безопасности может быть

определено отсутствием потерь в

катастрофах. Компании могут осознавать,

что имеют проблемы с безопасностью

только после аварии или потерь, частично

потому что это приведет к убыткам/уменьшением

прибылей. Тем не менее, компания может

работать годами, имея небезопасные

условия без неблагоприятных последствий.

В отсутствии эффективного руководства

по безопасности для выявления и устранения

небезопасных условий, компания может

считать, что выполняет цели по безопасности,

что доказывается «отсутствием

потерь». На

самом деле это просто счастливая

случайность.

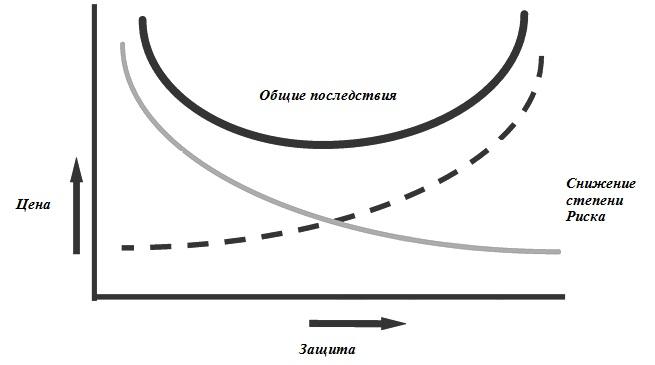

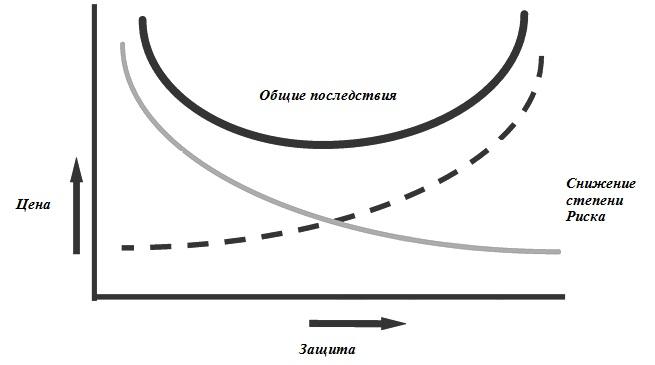

Рисунок 1.3. График

отношения затрат к безопасности

Безопасность и

прибыль не исключают друг друга. В самом

деле, качественные организации понимают,

что затраты на коррекцию небезопасных

условий – это вложение в дальнейшие

долгосрочные прибыли. Аварии стоят

дорого. Так деньги, истраченные на

способы снижения риска, снижают и потери

– как показано на рисунке 1.3. Тем не

менее, все большая и большая трата денег

на уменьшение степени риска может не

давать в результате равнозначную

прибыль. Компании должны сбалансировать

цену риска и расходы на способы степени

его снижения. Другими словами, некоторый

уровень потерь может быть принятым с

точки зрения соотношения прямой выгоды

и убытка. Как бы то ни было лишь немногие

компании способны пережить экономические

последствия большой катастрофы. Таким

образом, существует сильная экономическая

причина эффективного руководства

системой безопасности, чтобы справиться

с риском.

Цена риска

Существует три

типа последствий, связанных с аварией

или серьезным происшествием: Прямые,

Непрямые и Промышленные/Социальные

Прямые последствия:

Это очевидные

последствия, легко обозначаемые. В

большинстве своем, они связаны с

физическими увечьями, ремонт, замещение

или возмещение за повреждения, оборудование

самолета и ущерб собственности. Высокая

стоимость аварии может быть уменьшена

выплатой страховки.(Некоторые большие

организации пытаются обезопасить себя

сами, накоплением фондов для покрытия

расходов на риск).

Косвенные

последствия:

Так как страховка

может покрыть только определенные виды

расходов, существуют расходы не

покрываемые средствами страховки.

Понимание таких расходов является

фундаментальным для понимания экономики

безопасности.

Косвенные последствия

включают все, не покрываемые страховкой

расходы являются результатом аварии в

большей степени, чем прямые последствия.

Такие расходы не всегда ясны и часто

откладываются. Примеры некоторых

расходов, не входящих в страховку и

могущих накапливаться в зависимости

от аварии[5]

a) Потеря

бизнеса и непоправимый ущерб репутации

организации. Многие

организации не позволят своему персоналу

летать с оператором с запятнанной

репутацией безопасности.

б) Потери

в использовании оборудования приравниваются

к потерям дохода. Замененное оборудование

может выкупаться или арендоваться.

Компании, обслуживающие самолеты одного

типа могут оказаться в условиях, когда

их разработки и специально обученный

персонал оказываются лишними.

в) Потеря

продуктивности персонала. Если

люди пострадали в аварии и не могут

продолжать работу, многие государства

настаивают на продолжении им выплат.

Так же их необходимо заменить хотя бы

временно, что включает в себя расходы

по заработной плате, сверхурочные

(возможно расходы на обучение), так же

как и увеличение нагрузки на опытный

персонал.

г) Расследование

и чистка всегда

являются непрямыми расходами. Операторы

могут брать на себя расходы по

расследованию, возможному участию

персонала в расследовании, расходы на

тесты и анализы, сбор обломков,

восстановление места крушения и т.д.

д) Страховка —

уменьшение, общее обязательство многих

участников покрыть часть расходов по

последствиям любого происшествия. Право

на получение страховки ставит компанию

в категорию более вероятного риска в

целях страховки и таким образом может

повлиять на увеличение выплат. (И

наоборот, внедрение более надежной

системы безопасности может помочь

компании снизить выплаты).

е) Законные

действия и требования повреждения. Законные

выплаты могут постепенно накапливаться.

Пока существует возможность гарантировать

общественности надежность от повреждений,

виртуально невозможно избежать расхода

времени на решение юридических вопросов

и жалоб.

ж) Штрафы

и судебная ответственность могут

применяться властями так же, как и

закрытие небезопасных операций.

Промышленные и

социальные последствия:

В добавок к денежным

последствиям, описанным выше, авиакатастрофа

может повлечь за собой большее

снижение репутации авиапромышленности

и рынка в целом, чем происшествие на

авиалиниях. (События 11 сентября 2001 года

тому подтверждение). Пассажиры, выбирающие

альтернативные способы передвижения

(как железная дорога), могут подвергаться

дополнительному риску.

Цена происшествий

Серьезные

авиапроисшествия, результатом которых

стал меньший ущерб или увечья так же

могут подвергаться влиянию прямых и

косвенных последствий. Типичными

факторами последствий, возникающими

после таких происшествий являются:

a) Задержки и отмены

рейсов;

б) Альтернативные

способы перевозки пассажиров, удобства,

жалобы и т.д.;

в) Изменения состава

и расположения экипажа;

г) Потеря источника

дохода и репутации и т.д.;

д) Ремонт самолета

и тестовые полеты; и

е) Расследование

происшествия.

Цена безопасности

Цену безопасности

даже труднее определить, чем все

последствия аварии – частично из-за

трудности оценивания последствий

предотвращенных аварий. Как бы то ни

было, некоторые операторы пытаются

определить расходы и прибыль от

установления систем менеджмента

безопасности (СМБ). Они обнаружили, что

экономия существенна. Однако проведение

анализа прибыли затруднено, существует

процедура, которую необходимо выполнить,

а старшее руководство не расположено

тратить деньги, если нет прибыли,

поддающейся количественному определению.

Один путь решения этого вопроса –

отделение расходов на систему менеджмента

безопасности от расходов по коррекции

дефектов системы, возлагая ответственность

за расходы на систему менеджмента

безопасности на отдел безопасности, а

за расходы по коррекции дефектов системы

— на линейное руководство. Эта процедура

вовлекает старшее руководство в оценку

расходов и прибыли от системы менеджмента

безопасности.

Человеческий фактор в кабине пилота

Наиболее вероятной причиной гибели самолётов со всеми пассажирами и экипажем оказываются необъяснимо неловкие действия опытных пилотов

6 октября 2008

Фотографии с места падения Боинга-737 в Перми. Наиболее вероятной причиной катастрофы считается человеческий фактор.По мнению специалистов, пилотов мог сбить с толку непривычный им иностранный авиагоризонт — прибор, показывающий наклон самолёта в продольной и поперечной плоскостях. Российский авиагоризонт имеет обратную индикацию — пилот в нём видит качающийся символ самолёта на фоне неподвижного горизонта; иностранные же показывают реальный вид из кабины — качающийся горизонт.

«Я ему сказал: „По моим данным, вы набираете высоту. Подтвердите, что текущая высота — 900 метров“. Он ответил: „Да, подтверждаю, но мы снижаемся“. А сам в это время продолжал набор высоты 1200». Так диспетчер аэродрома «Большое Савино» описывает «неадекватное» поведение пилота Боинга-737, разбившегося 14 сентября 2008 года в Перми. В интервью «Первому каналу» диспетчер рассказал, что командир самолёта выполнял инструкции с точностью до наоборот. Среди многочисленных версий, разрабатываемых следствием, наиболее вероятной считается человеческий фактор.

По статистике Межгосударственного авиационного комитета (МАК), который занимается расследованием всех авиакатастроф, произошедших на территории стран СНГ, 70% происшествий за последние пять лет связаны с человеческим фактором. «Сколько лет я в авиации, всегда всё списывают на членов экипажа, погибших в катастрофе», — комментирует мой собеседник, который попросил не раскрывать его имя, в прошлом бортинженер вертолета Ми-8, в настоящее время сотрудник инженерной службы московской авиакомпании.

Право на человеческий фактор

Под человеческим фактором чаще всего подразумевают ошибку специалиста с последующим возложением на него вины и ответственности. «Это проявляется в характерных высказываниях, — пишет доктор медицинских наук, профессор Валерий Козлов в статье „Человеческий фактор: Толкование, понимание и внимание“, — как, например: „Причина произошедшего очевидна — человеческий фактор. Виноват Петров“». Бывает, что к трагедии приводит безответственное поведение лётчика, когда он даёт «порулить» пассажиру, случается, что в самолёт ставят новое оборудование, которое опытный пилот в решающий момент не может понять, или же его подводят профессиональные качества. Обычно всё это определяют как «человеческий фактор», что неверно.

Около ста лет назад стало понятно, что не все романтически настроенные юноши смогут освоить лётную профессию. Вместе с профессиональным психологическим отбором появился термин «личный фактор». Владимир Пономаренко, почётный президент Международной академии проблем человека в авиации и космонавтике, профессор психологии лётного труда, даёт такое определение этому понятию: личный фактор включает в себя «сферу врождённых и приобретённых качеств личности, сферу волевых и эмоциональных свойств субъекта, его черты характера и темперамента, задатки и способности, склонности и интересы, вкусы и привычки, моральный облик, физическое и умственное развитие конкретного человека, которое можно поставить в связь с причиной конкретного лётного происшествия». В 20-х годах ХХ века немецкий психолог Карл Марбе (Karl Marbe, 1869–1953) предложил радикальную трактовку влияния личного фактора на профессиональную деятельность. Он считал, что существуют так называемые «несчастники» — люди, фатально предрасположенные к производственным травмам.

Однако в конце 1920-х — начале 1930-х годов, — объясняет Валерий Козлов, — учёные обнаружили, что далеко не всегда причину ошибки человека можно связать с его индивидуальными особенностями. Даже безукоризненно здоровый и психологически устойчивый член экипажа в полёте может совершить ошибку — например, из-за плохой эргономики кабины или из-за того, что руководство требует подвигов и экономической прибыли, но совершенно не уделяет внимания оптимизации режима труда и отдыха. Если верить статистике, приводимой Пономаренко, треть ошибок лётчики совершают из-за эргономических недостатков, конструкторско-производственных дефектов, слабого психолого-методического обеспечения при переучивании.

Кабина лайнера «Конкорда». 25 июля 2000 года «Конкорд» компании «Эр Франс» через 3 минуты после взлёта из аэропорта «Шарль де Голль» рухнул на землю. Погибли 113 человек.

Правительственная комиссия по расследованию причин катастрофы назвала виновником трагедии покрышку основного шасси самолёта, развалившуюся во время разбега перед самым отрывом от земли. Кусок резины, армированный стальным кордом, пробил обшивку самолёта и балансировочный топливный бак — горючее хлынуло на двигатель. Какое-то время автоматическая противопожарная система справлялась с огнём, но пробоина была слишком велика, вспыхнул и второй двигатель. Действия экипажа были признаны правильными, даже героическими. По мнению экспертов, взрыв самолёта был неизбежен.

Оказалось, что часть ошибок совершается экипажем из-за объективных психофизических ограничений возможностей человека. Именно тогда было введено понятие «человеческий фактор», под которым понимают «возможности человека и ограничения его психики, проявляющиеся в конкретных условиях его взаимодействия с объектом управления».

Задача специалистов — вовремя обнаружить скрытые опасности, которые могут привести к сбоям в работе системы. Так, опасными факторами со стороны человека могут быть, например, недостаточный уровень профессиональной подготовки, усталость, ухудшение состояния здоровья, снижение работоспособности и мотивации.

Каких не берут в авиаторы

Профессионально важные качества (ПВК) лётчиков делят на пять групп: личностные, интеллектуальные, психофизиологические, физиологические и физические. К первым относятся нравственные (порядочность, честность, чувство долга) и социальные (коммуникабельность, склонность к лидерству, стремление к профессиональному развитию) качества, способность к адекватной самооценке, адаптивные способности, профессиональная мотивация. Интеллектуальные качества лётчика — это способность к ориентировке в сложном пространственном окружении, эффективные действия в условиях дефицита времени и навязанного темпа работы и быстрое переключение внимания. Психофизиологические — подразумевают нервно-эмоциональную устойчивость, а также устойчивость к лётному утомлению, к монотонности и работе в вынужденном темпе. Физиологические качества — вестибулярная устойчивость, устойчивость к длительным перегрузкам и к другим специфическим факторам полета. Физические — сила, быстрота, выносливость, антропометрические качества. «Ведущие лётные способности: интеллект, пространственная ориентировка, воля, оперативное мышление, гибкость и динамичность нервной системы, склонность к риску», — считает Пономаренко. Наоборот, неприемлемые для лётчика качества — эмоциональная возбудимость и недостаток внимательности.

В условиях лётной работы развитие профессионально важных качеств приобретает принципиальное значение. Условием допуска в авиацию является серьёзный медицинский и психологический отбор, который проходят все абитуриенты при поступлении в лётные училища. «Среди летчиков редко встречаются лица, не отвечающие по своим основным характеристикам требованиям избранной профессии», — замечает Козлов в статье «Новое понятие: потенциал надежности пилота!».

Вместе с тем ряд свойств и качеств человека оценить непросто. Например, социально-психологические: дисциплинированность, наличие авантюристических наклонностей, повышенную склонность к необоснованному риску. Некоторые же профессионально важные качества нуждаются в развитии, например, глазомер, вестибулярная устойчивость. Поэтому состоявшиеся профессионалы тоже не лишены приятных часов общения с врачами и психологами.

Все члены лётного (лётчики, бортинженеры, штурманы) и кабинного (бортпроводники, бортоператоры) экипажей не только ежегодного проходят медкомиссию, но и оказываются объектами пристального изучения врачей перед каждым полётом. Им проверяют пульс, давление, температуру, состояние психомоторики, эмоциональное состояние. Помимо чисто медицинских обследований, предусмотрены психологические тесты. Знакомый лётчик рассказал байку о находчивости пилотов при прохождении таких тестов. Конец 80-х, Хабаровск, врачебно-лётная экспертная комиссия. Психолог поставил банку с маленькими рыбками на магнитах, раздал экипажу удочки и говорит: «Вы пока рыбку ловите, а я отлучусь минут на десять». Возвращается и спрашивает: «Ну как? Поймали что-нибудь?» «Конечно, поймали!» — отчитываются лётчики и достают из пакета свежую рыбину полметра длиной.

Для отработки профессиональных навыков используются тренажеры, имитирующие разные виды самолётов. «Идёшь на тренировку и думаешь «Никогда тренажёры не сравнятся с настоящей работой», — делится впечатлениями бывший бортинженер. — «А когда начинаешь работать, забываешь о том, что вертолёт-то стоит на земле. Всё моделируется: здание аэровокзала, взлётная полоса, в полёте — обычное серое небо. Снижаешься до определённой высоты и опять видишь аэропорт. При посадке характерная тряска, вибрация». На тренажёрах отрабатываются не только нормальные полёты, но и аварийные. Инструктор вводит разные неисправности: разгерметизация, отказы двигателей, авиагоризонтов, системы кондиционирования. Лётчики должны научиться быстро оценивать обстановку, оперативно принимать правильные решения, грамотно действовать во всех ситуациях.

Но профессионально важные качества лётчика могут и не соответствовать должному уровню. Например, из-за дефицита кадров могут снижаться требования при приёме на работу. Или же эти качества могут ухудшаться с возрастом, от семейных неурядиц или отсутствия мотивации.

Симулятор для пилотов Б-52. Инструктор задаёт экипажу условия полёта. На заднем плане — кабина тренажёра.

Штурвал в дрожащих руках

Каким бы опытным ни был специалист, никто не отменял объективных психофизиологических факторов, влияющих на него во время полёта, тем более — в аварийной ситуации. Повышенная эмоциональная напряжённость — нормальная реакция организма на опасность. Однако, как отмечает В. А. Пономаренко и И. М. Алпатов в статье «Психофизиологические основы обеспечения безопасности полётов», не эмоциональная напряжённость, а психические состояния обеспечивают деятельность в экстремальных условиях, которая организуется по другим законам. Когда напряжение начинает нарастать, то до некоторого момента оно отражает мобилизацию функциональных возможностей организма и повышение работоспособности. Но когда критический порог пройден и напряжение становится чрезмерным, работоспособность падает, затрудняется мышление, сужается объём памяти.

Крайняя эмоциональная напряженность — стресс — проявляется двумя формами реакций: скованность, заторможенность или, наоборот, состояние сильного возбуждения. Заторможенность может достигать катастрофических масштабов — иногда пилот застывает на месте в той позе, в которой был в момент получения информации о ЧП. При этом интеллектуальная деятельность сохраняется: он знает, что нужно, например, приготовиться к катапультированию, но сделать не может ровным счётом ничего. Чрезмерное возбуждение может выражаться вегетативными нарушениями в виде бледности, учащенного сердцебиения и пульса, поверхностного дыхания, дрожания рук, потливости.

Самое деструктивное влияние стресс оказывает на восприятие и мышление. Замедленные и ошибочные действия, как правило, возникают в связи с нарушением процессов приёма, переработки информации и принятия решения. Аварийная ситуация отличается от нормальной необходимостью быстро переключиться с заученных стереотипных сенсомоторных навыков на новый план действий и новый образ полёта. Члены экипажа должны в условиях дефицита времени и информации распознать аварийную ситуацию и принять решение о конкретных действиях.

Согласно данным Пономаренко, две трети времени пилот тратит на принятие решения. Ой как непросто логично мыслить, когда неадекватно воспринимаешь действительность, когда трудно анализировать информацию и не помнишь, что было 5 минут назад. К тому же, может измениться представление о времени — кажется, что прошла целая вечность до того, как экипаж дал ответ на приказ командира.

Авиашоу на базе ВВС США в Айдахо. 14 сентября 2003 года. Капитан Кристофер Стриклин (Christopher Stricklin) катапультировался за секунду до падения самолёта F-16 — он сумел отвести его в сторону от 60-тысячной толпы и покинул самолёт только тогда, когда убедился, что больше ничего не может сделать для его спасения.

Находясь в состоянии стресса, пилот может «потерять» приборы на приборной доске, не заметить сигнализацию о выпуске шасси, неправильно интерпретировать происходящее, пропустить необходимое действие (например, когда отвлекается на радиосвязь). Иногда у лётчиков из-за очень высокого нервно-психического напряжения, связанного с необходимостью выполнить одновременно и за короткий срок несколько одинаково ответственных дел, на короткое время ухудшается общее самочувствие, путаются мысли. К грубым ошибкам может привести так называемая преждевременная психическая демобилизация: успешно выполнив основное задание, лётчик решил, что всё самое трудное уже позади, и расслабился.

Не менее опасным может быть и состояние эйфории — «Ура, мы сделали это!» В свою очередь, в так называемом доминантном состоянии, когда эмоциональные сдвиги превалируют над мышлением, лётчик из целого комплекса задач, требующих немедленного решения, концентрируется на выполнении какой-то одной.

В некоторых случаях нелогичные действия экипажа могут быть вызваны сугубо экономическими соображениями. Пономаренко говорит о формировании «синдрома виновности» у лётчиков из-за того, что человеческий фактор (трактуемый исключительно как вина лётчика) стал универсальным объяснением причин большинства авиационных происшествий. «Условно говоря, на 100 погибших, скажем, лётчиков-истребителей, более 50% имели возможность воспользоваться средством катапультирования, но не использовали. Боролись за жизнь самолёта, за свою честь, долг, предчувствуя последствия разборов, разносов на земле», — пишет он. «Нужно долететь, потому что иначе пойдешь на ковёр к начальству. Если жив останешься, конечно», — делится бывший бортинженер. Не стоит забывать и о том, что россиян давно воспитывают в духе геройских подвигов: «Прорвёмся! Пересилим! Выстоим!»

Предполагается, что хорошие, а, главное, многочисленные правила и строжайшее их выполнение помогут предотвратить авиакатастрофы. «Хотя исполнение правил и важно, одного этого недостаточно. Если бы исполнение гарантировало безопасность, нам бы было достаточно правила: „Не разбиваться“» — считает Уильям Восс (William R. Voss), президент Всемирного фонда безопасности полётов (Flight safety foundation). Все рассуждают об ошибках пилотов, но никто почему-то не говорит о тысячах случаев, когда человеческий фактор оказался спасительным для экипажа и пассажиров. Когда пилот, превозмогая психическое напряжение и сложность ситуации, принял единственно верное решение. Если бы пилотирование могло быть полностью формализовано, то при сегодняшнем уровне развития автоматизации человек был бы не нужен. В салонах пассажирских самолетов нас бы приветствовали только бортпроводники, а после взлёта механический голос сообщал бы нам: «Вас обслуживает автопилот Быстрый-1».

From Wikipedia, the free encyclopedia

1994 Fairchild Air Force Base B-52 crash, caused by flying the aircraft beyond its operational limits. Here the aircraft is seen in an unrecoverable bank, a split second before the crash. This accident is now used in military and civilian aviation environments as a case study in teaching crew resource management.

Actual flight path (red) of TWA Flight 3 from departure to crash point (controlled flight into terrain). Blue line shows the nominal Las Vegas course, while green is a typical course from Boulder. The pilot inadvertently used the Boulder outbound course instead of the appropriate Las Vegas course.

Departure/destination airports and crash site location of Varig Flight 254 (major navigational error leading to fuel exhaustion). The flight plan was later shown to 21 pilots of major airlines. No fewer than 15 pilots committed the same mistake.

Map of the Linate Airport disaster caused by taking the wrong taxiing route (red instead of green), as control tower had not given clear instructions. The accident occurred in thick fog.

The Tenerife airport disaster now serves as a textbook example.[1] Due to several misunderstandings, the KLM flight tried to take off while the Pan Am flight was still on the runway. The airport was accommodating an unusually large number of commercial airliners, resulting in disruption of the normal use of taxiways.

The «three-pointer» design altimeter is one of the most prone to being misread by pilots (a cause of the UA 389 and G-AOVD crashes).

Pilot error generally refers to an accident in which an action or decision made by the pilot was the cause or a contributing factor that led to the accident, but also includes the pilot’s failure to make a correct decision or take proper action.[2] Errors are intentional actions that fail to achieve their intended outcomes.[3] Chicago Convention defines accident as «An occurrence associated with the operation of an aircraft […] in which […] a person is fatally or seriously injured […] except when the injuries are […] inflicted by other persons.»[4] Hence the definition of the «pilot error» does not include deliberate crash (and such crash is not an accident).

The causes of pilot error include psychological and physiological human limitations. Various forms of threat and error management have been implemented into pilot training programs to teach crew members how to deal with impending situations that arise throughout the course of a flight.[5]

Accounting for the way human factors influence the actions of pilots is now considered standard practice by accident investigators when examining the chain of events that led to an accident.[5][6]

Description[edit]

Modern accident investigators avoid the words «pilot error», as the scope of their work is to determine the cause of an accident, rather than to apportion blame. Furthermore, any attempt to incriminate the pilots does not consider that they are part of a broader system, which in turn may be accountable for their fatigue, work pressure, or lack of training.[6] The International Civil Aviation Organization (ICAO), and its member states, therefore adopted James Reason’s model of causation in 1993 in an effort to better understand the role of human factors in aviation accidents.[7]

Pilot error is nevertheless a major cause of air accidents. In 2004, it was identified as the primary reason for 78.6% of disastrous general aviation (GA) accidents, and as the major cause of 75.5% of GA accidents in the United States.[8][better source needed] There are multiple factors that can cause pilot error; mistakes in the decision-making process can be due to habitual tendencies, biases, as well as a breakdown in the processing of the information coming in. For aircraft pilots, in extreme circumstances these errors are highly likely to result in fatalities.[9]

Causes of pilot error[edit]

Pilots work in complex environments and are routinely exposed to high amounts of situational stress in the workplace, inducing pilot error which may result in a threat to flight safety. While aircraft accidents are infrequent, they are highly visible and often involve significant numbers of fatalities. For this reason, research on causal factors and methodologies of mitigating risk associated with pilot error is exhaustive. Pilot error results from physiological and psychological limitations inherent in humans. «Causes of error include fatigue, workload, and fear as well as cognitive overload, poor interpersonal communications, imperfect information processing, and flawed decision making.»[10] Throughout the course of every flight, crews are intrinsically subjected to a variety of external threats and commit a range of errors that have the potential to negatively impact the safety of the aircraft.[11]

Threats[edit]

The term «threat» is defined as any event «external to flight crew’s influence which can increase the operational complexity of a flight.»[12] Threats may further be broken down into environmental threats and airline threats. Environmental threats are ultimately out of the hands of crew members and the airline, as they hold no influence on «adverse weather conditions, air traffic control shortcomings, bird strikes, and high terrain.»[12] Conversely, airline threats are not manageable by the flight crew, but may be controlled by the airline’s management. These threats include «aircraft malfunctions, cabin interruptions, operational pressure, ground/ramp errors/events, cabin events and interruptions, ground maintenance errors, and inadequacies of manuals and charts.»[12]

Errors[edit]

The term «error» is defined as any action or inaction leading to deviation from team or organizational intentions.[10] Error stems from physiological and psychological human limitations such as illness, medication, stress, alcohol/drug abuse, fatigue, emotion, etc. Error is inevitable in humans and is primarily related to operational and behavioral mishaps.[13] Errors can vary from incorrect altimeter setting and deviations from flight course, to more severe errors such as exceeding maximum structural speeds or forgetting to put down landing or takeoff flaps.

Decision making[edit]

Reasons for negative reporting of accidents include staff being too busy, confusing data entry forms, lack of training and less education, lack of feedback to staff on reported data and punitive organizational cultures.[14] Wiegmann and Shappell invented three cognitive models to analyze approximately 4,000 pilot factors associated with more than 2,000 U.S. Navy aviation mishaps. Although the three cognitive models have slight differences in the types of errors, all three lead to the same conclusion: errors in judgment.[15] The three steps are decision-making, goal-setting, and strategy-selection errors, all of which were highly related to primary accidents.[15] For example, on 28 December 2014, AirAsia Flight 8501, which was carrying seven crew members and 155 passengers, crashed into the Java Sea due to several fatal mistakes made by the captain in the poor weather conditions. In this case, the captain chose to exceed the maximum climb rate for a commercial aircraft, which caused a critical stall from which he was unable to recover.[16]

Threat and error management (TEM)[edit]

TEM involves the effective detection and response to internal or external factors that have the potential to degrade the safety of an aircraft’s operations.[11] Methods of teaching TEM stress replicability, or reliability of performance across recurring situations.[17] TEM aims to prepare crews with the «coordinative and cognitive ability to handle both routine and unforeseen surprises and anomalies.»[17] The desired outcome of TEM training is the development of ‘resiliency’. Resiliency, in this context, is the ability to recognize and act adaptively to disruptions which may be encountered during flight operations. TEM training occurs in various forms, with varying levels of success. Some of these training methods include data collection using the line operations safety audit (LOSA), implementation of crew resource management (CRM), cockpit task management (CTM), and the integrated use of checklists in both commercial and general aviation. Some other resources built into most modern aircraft that help minimize risk and manage threat and error are airborne collision and avoidance systems (ACAS) and ground proximity warning systems (GPWS).[18] With the consolidation of onboard computer systems and the implementation of proper pilot training, airlines and crew members look to mitigate the inherent risks associated with human factors.

Line operations safety audit (LOSA)[edit]

LOSA is a structured observational program designed to collect data for the development and improvement of countermeasures to operational errors.[19] Through the audit process, trained observers are able to collect information regarding the normal procedures, protocol, and decision making processes flight crews undertake when faced with threats and errors during normal operation. This data driven analysis of threat and error management is useful for examining pilot behavior in relation to situational analysis. It provides a basis for further implementation of safety procedures or training to help mitigate errors and risks.[12] Observers on flights which are being audited typically observe the following:[19]

- Potential threats to safety

- How the threats are addressed by the crew members

- The errors the threats generate

- How crew members manage these errors (action or inaction)

- Specific behaviors known to be associated with aviation accidents and incidents

LOSA was developed to assist crew resource management practices in reducing human error in complex flight operations.[12] LOSA produces beneficial data that reveals how many errors or threats are encountered per flight, the number of errors which could have resulted in a serious threat to safety, and correctness of crew action or inaction. This data has proven to be useful in the development of CRM techniques and identification of what issues need to be addressed in training.[12]

Crew resource management (CRM)[edit]

CRM is the «effective use of all available resources by individuals and crews to safely and effectively accomplish a mission or task, as well as identifying and managing the conditions that lead to error.»[20] CRM training has been integrated and mandatory for most pilot training programs, and has been the accepted standard for developing human factors skills for air crews and airlines. Although there is no universal CRM program, airlines usually customize their training to best suit the needs of the organization. The principles of each program are usually closely aligned. According to the U.S. Navy, there are seven critical CRM skills:[20]

- Decision making – the use of logic and judgement to make decisions based on available information

- Assertiveness – willingness to participate and state a given position until convinced by facts that another option is more correct

- Mission analysis – ability to develop short and long term contingency plans

- Communication – clear and accurate sending and receiving of information, instructions, commands and useful feedback

- Leadership – ability to direct and coordinate activities of pilots & crew members

- Adaptability/flexibility – ability to alter course of action due to changing situations or availability of new information

- Situational awareness – ability to perceive the environment within time and space, and comprehend its meaning

These seven skills comprise the critical foundation for effective aircrew coordination. With the development and use of these core skills, flight crews «highlight the importance of identifying human factors and team dynamics to reduce human errors that lead to aviation mishaps.»[20]

Application and effectiveness of CRM[edit]

Since the implementation of CRM circa 1979, following the need for increased research on resource management by NASA, the aviation industry has seen tremendous evolution of the application of CRM training procedures.[21] The applications of CRM has been developed in a series of generations:

- First generation: emphasized individual psychology and testing, where corrections could be made to behavior.

- Second generation: featured a shift in focus to cockpit group dynamics.

- Third evolution: diversification of scope and an emphasis on training crews in how they must function both in and out of the cockpit.

- Fourth generation: CRM integrated procedure into training, allowing organizations to tailor training to their needs.

- Fifth generation (current): acknowledges that human error is inevitable and provides information to improve safety standards.[22]

Today, CRM is implemented through pilot and crew training sessions, simulations, and through interactions with senior ranked personnel and flight instructors such as briefing and debriefing flights. Although it is difficult to measure the success of CRM programs, studies have been conclusive that there is a correlation between CRM programs and better risk management.[22]

Cockpit task management (CTM)[edit]

Multiple sources of information can be taken from one interface here, known as the PFD, or primary flight display from which pilots receive all of the most important data readings

Cockpit task management (CTM) is the «management level activity pilots perform as they initiate, monitor, prioritize, and terminate cockpit tasks.»[23] A ‘task’ is defined as a process performed to achieve a goal (i.e. fly to a waypoint, descend to a desired altitude).[23] CTM training focuses on teaching crew members how to handle concurrent tasks which compete for their attention. This includes the following processes:

- Task initiation – when appropriate conditions exist

- Task monitoring – assessment of task progress and status

- Task prioritization – relative to the importance and urgency for safety

- Resource allocation – assignment of human and machine resources to tasks which need completion

- Task interruption – suspension of lower priority tasks for resources to be allocated to higher priority tasks

- Task resumption – continuing previously interrupted tasks

- Task termination – the completion or incompletion of tasks

The need for CTM training is a result of the capacity of human attentional facilities and the limitations of working memory. Crew members may devote more mental or physical resources to a particular task which demands priority or requires the immediate safety of the aircraft.[23] CTM has been integrated to pilot training and goes hand in hand with CRM. Some aircraft operating systems have made progress in aiding CTM by combining instrument gauges into one screen. An example of this is a digital attitude indicator, which simultaneously shows the pilot the heading, airspeed, descent or ascent rate and a plethora of other pertinent information. Implementations such as these allow crews to gather multiple sources of information quickly and accurately, which frees up mental capacity to be focused on other, more prominent tasks.

A military pilot reads the pre-flight checklist prior the mission. Checklists ensure that pilots are able to follow operational procedure and aids in memory recall.

Checklists[edit]

The use of checklists before, during and after flights has established a strong presence in all types of aviation as a means of managing error and reducing the possibility of risk. Checklists are highly regulated and consist of protocols and procedures for the majority of the actions required during a flight.[24] The objectives of checklists include «memory recall, standardization and regulation of processes or methodologies.»[24] The use of checklists in aviation has become an industry standard practice, and the completion of checklists from memory is considered a violation of protocol and pilot error. Studies have shown that increased errors in judgement and cognitive function of the brain, along with changes in memory function are a few of the effects of stress and fatigue.[25] Both of these are inevitable human factors encountered in the commercial aviation industry. The use of checklists in emergency situations also contributes to troubleshooting and reverse examining the chain of events which may have led to the particular incident or crash. Apart from checklists issued by regulatory bodies such as the FAA or ICAO, or checklists made by aircraft manufacturers, pilots also have personal qualitative checklists aimed to ensure their fitness and ability to fly the aircraft. An example is the IM SAFE checklist (illness, medication, stress, alcohol, fatigue/food, emotion) and a number of other qualitative assessments which pilots may perform before or during a flight to ensure the safety of the aircraft and passengers.[24] These checklists, along with a number of other redundancies integrated into most modern aircraft operation systems, ensure the pilot remains vigilant, and in turn, aims to reduce the risk of pilot error.

Notable examples[edit]

One of the most famous examples of an aircraft disaster that was attributed to pilot error was the night-time crash of Eastern Air Lines Flight 401 near Miami, Florida on 29 December 1972. The captain, first officer, and flight engineer had become fixated on a faulty landing gear light and had failed to realize that one of the crew had accidentally bumped the flight controls, altering the autopilot settings from level flight to a slow descent. Told by ATC to hold over a sparsely populated area away from the airport while they dealt with the problem (with, as a result, very few lights visible on the ground to act as an external reference), the distracted flight crew did not notice the plane losing height and the aircraft eventually struck the ground in the Everglades, killing 101 of the 176 passengers and crew. The subsequent National Transportation Safety Board (NTSB) report on the incident blamed the flight crew for failing to monitor the aircraft’s instruments properly. Details of the incident are now frequently used as a case study in training exercises by aircrews and air traffic controllers.

During 2004 in the United States, pilot error was listed as the primary cause of 78.6% of fatal general aviation accidents, and as the primary cause of 75.5% of general aviation accidents overall.[26] For scheduled air transport, pilot error typically accounts for just over half of worldwide accidents with a known cause.[8]

- 28 July 1945 – A United States Army Air Forces B-25 bomber bound for Newark Airport crashed into the 79th floor of the Empire State Building after the pilot became lost in a heavy fog bank over Manhattan. All three crewmen were killed as well as eleven office workers in the building.

- 24 December 1958 – BOAC Bristol Britannia 312, registration G-AOVD, crashed as a result of a controlled flight into terrain (CFIT), near Winkton, England, while on a test flight. The crash was caused by a combination of bad weather and a failure on the part of both pilots to read the altimeter correctly. The first officer and two other people survived the crash.

- 3 January 1961 – Aero Flight 311 crashed near Kvevlax, Finland. All twenty-five occupants were killed in the accident, which was the deadliest in Finnish history. An investigation later determined that both pilots were intoxicated during the flight, and may have been interrupted by a passenger at the time of the crash.

- 28 February 1966 – American astronauts Elliot See and Charles Bassett were killed when their T-38 Talon crashed into a building at Lambert–St. Louis International Airport during bad weather. A NASA investigation concluded that See had been flying too low on his landing approach.

- 5 May 1972 — Alitalia Flight 112 crashed into Mount Longa after the flight crew did not adhere to approach procedures established by ATC. All 115 occupants perished. This is the worst single-aircraft disaster in Italian history.

- 29 December 1972 – Eastern Air Lines Flight 401 crashed into the Florida Everglades after the flight crew failed to notice the deactivation of the plane’s autopilot, having been distracted by their own attempts to solve a problem with the landing gear. Out of 176 occupants, 75 survived the crash.

- 27 March 1977 – The Tenerife airport disaster: a senior KLM pilot failed to hear, understand or follow instructions from the control tower, causing two Boeing 747s to collide on the runway at Tenerife. A total of 583 people were killed in the deadliest aviation accident in history.

- 28 December 1978 – United Airlines Flight 173: a flight simulator instructor captain allowed his Douglas DC-8 to run out of fuel while investigating a landing gear problem. United Airlines subsequently changed their policy to disallow «simulator instructor time» in calculating a pilot’s «total flight time». It was thought that a contributory factor to the accident is that an instructor can control the amount of fuel in simulator training so that it never runs out.

- 13 January 1982 – Air Florida Flight 90, a Boeing 737-200 with 79 passengers and crew, crashed into the 14th Street Bridge and careened into the Potomac River shortly after taking off from Washington National Airport, killing 75 passengers and crew, and four motorists on the bridge. The NTSB report blamed the flight crew for not properly employing the plane’s de-icing system.

- 19 February 1985 – The crew of China Airlines Flight 006 lost control of their Boeing 747SP over the Pacific Ocean, after the No. 4 engine flamed out. The aircraft descended 30,000 feet in two-and-a-half minutes before control was regained. There were no fatalities but there were several injuries, and the aircraft was badly damaged.

- 16 August 1987 – The crew of Northwest Airlines Flight 255 omitted their taxi checklist and failed to deploy the aircraft’s flaps and slats. Subsequently, the McDonnell Douglas MD-82 did not gain enough lift on takeoff and crashed into the ground, killing all but one of the 155 people on board, as well as two people on the ground. The sole survivor was a four-year-old girl named Cecelia Cichan, who was seriously injured.

- 28 August 1988 – The Ramstein airshow disaster: a member of an Italian aerobatic team misjudged a maneuver, causing a mid-air collision. Three pilots and 67 spectators on the ground were killed.

- 31 August 1988 – Delta Air Lines Flight 1141 crashed on takeoff after the crew forgot to deploy the flaps for increased lift. Of the 108 passengers and crew on board, fourteen were killed.

- 8 January 1989 – In the Kegworth air disaster, a fan blade broke off in the left engine of a new Boeing 737-400, but the pilots mistakenly shut down the right engine. The left engine eventually failed completely and the crew were unable to restart the right engine before the aircraft crashed. Instrumentation on the 737-400 was different from earlier models, but no flight simulator for the new model was available in Britain.

- 3 September 1989 – The crew of Varig Flight 254 made a series of mistakes so that their Boeing 737 ran out of fuel hundreds of miles off-course above the Amazon jungle. Thirteen died in the ensuing crash landing.

- 21 October 1989 – Tan-Sahsa Flight 414 crashed into a hill near Toncontin International Airport in Tegucigalpa, Honduras, because of a bad landing procedure by the pilot, killing 131 of the 146 passengers and crew.

- 14 February 1990 – Indian Airlines Flight 605 crashed into a golf course short of the runway near Hindustan Airport, India. The flight crew failed to pull up after radio callouts of how close they were into the ground. The plane struck a golf course and an embankment, bursting into flames. Of the 146 occupants on the plane, 92 died, including both flight crew. 54 occupants survived the crash.

- 24 November 1992 – China Southern Airlines Flight 3943 departed Guangzhou on a 55-minute flight to Guilin. During the descent towards Guilin, at an altitude of 7,000 feet (2,100 m), the captain attempted to level off the plane by raising the nose and the plane’s auto-throttle was engaged for descent. However, the crew failed to notice that the number 2 power lever was at idle, which led to an asymmetrical power condition. The plane crashed on descent to Guilin Airport, killing all 141 on board.

- 23 March 1994 – Aeroflot Flight 593, an Airbus A310-300, crashed on its way to Hong Kong. The captain, Yaroslav Kudrinsky, invited his two children into the cockpit, and permitted them to sit at the controls, against airline regulations. His sixteen-year-old son, Eldar Kudrinsky, accidentally disconnected the autopilot, causing the plane to bank to the right before diving. The co-pilot brought up the plane too far, causing it to stall and start a flat spin. The pilots eventually recovered the plane, but it crashed into a forest, killing all 75 people on board.

- 24 June 1994 – B-52 crashes in Fairchild Air Force Base. The crash was largely attributed to the personality and behavior of Lt Col Arthur «Bud» Holland, the pilot in command, and delayed reactions to the earlier incidents involving this pilot. After past histories, Lt Col Mark McGeehan, a USAF squadron commander, refused to allow any of his squadron members to fly with Holland unless he (McGeehan) was also on the aircraft. This crash is now used in military and civilian aviation environments as a case study in teaching crew resource management.

- 30 June 1994 – Airbus Industrie Flight 129, a certification test flight of the Airbus A330-300, crashed at Toulouse-Blagnac Airport. While simulating an engine-out emergency just after takeoff with an extreme center of gravity location, the pilots chose improper manual settings which rendered the autopilot incapable of keeping the plane in the air, and by the time the captain regained manual control, it was too late. The aircraft was destroyed, killing the flight crew, a test engineer, and four passengers. The investigative board concluded that the captain was overworked from earlier flight testing that day, and was unable to devote sufficient time to the preflight briefing. As a result, Airbus had to revise the engine-out emergency procedures.

- 2 July 1994 – USAir Flight 1016 crashed into a residential house due to spatial disorientation. 37 passengers were killed and the airplane was destroyed.

- 20 December 1995 – American Airlines Flight 965, a Boeing 757-200 with 155 passengers and eight crew members, departed Miami approximately two hours behind schedule at 1835 Eastern Standard Time (EST). The investigators believe that the pilot’s unfamiliarity with the modern technology installed in the Boeing 757-200 may have played a role. The pilots did not know their location in relation to a radio beacon in Tulua. The aircraft was equipped to provide that information electronically, but according to sources familiar with the investigation, the pilot apparently did not know how to access the information. The captain input the wrong coordinates, and the aircraft crashed into the mountains, killing 159 of the 163 people on board.

- 8 May 1997 – China Southern Airlines Flight 3456 crashed into the runway at Shenzhen Huangtian Airport during the crew’s second go-around attempt, killing 35 of the 74 people on board. The crew had unknowingly violated landing procedures, due to heavy weather.

- 6 August 1997 – Korean Air Flight 801, a Boeing 747-300, crashed into Nimitz Hill, three miles from Guam International Airport, killing 228 of the 254 people on board. The captain’s failure to properly conduct a non-precision approach contributed to the accident. The NTSB said pilot fatigue was a possible factor.

- 26 September 1997 — Garuda Indonesia Flight 152, an Airbus A300, crashed into a ravine, killing all 234 people on board. The NTSC concluded that the crash was caused when the pilots turned the aircraft in the wrong direction, along with ATC error. Low visibility and failure of the GPWS to activate were cited as contributing factors to the accident.

- 12 October 1997 – Singer John Denver died when his newly-acquired Rutan Long-EZ home-built aircraft crashed into the Pacific Ocean off Pacific Grove, California. The NTSB indicated that Denver lost control of the aircraft while attempting to manipulate the fuel selector handle, which had been placed in an inaccessible position by the aircraft’s builder. The NTSB cited Denver’s unfamiliarity with the aircraft’s design as a cause of the crash.

- 16 February 1998 – China Airlines Flight 676 was attempting to land at Chiang Kai-Shek International Airport but had initiate a go-around due to the bad weather conditions. However, the pilots accidentally disengaged the autopilot and did not notice for 11 seconds. When they did notice, the Airbus A300 had entered a stall. The aircraft crashed into a highway and residential area, and exploded, killing all 196 people on board, as well as seven people on the ground.

- 16 July 1999 – John F. Kennedy, Jr. died when his plane, a Piper Saratoga, crashed into the Atlantic Ocean off the coast of Martha’s Vineyard, Massachusetts. The NTSB officially declared that the crash was caused by «the pilot’s failure to maintain control of his airplane during a descent over water at night, which was a result of spatial disorientation». Kennedy did not hold a certification for IFR flight, but did continue to fly after weather conditions obscured visual landmarks.

- 31 August 1999 – Lineas Aéreas Privadas Argentinas (LAPA) flight 3142 crashed after an attempted take-off with the flaps retracted, killing 63 of the 100 occupants on the plane as well as two people on the ground.