-

Contents

-

Table of Contents

-

Troubleshooting

-

Bookmarks

Quick Links

Troubleshooting Guide for Cisco UCS E-Series

Servers and the Cisco UCS E-Series Network

Compute Engine

First Published: 2017-01-05

Overview

This document provides troubleshooting information for Cisco UCS E-Series Servers (E-Series Servers) and

the Cisco UCS E-Series Network Compute Engine (NCE).

Documentation is sometimes updated after original publication; therefore, review the documentation on

Cisco.com for any updates.

Link to Product Documentation

For links to the all Cisco UCS E-Series Servers and the Cisco UCS E-Series Network Compute Engine

documents, see:

Types of E-Series Servers and NCEs

Documentation Guide for Cisco UCS E-Series Servers

Troubleshooting Guide for Cisco UCS E-Series Servers and the Cisco UCS E-Series Network Compute Engine

1

Summary of Contents for Cisco UCS E series

-

Contents

-

Table of Contents

-

Troubleshooting

-

Bookmarks

Quick Links

Troubleshooting Guide for Cisco UCS E-Series

Servers and the Cisco UCS E-Series Network

Compute Engine

First Published: 2017-01-05

Overview

This document provides troubleshooting information for Cisco UCS E-Series Servers (E-Series Servers) and

the Cisco UCS E-Series Network Compute Engine (NCE).

Documentation is sometimes updated after original publication; therefore, review the documentation on

Cisco.com for any updates.

Link to Product Documentation

For links to the all Cisco UCS E-Series Servers and the Cisco UCS E-Series Network Compute Engine

documents, see:

Types of E-Series Servers and NCEs

Documentation Guide for Cisco UCS E-Series Servers

Troubleshooting Guide for Cisco UCS E-Series Servers and the Cisco UCS E-Series Network Compute Engine

1

Summary of Contents for Cisco UCS E series

Автор

Сообщение

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Вопрос по Cisco UCS-E140M1

Вопрос по Cisco UCS-E140M1

Добрый день.

Установил такой модуль в 2911, появилось 2 новых интерфейса

interface ucse1/0

no ip address

imc ip address 192.168.168.9 255.255.255.0 default-gateway 192.168.168.1

imc access-port dedicated

!

interface ucse1/1

description $Internal switch interface connected to Service Module$

switchport trunk allowed vlan 1-169,1002-1005

switchport mode trunk

no ip address

Читал мануал по настройке — все в основном говорится про интерфейс interface ucse1/0 и как через него сделать доступ к CIMC. Про interface ucse1/1 сказано лишь, что его надо перевести в switchport mode trunk и разрешить все vlan. То есть данные между роутером и этим модулем буду ходить только через interface ucse1/1??? И еще вопрос — при конфигурировании interface ucse1/0 в строке imc access-port можно выбрать dedicated и shared-lom. Shared-lom содержит пункты

Cisco_2911(config-if)#imc access-port shared-lom ?

GE1 GE1

GE2 GE2

console Console

failover Failover

GE2 — это порт на задней стороне модуля? все чудесно назначается, идут пинги и видится Менеджмент Консоль, а что за порт GE1? В мануале написано как сконфигурировать что бы к CIMC можно было заходить изнутри роутера и указан порт GE1. Делаю как написано — нет пингов и на CIMC зайти соответственно не могу. Получается только GE2 и dedicated, то есть через внешние интерфейсы, IP на GE1, GE2 и dedicated назначаю из VLAN который живой и на котором висит NAS, который видится из других VLAN.

Куда смотреть?

11 июн 2014, 07:11

![]()

![]()

R_KING

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

Еще вопрос — firmware и BIOS обновлять последовательно с повышением версии или можно на initial сразу накатить последнее обновление?

11 июн 2014, 10:48

![]()

![]()

R_KING

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

И может кто помочь с файлами

http://software.cisco.com/download/rele … ype=latest

ucse-huu-2.1.1.iso

http://software.cisco.com/download/rele … ype=latest

update_pkg-ucse.combined.REL.2.2.2.bin

Вчера правда еще был ISO от 15 мая 2014, но потом вдруг пропал. Может кто качал, весит около 290МБ.

Может кто дать рекомендации — стоит обновлять BIOS и CiMC? Просто стоит все initial.

11 июн 2014, 11:07

![]()

![]()

R_KING

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

Неужели никто с таким модулем не сталкивался?

15 июн 2014, 23:06

![]()

![]()

real1st

Зарегистрирован: 04 окт 2011, 19:33

Сообщения: 1316

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

R_KING

Привет!

Вообще, UCS-E вещь довольно редкая и врятли найдется много народу, кто работал с ними.

Вот здесь

http://www.cisco.com/c/en/us/td/docs/un … r_010.html

довольно подробно описано. В том числе, что за интерфейсы такие GE2, GE3 …

По поводу обновлений: просмотрите соответствующие гайды, или вернее даже compatibility. Но не вижу ничего, что могло бы помешать накатить нужную версию сразу.

18 июн 2014, 16:03

![]()

![]()

R_KING

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

f@ntasist0 писал(а):

R_KING

Привет!

Вообще, UCS-E вещь довольно редкая и врятли найдется много народу, кто работал с ними.

Вот здесь

http://www.cisco.com/c/en/us/td/docs/un … r_010.html

довольно подробно описано. В том числе, что за интерфейсы такие GE2, GE3 …

По поводу обновлений: просмотрите соответствующие гайды, или вернее даже compatibility. Но не вижу ничего, что могло бы помешать накатить нужную версию сразу.

Спасибо за ответ.

Модуль обновил — спасибо форумчанину, что скачал ISO, и с интерфейсами вроде тоже разобрался, после того как поставил server 2008 R2, что касаемо ссылки на cisco.com — я выкачал тонны описаний для UCS, но там очень подробно расписано для Cisco ISR 4451-X, про UCS как то вскользь.

Теперь вот мозг сверлит идея завернуть на этот модуль траффик после nat , поинспектировать его на модуле и через другой интерфейс выпустить обратно в роутер.

19 июн 2014, 10:01

![]()

![]()

real1st

Зарегистрирован: 04 окт 2011, 19:33

Сообщения: 1316

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

R_KING

Цитата:

Теперь вот мозг сверлит идея завернуть на этот модуль траффик после nat , поинспектировать его на модуле и через другой интерфейс выпустить обратно в роутер.

А это точно реально? Ибо inside source NAT у циски делается совсем в конце.

А для работы с CiMC качни гайды для С-серии серверов, думаю должно быть аналогично.

19 июн 2014, 10:30

![]()

![]()

R_KING

Зарегистрирован: 05 фев 2013, 17:02

Сообщения: 672

![]()

![]() Re: Вопрос по Cisco UCS-E140M1

Re: Вопрос по Cisco UCS-E140M1

f@ntasist0 писал(а):

R_KING

Цитата:

Теперь вот мозг сверлит идея завернуть на этот модуль траффик после nat , поинспектировать его на модуле и через другой интерфейс выпустить обратно в роутер.

А это точно реально? Ибо inside source NAT у циски делается совсем в конце.

А для работы с CiMC качни гайды для С-серии серверов, думаю должно быть аналогично.

Не знаю. Я совсем недавно цисками занимаюсь. Просто есть модуль очень похожий на UCS, но называется SM-SRE-910, под него выпускается антивирь Касперского, смотрел аналоги этого антивиря (серверные варианты с инспекцией), там всегда настраивается по принципу — один порт для провайдера, на модуле поднимается Антивирь и NAT, со второго порта в роутер. Хотелось бы NAT на роутере оставить.

C CIMC разобрался вроде, очень многое от обновления FW зависит. Сейчас стоит предпоследняя прошивка. Последнюю от 15 мая 2914 с сайта Cisco.com пропала. Прямо у меня на глазах — обновил страницы и пропала. Прошивка лежала меньше месяца. Может баги??

19 июн 2014, 11:47

![]()

General Troubleshooting Solutions

This chapter includes the following sections:

Guidelines for Troubleshooting

When you troubleshoot issues with Cisco UCS Manager or a component that it manages, you should follow the guidelines listed in the following table.

Table 1. Troubleshooting Guidelines

|

Guideline |

Description |

|---|---|

|

Check the release notes to see if the issue |

The release notes are accessible through the http://www.cisco.com/go/unifiedcomputing/b-series-doc. |

|

Take screenshots of the fault or error message |

These screenshots provide visual cues about the state of Cisco UCS Manager when the problem occurred. If your computer does not have software to take screenshots, check the documentation for your |

|

Record the steps that you took directly before |

If you have access to screen or keystroke recording software, repeat the steps you took and record what occurs in Cisco UCS Manager. If you do not have access to that type of software, repeat the steps you took and make detailed notes of the steps and what |

|

Create a technical support file. |

The information about the current state of the Cisco UCS domain is very helpful to Cisco support and frequently provides the information needed to identify the source of the problem. |

Faults

In Cisco UCS, a fault is a mutable object that is managed by Cisco UCS Manager. Each fault represents a failure in the Cisco UCS domain or an alarm threshold that has been raised. During the lifecycle of a fault, it can change from one state or severity to

another.

Each fault includes information about the operational state of the affected object at the time the fault was raised. If the

fault is transitional and the failure is resolved, the object transitions to a functional state.

A fault remains in Cisco UCS Manager until the fault is cleared and deleted according to the settings in the fault collection policy.

You can view all faults in a Cisco UCS domain from either the Cisco UCS Manager CLI or the Cisco UCS Manager GUI. You can also configure the fault collection policy to determine how a Cisco UCS domain collects and retains faults.

Note |

All Cisco UCS faults |

Fault Severities

A fault raised in a Cisco UCS domain can transition

through more than one severity during its lifecycle. The following table describes the fault

severities that you may encounter.

|

Severity |

Description |

|---|---|

|

Critical |

Service-affecting condition that requires immediate corrective action. For example, this severity could indicate that the |

|

Major |

Service-affecting condition that requires urgent corrective action. For example, this severity could indicate a severe degradation |

|

Minor |

Nonservice-affecting fault condition that requires corrective action to prevent a more serious fault from occurring. For example, |

|

Warning |

Potential or impending service-affecting fault that has no significant effects in the system. You should take action to further |

|

Condition |

Informational message about a condition, possibly independently insignificant. |

|

Info |

Basic notification or informational message, possibly independently insignificant. |

Fault States

A fault raised in a Cisco UCS domain transitions

through more than one state during its lifecycle. The following table describes the possible

fault states in alphabetical order.

|

State |

Description |

|---|---|

|

Cleared |

Condition that has been resolved and cleared. |

|

Flapping |

Fault that was raised, cleared, and raised again within a short time interval, known as the flap interval. |

|

Soaking |

Fault that was raised and cleared within a short time interval, known as the flap interval. Because this state may be a flapping |

Fault Types

A fault raised in a Cisco UCS domain can be

one of the types described in the following table.

|

Type |

Description |

|---|---|

|

fsm |

FSM task has failed to complete successfully, or Cisco UCS Manager is retrying one of the stages of the FSM. |

|

equipment |

Cisco UCS Manager has detected that a physical component is inoperable or has another functional issue. |

|

server |

Cisco UCS Manager cannot complete a server task, such as associating a service profile with a server. |

|

configuration |

Cisco UCS Manager cannot successfully configure a component. |

|

environment |

Cisco UCS Manager has detected a power problem, thermal problem, voltage problem, or loss of CMOS settings. |

|

management |

Cisco UCS Manager has detected a serious management issue, such as one of the following:

|

|

connectivity |

Cisco UCS Manager has detected a connectivity problem, such as an unreachable adapter. |

|

network |

Cisco UCS Manager has detected a network issue, such as a link down. |

|

operational |

Cisco UCS Manager has detected an operational problem, such as a log capacity issue or a failed server discovery. |

|

generic |

Cisco UCS Manager has detected a generic issue, such as Board Controller upgrade requires a manual power cycle of the server. |

|

sysdebug |

Cisco UCS Manager has detected a system debug issue, such as auto core transfer failure at remote server since the remote server is not accessible |

|

security |

Cisco UCS Manager has detected a security issue, such as invalid certificate. |

|

chassis profile |

This fault is raised when Cisco UCS Manager cannot complete a chassis task, such as associating a chassis profile with a chassis. |

Fault

Properties

Cisco UCS Manager provides detailed information about each fault raised in a

Cisco UCS domain. The following table describes the fault properties that you can

view in

Cisco UCS Manager CLI or

Cisco UCS Manager GUI.

|

Property |

Description |

|---|---|

|

Severity |

Current |

|

Last |

Day and |

|

Affected |

Component |

|

Description |

Description of the fault. |

|

ID |

The unique identifier associated with the message. |

|

Type |

Type of |

|

Cause |

Unique |

|

Created at |

Day and |

|

Code |

The unique identifier assigned to the fault. |

|

Number of |

Number of |

|

Original |

Severity |

|

Previous |

Previous |

|

Highest |

Highest |

Lifecycle of Faults

Faults in Cisco UCS are stateful. Only one instance of a given fault can exist on each object. If the same fault occurs a second time, Cisco UCS increases the number of occurrences by one.

A fault has the following lifecycle:

-

A condition occurs in the system and

Cisco UCS Manager

raises a fault. This is the active state. -

When the fault is alleviated, it enters a flapping or soaking interval that is designed to prevent flapping. Flapping occurs

when a fault is raised and cleared several times in rapid succession. During the flapping interval, the fault retains its

severity for the length of time specified in the fault collection policy. -

If the condition reoccurs during the flapping interval, the fault returns to the active state. If the condition does not reoccur

during the flapping interval, the fault is cleared. -

The cleared fault enters the retention interval. This interval ensures that the fault reaches the attention of an administrator

even if the condition that caused the fault has been alleviated and the fault has not been deleted prematurely. The retention

interval retains the cleared fault for the length of time specified in the fault collection policy. -

If the condition reoccurs during the retention interval, the fault returns to the active state. If the condition does not

reoccur, the fault is deleted.

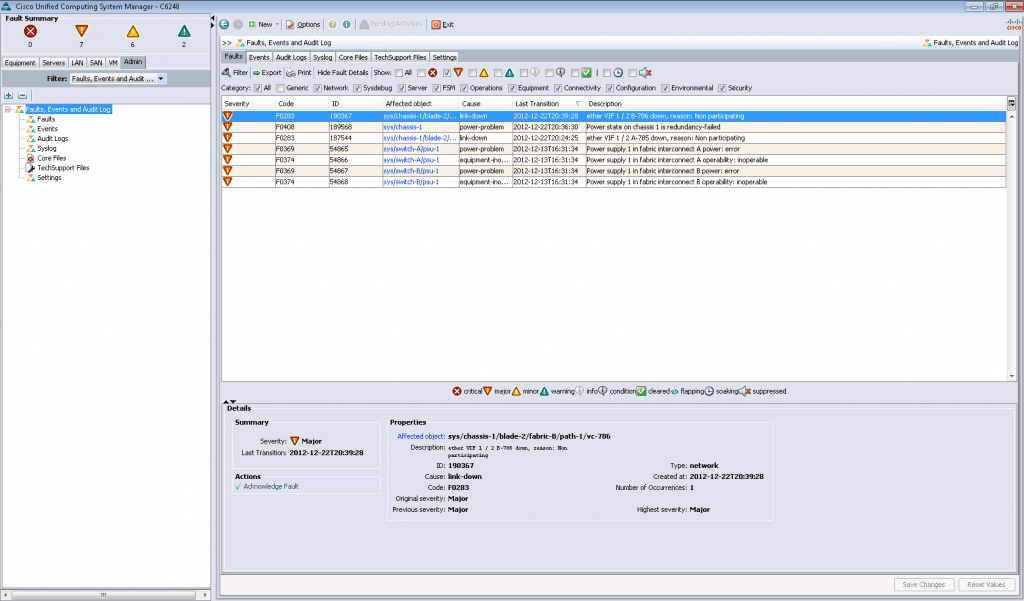

Faults in Cisco UCS Manager GUI

If you want to view faults for a single object in the system, navigate to that object in the Cisco UCS Manager GUI and click the Faults tab in the Work pane. If you want to view faults for all objects in the system, navigate to the Faults node on the Admin tab under Faults, Events and Audit Log.

In addition, you can also view a summary of all faults in a Cisco UCS domain in the Fault Summary area in the upper left of the Cisco UCS Manager GUI. This area provides a summary of all faults that have occurred in the Cisco UCS domain.

Each fault severity is represented by a different icon. The number below each icon indicates how many faults of that severity

have occurred in the system. If you click an icon, the Cisco UCS Manager GUI opens the Faults tab in the Work pane and displays the details of all faults with that severity.

Faults in Cisco UCS

Manager CLI

If you want to view

the faults for all objects in the system, enter the

show fault

command from the top-level scope. If you want to view the faults for a specific

object, scope to that object and then execute the

show fault

command.

If you want to view

all available details about a fault, enter the

show fault

detail command.

Fault Collection Policy

The fault collection policy controls the lifecycle of a fault in the Cisco UCS domain, including the length of time that each fault remains in the flapping and retention intervals.

Events

In Cisco UCS, an event is an immutable object that is managed by Cisco UCS Manager. Each event represents a nonpersistent condition in the Cisco UCS domain. After Cisco UCS Manager creates and logs an event, the event does not change. For example, if you power on a server, Cisco UCS Manager creates and logs an event for the beginning and the end of that request.

You can view events for a single object, or you can view all events in a Cisco UCS domain from either the Cisco UCS Manager CLI or the Cisco UCS Manager GUI. Events remain in the Cisco UCS until the event log fills up. When the log is full, Cisco UCS Manager purges the log and all events in it.

Properties of Events

Cisco UCS Manager provides detailed information about each event created and logged in a Cisco UCS domain. The following table describes the fault properties that you can view in Cisco UCS Manager CLI or Cisco UCS Manager GUI.

Table 2. Event Properties

|

Property Name |

Description |

|---|---|

|

Affected Object |

Component that created the event. |

|

Description |

Description of the event. |

|

Cause |

Unique identifier associated with the event. |

|

Created at |

Date and time when the event was created. |

|

User |

Type of user that created the event, such as one of the following:

|

|

Code |

Unique identifier assigned to the event. |

Events in the Cisco UCS Manager GUI

If you want to view events for a single object in the system, navigate to that object in the Cisco UCS Manager GUI and click

the Events tab in the Work pane. If you want to view events for all objects in the system, navigate to the Events node on

the Admin tab under the Faults, Events and Audit Log.

Events in the Cisco UCS Manager CLI

If you want to view events for all objects in the system, enter the show event command from the top-level scope. If you want to view events for a specific object, scope to that object and then enter the

show event command.

If you want to view all available details about an event, enter the show event detail command.

Audit Log

The audit log records actions performed by users in Cisco UCS Manager, including direct and indirect actions. Each entry in

the audit log represents a single, non-persistent action. For example, if a user logs in, logs out, or creates, modifies,

or deletes an object such as a service profile, Cisco UCS Manager adds an entry to the audit log for that action.

You can view the audit log entries in the Cisco UCS Manager CLI, Cisco UCS Manager GUI, or in a technical support file that

you output from Cisco UCS Manager.

Audit Log Entry

Properties

Cisco UCS Manager

provides detailed information about each entry in the audit log. The following

table describes the fault properties that you can view in the

Cisco UCS Manager GUI

or the

Cisco UCS Manager CLI.

Table 3. Audit Log Entry

Properties

|

Property |

Description |

|---|---|

|

ID |

Unique |

|

Affected |

Component |

|

Severity |

Current |

|

Trigger |

User role |

|

User |

Type of user

|

|

Indication |

Action

|

|

Description |

Description |

Audit Log in the Cisco UCS Manager GUI

In the Cisco UCS Manager GUI, you can view the audit log on the Audit Log node on the Admin tab under the Faults, Events and Audit Log node.

Audit Log in the

Cisco UCS Manager CLI

In the Cisco UCS

Manager CLI, you can view the audit log through the following commands:

-

scope security

-

show audit-logs

System Event

Log

The system event log (SEL) resides on the CIMC in NVRAM. It records most

server-related events, such as over and under voltage, temperature events, fan

events, and events from BIOS. The SEL is mainly used for troubleshooting

purposes.

The SEL file is approximately 40KB in size, and no further events can

be recorded when it is full. It must be cleared before additional events can be

recorded.

You can use the SEL policy to backup the SEL to a remote server, and

optionally clear the SEL after a backup operation occurs. Backup operations can

be triggered based on specific actions, or they can occur at regular intervals.

You can also manually backup or clear the SEL.

The backup file is automatically generated. The filename format is

sel-SystemName-ChassisID-ServerID-ServerSerialNumber-Timestamp;

for example, sel-UCS-A-ch01-serv01-QCI12522939-20091121160736.

SEL File

The SEL file is approximately 40 KB. No further events can be recorded when the SEL file is full. It must be cleared before

additional events can be recorded.

SEL Policy

You can use the SEL policy to back up the SEL to a remote server and optionally clear the SEL after a backup operation occurs.

Backup operations can be triggered, based on specific actions, or they can occur at regular intervals. You can also manually

back up or clear the SEL.

Cisco UCS Manager automatically generates the SEL backup file, according to the settings in the SEL policy. The filename format

is sel-SystemName—ChassisID—ServerID—ServerSerialNumber—Timestamp

For example, a filename could be sel-UCS-A-ch01-serv01-QCI12522939-20091121160736.

Syslog

The syslog provides a central point for collecting and processing system logs that you can use to troubleshoot and audit a

Cisco UCS domain. Cisco UCS Manager relies on the Cisco NX-OS syslog mechanism and API, and on the syslog feature of the primary fabric interconnect to collect

and process the syslog entries.

Cisco UCS Manager collects and logs syslog messages internally. You can send them to external syslog servers running a syslog

daemon. Logging to a central syslog server helps in aggregation of logs and alerts. Some syslog messages to monitor include,

DIMM problems, equipment failures, thermal problems, voltage problems, power problems, high availability (HA) cluster problems,

and link failures.

Note |

The FSM faults, threshold faults, and unresolved policy events are not sent to syslog server. However, SNMP traps are generated |

Cisco UCS Manager manages and configures the syslog collectors for a Cisco UCS domain and deploys the configuration to the fabric interconnect or fabric interconnects. This configuration affects all syslog entries

generated in a Cisco UCS domain by Cisco NX-OS or by Cisco UCS Manager.

You can configure Cisco UCS Manager to do one or more of the following with the syslog and syslog entries:

-

Display the syslog entries in the console or on the monitor

-

Store the syslog entries in a file

-

Forward the syslog entries to up to three external log collectors where the syslog for the Cisco UCS domain is stored

Syslog messages contain an event code and fault code. To monitor syslog messages, you can define syslog message filters. These

filters can parse the syslog messages based on the criteria you choose. You can use the following criteria to define a filter:

-

By event or fault codes: Define a filter with a parsing rule to include only the specific codes that you intend to monitor.

Messages that do not match these criteria are discarded. -

By severity level: Define a filter with a parsing rule to monitor syslog messages with specific severity levels. You can set

syslog severity levels individually for OS functions, to facilitate logging and display of messages ranging from brief summaries

to detailed information for debugging.

Syslog Entry Format

Each syslog entry generated by a Cisco UCS component is formatted

as follows:

Year month date hh:mm:ss hostname %facility-severity-MNEMONIC description

For example: 2007 Nov 1 14:07:58 excal-113 %MODULE-5-MOD_OK: Module

1 is online

Syslog Entry Severities

A syslog entry is assigned a Cisco UCS severity by Cisco UCS Manager. The following table shows how the Cisco UCS severities

map to the syslog severities.

Table 4. Syslog Entry Severities in Cisco UCS

|

Cisco UCS Severity |

Syslog Severity |

|---|---|

|

CRIT |

CRIT |

|

MAJOR |

ERR |

|

MINOR |

WARNING |

|

WARNING |

NOTICE |

|

INFO |

INFO |

Syslog Entry Parameters

The following table describes the information

contained in each syslog entry.

Table 5. Syslog Message Content

|

Name |

Description |

|---|---|

|

Facility |

Logging facility that generated and sent the syslog entry. The facilities are broad categories that are represented by integers.

|

|

Severity |

Severity of the event, alert, or issue that caused the syslog entry to be generated. The severity can be one of the following:

|

|

Hostname |

Hostname included in the syslog entry that depends upon the component where the entry originated, as follows:

|

|

Timestamp |

Date and time when the syslog entry was generated. |

|

Message |

Description of the event, alert, or issue that caused the syslog entry to be generated. |

Syslog Services

The following Cisco UCS components use the Cisco NX-OS syslog services to generate syslog entries for system information and

alerts:

-

I/O module—All syslog entries are sent by syslogd to the fabric interconnect to which it is connected.

-

CIMC—All syslog entries are sent to the primary fabric interconnect in a cluster configuration.

-

Adapter—All syslog entries are sent by NIC-Tools/Syslog to both fabric interconnects.

-

Cisco UCS Manager—Self-generated syslog entries are logged according to the syslog configuration.

Technical Support

Files

When you encounter an

issue that requires troubleshooting or a request for assistance to the Cisco

Technical Assistance Center (Cisco Technical Assistance Center), collect as much information as possible about the affected

Cisco UCS domain.

Cisco UCS Manager outputs this information into a tech support file that you can

send to Cisco.

You can create a tech

support file for the following components of a

Cisco UCS domain:

-

UCSM—Contains

technical support data for the entire

Cisco UCS domain. -

UCSM management services—Contains technical support data for the

Cisco UCS Manager

management services, excluding Fabric Interconnects. -

Chassis—Contains

technical support data for the I/O module or the CIMCs on the blade servers in

a given chassis only. -

Fabric

extender—Contains technical support data for the given FEX. -

Rack

server—Contains technical support data for the given rack-mount server and

adapter. -

Server memory—Contains server memory technical support data for the

given rack-mount servers and blade servers.

Creating a Tech

Support File in the Cisco UCS Manager GUI

Note |

In releases |

Procedure

| Step 1 |

In the |

||||||||||||||

| Step 2 |

Expand |

||||||||||||||

| Step 3 |

In the |

||||||||||||||

| Step 4 |

In the This path must

|

||||||||||||||

| Step 5 |

In the

|

||||||||||||||

| Step 6 |

Click |

Creating a Technical

Support File in the Cisco UCS Manager CLI

Use the

show

tech-support command to output information about a

Cisco UCS domain that you can send to

Cisco Technical Assistance Center.

Procedure

| Command or Action | Purpose | |||

|---|---|---|---|---|

| Step 1 |

UCS-A# |

Enters local |

||

| Step 2 |

UCS-A(local-mgmt) # server-id [adapter ucsm | ucsm-mgmt } [brief | |

Outputs

|

||

| Step 3 |

UCS-A |

Copies the The SCP and FTP |

Powering Down a

Cisco UCS Domain

You can decommission

an entire

Cisco UCS domain, for example as part of a planned power outage.

Procedure

| Step 1 |

Create a For more http://www.cisco.com/go/unifiedcomputing/b-series-doc. |

| Step 2 |

Gracefully power You can power |

| Step 3 |

Unplug the When the servers |

| Step 4 |

Power down each

|

Verification of LDAP Configurations

Note |

This procedure can be performed only through the Cisco UCS Manager CLI. |

The Cisco UCS Manager CLI test commands verify the configuration of the Lightweight Directory Access Protocol (LDAP) provider or the LDAP provider group.

Verifying the LDAP Provider Configuration

Note |

The test aaa server ldap command verifies the server-specific configuration, irrespective of the LDAP global configurations. This command uses the |

You can enter the test aaa server ldap command to verify the following information if Cisco UCS Manager is able to communicate with the LDAP provider as follows:

-

The server responds to the authentication request if the correct username and password is provided.

-

The roles and locales defined on the user object in the LDAP are downloaded.

-

If the LDAP group authorization is turned on, the LDAP groups are downloaded.

Procedure

| Command or Action | Purpose | |

|---|---|---|

| Step 1 |

connect nxos |

Enters nxos mode. |

| Step 2 |

test aaa server ldap |

Tests the LDAP provider configuration. |

Example

The following is an example of the response:

UCS-A# /security # connect nxos

UCS-A#(nxos)# test aaa server ldap 10.193.23.84 kjohn Nbv12345

user has been authenticated

Attributes downloaded from remote server:

User Groups:

CN=g3,CN=Users,DC=ucsm CN=g2,CN=Users,DC=ucsm CN=group-2,CN=groups,DC=ucsm

CN=group-1,CN=groups,DC=ucsm CN=Domain Admins,CN=Users,DC=ucsm

CN=Enterprise Admins,CN=Users,DC=ucsm CN=g1,CN=Users,DC=ucsm

CN=Administrators,CN=Builtin,DC=ucsm

User profile attribute:

shell:roles="server-security,power"

shell:locales="L1,abc"

Roles:

server-security power

Locales:

L1 abc

Verifying the LDAP Provider Group Configuration

Note |

The test aaa group command verifies the group-specific configuration, irrespective of the LDAP global configurations. |

You can enter the test aaa group command to verify the following information if Cisco UCS Manager is able to communicate with the LDAP group as follows:

-

The server responds to the authentication request if the correct username and password is provided.

-

The roles and locales defined on the user object in the LDAP are downloaded.

-

If the LDAP group authorization is turned on, the LDAP groups are downloaded.

Procedure

| Command or Action | Purpose | |

|---|---|---|

| Step 1 |

connect nxos |

Enters nxos mode. |

| Step 2 |

test aaa group |

Tests the LDAP group configuration. |

Example

The following is an example of the response:

UCS-A# /security # connect nxos

UCS-A#(nxos)# test aaa group grp-ad1 kjohn Nbv12345

user has been authenticated

Attributes downloaded from remote server:

User Groups:

CN=g3,CN=Users,DC=ucsm CN=g2,CN=Users,DC=ucsm CN=group-2,CN=groups,DC=ucsm

CN=group-1,CN=groups,DC=ucsm CN=Domain Admins,CN=Users,DC=ucsm

CN=Enterprise Admins,CN=Users,DC=ucsm CN=g1,CN=Users,DC=ucsm

CN=Administrators,CN=Builtin,DC=ucsm

User profile attribute:

shell:roles="server-security,power"

shell:locales="L1,abc"

Roles:

server-security power

Locales:

L1 abc

-

-

October 21 2011, 15:59

- IT

- Компьютеры

- Cancel

Ошибки могут накапливаться по следующим причинам:

- Проблема со средой передачи (физика) — это может быть битая пара (если по меди), сгиб оптического патча, неисправный RJ45 и т.п.

- Наводки — проявляются только с медью. Если кабель идет рядом с железными прутьями, с эл кабелем и т.п. Если UTP брошена мотком — то могут проявиться перекрестные наводки.

- Неправильные настройки на интерфейсах.

Рассмотрим последний пункт подробнее:

CISCO не дружит с другими производителями сетевого оборудования.

Открою секрет — разные модели cisco могут также не дружить между собой.

Если команда sh int fa0/1 выдала следующее

11802 input errors, 11801 CRC, 0 frame, 0 overrun, 0 ignored

Попробуйте поиграться с настройками скорости и дуплекса на интерфейсе:

conf t

int fa 0/1

duplex auto

speed auto

или

duplex full

speed 100

Также посмотрите на тип инкапсуляции, если у вас оба порта находятся в trunk.

При различных типах ничего не заработает.

Устанавливаем на обоих портах:

switchport trunk enc dot1q

Примечание: коммутаторы 29xx серии

dot1q

В продолжение поста о распаковке Cisco UCS, приехавшей в наш Центр компетенции, мы расскажем о Cisco UCS Manager, с помощью которого производится настройка всей системы. Данную задачу мы выполнили в рамках подготовки к тестированию FlexPod (Cisco UCS + NetApp в режиме MetroCluster) для одного из наших заказчиков.

Отметим основные преимущества Cisco UCS, благодаря которым выбор пал именно на данную систему:

- Cisco UCS является унифицированной системой, а не разрозненной группой серверов с попыткой единого

управления; - наличие унифицированной фабрики, которая содержит встраиваемое управление, использование универсального

транспорта, отсутствие уровня коммутации в шасси и на уровне гипервизора– Virtual Interface Card, простое

каблирование; - единая конвергентная фабрика на всю систему (единовременное управление до 320 серверами) в отличие от

конкурентов – своя фабрика на каждое шасси (до 16 серверов); - одна точка управления, быстрота конфигурирования при использовании политик и профилей, что дает минимизацию

рисков при настройке, развертывании, тиражировании, обеспечивает высокую масштабируемость.

Традиционные блейд системы имеют следующие недостатки:

- каждый блейд-сервер – идеологически, с точки зрения управления такой же стоечный или башенный сервер, только

в другом форм-факторе; - каждый сервер – сложная система с большим числом компонентов и большим числом мощных средств управления;

- каждое шасси, каждый сервер, и в большинстве случаев каждый коммутатор должны настраиваться отдельно и чаще

всего «вручную»; - «зонтичные» «единые» системы управления существуют, но это в большинстве случаев просто набор ссылок на

отдельные утилиты; - интеграция «наверх» у этих систем возможна, но ограничивается «стандартными» простыми интерфейсами.

В отличие от конкурентов Cisco UCS имеет продуманную систему управления – UCS Manager. Данный продукт имеет следующие отличительные особенности:

- не требует отдельного сервера, СУБД, ОС и лицензий на них — он часть UCS;

- не требует инсталляции и настройки – просто включите систему и задайте IP-адрес;

- обладает встроенной отказоустойчивостью;

- имеет эффективные и простые средства резервного копирования конфигурации;

- обновляется несколькими «кликами»;

- делегирует весь свой функционал «наверх» через открытый XML API;

- стоит $0.00.

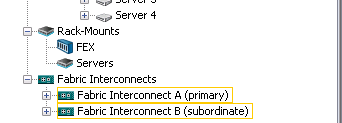

Сам Cisco UCS Manager располагается на обоих Fabric Interconnect, и, соответственно, все настройки, политики и т.п. хранятся также на них.

К одной паре Fabric Interconnect может подключено до 20 блейд-шасси. Управление каждым из шасси осуществляется из одной точки – UCS Manager. Это возможно благодаря тому, что Fabric Interconnect строится как распределенный коммутатор с участием Fabric Extender’ов . Каждое шасси имеет по два Fabric Extender, с возможностью подключения 4 либо 8 10GB линками каждый.

Начинаем с самого основного: подключения консольного провода и задания начального IP-адреса.

После чего запускаем браузер и соединяемся. (Понадобится java, т.к. по сути GUI UCS Manager’а реализовано на ней). На рисунках ниже представлен внешний вид программы, который появляется на экране после ввода логина и пароля и входа в UCS Manager.

Работу по настройке начинаем на вкладке «LAN». Надо отметить, что с настройки данной вкладки, а также вкладки «SAN» начинается настройка всей системы. Особенно актуально это в случае использования бездисковых серверов – как раз наш случай.

Здесь настраивается абсолютно все, что имеет отношение к сети: какие VLAN разрешены на том или ином Fabric Interconnect, какими портами соединены Fabric Interconnect между собой, какие порты в каком режиме работают и многое другое.

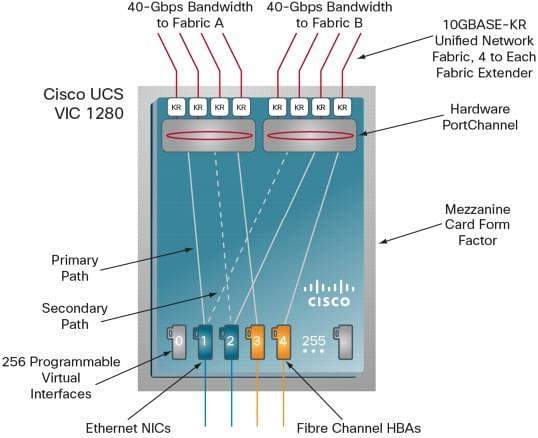

Также на этой вкладке настраиваются шаблоны для виртуальных сетевых интерфейсов: vNIC, которые в дальнейшем будут применяться в сервисных политиках, описанных выше. На каждый vNIC (которых к слову на хосте может быть до 512 при установке 2 плат Cisco UCS VIC) привязывается определенный VLAN, либо группа VLAN и «общение» физического хоста по сети идет именно через эти vNIC.

Организация такого количества vNIC возможна с помощью карты виртуального интерфейса VIC (Virtual Interface Card). В семействе блейд серверов Cisco UCS существует 2 вида VIC: 1240 и 1280.

Каждая из них имеет возможность поддержки до 256 vNIC или vHBA. Главное отличие в том, что 1240 является LOM модулем, а 1280 мезанинная карта, так же в пропускной способности.

1240 самостоятельно имеет возможность агрегации до 40 GB, с возможностью расширения до 80GB при использовании Expander Card.

1280 изначально умеет пропускать через себя до 80GB.

VIC позволяют динамически назначать пропускную способность на каждый vNIC или vHBА, а так же поддерживают hardware failover.

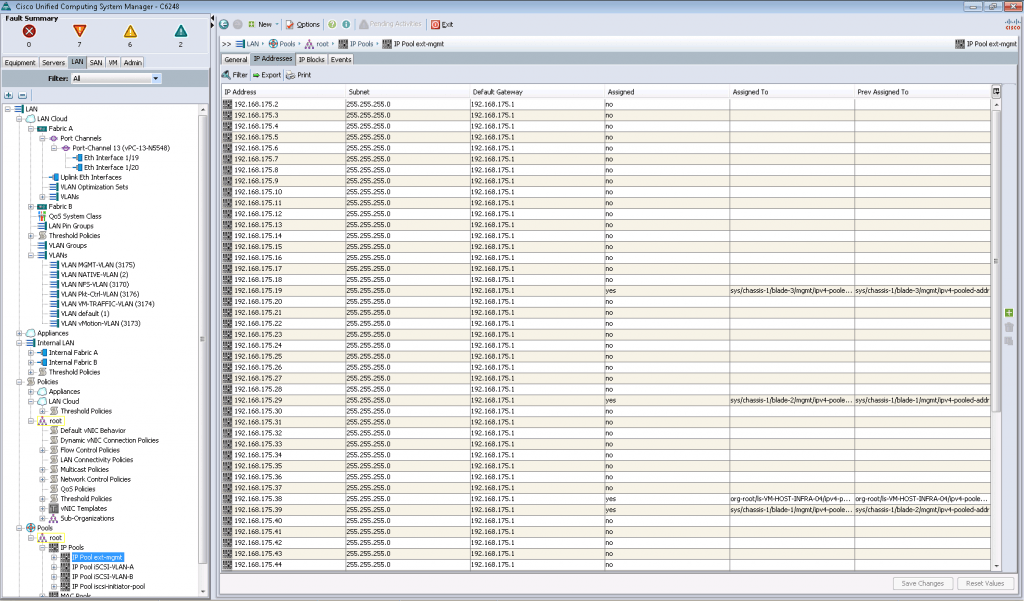

Ниже можно заметить несколько созданных пулов IP адресов, из которых эти самые адреса будут присваиваться сетевым интерфейсам в определенных VLAN (этакий аналог EBIPA у HP). Аналогично дело обстоит и с MAC адресами, которые берутся из MAC пулов.

В общем концепция простая: создаем VLAN(ы), настраиваем порты на Fabric Interconnect, настраиваем vNIC, выдаем этим vNIC MAC/IP адреса из пулов и загоняем в сервисную политику для дальнейшего использования.

Важное замечание: Как вы знаете существуют валидированные дизайны Cisco с крупными игроками рынка систем хранения данных, например, такой как FlexPod. Дизайн FlexPod включает серверное и сетевое оборудование – Cisco, а в роли СХД выступает NetApp. Зачем спросите вы там еще и сетевое оборудование? Дело все в том, что в версии 1.4 и 2.0 UCS Manager сам Fabric Interconnect не осуществлял FC зонирование. Для этого был необходим вышестоящий коммутатор (например, Cisco Nexus), подключенный к Fabric Interconnect через Uplink порты. В версии UCS Manager 2.1. появилась поддержка локальных зон, что дало возможно подключать Storage напрямую к Fabric Interconnect. Возможные дизайны можно посмотреть вот здесь. Но все-таки оставлять FlexPod без коммутатора не стоит, т.к. FlexPod является самостоятельным строительным блоком ЦОДа.

Перейдем к следующей вкладке: «SAN».

Здесь располагается все, что относится к сети передачи данных: iSCSI и FCoE. Концепция такая же, как и у сетевых адаптеров vNIC, но со своими отличиями: WWN, WWPN, IQN и т.п.

Переходим на вкладку «Equipment».

С помощью данного интерфейса можно увидеть информацию о нашей общей вычислительной инфраструктуре, которая была развернута для тестирования. Так, было задействовано одно шасси (Chassis 1) и четыре сервера-лезвия (Server1, Server2, Server3, Server4). Эту информацию можно получить из дерева в левой части (Equipment), либо в графическом виде (Physical Display).

Помимо количества шасси/серверов можно посмотреть информацию о вспомогательных компонентах (вентиляторы, блоки питания и т.п.), а также информацию об алертах разного типа. Общее количество алертов выводится в блоке «Fault Summary», отдельно информацию по каждому узлу можно посмотреть, кликнув по нему слева. Цветные рамки вокруг названий узлов слева помогают узнать, на каком узле есть алерты. Внимательные читатели заметят также небольшие пиктограммы и на графическом виде.

Наши Fabric Interconnect настроены на работу в failover режиме (при выходе из строя одного из агрегатов – его работу незамедлительно возьмет на себя другой). Информация об этом видна в самом низу дерева – обозначения primary и subordinate.

Далее переходим к вкладке «Servers».

Здесь находятся различные политики, шаблоны сервисных профилей и непосредственно сами сервисные профили. Например, мы можем создать несколько организаций, каждой из которых назначить свои политики выбора загрузочного устройства, доступа к определенным VLAN/VSAN и др.

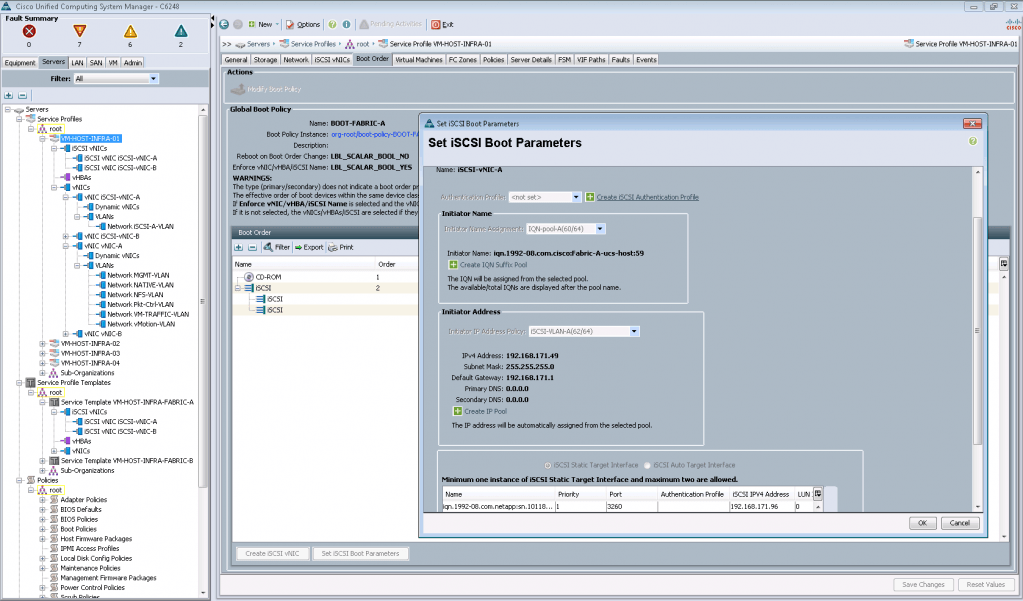

На следующем рисунке показан пример настройки iSCSI загрузочного луна.

Глобальный смысл всего этого: предварительно настроив все политики и шаблоны, можно быстро настраивать новые сервера для работы, применяя тот или иной сервисный профиль (Service Profile).

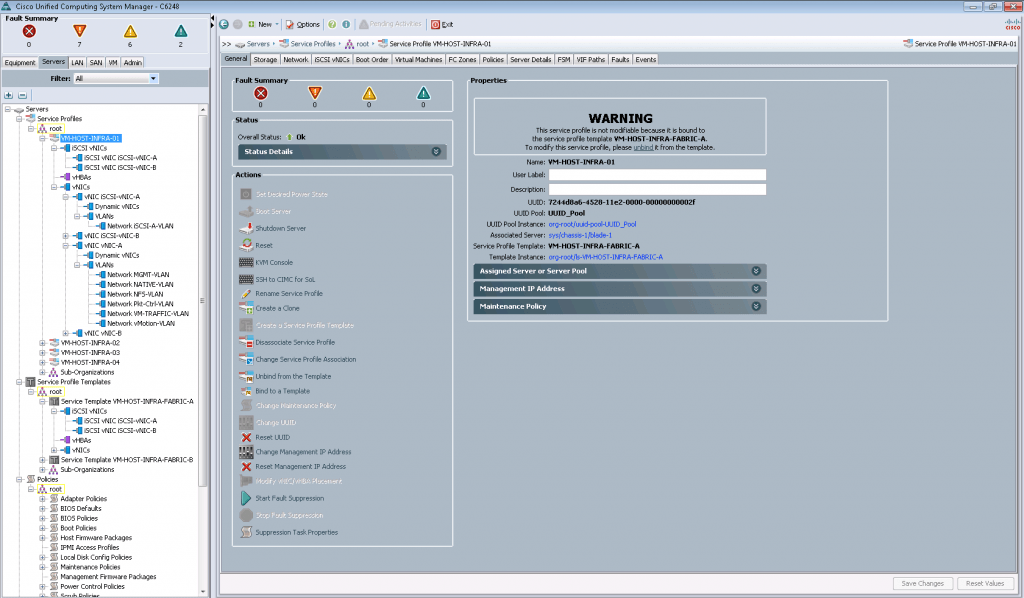

Сервисный профиль, который содержит в себе вышеупомянутые настройки, может быть применен к одному определенному серверу, либо группе серверов. Если в ходе развертывания возникают какие-либо ошибки или сообщения – мы можем посмотреть их в соответствующей вкладке «Faults»:

После чего пользователи этих организаций могут развернуть и настроить сервер под себя с выбранной операционной системой и набором предустановленным набором программного обеспечения. Для этого необходимо воспользоваться возможностями интерфейса UCS Manager, либо обратившись к автоматизации: например при помощи продукта VMware vCloud Automation Center или Cisco Cloupia.

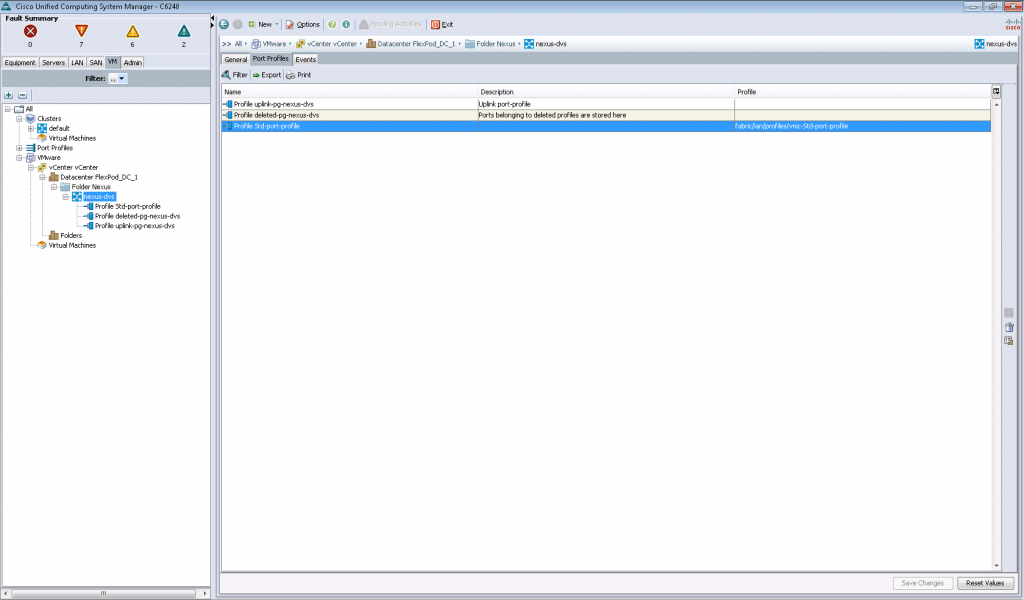

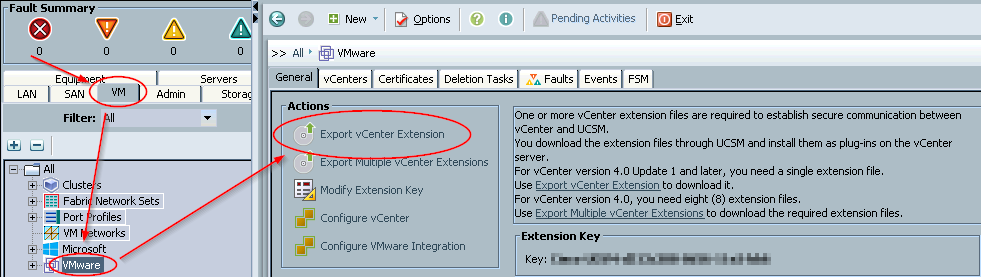

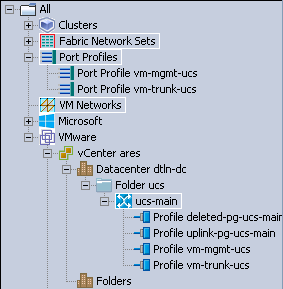

Переходим на вкладку «VM».

В VMware vCenter можно установить плагины для Cisco UCS Manager. Так, мы подключили плагин, через который подключили виртуальный дата-центр с названием «FlexPod_DC_1». В нем работает Cisco Nexus 1000v (nexus-dvs), и мы имеем возможность смотреть его настройки.

Ну и последняя вкладка: «Admin».

Здесь мы можем посмотреть глобальные события: ошибки, предупреждения. Собрать различные данные в случае обращения в поддержку Cisco TAC и т.п. вещи. В частности их можно получить на вкладках «TechSupport Files», «Core Files».

На скриншоте видны ошибки, связанные с отключением электричества. В рамках тестирования мы отключали по очереди блоки питания (Power supply 1 in fabric interconnect A, B) для демонстрации заказчику стабильности работы системы при смоделированном случае отключения подачи питания на одном энерговводе.

В качестве заключения хотим отметить, что весь процесс настройки и тестирования FlexPod, частью которого является настройка и тест Cisco UCS, занял целую неделю. Немного усложнило задачу отсутствие документации для последней версии UCS Manager 2.1. Приходилось пользоваться вариантом для 2.0, который имеет ряд расхождений. На всякий случай выкладываем ссылку на документацию. Возможно, и она кому-нибудь пригодится.

В следующих постах мы продолжим освещать тему FlexPod. В частности мы планируем рассказать о том, как мы вместе с заказчиком тестировали NetApp в режиме MetroCluster в составе FlexPod. Не отключайтесь!

В этой небольшой статье я хочу показать самые распространённые типы ошибок, возникающие на сетевом интерфейсе коммутатора или роутера. Это будет полезно при проведении диагностики и аудита локальной сети среднего и крупного масштаба.

Align-Err

Количество ошибок выравнивания.

Как правило, увеличение данного счетчика свидетельствует о проблемах согласования дуплексных режимов, либо о наличии проблемы на физическом уровне.

collisions

Число коллизий произошедших до окончания передачи пакета. Нормальное явление для полудуплексного интерфейса. Быстрый рост счетчика может быть вызван высокой загрузкой интерфейса, либо несоответствием режимов дуплекса.

CRC

Несовпадение контрольной суммы кадра.

Обычно является результатом конфликтов, но может указывать и на физическую неполадку. В некоторых случаях возможны наводки на физику ЛВС, либо помехи.

Pause input

Подключенное устройство запрашивает приостановку передачи трафика при переполнении его буфера.

Excess-Col

Подобно коллизиям не должно наблюдаться на полнодуплексном интерфейсе.

FCS-Err

Ошибки в контрольной последовательности кадров.

Как правило, увеличение данного счетчика свидетельствует о проблемах согласования дуплексных режимов, либо о наличии проблемы на физическом уровне.

Ignored

Может быть признаком широковещательного шторма в сети.

Late-Col

Коллизии на последних этапах передачи кадра. Не должны наблюдаться на полнодуплексном порту.

Lost carrier

Потеря несущей. Проблемы на физическом уровне.

Underruns

Скорость передатчика превышает возможности коммутатора.

Undersize

Полученные кадры с размером меньше минимума. Необходимо проверить устройство, посылающее такие кадры

Cisco Unified Computing System (UCS) — это платформа для ЦОД следующего поколения, которая объединяет вычислительные и сетевые ресурсы, доступ к системам хранения данных, а также средства виртуализации в единую систему. Решение позволяет значительно снизить затраты на эксплуатацию ЦОД и увеличивает операционную эффективность бизнеса.

Cisco Unified Computing System (UCS) — это платформа для ЦОД следующего поколения, которая объединяет вычислительные и сетевые ресурсы, доступ к системам хранения данных, а также средства виртуализации в единую систему. Решение позволяет значительно снизить затраты на эксплуатацию ЦОД и увеличивает операционную эффективность бизнеса.

Система объединяет в себе универсальную высокоскоростную сетевую инфраструктуру (unified fabric) на базе технологий 10-Gigabit Ethernet и широко используемую x-86 архитектуру серверов компании Intel. Решение Cisco UCS позволяет создать интегрированную и масштабируемую платформу, в которой все элементы решения управляются централизовано.

Cisco UCS имеет в своем составе единую систему управления, которая позволяет управлять комплексами до 160 физических серверов, на каждом из которых могут функционировать десятки виртуальных машин, обеспечивая превосходное масштабирование ЦОД без увеличения сложности управления.

Архитектура системы Cisco UCS улучшает переносимость профилей физических машин, т.к. профиль сервера, конфигурация его LAN/SAN соединений и I/O, встроенного ПО и профили сетевых соединений могут быть динамически присвоены любому физическому серверу в системе. Такая высокодинамичная среда с поддержкой принципа Stateless Computing может быть легко адаптирована для удовлетворения быстро меняющихся требований современных центров обработки данных. Это подразумевает внедрение в нужный момент необходимых вычислительных ресурсов и перемещение рабочей нагрузки.

Cisco Unified Computing System улучшает доступность, безопасность и производительность благодаря интегрированному дизайну системы.

Компоненты системы UCS

• Центральные коммутаторы UCS 6200 Series Fabric

• Шассиблейд—серверов UCS 5100 Series

• Сетевыемодули UCS 2200 Series Fabric Extender

• Блейд—серверы UCS B-Series

• Стоечные-серверы UCSC—Series

• Сетевые адаптеры UCS

• Модуль управления UCS Manager

Центральные коммутаторы UCS серии 6200 Fabric Interconnect

Конвергентные коммутаторы сочетают функции коммутации трафика ethernet и fibre channel с управлением системой UCS. Архитектура коммутаторов предусматривает коммутацию трафика на скоростях до 10 Гбит/с без потерь пакетов и с крайне низкими задержками. Устройства поставляются в корпусе 1RU с 48 портами или в корпусе 2RU с 96 портами. Поддерживают модули расширения, обеспечивающие подключения Fibre Channel и 10 Gigabit Ethernet.

Основные функции:

• 10 Gigabit Ethernet порты SFP+, поддержка FCoE

• Варианты 48 и 96 встроенных портов со слотами расширения для добавления портов Fibre Channel и 10 GE

• Встроенная система управления UCS Manager

• До 1.04 Tbps производительности

• Зарезервированные блоки питания и вентиляторы с «горячей заменой»

• Управление до 40 шасси на систему UCS

Сетевоймодуль UCS серии 2200 Fabric Extender

Модули обеспечивают связи между центральными коммутаторами и блейд-серверами. С их помощью упрощаются процессы диагностики, подключения кабелей и управления системой.

Основные функции:

• Подключение блейд-шасси UCS к центральным коммутаторам (Fabric Interconnect)

• 8 внешних порта 10 Gigabit Ethernet SFP+ с поддержкой FCoE

• До двух модулей на шасси для обеспечения отказоустойчивости и до 80 Гбит/с полнодуплексной производительности

• Встроенное управление шасси

• Управляется UCS Manager через центральный коммутатор

Шасси для блейд-серверов UCS серии 5100

Представляет собой серверную корзину, которая поддерживает до восьми блейд-серверов и до двух сетевых модулей в корпусе 6RU, не требуя дополнительных модулей управления.

Основные функции:

• 4 блока питания (резервирование по схеме N+1 или N+N )

• 8 вентиляторов (по умолчанию)

• Охлаждение «спереди назад»

• Высота шасси 6U

• Внутрь можно установить до 8 блейд-серверов половинной ширины или 4 блейд-сервера полной ширины

• Все блейд-серверы одинарной высоты

• Установка до 2-х сетевых модулей

• Индикаторная идентификация

Блейд-серверы UCS (серия B)

Блейд-серверы UCS – это блейд-серверы архитектуры x86 на базе процессоров Intel Xeon, которые адаптируются под требования приложений, регулируют использование электроэнергии и обеспечивают лучшую виртуализацию среди устройств своего класса. Уникальная технология расширения памяти Cisco значительно увеличивает объем памяти, что повышает производительность и пропускную способность для ресурсоемких приложений виртуализации и обработки крупных наборов данных. Кроме того, эта технология предлагает более экономичный вариант памяти для менее требовательных рабочих нагрузок.

Стоечные серверы UCS (серия C)

Стоечные серверы UCS — серверы, предназначенные для работы в автономных средах и в составе среды унифицированных вычислений Cisco, выполненные в стандартном конструктивном исполнении. Они поддерживает модель пошагового развертывания с возможностью будущего перехода на унифицированные вычисления.

Сетевые адаптеры Cisco UCS

В настоящее время все сетевые адаптеры для блейд-систем условно можно поделить на три типа: традиционные, конвергентные и виртуализиро-ванные.

• Традиционные адаптеры — классические адаптеры с аппаратной поддержкой протокола Ethernet и программной поддержкой конвергентного протокола Fibre Channel over Ethernet, предназначенные для передачи и обмена данными в сети. Наиболее известный производитель таких адаптеров — компания Intel, Broadcom.

• Конвергентные адаптеры — адаптеры с интегрированными чипами протоколов 10GbE и Fibre Channel или имеющие конвергентный чип протокола FCoE. На данный момент это наиболее используемый тип адаптеров в существующих серверных системах. Наиболее распространенные производители этих типов — компании Emulex и Qlogic.

• Виртуализированные адаптеры – адаптеры, которые позволяют создать несколько логических адаптеров как в динамике (например, при интеграции с системами виртуализации), так и статично. Использование виртуализированного адаптера в среде гипервизора позволяет перенести задачи коммутации трафика между сетевыми машинами на сетевое оборудование, что позволяет высвободить процессорные ресурсы и предоставить их виртуальным машинам, тем самым повысить их производительность в целом.

Компания Cisco Systems разработала собственный виртуализированный двухпортовый конвергентный адаптер Cisco Virtualized Interface Card с исключительными характеристиками, позволяющий иметь преимущество перед другими производителями:

• Способен создать до 58 виртуализированных Ethernet или FC адаптеров (на одном физическом адаптере с использованием метки VNTag проекта стандарта IEEE 802.1Qbh)

• Поддержка стандарта PCIe

• Работа в виртуализированной и невиртуализированной среде

• Поддержка Hypervisor Bypass

• Отказоустойчивость на аппаратном уровне

• Высокая производительность (2x 10Gb, >600K IOPS)

В стоечных серверах UCS используются наиболее востребованные сетевые адаптеры в виде карт PCIe, таких производителей, как QLogic, Broadcom, Emulex и Intel, а также виртуализированный PCIe адаптер Cisco VIC.

Программный модуль UCS manager

UCS Manager – это встроенный программный модуль, с помощью которого осуществляется управление всеми компонентами блейд-системы. Интерфейс UCS Manager разделен на пять зон: администрирование, оборудование, серверы, ЛВС и сеть хранения. Под администрированием подразумеваются операции, производимые с помощью UCS Manager. Оборудование — это, как правило, задействованная в данный момент физическая основа UCS. Серверами в общем случае именуются логические серверы, созданные и используемые посредством UCS Manager. В зону ЛВС включается всё, что относится к локальным сетям, а в зону сети хранения — всё, что касается ресурсов хранения.

Преимущества Unified Computing System (UCS)

• Встроенное управление системой

Каждый из компонентов объединенной системы вычислений Cisco UCS поставляется со встроенным микропрограммным обеспечением, которое позволяет управлять работой устройства с помощью Cisco UCS Manager. Администраторы сети, системы хранения данных и серверов могут работать с графическим пользовательским интерфейсом или интерфейсом командной строки системы Cisco UCS Manager или, используя документированный набор функций XML API, из существующей корпоративной системы управления ЦОД.

Ролевая модель контроля упрощает решение задач управления, к которым должны привлекаться группы администраторов серверов, сети и системы хранения данных, позволяя ограничить область распространения специальной информации рамками каждой группы. Это позволят экспертам по конкретным вопросам следовать обычным рабочим процедурам и интегрировать все данные о конфигурации в рамках единой системы управления, а не в разрозненных системах, как это нередко происходит в современных ЦОД.

• Внедрение приложений с использованием сервисных профилей

ПО UCS Manager реализует концепцию управления на базе ролей и политик с использованием сервисных профилей и шаблонов. Информация о параметрах системы электропитания, охлаждения, физической безопасности, а также о состоянии оборудования, конфигурации сетевой среды и сети хранения данных содержится в сервисном профиле. Использование сервисных профилей позволяет ИТ-персоналу ЦОД снизить время внедрения приложений в ЦОД от дней до минут.

• Объединенный транспорт

Разработанная CiscoSystems технология консолидированной сети (unifiedfabric) на базе наборов стандартов DataCenterBridging и FibreChanneloverEthernet (FCoE) позволяет значительно снизить затраты на элементы сетевой инфраструктуры (множество сетевых адаптеров, коммутаторы LAN, SAN, различные сетевые кабели и т.п.). Сетевые модули шасси позволяют отказаться от использования коммутаторов в составе блейд-серверов путем транзита всего трафика от серверов через централизованную фабрику коммутации, где трафик будет обрабатываться и коммутироваться по назначению. Унифицированная фабрика коммутации строится на базе технологии 10-Gigabit Ethernet со стандартными кабельными соединениями. Теперь в случае изменения типа подключения сервера к сети нет необходимости в установке дополнительных адаптеров и прокладке новых кабелей.

• Поддержка технологии виртуализации (VN-Link)

Технология Cisco VN-Link расширяет границу сети до виртуальной машины. Эта технология стирает различия по управлению сетевой инфраструктурой для физических и виртуальных серверов. Теперь все сетевые соединения настраиваются и управляются централизовано, без выделения дополнительного уровня коммутации для виртуальных сред. Конфигурации портов ввода/вывода и сетевые политики могут перемещаться между виртуальными серверами, что увеличивает эффективность и уменьшает сложность их эксплуатации.

• Виртуализированный адаптер Cisco VIC

Виртуализированный адаптер Cisco VIC позволяет получить на одномдвухпортовом конвергентном адаптере динамически или статически до 58 виртуальных адаптеров, каждый их которых представлен PCIe-функцией. Таким образом, операционная система «видит» каждый из виртуальных адаптеров как физический адаптер. Данным виртуальным адаптерам можно гарантировать полосу пропускания; неиспользуемая в текущий момент часть полосы пропускания любого виртуального адаптера может быть динамически распределена между другими виртуальными адаптерами, которым в тот же момент требуется бОльшая полоса, чем им гарантировал системный администратор.

• Технология расширения памяти Cisco

Технология расширения памяти Cisco позволяет увеличить в 4 раза количество разъемов для установки модулей памяти DIMM (до 96) по сравнению с классическими двухпроцессорными серверами архитектуры x86 при сохранении скорости частоты 1866Мгц. Увеличение оперативной памяти позволяет увеличить производительность работы серверов, особенно при работе в виртуальных средах.

• Современная производительность

В решении Cisco UCS используются блейд-сервера, построенные на базе процессоров серии Intel Xeon E5 v2 и Е7 v2. Эти многоядерные процессоры интеллектуально и автоматически регулируют производительность серверов в соответствии с требованиями приложений, увеличивают производительность в необходимый момент и существенно экономят энергопотребление в период простоя. Для более точного управления серверами все параметры производительности и экономии электроэнергии могут быть настроены вручную.

• Энергетическая эффективность

Компоненты решения Cisco UCS были спроектированы с учетом требований по энергетической эффективности. Упрощенная архитектура системы позволила сократить количество элементов, для которых необходимо электропитание и охлаждение примерно на 50% по сравнению с классическими средами блейд-серверов. Шасси блейд-серверов в решении Cisco UCS сделано таким образом, чтобы значительно увеличить теплообмен с окружающей средой. Решение Cisco UCS использует новые, более эффективные блоки питания для своих компонентов.

Гарантия и сервисные контракты

Компания Cisco Systems на все продукты UCS помимо стандартной гарантии по желанию партнеров предоставляет сервисные контракты.

Unified Computing Warranty (3-year) — бесплатная стандартная гарантия сроком на 3 года, она включает в себя:

• Загрузку прошивок BIOS и драйверов

• Авансовую замену оборудования сроком NBD (next business day)

• 90-дневную гарантию на программный носитель

• Круглосуточный доступ в службу технической поддержки Cisco TAC для оформления RMA

Unified Computing Warranty Plus — платное расширение гарантии сроком на 1 год (по умолчанию) включает:

• Все выше перечисленное

• Более гибкое время реакции на замену оборудования • Возможность замены оборудования на площадке у заказчика

Unified Computing Support Service — платный сервисный контракт сроком на 1 год (по умолчанию), включает:

• Все выше перечисленное

• Круглосуточная поддержка в TAC на ПО (все ОС, VMWare, BMC BladeLogic)

• Разделение зоны ответственности между Cisco и производителем ПО

• Возможность проактивной диагностики оборудования

• Круглосуточный доступ в службу Cisco TAC по любым вопросам

• Обновление UCS Manager

ucs_cisco@marvel.ru

Компания Марвел: +7 812 326 3232; +7 495 745 8008, www.marvel.ru

Intel, логотип Intel,Xeon и Xeon Inside являются товарными знаками корпорации Intel на территории США и других стран.

Данный материал является частной записью члена сообщества Club.CNews.

Редакция CNews не несет ответственности за его содержание.

Номер статьи: 0000204

Обычно настройку производят сотрудники банка. Драйвера и инструкции можно скачать по ссылке

Краткая инструкция по установке и настройке МикроМодуля

TCP/IP

УСТАНОВКА МИКРОМОДУЛЯ:

1) Распаковать архив MM260816_IP.zip на рабочую станцию в произвольный каталог.

Например – C:temp .

2) Перезагрузить рабочую станцию. Войти в систему под учетной записью администратора или пользователя с правами администратора.

3) Запустить файл custom.bat

4) Нажимать кнопку «Далее» до завершения установки.

5) Установка завершена. МикроМодуль установлен в каталог C:UCS .

Замечание.

Автоматически выполняется установка и регистрация в системе COM-обертки — UCS_MA.ocx.

НАСТРОЙКА МИКРОМОДУЛЯ:

1) Открываем на редактирование файл micromgl.cfg в папке C:UCS c помощью блокнота или любого текстового редактора.

2) В данном файле есть блок параметров [PROXY].

Он имеет вид:

[PROXY]

TYPE=IP

ADDR=172.16.32.177:4001

FMT=H

TO=3200

В переменной «ADDR» нужно изменить IP-адрес 172.16.32.177 на тот, который присвоен терминалу.

Важно: изменить нужно только адрес, номер порта ( :4001 ) оставляем неизменным.

3) Сохраняем и закрываем файл.

ПРОВЕРКА СВЯЗИ С ТЕРМИНАЛОМ:

1) Перейти в каталог C:UCSBIN .

2) Запустить файл test.bat

3) На терминале должна начаться операция «Инкассация».

Если инкассация началась, это значит, что связь между терминалом и кассой присутствует, и настройки МикроМодуля верны. После этого можно приступать к необходимым настройкам кассы.

Замечания.

- 1) В bat выполняется запуск утилиты ucs_dt.exe. Лог утилиты: файл stdout.txt.

В данном файле, при необходимости, можно увидеть ID подключенного терминала (TID).

См. строку вида:

2016-10-14 14.11.08 {000014AC} L[0:300] : UCS_DT: Recevd (3100199997310210)

TID в данном примере: 19999731.

2) При возникновении вопросов, в тех. службу необходимо передавать логи:

Лог микромодуля: файл ucs_comm.log

Лог утилиты ucs_dt: файл stdout.txt .

Просмотры: 4096

Introduction

This document describes commands used to troubleshoot network connectivity, drops, and CRC errors within different UCS, FIs, IOMs, and VIC adapters.

Prerequisites

Requirements

This document assumes that you have knowledge of these topics:

- Cisco Unified Computing Systems (UCS) Virtual Interface Card (VIC)

- Cisco UCS B-Series and C-Series servers

- Cisco UCS Fabric extender I/O Module (IOM)

- Cisco UCS Fabric Interconnect (FI)

- Cisco Unified Computing System Manager (UCSM)

- Cisco Unified Computing System Manager (UCSM) Command Line Interface (CLI)

- Cut-through and store-and-forward switches

- Stomps

Components Used

The information in this document is based on these software and hardware versions:

- Cisco UCS Manager version 2.x and later

- Cisco UCS 6200, 6300, and 6400 Series Fabric Interconnect

- Cisco UCS 2200, 2300 and 2400 Series Fabric extender I/O Module

- Cisco UCS 1200, 1300, and 1400 Series Virtual Interface Card (VIC)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. If your network is live, ensure that you understand the potential impact of any command.

Background Information

The Cisco UCS Fabric Interconnect is a cut-through switch like the Cisco Nexus 5000 Series Switches. It forwards bad frames like good frames. Bad frames get dropped by the destination server or when they pass through a piece of network equipment that is not cut-through.

Note: A CRC check is performed at the end of the frame to determine whether or not a frame has become corrupted. Some switches can drop the frame once they detect a frame is corrupted. Cut through switches make the forwarding decision before they can perform the CRC check. Because of these frames that fail, a CRC check can still be switched by a cut-through switch. Other switches like the N7K are store and forward switches. Store and forward switches look at the entire frame before they make a forwarding decision. A store and forward switch would drop a frame that failed a CRC check. If you experience CRC errors on an interface, it does not mean that interface is the source of the problem. To understand the architecture (cut-through vs store-forward) of the switches in the topology is imperative. Many times, you need to work your way backward to the source of the CRC error. Refer to this article for more details about cut-through and store-and-forward switches: Cloud Networking Switches

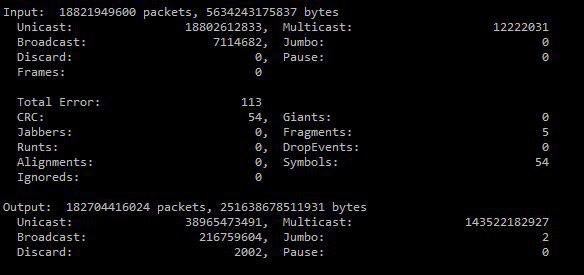

Reasons for Bad Frames and CRC Errors

Some of the reasons for when you get bad frames and CRC errors can be:

- Bad physical connection; transceiver, copper, fiber, adapter, port expander, and so on.

- MTU Violation

- Received bad CRC stomped from neighboring cut-through switch.

Forwarding Mode Behavior (Cut-Through or Store-and-Forward)

UCS Fabric Interconnects (similar to Nexus 5000) utilizes both cut-through and store-and-forward switching. Forwarding mode is dependent on the ingress and egress data rate, as shown in table 1.

Note: Cut-through switching can be performed only when the ingress data rate is equivalent to or faster than the egress data rate.

Table 1 — Forwarding Mode Behavior (Cut-Through or Store-and-Forward) for UCS Fabric Interconnect

|

Ingress/ Source Interface |

Egress/ Destination Interface |

Forwarding mode |

|

10 Gigabit Ethernet |

10 Gigabit Ethernet |

Cut-through |

|

10 Gigabit Ethernet |

1 Gigabit Ethernet |

Cut-through |

|

1 Gigabit Ethernet |

1 Gigabit Ethernet |

Store-and-forward |

|

1 Gigabit Ethernet |

10 Gigabit Ethernet |

Store-and-forward |

|

10 Gigabit Ethernet |

40 Gigabit Ethernet |

Store-and-forward |

|

40 Gigabit Ethernet |

10 Gigabit Ethernet |

Cut-through |

|

40 Gigabit Ethernet |

40 Gigabit Ethernet |

Cut-through |

|

FCoE |

Fibre Channel |

Cut-through |

|

Fibre Channel |

FCoE |

Store-and-forward |

|

Fibre Channel |

Fibre Channel |

Store-and-forward |

|

FCoE |

FCoE |

Cut-through |

Main Forwarding ASICs Commands for UCS FIs, IOMs and VIC Cards

Tables 2 and 3 show the different commands that can be run from the different management endpoints in UCS to determine where the drops are coming from and why they are occurring.

In addition to the ASIC specific commands mentioned in table 2, these commands can be run from UCS FI NXOS shell to look for errors at the receive direction of interfaces:

show interface counters errors

Table 2 — Main Forwarding ASICs commands for UCS FIs and IOMs

|

UCS FI / IOM |

Main FW ASIC Name |

Commands |

Purpose |

|

Cisco UCS Fabric Interconnects |

|||

|

1Cisco UCS 6100 Series (Gen 1 FIs 61xx) End-of-Life and End-of-Sale) |

Gatos |

(nxos)# show hardware internal gatos |

This command shows Gatos ASIC internals and driver information. The third column shows how many ports/interfaces are mapped to each ASIC. |

|

(nxos)#show hardware internal gatos all-ports |

This command shows driver information for all ports + front panel port to ASIC mapping. |

||

|

Cisco UCS 6200 Series (Gen 2 FIs 62xx) |

Carmel |

(nxos)# show hardware internal carmel |

This command shows the Carmel ASIC internals and driver information. 5th column shows how many ports/interfaces are mapped to each Carmel ASIC. |

|

(nxos)# show hardware internal carmel all-ports |

This command shows driver information for all ports and front panel physical ports to ASIC mapping. |

||

|

2(nxos)# show hardware internal carmel crc |

This command shows information if any frames were received or transmitted with CRC errors or stomped for all ports. |

||

|

(nxos)# show platform fwm info asic-errors X |

This command shows non zero Carmel drop reasons error registers (where X is the Carmel ASIC number from 0-4). |

||

|

(nxos)# show platform fwm info pif e1/X | grep asic |

Use this command and you can map your interface to the Carmel ASIC ID “global_asic_num” (where X is the interface number). |

||

|

(nxos)# show platform fwm info pif e1/X | grep drop |

This command shows the number of frames, and it filters for the drop counter for a certain interface (where X is the interface number). |

||

|

(nxos)# show hardware internal carmel all-ports detail | egrep -i «Carmel port|crc|frame_error» |

This command filters for CRC and frame error counters for all ports. |

||

|

Cisco UCS 6300 Series (Gen 3 FIs 63xx) |

Trident2 (Broadcom ASIC) |

(nxos)# show hardware internal bcm-usd info port-info |

This command shows the mapping between each physical port to a front port on the Broadcom ASIC and this mapping is different between 6332 and 6332-16UP FIs. |

|

(nxos)# show hard internal interface indiscard-stats front-port X |

This command shows port internal discard counters for a certain front port on the Broadcom ASIC after the mapping is done that uses the previous command. |

||

|

Cisco UCS 6400 (Gen 4 FIs 64xx) |

Homewood ASIC |

FI # connect nxos (nx-os)# show hardware internal interface asic counters module 1 |

This command shows the reason for the forwarding drops if reported on the interface. |

|

FI # attach module 1 |

This command shows the different counters of information tha use ASIC library. There is only one ASIC within this UCS Fabric interconnect model so always ASIC number 0. |

||

|

FI # attach module 1 module-1# show hardware internal tah drop-reason counters module 0 |

This command shows the drop reasons and number of dropped packets. |

||

|

Cisco UCS 64108 Gen 4 FIs |

Cisco ASIC Heavenly |

FI # connect nxos (nx-os)# show hardware internal interface asic counters module 1 |

This command shows the reason for the forwarding drops if reported on the interface |

|

FI # attach module 1 |

This command shows the different counters of information that use the ASIC library. |

||

|

FI # attach module 1 module-1# show hardware internal tah drop-reason counters module 0 |

This command shows the reason for the forwarding drops if reported on the interface. |

||

|

Cisco UCS Mini (6324 Fabric Interconnect) |

Monticello ASIC |

(nxos)# show hardware internal mtc-usd port-status |

This command shows the status of the ports for the Monticello ASIC. (nxos)# show hardware internal inband-mtc ? ASIC Show Monticello ASIC information info. Show Monticello inband driver info stats. Show Monticello inband driver statistics.

|

|

Cisco UCS Fabric extender I/O Modules (IOMs) |

|||

|

1Cisco UCS 2100 IOM (Gen 1) |

Redwood |

FI # connect IOM <chassis ID> Fex-1# show platform software redwood sts |

This command shows the interface status of the HIFs and NIFs within the Redwood ASIC and which HIFs are used by each blade. |

|

Cisco UCS 2200 IOM (Gen 2) |

Woodside |

FI # connect IOM <chassis ID> fex-1# show platform software woodside sts |

This command shows the interface status of the HIFs and NIFs within the Woodside ASIC and which HIFs are used by each blade.

Note: There are two numberings for the HIFs, one is used when you troubleshoot from the IOM (after you connect to IOM) and the other is used when you troubleshoot the same HIF and run the commands from UCSM nxos. For example, blade 1 uses HIF numbers 28-31. You can use these numbers after you connect to IOM and run the related commands to that HIF. While these correspond to Eth1/1/1 — 4 from UCSM nxos as per show FEX detail. |

|

FI # connect IOM <chassis ID> fex-1# show platform software woodside rate |

This command shows the packet rates for active HIF or NIF ports. |

||

|

FI # connect IOM <chassis ID> fex-1# show platform software woodside rmon 0 [NIx/HIx] For example, you can filter some error counters using grep for all NIFs as below: fex-1# show platform software woodside rmon 0 nif_all | egrep -i |

This command shows the received and transmitted packet sizes for a certain HIF or NIF and packet types like unicast, broadcast, or multicast. RX_CRC_NOT_STOMPED |

||

|

FI # connect IOM <chassis ID> fex-1# show platform software woodside drops 0 [NIx/HIx] |

This command shows the drop counters for a certain NIF or HIF. |

||

|

FI # connect IOM <chassis ID> fex-1# show platform software woodside oper |

This command shows the administrative control, MAC, and physical status, in addition to detected SFPs within the NIFs. |

||

|

FI # connect iom <chassis ID> |

This command shows the transceiver details within the woodside IOM NIF ports. |

||

|

Cisco UCS 2300 IOM (Gen 3) and Cisco UCS 2300 IOM version 2 (UCS-IOM-2304V2) |

Tiburon (Broadcom ASIC) |

# connect IOM <chassis ID> Fex-1# show platform software tiburon sts |

This command shows the interface status of the HIFs and NIFs within the Tibrun ASIC and which HIFs are used by each blade.

Note: in regards to the 40G backplane ports within Gen 3 IOMs, HIF status can normally be with the 40 Gig primary ports marked as UP, and the 40 Gig member ports are marked Down. |

|

# connect IOM <chassis ID> fex-1# show platform software tiburon rate |

This command shows the packet rates for active HIF or NIF ports. |

||

|

FI # connect IOM <chassis ID> For example, you can filter some error counters using grep for all NIFs as shown: fex-1# show platform software tiburon rmon 0 nif_all | egrep -i ‘crc|ni|stomp|pause|err’ |

This command shows the received and transmitted packet sizes for a certain HIF or NIF and packet types like unicast, broadcast, or multicast. RX_CRC_NOT_STOMPED |

||

|

Cisco UCS 2408 (fourth-generation I/O Module) «Summerville» UCS-IOM-2408 |

Sundown |

FI # connect iom <chassis ID> |

This command shows the interface status of the HIFs and NIFs within the Tahoe ASIC and which HIFs are used by each blade. |

|

fex-1# show hardware internal tah sts detail |

This command shows the NXOS to HIF port mapping, link-state, and operational speed. |

||

|

fex-1# show hardware internal tah counters asic 0 nxos-port ? |

This command shows the detailed per-port counters The detailed interface counters can be viewed by referring to the NXOS port number. NXOS Ports 0-31 correspond to 32 HIF Ports |

1 End-of-Sale and End-of-Life Announcement for the Cisco UCS 6100 Series Fabric Interconnects and Cisco UCS 2100 Series IO Modules: Cisco UCS 6100 Series Fabric Interconnects

2 Mode details on some columns of show hardware internal carmel crc command:

- MM rx CRC = CRC on this link; Problem is L1 issue; Check eye height; shut, no shut; replace cable;

- MM Rx Stomp = STOMP on the remote switch; Go check the same output on the switch across this link;

- FI Rx Stomp = If MM Rx CRC and MM Rx Stomp are blank; L2/policy violation, most commonly MTU violation; Check QoS MTU settings.

Table 3 — The main commands to troubleshoot connectivity, drops, and CRC errors for Cisco UCS VIC cards.

|

UCS VIC Generation |