Сформулируем новый набор предпосылок, который будем называть предпосылками линейной модели со стохастическими регрессорами. Начнем с модели парной регрессии.

Предпосылки линейной модели со стохастическим регрессором (случай парной регрессии):

-

Модель линейна по параметрам и правильно специфицирована:

(y_{i} = beta_{1} + beta_{2}x_{i} + varepsilon_{i}, i = 1,2,ldots, n.)

-

Наблюдения ({left( x_{i},y_{i} right),text{~i} = 1,ldots,n}) независимы и одинаково распределены.

-

(x_{i}) и (y_{i}) имеют ненулевые конечные четвертые моменты распределения (Eleft( x_{i}^{4} right) < infty,) (Eleft( y_{i}^{4} right) < infty).

-

Случайные ошибки имеют нулевое условное математическое ожидание при заданном (x_{i}): (Eleft( varepsilon_{i} middle| x_{i} right) = 0).

Сравним предпосылки этой модели с предпосылками классической линейной модели парной регрессии (КЛМПР) из главы 2.

Первая предпосылка стандартна и остается без изменений.

Вторая предпосылка в КЛМПР требовала, чтобы регрессоры были неслучайными величинами. Теперь мы отказываемся от неё, допуская, что объясняющие переменные могут быть случайными. При этом мы требуем, чтобы наблюдения ({left( x_{i},y_{i} right),text{~i} = 1,ldots,n}) были независимыми и одинаково распределенными (independent and identically distributed, i.i.d.).

Это требование вовсе не означает, что (y_{i}) не зависит от (x_{i}) (ясно, что в этом случае анализировать модель их взаимосвязи было бы бессмысленно). Зато оно говорит о том, что векторы (left( x_{1},y_{1} right),left( x_{2},y_{2} right)), (left( x_{3},y_{3} right)ldots) независимы друг от друга в вероятностном смысле. Иными словами, отдельные наблюдения в нашей модели не влияют друг на друга.

Для пространственных данных эта предпосылка практически всегда выполняется1. В то же время следует помнить, что при работе с временными рядами эта предпосылка часто нарушается, так как для временных рядов естественно предполагать, что будущие значения переменных зависят от прошлых2. Поскольку пока мы в основном концентрируемся на пространственных данных, для нас она остается весьма реалистичной.

Лирическое отступление о неслучайных и случайных регрессорах

Отвлечемся ненадолго от технических деталей и обратимся к вопросу: как следует думать об объясняющих переменных с содержательной точки зрения? Следует ли считать их скорее детерминированными величинами или скорее случайными?

Ответ, разумеется, зависит от того, с какими данными вы работаете, и какова процедура их сбора.

Представим, например, что вы анализируете зависимость логарифма реального ВВП от номера года. То есть оцениваете параметры линии тренда для временного ряда:

({ln y}_{t} = beta_{1} + beta_{2}*t + varepsilon_{t})

Здесь (y_{t}) — ВВП в год t. В данном примере регрессор (номер года t) вполне естественно считать неслучайным (детерминированным). Действительно, мы точно знаем, что в принятой нами системе летоисчисления за 2020-ым годом последует 2021-ый, а затем наступит 2022-ой. Никакой случайности тут нет.

Теперь представим, что вас интересуют параметры следующей модели для инфляции:

(pi_{t} = beta_{1} + beta_{2}pi_{t — 1} + beta_{2}x_{t} + varepsilon_{t})

(pi_{t}) — это уровень инфляции в год t, а (x_{t}) — это, например, отклонение фактического ВВП от потенциального ВВП в год t 3. Обратите внимание: здесь предполагается, что инфляция в текущем периоде зависит от инфляции в прошлом периоде. Однако инфляция прошлого периода (pi_{t — 1}), в свою очередь, зависит от (varepsilon_{t — 1}), а значит уж точно является случайной величиной. Следовательно, в данном примере по крайней мере один из регрессоров (переменная (pi_{t — 1})) заведомо является случайным (стохастическим).

В двух приведенных примерах детерминированная или стохастическая природа объясняющих переменных может быть определена однозначно из соображений здравого смысла. В то же время, во многих ситуациях решение о том, как воспринимать регрессоры — как неслучайные величины или как случайные — это исключительно вопрос технического удобства. В частности, при использовании асимптотического подхода второй вариант более удобен, поэтому в современных эконометрических приложениях по умолчанию используют его.

Третья предпосылка выглядит достаточно устрашающе. Однако в действительности никак не ограничивает исследователя. По существу, она означает, что очень большие выбросы в данных маловероятны. Это техническая предпосылка, которая, как мы увидим в дальнейшем, позволяет гарантировать асимптотическую нормальность оценок коэффициентов. Это даст нам возможность тестировать гипотезы и строить доверительные интервалы.

Проверить эту предпосылку сложно, однако она достаточно слабая, и потому на практике обычно считают, что она выполнена. Во всяком случае, легко согласиться с тем, что она выполняется гораздо чаще, чем предпосылка КЛМПР №6 о нормальности случайных ошибок. А ведь именно её она, в сущности, заменяет.

Четвертая предпосылка играет ключевую роль в получении корректных результатов эконометрического моделирования. В последующих параграфах и главах мы увидим, что именно вопрос о выполнении или нарушении этой предпосылки оказывается в центре дискуссии об уместности применения тех или иных методов и спецификаций моделей в различных ситуациях.

Содержательно эта предпосылка говорит о том, что «прочие факторы», которые «спрятаны» в случайной ошибке (varepsilon_{i}), никак не связаны с регрессором. Поэтому знание (x_{i}) никак не влияет на ожидания по поводу случайной величины (varepsilon_{i}).

Чтобы на конкретных числах «пощупать» эту предпосылку, а заодно вспомнить, что такое условное математическое ожидание и как его считать, рассмотрим следующий простой пример.

Пример 6.3. Об условном математическом ожидании

Пусть известен совместный закон распределения случайных величин (x_{i}) и (varepsilon_{i}).

| (varepsilon_{i} = — 1) | (varepsilon_{i} = 0) | (varepsilon_{i} = 1) | |

|---|---|---|---|

| (x_{i} = 0) | 0,2 | 0,1 | 0,2 |

| (x_{i} = 1) | 0,1 | 0,3 | 0,1 |

(а) Проверьте, выполняется ли в данном случае предпосылка №4 об условном математическом ожидании случайной ошибки?

(б) Вычислите безусловное математическое ожидание случайной ошибки.

(в) Вычислите (text{cov}left( varepsilon_{i},x_{i} right)).

Решение:

(а) Напомним, что по определению условным математическим ожиданием случайной величины (varepsilon_{i}) при условии (x_{i}) называется математическое ожидание условного распределения случайной величины (varepsilon_{i}) при условии (x_{i}).

Запишем закон условного распределения (varepsilon_{i}) при условии, что (x_{i} = 0). Для этого отметим, что вероятность события (x_{i} = 0) в нашем примере составляет 0,2+0,1+0,2=0,5.

| (varepsilon_{i} = — 1) | (varepsilon_{i} = 0) | (varepsilon_{i} = 1) | |

|---|---|---|---|

| (Pleft( varepsilon_{i}|x_{i} = 0 right)) | (frac{0,2}{0,5}) | (frac{0,1}{0,5}) | (frac{0,2}{0,5}) |

Зная этот закон распределения, легко посчитать математическое ожидание:

(Eleft( varepsilon_{i}|x_{i} = 0 right) = — 1*frac{0,2}{0,5} + 0*frac{0,1}{0,5} + 1*frac{0,2}{0,5} = 0)

Аналогично получаем условное математическое ожидание (varepsilon_{i}) при условии, что (x_{i} = 1).

| (varepsilon_{i} = — 1) | (varepsilon_{i} = 0) | (varepsilon_{i} = 1) | |

|---|---|---|---|

| (Pleft( varepsilon_{i}|x_{i} = 1 right)) | (frac{0,1}{0,5}) | (frac{0,3}{0,5}) | (frac{0,1}{0,5}) |

(Eleft( varepsilon_{i}|x_{i} = 1 right) = — 1*frac{0,1}{0,5} + 0*frac{0,3}{0,5} + 1*frac{0,1}{0,5} = 0)

Таким образом, для любого возможного значения (x_{i}) условие (Eleft( varepsilon_{i}|x_{i} right) = 0) соблюдается. То есть предпосылка выполнена.

(б) (Eleft( varepsilon_{i} right) = Pleft( varepsilon_{i} = — 1 right)*( — 1) + Pleft( varepsilon_{i} = 0 right)*0 + Pleft( varepsilon_{i} = 1 right)*(1) =)

(= 0,3*( — 1) + 0,4*0 + 0,3*1 = 0)

Следовательно, безусловное математическое ожидание случайной ошибки тоже равно нулю.

(в) (text{cov}left( varepsilon_{i},x_{i} right) = Eleft( varepsilon_{i}x_{i} right) — Eleft( varepsilon_{i} right)*Eleft( x_{i} right) = Eleft( varepsilon_{i}x_{i} right) — 0*Eleft( x_{i} right) = Eleft( varepsilon_{i}x_{i} right))

(Eleft( varepsilon_{i}x_{i} right) = 0,2*( — 1)*0 + 0,1*0*0 + 0,2*1*0 +)

(+ 0,1*( — 1)*1 + 0,3*0*1 + 0,1*1*1 = 0)

В нашем примере оказалось, что предпосылке №4 соответствует выполнение условий (Eleft( varepsilon_{i} right) = 0) и (text{cov}left( varepsilon_{i},x_{i} right) = 0). На самом деле это не случайный результат. Его можно обобщить, доказав два важных следствия из предпосылки №4.

Следствие 1. Если случайные ошибки имеют нулевое условное математическое ожидание при заданном (x_{i}): (Eleft( varepsilon_{i} middle| x_{i} right) = 0), то они имеют нулевое безусловное математическое ожидание: (Eleft( varepsilon_{i} right) = 0)

Доказательство этого следствия является хорошим примером применения закона повторного математического ожидания.

Напомним формулировку закона повторного математического ожидания:

(E(xi) = Eleft( Eleft( xi middle| eta right) right))

В нашем случае в соответствии с этим законом:

(Eleft( varepsilon_{i} right) = Eleft( Eleft( varepsilon_{i} middle| x_{i} right) right) = E(0) = 0.)

Поэтому, сформулировав предпосылку №4, мы не нуждаемся в том, чтобы отдельно формулировать предположение по поводу безусловного математического ожидания случайной ошибки, которое мы делаем в КЛМПР.

Подчеркнем, что обратное утверждение, вообще говоря, неверно. Вполне возможна ситуация, когда безусловное математическое ожидание случайной ошибки равно нулю, а её условное математическое ожидание при условии (x_{i}) — нет. См. пример 6.4 далее.

Следствие 2. Если случайные ошибки имеют нулевое условное математическое ожидание при любом заданном (x_{i}): (Eleft( varepsilon_{i} middle| x_{i} right) = 0), то регрессор и случайная ошибка не коррелированы друг с другом: (text{cov}left( varepsilon_{i},x_{i} right) = 0).

Для доказательства сначала отметим, что по свойству теоретической ковариации:

(text{cov}left( varepsilon_{i},x_{i} right) = Eleft( varepsilon_{i}x_{i} right) — Eleft( varepsilon_{i} right)Eleft( x_{i} right) = Eleft( varepsilon_{i}x_{i} right) — 0*Eleft( x_{i} right) = Eleft( varepsilon_{i}x_{i} right).)

А затем снова воспользуемся законом повторного математического ожидания:

(Eleft( varepsilon_{i}x_{i} right) = Eleft( Eleft( varepsilon_{i}x_{i} middle| x_{i} right) right) = Eleft( x_{i}Eleft( varepsilon_{i} middle| x_{i} right) right) = Eleft( x_{i}*0 right) = E(0) = 0)

Регрессор, который не коррелирован со случайной ошибкой модели, обычно называют экзогенным регрессором. Таким образом, предпосылку №4 иногда называют предпосылкой об экзогенности регрессора.

Если же объясняющая переменная в модели, наоборот, коррелирована со случайной ошибкой (text{cov}left( varepsilon_{i},x_{i} right) neq 0), то её называют эндогенным регрессором.

Пример 6.4. Об условном математическом ожидании (продолжение)

Пусть теперь совместный закон распределения (x_{i}) и (varepsilon_{i}) имеет такой вид:

| (varepsilon_{i} = — 1) | (varepsilon_{i} = 0) | (varepsilon_{i} = 1) | |

|---|---|---|---|

| (x_{i} = 0) | 0,3 | 0,1 | 0,1 |

| (x_{i} = 1) | 0,1 | 0,1 | 0,3 |

Покажите, что в этом случае условие (Eleft( varepsilon_{i} right) = 0) выполнено, а условие (Eleft( varepsilon_{i} middle| x_{i} right) = 0) нарушается.

Решение:

(Eleft( varepsilon_{i} right) = Pleft( varepsilon_{i} = — 1 right)*( — 1) + Pleft( varepsilon_{i} = 0 right)*0 + Pleft( varepsilon_{i} = 1 right)*(1) =)

(= 0,4*( — 1) + 0,2*0 + 0,4*1 = 0)

Чтобы показать, что предпосылка (Eleft( varepsilon_{i}|x_{i} right) = 0) не выполняется, достаточно привести любое значение (x_{i}), для которого указанное равенство нарушено. Рассмотрим, например, случай (x_{i} = 0).

(Eleft( varepsilon_{i}|x_{i} = 0 right) = — 1*frac{0,3}{0,5} + 0*frac{0,1}{0,5} + 1*frac{0,1}{0,5} = — 0,4)

Следовательно, предпосылка (Eleft( varepsilon_{i}|x_{i} right) = 0) не выполняется: регрессор в модели является эндогенным.

***

Выполнение четырех предпосылок линейной модели со стохастическими регрессорами (случай парной регрессии) гарантирует, что применение МНК будет приводить к хорошим результатам. Говоря более строго, эти гарантии можно сформулировать в виде следующей теоремы:

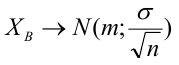

Теорема о состоятельности и асимптотической нормальности МНК-оценок в парной регрессии. Если предпосылки №1–4 выполнены, то МНК-оценки коэффициентов (beta_{1}) и (beta_{2}) состоятельны и асимптотически нормальны.

Доказательство этой теоремы приводится в параграфах 6.3 и 6.4. В первом из них доказывается состоятельность, а во втором — асимптотическая нормальность. Однако прежде, чем переходить к доказательству, обсудим значение теоремы для прикладных исследований. Забегая вперед, отметим, что оно велико.

Первый из результатов — состоятельность — даёт нам уверенность, что при достаточно слабых предположениях МНК будет обеспечивать верные ответы на интересующие нас вопросы о мире. Для получения этих ответов нужно лишь собрать достаточно много данных, чтобы асимптотические свойства были применимы. В практических исследованиях вполне хватает нескольких сотен точек (хотя, конечно, когда речь идет об асимптотических методах, то чем больше, тем лучше).

Второй результат — асимптотическая нормальность — позволяет нам легко тестировать гипотезы и строить доверительные интервалы, не делая жестких предположений о распределении отдельных случайных ошибок и отдельных переменных. Детали см. в параграфе 6.5. Это ценно потому, что на практике обычно нет никакой уверенности в том, что случайные ошибки модели распределены нормально. А ведь в рамках КЛМПР, как вы помните, мы были вынуждены делать такую предпосылку.

Отметим также, что в рамках нашей новой модели, в отличие от КЛМПР, мы не требуем гомоскедастичности. Действительно, мы сделали предположение по поводу того, что константой должно быть условное математическое ожидание случайной ошибки (Eleft( varepsilon_{i} middle| x_{i} right)), однако по поводу условной дисперсии случайной ошибки (text{var}(varepsilon_{i}|x_{i})) мы никаких предпосылок не делали. Следовательно, эта величина может меняться при изменении (x_{i}), то есть в модели может наблюдаться гетероскедастичность (в таком случае её также называют условной гетероскедастичностью).

Аналогичный набор предпосылок и аналогичная теорема могут быть, разумеется, сформулированы и для множественной регрессии:

Предпосылки линейной модели со стохастическими регрессорами (случай множественной регрессии):

-

Модель линейна по параметрам:

(y_{i} = beta_{1} + beta_{2}*x_{i}^{(2)} + beta_{3}*x_{i}^{(3)} + ldots + beta_{k}*x_{i}^{(k)} + varepsilon_{i}, i = 1,2,ldots, n.)

-

Наблюдения (left{ left( x_{i}^{(2)},ldots,x_{i}^{(k)},y_{i} right),text{~i} = 1,ldots,n right}) независимы и одинаково распределены.

-

(x_{i}^{(2)},ldots,x_{i}^{(k)},y_{i}) имеют ненулевые конечные четвертые моменты.

-

Случайные ошибки имеют нулевое условное математическое ожидание при заданных значениях регрессоров:

(Eleft( varepsilon_{i} middle| x_{i}^{(2)},ldots,x_{i}^{(k)} right) = 0, i = 1,ldots,n)

-

В модели с вероятностью единица отсутствует чистая мультиколлинеарность.

Теорема о состоятельности и асимптотической нормальности МНК-оценок (случай множественной регрессии). Если предпосылки №1–5 выполнены, то МНК-оценки коэффициентов модели множественной регрессии состоятельны и асимптотически нормальны.

Легко видеть, что набор предпосылок полностью идентичен случаю парной регрессии за одним исключением: нам пришлось добавить требование отсутствия мультиколлинеарности. Как мы знаем, при его нарушении МНК-оценки в модели множественной регрессии в принципе невозможно определить однозначно. Упоминание вероятности в формулировке предпосылки связано с тем, что теперь регрессоры являются стохастическими, то есть при каждой реализации их набор может отличаться.

Таблица 6.1. Сопоставление различных регрессионных моделей

| Название модели | Классическая линейная модель множественной регрессии | Обобщенная линейная модель множественной регрессии | Линейная модель со стохастическими регрессорами |

|---|---|---|---|

| Где эта модель описана |

В параграфе 3.2 (а также для случая парной регрессии в параграфе 2.3) |

В параграфе 5.5 | В параграфе 6.2 |

| Предположение о детерминированности (неслучайности) регрессоров | Требуется | Требуется | Не требуется |

| Предположение о нормальности случайных ошибок | Требуется для тестирования гипотез | Требуется для тестирования гипотез | Не требуется |

| Предположение об отсутствии гетероскедастичности | Требуется | Не требуется | Не требуется |

В таблице 6.1 содержится сопоставление предпосылок трёх основных моделей, в условиях которых мы исследуем свойства МНК-оценок. Из неё легко видеть, что предпосылки нашей новой модели, действительно, являются сравнительно более мягкими, что делает её максимально реалистичной моделью для практической работы с пространственными данными.

-

Исключение составляет специфический класс моделей пространственной автокорреляции, которые обычно рассматриваются отдельно.↩︎

-

Пример такой ситуации приведен далее в лирическом отступлении о неслучайных и случайных регрессорах.↩︎

-

Макроэкономист узнает в такой спецификации одну из возможных версий современной кривой Филлипса с адаптивными инфляционными ожиданиями. Однако даже человек, незнакомый с макроэкономическими моделями, наверняка согласится с тем, что если инфляция была высока в прошлом месяце, то и в этом она тоже наверняка будет высокой. Иными словами, текущая инфляция зависит от своих прошлых значений, что и отражено в данной модели.↩︎

Содержание:

Регрессионный анализ:

Регрессионным анализом называется раздел математической статистики, объединяющий практические методы исследования корреляционной зависимости между случайными величинами по результатам наблюдений над ними. Сюда включаются методы выбора модели изучаемой зависимости и оценки ее параметров, методы проверки статистических гипотез о зависимости.

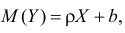

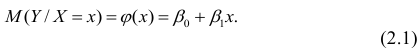

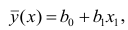

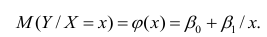

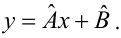

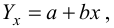

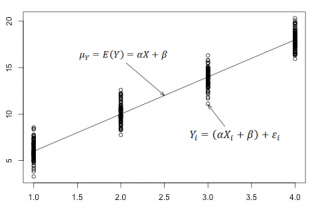

Пусть между случайными величинами X и Y существует линейная корреляционная зависимость. Это означает, что математическое ожидание Y линейно зависит от значений случайной величины X. График этой зависимости (линия регрессии Y на X) имеет уравнение

Линейная модель пригодна в качестве первого приближения и в случае нелинейной корреляции, если рассматривать небольшие интервалы возможных значений случайных величин.

Пусть параметры линии регрессии  неизвестны, неизвестна и величина коэффициента корреляции

неизвестны, неизвестна и величина коэффициента корреляции  Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:

Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:  Эти результаты могут служить источником информации о неизвестных значениях

Эти результаты могут служить источником информации о неизвестных значениях  надо только уметь эту информацию извлечь оттуда.

надо только уметь эту информацию извлечь оттуда.

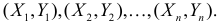

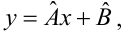

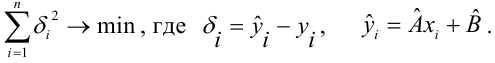

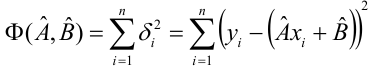

Неизвестная нам линия регрессии  как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для

как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для  можно принять те их значения, при которых имеет минимум функция

можно принять те их значения, при которых имеет минимум функция

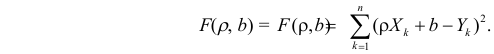

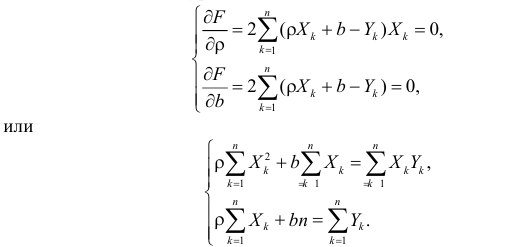

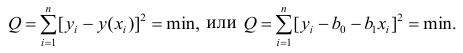

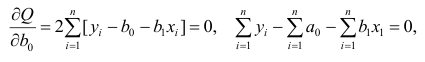

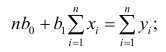

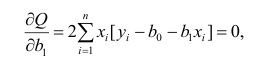

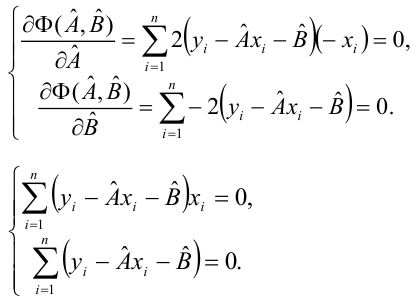

Такие значения  , согласно необходимым условиям экстремума, находятся из системы уравнений:

, согласно необходимым условиям экстремума, находятся из системы уравнений:

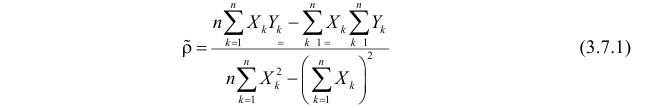

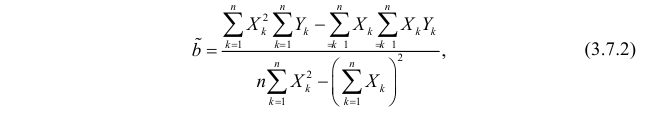

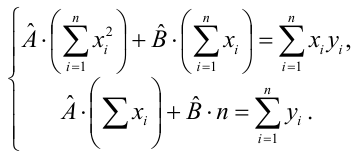

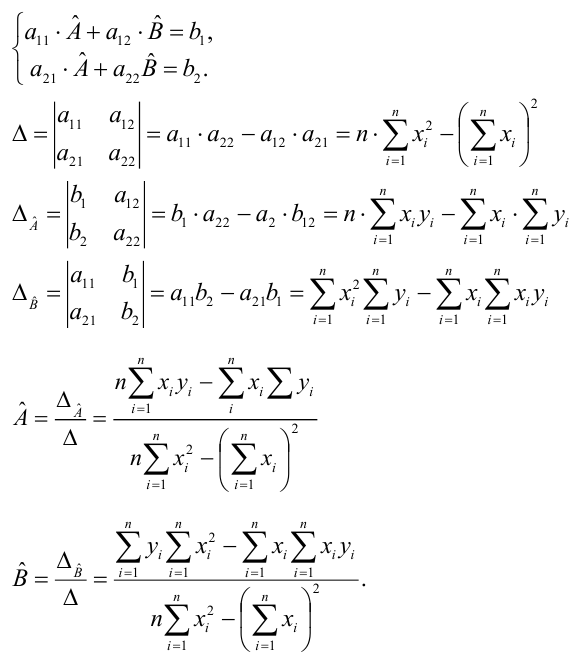

Решения этой системы уравнений дают оценки называемые оценками по методу наименьших квадратов.

и

Известно, что оценки по методу наименьших квадратов являются несмещенными и, более того, среди всех несмещенных оценок обладают наименьшей дисперсией. Для оценки коэффициента корреляции можно воспользоваться тем, что  где

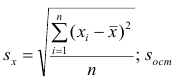

где  средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через

средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через  оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

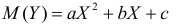

По методу наименьших квадратов можно находить оценки параметров линии регрессии и при нелинейной корреляции. Например, для линии регрессии вида  оценки параметров

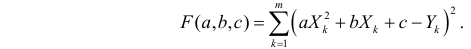

оценки параметров  находятся из условия минимума функции

находятся из условия минимума функции

Пример:

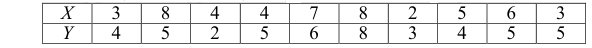

По данным наблюдений двух случайных величин найти коэффициент корреляции и уравнение линии регрессии Y на X

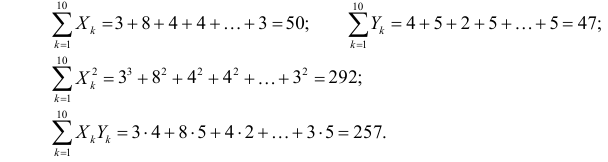

Решение. Вычислим величины, необходимые для использования формул (3.7.1)–(3.7.3):

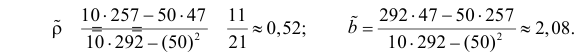

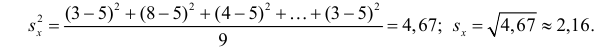

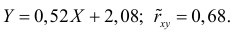

По формулам (3.7.1) и (3.7.2) получим

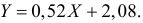

Итак, оценка линии регрессии имеет вид  Так как

Так как  то по формуле (3.1.3)

то по формуле (3.1.3)

Аналогично,  Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Ответ.

Пример:

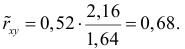

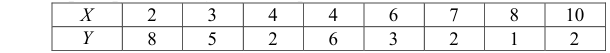

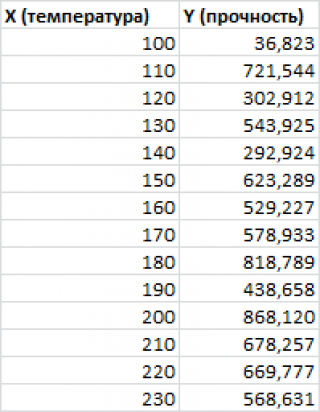

Получена выборка значений величин X и Y

Для представления зависимости между величинами предполагается использовать модель  Найти оценки параметров

Найти оценки параметров

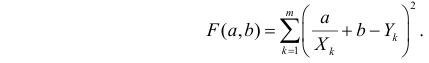

Решение. Рассмотрим сначала задачу оценки параметров этой модели в общем виде. Линия  играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

Необходимые условия экстремума приводят к системе из двух уравнений:

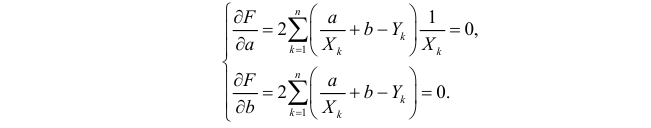

Откуда

Решения системы уравнений (3.7.4) и (3.7.5) и будут оценками по методу наименьших квадратов для параметров

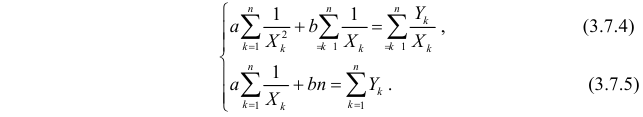

На основе опытных данных вычисляем:

В итоге получаем систему уравнений (?????) и (?????) в виде

Эта система имеет решения

Ответ.

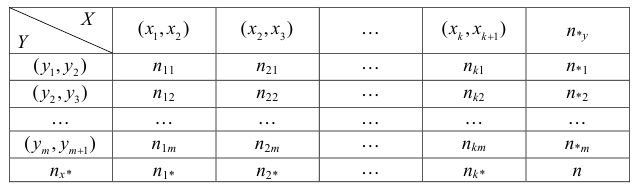

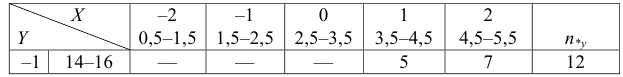

Если наблюдений много, то результаты их обычно группируют и представляют в виде корреляционной таблицы.

В этой таблице  равно числу наблюдений, для которых X находится в интервале

равно числу наблюдений, для которых X находится в интервале  а Y – в интервале

а Y – в интервале  Через

Через  обозначено число наблюдений, при которых

обозначено число наблюдений, при которых  а Y произвольно. Число наблюдений, при которых

а Y произвольно. Число наблюдений, при которых  а X произвольно, обозначено через

а X произвольно, обозначено через

Если величины дискретны, то вместо интервалов указывают отдельные значения этих величин. Для непрерывных случайных величин представителем каждого интервала считают его середину и полагают, что  и

и  наблюдались

наблюдались  раз.

раз.

При больших значениях X и Y можно для упрощения вычислений перенести начало координат и изменить масштаб по каждой из осей, а после завершения вычислений вернуться к старому масштабу.

Пример:

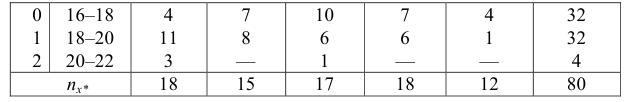

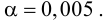

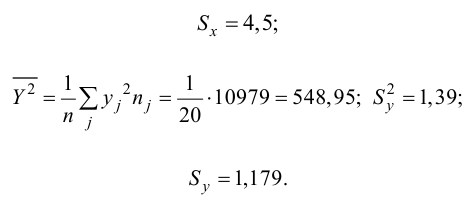

Проделано 80 наблюдений случайных величин X и Y. Результаты наблюдений представлены в виде таблицы. Найти линию регрессии Y на X. Оценить коэффициент корреляции.

Решение. Представителем каждого интервала будем считать его середину. Перенесем начало координат и изменим масштаб по каждой оси так, чтобы значения X и Y были удобны для вычислений. Для этого перейдем к новым переменным  Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

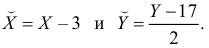

Чтобы иметь представление о виде линии регрессии, вычислим средние значения  при фиксированных значениях

при фиксированных значениях  :

:

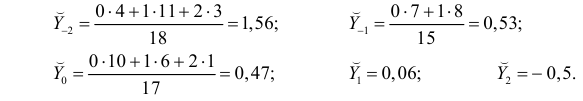

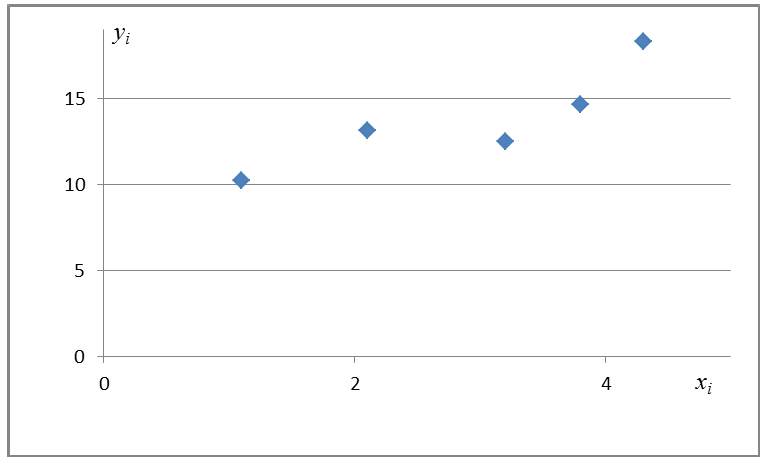

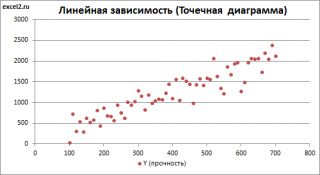

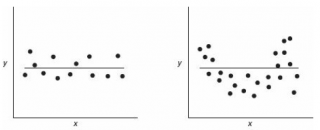

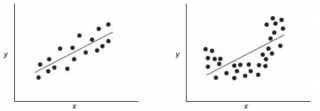

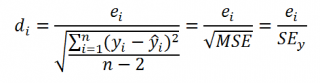

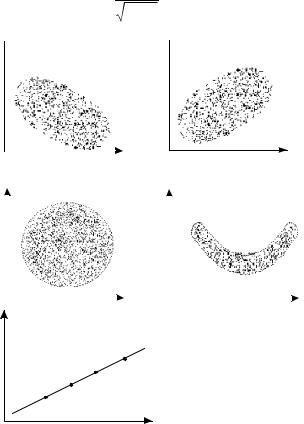

Нанесем эти значения на координатную плоскость, соединив для наглядности их отрезками прямой (рис. 3.7.1).

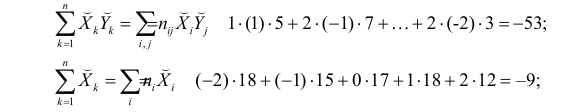

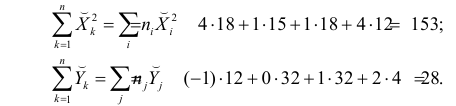

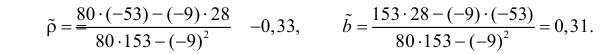

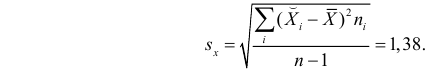

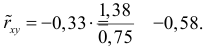

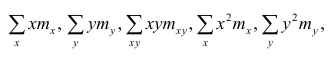

По виду полученной ломанной линии можно предположить, что линия регрессии Y на X является прямой. Оценим ее параметры. Для этого сначала вычислим с учетом группировки данных в таблице все величины, необходимые для использования формул (3.31–3.33):

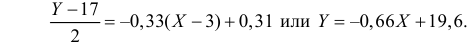

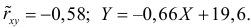

Тогда

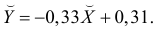

В новом масштабе оценка линии регрессии имеет вид  График этой прямой линии изображен на рис. 3.7.1.

График этой прямой линии изображен на рис. 3.7.1.

Для оценки  по корреляционной таблице можно воспользоваться формулой (3.1.3):

по корреляционной таблице можно воспользоваться формулой (3.1.3):

Подобным же образом можно оценить  величиной

величиной  Тогда оценкой коэффициента корреляции может служить величина

Тогда оценкой коэффициента корреляции может служить величина

Вернемся к старому масштабу:

Коэффициент корреляции пересчитывать не нужно, так как это величина безразмерная и от масштаба не зависит.

Ответ.

Пусть некоторые физические величины X и Y связаны неизвестной нам функциональной зависимостью  Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то

Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то  играет роль линии регрессии и все свойства линии регрессии приложимы к

играет роль линии регрессии и все свойства линии регрессии приложимы к  . В частности,

. В частности,  обычно находят по методу наименьших квадратов.

обычно находят по методу наименьших квадратов.

Регрессионный анализ

Основные положения регрессионного анализа:

Основная задача регрессионного анализа — изучение зависимости между результативным признаком Y и наблюдавшимся признаком X, оценка функции регрессий.

Предпосылки регрессионного анализа:

- Y — независимые случайные величины, имеющие постоянную дисперсию;

- X— величины наблюдаемого признака (величины не случайные);

- условное математическое ожидание

можно представить в виде

можно представить в виде

Выражение (2.1), как уже упоминалось в п. 1.2, называется функцией регрессии (или модельным уравнением регрессии) Y на X. Оценке в этом выражении подлежат параметры  называемые коэффициентами регрессии, а также

называемые коэффициентами регрессии, а также  — остаточная дисперсия.

— остаточная дисперсия.

Остаточной дисперсией называется та часть рассеивания результативного признака, которую нельзя объяснить действием наблюдаемого признака; Остаточная дисперсия может служить для оценки точности подбора вида функции регрессии (модельного уравнения регрессии), полноты набора признаков, включенных в анализ. Оценки параметров функции регрессии находят, используя метод наименьших квадратов.

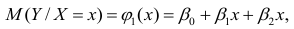

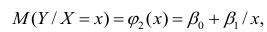

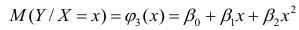

В данном вопросе рассмотрен линейный регрессионный анализ. Линейным он называется потому, что изучаем лишь те виды зависимостей которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

линейны относительно параметров

линейны относительно параметров

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости  выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

Важное место в линейном регрессионном анализе занимает так называемая «нормальная регрессия». Она имеет место, если сделать предположения относительно закона распределения случайной величины Y. Предпосылки «нормальной регрессии»:

- Y — независимые случайные величины, имеющие постоянную дисперсию и распределенные по нормальному закону;

- X— величины наблюдаемого признака (величины не случайные);

- условное математическое ожидание

можно представить в виде (2.1).

можно представить в виде (2.1).

В этом случае оценки коэффициентов регрессии — несмещённые с минимальной дисперсией и нормальным законом распределения. Из этого положения следует что при «нормальной регрессии» имеется возможность оценить значимость оценок коэффициентов регрессии, а также построить доверительный интервал для коэффициентов регрессии и условного математического ожидания M(YX=x).

Линейная регрессия

Рассмотрим простейший случай регрессионного анализа — модель вида (2.1), когда зависимость  линейна и по оцениваемым параметрам, и

линейна и по оцениваемым параметрам, и

по переменным. Оценки параметров модели (2.1)  обозначил

обозначил  Оценку остаточной дисперсии

Оценку остаточной дисперсии  обозначим

обозначим  Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии

Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии  коэффициенты которого

коэффициенты которого  находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака

находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака от вычисленных по уравнению регрессии

от вычисленных по уравнению регрессии

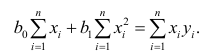

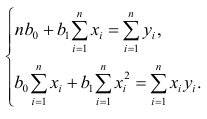

Составим систему нормальных уравнений: первое уравнение

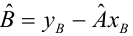

откуда

второе уравнение

откуда

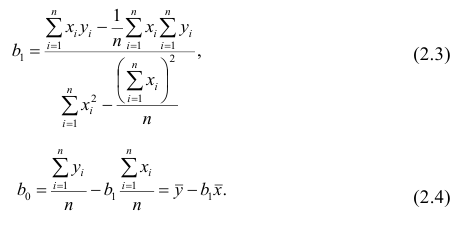

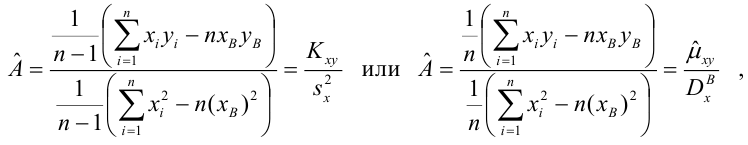

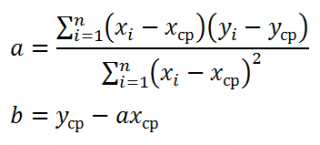

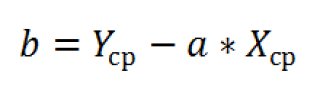

Итак,

Оценки, полученные по способу наименьших квадратов, обладают минимальной дисперсией в классе линейных оценок. Решая систему (2.2) относительно найдём оценки параметров

найдём оценки параметров

Остаётся получить оценку параметра  . Имеем

. Имеем

где т — количество наблюдений.

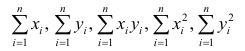

Еслит велико, то для упрощения расчётов наблюдавшиеся данные принята группировать, т.е. строить корреляционную таблицу. Пример построения такой таблицы приведен в п. 1.5. Формулы для нахождения коэффициентов регрессии по сгруппированным данным те же, что и для расчёта по несгруппированным данным, но суммы заменяют на

заменяют на

где  — частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

— частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

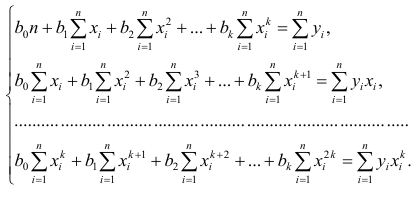

Нелинейная регрессия

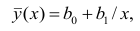

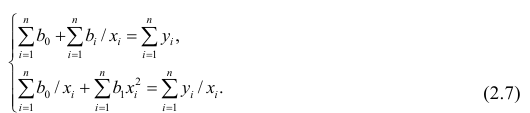

Рассмотрим случай, когда зависимость нелинейна по переменным х, например модель вида

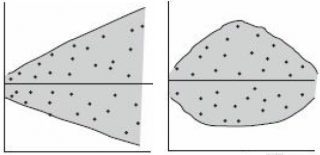

На рис. 2.1 изображено поле корреляции. Очевидно, что зависимость между Y и X нелинейная и её графическим изображением является не прямая, а кривая. Оценкой выражения (2.6) является уравнение регрессии

где  —оценки коэффициентов регрессии

—оценки коэффициентов регрессии

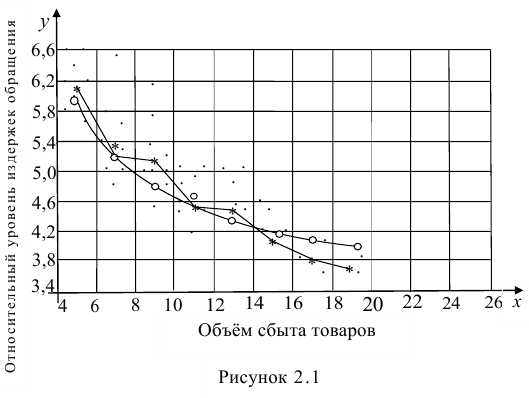

Принцип нахождения коэффициентов тот же — метод наименьших квадратов, т.е.

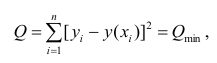

или

Дифференцируя последнее равенство по  и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

В общем случае нелинейной зависимости между переменными Y и X связь может выражаться многочленом k-й степени от x:

Коэффициенты регрессии определяют по принципу наименьших квадратов. Система нормальных уравнений имеет вид

Вычислив коэффициенты системы, её можно решить любым известным способом.

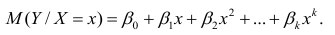

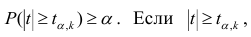

Оценка значимости коэффициентов регрессии. Интервальная оценка коэффициентов регрессии

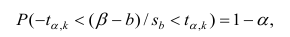

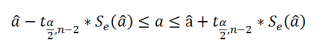

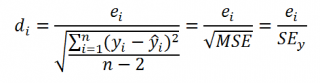

Проверить значимость оценок коэффициентов регрессии — значит установить, достаточна ли величина оценки для статистически обоснованного вывода о том, что коэффициент регрессии отличен от нуля. Для этого проверяют гипотезу о равенстве нулю коэффициента регрессии, соблюдая предпосылки «нормальной регрессии». В этом случае вычисляемая для проверки нулевой гипотезы  статистика

статистика

имеет распределение Стьюдента с к= n-2 степенями свободы (b — оценка коэффициента регрессии,  — оценка среднеквадратического отклонения

— оценка среднеквадратического отклонения

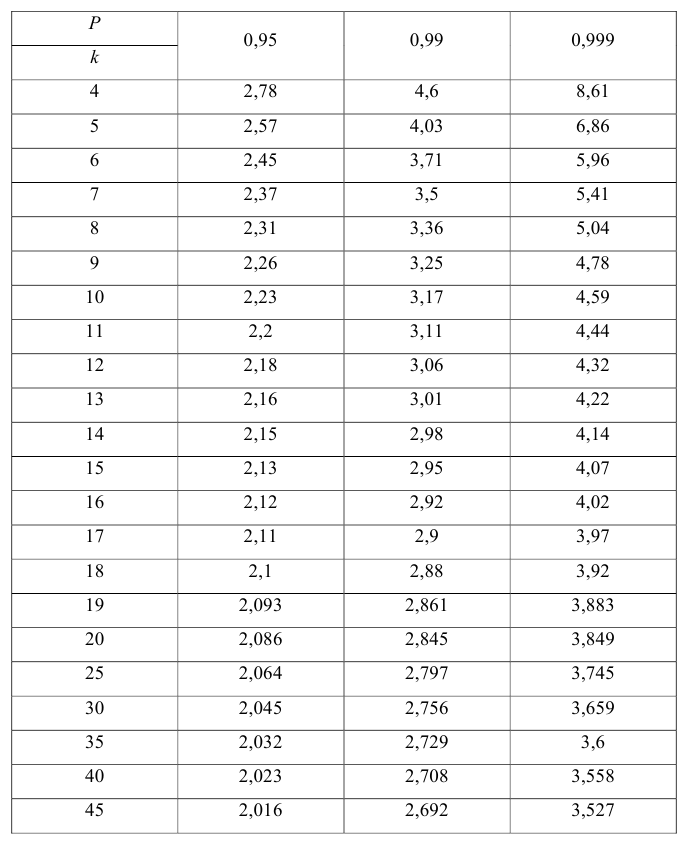

коэффициента регрессии, иначе стандартная ошибка оценки). По уровню значимости а и числу степеней свободы к находят по таблицам распределения Стьюдента (см. табл. 1 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При нет оснований отвергать нулевую гипотезу.

нет оснований отвергать нулевую гипотезу.

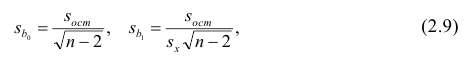

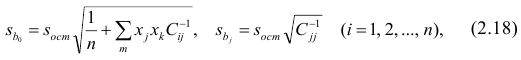

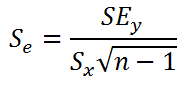

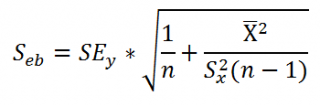

Оценки среднеквадратического отклонения коэффициентов регрессии вычисляют по следующим формулам:

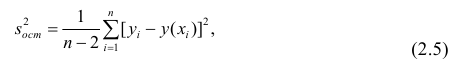

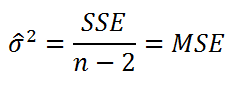

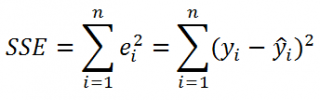

где  — оценка остаточной дисперсии, вычисляемая по

— оценка остаточной дисперсии, вычисляемая по

формуле (2.5).

Доверительный интервал для значимых параметров строят по обычной схеме. Из условия

где а — уровень значимости, находим

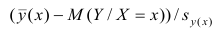

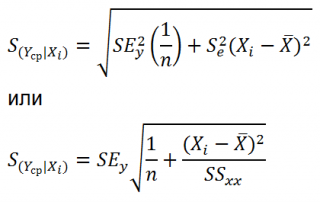

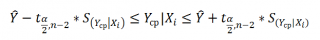

Интервальная оценка для условного математического ожидания

Линия регрессии характеризует изменение условного математического ожидания результативного признака от вариации остальных признаков.

Точечной оценкой условного математического ожидания  является условное среднее

является условное среднее  Кроме точечной оценки для

Кроме точечной оценки для  можно

можно

построить доверительный интервал в точке

Известно, что  имеет распределение

имеет распределение

Стьюдента с k=n—2 степенями свободы. Найдя оценку среднеквадратического отклонения для условного среднего, можно построить доверительный интервал для условного математического ожидания

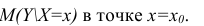

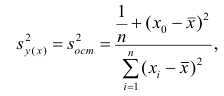

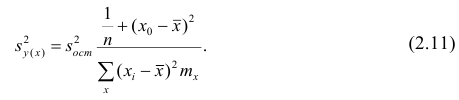

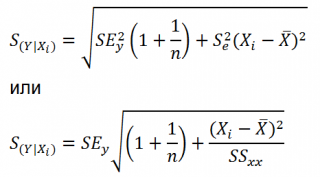

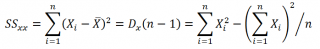

Оценку дисперсии условного среднего вычисляют по формуле

или для интервального ряда

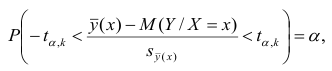

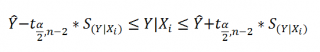

Доверительный интервал находят из условия

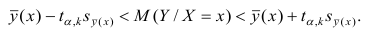

где а — уровень значимости. Отсюда

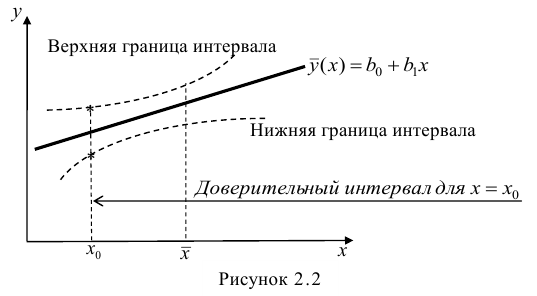

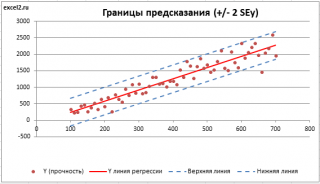

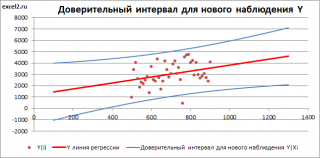

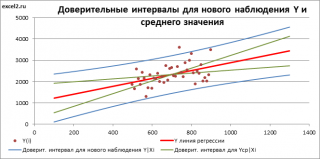

Доверительный интервал для условного математического ожидания можно изобразить графически (рис, 2.2).

Из рис. 2.2 видно, что в точке  границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

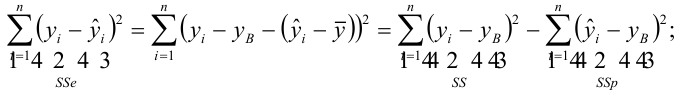

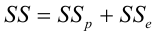

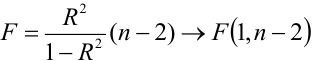

Проверка значимости уравнения регрессии

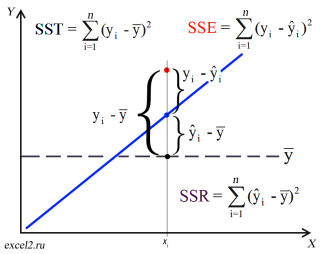

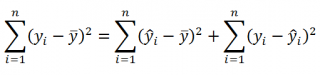

Оценить значимость уравнения регрессии — значит установить, соответствует ли математическая, модель, выражающая зависимость между Y и X, экспериментальным данным. Для оценки значимости в предпосылках «нормальной регрессии» проверяют гипотезу  Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением

Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением  — Общая сумма квадратов отклонений результативного признака

— Общая сумма квадратов отклонений результативного признака

разлагается на

разлагается на  (сумму, характеризующую влияние признака

(сумму, характеризующую влияние признака

X) и  (остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

(остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

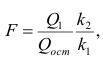

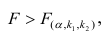

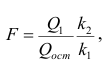

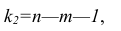

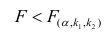

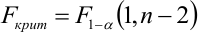

Для проверки нулевой гипотезы вычисляют статистику  которая имеет распределение Фишера-Снедекора с А

которая имеет распределение Фишера-Снедекора с А степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы

степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы  находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение

находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  . Если

. Если  нулевую гипотезу отвергают, уравнение считают значимым. Если

нулевую гипотезу отвергают, уравнение считают значимым. Если  то нет оснований отвергать нулевую гипотезу.

то нет оснований отвергать нулевую гипотезу.

Многомерный регрессионный анализ

В случае, если изменения результативного признака определяются действием совокупности других признаков, имеет место многомерный регрессионный анализ. Пусть результативный признак У, а независимые признаки  Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним

Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним  и постоянной дисперсией

и постоянной дисперсией  — линейно независимые векторы

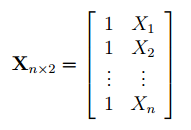

— линейно независимые векторы  . Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

. Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

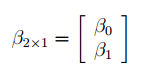

Оценке подлежат параметры  и остаточная дисперсия.

и остаточная дисперсия.

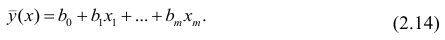

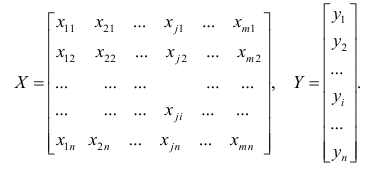

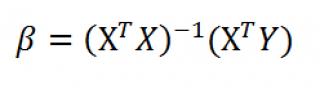

Заменив параметры их оценками, запишем уравнение регрессии

Коэффициенты в этом выражении находят методом наименьших квадратов.

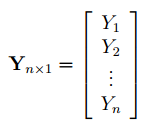

Исходными данными для вычисления коэффициентов  является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

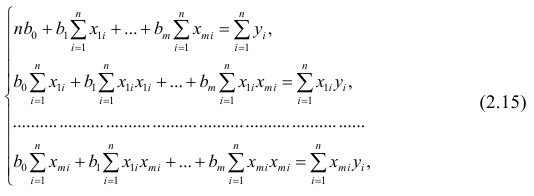

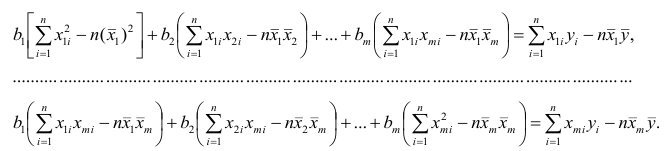

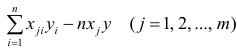

Как и в двумерном случае, составляют систему нормальных уравнений

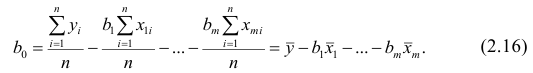

которую можно решить любым способом, известным из линейной алгебры. Рассмотрим один из них — способ обратной матрицы. Предварительно преобразуем систему уравнений. Выразим из первого уравнения значение  через остальные параметры:

через остальные параметры:

Подставим в остальные уравнения системы вместо  полученное выражение:

полученное выражение:

Пусть С — матрица коэффициентов при неизвестных параметрах

— матрица, обратная матрице С;

— матрица, обратная матрице С;  — элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы

— элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы — выражение

— выражение

. Тогда, используя формулы линейной алгебры,

. Тогда, используя формулы линейной алгебры,

запишем окончательные выражения для параметров:

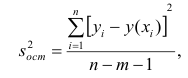

Оценкой остаточной дисперсии является

является

где  — измеренное значение результативного признака;

— измеренное значение результативного признака; значение результативного признака, вычисленное по уравнению регрессий.

значение результативного признака, вычисленное по уравнению регрессий.

Если выборка получена из нормально распределенной генеральной совокупности, то, аналогично изложенному в п. 2.4, можно проверить значимость оценок коэффициентов регрессии, только в данном случае статистику вычисляют для каждого j-го коэффициента регрессии

вычисляют для каждого j-го коэффициента регрессии

где  —элемент обратной матрицы, стоящий на пересечении i-й строки и j-

—элемент обратной матрицы, стоящий на пересечении i-й строки и j-

го столбца; —диагональный элемент обратной матрицы.

—диагональный элемент обратной матрицы.

При заданном уровне значимости а и числе степеней свободы к=n— m—1 по табл. 1 приложений находят критическое значение  Если

Если то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

Для значимых коэффициентов регрессии целесообразно построить доверительные интервалы по формуле (2.10). Для оценки значимости уравнения регрессии следует проверить нулевую гипотезу о том, что все коэффициенты регрессии (кроме свободного члена) равны нулю:

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики  , где

, где  — сумма квадратов, характеризующая влияние признаков X;

— сумма квадратов, характеризующая влияние признаков X;  — остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

— остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

Для уровня значимости а и числа степеней свободы

Для уровня значимости а и числа степеней свободы  по табл. 3 приложений находят критическое значение

по табл. 3 приложений находят критическое значение  Если

Если  то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При

то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При  нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

Факторный анализ

Основные положения. В последнее время всё более широкое распространение находит один из новых разделов многомерного статистического анализа — факторный анализ. Первоначально этот метод

разрабатывался для объяснения многообразия корреляций между исходными параметрами. Действительно, результатом корреляционного анализа является матрица коэффициентов корреляций. При малом числе параметров можно произвести визуальный анализ этой матрицы. С ростом числа параметра (10 и более) визуальный анализ не даёт положительных результатов. Оказалось, что всё многообразие корреляционных связей можно объяснить действием нескольких обобщённых факторов, являющихся функциями исследуемых параметров, причём сами обобщённые факторы при этом могут быть и неизвестны, однако их можно выразить через исследуемые параметры.

Один из основоположников факторного анализа Л. Терстоун приводит такой пример: несколько сотен мальчиков выполняют 20 разнообразных гимнастических упражнений. Каждое упражнение оценивают баллами. Можно рассчитать матрицу корреляций между 20 упражнениями. Это большая матрица размером 20><20. Изучая такую матрицу, трудно уловить закономерность связей между упражнениями. Нельзя ли объяснить скрытую в таблице закономерность действием каких-либо обобщённых факторов, которые в результате эксперимента непосредственно, не оценивались? Оказалось, что обо всех коэффициентах корреляции можно судить по трём обобщённым факторам, которые и определяют успех выполнения всех 20 гимнастических упражнений: чувство равновесия, усилие правого плеча, быстрота движения тела.

Дальнейшие разработки факторного анализа доказали, что этот метод может быть с успехом применён в задачах группировки и классификации объектов. Факторный анализ позволяет группировать объекты со сходными сочетаниями признаков и группировать признаки с общим характером изменения от объекта к объекту. Действительно, выделенные обобщённые факторы можно использовать как критерии при классификации мальчиков по способностям к отдельным группам гимнастических упражнений.

Методы факторного анализа находят применение в психологии и экономике, социологии и экономической географии. Факторы, выраженные через исходные параметры, как правило, легко интерпретировать как некоторые существенные внутренние характеристики объектов.

Факторный анализ может быть использован и как самостоятельный метод исследования, и вместе с другими методами многомерного анализа, например в сочетании с регрессионным анализом. В этом случае для набора зависимых переменных наводят обобщённые факторы, которые потом входят в регрессионный анализ в качестве переменных. Такой подход позволяет сократить число переменных в регрессионном анализе, устранить коррелированность переменных, уменьшить влияние ошибок и в случае ортогональности выделенных факторов значительно упростить оценку значимости переменных.

Представление, информации в факторном анализе

Для проведения факторного анализа информация должна быть представлена в виде двумерной таблицы чисел размерностью  аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений

аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений  столбцы — признакам

столбцы — признакам таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных

таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных  переходят к переменным

переходят к переменным  В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

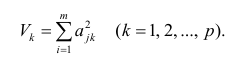

Основная модель факторного анализа. Основная модель факторного анализа имеет вид

где  -j-й признак (величина случайная);

-j-й признак (величина случайная);  — общие факторы (величины случайные, имеющие нормальный закон распределения);

— общие факторы (величины случайные, имеющие нормальный закон распределения);  — характерный фактор;

— характерный фактор;  — факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению);

— факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению); — нагрузка характерного фактора.

— нагрузка характерного фактора.

Модель предполагает, что каждый из j признаков, входящих в исследуемый набор и заданных в стандартной форме, может быть представлен в виде линейной комбинации небольшого числа общих факторов  и характерного фактора

и характерного фактора

Термин «общий фактор» подчёркивает, что каждый такой фактор имеет существенное значение для анализа всех признаков , т.е.

, т.е.

Термин «характерный фактор» показывает, что он относится только к данному j-му признаку. Это специфика признака, которая не может быть, выражена через факторы

Факторные нагрузки  . характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

. характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

Для j-го признака и i-го объекта модель (2.19) можно записать в. виде

где  значение k-го фактора для i-го объекта.

значение k-го фактора для i-го объекта.

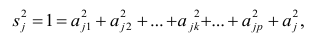

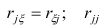

Дисперсию признака  можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность

можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность  и часть, обусловленную действием j-го характера фактора, характерность

и часть, обусловленную действием j-го характера фактора, характерность  Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака

Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака  Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Если общие и характерные факторы не коррелируют между собой, то дисперсию j-го признака можно представить в виде

где  —доля дисперсии признака

—доля дисперсии признака  приходящаяся на k-й фактор.

приходящаяся на k-й фактор.

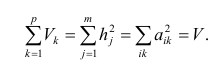

Полный вклад k-го фактора в суммарную дисперсию признаков

Вклад общих факторов в суммарную дисперсию

Факторное отображение

Используя модель (2.19), запишем выражения для каждого из параметров:

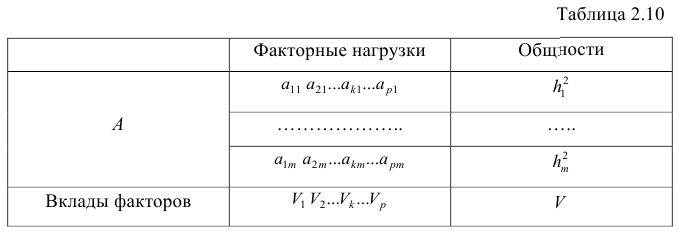

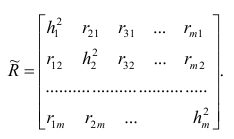

Коэффициенты системы (2,21) — факторные нагрузки — можно представить в виде матрицы, каждая строка которой соответствует параметру, а столбец — фактору.

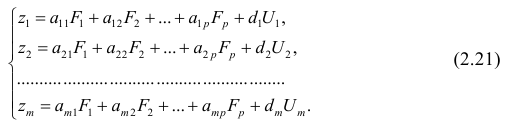

Факторный анализ позволяет получить не только матрицу отображений, но и коэффициенты корреляции между параметрами и

факторами, что является важной характеристикой качества факторной модели. Таблица таких коэффициентов корреляции называется факторной структурой или просто структурой.

Коэффициенты отображения можно выразить через выборочные парные коэффициенты корреляции. На этом основаны методы вычисления факторного отображения.

Рассмотрим связь между элементами структуры и коэффициентами отображения. Для этого, учитывая выражение (2.19) и определение выборочного коэффициента корреляции, умножим уравнения системы (2.21) на соответствующие факторы, произведём суммирование по всем n наблюдениям и, разделив на n, получим следующую систему уравнений:

где — выборочный коэффициент корреляции между j-м параметром и к-

— выборочный коэффициент корреляции между j-м параметром и к-

м фактором; — коэффициент корреляции между к-м и р-м факторами.

— коэффициент корреляции между к-м и р-м факторами.

Если предположить, что общие факторы между собой, не коррелированы, то уравнения (2.22) можно записать в виде

, т.е. коэффициенты отображения равны

, т.е. коэффициенты отображения равны

элементам структуры.

Введём понятие, остаточного коэффициента корреляции и остаточной корреляционной матрицы. Исходной информацией для построения факторной модели (2.19) служит матрица выборочных парных коэффициентов корреляции. Используя построенную факторную модель, можно снова вычислить коэффициенты корреляции между признаками и сравнись их с исходными Коэффициентами корреляции. Разница между ними и есть остаточный коэффициент корреляции.

В случае независимости факторов имеют место совсем простые выражения для вычисляемых коэффициентов корреляции между параметрами: для их вычисления достаточно взять сумму произведений коэффициентов отображения, соответствующих наблюдавшимся признакам:

где  —вычисленный по отображению коэффициент корреляции между j-м

—вычисленный по отображению коэффициент корреляции между j-м

и к-м признаком. Остаточный коэффициент корреляции

Матрица остаточных коэффициентов корреляции называется остаточной матрицей или матрицей остатков

где  — матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

— матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

Результаты факторного анализа удобно представить в виде табл. 2.10.

Здесь суммы квадратов нагрузок по строкам — общности параметров, а суммы квадратов нагрузок по столбцам — вклады факторов в суммарную дисперсию параметров. Имеет место соотношение

Определение факторных нагрузок

Матрицу факторных нагрузок можно получить различными способами. В настоящее время наибольшее распространение получил метод главных факторов. Этот метод основан на принципе последовательных приближений и позволяет достичь любой точности. Метод главных факторов предполагает использование ЭВМ. Существуют хорошие алгоритмы и программы, реализующие все вычислительные процедуры.

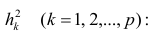

Введём понятие редуцированной корреляционной матрицы или просто редуцированной матрицы. Редуцированной называется матрица выборочных коэффициентов корреляции у которой на главной диагонали стоят значения общностей

у которой на главной диагонали стоят значения общностей  :

:

Редуцированная и полная матрицы связаны соотношением

где D — матрица характерностей.

Общности, как правило, неизвестны, и нахождение их в факторном анализе представляет серьезную проблему. Вначале определяют (хотя бы приближённо) число общих факторов, совокупность, которых может с достаточной точностью аппроксимировать все взаимосвязи выборочной корреляционной матрицы. Доказано, что число общих факторов (общностей) равно рангу редуцированной матрицы, а при известном ранге можно по выборочной корреляционной матрице найти оценки общностей. Числа общих факторов можно определить априори, исходя из физической природы эксперимента. Затем рассчитывают матрицу факторных нагрузок. Такая матрица, рассчитанная методом главных факторов, обладает одним интересным свойством: сумма произведений каждой пары её столбцов равна нулю, т.е. факторы попарно ортогональны.

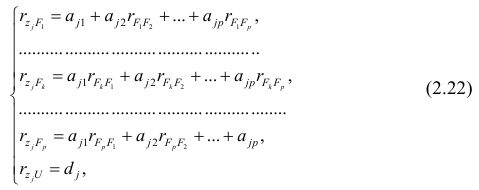

Сама процедура нахождения факторных нагрузок, т.е. матрицы А, состоит из нескольких шагов и заключается в следующем: на первом шаге ищут коэффициенты факторных нагрузок при первом факторе так, чтобы сумма вкладов данного фактора в суммарную общность была максимальной:

Максимум  должен быть найден при условии

должен быть найден при условии

где  —общность

—общность параметра

параметра

Затем рассчитывают матрицу коэффициентов корреляции с учётом только первого фактора Имея эту матрицу, получают первую матрицу остатков:

Имея эту матрицу, получают первую матрицу остатков:

На втором шаге определяют коэффициенты нагрузок при втором факторе так, чтобы сумма вкладов второго фактора в остаточную общность (т.е. полную общность без учёта той части, которая приходится на долю первого фактора) была максимальной. Сумма квадратов нагрузок при втором факторе

Максимум  находят из условия

находят из условия

где  — коэффициент корреляции из первой матрицы остатков;

— коэффициент корреляции из первой матрицы остатков;  — факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

— факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

Факторный анализ учитывает суммарную общность. Исходная суммарная общность Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на

Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на  — наперёд заданное малое число).

— наперёд заданное малое число).

Адекватность факторной модели оценивается по матрице остатков (если величины её коэффициентов малы, то модель считают адекватной).

Такова последовательность шагов для нахождения факторных нагрузок. Для нахождения максимума функции (2.24) при условии (2.25) используют метод множителей Лагранжа, который приводит к системе т уравнений относительно m неизвестных

Метод главных компонент

Разновидностью метода главных факторов является метод главных компонент или компонентный анализ, который реализует модель вида

где m — количество параметров (признаков).

Каждый из наблюдаемых, параметров линейно зависит от m не коррелированных между собой новых компонент (факторов)  По сравнению с моделью факторного анализа (2.19) в модели (2.28) отсутствует характерный фактор, т.е. считается, что вся вариация параметра может быть объяснена только действием общих или главных факторов. В случае компонентного анализа исходной является матрица коэффициентов корреляции, где на главной диагонали стоят единицы. Результатом компонентного анализа, так же как и факторного, является матрица факторных нагрузок. Поиск факторного решения — это ортогональное преобразование матрицы исходных переменных, в результате которого каждый параметр может быть представлен линейной комбинацией найденных m факторов, которые называют главными компонентами. Главные компоненты легко выражаются через наблюдённые параметры.

По сравнению с моделью факторного анализа (2.19) в модели (2.28) отсутствует характерный фактор, т.е. считается, что вся вариация параметра может быть объяснена только действием общих или главных факторов. В случае компонентного анализа исходной является матрица коэффициентов корреляции, где на главной диагонали стоят единицы. Результатом компонентного анализа, так же как и факторного, является матрица факторных нагрузок. Поиск факторного решения — это ортогональное преобразование матрицы исходных переменных, в результате которого каждый параметр может быть представлен линейной комбинацией найденных m факторов, которые называют главными компонентами. Главные компоненты легко выражаются через наблюдённые параметры.

Если для дальнейшего анализа оставить все найденные т компонент, то тем самым будет использована вся информация, заложенная в корреляционной матрице. Однако это неудобно и нецелесообразно. На практике обычно оставляют небольшое число компонент, причём количество их определяется долей суммарной дисперсии, учитываемой этими компонентами. Существуют различные критерии для оценки числа оставляемых компонент; чаще всего используют следующий простой критерий: оставляют столько компонент, чтобы суммарная дисперсия, учитываемая ими, составляла заранее установленное число процентов. Первая из компонент должна учитывать максимум суммарной дисперсии параметров; вторая — не коррелировать с первой и учитывать максимум оставшейся дисперсии и так до тех пор, пока вся дисперсия не будет учтена. Сумма учтённых всеми компонентами дисперсий равна сумме дисперсий исходных параметров. Математический аппарат компонентного анализа полностью совпадает с аппаратом метода главных факторов. Отличие только в исходной матрице корреляций.

Компонента (или фактор) через исходные переменные выражается следующим образом:

где  — элементы факторного решения:

— элементы факторного решения: — исходные переменные;

— исходные переменные;  .— k-е собственное значение; р — количество оставленных главных

.— k-е собственное значение; р — количество оставленных главных

компонент.

Для иллюстрации возможностей факторного анализа покажем, как, используя метод главных компонент, можно сократить размерность пространства независимых переменных, перейдя от взаимно коррелированных параметров к независимым факторам, число которых р

Следует особо остановиться на интерпретации результатов, т.е. на смысловой стороне факторного анализа. Собственно факторный анализ состоит из двух важных этапов; аппроксимации корреляционной матрицы и интерпретации результатов. Аппроксимировать корреляционную матрицу, т.е. объяснить корреляцию между параметрами действием каких-либо общих для них факторов, и выделить сильно коррелирующие группы параметров достаточно просто: из корреляционной матрицы одним из методов

факторного анализа непосредственно получают матрицу нагрузок — факторное решение, которое называют прямым факторным решением. Однако часто это решение не удовлетворяет исследователей. Они хотят интерпретировать фактор как скрытый, но существенный параметр, поведение которого определяет поведение некоторой своей группы наблюдаемых параметров, в то время как, поведение других параметров определяется поведением других факторов. Для этого у каждого параметра должна быть наибольшая по модулю факторная нагрузка с одним общим фактором. Прямое решение следует преобразовать, что равносильно повороту осей общих факторов. Такие преобразования называют вращениями, в итоге получают косвенное факторное решение, которое и является результатом факторного анализа.

Приложения

Значение t — распределения Стьюдента

Понятие о регрессионном анализе. Линейная выборочная регрессия. Метод наименьших квадратов (МНК)

Основные задачи регрессионного анализа:

- Вычисление выборочных коэффициентов регрессии

- Проверка значимости коэффициентов регрессии

- Проверка адекватности модели

- Выбор лучшей регрессии

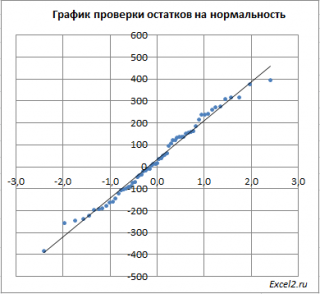

- Вычисление стандартных ошибок, анализ остатков

Построение простой регрессии по экспериментальным данным.

Предположим, что случайные величины  связаны линейной корреляционной зависимостью

связаны линейной корреляционной зависимостью  для отыскания которой проведено

для отыскания которой проведено  независимых измерений

независимых измерений

Диаграмма рассеяния (разброса, рассеивания)

— координаты экспериментальных точек.

— координаты экспериментальных точек.

Выборочное уравнение прямой линии регрессии  имеет вид

имеет вид

Задача: подобрать  таким образом, чтобы экспериментальные точки как можно ближе лежали к прямой

таким образом, чтобы экспериментальные точки как можно ближе лежали к прямой

Для того, что бы провести прямую  воспользуемся МНК. Потребуем,

воспользуемся МНК. Потребуем,

чтобы

Постулаты регрессионного анализа, которые должны выполняться при использовании МНК.

подчинены нормальному закону распределения.

подчинены нормальному закону распределения.- Дисперсия

постоянна и не зависит от номера измерения.

постоянна и не зависит от номера измерения. - Результаты наблюдений

в разных точках независимы.

в разных точках независимы. - Входные переменные

независимы, неслучайны и измеряются без ошибок.

независимы, неслучайны и измеряются без ошибок.

Введем функцию ошибок  и найдём её минимальное значение

и найдём её минимальное значение

Решив систему, получим искомые значения

является несмещенными оценками истинных значений коэффициентов

является несмещенными оценками истинных значений коэффициентов

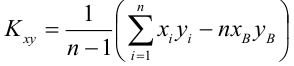

где

где

несмещенная оценка корреляционного момента (ковариации),

несмещенная оценка корреляционного момента (ковариации),

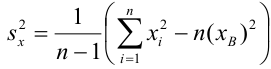

несмещенная оценка дисперсии

несмещенная оценка дисперсии

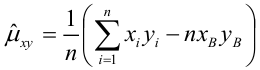

выборочная ковариация,

выборочная ковариация,

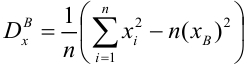

выборочная дисперсия

выборочная дисперсия

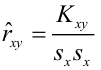

— выборочный коэффициент корреляции

— выборочный коэффициент корреляции

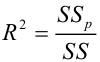

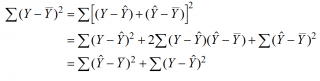

Коэффициент детерминации

— наблюдаемое экспериментальное значение

— наблюдаемое экспериментальное значение  при

при

— предсказанное значение

— предсказанное значение  удовлетворяющее уравнению регрессии

удовлетворяющее уравнению регрессии

— средневыборочное значение

— средневыборочное значение

— коэффициент детерминации, доля изменчивости

— коэффициент детерминации, доля изменчивости  объясняемая рассматриваемой регрессионной моделью. Для парной линейной регрессии

объясняемая рассматриваемой регрессионной моделью. Для парной линейной регрессии

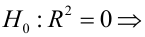

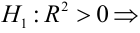

Коэффициент детерминации принимает значения от 0 до 1. Чем ближе значение коэффициента к 1, тем сильнее зависимость. При оценке регрессионных моделей это используется для доказательства адекватности модели (качества регрессии). Для приемлемых моделей предполагается, что коэффициент детерминации должен быть хотя бы не меньше 0,5 (в этом случае коэффициент множественной корреляции превышает по модулю 0,7). Модели с коэффициентом детерминации выше 0,8 можно признать достаточно хорошими (коэффициент корреляции превышает 0,9). Подтверждение адекватности модели проводится на основе дисперсионного анализа путем проверки гипотезы о значимости коэффициента детерминации.

регрессия незначима

регрессия незначима

регрессия значима

регрессия значима

— уровень значимости

— уровень значимости

— статистический критерий

— статистический критерий

Критическая область — правосторонняя;

Если  то нулевая гипотеза отвергается на заданном уровне значимости, следовательно, коэффициент детерминации значим, следовательно, регрессия адекватна.

то нулевая гипотеза отвергается на заданном уровне значимости, следовательно, коэффициент детерминации значим, следовательно, регрессия адекватна.

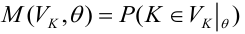

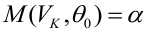

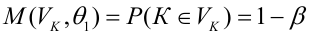

Мощность статистического критерия. Функция мощности

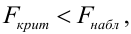

Определение. Мощностью критерия  называют вероятность попадания критерия в критическую область при условии, что справедлива конкурирующая гипотеза.

называют вероятность попадания критерия в критическую область при условии, что справедлива конкурирующая гипотеза.

Задача: построить критическую область таким образом, чтобы мощность критерия была максимальной.

Определение. Наилучшей критической областью (НКО) называют критическую область, которая обеспечивает минимальную ошибку второго рода

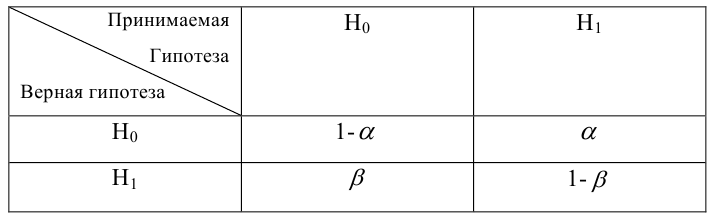

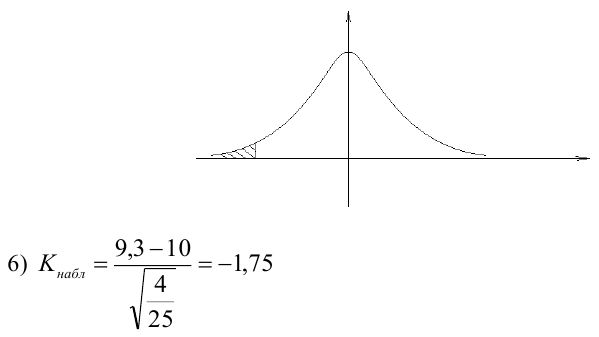

Пример:

По паспортным данным автомобиля расход топлива на 100 километров составляет 10 литров. В результате измерения конструкции двигателя ожидается, что расход топлива уменьшится. Для проверки были проведены испытания 25 автомобилей с модернизированным двигателем; выборочная средняя расхода топлива по результатам испытаний составила 9,3 литра. Предполагая, что выборка получена из нормально распределенной генеральной совокупности с математическим ожиданием  и дисперсией

и дисперсией  проверить гипотезу, утверждающую, что изменение конструкции двигателя не повлияло на расход топлива.

проверить гипотезу, утверждающую, что изменение конструкции двигателя не повлияло на расход топлива.

3) Уровень значимости

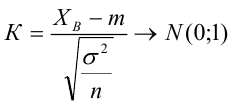

4) Статистический критерий

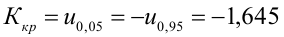

5) Критическая область — левосторонняя

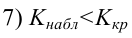

следовательно

следовательно  отвергается на уровне значимости

отвергается на уровне значимости

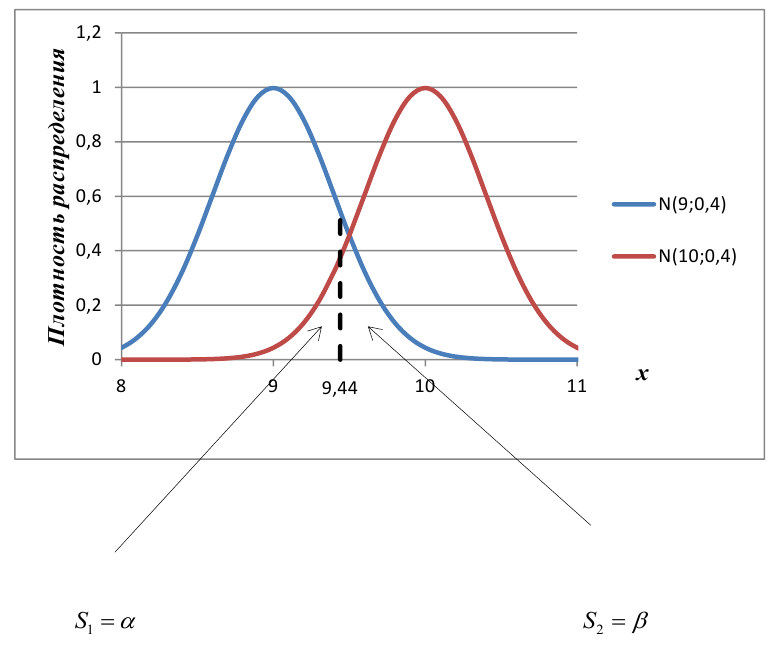

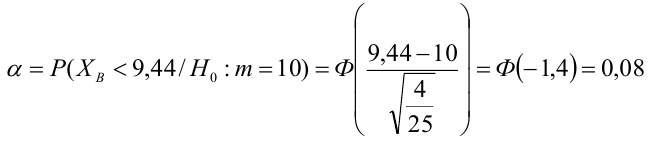

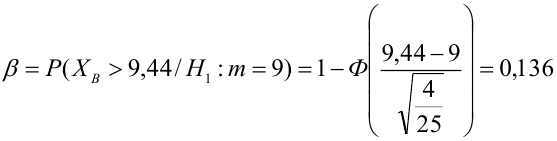

Пример:

В условиях примера 1 предположим, что наряду с  рассматривается конкурирующая гипотеза

рассматривается конкурирующая гипотеза  а критическая область задана неравенством

а критическая область задана неравенством  Найти вероятность ошибок I рода и II рода.

Найти вероятность ошибок I рода и II рода.

автомобилей имеют меньший расход топлива)

автомобилей имеют меньший расход топлива)

автомобилей, имеющих расход топлива 9л на 100 км, классифицируются как автомобили, имеющие расход 10 литров).

автомобилей, имеющих расход топлива 9л на 100 км, классифицируются как автомобили, имеющие расход 10 литров).

Определение. Пусть проверяется  — критическая область критерия с заданным уровнем значимости

— критическая область критерия с заданным уровнем значимости  Функцией мощности критерия

Функцией мощности критерия  называется вероятность отклонения

называется вероятность отклонения  как функция параметра

как функция параметра  т.е.

т.е.

— ошибка 1-ого рода

— ошибка 1-ого рода

— мощность критерия

— мощность критерия

Пример:

Построить график функции мощности из примера 2 для

попадает в критическую область.

попадает в критическую область.

Пример:

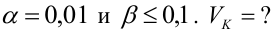

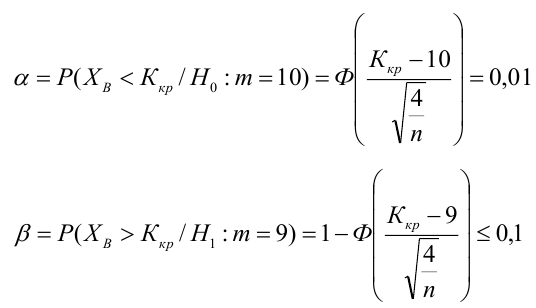

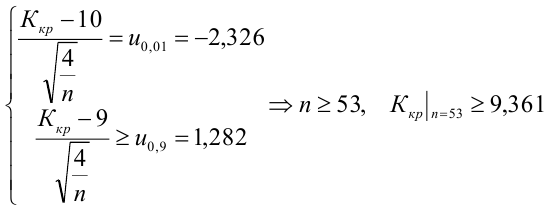

Какой минимальный объем выборки следует взять в условии примера 2 для того, чтобы обеспечить

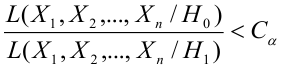

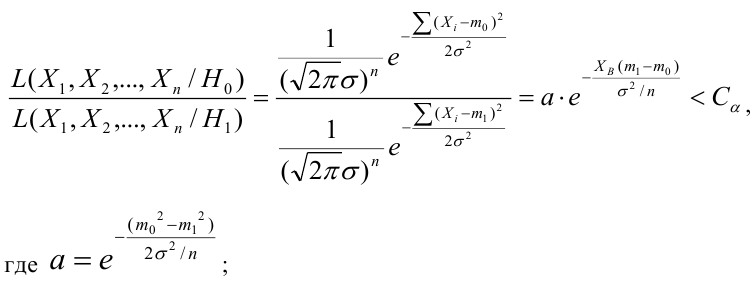

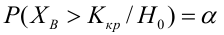

Лемма Неймана-Пирсона.

При проверке простой гипотезы  против простой альтернативной гипотезы

против простой альтернативной гипотезы  наилучшая критическая область (НКО) критерия заданного уровня значимости

наилучшая критическая область (НКО) критерия заданного уровня значимости  состоит из точек выборочного пространства (выборок объема

состоит из точек выборочного пространства (выборок объема  для которых справедливо неравенство:

для которых справедливо неравенство:

— константа, зависящая от

— константа, зависящая от

— элементы выборки;

— элементы выборки;

— функция правдоподобия при условии, что соответствующая гипотеза верна.

— функция правдоподобия при условии, что соответствующая гипотеза верна.

Пример:

Случайная величина  имеет нормальное распределение с параметрами

имеет нормальное распределение с параметрами  известно. Найти НКО для проверки

известно. Найти НКО для проверки  против

против  причем

причем

Решение:

Ошибка первого рода:

НКО:

Пример:

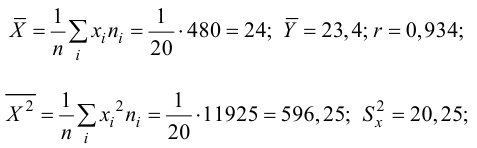

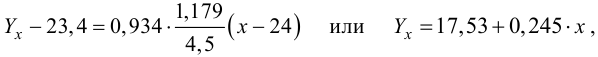

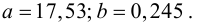

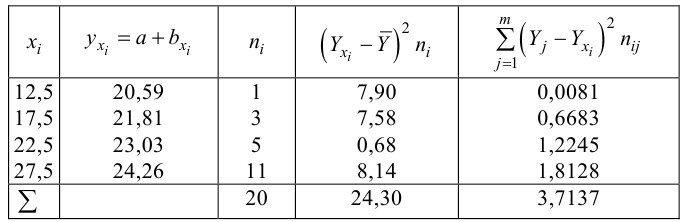

Для зависимости заданной корреляционной табл. 13, найти оценки параметров

заданной корреляционной табл. 13, найти оценки параметров  уравнения линейной регрессии

уравнения линейной регрессии  остаточную дисперсию; выяснить значимость уравнения регрессии при

остаточную дисперсию; выяснить значимость уравнения регрессии при

Решение. Воспользуемся предыдущими результатами

Согласно формуле (24), уравнение регрессии будет иметь вид  тогда

тогда

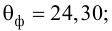

Для выяснения значимости уравнения регрессии вычислим суммы  Составим расчетную таблицу:

Составим расчетную таблицу:

Из (27) и (28) по данным таблицы получим

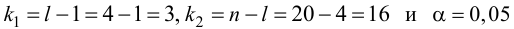

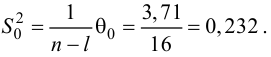

по табл. П7 находим

по табл. П7 находим

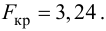

Вычислим статистику

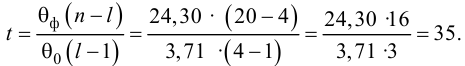

Так как  то уравнение регрессии значимо. Остаточная дисперсия равна

то уравнение регрессии значимо. Остаточная дисперсия равна

- Корреляционный анализ

- Статистические решающие функции

- Случайные процессы

- Выборочный метод

- Проверка гипотезы о равенстве вероятностей

- Доверительный интервал для математического ожидания

- Доверительный интервал для дисперсии

- Проверка статистических гипотез

Проверка адекватности регрессионной модели и значимости показателей тесноты корреляционной связи

Информация, содержащаяся в эмпирических данных, извлекается с большей полнотой, чем полученная традиционными методами описательной статистики, и, что самое важное, может быть представлена с разных точек зрения. Тем самым перед исследователем открывается обширная область для теоретических выводов, формирования новых представлений и гипотез.

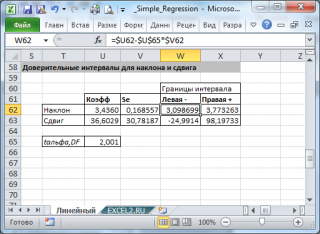

Особое внимание необходимо обратить на интерпретацию и оценку параметров уравнения. Параметры уравнения регрессии следует проверить на их значимость.

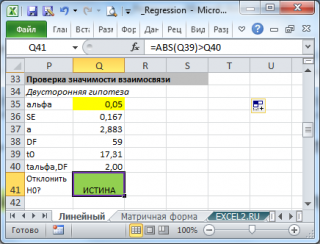

Для того чтобы получить оценку значимости коэффициентов регрессии при линейной зависимости у от х, и х2, используют t-кри- терий Стьюдента.

Значимость коэффициентов линейного уравнения регрессии а0 и ах оценивается с помощью ^-критерия Стьюдента (п /табл с уровнем значимости 0,05 и числом степеней свободы (п-т- 1).

Уравнение признают окончательным и применяют в качестве модели изучаемого показателя для последующего анализа в том случае, если в данном уравнении все коэффициенты регрессии значимы.

Показатели множественной регрессии и корреляции могут оказаться подверженными действию случайных факторов, поэтому только после проверки адекватности уравнения оно может быть пригодно.

Прежде всего, следует установить, соответствуют ли полученные данные тем гипотетическим представлениям, которые сложились в результате анализа, и показывают ли они причинно-следственные связи, которые ожидались. Для оценки адекватности модели можно вычислить отклонение теоретических данных от эмпирических, остаточную дисперсию, а также ошибку аппроксимации, которая определяется по формуле:

1) для однофакторной регрессионной модели:

2) для многофакторной регрессионной модели:

Общая оценка адекватности уравнения может быть получена с помощью дисперсионного F-критерия Фишера, на основании которого проводят проверку значимости регрессии:

1) для однофакторной регрессионной модели:

где т — число параметров в уравнении регрессии; п — число единиц наблюдения;

2) для многофакторной регрессионной модели:

Распределение Фишера [Рональд Фишер (1890—1968) — английский ученый] — двухпараметрическое распределение неотрицательной случайной величины, являющейся в частном случае, при т= 1, квадратом случайной величины, распределенной по Стьюденту. Для распределения Фишера имеются таблицы критических значений, зависящих от чисел степеней свободы т и п- т — I, при различных уровнях значимости.

Считается, что влияние факторного признака статистически существенно, для принятого уровня значимости 0,05 или 0,01, если Fp (расчетное) > FT (табличное), то влияние факторного признака считается существенным и данное уравнение регрессии будет статистически значимым.

FT зависит от трех параметров:

- 1) определяет достоверность выводов (называется уровнем значимости). Для социологических и экономических задач FT — 0,05 — определяет вероятность отвергнуть правильную гипотезу в 5 случаях из 100;

- 2) определяется количеством значений факторного признака

- (т-1);

- 3) определяется объемом выборки, уменьшенным на количество значений факторного признака (п — т).

FT определяется по таблице критических значений критерия Фишера.

Вернемся к примеру 10.1.

Проведем оценку адекватности регрессионной модели:

выражающей зависимость между производительностью труда и выполнением плана реализации, с помощью F-критерия Фишера:

Эмпирическое значение Fбольше табличного, следовательно, уравнение регрессии можно признать адекватным.

Оценим значимость параметров уравнения регрессии с помощью /-критерия Стьюдента:

Табличное значение /-критерия с уровнем значимости 0,05 и числом степеней свободы (п — 2) равно 2,307. Так как /эмп > /табл, то параметры уравнения регрессии признаются значимыми.

Значимость коэффициента корреляции оценим с помощью /-критерия Стьюдента по формуле

Эмпирическое значение / больше табличного, следовательно, коэффициент корреляции можно признать значимым.

Вычислим ошибку аппроксимации по формуле

На основании данных расчетов можно сделать заключение, что построенная регрессионная модель зависимости производительности труда от выполнения плана реализации может быть использована для анализа и прогноза.

Итак, в общем виде многообразие видов регрессионных моделей порождается формой связи изучаемых признаков (линейной или нелинейной) и представлениями о распределении остатков (ошибки, шума) модели. Кроме того, модели более высокого уровня включают не одно, а систему регрессионных уравнений. Поиск решений для множества моделей приводит исследователя к задаче преобразования этих моделей и получения форм с хорошо известными и реализуемыми алгоритмами оценивания, как, например, в описанном выше случае с нелинейными моделями. Реформирование моделей производится при помощи трансформационных изменений переменных (отклика предикторов) или введением особых ограничений на признаковые или параметрические значения.

Благодаря своей разработанности и гибкости метод регрессионного анализа в настоящее время широко распространен в аналитической практике. Он становится также неотъемлемой частью или обычным логическим дополнением многих методов многомерной статистики в факторном, дискриминантном анализе, методе канонических корреляций, многомерном шкалировании, кластерном анализе и т. д.

Дальнейшее развитие теории регрессионного анализа, прежде всего, видится в разработке новых нелинейных форм, позволяющих с высокой степенью адекватности описывать реальные процессы, расклассификации многочисленных регрессионных моделей и методов их решения, ориентированной на конкретные группы исследовательских задач, определении перспектив использования регрессионного анализа в сочетании с другими методами статистического анализа.

Пример 10.3. По территории регионов имеются следующие данные:

Прожиточный min в день одного трудоспособного, руб.

Среднедневная заработная плата, руб.

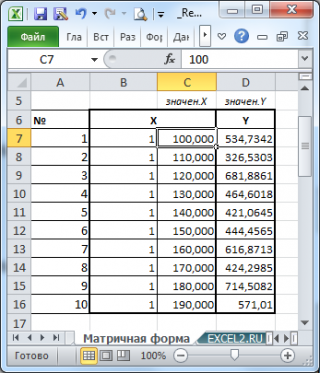

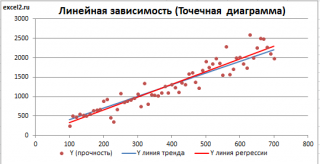

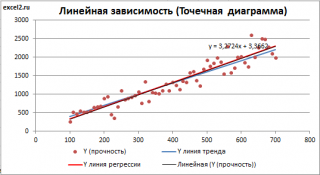

Простая линейная регрессия в EXCEL

history 26 января 2019 г.

- Группы статей

- Статистический анализ

Регрессия позволяет прогнозировать зависимую переменную на основании значений фактора. В MS EXCEL имеется множество функций, которые возвращают не только наклон и сдвиг линии регрессии, характеризующей линейную взаимосвязь между факторами, но и регрессионную статистику. Здесь рассмотрим простую линейную регрессию, т.е. прогнозирование на основе одного фактора.

Disclaimer : Данную статью не стоит рассматривать, как пересказ главы из учебника по статистике. Статья не обладает ни полнотой, ни строгостью изложения положений статистической науки. Эта статья – о применении MS EXCEL для целей Регрессионного анализа. Теоретические отступления приведены лишь из соображения логики изложения. Использование данной статьи для изучения Регрессии – плохая идея.