15. Оценка дисперсии случайной ошибки модели регрессии

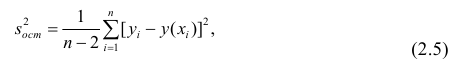

При проведении регрессионного анализа основная трудность заключается в том, что генеральная дисперсия случайной ошибки является неизвестной величиной, что вызывает необходимость в расчёте её несмещённой выборочной оценки.

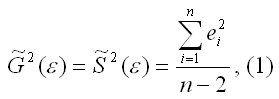

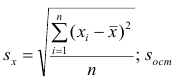

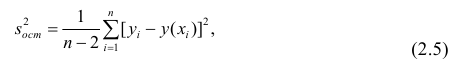

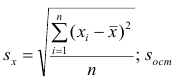

Несмещённой оценкой дисперсии (или исправленной дисперсией) случайной ошибки линейной модели парной регрессии называется величина, рассчитываемая по формуле:

где n – это объём выборочной совокупности;

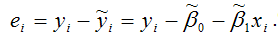

еi– остатки регрессионной модели:

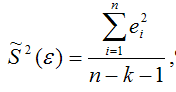

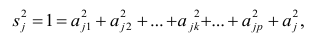

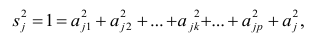

Для линейной модели множественной регрессии несмещённая оценка дисперсии случайной ошибки рассчитывается по формуле:

где k – число оцениваемых параметров модели регрессии.

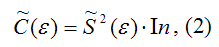

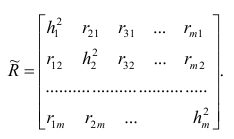

Оценка матрицы ковариаций случайных ошибок Cov(?) будет являться оценочная матрица ковариаций:

где In – единичная матрица.

Оценка дисперсии случайной ошибки модели регрессии распределена по ?2(хи-квадрат) закону распределения с (n-k-1) степенями свободы.

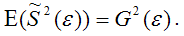

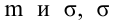

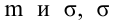

Для доказательства несмещённости оценки дисперсии случайной ошибки модели регрессии необходимо доказать справедливость равенства

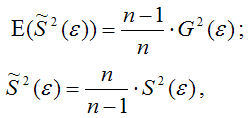

Доказательство. Примем без доказательства справедливость следующих равенств:

где G2(?) – генеральная дисперсия случайной ошибки;

S2(?) – выборочная дисперсия случайной ошибки;

– выборочная оценка дисперсии случайной ошибки.

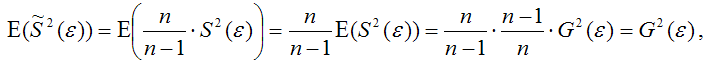

Тогда:

т. е.

что и требовалось доказать.

Следовательно, выборочная оценка дисперсии случайной ошибки

является несмещённой оценкой генеральной дисперсии случайной ошибки модели регрессии G2(?).

При условии извлечения из генеральной совокупности нескольких выборок одинакового объёма n и при одинаковых значениях объясняющих переменных х, наблюдаемые значения зависимой переменной у будут случайным образом колебаться за счёт случайного характера случайной компоненты ?. Отсюда можно сделать вывод, что будут варьироваться и зависеть от значений переменной у значения оценок коэффициентов регрессии и оценка дисперсии случайной ошибки модели регрессии.

Для иллюстрации данного утверждения докажем зависимость значения МНК-оценки

от величины случайной ошибки ?.

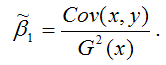

МНК-оценка коэффициента ?1 модели регрессии определяется по формуле:

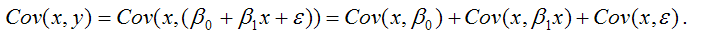

В связи с тем, что переменная у зависит от случайной компоненты ? (yi=?0+?1xi+?i), то ковариация между зависимой переменной у и независимой переменной х может быть представлена следующим образом:

Для дальнейших преобразования используются свойства ковариации:

1) ковариация между переменной х и константой С равна нулю: Cov(x,C)=0, C=const;

2) ковариация переменной х с самой собой равна дисперсии этой переменной: Cov(x,x)=G2(x).

Исходя из указанных свойств ковариации, справедливы следующие равенства:

Cov(x,?0)=0 (?0=const);

Cov(x, ?1x)= ?1*Cov(x,x)= ?1*G2(x).

Следовательно, ковариация между зависимой и независимой переменными Cov(x,y) может быть записана как:

Cov(x,y)= ?1G2(x)+Cov(x,?).

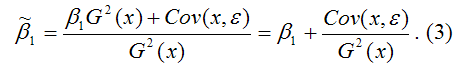

В результате МНК-оценка коэффициента ?1 модели регрессии примет вид:

Таким образом, МНК-оценка

может быть представлена как сумма двух компонент:

1) константы ?1, т. е. истинного значения коэффициента;

2) случайной ошибки Cov(x,?), вызывающей вариацию коэффициента модели регрессии.

Однако на практике подобное разложение МНК-оценки невозможно, потому что истинные значения коэффициентов модели регрессии и значения случайной ошибки являются неизвестными. Теоретически данное разложение можно использовать при изучении статистических свойств МНК-оценок.

Аналогично доказывается, что МНК-оценка

коэффициента модели регрессии и несмещённая оценка дисперсии случайной ошибки

могут быть представлены как сумма постоянной составляющей (константы) и случайной компоненты, зависящей от ошибки модели регрессии ?.

Данный текст является ознакомительным фрагментом.

Читайте также

11. Критерии оценки неизвестных коэффициентов модели регрессии

11. Критерии оценки неизвестных коэффициентов модели регрессии

В ходе регрессионного анализа была подобрана форма связи, которая наилучшим образом отражает зависимость результативной переменной у от факторной переменной х:y=f(x).Необходимо оценить неизвестные

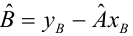

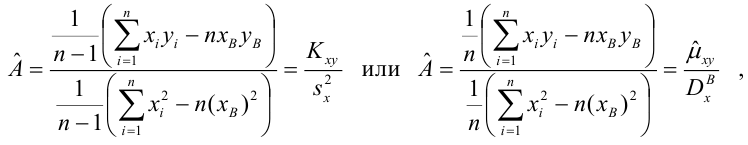

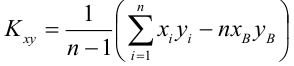

14. Оценка коэффициентов модели парной регрессии с помощью выборочного коэффициента регрессии

14. Оценка коэффициентов модели парной регрессии с помощью выборочного коэффициента регрессии

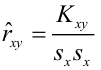

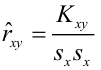

Помимо метода наименьших квадратов, с помощью которого в большинстве случаев определяются неизвестные параметры модели регрессии, в случае линейной модели парной регрессии

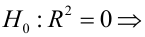

18. Характеристика качества модели регрессии

18. Характеристика качества модели регрессии

Качеством модели регрессии называется адекватность построенной модели исходным (наблюдаемым) данным.Для оценки качества модели регрессии используются специальные показатели.Качество линейной модели парной регрессии

22. Проверка гипотезы о значимости коэффициентов модели парной регрессии

22. Проверка гипотезы о значимости коэффициентов модели парной регрессии

Проверкой статистической гипотезы о значимости отдельных параметров модели называется проверка предположения о том, что данные параметры значимо отличаются от нуля.Необходимость проверки

25. Точечный и интервальный прогнозы для модели парной регрессии

25. Точечный и интервальный прогнозы для модели парной регрессии

Одна из задач эконометрического моделирования заключается в прогнозировании поведения исследуемого явления или процесса в будущем. В большинстве случаев данная задача решается на основе регрессионных

32. Построение частных коэффициентов корреляции для модели множественной регрессии через показатель остаточной дисперсии и коэффициент множественной детерминации

32. Построение частных коэффициентов корреляции для модели множественной регрессии через показатель остаточной дисперсии и коэффициент множественной детерминации

Помимо рекуррентных формул, которые используются для построения частных коэффициентов корреляции для

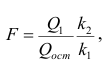

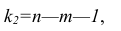

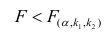

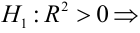

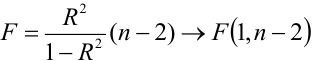

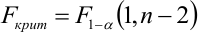

35. Проверка гипотезы о значимости коэффициентов регрессии и модели множественной регрессии в целом

35. Проверка гипотезы о значимости коэффициентов регрессии и модели множественной регрессии в целом

Проверка значимости коэффициентов регрессии означает проверку основной гипотезы об их значимом отличии от нуля.Основная гипотеза состоит в предположении о незначимости

39. Модели регрессии, нелинейные по факторным переменным

39. Модели регрессии, нелинейные по факторным переменным

При исследовании социально-экономических явлений и процессов далеко не все зависимости можно описать с помощью линейной связи. Поэтому в эконометрическом моделировании широко используется класс нелинейных

40. Модели регрессии, нелинейные по оцениваемым коэффициентам

40. Модели регрессии, нелинейные по оцениваемым коэффициентам

Нелинейными по оцениваемым параметрам моделями регрессииназываются модели, в которых результативная переменная yi нелинейно зависит от коэффициентов модели ?0…?n.К моделям регрессии, нелинейными по

41. Модели регрессии с точками разрыва

41. Модели регрессии с точками разрыва

Определение. Моделями регрессии с точками разрыва называются модели, которые нельзя привести к линейной форме, т. е. внутренне нелинейные модели регрессии.Модели регрессии делятся на два класса:1) кусочно-линейные модели регрессии;2)

44. Методы нелинейного оценивания коэффициентов модели регрессии

44. Методы нелинейного оценивания коэффициентов модели регрессии

Функцией потерь или ошибок называется функционал вида

Также в качестве функции потерь может быть использована сумма модулей отклонений наблюдаемых значений результативного признака у от теоретических

46. Проверка гипотезы о значимости нелинейной модели регрессии. Проверка гипотезы о линейной зависимости между переменными модели регрессии

46. Проверка гипотезы о значимости нелинейной модели регрессии. Проверка гипотезы о линейной зависимости между переменными модели регрессии

На нелинейные модели регрессии, которые являются внутренне линейными, т. е. сводимыми к линейному виду, распространяются все

57. Гетероскедастичность остатков модели регрессии

57. Гетероскедастичность остатков модели регрессии

Случайной ошибкой называется отклонение в линейной модели множественной регрессии:?i=yi–?0–?1x1i–…–?mxmiВ связи с тем, что величина случайной ошибки модели регрессии является неизвестной величиной, рассчитывается

60. Устранение гетероскедастичности остатков модели регрессии

60. Устранение гетероскедастичности остатков модели регрессии

Существует множество методов устранения гетероскедастичности остатков модели регрессии. Рассмотрим некоторые из них.Наиболее простым методом устранения гетероскедастичности остатков модели регрессии

63. Устранение автокорреляции остатков модели регрессии

63. Устранение автокорреляции остатков модели регрессии

В связи с тем, что наличие в модели регрессии автокорреляции между остатками модели может привести к негативным результатам всего процесса оценивания неизвестных коэффициентов модели, автокорреляция остатков

67. Модели регрессии с переменной структурой. Фиктивные переменные

67. Модели регрессии с переменной структурой. Фиктивные переменные

При построении модели регрессии может возникнуть ситуация, когда в неё необходимо включить не только количественные, но и качественные переменные (например, возраст, образование, пол, расовую

Гомоскедастичность (Homoscedasticity)

Гомоскедастичность – допущение линейной регрессии об «одинаковости» Дисперсии (Variance). Иными словами, разность между реальным Ypred и предсказанным Yactual значениями, скажем, Линейной регрессии (Linear Regresion) остается в определенном известном диапазоне, что позволяет в принципе использовать такую Модель (Model). В случае такого единообразия ошибок Наблюдения (Observation) с большими значениями будут иметь то же влияние на предсказывающий Алгоритм (Algorithm), что и наблюдения с меньшими значениями:

Линейная регрессия базируется на предположении, что для всех случаев ошибки будут одинаковыми и с очень малой дисперсией.

Пример. У нас есть две переменные – высота дерева навскидку и реальный его рост. Естественно, по мере увеличения оценочной высоты реальные тоже растут. Итак, мы подбираем модель линейной регрессии и видим, что ошибки имеют одинаковую дисперсию:

Прогнозы почти совпадают с линейной регрессией и имеют одинаковую известную дисперсию повсюду. Кроме того, если мы нанесем эти остатки на ось X, мы увидим их вдоль прямой линии, параллельной оси X. Это явный признак гомоскедастичности.

Когда это условие нарушается, в модели присутствует Гетероскедастичность (Heteroscedasticity). Предположим, что для деревьев с меньшей приблизительной высотой разность между прогнозируемым и реальным значением меньше, чем для высоких представителей флоры. По мере увеличения высоты дисперсия в прогнозах увеличивается, что приводит к увеличению значения ошибки или Остатка (Residual). Когда мы снова построим график остатков, то увидим типичную коническую кривую, которая четко указывает на наличие гетероскедастичности в модели:

Гетероскедастичность – это систематическое увеличение или уменьшение дисперсии остатков в диапазоне независимых переменных. Это проблема, потому нарушается базовое предположение о линейной регрессии: все ошибки должны иметь одинаковую дисперсию.

Как узнать, присутствует ли гетероскедастичность?

Проще говоря, самый простой способ узнать, присутствует ли гетероскедастичность, – построить график остатков. Если вы видите какую-либо закономерность, значит, есть гетероскедастичность. Обычно значения увеличиваются, образуя конусообразную кривую.

Причины гетероскедастичности

- Есть большая разница в переменной. Другими словами, когда наименьшее и наибольшее значения переменной слишком экстремальны. Это также могут быть Выбросы (Outlier).

- Мы выбираем неправильную модель. Если вы подгоните модель линейной регрессии к нелинейным данным, это приведет к гетероскедастичности.

- Когда масштаб значений в переменной некорректен (например, стоит рассматривать данные по сезонам, а не по дням).

- Когда для регрессии используется неправильное преобразование данных.

- Когда в данных присутствует Скошенность (Skewness).

Чистая и нечистая гетероскедастичности

Когда мы подбираем правильную модель (линейную или нелинейную) и все же есть видимый образец в остатках, это называется чистой гетероскедастичностью.

Однако, если мы подбираем неправильную модель, а затем наблюдаем закономерность в остатках, то это случай нечистой гетероскедастичности. В зависимости от типа гетероскедастичности необходимо принять меры для ее преодоления. Это зависит и от сферы, в которой мы работаем.

Эффекты гетероскедастичности в Машинном обучении

Как мы обсуждали ранее, модель линейной регрессии делает предположение о наличии гомоскедастичности в данных. Если это предположение неверно, мы не сможем доверять полученным результатам.

Наличие гетероскедастичности делает коэффициенты менее точными, и, следовательно, правильные находятся дальше от значения Генеральной совокупности (Population).

Как лечить гетероскедастичность?

Если мы обнаружили гетероскедастичность, есть несколько способов справиться с ней. Во-первых, давайте рассмотрим пример, в котором у нас есть две переменные: население города и количество заражений COVID-19.

В этом примере будет огромная разница в количестве заражений в крупных мегаполисах по сравнению с небольшими городами. Переменная «Количество инфекций» будет Целевой переменной (Target Variable), а «Население города» – Предиктором (Predictor Variable). Мы знаем, что в модели присутствует гетероскедастичность, и ее необходимо исправить.

В нашем случае, источник проблемы – это переменная с большой дисперсией (Население). Есть несколько способов справиться с подобным неоднообразием остатков, мы же рассмотрим три таких метода.

Управление переменными

Мы можем внести некоторые изменения в имеющиеся переменные, чтобы уменьшить влияние этой большой дисперсии на прогнозы модели. Один из способов сделать это – осуществить Нормализацию (Normalization), то есть привести значения Признака (Feature) к диапазону от 0 до 1. Это заставит признаки передавать немного другую информацию. От проблемы и данных будет зависеть, можно ли реализовать такой подход.

Этот метод требует минимальных модификаций и часто помогает решить проблему, а в некоторых случаях даже повысить производительность модели.

В нашем случае, мы изменим параметр «Количество инфекций» на «Скорость заражения». Это поможет уменьшить дисперсию, поскольку совершенно очевидно, что число инфекций в городах с большой численностью населения будет большим.

Взвешенная регрессия

Взвешенная регрессия – это модификация нормальной регрессии, при которой точкам данных присваиваются определенные Веса (Weights) в соответствии с их дисперсией. Те, у которых есть бо́льшая дисперсия, получают небольшой вес, а те, у которых меньшая дисперсия, получают бо́льший вес.

Таким образом, когда веса возведены в квадрат, это позволяет снизить влияние остатков с большой дисперсией.

Когда используются правильные веса, гетероскедастичность заменяется гомоскедастичностью. Но как найти правильный вес? Один из быстрых способов – использовать инверсию этой переменной в качестве веса (население города превратится в дробь 1/n, где n – число жителей).

Трансформация

Преобразование данных – последнее средство, поскольку при этом вы теряете интерпретируемость функции. Это означает, что вы больше не сможете легко объяснить, что показывает признак. Один из способов – взятие логарифма. Воспринять новые значения высоты дерева (например, 16 метров превратятся в ≈2.772) будет сложнее.

Контрольная работа: Контрольная работа по эконометрике вариант №8

Тема: Контрольная работа по эконометрике вариант №8

Тип: Контрольная работа | Размер: 29.98K | Скачано: 176 | Добавлен 07.04.16 в 21:06 | Рейтинг: 0 | Еще Контрольные работы

Вуз: Финансовый университет

Год и город: Владимир 2015

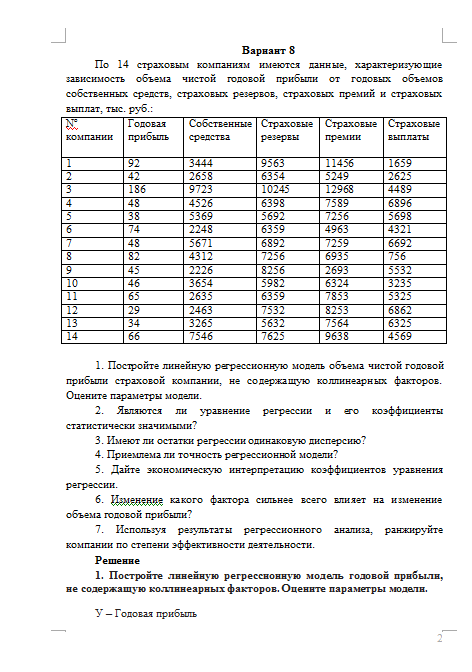

Вариант 8

По 14 страховым компаниям имеются данные, характеризующие зависимость объема чистой годовой прибыли от годовых объемов собственных средств, страховых резервов, страховых премий и страховых выплат, тыс. руб.:

1. Постройте линейную регрессионную модель объема чистой годовой прибыли страховой компании, не содержащую коллинеарных факторов. Оцените параметры модели.

2. Являются ли уравнение регрессии и его коэффициенты статистически значимыми?

3. Имеют ли остатки регрессии одинаковую дисперсию?

4. Приемлема ли точность регрессионной модели?

5. Дайте экономическую интерпретацию коэффициентов уравнения регрессии.

6. Изменение какого фактора сильнее всего влияет на изменение объема годовой прибыли?

7. Используя результаты регрессионного анализа, ранжируйте компании по степени эффективности деятельности.

Чтобы полностью ознакомиться с контрольной, скачайте файл!

Если вам нужна помощь в написании работы, то рекомендуем обратиться к профессионалам. Более 70 000 авторов готовы помочь вам прямо сейчас. Бесплатные корректировки и доработки. Узнайте стоимость своей работы

Понравилось? Нажмите на кнопочку ниже. Вам не сложно, а нам приятно).

Чтобы скачать бесплатно Контрольные работы на максимальной скорости, зарегистрируйтесь или авторизуйтесь на сайте.

Важно! Все представленные Контрольные работы для бесплатного скачивания предназначены для составления плана или основы собственных научных трудов.

Друзья! У вас есть уникальная возможность помочь таким же студентам как и вы! Если наш сайт помог вам найти нужную работу, то вы, безусловно, понимаете как добавленная вами работа может облегчить труд другим.

Если Контрольная работа, по Вашему мнению, плохого качества, или эту работу Вы уже встречали, сообщите об этом нам.

Добавление отзыва к работе

Добавить отзыв могут только зарегистрированные пользователи.

Ответы на тесты по эконометрике

Q=………..min соответствует методу наименьших квадратов

Автокорреляция — это корреляционная зависимость уровней ряда от предыдущих значений.

Автокорреляция имеется когда каждое следующее значение остатков

Аддитивная модель временного ряда имеет вид: Y=T+S+E

Атрибутивная переменная может употребляться, когда: независимая переменная качественна;

В каких пределах изменяется коэффициент детерминанта: от 0 до 1.

В каком случае модель считается адекватной Fрасч>Fтабл

В каком случае рекомендуется применять для моделирования показателей с увелич. ростом параболу если относительная величина…неограниченно

В результате автокорреляции имеем неэффективные оценки параметров

В хорошо подобранной модели остатки должны иметь нормальный закон

В эконометрическом анализе Xj рассматриваются как случайные величины

Величина доверительного интервала позволяет установить предположение о том, что: интервал содержит оценку параметра неизвестного.

Величина рассчитанная по формуле r=…является оценкой парного коэф. Корреляции

Внутренне нелинейная регрессия — это истинно нелинейная регрессия, которая не может быть приведена к линейной регрессии преобразованием переменных и введением новых переменных.

Временной ряд — это последовательность значений признака (результативного переменного), принимаемых в течение последовательных моментов времени или периодов.

Выберете авторегрессионную модель Уt=a+b0x1+Ɣyt-1+ƹt

Выберете модель с лагами Уt= a+b0x1…….(самая длинная формула)

Выборочное значение Rxy не > 1, |R|

Выборочный коэффициент корреляции r по абсолютной величине не превосходит единицы

Гетероскедастичность — нарушение постоянства дисперсии для всех наблюдений.

Гетероскедастичность присутствует когда: дисперсия случайных остатков не постоянна

Гетероскидастичность – это когда дисперсия остатков различна

Гипотеза об отсутствии автокорреляции остатков доказана, если Dтабл2…

Гомоскедастичность — постоянство дисперсии для всех наблюдений, или одинаковость дисперсии каждого отклонения (остатка) для всех значений факторных переменных.

Гомоскидастичность – это когда дисперсия остатков постоянна и одинакова для всех … наблюдений.

Дисперсия — показатель вариации.

Для определения параметров неиденцифицированной модели применяется.: не один из сущ. методов применить нельзя

Для определения параметров сверх иденцифицированной модели примен.: применяется. 2-х шаговый МНК

Для определения параметров структурную форму модели необходимо преобразовать в приведенную форму модели

Для определения параметров точно идентифицируемой модели: применяется косвенный МНК;

Для оценки … изменения y от x вводится: коэффициент эластичности:

Для парной регрессии ơ²b равно ….(xi-x¯)²)

Для проверки значимости отдельных параметров регрессии используется: t-тест.

Для регрессии y=a+bx из n наблюдений интервал доверия (1-а)% для коэф. b составит b±t…….·ơb

Для регрессии из n наблюдений и m независимых переменных существует такая связь между R² и F..=[(n-m-1)/m]( R²/(1- R²)]

Доверительная вероятность – это вероятность того, что истинное значение результативного показателя попадёт в расчётный прогнозный интервал.

Допустим что для описания одного экономического процесса пригодны 2 модели. Обе адекватны по f критерию фишера. какой предоставить преимущество, у той у кот.: большее значения F критерия

Допустим, что зависимость расходов от дохода описывается функцией y=a+bx среднее значение у=2…равняется 9

Если Rxy положителен, то с ростом x увеличивается y.

Если в уравнении регрессии имеется несущественная переменная, то она обнаруживает себя по низкому значению T статистки

Если качественный фактор имеет 3 градации, то необходимое число фиктивных переменных 2

Если коэффициент корреляции положителен, то в линейной модели с ростом х увеличивается у

Если мы заинтересованы в использовании атрибутивных переменных для отображения эффекта разных месяцев мы должны использовать 11 атрибутивных методов

Если регрессионная модель имеет показательную зависимость, то метод МНК применим после приведения к линейному виду.

Зависимость между коэффициентом множественной детерминации (D) и корреляции (R) описывается следующим методом R=√D

Значимость уравнения регрессии — действительное наличие исследуемой зависимости, а не просто случайное совпадение факторов, имитирующее зависимость, которая фактически не существует.

Значимость уравнения регрессии в целом оценивают: -F-критерий Фишера

Значимость частных и парных коэф. корреляции поверен. с помощью: -t-критерия Стьюдента

Интеркорреляция и связанная с ней мультиколлинеарность — это приближающаяся к полной линейной зависимости тесная связь между факторами.

Какая статистическая характеристика выражается формулой R²=…коэффициент детерминации

Какая статистическая хар-ка выражена формулой : rxy=Ca(x;y) разделить на корень Var(x)*Var(y): коэффициент. корреляции

Какая функция используется при моделировании моделей с постоянным ростом степенная

Какие точки исключаются из временного ряда процедурой сглаживания и в начале, и в конце.

Какое из уравнений регрессии является степенным y=a˳aͯ¹a

Классический метод к оцениванию параметров регрессии основан на: – метод наименьших квадратов (МНК)

Количество степеней свободы для t статистики при проверки значимости параметров регрессии из 35 наблюдений и 3 независимых переменных 31;

Количество степеней свободы знаменателя F-статистики в регрессии из 50 наблюдений и 4 независимых переменных: 45

Компоненты вектора Ei имеют нормальный закон

Корреляция — стохастическая зависимость, являющаяся обобщением строго детерминированной функциональной зависимости посредством включения вероятностной (случайной) компоненты.

Коэффициент автокорреляции: характеризует тесноту линейной связи текущего и предстоящего уровней ряда

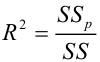

Коэффициент детерминации — показатель тесноты стохастической связи в общем случае нелинейной регрессии

Коэффициент детерминации – это величина, которая характеризует связь между зависимыми и независимыми переменными.

Коэффициент детерминации – это квадрат множественного коэффициента корреляции

Коэффициент детерминации – это: величина, которая характеризует связь между независимой и зависимой (зависящей) переменными;

Коэффициент детерминации R показывает долю вариаций зависимой переменной y, объяснимую влиянием факторов, включаемых в модель.

Коэффициент детерминации изменяется в пределах: – от 0 до 1

Коэффициент доверия — это коэффициент, который связывает линейной зависимостью предельную и среднюю ошибки, выясняет смысл предельной ошибки, характеризующей точность оценки, и является аргументом распределения (чаще всего, интеграла вероятностей). Именно эта вероятность и есть степень надежности оценки.

Коэффициент доверия (нормированное отклонение) — результат деления отклонения от среднего на стандартное отклонение, содержательно характеризует степень надежности (уверенности) полученной оценки.

Коэффициент корелляции Rxy используется для определения полноты связи X и Y.

Коэффициент корелляции меняется в пределах : от -1 до 1

Коэффициент корелляции равный 0 означает, что: –отсутствует линейная связь.

Коэффициент корелляции равный 1 означает, что: -существует функциональная зависимость.

Коэффициент корреляции используется для: определения тесноты связи между случайными величинами X и Y;

Коэффициент корреляции рассчитывается для измерения степени линейной взаимосвязи между двумя случайными переменными.

Коэффициент линейной корреляции — показатель тесноты стохастической связи между фактором и результатом в случае линейной регрессии.

Коэффициент регрессии — коэффициент при факторной переменной в модели линейной регрессии.

Коэффициент регрессии b показывает: на сколько единиц увеличивается y, если x увеличивается на 1.

Коэффициент регрессии изменяется в пределах: применяется любое значение ; от 0 до 1; от -1 до 1;

Коэффициент эластичности измеряется в: неизмеримая величина.

Критерий Дарвина-Чотсона применяется для: – отбора факторов в модель; или – определения автокорреляции в остатках

Критерий Стьюдента — проверка значимости отдельных коэффициентов регрессии и значимости коэффициента корреляции.

Критерий Фишера показывает статистическую значимость модели в целом на основе совокупной достоверности всех ее коэффициентов;

Лаговые переменные : – это переменные, относящиеся к предыдущим моментам времени; или -это значения зависим. перемен. за предшествующий период времени.

Лаговые переменные это значение зависимых переменных за предшествующий период времени

Модель в целом статистически значима, если Fрасч > Fтабл.

Модель идентифицирована, если: – число параметров структурной модели равно числу параметров приведён. формы модели.

Модель неидентифицирована, если: – число приведён. коэф . больше числа структурных коэф.

Модель сверхидентифицирована, если: число приведён. коэф. меньше числа структурных коэф

Мультиколлениарность возникает, когда: ошибочное включение в уравнение 2х или более линейно зависимых переменных; 2. две или более объясняющие переменные, в нормальной ситуации слабо коррелированные, становятся в конкретных условиях выборки сильно коррелированными; . в модель включается переменная, сильно коррелирующая с зависимой переменной.

Мультипликативная модель временного ряда имеет вид: – Y=T*S*E

Мультипликативная модель временного ряда строится, если: амплитуда сезонных колебаний возрастает или уменьшается

На основе поквартальных данных…значения 7-1 квартал, 9-2квартал и 11-3квартал …-5

Неправильный выбор функциональной формы или объясняющих переменных называется ошибками спецификации

Несмещённость оценки параметра регрессии, полученной по МНК, означает: – что она характеризуется наименьшей дисперсией.

Одной из проблем которая может возникнуть в многофакторной регрессии и никогда не бывает в парной регрессии, является корреляция между независимыми переменными

От чего зависит количество точек, исключаемых из временного ряда в результате сглаживания: от применяемого метода сглаживания.

Отметьте основные виды ошибок спецификации: отбрасывание значимой переменной; добавление незначимой переменной;

Оценки коэффициентов парной регрессии является несмещённым, если: математические ожидания остатков =0.

Оценки параметров парной линейной регрессии находятся по формуле b= Cov(x;y)/Var(x);a=y¯ bx¯

Оценки параметров регрессии являются несмещенными, если Математическое ожидание остатков равно 0

Оценки параметров регрессии являются состоятельными, если: -увеличивается точность оценки при n, т. е. при увеличении n вероятность оценки от истинного значения параметра стремится к 0.

Оценки парной регрессии явл. эффективными, если: оценка обладают наименьшей дисперсией по сравнению с другими оценками

При наличии гетероскедастичности следует применять: – обобщённый МНК

При проверке значимости одновременно всех параметров используется: -F-тест.

При проверке значимости одновременно всех параметров регрессии используется: F-тест.

Применим ли метод наименьших квадратов для расчетов параметров показательной зависимости применим после ее приведения

Применим ли метод наименьших квадратов(МНК) для расчёта параметров нелинейных моделей? применим после её специального приведения к линейному виду

С помощью какого критерия оценивается значимость коэффициента регрессии T стьюдента

С увеличением числа объясняющих переменных скоррестированный коэффициент детерминации: – увеличивается.

Связь между индексом множественной детерминации R² и скорректированным индексом множественной детерминации Ȓ² есть

Скорректиров. коэф. детерминации: – больше обычного коэф. детерминации

Стандартизованный коэффициент уравнения регрессии Ƀk показывает на сколько % изменится результирующий показатель у при изменении хi на 1%при неизмененном среднем уровне других факторов

Стандартный коэффициент уравнения регрессии: показывает на сколько 1 изменится y при изменении фактора xk на 1 при сохранении др.

Суть коэф. детерминации r 2 xy состоит в следующем: – характеризует долю дисперсии результативного признака y объясняем. регресс., в общей дисперсии результативного признака.

Табличное значение критерия Стьюдента зависит от уровня доверительной вероятности и от числа включённых факторов и от длины исходного ряда.(от принятого уровня значимости и от числа степеней свободы ( n – m -1))

Табличные значения Фишера (F) зависят от доверительной вероятности и от числа включённых факторов и от длины исходного ряда (от доверительной вероятности p и числа степеней свободы дисперсий f1 и f2)..

Уравнение в котором H число эндогенных переменных, D число отсутствующих экзогенных переменных, идентифицируемо если D+1=H

Уравнение в котором H число эндогенных переменных, D число отсутствующих экзогенных переменных, НЕидентифицируемо если D+1 H

Уравнение идентифицировано, если: – D+1=H

Уравнение неидентифицировано, если: – D+1 H

Фиктивные переменные – это: атрибутивные признаки (например, как профессия, пол, образование), которым придали цифровые метки;

Формула t= rxy….используется для проверки существенности коэффициента корреляции

Частный F-критерий: – оценивает значимость уравнения регрессии в целом

Число степеней свободы для факторной суммы квадратов в линейной модели множественной регрессии равно: m;

Что показывает коэффициент наклона – на сколько единиц изменится у, если х изменился на единицу,

Что показывает коэффициент. абсолютного роста на сколько единиц изменится у, если х изменился на единицу

Экзогенная переменная – это независимая переменная или фактор-Х.

Экзогенные переменные — это переменные, которые определяются вне системы и являются независимыми

Экзогенные переменные – это предопределенные переменные, влияющие на зависимые переменные (Эндогенные переменные), но не зависящие от них, обозначаются через х

Эластичность измеряется единица измерения фактора…показателя

Эластичность показывает на сколько % изменится редуктивный показатель y при изменении на 1% фактора xk .

Эндогенные переменные – это: зависимые переменные, число которых равно числу уравнений в системе и которые обозначаются через у

Определения

T-отношение (t-критерий) — отношение оценки коэффициента, полученной с помощью МНК, к величине стандартной ошибки оцениваемой величины.

Аддитивная модель временного ряда – это модель, в которой временной ряд представлен как сумма перечисленных компонент.

Критерий Фишера — способ статистической проверки значимости уравнения регрессии, при котором расчетное (фактическое) значение F-отношения сравнивается с его критическим (теоретическим) значением.

Линейная регрессия — это связь (регрессия), которая представлена уравнением прямой линии и выражает простейшую линейную зависимость.

Метод инструментальных переменных — это разновидность МНК. Используется для оценки параметров моделей, описываемых несколькими уравнениями. Главное свойство — частичная замена непригодной объясняющей переменной на такую переменную, которая некоррелированна со случайным членом. Эта замещающая переменная называется инструментальной и приводит к получению состоятельных оценок параметров.

Метод наименьших квадратов (МНК) — способ приближенного нахождения (оценивания) неизвестных коэффициентов (параметров) регрессии. Этот метод основан на требовании минимизации суммы квадратов отклонений значений результата, рассчитанных по уравнению регрессии, и истинных (наблюденных) значений результата.

Множественная линейная регрессия — это множественная регрессия, представляющая линейную связь по каждому фактору.

Множественная регрессия — регрессия с двумя и более факторными переменными.

Модель идентифицируемая — модель, в которой все структурные коэффициенты однозначно определяются по коэффициентам приведенной формы модели.

Модель рекурсивных уравнений — модель, которая содержит зависимые переменные (результативные) одних уравнений в роли фактора, оказываясь в правой части других уравнений.

Мультипликативная модель – модель, в которой временной ряд представлен как произведение перечисленных компонент.

Несмещенная оценка — оценка, среднее которой равно самой оцениваемой величине.

Нулевая гипотеза — предположение о том, что результат не зависит от фактора (коэффициент регрессии равен нулю).

Обобщенный метод наименьших квадратов (ОМНК) — метод, который не требует постоянства дисперсии (гомоскедастичности) остатков, но предполагает пропорциональность остатков общему множителю (дисперсии). Таким образом, это взвешенный МНК.

Объясненная дисперсия — показатель вариации результата, обусловленной регрессией.

Объясняемая (результативная) переменная — переменная, которая статистически зависит от факторной переменной, или объясняющей (регрессора).

Остаточная дисперсия — необъясненная дисперсия, которая показывает вариацию результата под влиянием всех прочих факторов, неучтенных регрессией.

Предопределенные переменные — это экзогенные переменные системы и лаговые эндогенные переменные системы.

Приведенная форма системы — форма, которая, в отличие от структурной, уже содержит одни только линейно зависящие от экзогенных переменных эндогенные переменные. Внешне ничем не отличается от системы независимых уравнений.

Расчетное значение F-отношения — значение, которое получают делением объясненной дисперсии на 1 степень свободы на остаточную дисперсию на 1 степень свободы.

Регрессия (зависимость) — это усредненная (сглаженная), т.е. свободная от случайных мелкомасштабных колебаний (флуктуаций), квазидетерминированная связь между объясняемой переменной (переменными) и объясняющей переменной (переменными). Эта связь выражается формулами, которые характеризуют функциональную зависимость и не содержат явно стохастических (случайных) переменных, которые свое влияние теперь оказывают как результирующее воздействие, принимающее вид чисто функциональной зависимости.

Регрессор (объясняющая переменная, факторная переменная) — это независимая переменная, статистически связанная с результирующей переменной. Характер этой связи и влияние изменения (вариации) регрессора на результат исследуются в эконометрике.

Система взаимосвязанных уравнений — это система одновременных или взаимозависимых уравнений. В ней одни и те же переменные выступают одновременно как зависимые в одних уравнениях и в то же время независимые в других. Это структурная форма системы уравнений. К ней неприменим МНК.

Система внешне не связанных между собой уравнений — система, которая характеризуется наличием одних только корреляций между остатками (ошибками) в разных уравнениях системы.

Случайный остаток (отклонение) — это чисто случайный процесс в виде мелкомасштабных колебаний, не содержащий уже детерминированной компоненты, которая имеется в регрессии.

Состоятельные оценки — оценки, которые позволяют эффективно применять доверительные интервалы, когда вероятность получения оценки на заданном расстоянии от истинного значения параметра становится близка к 1, а точность самих оценок увеличивается с ростом объема выборки.

Спецификация модели — определение существенных факторов и выявление мультиколлинеарности.

Стандартная ошибка — среднеквадратичное (стандартное) отклонение. Оно связано со средней ошибкой и коэффициентом доверия.

Степени свободы — это величины, характеризующие число независимых параметров и необходимые для нахождения по таблицам распределений их критических значений.

Тренд — основная тенденция развития, плавная устойчивая закономерность изменения уровней ряда.

Уровень значимости — величина, показывающая, какова вероятность ошибочного вывода при проверке статистической гипотезы по статистическому критерию.

Фиктивные переменные — это переменные, которые отражают сезонные компоненты ряда для какого-либо одного периода.

Эконометрическая модель — это уравнение или система уравнений, особым образом представляющие зависимость (зависимости) между результатом и факторами. В основе эконометрической модели лежит разбиение сложной и малопонятной зависимости между результатом и факторами на сумму двух следующих компонентов: регрессию (регрессионная компонента) и случайный (флуктуационный) остаток. Другой класс эконометрических моделей образует временные ряды.

Эффективность оценки — это свойство оценки обладать наименьшей дисперсией из всех возможных.

источники:

http://studrb.ru/works/entry29502WbDxMY

http://damirock.com/exam/math/otvetyi-na-testyi-po-ekonometrike/

В этой серии мы внимательно рассмотрим алгоритм машинного обучения и изучим плюсы и минусы каждого алгоритма. Мы рассмотрим алгоритмы вместе с математикой, лежащей в основе алгоритма.

Во-первых, давайте проясним некоторые основные термины, используемые в машинном обучении.

- Контролируемый алгоритм ML: Те алгоритмы, которые используют помеченные данные, известны как контролируемые алгоритмы ml. Контролируемые алгоритмы ml широко используются для двух задач: классификации и регрессии.

- Классификация: Когда задача состоит в том, чтобы классифицировать объекты выборки по определенным категориям (целевая переменная), тогда это называется классификацией. Например, определение того, является ли электронное письмо спамом или нет.

- Регрессия: когда задача состоит в том, чтобы предсказать непрерывную переменную (целевую переменную), тогда это называется регрессией. Например, прогнозирование цен на жилье.

- Неконтролируемый алгоритм ML: те алгоритмы, которые используют немаркированные данные, известны как неконтролируемые алгоритмы ml. Для кластеризации используется неконтролируемый алгоритм.

- Кластеризация: задача поиска групп в заданных немаркированных данных известна как кластеризация.

- Ошибка: разница между фактическим и прогнозируемым значением.

- Градиентный спуск: механизм обновления параметров модели таким образом, чтобы генерировать минимальное значение функции ошибки.

Что такое линейная регрессия в машинном обучении?

Линейная регрессия — это тип контролируемого алгоритма машинного обучения, который используется для прогнозирования непрерывной числовой переменной, известной как цель. Это один из самых простых алгоритмов машинного обучения. Он называется «линейным», потому что алгоритм предполагает, что взаимосвязь между входными характеристиками (также известными как независимые переменные) и выходной переменной (также известной как зависимая или целевая переменная) является линейной. Другими словами, алгоритм пытается найти прямую линию (или гиперплоскость в случае нескольких входных объектов), которая наилучшим образом соответствует данным.

Типы линейной регрессии:

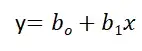

Простая линейная регрессия:

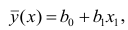

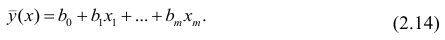

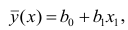

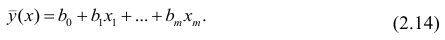

Линейная регрессия известна как простая линейная регрессия, когда прогнозирование выходного значения выполняется с использованием одной входной функции. Мы можем провести линию между зависимыми и независимыми переменными в 2D-пространстве, когда задан один входной признак. здесь b0 — точка пересечения, b1 — коэффициент, x1, x2,…, xn — входные признаки, а y — выходная переменная.

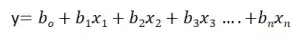

Множественная линейная регрессия:

Линейная регрессия известна как множественная линейная регрессия, когда прогнозирование выходной переменной выполняется с использованием нескольких входных признаков. Мы можем нарисовать плоскость между зависимой и независимой переменными в 3D-пространстве, когда заданы только два входных объекта. В более высоких измерениях визуализация становится затруднительной, но интуиция заключается в том, чтобы найти гиперплоскость в более высоких измерениях. здесь b0 — это перехват, а b1, b2, b3, ......., bn-1, bn известны как коэффициенты, а x1, x2,..., xn известны как входные характеристики, а y — переменная результата.

К этому моменту мы поняли, что линейная регрессия пытается построить линейную границу, но как она это делает?

Как он найдет идеальную линию, которая разделяет данные два класса?

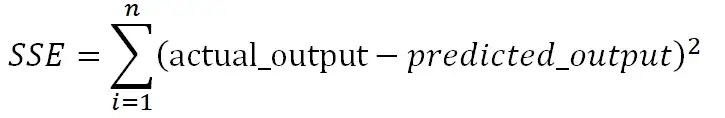

Как указано в уравнении, b0 известен как перехват, а b1, b2,...., bn известны как коэффициенты линейной регрессии, и теперь цель состоит в том, чтобы найти ту линейную границу, которая минимизирует функцию ошибки. Функция ошибки представляет собой квадрат суммы разностей между прогнозируемыми и фактическими значениями целевой переменной. Если мы не сведем ошибку в квадрат, то положительные и отрицательные моменты будут компенсировать друг друга.

Нам нужно найти коэффициенты и перехваты для линейной регрессии таким образом, чтобы сумма квадратов ошибок (SSE) была минимизирована. Градиентный спуск — один из самых популярных методов, который используется для нахождения оптимальных коэффициентов для ml и алгоритмов глубокого обучения.

В приведенном ниже разделе мы обучим модель на базе данных страхования, где мы должны спрогнозировать расходы с учетом входных данных: возраст, пол, ИМТ, расходы на больницу, количество прошлых консультаций и т.д.

Реализация на Python:

Вы можете использовать библиотеку sklearn на python для обучения и тестирования модели линейной регрессии. Мы будем использовать набор данных insurance.csv для обучения модели линейной регрессии. Некоторые этапы предварительной обработки выполняются для описания данных, обработки пропущенных значений и проверки допущений линейной регрессии.

Шаг 1: Загрузите все необходимые библиотеки и наборы данных, используя библиотеку pandas.

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from statsmodels.stats.outliers_influence import variance_inflation_factor as VIF

from sklearn.metrics import classification_report

insurance=pd.read_csv('new_insurance_data.csv')

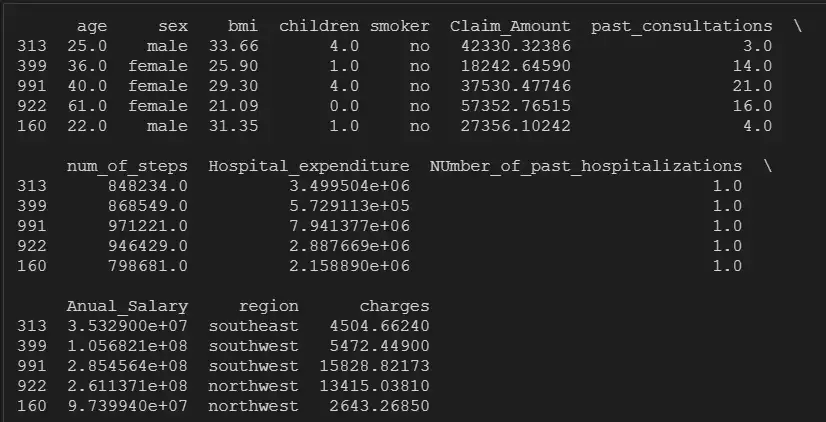

insurance.head()

Шаг 2: Проверьте нулевые значения, форму и тип данных переменных:

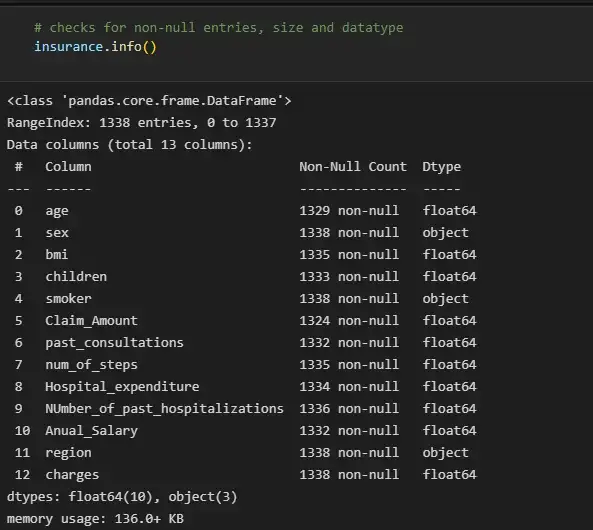

# checks for non-null entries, size and datatype

insurance.info()

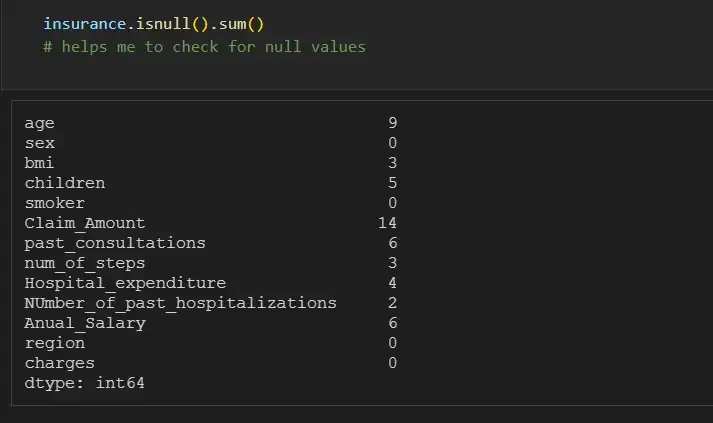

Мы можем отдельно проверить количество нулей для каждой функции, используя df.isna().sum():

insurance.isnull().sum()

# helps me to check for null values

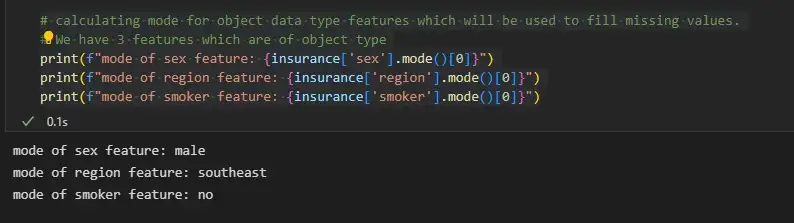

Шаг 3. Заполните пропущенные значения

Мы можем заполнить недостающие значения объектов объектного типа, используя режим, а объектов целочисленного типа — среднее значение или медиану.

# calculating mode for object data type features which will be used to fill missing values.

# We have 3 features which are of object type

print(f"mode of sex feature: {insurance['sex'].mode()[0]}")

print(f"mode of region feature: {insurance['region'].mode()[0]}")

print(f"mode of smoker feature: {insurance['smoker'].mode()[0]}")

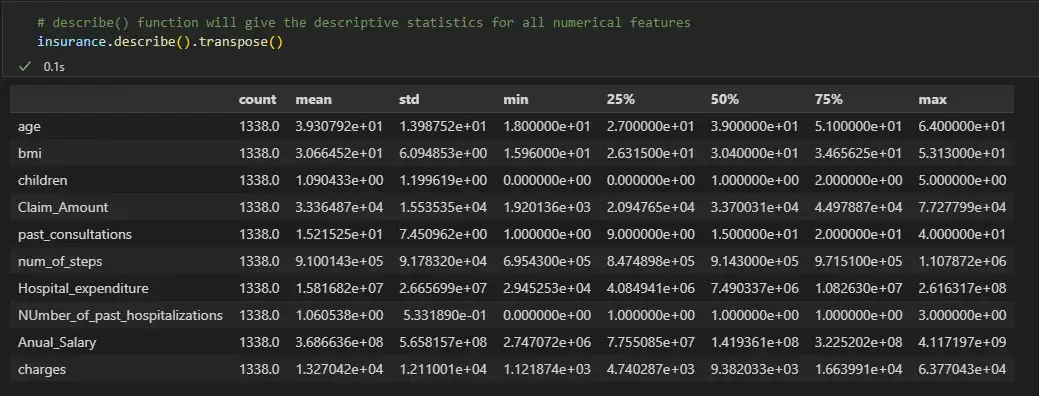

# describe() function will give the descriptive statistics for all numerical features

insurance.describe().transpose()

Мы видим, что для числовых признаков среднее и медиана почти одинаковы. Поэтому теперь мы заменим нулевые значения числовых признаков их медианой, а нулевые значения категориальных переменных — их режимом.

for col_name in list(insurance.columns):

if insurance[col_name].dtypes=='object':

# filling null values with mode for object type features

insurance[col_name] = insurance[col_name].fillna(insurance[col_name].mode()[0])

else:

# filling null values with mean for numeric type features

insurance[col_name] = insurance[col_name].fillna(insurance[col_name].median())

# Now the null count for each feature is zero

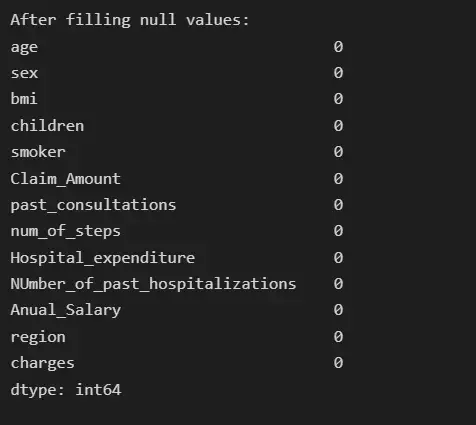

print("After filling null values:")

print(insurance.isna().sum())

Шаг 4: Анализ выбросов

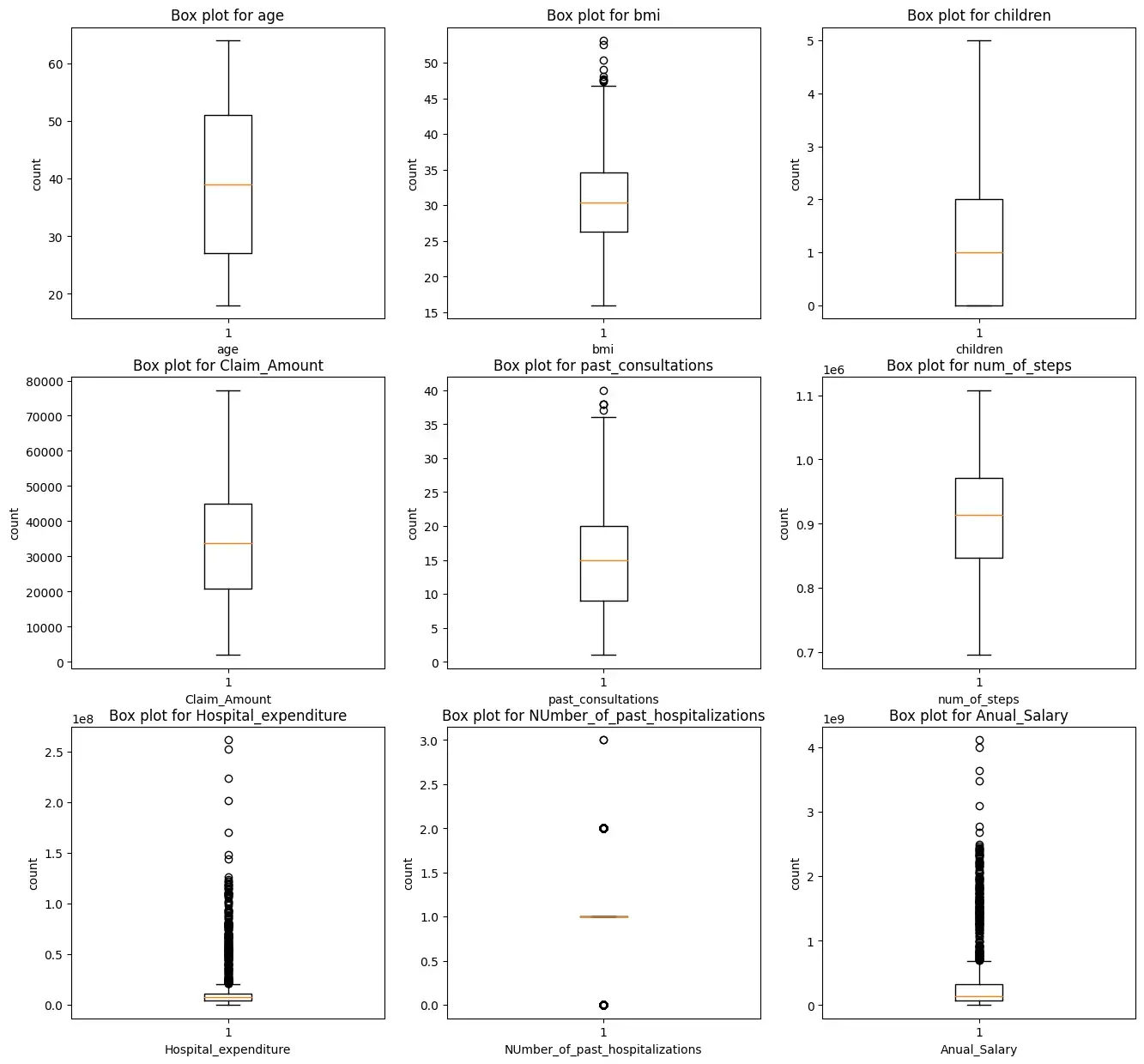

Мы построим прямоугольную диаграмму для всех числовых характеристик, кроме целевых переменных зарядов.

i = 1

plt.figure(figsize=(16,15))

for col_name in list(insurance.columns):

# total 9 box plots will be plotted, therefore 3*3 grid is taken

if((insurance[col_name].dtypes=='int64' or insurance[col_name].dtypes=='float64') and col_name != 'charges'):

plt.subplot(3,3, i)

plt.boxplot(insurance[col_name])

plt.xlabel(col_name)

plt.ylabel('count')

plt.title(f"Box plot for {col_name}")

i += 1

plt.show()

Мы видим, что характеристики ‘bmi’, ‘Hospital_expenditure’ и ‘Number_of_past_hospitalizations’ имеют выбросы. Мы удалим эти выбросы:

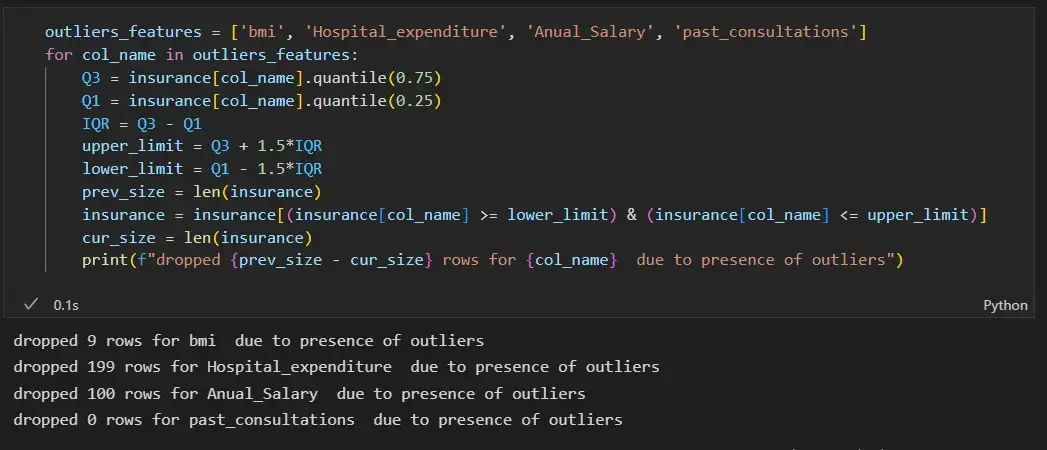

outliers_features = ['bmi', 'Hospital_expenditure', 'Anual_Salary', 'past_consultations']

for col_name in outliers_features:

Q3 = insurance[col_name].quantile(0.75)

Q1 = insurance[col_name].quantile(0.25)

IQR = Q3 - Q1

upper_limit = Q3 + 1.5*IQR

lower_limit = Q1 - 1.5*IQR

prev_size = len(insurance)

insurance = insurance[(insurance[col_name] >= lower_limit) & (insurance[col_name] <= upper_limit)]

cur_size = len(insurance)

print(f"dropped {prev_size - cur_size} rows for {col_name} due to presence of outliers")

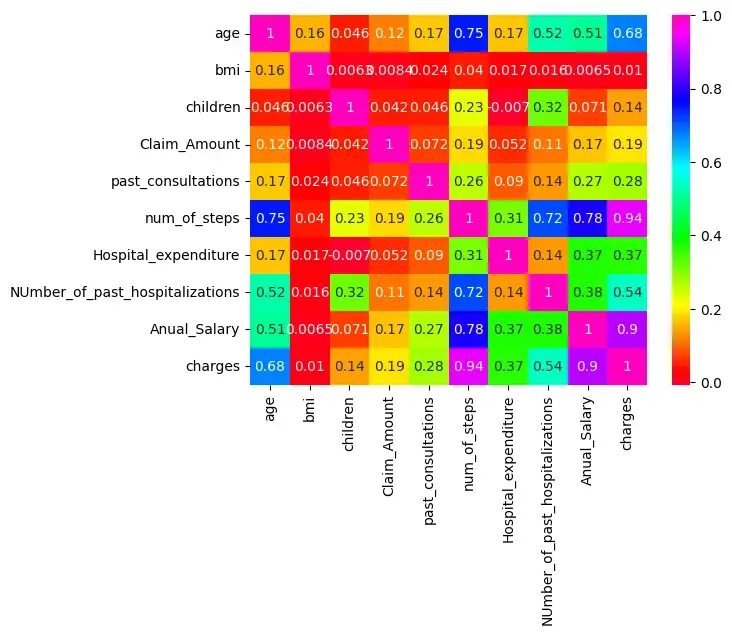

Шаг 5: Проверьте корреляцию:

Существует корреляция между age & charges, age & Anual_salary и т. д., поскольку их корреляция больше 0,5.

import seaborn as sns

sns.heatmap(insurance.corr(),cmap='gist_rainbow',annot=True)

plt.show()

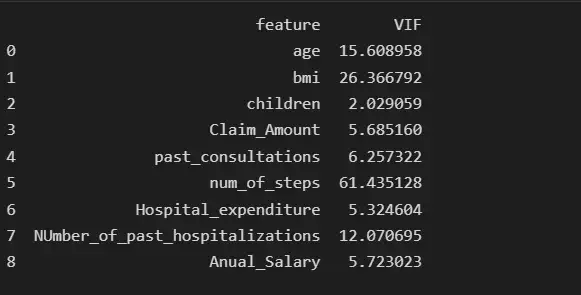

Мы проверим наличие мультиколлинеарности среди признаков:

from statsmodels.stats.outliers_influence import variance_inflation_factor

col_list = []

for col in insurance.columns:

if ((insurance[col].dtype != 'object') & (col != 'charges') ):#only num cols except for the charges column

col_list.append(col)

X = insurance[col_list]

vif_data = pd.DataFrame()

vif_data["feature"] = X.columns

vif_data["VIF"] = [variance_inflation_factor(X.values, i) for i in range(len(X.columns))]

print(vif_data)

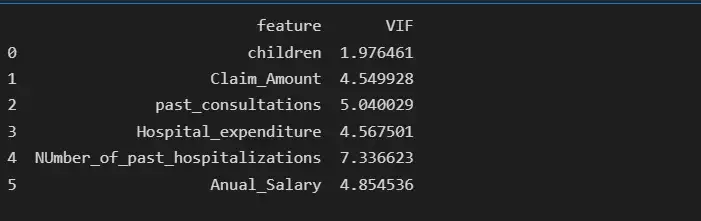

Мы видим, что функция num_of_steps имеет самую высокую коллинеарность, равную 61,43, поэтому мы удалим функцию num_of_steps и снова проверим оценку VIF.

# deleting num_of_steps feature

insurance.drop('num_of_steps', axis = 1, inplace= True)

from statsmodels.stats.outliers_influence import variance_inflation_factor

col_list = []

for col in insurance.columns:

if ((insurance[col].dtype != 'object') & (col != 'charges') ):#only num cols except for the charges column

col_list.append(col)

X = insurance[col_list]

X = insurance[col_list]

vif_data = pd.DataFrame()

vif_data["feature"] = X.columns

vif_data["VIF"] = [variance_inflation_factor(X.values, i) for i in range(len(X.columns))]

print(vif_data)

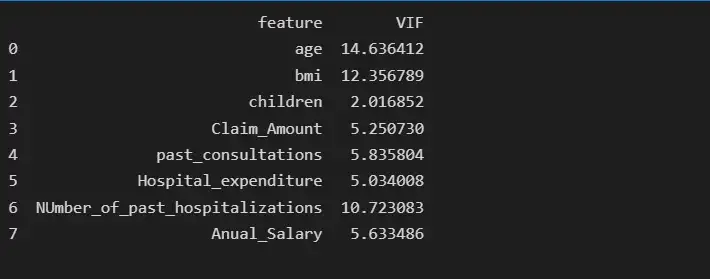

После удаления функции num_of_steps age имеет самую высокую коллинеарность, равную 14,63, поэтому мы удалим функцию age и снова проверим оценку VIF.

# deleting age feature

insurance.drop('age', axis = 1, inplace= True)

from statsmodels.stats.outliers_influence import variance_inflation_factor

col_list = []

for col in insurance.columns:

if ((insurance[col].dtype != 'object') & (col != 'charges') ):#only num cols except for the charges column

col_list.append(col)

X = insurance[col_list]

X = insurance[col_list]

vif_data = pd.DataFrame()

vif_data["feature"] = X.columns

vif_data["VIF"] = [variance_inflation_factor(X.values, i) for i in range(len(X.columns))]

print(vif_data)

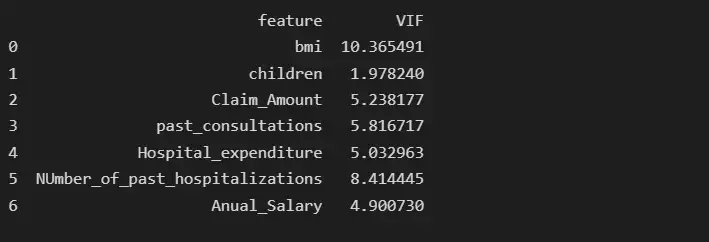

После удаления функции возраста BMI имеет самую высокую коллинеарность, равную 10,36, поэтому мы удалим BMI и снова проверим показатель VIF.

# deleting bmi feature

insurance.drop('bmi', axis = 1, inplace= True)

from statsmodels.stats.outliers_influence import variance_inflation_factor

col_list = []

for col in insurance.columns:

if ((insurance[col].dtype != 'object') & (col != 'charges') ):#only num cols except for the charges column

col_list.append(col)

X = insurance[col_list]

X = insurance[col_list]

vif_data = pd.DataFrame()

vif_data["feature"] = X.columns

vif_data["VIF"] = [variance_inflation_factor(X.values, i) for i in range(len(X.columns))]

print(vif_data)

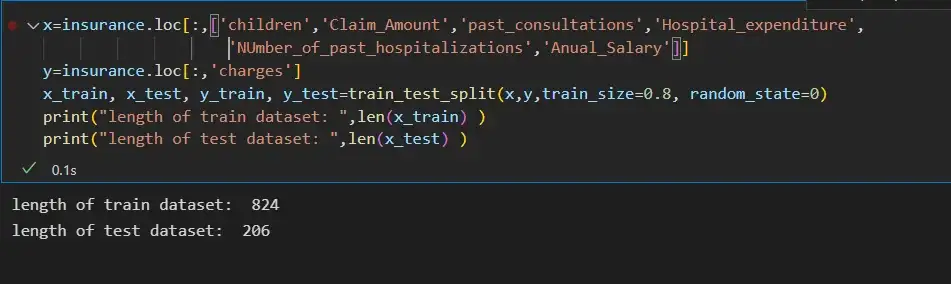

Шаг 6: Разделение входных функций и целевой переменной:

x=insurance.loc[:,['children','Claim_Amount','past_consultations','Hospital_expenditure','NUmber_of_past_hospitalizations','Anual_Salary']]

y=insurance.loc[:,'charges']

x_train, x_test, y_train, y_test=train_test_split(x,y,train_size=0.8, random_state=0)

print("length of train dataset: ",len(x_train) )

print("length of test dataset: ",len(x_test) )

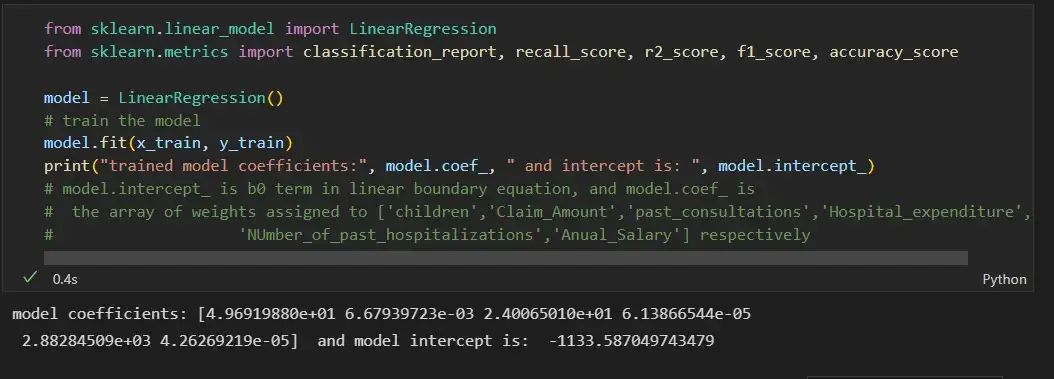

Шаг 7: Обучение модели линейной регрессии на наборе поездов и ее оценка на тестовом наборе данных:

from sklearn.linear_model import LinearRegression

from sklearn.metrics import classification_report, recall_score, r2_score, f1_score, accuracy_score

model = LinearRegression()

# train the model

model.fit(x_train, y_train)

print("trained model coefficients:", model.coef_, " and intercept is: ", model.intercept_)

# model.intercept_ is b0 term in linear boundary equation, and model.coef_ is

# the array of weights assigned to ['children','Claim_Amount','past_consultations','Hospital_expenditure',

# 'NUmber_of_past_hospitalizations','Anual_Salary'] respectively

y_pred = model.predict(x_test)

error_pred=pd.DataFrame(columns={'Actual_data','Prediction_data'})

error_pred['Prediction_data'] = y_pred

error_pred['Actual_data'] = y_test

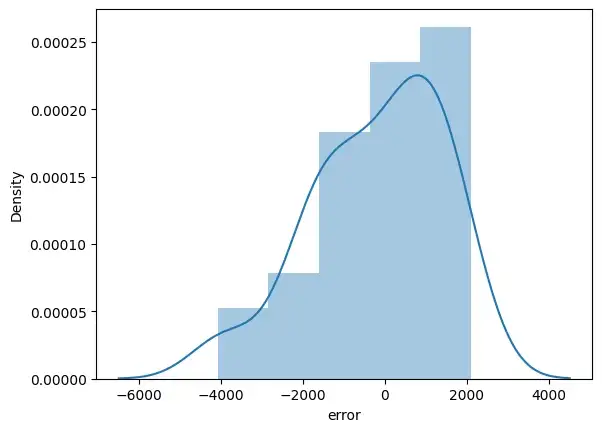

error_pred["error"] = y_test - y_pred

sns.distplot(error_pred['error'])

plt.show()

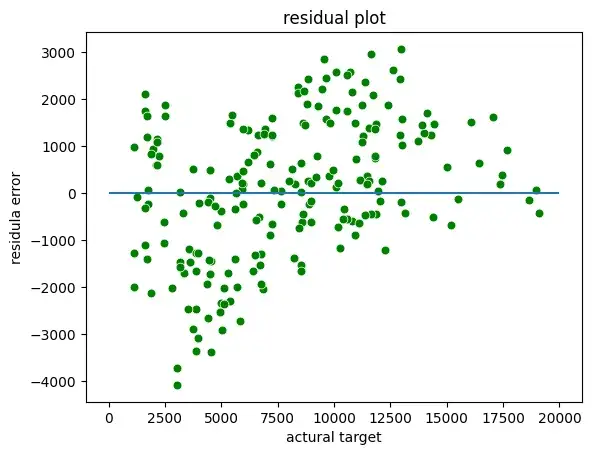

Мы можем построить остаточные графики между фактической целью и остатками или ошибками:

sns.scatterplot(x = y_test,y = (y_test - y_pred), c = 'g', s = 40)

plt.hlines(y = 0, xmin = 0, xmax=20000)

plt.title("residual plot")

plt.xlabel("actural target")

plt.ylabel("residula error")

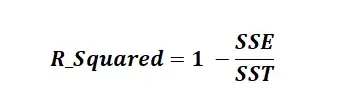

Оценка R-квадрата:

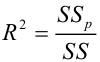

R-квадрат известен как коэффициент детерминации. R Squared — это статистическая мера, которая представляет долю дисперсии зависимой переменной, объясненную независимыми переменными в регрессии. Это значение находится в диапазоне от 0 до 1. Значение «1» указывает, что предиктор полностью учитывает все изменения в Y. Значение «0» указывает, что предиктор «x» не учитывает никаких изменений в «y». Значение R-Squared содержит три термина SSE, SSR и SST.

SSE — это сумма квадратов ошибок. Его также называют остаточной суммой квадратов (RSS).

SSR — это сумма квадратов регрессии.

SST (Сумма в квадрате) — это квадрат разницы между наблюдаемой зависимой переменной и ее средним значением.

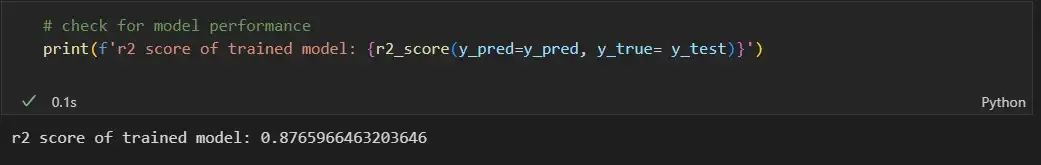

# check for model performance

print(f'r2 score of trained model: {r2_score(y_pred=y_pred, y_true= y_test)}')

Предположения линейной регрессии

- Линейная связь: линейная регрессия предполагает линейную связь между прогнозируемой переменной и независимой переменной. Вы можете использовать точечную диаграмму, чтобы визуализировать взаимосвязь между независимой переменной и зависимой переменной в 2D-пространстве.

- Небольшая мультиколлинеарность или отсутствие мультиколлинеарности между функциями: линейная регрессия предполагает, что функции должны быть независимыми друг от друга, т. Е. Никакой корреляции между функциями. Вы можете использовать функцию VIF, чтобы найти значение мультиколлинеарности признаков. Общее предположение гласит, что если значение признака VIF больше 5, то признаки сильно коррелированы.

- Однородность: линейная регрессия предполагает, что члены ошибок имеют постоянную дисперсию, т. е. разброс членов ошибок должен быть постоянным. Это предположение можно проверить, построив остаточную диаграмму. Если предположение нарушается, то точки образуют форму воронки, в противном случае они будут постоянными.

- Нормальность: линейная регрессия предполагает, что каждая функция данного набора данных следует нормальному распределению. Вы можете строить гистограммы и графики KDE для каждой функции, чтобы проверить, нормально ли они распределены или нет.

- Ошибка: линейная регрессия предполагает, что условия ошибки также должны быть нормально распределены. Вы можете строить гистограммы, а KDE строит графики ошибок, чтобы проверить, нормально ли они распределены или нет.

Вот ссылка GitHub для кода и набора данных.

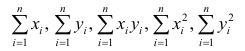

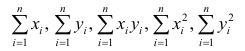

Содержание:

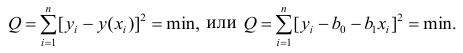

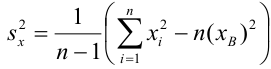

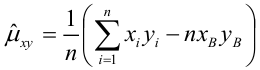

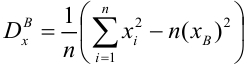

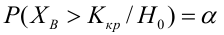

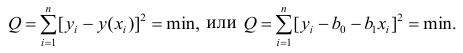

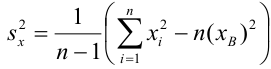

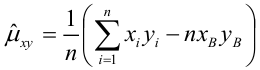

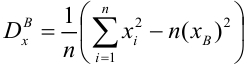

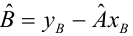

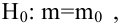

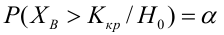

Регрессионный анализ:

Регрессионным анализом называется раздел математической статистики, объединяющий практические методы исследования корреляционной зависимости между случайными величинами по результатам наблюдений над ними. Сюда включаются методы выбора модели изучаемой зависимости и оценки ее параметров, методы проверки статистических гипотез о зависимости.

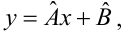

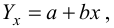

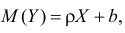

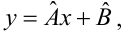

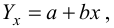

Пусть между случайными величинами X и Y существует линейная корреляционная зависимость. Это означает, что математическое ожидание Y линейно зависит от значений случайной величины X. График этой зависимости (линия регрессии Y на X) имеет уравнение

Линейная модель пригодна в качестве первого приближения и в случае нелинейной корреляции, если рассматривать небольшие интервалы возможных значений случайных величин.

Пусть параметры линии регрессии  неизвестны, неизвестна и величина коэффициента корреляции

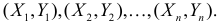

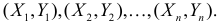

неизвестны, неизвестна и величина коэффициента корреляции  Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:

Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:  Эти результаты могут служить источником информации о неизвестных значениях

Эти результаты могут служить источником информации о неизвестных значениях  надо только уметь эту информацию извлечь оттуда.

надо только уметь эту информацию извлечь оттуда.

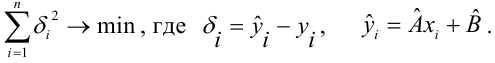

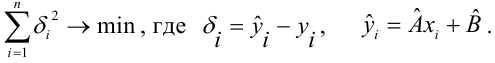

Неизвестная нам линия регрессии  как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для

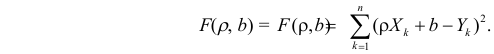

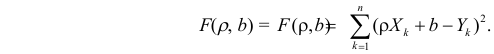

как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для  можно принять те их значения, при которых имеет минимум функция

можно принять те их значения, при которых имеет минимум функция

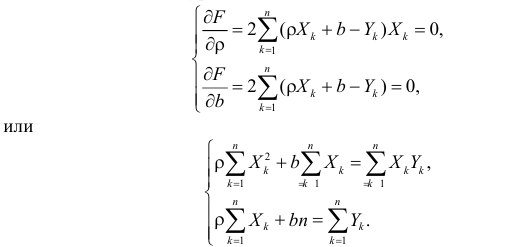

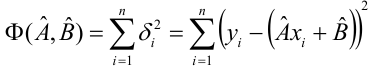

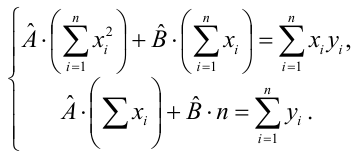

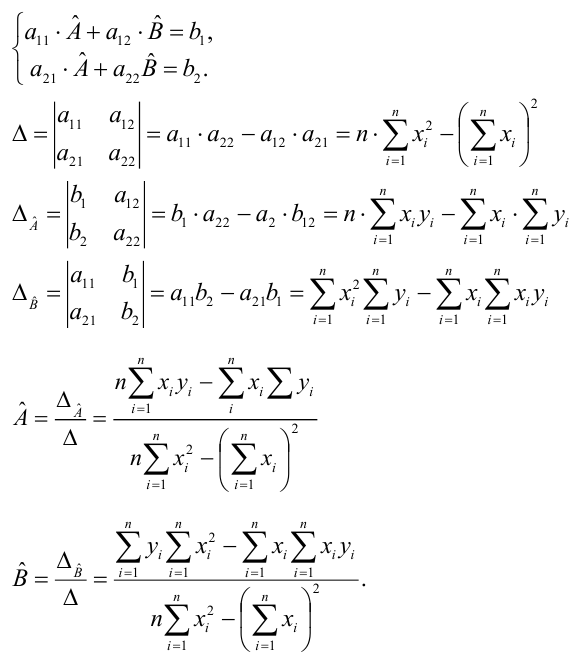

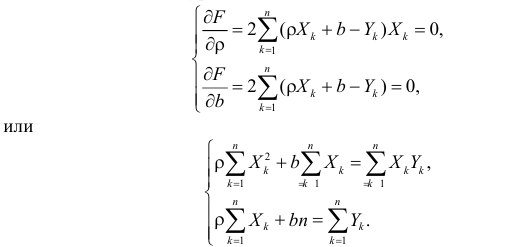

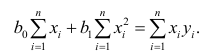

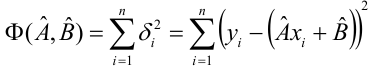

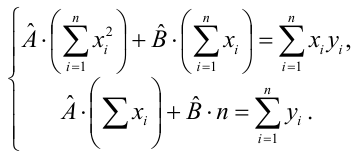

Такие значения  , согласно необходимым условиям экстремума, находятся из системы уравнений:

, согласно необходимым условиям экстремума, находятся из системы уравнений:

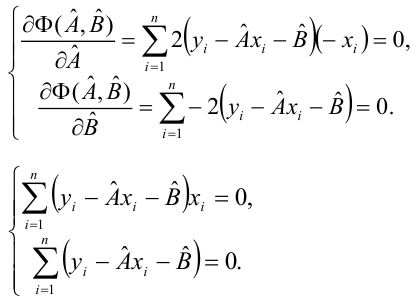

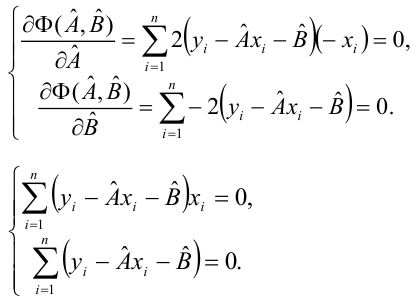

Решения этой системы уравнений дают оценки называемые оценками по методу наименьших квадратов.

и

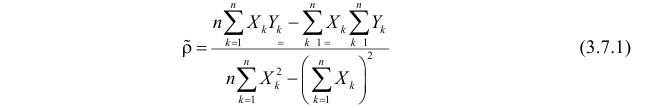

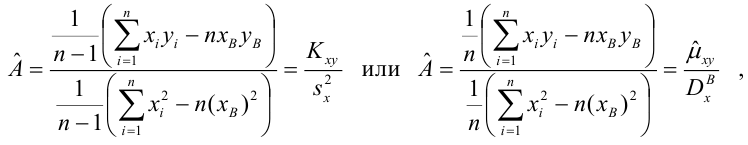

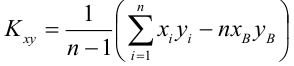

Известно, что оценки по методу наименьших квадратов являются несмещенными и, более того, среди всех несмещенных оценок обладают наименьшей дисперсией. Для оценки коэффициента корреляции можно воспользоваться тем, что  где

где  средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через

средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через  оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

По методу наименьших квадратов можно находить оценки параметров линии регрессии и при нелинейной корреляции. Например, для линии регрессии вида  оценки параметров

оценки параметров  находятся из условия минимума функции

находятся из условия минимума функции

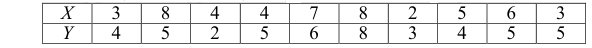

Пример:

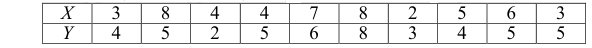

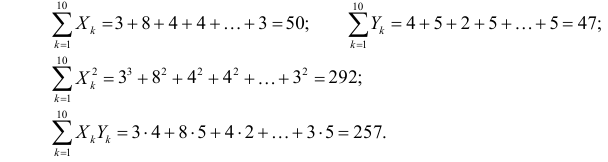

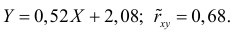

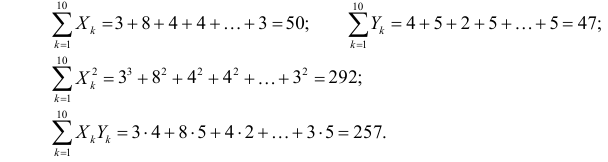

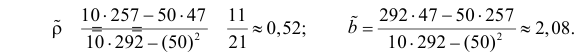

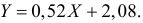

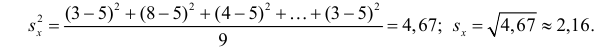

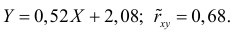

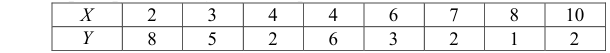

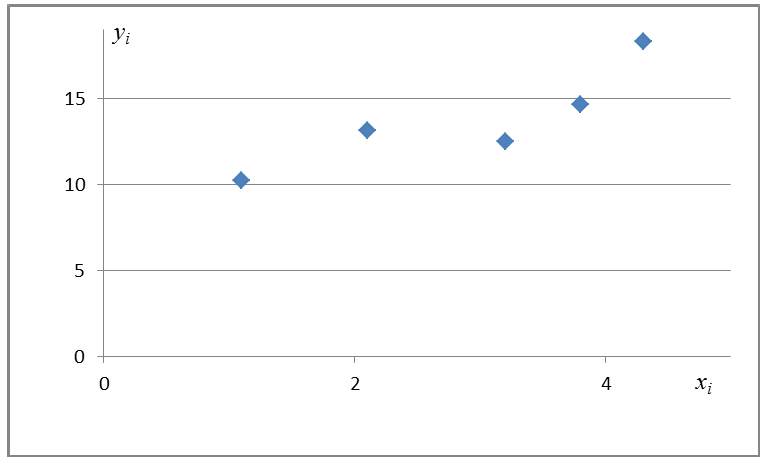

По данным наблюдений двух случайных величин найти коэффициент корреляции и уравнение линии регрессии Y на X

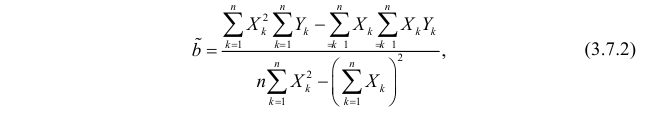

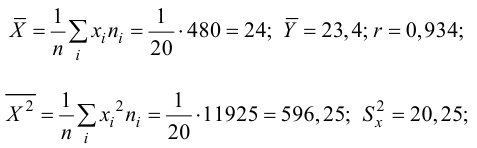

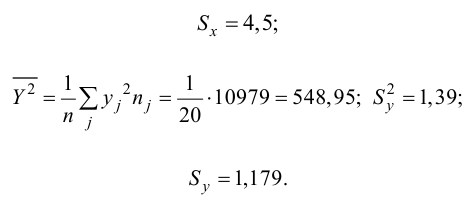

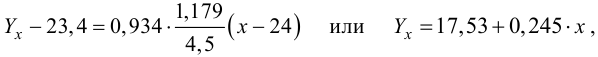

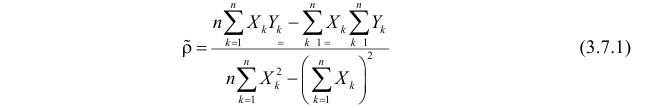

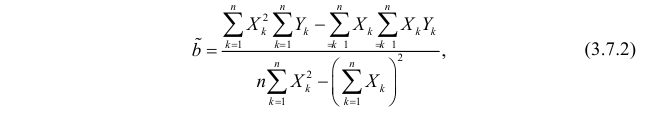

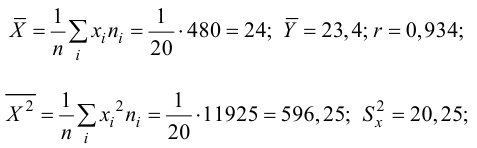

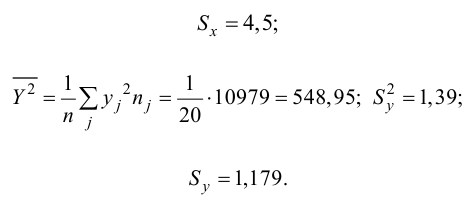

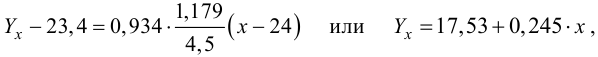

Решение. Вычислим величины, необходимые для использования формул (3.7.1)–(3.7.3):

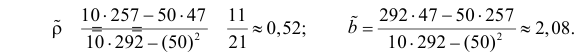

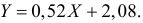

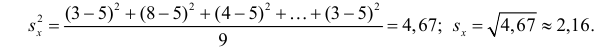

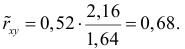

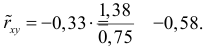

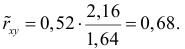

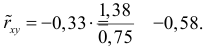

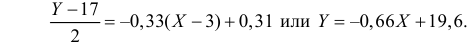

По формулам (3.7.1) и (3.7.2) получим

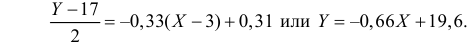

Итак, оценка линии регрессии имеет вид  Так как

Так как  то по формуле (3.1.3)

то по формуле (3.1.3)

Аналогично,  Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Ответ.

Пример:

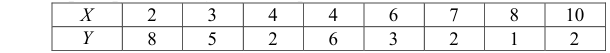

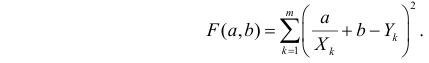

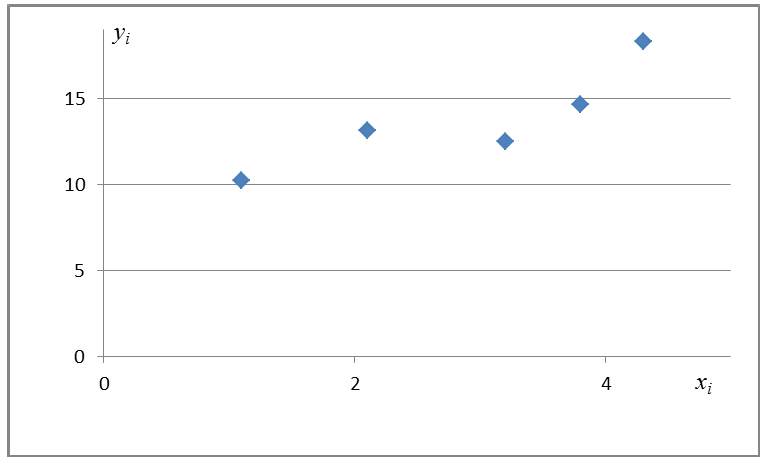

Получена выборка значений величин X и Y

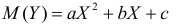

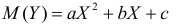

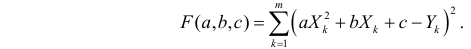

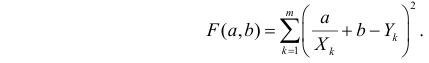

Для представления зависимости между величинами предполагается использовать модель  Найти оценки параметров

Найти оценки параметров

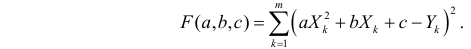

Решение. Рассмотрим сначала задачу оценки параметров этой модели в общем виде. Линия  играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

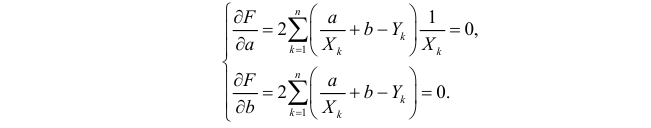

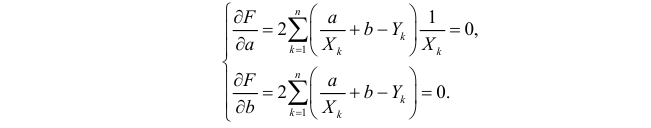

Необходимые условия экстремума приводят к системе из двух уравнений:

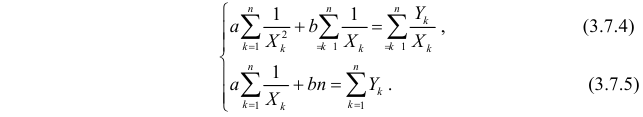

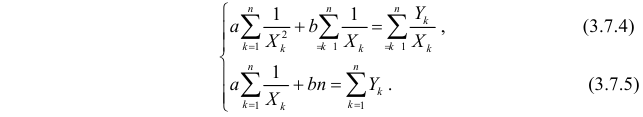

Откуда

Решения системы уравнений (3.7.4) и (3.7.5) и будут оценками по методу наименьших квадратов для параметров

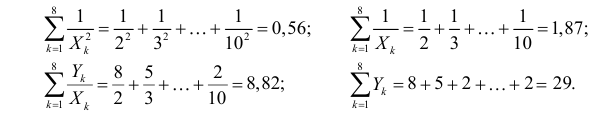

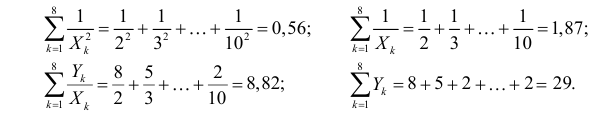

На основе опытных данных вычисляем:

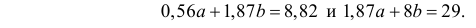

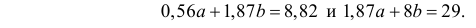

В итоге получаем систему уравнений (?????) и (?????) в виде

Эта система имеет решения

Ответ.

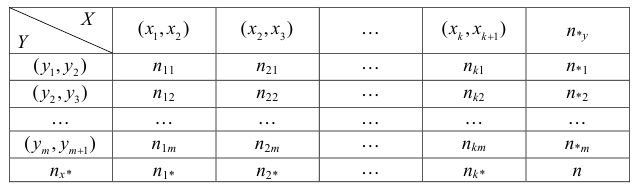

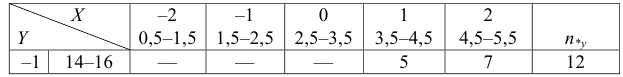

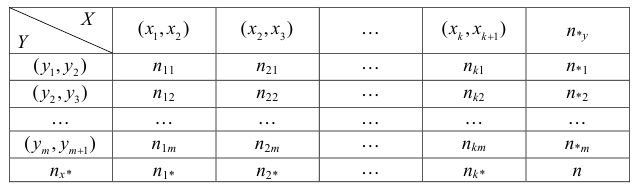

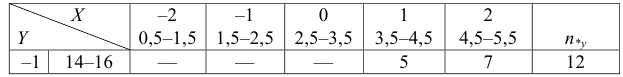

Если наблюдений много, то результаты их обычно группируют и представляют в виде корреляционной таблицы.

В этой таблице  равно числу наблюдений, для которых X находится в интервале

равно числу наблюдений, для которых X находится в интервале  а Y – в интервале

а Y – в интервале  Через

Через  обозначено число наблюдений, при которых

обозначено число наблюдений, при которых  а Y произвольно. Число наблюдений, при которых

а Y произвольно. Число наблюдений, при которых  а X произвольно, обозначено через

а X произвольно, обозначено через

Если величины дискретны, то вместо интервалов указывают отдельные значения этих величин. Для непрерывных случайных величин представителем каждого интервала считают его середину и полагают, что  и

и  наблюдались

наблюдались  раз.

раз.

При больших значениях X и Y можно для упрощения вычислений перенести начало координат и изменить масштаб по каждой из осей, а после завершения вычислений вернуться к старому масштабу.

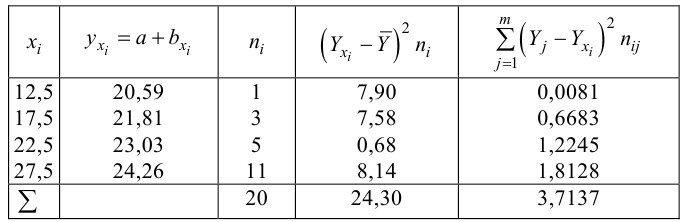

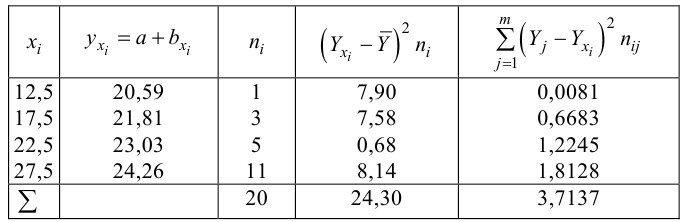

Пример:

Проделано 80 наблюдений случайных величин X и Y. Результаты наблюдений представлены в виде таблицы. Найти линию регрессии Y на X. Оценить коэффициент корреляции.

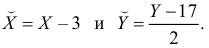

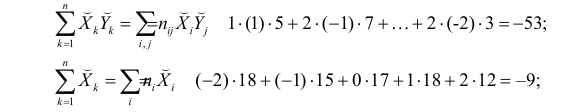

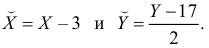

Решение. Представителем каждого интервала будем считать его середину. Перенесем начало координат и изменим масштаб по каждой оси так, чтобы значения X и Y были удобны для вычислений. Для этого перейдем к новым переменным  Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

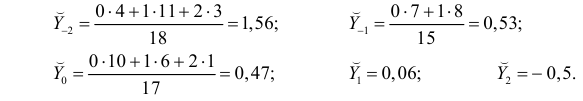

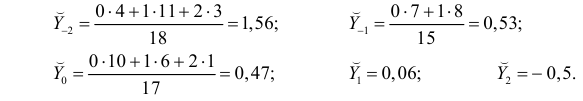

Чтобы иметь представление о виде линии регрессии, вычислим средние значения  при фиксированных значениях

при фиксированных значениях  :

:

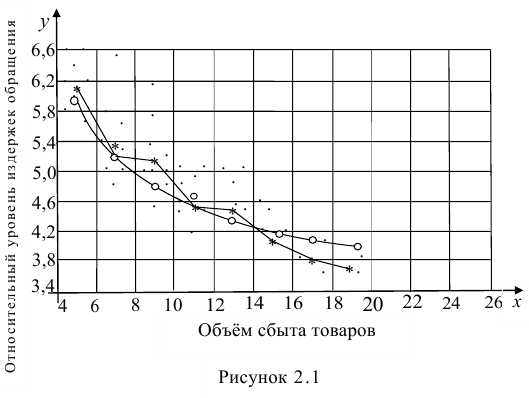

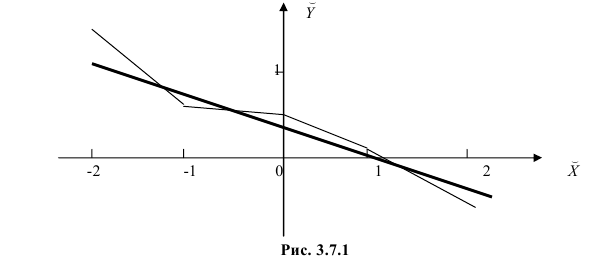

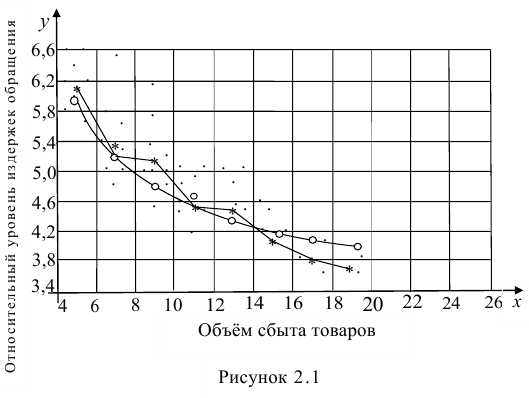

Нанесем эти значения на координатную плоскость, соединив для наглядности их отрезками прямой (рис. 3.7.1).

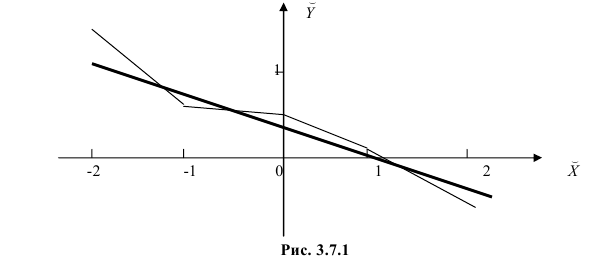

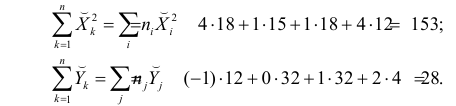

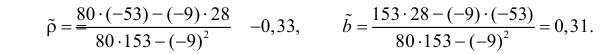

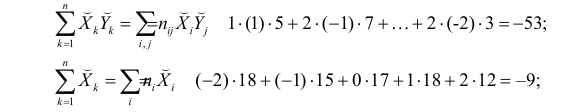

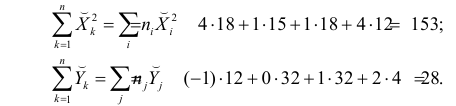

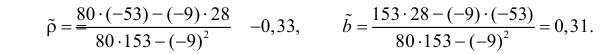

По виду полученной ломанной линии можно предположить, что линия регрессии Y на X является прямой. Оценим ее параметры. Для этого сначала вычислим с учетом группировки данных в таблице все величины, необходимые для использования формул (3.31–3.33):

Тогда

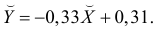

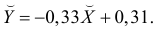

В новом масштабе оценка линии регрессии имеет вид  График этой прямой линии изображен на рис. 3.7.1.

График этой прямой линии изображен на рис. 3.7.1.

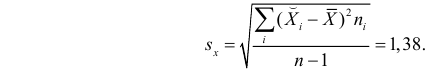

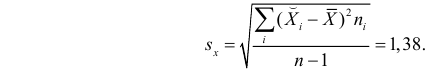

Для оценки  по корреляционной таблице можно воспользоваться формулой (3.1.3):

по корреляционной таблице можно воспользоваться формулой (3.1.3):

Подобным же образом можно оценить  величиной

величиной  Тогда оценкой коэффициента корреляции может служить величина

Тогда оценкой коэффициента корреляции может служить величина

Вернемся к старому масштабу:

Коэффициент корреляции пересчитывать не нужно, так как это величина безразмерная и от масштаба не зависит.

Ответ.

Пусть некоторые физические величины X и Y связаны неизвестной нам функциональной зависимостью  Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то

Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то  играет роль линии регрессии и все свойства линии регрессии приложимы к

играет роль линии регрессии и все свойства линии регрессии приложимы к  . В частности,

. В частности,  обычно находят по методу наименьших квадратов.

обычно находят по методу наименьших квадратов.

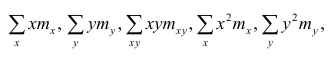

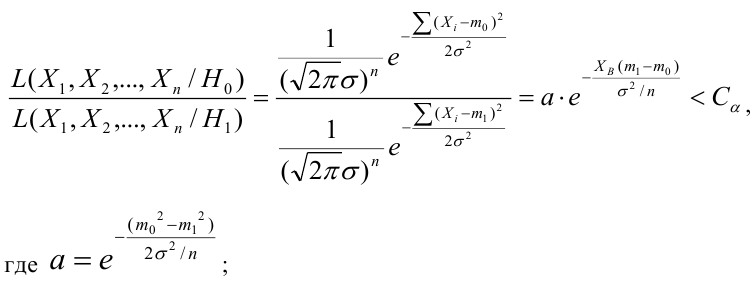

Регрессионный анализ

Основные положения регрессионного анализа:

Основная задача регрессионного анализа — изучение зависимости между результативным признаком Y и наблюдавшимся признаком X, оценка функции регрессий.

Предпосылки регрессионного анализа:

- Y — независимые случайные величины, имеющие постоянную дисперсию;

- X— величины наблюдаемого признака (величины не случайные);

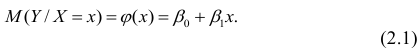

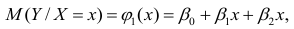

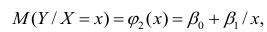

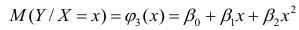

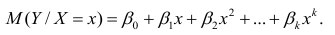

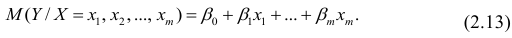

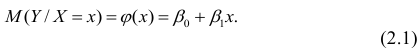

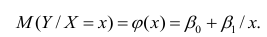

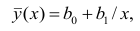

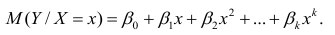

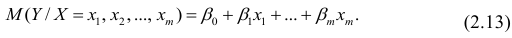

- условное математическое ожидание

можно представить в виде

можно представить в виде

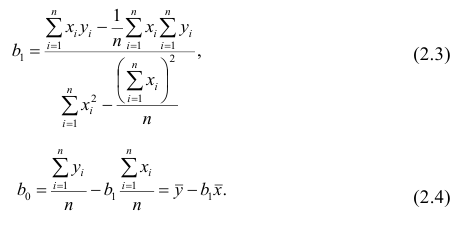

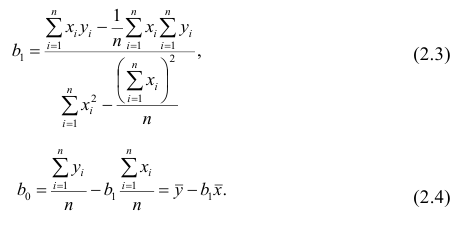

Выражение (2.1), как уже упоминалось в п. 1.2, называется функцией регрессии (или модельным уравнением регрессии) Y на X. Оценке в этом выражении подлежат параметры  называемые коэффициентами регрессии, а также

называемые коэффициентами регрессии, а также  — остаточная дисперсия.

— остаточная дисперсия.

Остаточной дисперсией называется та часть рассеивания результативного признака, которую нельзя объяснить действием наблюдаемого признака; Остаточная дисперсия может служить для оценки точности подбора вида функции регрессии (модельного уравнения регрессии), полноты набора признаков, включенных в анализ. Оценки параметров функции регрессии находят, используя метод наименьших квадратов.

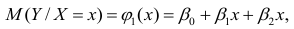

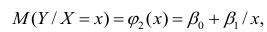

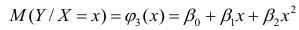

В данном вопросе рассмотрен линейный регрессионный анализ. Линейным он называется потому, что изучаем лишь те виды зависимостей которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

линейны относительно параметров

линейны относительно параметров

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости  выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

Важное место в линейном регрессионном анализе занимает так называемая «нормальная регрессия». Она имеет место, если сделать предположения относительно закона распределения случайной величины Y. Предпосылки «нормальной регрессии»:

- Y — независимые случайные величины, имеющие постоянную дисперсию и распределенные по нормальному закону;

- X— величины наблюдаемого признака (величины не случайные);

- условное математическое ожидание

можно представить в виде (2.1).

можно представить в виде (2.1).

В этом случае оценки коэффициентов регрессии — несмещённые с минимальной дисперсией и нормальным законом распределения. Из этого положения следует что при «нормальной регрессии» имеется возможность оценить значимость оценок коэффициентов регрессии, а также построить доверительный интервал для коэффициентов регрессии и условного математического ожидания M(YX=x).

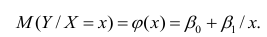

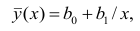

Линейная регрессия

Рассмотрим простейший случай регрессионного анализа — модель вида (2.1), когда зависимость  линейна и по оцениваемым параметрам, и

линейна и по оцениваемым параметрам, и

по переменным. Оценки параметров модели (2.1)  обозначил

обозначил  Оценку остаточной дисперсии

Оценку остаточной дисперсии  обозначим

обозначим  Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии

Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии  коэффициенты которого

коэффициенты которого  находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака

находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака от вычисленных по уравнению регрессии

от вычисленных по уравнению регрессии

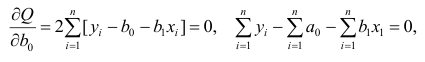

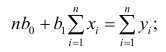

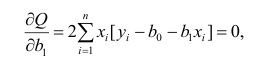

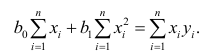

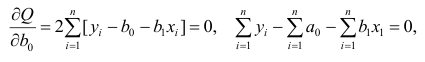

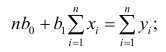

Составим систему нормальных уравнений: первое уравнение

откуда

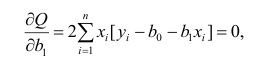

второе уравнение

откуда

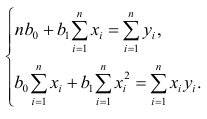

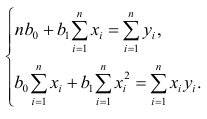

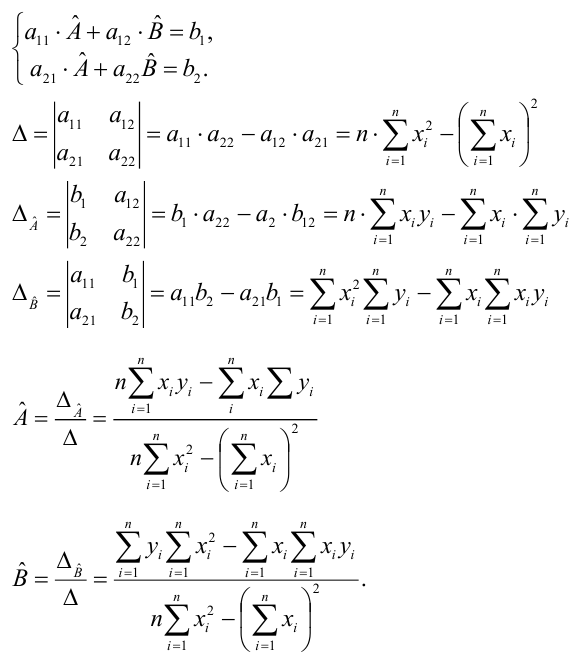

Итак,

Оценки, полученные по способу наименьших квадратов, обладают минимальной дисперсией в классе линейных оценок. Решая систему (2.2) относительно найдём оценки параметров

найдём оценки параметров

Остаётся получить оценку параметра  . Имеем

. Имеем

где т — количество наблюдений.

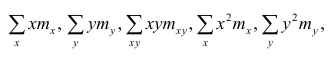

Еслит велико, то для упрощения расчётов наблюдавшиеся данные принята группировать, т.е. строить корреляционную таблицу. Пример построения такой таблицы приведен в п. 1.5. Формулы для нахождения коэффициентов регрессии по сгруппированным данным те же, что и для расчёта по несгруппированным данным, но суммы заменяют на

заменяют на

где  — частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

— частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

Нелинейная регрессия

Рассмотрим случай, когда зависимость нелинейна по переменным х, например модель вида

На рис. 2.1 изображено поле корреляции. Очевидно, что зависимость между Y и X нелинейная и её графическим изображением является не прямая, а кривая. Оценкой выражения (2.6) является уравнение регрессии

где  —оценки коэффициентов регрессии

—оценки коэффициентов регрессии

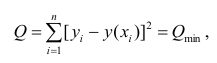

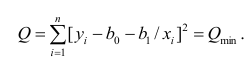

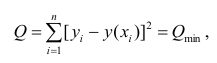

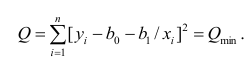

Принцип нахождения коэффициентов тот же — метод наименьших квадратов, т.е.

или

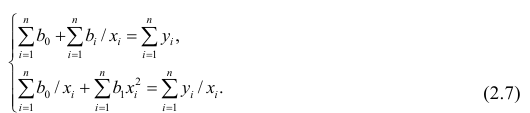

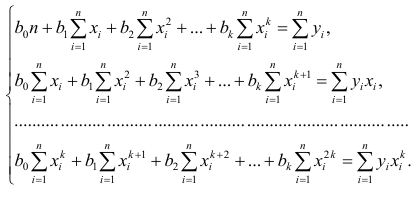

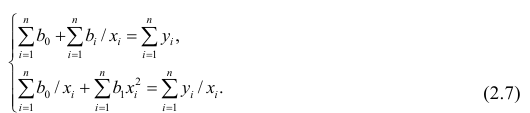

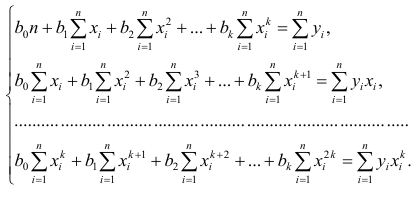

Дифференцируя последнее равенство по  и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

В общем случае нелинейной зависимости между переменными Y и X связь может выражаться многочленом k-й степени от x:

Коэффициенты регрессии определяют по принципу наименьших квадратов. Система нормальных уравнений имеет вид

Вычислив коэффициенты системы, её можно решить любым известным способом.

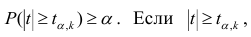

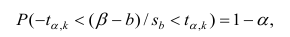

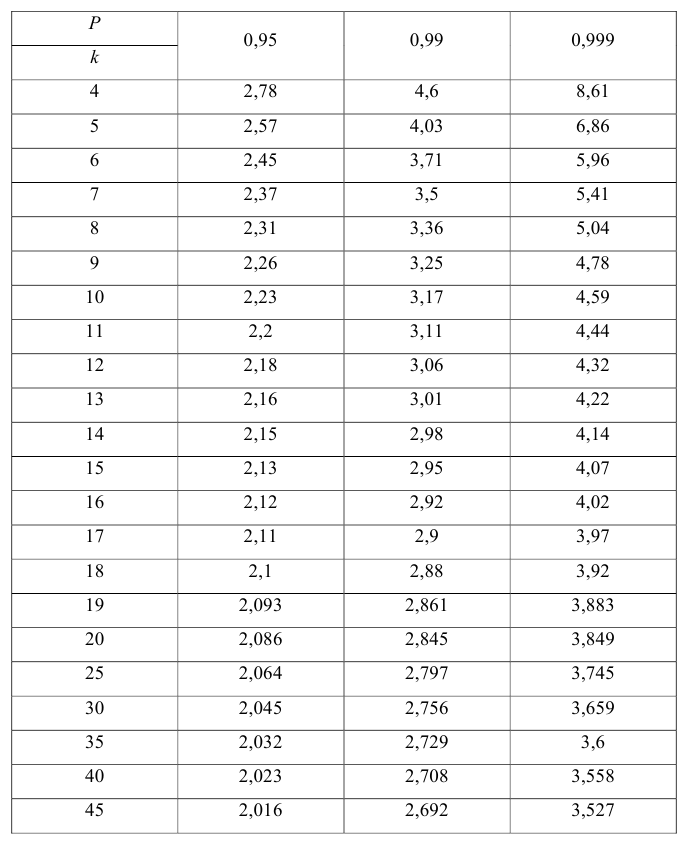

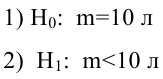

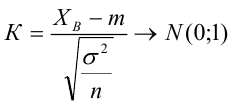

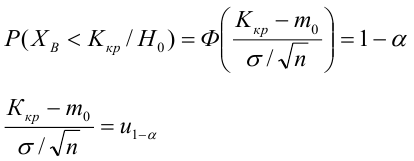

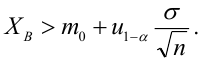

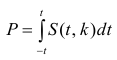

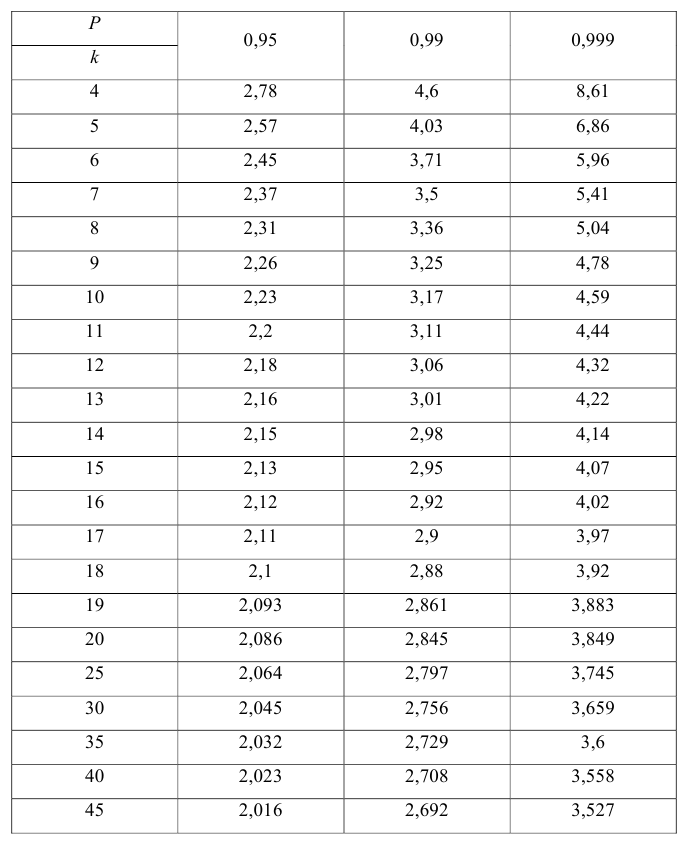

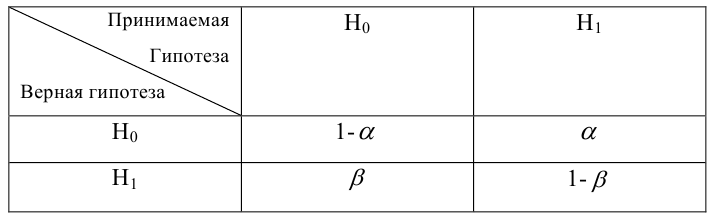

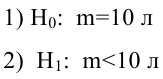

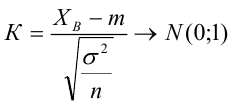

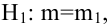

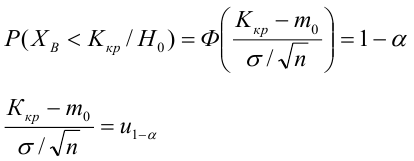

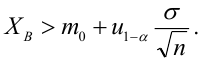

Оценка значимости коэффициентов регрессии. Интервальная оценка коэффициентов регрессии

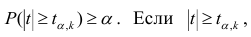

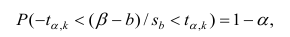

Проверить значимость оценок коэффициентов регрессии — значит установить, достаточна ли величина оценки для статистически обоснованного вывода о том, что коэффициент регрессии отличен от нуля. Для этого проверяют гипотезу о равенстве нулю коэффициента регрессии, соблюдая предпосылки «нормальной регрессии». В этом случае вычисляемая для проверки нулевой гипотезы  статистика

статистика

имеет распределение Стьюдента с к= n-2 степенями свободы (b — оценка коэффициента регрессии,  — оценка среднеквадратического отклонения

— оценка среднеквадратического отклонения

коэффициента регрессии, иначе стандартная ошибка оценки). По уровню значимости а и числу степеней свободы к находят по таблицам распределения Стьюдента (см. табл. 1 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При нет оснований отвергать нулевую гипотезу.

нет оснований отвергать нулевую гипотезу.

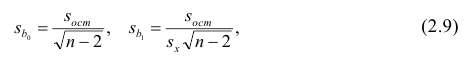

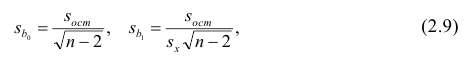

Оценки среднеквадратического отклонения коэффициентов регрессии вычисляют по следующим формулам:

где  — оценка остаточной дисперсии, вычисляемая по

— оценка остаточной дисперсии, вычисляемая по

формуле (2.5).

Доверительный интервал для значимых параметров строят по обычной схеме. Из условия

где а — уровень значимости, находим

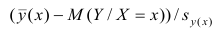

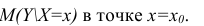

Интервальная оценка для условного математического ожидания

Линия регрессии характеризует изменение условного математического ожидания результативного признака от вариации остальных признаков.

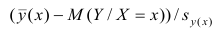

Точечной оценкой условного математического ожидания  является условное среднее

является условное среднее  Кроме точечной оценки для

Кроме точечной оценки для  можно

можно

построить доверительный интервал в точке

Известно, что  имеет распределение

имеет распределение

Стьюдента с k=n—2 степенями свободы. Найдя оценку среднеквадратического отклонения для условного среднего, можно построить доверительный интервал для условного математического ожидания

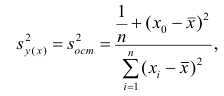

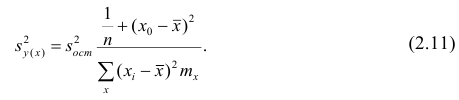

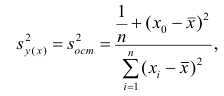

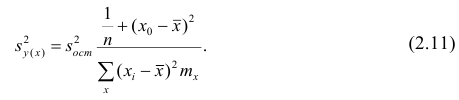

Оценку дисперсии условного среднего вычисляют по формуле

или для интервального ряда

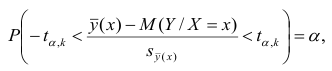

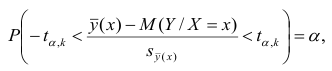

Доверительный интервал находят из условия

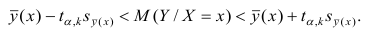

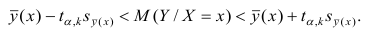

где а — уровень значимости. Отсюда

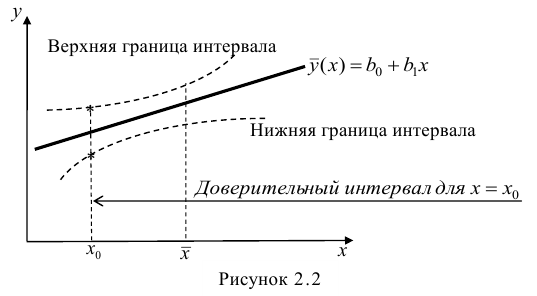

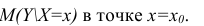

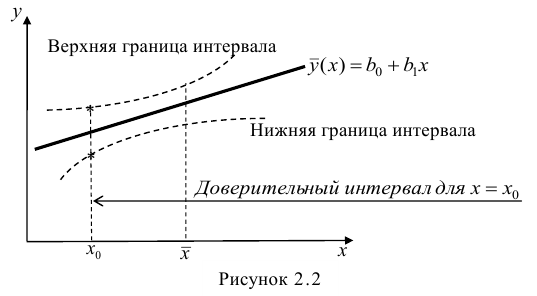

Доверительный интервал для условного математического ожидания можно изобразить графически (рис, 2.2).

Из рис. 2.2 видно, что в точке  границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

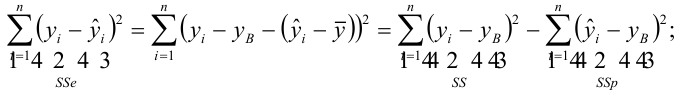

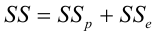

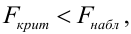

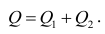

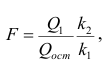

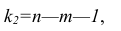

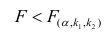

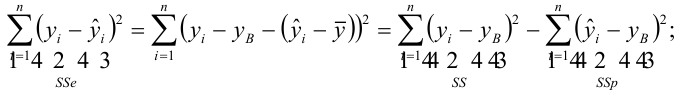

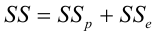

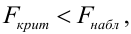

Проверка значимости уравнения регрессии

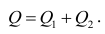

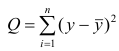

Оценить значимость уравнения регрессии — значит установить, соответствует ли математическая, модель, выражающая зависимость между Y и X, экспериментальным данным. Для оценки значимости в предпосылках «нормальной регрессии» проверяют гипотезу  Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением

Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением  — Общая сумма квадратов отклонений результативного признака

— Общая сумма квадратов отклонений результативного признака

разлагается на

разлагается на  (сумму, характеризующую влияние признака

(сумму, характеризующую влияние признака

X) и  (остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

(остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

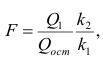

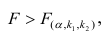

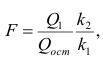

Для проверки нулевой гипотезы вычисляют статистику  которая имеет распределение Фишера-Снедекора с А

которая имеет распределение Фишера-Снедекора с А степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы

степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы  находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение

находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  . Если

. Если  нулевую гипотезу отвергают, уравнение считают значимым. Если

нулевую гипотезу отвергают, уравнение считают значимым. Если  то нет оснований отвергать нулевую гипотезу.

то нет оснований отвергать нулевую гипотезу.

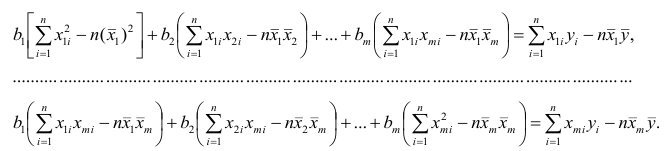

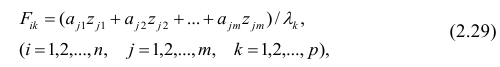

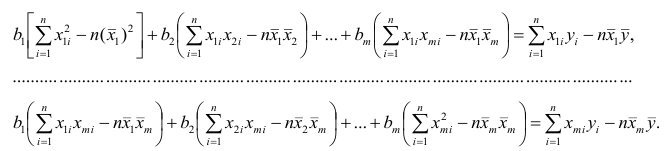

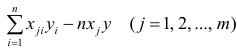

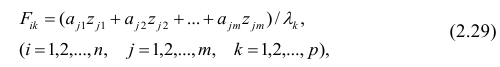

Многомерный регрессионный анализ

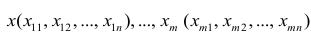

В случае, если изменения результативного признака определяются действием совокупности других признаков, имеет место многомерный регрессионный анализ. Пусть результативный признак У, а независимые признаки  Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним

Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним  и постоянной дисперсией

и постоянной дисперсией  — линейно независимые векторы

— линейно независимые векторы  . Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

. Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

Оценке подлежат параметры  и остаточная дисперсия.

и остаточная дисперсия.

Заменив параметры их оценками, запишем уравнение регрессии

Коэффициенты в этом выражении находят методом наименьших квадратов.

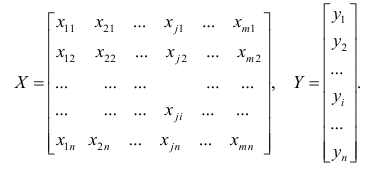

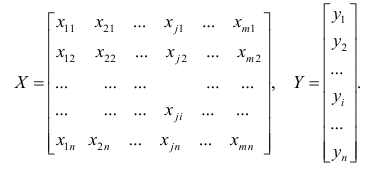

Исходными данными для вычисления коэффициентов  является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

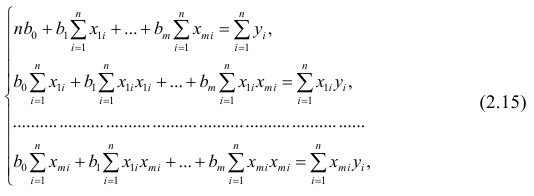

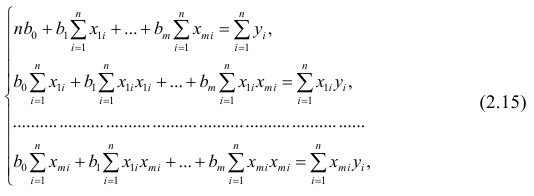

Как и в двумерном случае, составляют систему нормальных уравнений

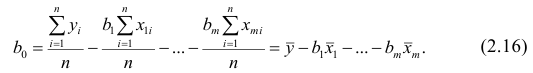

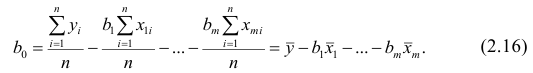

которую можно решить любым способом, известным из линейной алгебры. Рассмотрим один из них — способ обратной матрицы. Предварительно преобразуем систему уравнений. Выразим из первого уравнения значение  через остальные параметры:

через остальные параметры:

Подставим в остальные уравнения системы вместо  полученное выражение:

полученное выражение:

Пусть С — матрица коэффициентов при неизвестных параметрах

— матрица, обратная матрице С;

— матрица, обратная матрице С;  — элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы

— элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы — выражение

— выражение

. Тогда, используя формулы линейной алгебры,

. Тогда, используя формулы линейной алгебры,

запишем окончательные выражения для параметров:

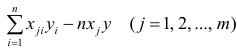

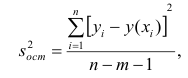

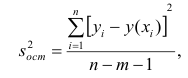

Оценкой остаточной дисперсии является

является

где  — измеренное значение результативного признака;

— измеренное значение результативного признака; значение результативного признака, вычисленное по уравнению регрессий.

значение результативного признака, вычисленное по уравнению регрессий.

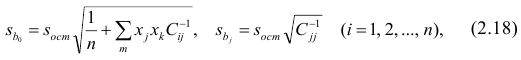

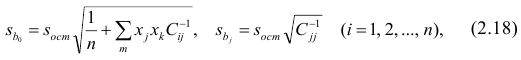

Если выборка получена из нормально распределенной генеральной совокупности, то, аналогично изложенному в п. 2.4, можно проверить значимость оценок коэффициентов регрессии, только в данном случае статистику вычисляют для каждого j-го коэффициента регрессии

вычисляют для каждого j-го коэффициента регрессии

где  —элемент обратной матрицы, стоящий на пересечении i-й строки и j-

—элемент обратной матрицы, стоящий на пересечении i-й строки и j-

го столбца; —диагональный элемент обратной матрицы.

—диагональный элемент обратной матрицы.

При заданном уровне значимости а и числе степеней свободы к=n— m—1 по табл. 1 приложений находят критическое значение  Если

Если то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

Для значимых коэффициентов регрессии целесообразно построить доверительные интервалы по формуле (2.10). Для оценки значимости уравнения регрессии следует проверить нулевую гипотезу о том, что все коэффициенты регрессии (кроме свободного члена) равны нулю:

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики