В этой статье мы собрали и описали ошибки, с которыми на практике столкнулись наши специалисты, разбирая заявки, поступившие в SiteСlinic в прошлом году. Эта статья не ориентирована на продвинутых SEO-специалистов, а вот начинающие оптимизаторы могут найти в ней тот «камень», который тормозит развитие их проектов.

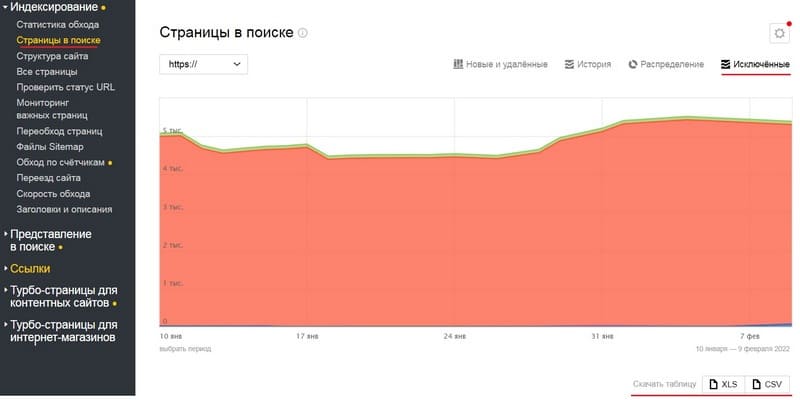

1. Тестовая версия сайта не закрыта от индексации

Разработчики часто создают копии сайта, на которых тестируют изменения. У многих проектов после редизайна сохраняется старая версия, которая была использована во время переноса контента. Такие служебные копии сайта обычно закрывают от индексации в файле robots.txt, но из-за ошибок (удаление robots или запрет на индексацию) копии могут попасть в индекс.

Чем грозит:

Страницы тестовой версии могут посчитаться дублями продвигаемых страниц и потому стать причиной ухудшения позиций.

Тестовый сайт может быть признан основным зеркалом (бывает и такое, случай из практики).

Как исправить:

Все разработчики понимают, что служебные версии сайта нужно запрещать к индексации. Но присутствует человеческий фактор, который невозможно исключить полностью. Чтобы снизить риск ошибки, рекомендуем не только запрещать индексацию тестовой версии, но и делать её доступной по паролю. Это поможет снизить риски того, что копия попадёт в индекс.

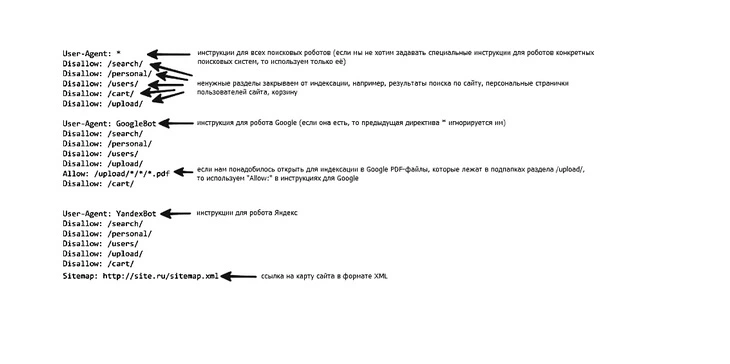

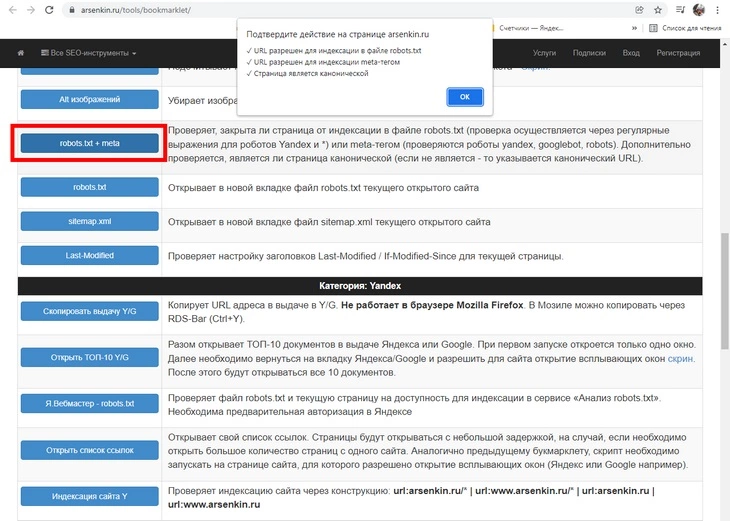

2. Ошибочное использование атрибута Disallow в robots.txt

При исключении из индекса служебных страниц и страниц-дублей можно легко ошибиться и удалить нужные страницы или целые разделы.

Чем грозит:

Из индекса пропадут полезные страницы вместе с позициями и трафиком.

Одной неправильно прописанной директивой в этом файле вы легко можете запретить весь сайт к индексации.

Как исправить:

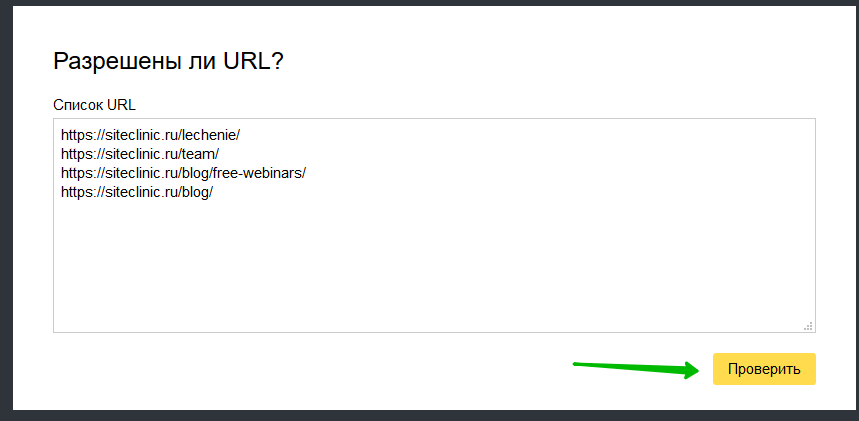

Проверьте файл на наличие ошибок инструментом «Анализ robots.txt». Найти его можно в панели Яндекс Вебмастера, вкладка «Инструменты».

Проверьте основные типы страниц вашего сайта на доступность к индексации.

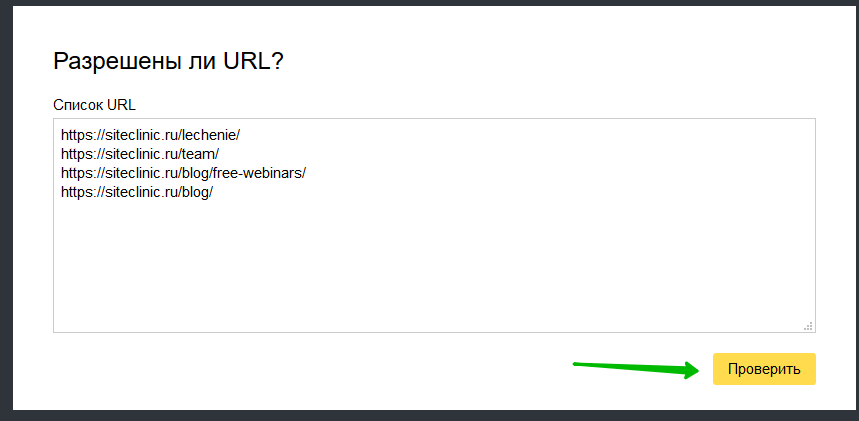

Для этого добавьте в блок «Разрешены ли URL?» интересующие вас адреса страниц и нажмите на кнопку «Проверить».

Рекомендуем использовать этот инструмент при любых корректировках robots.txt.

3. Отсутствие закрывающего тега noindex

Чтобы служебная часть текста не попадала в индекс, в Яндексе предусмотрен тег <noindex>.

Если вы забыли закрыть тег, то от индексации будет закрыт не только служебный текст, но и полезная часть контента.

Чем грозит:

Заключённая в noindex часть текста не будет учитываться при обработке страницы, что может негативно сказаться на её позициях.

Как исправить:

Не стоит злоупотреблять тегом. Алгоритмы Яндекса хорошо отличают служебные страницы от основного контента. Если вы всё-таки используете тег на страницах сайта, то откройте код и убедитесь в следующем:

- число закрывающих тегов noindex соответствует числу открывающих;

- закрывающий тег стоит сразу после конца блока со служебной информацией.

4. Неправильное использование тега noindex

Гораздо чаще встречается ситуация с неправильным использованием тега в целях «оптимизации».

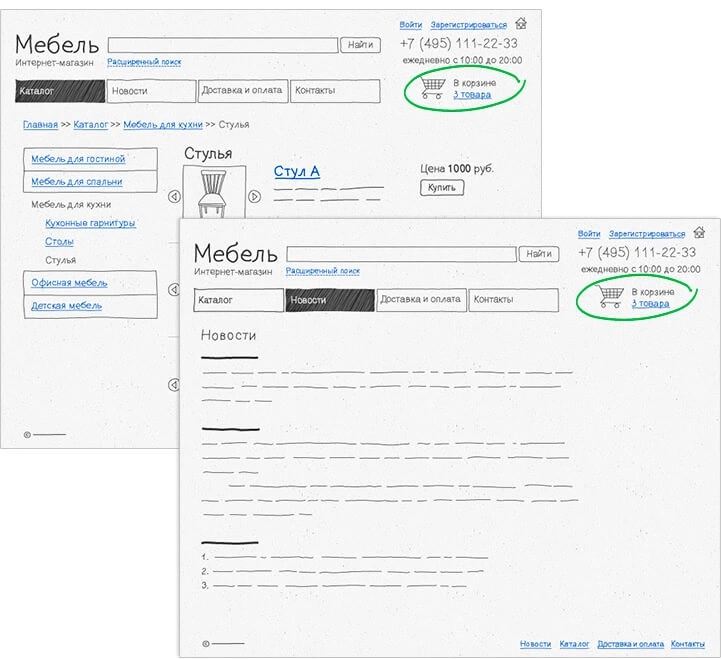

Чтобы сделать больше акцента на контенте страницы, от индексации прячут важные части страницы: шапку сайта с контактной информацией, навигационные блоки, фильтры, информацию о доставке, ссылки на соцсети, отзывы.

Чем грозит:

Ошибка грозит проблемами с ранжированием по продвигаемым запросам.

При оценке страницы оценивается её информативность, насколько полно она отвечает на запросы пользователя. Пряча от Яндекса блоки с дополнительной информацией, вы ухудшаете оценку качества страницы.

Как исправить:

Откройте блоки с важной для пользователей информацией к индексации. Если вы сомневаетесь, нужно ли открывать блок, проведите небольшой эксперимент и сначала откройте блок на нескольких тестовых страницах.

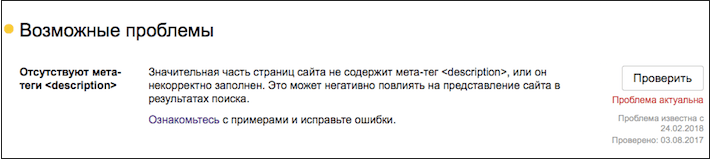

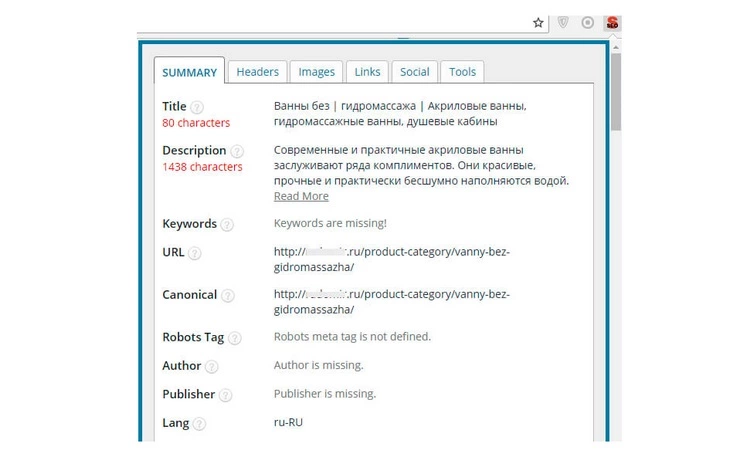

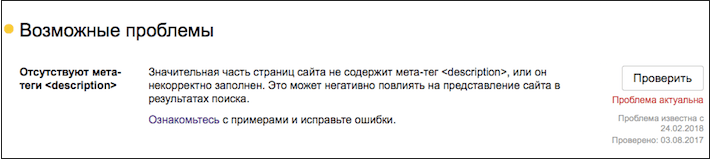

5. Заполнение метаданных и заголовков только для продвигаемых страниц

Подготовить уникальные и релевантные контенту Title и Description нужно не только для продвигаемых страниц, но и для всего сайта. При этом не надо исключать страницы со служебной информацией («Контакты», «О нас», «Доставка» и проч.).

Чем грозит:

- ухудшается общая оценка качества проекта;

- вы теряете дополнительный поисковый трафик, который могли бы приносить неоптимизированные страницы.

Как исправить:

Заполнить Title и Description для всех страниц сайта. Если страниц много, используйте для заполнения шаблоны.

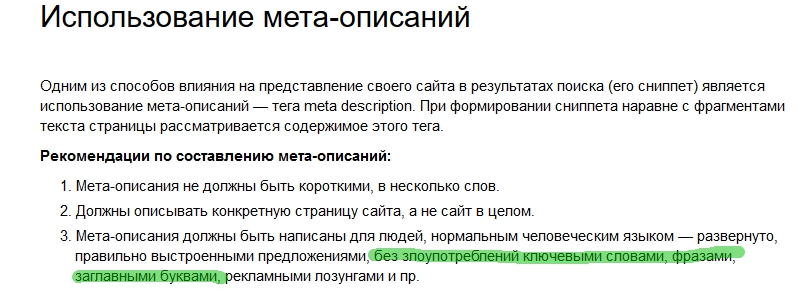

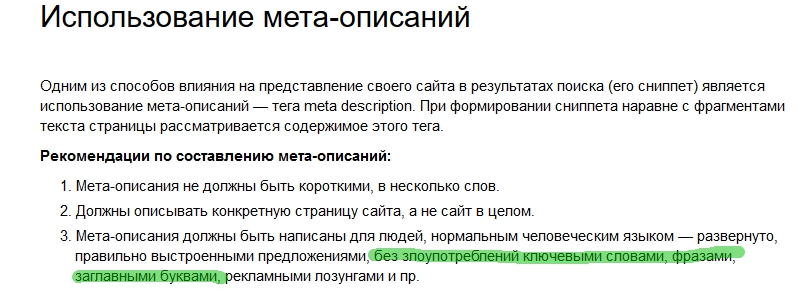

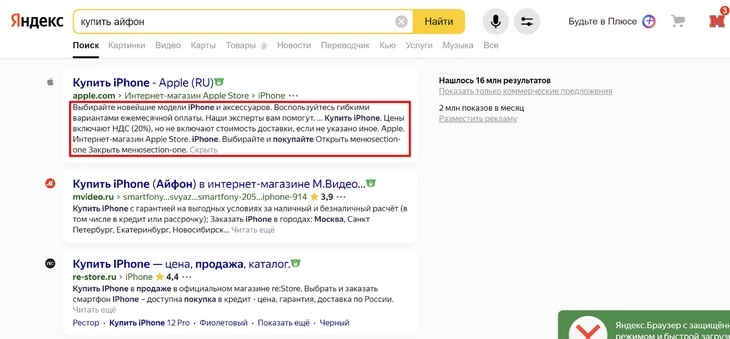

6. Использование заглавных букв в метаданных

Чтобы сделать сниппет страницы более заметным, оптимизаторы иногда используют в метаданных и заголовках заглавные буквы. Если такое написание противоречит правилам русского языка, подобное заполнение может быть расценено как спам.

Подробнее ознакомиться с рекомендациями Яндекса вы можете тут.

Чем грозит:

Страница может быть понижена в поисковой выдаче. Если ошибок на сайте много и есть другие признаки поискового спама, то санкции могут быть применены ко всему сайту.

Как исправить:

Заменить заглавные буквы строчными.

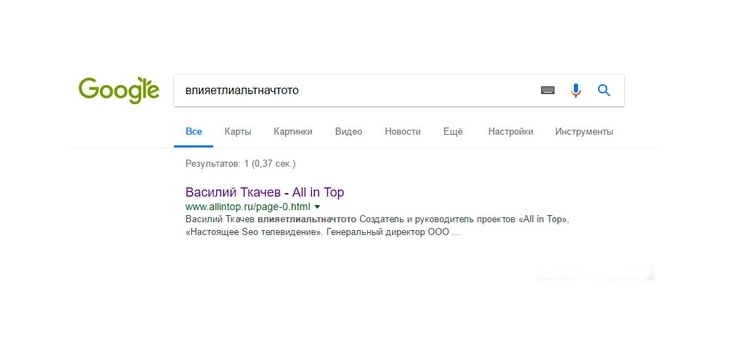

Больше информации о том, что поисковые алгоритмы воспринимают как переоптимизацию, вы получите в нашем блоге:

Как почистить сайт от переоптимизации: видео и текст вебинара

Что делать с переоптимизацией сайта, или Печальный опыт Винни-Пуха

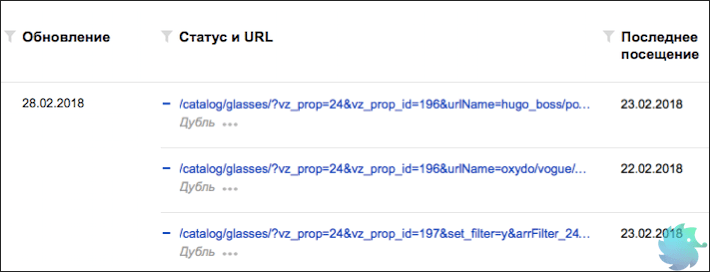

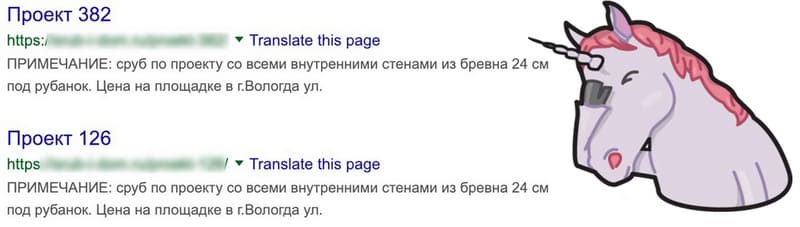

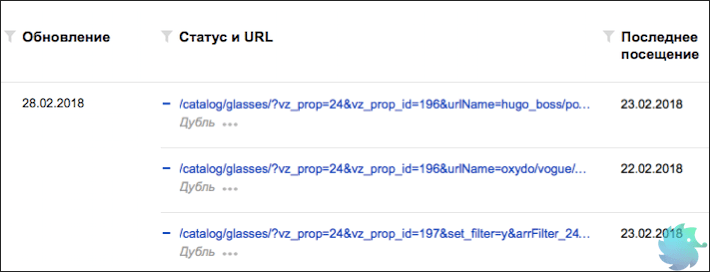

7. Дублирование страниц из-за ошибок в структуре сайта

Такое дублирование чаще встречается на сайтах интернет-магазинов, когда одна и та же товарная карточка находится в разных разделах каталога.

Например:

site.ru/страна/производитель/товарная карточка-25

site.ru/каталог/раздел/товарная карточка-25

Чем грозит:

- ухудшается скорость индексации сайта;

- страницы могут конкурировать в поисковой выдаче, что затрудняет продвижение.

Как исправить:

Возможны три варианта решения:

А) Можно поместить все товарные карточки в одну папку и так уйти от привязки одной карточки к разным разделам сайта. Независимо от того, как пользователь нашёл товар на сайте, он будет попадать на один и тот же адрес товарной карточки.

Пример:

site.ru/товары/товарная карточка-25

Этот вариант подходит для сайтов с большим количеством подкатегорий. Карточки при таком решении не будут уходить на пятый и более уровень вложенности.

Б) Оставить один адрес страницы как основной, а с остальных карточек настроить 301 редирект на основной адрес страницы.

Технически это решит проблему дублирования, но может запутать пользователей, переадресованных из одной категории в другую.

В) Оставить один адрес страницы как основной, а на остальных карточках указать основную страницу как каноническую.

В этом случае пользователя не будет никуда перебрасывать, а сайт избавится от дублей.

8. Дубль на первой странице пагинации

Ещё одна проблема с дублированием, которая часто встречается на сайтах. Основная страница и первая страница пагинации – это одна и та же страница, она должна быть доступна по одному и тому же адресу. Однако разработчики часто не учитывают этого, из-за чего возникают дубли.

Пример дублирования:

site.ru/каталог/раздел/

site.ru/каталог/раздел?page1

Чем грозит:

- расходуется краулинговый бюджет сайта, ухудшается его индексация;

- дубль может мешать продвижению основной страницы.

Как исправить:

- первая ссылка в пагинации должна вести на основную страницу;

- если дубль уже есть, то нужно не только исправить ссылку, но и настроить 301 редирект.

В этой статье мы привели только две распространённые ошибки из-за дублирования страниц. На самом деле ситуаций, когда на сайте могут появляться дубли, гораздо больше, и это тема отдельной статьи. О том, как найти и устранить дубли, можно прочитать в статье об опасности дублей.

9. Ошибка в использовании канонических адресов

Для всех страниц сайта (в независимости от того, нужна она в индексе или нет) адрес самой страницы прописан как канонический. Очень банальная ошибка, но часто встречающаяся. Возникает такая ситуация, когда программист получил задачу прописать канонические адреса, а вот заглянуть в справку Яндекса или Google поленился.

Чем грозит:

Страницы-дубли останутся на сайте, вследствие чего будут ухудшать его индексацию и затруднять продвижение.

Как исправить:

Прочитать рекомендации Яндекса или советы Google и настроить всё правильно.

Рекомендуем также прочесть список распространённых ошибок при настройке канонических адресов, который подготовили специалисты Google.

10. На сайте настроен 302 редирект вместо 301

Чтобы страницы сайта «склеились» корректно, нужно использовать 301 редирект – он показывает, что страница навсегда изменила адрес. Но по умолчанию на сервере часто используется 302 редирект (временная смена адреса).

Чем грозит:

В поисковой выдаче может остаться старая версия страницы. Вы также рискуете потерять параметры старой версии страницы.

Как исправить:

Настроить 301 редирект. О том, как это сделать, можно прочитать в старой, но до сих пор актуальной статье Сергея Кокшарова.

Также отметим: недавно представители Google объявили, что ссылочный вес при использовании 302 редиректа сохраняется.

Яндекс правил пока не менял.

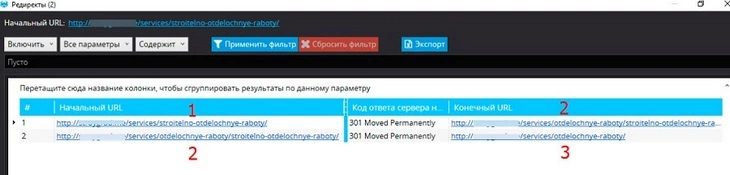

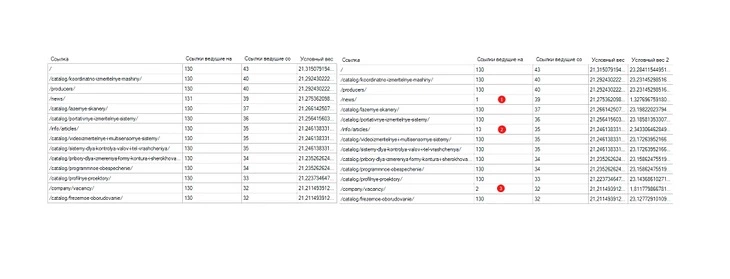

11. Внутренние ссылки на сайте работают через редирект

Поясним на примере. Такая ситуация может возникнуть, когда на всём сайте настроен редирект на версию страницы со слешем на конце, в то время как внутренние ссылки ведут на страницы без слеша. Кликнув по ссылке, вы вначале попадёте на несуществующую страницу без слеша и только потом переадресуетесь на правильный адрес. Пользователи сайта таких промежуточных редиректов обычно не замечают, а вот роботы поисковых систем обращают на это внимание.

Чем грозит:

Подобные редиректы создают лишнюю нагрузку на сервер и съедают часть краулингового бюджета сайта.

Как исправить:

Для исправления ситуации необходимо сделать так, чтобы все внутренние ссылки вели на нужные страницы без дополнительных редиректов.

Ошибка чаще бывает не на всех страницах, а только в одном блоке или разделе. Чтобы найти подобные ссылки, стоит проанализировать сайт полностью. В сети есть много сервисов для автоматического анализа сайта. Подобрать подходящий сервис можно на Netor.ru.

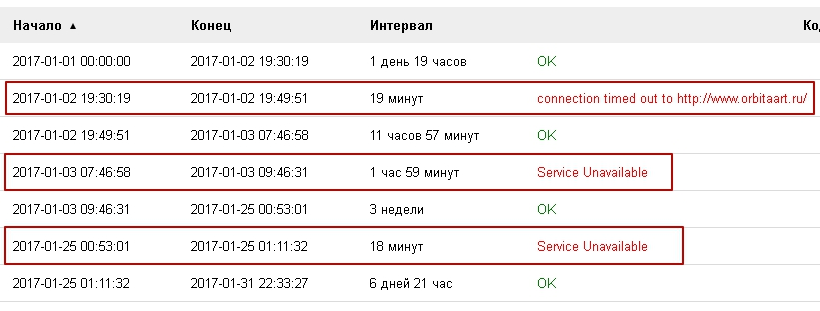

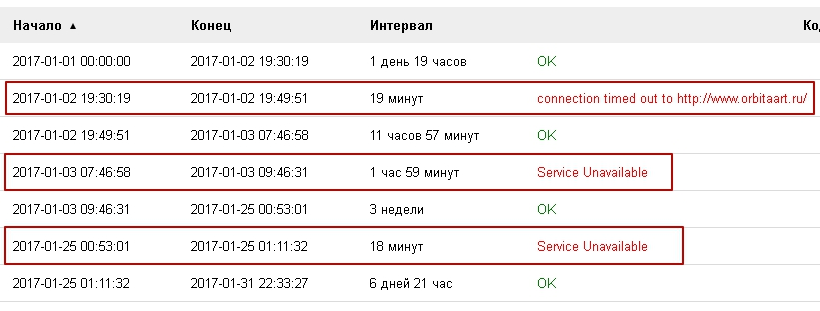

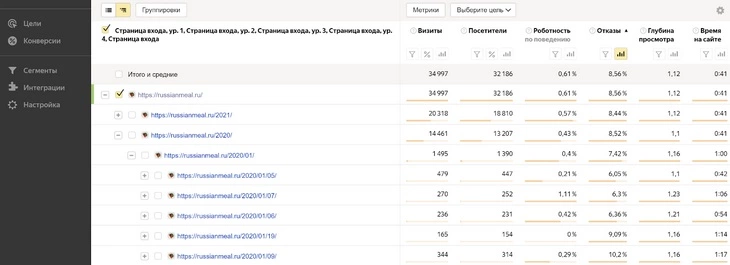

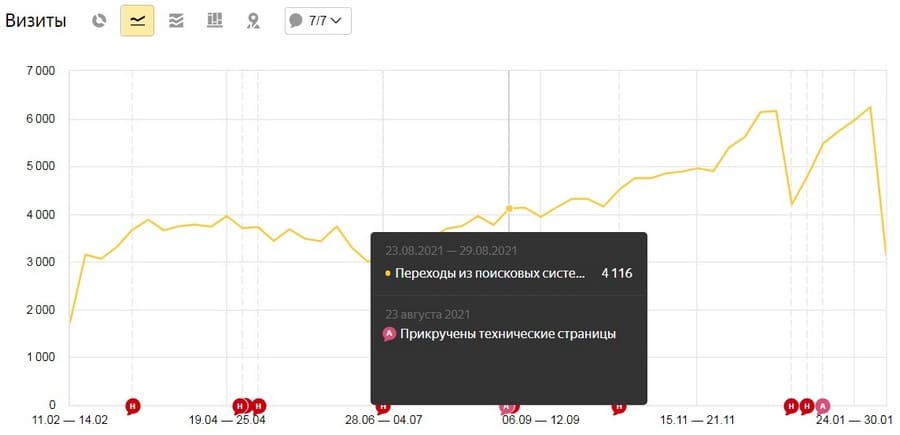

12. Сайт часто недоступен

Проблемы с доступностью сайта бывают практически у всех проектов. Если ваш сайт недоступен раз в месяц в течение 10-30 минут, то это вряд ли помешает его развитию. А вот более частые и продолжительные падения – это повод для беспокойства.

Чем грозит:

Регулярные проблемы с доступностью сайта снижают авторитет проекта с позиции поисковых алгоритмов и могут стать причиной временного выпадения страниц из индекса.

Как исправить:

В первую очередь следует проверить, как часто недоступен сайт. Сделать это можно в отчётах Яндекс Метрики.

Отчёты -> Стандартные отчёты -> Мониторинг -> Результаты проверок

Если вы видите, что проблемы возникают часто, свяжитесь с поддержкой хостинга. Если общение с хостингом не принесло результатов, перейдите на более надёжный хостинг.

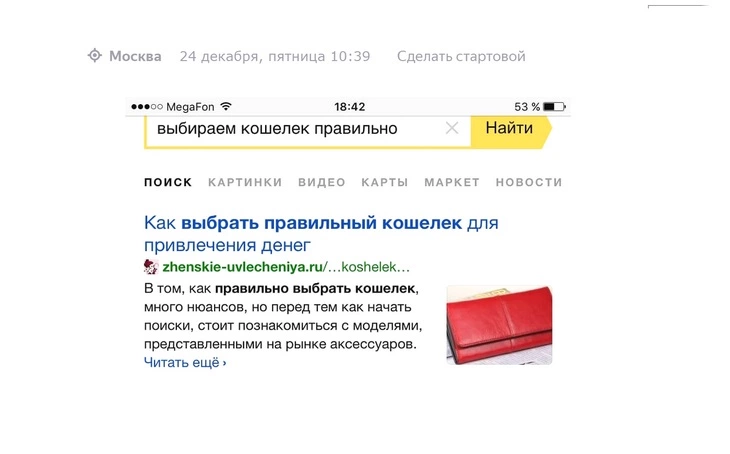

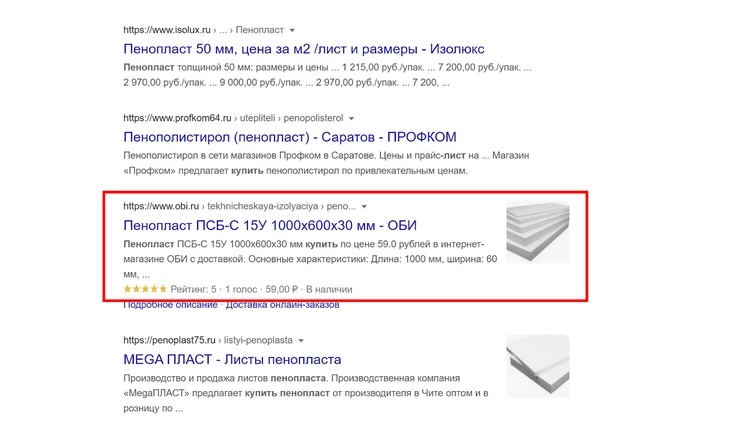

13. Отсутствие у сайта Favicon

Favicon сегодня есть у большинства сайтов, но из-за ошибок (удаление файла или ссылки на него из кода) он может пропасть.

![]()

Чем грозит:

Сниппеты без Favicon становятся менее заметными. Уменьшается количество переходов на сайт из поисковой выдачи.

Как исправить:

О настройке Favicon подробно написано в официальной справке Яндекса.

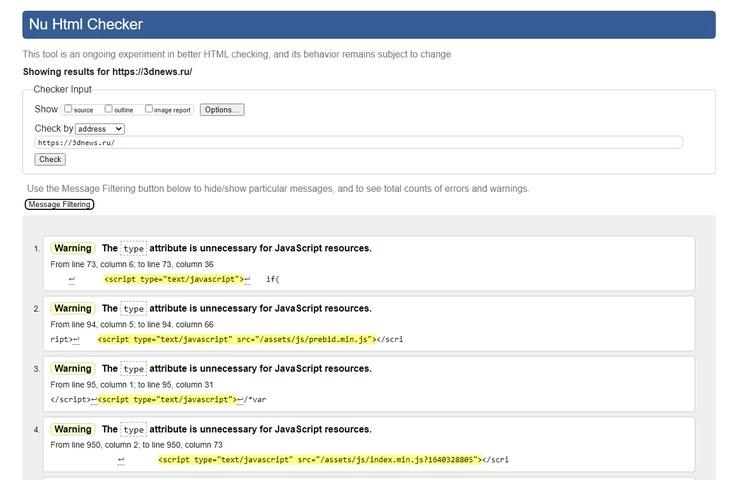

14. Скрипты, стили, служебная информация в коде страниц

Чтобы страницы сайта быстро подгружались, код должен быть максимально лёгким. Все стили, скрипты, служебные файлы должны быть по максимуму вынесены из кода страниц. Но на практике в процессе развития и доработки сайта код обрастает большим количеством мусора. При анализе кода сайта часто можно найти блоки закомментированного кода, который уже не используется.

Чем грозит:

- увеличивается время загрузки страниц;

- уменьшается скорость индексации страниц.

Как исправить:

- проверить, все ли подгружаемые стили и скрипты нужны для работы сайта и отдельных страниц. Бывает так, что функционал, используемый только на одном типе страниц, подгружается на все страницы сайта;

- вынести из кода стили CSS и скрипты;

- удалить или вынести из кода закомментированный код и служебные блоки.

15. Контактная информация в шапке в виде картинок

Для коммерческих сайтов важно, чтобы контактная информация была доступна пользователю, а основные способы связи находились в шапке сайта. При этом нужно учитывать, что поисковые алгоритмы не умеют корректно распознавать текст на картинках. Поэтому вся важная для пользователей информация должна быть размещена в виде текста.

Чем грозит:

Наличие ошибки будет препятствовать росту позиций по коммерческим запросам.

Как исправить:

Переверстать шапку сайта – разместить важную информацию в виде текста.

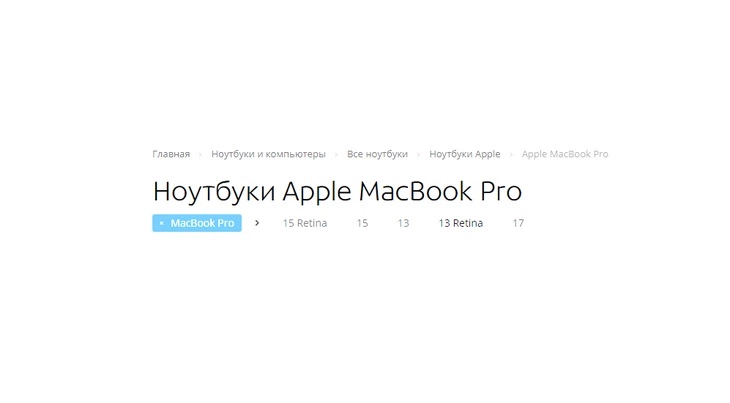

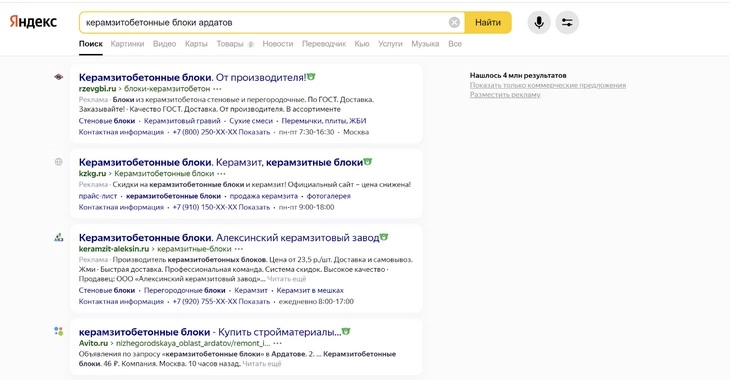

16. Отсутствие на продвигаемых страницах информации о цене

Указание цены принципиально важно для ранжирования по коммерческим запросам. Одно только добавление цен на страницу может дать значительный скачок в позициях.

Чем грозит:

Отсутствие информации о стоимости товаров или услуг влияет на ранжирование по коммерческим запросам.

Как исправить:

Просмотрите сайты конкурентов в выдаче по интересующим вас запросам. Сделать это можно вручную, а можно воспользоваться специальными сервисами. Например, такой функционал есть у SeoLib.

Если большинство конкурентов указывает цены, то нужно разместить их и на ваших продвигаемых страницах.

Чаще всего встречаются следующие ситуации:

А) Цены не указывают на категорийных страницах и размещают их только на товарных карточках.

Тут всё просто. Если вы планируете продвигать страницы по коммерческим запросам, укажите информацию о стоимости.

Б) Нет информации о ценах на главной странице.

На главной странице можно поместить блок с популярными товарами или новинками. Для сферы услуг это может быть таблица с ценами на наиболее популярные услуги.

В) В некоторых тематиках цены не указывают специально, так как конечная цена зависит от курса валют или ряда дополнительных факторов.

В таких случаях можно указывать:

- цену «От» или базовую цену;

- диапазон цен;

- информацию о том, что окончательную стоимость нужно уточнить у менеджера.

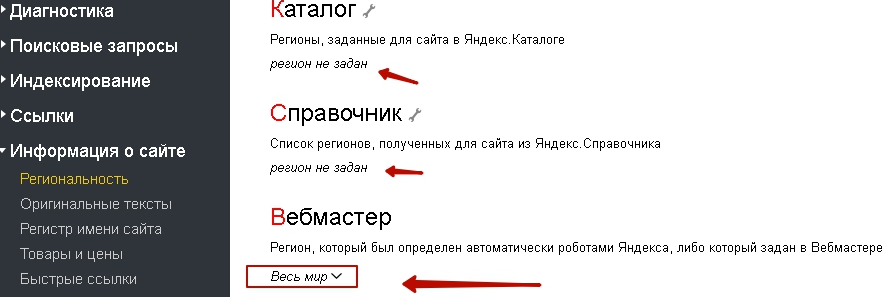

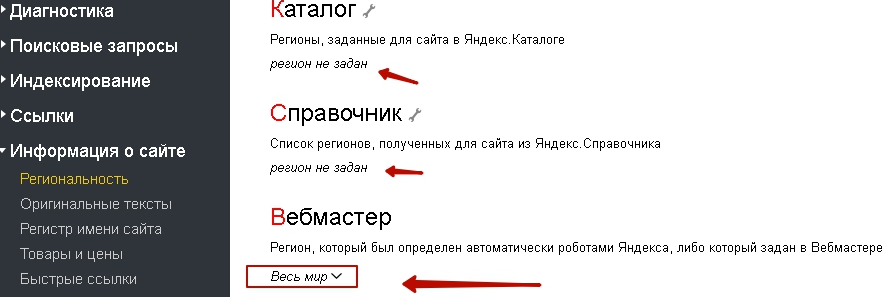

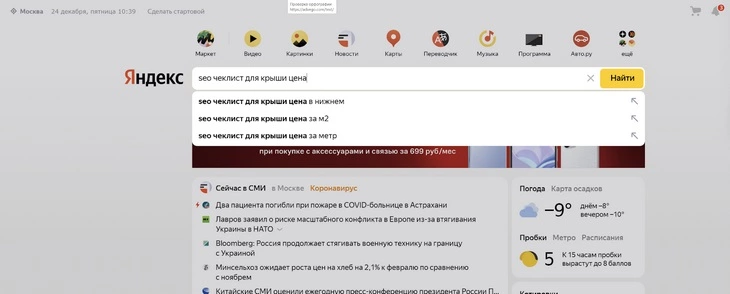

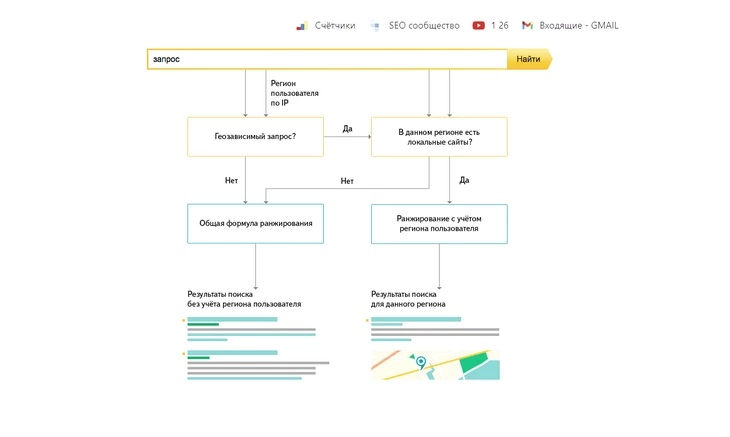

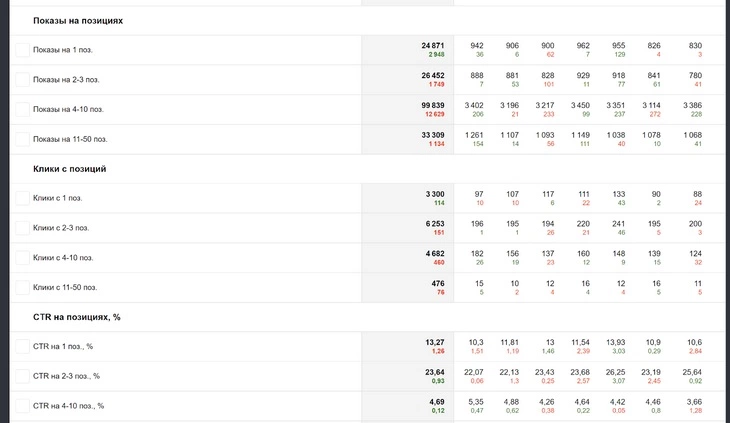

17. Ошибка в выборе региона

Для ранжирования в Яндексе по геозависимым запросам принципиально важно, какой регион присвоен сайту. Если сайту присвоен регион «Иваново» или «Мытищи», то вы уже не сможете конкурировать в выдаче по региону «Москва». Ошибкой будет и присвоение слишком широкого региона, например, «Россия» или «Весь мир». Регион должен быть указан максимально точно.

Чем грозит:

Ошибка грозит отсутствием высоких позиций по конкурентным запросам в нужном регионе.

Для продвижения в Москве по геозависимым запросам сайту должен быть присвоен регион «Москва». В противном случае вы будете проигрывать конкурентам, у которых есть такая привязка.

Как исправить:

Посмотреть, какой регион присвоен сайту, можно в панели Яндекс Вебмастера, вкладка «Информация о сайте».

Присвоить сайту нужный регион можно таким образом:

- указать привязку в панели Яндекс Вебмастера. Заявка после рассмотрения будет принята или отклонена;

- добавить адрес в Яндекс Справочник. Этим способом можно присвоить сайту много регионов;

- добавить сайт в Яндекс Каталог. После добавления можно присвоить сайту до 7 регионов.

Следует отметить, что сотрудники Яндекса часто проверяют информацию о наличии у компании офиса по указанному адресу. В последнее время к процессу проверки подключены также пользователи сервиса Toloka.

Подробнее о вопросах регионального ранжирования можно узнать в этих статьях:

Региональное продвижение в Яндекс и Google

Особенности регионального ранжирования в Яндексе

18. Ошибка в настройке ответа 404

Если пользователь обращается к несуществующей странице, сервер должен отдать ответ 404. Посетители должны увидеть страницу с сообщением об ошибке и предложением перейти на рабочие страницы сайта.

Чем грозит:

Если на сайте нет юзабильной страницы 404, вы рискуете потерять часть посетителей.

Неправильная настройка ответа 404 грозит сайту появлением в индексе дублей или малополезных страниц.

Как исправить:

Подробные рекомендации по настройке 404 ответа есть у Яндекса и у Google.

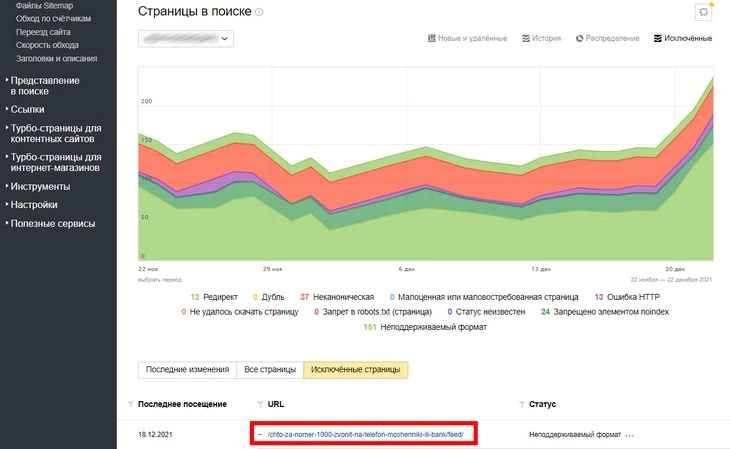

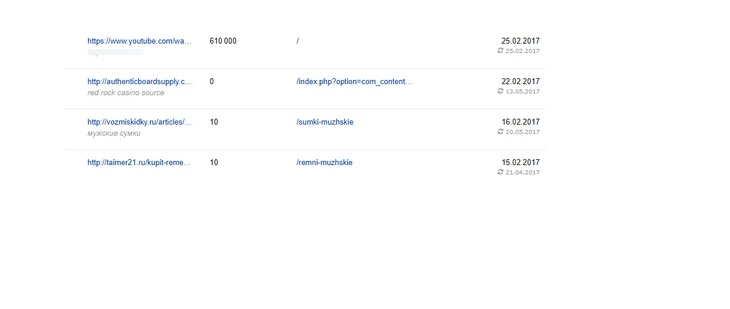

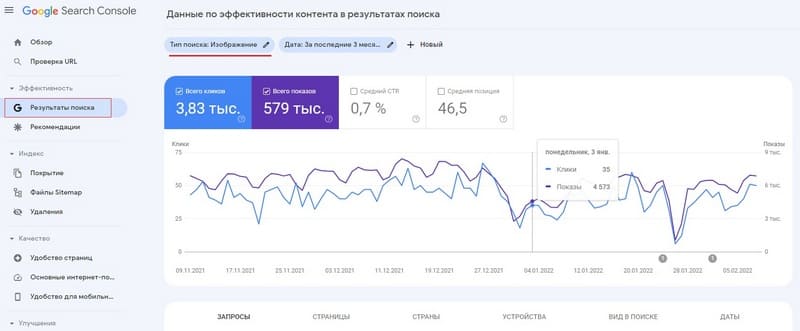

19. Ошибки в файле sitemap.xml

Наличие файла sitemap.xml может давать плюс к индексированию новых страниц сайта. Но если редко его обновлять или изначально создать файл с ошибками, то он может стать источником проблем на сайте. Такой файл будет больше вредить, чем помогать развитию. Если вы не можете поддерживать данные в карте сайта в актуальном состоянии, лучше удалите такой файл.

Чем грозит:

- из-за ошибок в файле в индекс могут попадать дубли и малополезные страницы сайта;

- ошибки в карте сайта могут ухудшать скорость индексации.

Как исправить:

- проверить файл на наличие ошибок специальными инструментами Яндекса и Google и устранить выявленные проблемы;

В панели Яндекс Вебмастера: «Анализ файлов Sitemap», вкладка «Инструменты».

В Google Search Console: «Файлы Sitemap», вкладка «Сканирование». - настроить автоматическое обновление файла, если на сайте были добавлены или удалены страницы;

- при настройке файла руководствоваться официальными рекомендациями Яндекса и советами Google.

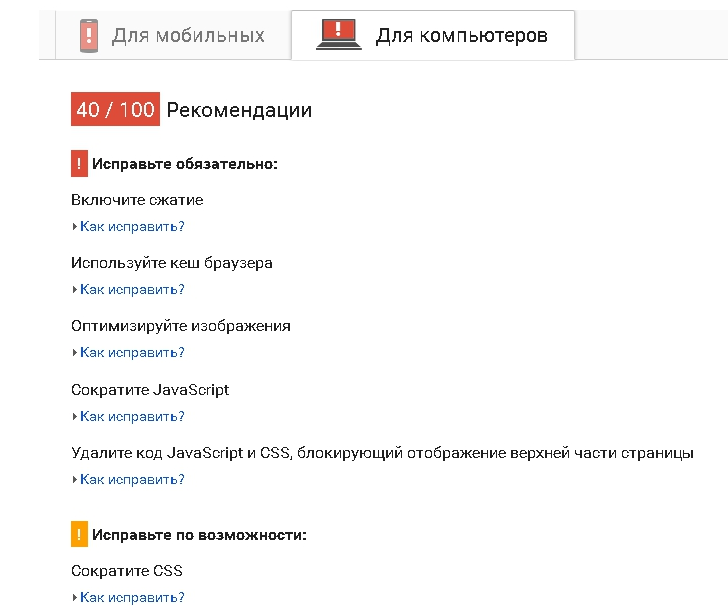

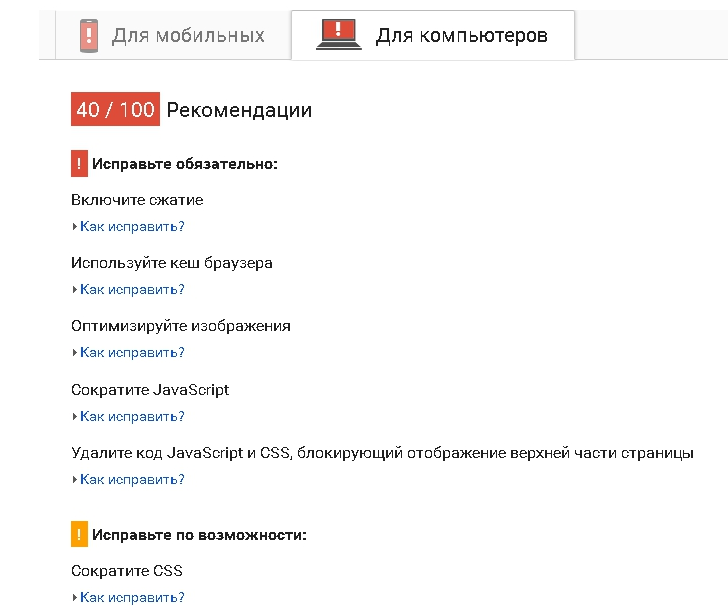

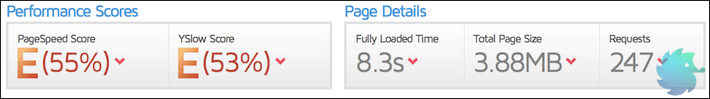

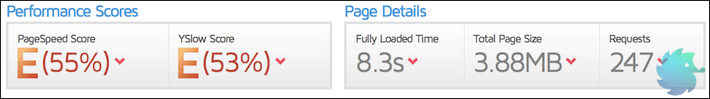

20. Низкая скорость загрузки

Скорость загрузки сайта – тот показатель, на который сегодня нельзя не обращать внимания. Поисковые алгоритмы выше ранжируют проекты с высокой скоростью загрузки и понижают сайты, у которых есть проблемы с этим показателем. От скорости загрузки зависит и поведение посетителя – останется ли он на вашем сайте или уйдёт к конкуренту.

Чем грозит:

- проблемы со скоростью загрузки могут влиять на позиции сайта в поисковой выдаче;

- ухудшаются поведенческие показатели;

- снижается число конверсий.

Как исправить:

В первую очередь необходимо понять, что тормозит скорость загрузки сайта.

Сделать это можно с помощью официального инструмента от разработчиков Google – Page Speed Insights. Сервис не только анализирует скорость загрузки, но и предлагает рекомендации по её улучшению.

Вам важно проверить скорость загрузки не только главной страницы сайта, но и внутренних страниц. Также нужно посмотреть отчёты по скорости загрузки в Яндекс Метрике или Google Analytics. Это позволит комплексно оценить скорость загрузки вашего проекта.

Заключение

Мы искренне надеемся, что перечисленные в статье ошибки помогут в развитии ваших проектов, но в заключение хотим сделать акцент на другом.

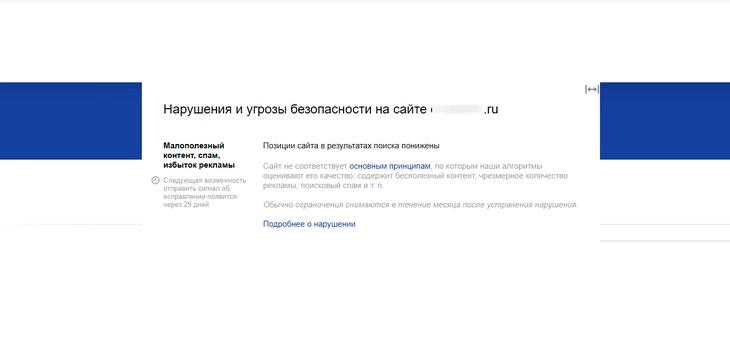

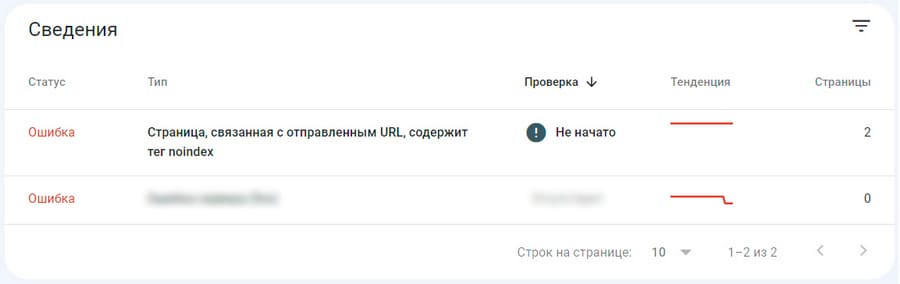

Ошибки в процессе внесения изменений на сайт – это нормальный процесс, тут нет ничего страшного. Серьёзные проблемы возникают в том случае, если эти ошибки не были своевременно выявлены и устранены. Но сегодня у вебмастеров есть отличные инструменты для нахождения ошибок и проблем на своём сайте – это панели Яндекс Вебмастер и Google Search Console.

Почти все сайты, владельцы которых обращаются к нам за помощью, добавлены в эти панели. Но пользуются ли этими панелями хозяева проектов? На практике мы видим, что как минимум у половины проектов в панелях висят сообщения об ошибках, на которые месяцами не обращают внимания.

Настоятельно рекомендуем регулярно (минимум раз в 2 недели) мониторить панели на предмет сообщений о проблемах на сайте.

Если ошибок на вашем сайте слишком много или вы не знаете, как правильно работать с проектом, обратитесь к нам. Мы проведём SEO-аудит сайта и расскажем, как вывести ваш проект в ТОП.

Еще по теме:

- Что делать с рекламой на сайте, или Чиним двигатель торговли

- Что такое LSI-ключи, как их найти и внедрить на сайт

- 6 функций Key Collector, которые заменят платные инструменты

- «Бессылочный» аудит сайта — готов ли Ваш магазин к отключению ссылочного ранжирования?

- Идеальная товарная карточка: как привлечь максимальное количество пользователей из органики и смотивировать их купить продукт

Мы не раз сталкивались с ситуациями, когда сайты были пессимизированы поисковой системой за переизбыток рекламы. Допустима ли реклама на сайте, где и в каких количествах ее лучше…

В этой статье речь пойдёт о том, что такое LSI, как и где искать LSI-запросы, как внедрить на сайт, и каких результатов можно достичь с…

Определение конкурентов при помощи функции SERP Кластеризация запросов при помощи функции «Анализ групп» в Key Collector Определение конкурентности запросов при помощи функции KEI Сбор поисковых…

Несколько дней назад, во время своего выступления на IBC Russia 2013, руководитель отдела веб-поиска Яндекса Александр Садовский шокировал всех оптимизаторов: в начале следующего года коммерческие…

Многие коммерческие сайты пренебрегают важностью оптимизации карточек товара. В особенности если в ассортименте интернет-магазина более тысячи товаров. Заполнять карточку товара нужно не только чтобы занять…

SEO-аналитик

Специализируюсь на продвижении коммерческих сайтов. Разрабатываю стратегии для интернет-магазинов и агрегаторов. Умею выжимать максимум трафика в любой тематике.

Руковожу SEO-процессами внутренних проектов SiteClinic. Обучаю молодых специалистов команды.

Любимая цитата: Хорошо смеётся тот, кто смеётся из ТОПа

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

В этой статье мы собрали и описали ошибки, с которыми на практике столкнулись наши специалисты, разбирая заявки, поступившие в SiteСlinic в прошлом году. Эта статья не ориентирована на продвинутых SEO-специалистов, а вот начинающие оптимизаторы могут найти в ней тот «камень», который тормозит развитие их проектов.

1. Тестовая версия сайта не закрыта от индексации

Разработчики часто создают копии сайта, на которых тестируют изменения. У многих проектов после редизайна сохраняется старая версия, которая была использована во время переноса контента. Такие служебные копии сайта обычно закрывают от индексации в файле robots.txt, но из-за ошибок (удаление robots или запрет на индексацию) копии могут попасть в индекс.

Чем грозит:

Страницы тестовой версии могут посчитаться дублями продвигаемых страниц и потому стать причиной ухудшения позиций.

Тестовый сайт может быть признан основным зеркалом (бывает и такое, случай из практики).

Как исправить:

Все разработчики понимают, что служебные версии сайта нужно запрещать к индексации. Но присутствует человеческий фактор, который невозможно исключить полностью. Чтобы снизить риск ошибки, рекомендуем не только запрещать индексацию тестовой версии, но и делать её доступной по паролю. Это поможет снизить риски того, что копия попадёт в индекс.

2. Ошибочное использование атрибута Disallow в robots.txt

При исключении из индекса служебных страниц и страниц-дублей можно легко ошибиться и удалить нужные страницы или целые разделы.

Чем грозит:

Из индекса пропадут полезные страницы вместе с позициями и трафиком.

Одной неправильно прописанной директивой в этом файле вы легко можете запретить весь сайт к индексации.

Как исправить:

Проверьте файл на наличие ошибок инструментом «Анализ robots.txt». Найти его можно в панели Яндекс Вебмастера, вкладка «Инструменты».

Проверьте основные типы страниц вашего сайта на доступность к индексации.

Для этого добавьте в блок «Разрешены ли URL?» интересующие вас адреса страниц и нажмите на кнопку «Проверить».

Рекомендуем использовать этот инструмент при любых корректировках robots.txt.

3. Отсутствие закрывающего тега noindex

Чтобы служебная часть текста не попадала в индекс, в Яндексе предусмотрен тег <noindex>.

Если вы забыли закрыть тег, то от индексации будет закрыт не только служебный текст, но и полезная часть контента.

Чем грозит:

Заключённая в noindex часть текста не будет учитываться при обработке страницы, что может негативно сказаться на её позициях.

Как исправить:

Не стоит злоупотреблять тегом. Алгоритмы Яндекса хорошо отличают служебные страницы от основного контента. Если вы всё-таки используете тег на страницах сайта, то откройте код и убедитесь в следующем:

- число закрывающих тегов noindex соответствует числу открывающих;

- закрывающий тег стоит сразу после конца блока со служебной информацией.

4. Неправильное использование тега noindex

Гораздо чаще встречается ситуация с неправильным использованием тега в целях «оптимизации».

Чтобы сделать больше акцента на контенте страницы, от индексации прячут важные части страницы: шапку сайта с контактной информацией, навигационные блоки, фильтры, информацию о доставке, ссылки на соцсети, отзывы.

Чем грозит:

Ошибка грозит проблемами с ранжированием по продвигаемым запросам.

При оценке страницы оценивается её информативность, насколько полно она отвечает на запросы пользователя. Пряча от Яндекса блоки с дополнительной информацией, вы ухудшаете оценку качества страницы.

Как исправить:

Откройте блоки с важной для пользователей информацией к индексации. Если вы сомневаетесь, нужно ли открывать блок, проведите небольшой эксперимент и сначала откройте блок на нескольких тестовых страницах.

5. Заполнение метаданных и заголовков только для продвигаемых страниц

Подготовить уникальные и релевантные контенту Title и Description нужно не только для продвигаемых страниц, но и для всего сайта. При этом не надо исключать страницы со служебной информацией («Контакты», «О нас», «Доставка» и проч.).

Чем грозит:

- ухудшается общая оценка качества проекта;

- вы теряете дополнительный поисковый трафик, который могли бы приносить неоптимизированные страницы.

Как исправить:

Заполнить Title и Description для всех страниц сайта. Если страниц много, используйте для заполнения шаблоны.

6. Использование заглавных букв в метаданных

Чтобы сделать сниппет страницы более заметным, оптимизаторы иногда используют в метаданных и заголовках заглавные буквы. Если такое написание противоречит правилам русского языка, подобное заполнение может быть расценено как спам.

Подробнее ознакомиться с рекомендациями Яндекса вы можете тут.

Чем грозит:

Страница может быть понижена в поисковой выдаче. Если ошибок на сайте много и есть другие признаки поискового спама, то санкции могут быть применены ко всему сайту.

Как исправить:

Заменить заглавные буквы строчными.

Больше информации о том, что поисковые алгоритмы воспринимают как переоптимизацию, вы получите в нашем блоге:

Как почистить сайт от переоптимизации: видео и текст вебинара

Что делать с переоптимизацией сайта, или Печальный опыт Винни-Пуха

7. Дублирование страниц из-за ошибок в структуре сайта

Такое дублирование чаще встречается на сайтах интернет-магазинов, когда одна и та же товарная карточка находится в разных разделах каталога.

Например:

site.ru/страна/производитель/товарная карточка-25

site.ru/каталог/раздел/товарная карточка-25

Чем грозит:

- ухудшается скорость индексации сайта;

- страницы могут конкурировать в поисковой выдаче, что затрудняет продвижение.

Как исправить:

Возможны три варианта решения:

А) Можно поместить все товарные карточки в одну папку и так уйти от привязки одной карточки к разным разделам сайта. Независимо от того, как пользователь нашёл товар на сайте, он будет попадать на один и тот же адрес товарной карточки.

Пример:

site.ru/товары/товарная карточка-25

Этот вариант подходит для сайтов с большим количеством подкатегорий. Карточки при таком решении не будут уходить на пятый и более уровень вложенности.

Б) Оставить один адрес страницы как основной, а с остальных карточек настроить 301 редирект на основной адрес страницы.

Технически это решит проблему дублирования, но может запутать пользователей, переадресованных из одной категории в другую.

В) Оставить один адрес страницы как основной, а на остальных карточках указать основную страницу как каноническую.

В этом случае пользователя не будет никуда перебрасывать, а сайт избавится от дублей.

8. Дубль на первой странице пагинации

Ещё одна проблема с дублированием, которая часто встречается на сайтах. Основная страница и первая страница пагинации – это одна и та же страница, она должна быть доступна по одному и тому же адресу. Однако разработчики часто не учитывают этого, из-за чего возникают дубли.

Пример дублирования:

site.ru/каталог/раздел/

site.ru/каталог/раздел?page1

Чем грозит:

- расходуется краулинговый бюджет сайта, ухудшается его индексация;

- дубль может мешать продвижению основной страницы.

Как исправить:

- первая ссылка в пагинации должна вести на основную страницу;

- если дубль уже есть, то нужно не только исправить ссылку, но и настроить 301 редирект.

В этой статье мы привели только две распространённые ошибки из-за дублирования страниц. На самом деле ситуаций, когда на сайте могут появляться дубли, гораздо больше, и это тема отдельной статьи. О том, как найти и устранить дубли, можно прочитать в статье об опасности дублей.

9. Ошибка в использовании канонических адресов

Для всех страниц сайта (в независимости от того, нужна она в индексе или нет) адрес самой страницы прописан как канонический. Очень банальная ошибка, но часто встречающаяся. Возникает такая ситуация, когда программист получил задачу прописать канонические адреса, а вот заглянуть в справку Яндекса или Google поленился.

Чем грозит:

Страницы-дубли останутся на сайте, вследствие чего будут ухудшать его индексацию и затруднять продвижение.

Как исправить:

Прочитать рекомендации Яндекса или советы Google и настроить всё правильно.

Рекомендуем также прочесть список распространённых ошибок при настройке канонических адресов, который подготовили специалисты Google.

10. На сайте настроен 302 редирект вместо 301

Чтобы страницы сайта «склеились» корректно, нужно использовать 301 редирект – он показывает, что страница навсегда изменила адрес. Но по умолчанию на сервере часто используется 302 редирект (временная смена адреса).

Чем грозит:

В поисковой выдаче может остаться старая версия страницы. Вы также рискуете потерять параметры старой версии страницы.

Как исправить:

Настроить 301 редирект. О том, как это сделать, можно прочитать в старой, но до сих пор актуальной статье Сергея Кокшарова.

Также отметим: недавно представители Google объявили, что ссылочный вес при использовании 302 редиректа сохраняется.

Яндекс правил пока не менял.

11. Внутренние ссылки на сайте работают через редирект

Поясним на примере. Такая ситуация может возникнуть, когда на всём сайте настроен редирект на версию страницы со слешем на конце, в то время как внутренние ссылки ведут на страницы без слеша. Кликнув по ссылке, вы вначале попадёте на несуществующую страницу без слеша и только потом переадресуетесь на правильный адрес. Пользователи сайта таких промежуточных редиректов обычно не замечают, а вот роботы поисковых систем обращают на это внимание.

Чем грозит:

Подобные редиректы создают лишнюю нагрузку на сервер и съедают часть краулингового бюджета сайта.

Как исправить:

Для исправления ситуации необходимо сделать так, чтобы все внутренние ссылки вели на нужные страницы без дополнительных редиректов.

Ошибка чаще бывает не на всех страницах, а только в одном блоке или разделе. Чтобы найти подобные ссылки, стоит проанализировать сайт полностью. В сети есть много сервисов для автоматического анализа сайта. Подобрать подходящий сервис можно на Netor.ru.

12. Сайт часто недоступен

Проблемы с доступностью сайта бывают практически у всех проектов. Если ваш сайт недоступен раз в месяц в течение 10-30 минут, то это вряд ли помешает его развитию. А вот более частые и продолжительные падения – это повод для беспокойства.

Чем грозит:

Регулярные проблемы с доступностью сайта снижают авторитет проекта с позиции поисковых алгоритмов и могут стать причиной временного выпадения страниц из индекса.

Как исправить:

В первую очередь следует проверить, как часто недоступен сайт. Сделать это можно в отчётах Яндекс Метрики.

Отчёты -> Стандартные отчёты -> Мониторинг -> Результаты проверок

Если вы видите, что проблемы возникают часто, свяжитесь с поддержкой хостинга. Если общение с хостингом не принесло результатов, перейдите на более надёжный хостинг.

13. Отсутствие у сайта Favicon

Favicon сегодня есть у большинства сайтов, но из-за ошибок (удаление файла или ссылки на него из кода) он может пропасть.

![]()

Чем грозит:

Сниппеты без Favicon становятся менее заметными. Уменьшается количество переходов на сайт из поисковой выдачи.

Как исправить:

О настройке Favicon подробно написано в официальной справке Яндекса.

14. Скрипты, стили, служебная информация в коде страниц

Чтобы страницы сайта быстро подгружались, код должен быть максимально лёгким. Все стили, скрипты, служебные файлы должны быть по максимуму вынесены из кода страниц. Но на практике в процессе развития и доработки сайта код обрастает большим количеством мусора. При анализе кода сайта часто можно найти блоки закомментированного кода, который уже не используется.

Чем грозит:

- увеличивается время загрузки страниц;

- уменьшается скорость индексации страниц.

Как исправить:

- проверить, все ли подгружаемые стили и скрипты нужны для работы сайта и отдельных страниц. Бывает так, что функционал, используемый только на одном типе страниц, подгружается на все страницы сайта;

- вынести из кода стили CSS и скрипты;

- удалить или вынести из кода закомментированный код и служебные блоки.

15. Контактная информация в шапке в виде картинок

Для коммерческих сайтов важно, чтобы контактная информация была доступна пользователю, а основные способы связи находились в шапке сайта. При этом нужно учитывать, что поисковые алгоритмы не умеют корректно распознавать текст на картинках. Поэтому вся важная для пользователей информация должна быть размещена в виде текста.

Чем грозит:

Наличие ошибки будет препятствовать росту позиций по коммерческим запросам.

Как исправить:

Переверстать шапку сайта – разместить важную информацию в виде текста.

16. Отсутствие на продвигаемых страницах информации о цене

Указание цены принципиально важно для ранжирования по коммерческим запросам. Одно только добавление цен на страницу может дать значительный скачок в позициях.

Чем грозит:

Отсутствие информации о стоимости товаров или услуг влияет на ранжирование по коммерческим запросам.

Как исправить:

Просмотрите сайты конкурентов в выдаче по интересующим вас запросам. Сделать это можно вручную, а можно воспользоваться специальными сервисами. Например, такой функционал есть у SeoLib.

Если большинство конкурентов указывает цены, то нужно разместить их и на ваших продвигаемых страницах.

Чаще всего встречаются следующие ситуации:

А) Цены не указывают на категорийных страницах и размещают их только на товарных карточках.

Тут всё просто. Если вы планируете продвигать страницы по коммерческим запросам, укажите информацию о стоимости.

Б) Нет информации о ценах на главной странице.

На главной странице можно поместить блок с популярными товарами или новинками. Для сферы услуг это может быть таблица с ценами на наиболее популярные услуги.

В) В некоторых тематиках цены не указывают специально, так как конечная цена зависит от курса валют или ряда дополнительных факторов.

В таких случаях можно указывать:

- цену «От» или базовую цену;

- диапазон цен;

- информацию о том, что окончательную стоимость нужно уточнить у менеджера.

17. Ошибка в выборе региона

Для ранжирования в Яндексе по геозависимым запросам принципиально важно, какой регион присвоен сайту. Если сайту присвоен регион «Иваново» или «Мытищи», то вы уже не сможете конкурировать в выдаче по региону «Москва». Ошибкой будет и присвоение слишком широкого региона, например, «Россия» или «Весь мир». Регион должен быть указан максимально точно.

Чем грозит:

Ошибка грозит отсутствием высоких позиций по конкурентным запросам в нужном регионе.

Для продвижения в Москве по геозависимым запросам сайту должен быть присвоен регион «Москва». В противном случае вы будете проигрывать конкурентам, у которых есть такая привязка.

Как исправить:

Посмотреть, какой регион присвоен сайту, можно в панели Яндекс Вебмастера, вкладка «Информация о сайте».

Присвоить сайту нужный регион можно таким образом:

- указать привязку в панели Яндекс Вебмастера. Заявка после рассмотрения будет принята или отклонена;

- добавить адрес в Яндекс Справочник. Этим способом можно присвоить сайту много регионов;

- добавить сайт в Яндекс Каталог. После добавления можно присвоить сайту до 7 регионов.

Следует отметить, что сотрудники Яндекса часто проверяют информацию о наличии у компании офиса по указанному адресу. В последнее время к процессу проверки подключены также пользователи сервиса Toloka.

Подробнее о вопросах регионального ранжирования можно узнать в этих статьях:

Региональное продвижение в Яндекс и Google

Особенности регионального ранжирования в Яндексе

18. Ошибка в настройке ответа 404

Если пользователь обращается к несуществующей странице, сервер должен отдать ответ 404. Посетители должны увидеть страницу с сообщением об ошибке и предложением перейти на рабочие страницы сайта.

Чем грозит:

Если на сайте нет юзабильной страницы 404, вы рискуете потерять часть посетителей.

Неправильная настройка ответа 404 грозит сайту появлением в индексе дублей или малополезных страниц.

Как исправить:

Подробные рекомендации по настройке 404 ответа есть у Яндекса и у Google.

19. Ошибки в файле sitemap.xml

Наличие файла sitemap.xml может давать плюс к индексированию новых страниц сайта. Но если редко его обновлять или изначально создать файл с ошибками, то он может стать источником проблем на сайте. Такой файл будет больше вредить, чем помогать развитию. Если вы не можете поддерживать данные в карте сайта в актуальном состоянии, лучше удалите такой файл.

Чем грозит:

- из-за ошибок в файле в индекс могут попадать дубли и малополезные страницы сайта;

- ошибки в карте сайта могут ухудшать скорость индексации.

Как исправить:

- проверить файл на наличие ошибок специальными инструментами Яндекса и Google и устранить выявленные проблемы;

В панели Яндекс Вебмастера: «Анализ файлов Sitemap», вкладка «Инструменты».

В Google Search Console: «Файлы Sitemap», вкладка «Сканирование». - настроить автоматическое обновление файла, если на сайте были добавлены или удалены страницы;

- при настройке файла руководствоваться официальными рекомендациями Яндекса и советами Google.

20. Низкая скорость загрузки

Скорость загрузки сайта – тот показатель, на который сегодня нельзя не обращать внимания. Поисковые алгоритмы выше ранжируют проекты с высокой скоростью загрузки и понижают сайты, у которых есть проблемы с этим показателем. От скорости загрузки зависит и поведение посетителя – останется ли он на вашем сайте или уйдёт к конкуренту.

Чем грозит:

- проблемы со скоростью загрузки могут влиять на позиции сайта в поисковой выдаче;

- ухудшаются поведенческие показатели;

- снижается число конверсий.

Как исправить:

В первую очередь необходимо понять, что тормозит скорость загрузки сайта.

Сделать это можно с помощью официального инструмента от разработчиков Google – Page Speed Insights. Сервис не только анализирует скорость загрузки, но и предлагает рекомендации по её улучшению.

Вам важно проверить скорость загрузки не только главной страницы сайта, но и внутренних страниц. Также нужно посмотреть отчёты по скорости загрузки в Яндекс Метрике или Google Analytics. Это позволит комплексно оценить скорость загрузки вашего проекта.

Заключение

Мы искренне надеемся, что перечисленные в статье ошибки помогут в развитии ваших проектов, но в заключение хотим сделать акцент на другом.

Ошибки в процессе внесения изменений на сайт – это нормальный процесс, тут нет ничего страшного. Серьёзные проблемы возникают в том случае, если эти ошибки не были своевременно выявлены и устранены. Но сегодня у вебмастеров есть отличные инструменты для нахождения ошибок и проблем на своём сайте – это панели Яндекс Вебмастер и Google Search Console.

Почти все сайты, владельцы которых обращаются к нам за помощью, добавлены в эти панели. Но пользуются ли этими панелями хозяева проектов? На практике мы видим, что как минимум у половины проектов в панелях висят сообщения об ошибках, на которые месяцами не обращают внимания.

Настоятельно рекомендуем регулярно (минимум раз в 2 недели) мониторить панели на предмет сообщений о проблемах на сайте.

Если ошибок на вашем сайте слишком много или вы не знаете, как правильно работать с проектом, обратитесь к нам. Мы проведём SEO-аудит сайта и расскажем, как вывести ваш проект в ТОП.

Еще по теме:

- Написание текстов на сайт и их последующая оптимизация для эффективного продвижения

- Что такое LSI-ключи, как их найти и внедрить на сайт

- Влияние уникальности контента на ранжирование и её важность для SEO

- Атрибуты Alt и Title для картинок. Ответы на популярные вопросы

- Обновление Google – «Speed Update». Какие метрики помогут улучшить скорость загрузки сайта

Продолжаем публикацию обзоров он-лайн обучения в мастер-группе All in Top. На первом занятии мы научились правильно составлять семантическое ядро на основе анализа сайтов-конкурентов. В этом…

В этой статье речь пойдёт о том, что такое LSI, как и где искать LSI-запросы, как внедрить на сайт, и каких результатов можно достичь с…

Что такое уникальность контента Уникальный текст Уникальные изображения Уникальный дизайн Сервисы для проверки уникальности текста Как влияет уникальность контента на продвижение в разных ПС? Почему…

1. Что такое атрибут Alt? 2. Как правильно заполнить атрибут Alt для картинок 3. Зачем нужен атрибут Title? 4. Ответы на популярные вопросы по Alt…

Chrome User Experience Report First Paint и First Contentful Paint First Meaningful Paint (FMP) и Hero Element Timing Time to Interactive. Long Tasks Сервис Google…

SEO-аналитик

Специализируюсь на продвижении коммерческих сайтов. Разрабатываю стратегии для интернет-магазинов и агрегаторов. Умею выжимать максимум трафика в любой тематике.

Руковожу SEO-процессами внутренних проектов SiteClinic. Обучаю молодых специалистов команды.

Любимая цитата: Хорошо смеётся тот, кто смеётся из ТОПа

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

- Опубликовано:18.09.2015

- Комментарии:

3 Комментария - Рубрика:

SEO для начинающих - Просмотров: 7 359

Внутренняя оптимизация сайта – это действия, направленные на изменение содержимого сайта, структуры, дизайна, кода, настроек для лучшей индексации и ранжирования сайта в результатах поиска. Перед внутренней оптимизацией сайта необходимо провести работы с семантическим ядром сайта. Семантическое ядро сайта – это список запросов, по которым продвигается сайт.

Если вы решили самостоятельно провести оптимизацию сайта, данная статья поможет избежать типичных ошибок.

Рассмотрим основные ошибки в работе с семантическим ядром:

- Преобладание высоко- частотных запросов. Основной трафик на сайт, как правило, приносят низко- частотные запросы. Поэтому исключение этих запросов из семантического ядра приведет к снижению результатов от внутренней оптимизации.

- Малое разнообразие запросов. Необходимо добавлять в семантическое ядро сезонные запросы, прорабатывать основные информационные запросы в тематике и т.д.

- Продвижение малого числа страниц на сайте. Приходилось встречаться с ситуациями, когда на сайте продвигалась только главная страница, а другие страницы – не продвигались. Оптимально продвигать все страницы на сайте, на которые можно получить трафик из поисковых систем.

- Слишком много ВЧ-запросов на одной странице. Оптимально размещать 1-2 ВЧ-запроса на страницу. Размещение большего числа ВЧ-запросов может затруднить оптимизацию страницы и снизить результаты от продвижения.

После разработки семантического ядра проводится группировка запросов. В рамках группировки определяется, какие страницы и по каким запросам будут продвигаться в поисковых системах. На основе группировки проводится дальнейшая внутренняя оптимизация сайта – работы со структурой, текстами и т.д.

Особенности оптимизации структуры сайта

- Глубина вложенности страниц. Структура сайта должна быть понятной и четкой. Желательно, чтобы на сайте все страницы находились не дальше 3 кликов от главной. На практике бывает сложно реализовать данное правило, поэтому при большом числе страниц рекомендуется создавать карту сайта и внедрять модули для более глубокой индексации сайта.

- Распределение внутренних ссылок. Страницы, которые продвигаются по более конкурентным запросам, должны получать больше входящих внутренних ссылок, чем страницы, которые продвигаются по менее конкурентным запросам. Для проектирования внутренней перелинковки можно использовать инструменты для создания mind-map.

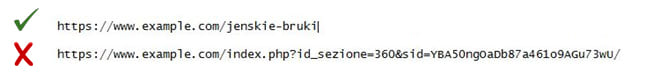

- ЧПУ-адреса страниц. ЧПУ – это аббревиатура от «человеку понятный URL», где URL – это адрес страницы сайта. Желательно, чтобы в адресах страниц были ключевые слова, по которым эти страницы продвигаются. Структура адресов должна отражать структуру сайта.

- Карта сайта (Sitemap). Наличие карты сайта необходимо крупным сайтам. Если на вашем проекте 50-100 страниц, карту сайта можно не делать. Если ваш сайт часто обновляется, в карту стоит добавлять только новые страницы, а не все подряд.

- Битые ссылки и дубли. Старайтесь избегать наличия битых ссылок и дублей страниц. Битые ссылки – это ссылки, ведущие на несуществующую страницу. Ошибки внутренней оптимизации, связанные с дублями, могут привести к наложению фильтров в Яндексе или санкций в Google.

- Переадресация. Если вы меняете адрес страницы, делайте 301 редирект со старого адреса на новый. Это позволит передать «вес» по ссылкам со старого адреса новой странице.

Типичные ошибки при оптимизации текстов, картинок

Контент – это информационное наполнение сайта. Он включает в себя текст, картинки, видео, различные таблицы, графики, анимации и др.

Ошибки при работе с текстом

- Частой ошибкой в оптимизации текста сайта является превышение плотности ключевых слов. По общему правилу, она не должна превышать 5%. При этом ключевые слова не должны концентрироваться только в одной части текста. Определить плотность можно при помощи сервисов проверки плотности ключевых слов.

- Оптимальный объем текста на странице – от 1000 символов. Слишком малый объем текста может увеличить риски выпадения страницы из индекса.

- Уникальность текста – один из самых важных факторов. Проверить уникальность можно при помощи сервисов проверки на уникальность. Необходимо стремиться к 100% уникальности всех текстов. Перед добавлением текстов на сайт добавляйте их в сервис «Оригинальные тексты» в Яндекс.Вебмастер. Это позволит закрепить за вами авторство в случае копирования контента другими сайтами.

- Качество текстов. В грамотно оптимизированных текстах не должно быть мешанины из ключевых слов. Они должны быть красиво оформлены, легко читаться, включать фотографии, таблицы, списки для упрощения восприятия информации.

Ошибки при работе с картинками

- Отсутствие картинок нельзя назвать ошибкой, но их наличие скажется положительно на уровне внутренней оптимизации текстов. Наличие картинок критично для проектов, тематика которых предполагает большой трафик из поиска по картинкам.

- Типичной ошибкой при работе с картинками является отсутствие описания в ALT-теге. Туда необходимо добавлять ключевые слова, по которым вы хотите вывести картинку в поиске по картинкам.

- Описание в ALT-теге должно соответствовать содержанию картинки. Несоответствие является ошибкой.

- Ошибка – размещать неуникальные картинки или картинки низкого разрешения. Чтобы улучшить оптимизацию сайта, необходимо добавлять уникальные (сделанные самостоятельно) фотографии в хорошем качестве.

Ошибки в коде

Наибольшее количество ошибок при внутренней оптимизации сайта связано именно с кодом и мета-тегами. Код должен быть максимально простым и понятным, JS-скрипты и CSS-стили должны быть вынесены в отдельный файл.

Типичные ошибки в коде:

- используется более одного тега H1;

- неправильный порядок в заголовках, например, H2, H1, H3;

- чрезмерное количество ключевых слов в H1 и TITLE;

- чрезмерное использование тегов B, STRONG;

- код закрывает часть содержания страницы (если это сделано не специально).

Резюме

Если Вы занимаетесь оптимизацией сайта самостоятельно, то помните основные правила оптимизации: правильная структура сайта, отсутствие длинных и переоптимизированных заголовков, уникальный и грамотно оформленный контент с картинками, чистый код на сайте с правильно прописанными тегами. Выполнение данных правил позволит вашему сайту занять более высокие позиции в поиске и обогнать конкурентов.

Полезные статьи по теме:

- Какой длины должен быть Title в Яндексе? Эксперимент 2017 года.

1. Оптимизация нескольких страниц.

Если сайт содержит большой объем информации и только некоторые страницы правильно оптимизированы, вы будете терять трафик. Часто на сайтах оптимизируется только главная страница, а остальные просто наполняются контентом без популярных запросов. В результате площадка плохо ранжируется, в поиске отображается только главная страница, поэтому вы получаете минимум трафика. Необходимо продвигать и оптимизировать все страницы.

2. Преобладание высокочастотных запросов.

В семантическом ядре (СЯ) должны быть не только высокочастотники (ВЧ), но и средне, а также низкочастотные запросы. Это обеспечит привлечение целевого трафика в большом объеме. Нельзя продвигать сайт только ВЧ-запросами. Исключением являются лендинги и одностраничники.

3. Малое количество запросов.

Оптимизация сайта должна производиться под такое количество ключевых слов, которое превышает количество страниц. Следует подбирать запросы разного типа, чтобы привлекать как можно больше заинтересованных посетителей.

4. Перебор с запросами на странице.

Использование слишком большого количества ВЧ-запросов на одной странице — ошибка SEO-оптимизации. Она приводит к снижению качества продвижения сайта. Оптимально включать в текст 1−2 высокочастотных запроса и несколько СЧ- и НЧ-запросов.

Ошибки на этапе проектирования сайта

- Некорректный сбор семантического ядра

- Неправильное создание структуры

- Неверное распределение ключевых слов

- Непродуманные прототипы страниц

Ошибки на этапе создания сайта

- Наличие дублей страниц

- Низкая скорость загрузки сайта

- Некорректный вывод текстового контента

Ошибки на существующем сайте

- Отсутствие meta тегов и заголовков

- Некорректные meta теги и заголовки

- Неуникальный текстовой контент

- Бесполезный текстовой контент

- Неправильная перелинковка

- Технические настройки

Мало кто задумывается, но ошибки в оптимизации сайта начинаются еще на этапе его проектирования. Половина глобальных недоработок, которые мешают полноценно развиваться ресурсу, приходятся именно на период создания.

Ошибки на ранних этапах, обычно, являются фундаментальными и очень сложны в исправлении. Поэтому, сегодня мы уделим им особое внимание.

Сразу разделим нашу статью на 3 глобальные блока: «Этап проектирования», «Этап создания» и «Готовый сайт».

Ошибки на этапе проектирования сайта

К данному виду ошибок относятся те, которые связаны со сбором семантического ядра, созданием структуры, прототипированием, а также другой аналитической работой. Недоработки на этом этапе могут серьезно повлиять на будущее вашего сайта.

1. Некорректный сбор семантического ядра

От того, как собрано семантическое ядро, будет зависеть структура сайта, наполнение и собственно сама внутренняя оптимизация. Это основа основ. Именно поэтому, данному этапу необходимо уделить особое внимание.

Нужно понимать, что семантика это прямое отражение покупательского спроса, потребности клиентов. Халатное отношение к ее сбору приведет к появлению серьезных и даже фатальных проблем в продвижении. Вот лишь часть из них:

-

Недостаточная проработка глобальных направлений спроса;

-

Недостаточная проработка спроса внутри направления;

-

Пересечение и дублирование информации внутри сайта;

-

Привлечение нерелевантной аудитории;

-

«Захват» других областей рынка.

Все эти ошибки рано или поздно приведут к потере поискового трафика, сил, времени и денег. Мы уже ранее рассказывали о том, как правильно собирается семантическое ядро. Советуем ознакомиться с данным материалом.

2. Неправильное создание структуры

Наполнение сайта по принципу «разместим там, где будет место», является грубой ошибкой, исправить которую впоследствии будет крайне проблематично. Структура должна создаваться на этапе проектирования с учетом спроса, приоритетных направлений, сезонности, дальнейшего развития и других факторов. В противном случае, Вы столкнетесь с целым рядом сложностей, таких как:

-

Ограничения в дальнейшем развитии сайта;

-

Некорректное распределение ключевых слов;

-

Неправильное распределение «веса» внутри сайта;

-

Избыточное количество уровней вложенности;

-

Проблемы с навигацией и юзабилити;

-

Проблемы с индексацией сайта.

3. Неверное распределение ключевых слов

С точки зрения продвижения, каждая страница сайта должна быть оптимизирована под один или несколько похожих по смыслу ключевых слов. Решать к какому разделу будет отнесен тот или иной ключевик нужно не во время заполнения сайта, а еще на этапе его проектирования. Делается это для того, чтобы избежать логических ошибок и пересечений.

Если ключевые слова будут распределены неверно, Вы столкнетесь с такими сложностями, как:

-

Низкая конверсия;

-

Снижение шансов попадания в ТОП;

-

Путаница в выборе канонической страницы;

-

Присутствие в поиске не соответствующих посадочных страниц.

О том, как правильно распределить ключевые слова по сайту мы уже писали ранее.

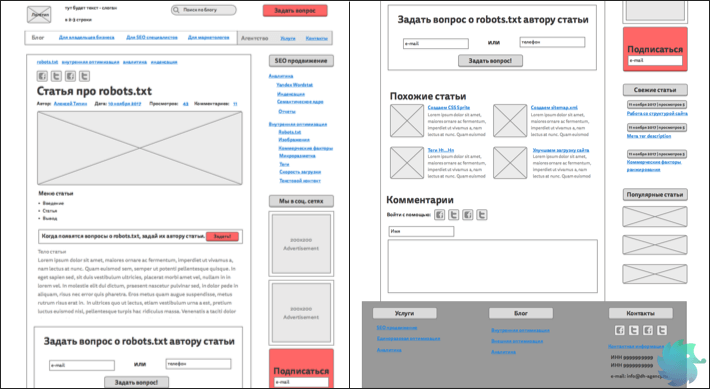

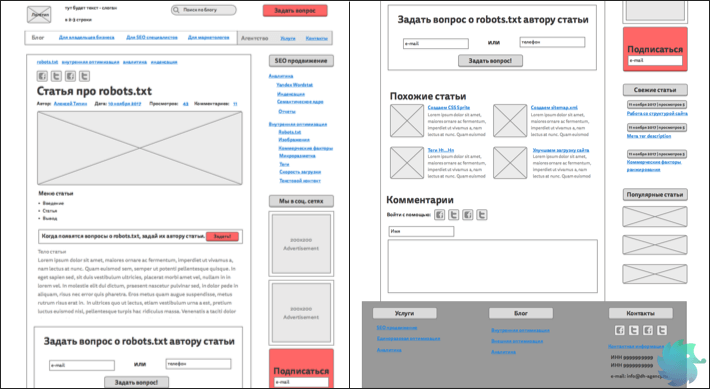

4. Непродуманные прототипы страниц

Перед тем, как приступить к отрисовке дизайна, добросовестные разработчики всегда создают прототипы страниц. Однако, в преимущественном большинстве случаев, они делаются для дизайнера и никак не учитывают требования SEO. С точки зрения поискового продвижения это некорректно.

То, что расположено на странице играет для SEO не менее важную роль, чем сам текстовой контент. Очень важно учитывать коммерческие и поведенческие факторы, продающие элементы и юзабилити. Если не заложить этого в прототипы перед отрисовкой дизайна, дорабатывать уже готовый сайт будет проблематично.

Ниже представлен пример прототипа для информационного ресурса, который учитывает не только дизайн, но и требования поискового маркетинга.

Ошибки на этапе создания сайта

1. Наличие дублей страниц

Одна из основных проблем возникающих в процессе индексации сайта — наличие дублей URL. Речь идет о ситуации, когда одна и та же страница доступна по двум или более адресам. С точки зрения продвижения это некорректно, так как роботу приходится скачивать несколько раз один и тот же контент, на что уходит драгоценное время.

Бороться с дублями, которые уже попали в индекс, достаточно проблематично, поэтому лучше исключить их на этапе создания сайта. Сделать это можно двумя способами.

-

Исключить появление. Большая часть дублей бесполезна и никак не влияет на работу сайта. К примеру, у ряда CMS, страницы по умолчанию могут быть доступны как по адресу example.ru/page.html, так и по адресу example.ru/page. Исправляется это путем настройки системы управления контентом.

-

Сразу запретить индексацию. Если избежать появление дублей невозможно, к примеру, в случае с параметрами в карточке товара, нужно сразу исключить подобные URL при помощи масок в файле robots.txt.

2. Низкая скорость загрузки сайта

Поисковые системы учитывают скорость загрузки сайта. Это далеко не самый основной фактор ранжирования, но от этого не менее важный.

Имея низкие показатели загрузки, Вы рискуете потерять существенную долю поискового трафика, так как по ряду запросов будите пессимизированы в выдаче.

Существует множество online инструментов способных проверить показатели загрузки Вашего ресурса. Один из них — https://gtmetrix.com. Довольно популярный сервис, который показывает не только ошибки, но и предлагает решения.

Прежде чем перейти к проверке убедитесь, что:

-

Все графические элементы дизайна и фото сжаты без потери качества;

-

Фактический размер изображений соответствует отображаемому на сайте;

-

Фотогалерея имеет миниатюры, а не сжимает большие изображения при помощи CSS;

-

Изображения небольшого размера объединены в CSS Sprite;

-

Видимые элементы сайта загружаются в первую очередь;

-

Все скрипты и каскадные таблицы стилей подгружаются минимальное количество раз;

-

Весь код, который подгружается, действительно используется;

Если все вышеперечисленное уже сделано, смело пользуйтесь gtmetrix и улучшайте свои показатели.

3. Некорректный вывод текстового контента

Некорректный вывод текстового контента является одной из самых распространенных проблем у сайтов с уникальным авторским дизайном. Мы ничего не имеем против необычных решений, но обращаем внимание, что они не должны влиять на корректность отображения текста. Необходимо найти компромисс между практическим применением и внешним видом.

Рассмотрим конкретные ошибки.

-

Весь текст (большая его часть) скрыты, и отображаются только после определенных действий пользователя;

-

Вывод текста осуществляется при помощи JS или других технологий, которые не позволяют загрузить его роботу;

-

Текст разбит на множество скрытых вкладок и элементов;

-

Текст представлен в виде графического изображения или анимации.

Ошибки на существующем сайте

1. Отсутствие meta тегов и заголовков

Полное отсутствие meta тегов и заголовков снижает эффективность поискового продвижения практически до нуля. Чтобы полноценно участвовать в поиске, каждая страница в обязательном порядке должна иметь:

-

<title></title> (Подробнее о том, что это такое)

-

<meta name=»description» content=»»>(Подробнее о том, что это такое)

-

<h1></h1>(Подробнее о том, что это такое)

-

<h2>…</h6>(Подробнее о том, что это такое)

Если <title></title>, обычно, заполняется CMS по умолчанию (к примеру, из первых строк текста или заголовка), то с description и другими тегами дела обстоят хуже. Их может не быть совсем.

Для проверки ошибок, в первую очередь, стоит обратиться к Яндекс Вебмастеру. В разделе «Диагностика сайта» показываются самые актуальные проблемы, в том числе отсутствие title и description.

Кроме этого, проверку возможно сделать вручную просто открыв исходный код сайта через браузер. Такой вариант подходит только для небольших сайтов. В случае с Интернет-магазинами и крупными проектами лучше использовать сервисы, вроде www.screamingfrog.co.uk. Это попросту сэкономит Ваше время и уменьшит шансы что-то пропустить.

2. Некорректные meta теги и заголовки

В отличии от ошибки описанной пунктом ранее, определить некорректно прописанные meta теги куда сложнее. В данном случае Яндекс Вебмастер и различного рода сервисы не помогут. Проблема распознается только вручную, путем подробного анализа и сопоставления имеющихся тегов с семантическим ядром.

Основные требования, которые должны быть соблюдены.

-

<title></title> — Должен содержать высокочастотный запрос (в рамках данной страницы). Быть легко читаемым и привлекающим внимание; (Подробные требования)

-

<meta name=»description» content=»»> — Должен содержать как высокочастотные, так и низкочастотные запросы (в рамках данной страницы). Полноценно описывать содержимое и быть полезным для пользователя. (Подробные требования)

-

<h1></h1> — Должен содержать высокочастотный запрос и кратко описывать суть статьи. Обязательно пишется для человека. (Подробные требования)

-

<h2>…</h6> — Должны содержать менее частотные запросы и описывать суть оглавляемого отрывка текста. (Подробные требования)

Ни в одном из вариантов не допустим поисковый СПАМ, то есть, излишнее вхождение ключевых слов или другие попытки повлиять на поисковую систему.

3. Неуникальный текстовой контент

Текстовой контент всегда являлся основным фактором ранжирования. В процессе развития поисковых систем к нему предъявлялись различные требования, но основа оставалась неизменной — текст должен быть уникальным. Сегодня это актуально как никогда.

Для проверки уникальности существует множество инструментов, таких как https://content-watch.ru/text/. Процедура простая.

-

Добавляем статью;

-

В поле «Игнорировать» прописываем доменное имя нашего сайта;

-

Нажимаем «Проверить».

Показатель более 90% является нормой для большинства сайтов. Если уникальность менее 70%, то стоит задуматься о доработке статьи. Исключение составляют сложные технические тексты и карточки товаров, где добиться уникальности в 90% практически невозможно.

Ранее у нас уже была статья об анализе текстового контента. Советуем ознакомиться с ней.

Если Вы столкнулись с тем, что текстовой материал имеет низкую уникальность, советуем переписать статью заново, а не искать совпадающие отрывки и переформулировать их.

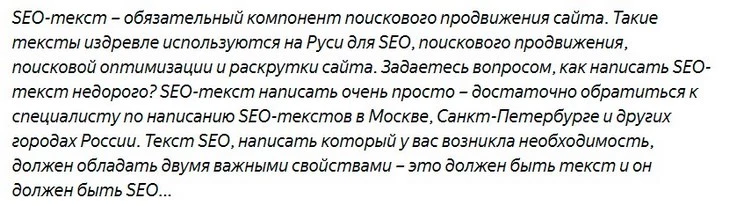

4. Бесполезный текстовой контент

Сегодня, для того, чтобы статья попала в ТОП, одной уникальности уже недостаточно. Материал должен быть полезным, актуальным, легко читаемым и полностью раскрывать освещаемую тему. Уже прошел не один год с момента, как поисковые системы научились отделять дешевый рерайт, от качественного копирайта. Но, к сожалению, до сих пор, множество коммерческих сайтов имеют массу никому ненужного текстового контента.

Чтобы определить, действительно ли статья полезна и интересна пользователю, придется работать с каждым материалом в отдельности. Вот основные вопросы, которыми Вы должны задаться перед тем, как приступить к написанию или анализу текста:

-

Для кого пишется статья?;

-

Какую проблему она решает?/На какой вопрос дает ответ?;

-

В чем отличие Вашей статьи от материалов конкурентов?

-

Полностью ли освещена тема?

-

Легко ли преподнесен материал?

- Есть ли признаки поискового СПАМа?

Каждая статья внутри сайта должна быть уникальна в своем роде и не пересекаться по смыслу с другими. Старайтесь как можно подробнее раскрывать тему. Пишите то, что действительно важно людям. Только полезный контент позволит занимать ТОПовые позиции.

5. Неправильная перелинковка

Внутренняя перелинковка нужна как пользователям так и поисковым системам. Первым она позволяет без труда серфить сайт и находить нужные материалы, вторым корректно индексировать и понимать распределение веса.

Перелинковка должна представлять из себя не хаотичный набор ссылок, а продуманную, основанную на спросе структуру. Ошибки приведут к некорректной индексации и негативным поведенческим факторам.

Правильная перелинковка должна отвечать ряду условий.

- На каждую страницу, которая имеется на сайте, должна быть ссылка. «Острова», на которые можно попасть только введя прямой адрес, недопустимы;

- Основные разделы должны быть доступны из сквозного меню;

- Всегда должна быть возможность вернуться на уровень выше;

- Не должно быть циклических ссылок. То есть, страниц, которые ссылаются сами на себя;

- Перелинковка не должна вводить пользователя в заблуждение;

Основная карта ссылок должна делаться еще на этапе проектирования, а в процессе заполнения сайта только дополняться.

6. Технические настройки

Помимо всего вышеперечисленного, существуют еще обязательные технические настройки, без которых поисковый робот не сможет корректно индексировать Ваш сайт.

-

Убедитесь, что все страницы сайта имеют корректные ответы сервера. (Подробнее о 404, 301, 302)

-

Проверьте правильность настройки файла robots.txt. (Подробнее…)

-

Создайте техническую карту сайта sitemap.xml (Подробнее…)

-

Корректно присвойте сайту регион (Подробнее…)

-

Переведите сайт на https (Подробнее…)

-

Сделайте для товаров микроразметку (Подробнее…)

Следующие пять ошибок делают невозможным продвижение вашего сайта. Это основные и наиболее распространенные ошибки SEO. В статье мы подробнее рассмотрим технические ошибки, ошибки оптимизации и даже некоторые ошибки SEO в работе с WordPress — в общем, прольем свет на всевозможные недочеты, которые мешают продвижению вашего сайта!

Основные SEO ошибки

1. Поисковые системы видят ваш сайт. Банальная проблема SEO, однако доступность сайта — это важно в продвижении. Не мешайте страницам индексироваться (проверьте, чтобы robots.txt был корректно составлен и на важных страницах не было мета-тега noindex).

2. Низкокачественный контент. Актуальный, достоверный и полезный контент заставит посетителей сайта не только задержаться на странице, но и поделиться в соцсетях. Популярность контента повысит ваш коэффициент в уравнении ранжирования SEO. Выглядит оно так: отношение уникальных посетителей страницы к тем, кто ещё поделился ею с другими (по помните, что никто доподлинно не знает формулу ранжирования — мы можем лишь выводить закономерности и обращать внимание на приемы, которые реально работают).

3. Неправильное расположение ключевых слов в тексте. Это серьезная ошибка в продвижении сайта. Для релевантности к поисковому запросу ключевики на страницу вписывают в заголовки, внутреннюю перелинковку, а также в начало текста (зачастую) и разбрасывают на протяжении всего текста.

4. Не думать о посетителе. Траст сайта обеспечивается ссылками и цитатами. Предполагается, что если сайт удобен и полезен, им будут делиться на сторонних ресурсах: эти внешние ссылки-доноры будут благотворно влиять на траст домена/страницы и в целом рост позиций.

5. Информативность — не замена маркетингу. В поисковой выдаче выигрывает не тот, кто правдивее, а тот, кто «распространеннее». Гораздо больше входящих ссылок удается раздобыть благодаря эффективной маркетинговой компании (например, вирусной статьи, которая взбудоражила бы ЦА).

Ошибки во внутренней оптимизации

Ошибки контента страницы

6. Плохая читабельность. Чем выше читабельность текста, тем лучше ранжирование страниц в SEO. Влияние происходит не напрямую, но от удобства восприятия зависят:

- Глубина скроллинга;

- Общее время пребывания на странице;

- Отказы;

- Соцсигналы.

То есть поведенческие характеристики. Как исправить эту ошибку? Важно сделать так, чтобы уже имеющиеся статьи повысили свою позицию в выдаче. Для этого нужно:

- Провести аудит опубликованных страниц;

- Реоптимизировать контент. Добавить гиперссылки на другие статьи и метаописание;

- Провести дополнительную внутреннюю SEO-оптимизацию;

- Где нет заголовков h1, h2, h3, добавить;

- Не забывайте про картинки, гифки и видео.

7. Неудачный выбор формата контента. С каждым днем становится все сложнее удержать внимание пользователя. Контент в свою очередь должен быть максимально разнообразным: наличие маркированных списков, инфографики, картинок, видео. Однотипные статьи по тысяче слов уже не заинтересуют ни поисковик, ни человека.

8. Дублирование контента. Эта ошибка SEO возникает в связи с техническими особенностями CMS. Например, в WordPress один и тот же контент отображается как на странице публикации, так и на страницах меток. Запретить их индексацию можно через мета-тег noindex (плагин Yoast, который стоит абсолютно у всех, кому нужна SEO, например, это делает) Дальше в этой статье мы ещё поговорим о частых ошибках SEO на WordPress. Что касается конкретно этой ошибки на сайте, решить её можно канонизацией URL и запретом индексации служебных разделов сайта.

9. Неуникальный контент. Это чужие публикации или иначе говоря — ворованный контент. Наполняя им свой сайт, вы нарушаете требования поисковых систем и мешаете продвижению.

10. Нерегулярные публикации на сайте. Обновление сайта поможет избежать серьезной ошибки SEO. Чтобы его актуальность не падала, публикуйте новые материалы регулярно. Важно, чтобы они имели пользу для людей, а не для поисковых систем.

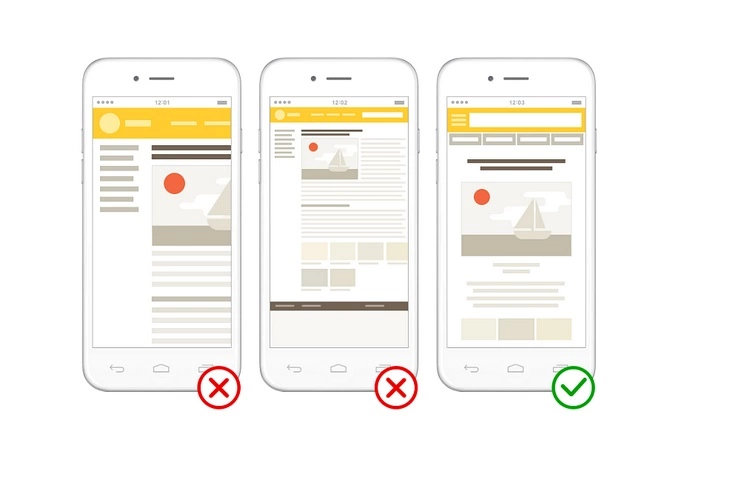

11. Сайт не адаптирован под мобильный трафик. Дискомфорт при просмотре со смартфонов или планшетов уводит посетителей с вашего сайта. Для эффективного SEO целевые кнопки должны быть крупными, картинки органично сочетаться с текстом, то есть шаблон/ макет / дизайн должны быть адаптивными.

12. Страница 404 не соответствует принципу usability. Это значит, что на ней отсутствуют форма поиска и возможность вернуться на главную. Сделайте её выделяющейся за счет дизайна, чтобы пользователь не закрыл сайт совсем.

13. В тег img не вписан атрибут alt. Это простое действие способствует SEO и индексированию изображений, что приводит трафик из раздела “Картинки”. Также текстовое описание выводится на странице вместо изображения, если у пользователя медленный интернет.

14. Перевес внимания в сторону технического SEO. Используйте необходимый минимум плагинов и уделяйте больше времени публикации материалов, чем работе с настройками темы и CMS.

15. Создание splash-страниц. Их не любят поисковики, потому что пользователям они не нужны.

Ошибки в семантике

16. Неверный выбор ключевых слов. Это серьезная ошибка SEO, потому что используя нерелевантные ключевые запросы при сборе семантического ядра и текстовой оптимизации страниц, вас просто не смогут найти потенциальные клиенты.

Как предотвратить эту ошибку продвижения: обязательно проводите анализ ЦА и изучите формирование потребностей. Вот несколько вопросов, которые помогут выявить релевантные ключевые слова:

- Как формируется запрос ЦА?

- Какие дальнейшие шаги совершает ЦА перед покупкой?

- Какие ключевики используют конкуренты? Используйте сервисы SpyWords и iSpionage.

Конкуренция в SEO всегда выше на коротких запросах (высокочастотные). Они являются общими и не содержат в себе уточняющей информации. Их длина обычно 1-2 слова. Поэтому более целевыми являются длинные запросы (низкочастотные). Такими запросами считаются фразы от трех слов. В них уже видна конкретика. Работа с узким семантическим ядром высокочастотных запросов будет ошибкой в продвижении. Ранжирование запросов на высокочастотные, среднечастотные и низкочастотные происходит в зависимости от конкретного запроса, но приблизительно им можно дать следующие значения:

- Низкочастотные — до 100 (иногда до 1000) в месц;

- Среднечастотные — от 1000 до 100 (иногда до 5000) в месяц;

- Высокочастотные — от 1000 или 5000, иногда даже свыше 10000 в месяц.

При сборе ключевиков используйте эти программы и сервисы:

- KeyCollector;

- Rookee;

- СлобоЕБ;

- Яндекс Wordstat;

- Google Trends;

17. Переспам или тошнота в тексте (слишком много ключевых слов). Эта ошибка оптимизации угрожает наложению санкций на ваш сайт. Старайтесь распределять ключевые запросы равномерно: примерно один запрос на два абзаца. Положение ключевого слова относительно начала или конца текста тоже влияет на продвижение сайта.

18. Ключевые слова указаны слишком низко в тексте. Положение важных ключевиков на странице предпочтительнее в начале текста. Как можно раньше, хотя бы в первых 50-100 словах.

19. Несколько страниц для похожих ключевиков. Сортируйте запросы по намерению пользователей, а не по синонимам.

Технические ошибки SEO

20. Наличие флеш-элементов. Лет 10 назад можно было встретить флеш-баннеры, но лучше вообще не использовать флеш-элементы на вашем сайте: они перегружают страницу и, более того, считаются подозрительными.

21. Нет title, description, и robots. Использование метаданных необходимо в SEO как для поисковых роботов, так и для людей.

22. Низкая скорость загрузки сайта. Сейчас низкой скоростью сайта считается загрузка страницы более 3 секунд. Больше половины посетителей уходят со страницы после этого времени. Оптимальная скорость загрузки для эффективного продвижения — 1,5-3 секунды. Для проверки используйте Pagespeed Insights.

23. Ошибки в robots.txt файле. При несоблюдении технической грамматики могут нарушаться правила индексирования. Часто эти ошибки SEO связаны с неправильным написанием слова. Например, написать директиву как “Dissalow” вместо “Disallow”.

24. Частая ошибка SEO у сайтов на CMS Bitrix возникает при запуске сайта. После того, как сайт во время разработки был закрыт от индексации, в интерфейсе CMS устанавливаются стартовые правила для закрытия административных страниц. Здесь самое важное — удалить директиву “Disallow: /”. Иначе сайт не начет индексацию.

Ошибки индексации

25. Нет карты сайта. Это препятствует работе поисковых роботов. Пользователям нужна HTML карта сайта для быстрого и удобного поиска информации. А для поисковикам нужна XML sitemap для улучшения индексации.

26. Тег noindex используется неправильно. В SEO его иногда применяют для запрета индексации исходящих ссылок (для них используется nofollow). Контент недоступен для поисковых ботов, пока заключен между тегами <noindex> … </noindex>. Поэтому конкретно <noindex> и не используется для контента.

27. Нет ссылок на новую страницу или сайт. При создании нового раздела или страницы, отсылайте к ним через внутренние ссылки и элементы навигации. А при создании сайта, зарегистрируйте его в рейтинге LiveInternet.ru, а также анонсируйте появление сайта в соцсетях. На вас должны ссылаться и другие ресурсы, это тоже способствует продвижению.

28. На странице несколько заголовков уровня H1. Это создает путанницу у поисковых систем.

29. Используется редирект 302 вместо 301. Таким путем трафик перенаправляется, но пользы для оптимизации никакой. Только 301 редирект передает ссылочный вес новому адресу URL, потому и для поисковых роботов означает “переезд” страницы навсегда. Редирект 302 означает временное перемещение страницы. Если пришлось настраивать редиректы вручную с помощью Excel, помните: нельзя написать в ячейке “Redirect 301”, а затем растянуть её вниз. Excel меняет значение следующих ячеек на “Redirect 302”, “Redirect 303” и так далее.

30. Написание атрибутов noindex и none в мета-теге robots. Использовать их для SEO нужно, только если вы хотите запретить индексацию некоторых страниц, например:

- Пагинации;

- Тегов;

- Авторов.

31. Сообщения об ошибках не обрабатываются корректно. В случае, когда пользователь переходит по несуществующему адресу, сайт должен перенаправлять пользователя на страницу ошибки 404.

32. Смена дизайна без внимания к SEO. Важные данные (такие, как перелинковка в сайдбаре и других блоках) могут удалиться при таком обновлении на сайте.

Ошибки внешней оптимизации

В работе с системами аналитики и инструментами для вебмастеров встречаются следующие ошибки в продвижении:

- Код счетчика не актуален или установлен не между тегами head;

- Чрезмерная фокусировка на метрике, вместо интересов пользователя;

- Накрутка поведенческих метрик, после которой ваш сайт ждут санкции — подробнее о программах накрутки ПФ и принципах их работы можно почитать по ссылке;

- Излишнее внимание к показателям эффективности продвижения. На новом сайте вполне достаточно отслеживать базовые индикаторы эффективности маркетинговой кампании;

- Показатель отказов анализируется без уточнения. В системе Google Analytics отказ засчитывается в случае, когда пользователь посетил только одну страницу сайта.

Ошибки линкбилдинга

33. Закуп ссылок на биржах. Получение санкций от поисковиков и сложности в продвижении становятся наиболее вероятными.

34. Продажа ссылок с сайта. То же, что и в пункте выше.

35. Обратные ссылки из каталогов. Поисковые системы считают автоматическую или ручную регистрацию сайта в каталогах и десятки backlink признаком манипуляции.

36. Постинг спамных ссылок в профилях/спамных донорах без трафика. Причем не важно, автоматически или вручную вы пытаетесь получить ссылки. Это устаревший метод линкбилдинга и продвижения.

37. Активное комментирование на Dofollow блогах. Равно как и пара комментариев на нескольких площадках не принесет авторитетности вашему сайту, сотни комментариев не помогут SEO. Зато могут отправить ваш сайт под санкции.

38. Обилие ссылок в футере сайта. Поисковые системы нормально относятся к таким ссылкам на сайтах, связанных с услугами интернет-маркетинга или разработкой сайтов. Для таких ниш нормально, когда партнеры ссылаются на них. Это положительно влияет на продвижение. В остальных случаях много ссылок из футеров на ваш сайт вызывают подозрения. Чтобы не получить санкции, закрывайте ссылки из футеров атрибутом “nofollow” и не помещайте анкоры с ключевыми словами.

39. Битые ссылки на сайте. Такая ошибка веб сайта может возникать периодически. На наличие битых ссылок проверяйте сайт через бесплатные онлайн сервисы Link Cheker.

40. Нет релевантных исходящих ссылок. В основе естественного линкбилдинга лежит двустороннее продвижение. Поэтому обязательно ставьте ссылки (открытые для индексации) на авторитетные источники.

41. Много ссылок с оптимизированными анкорами. Во всем должна быть мера, чтобы не попасть под санкции. Избегайте формулировок типа “купить товары для садоводства в москве”.

Ошибки оптимизации в работе с соцсетями

42. Не игнорируйте соцсети в работе с SEO. Обязательно используйте кнопки шеринга и социальные плагины для комментирования и авторизации. Посещаемость сайта можно увеличить благодаря анонсам в соцсетях. Социальные сети могут также: приносить трафик и тем самым увеличивать поведенческие факторы, давать реальные переходы людей с других источников, а также увеличивать скорость индексации страниц.

43. Заблуждение, что социальные ссылки влияют на авторитет сайта. Имеет смысл публиковать ссылки ради анонса материалов, тем самым привлекая трафик и раскачивая ПФ. Однако надеяться на то, что ссылки из соцсетей повысят значительно повысят траст домена, не стоти.

Частые ошибки оптимизации WordPress