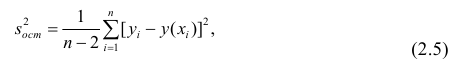

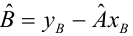

Стандартное

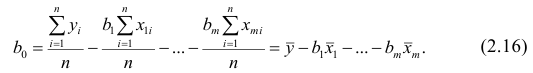

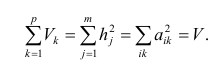

отклонение для оценки обозначается Se

и рассчитывается по формуле

среднеквадратичного отклонения:

![]() .

.

Величина стандартного

отклонения характеризует точность

прогноза.

Вариант

5. Возвращаясь к данным нашего примера,

рассчитаем значение Se:

![]()

Предположим,

необходимо оценить значение Y для

конкретного значения независимой

переменной, например, спрогнозировать

объем продаж при затратах на рекламу в

объеме 10 тыс. долл. Обычно при этом также

требуется оценить степень достоверности

результата, одним из показателей которого

является доверительный интервал для

Y.

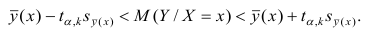

Граница доверительного

интервала для Y при заданной величине

X рассчитывается следующим образом:

где

Хp

– выбранное значение независимой

переменной, на основе которого выполняется

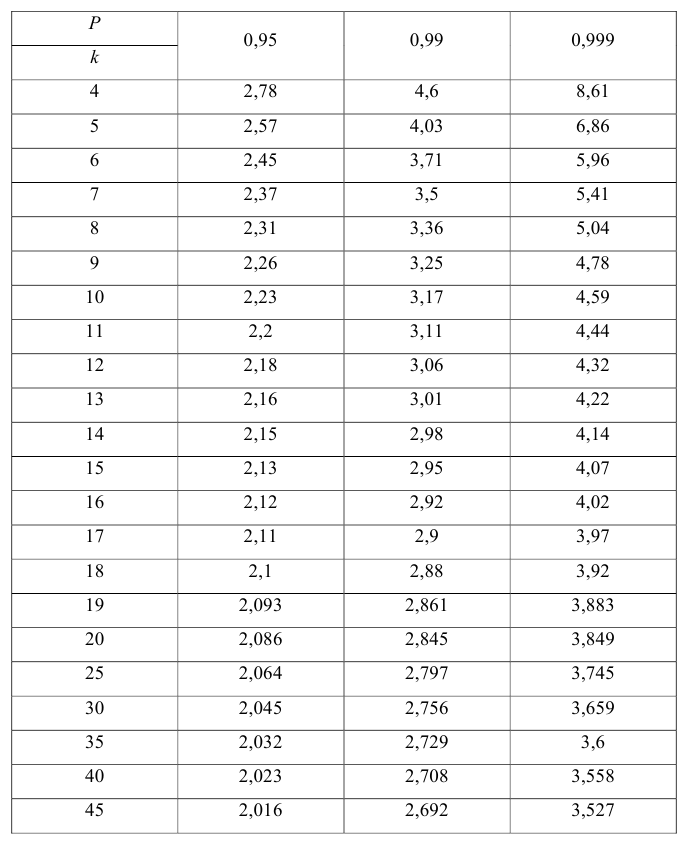

прогноз. Обратите внимание: t – это

критическое значение текущего уровня

значимости. Например, для уровня

значимости, равного 0,025 (что соответствует

уровню доверительности двухстороннего

критерия, равному 95%) и числа степеней

свободы, равного 10, критическое значение

t равно 2, 228 (см. Приложение II). Как можно

увидеть, доверительный интервал – это

интервал, ограниченный с двух сторон

граничными значениями предсказания

(зависимой переменной).

Вариант

6. Для нашего примера расходов на рекламу

в размере 10 тыс. долл. интервал предсказания

зависимой переменной (объема продаж) с

уровнем доверительности в 95% находится

в пределах [10,5951; 21,8361]. Его границы

определяются следующим образом (обратите

внимание, что в Варианте 2 Y’=16,2156):

Из приведенного

расчета имеем: для заданных расходов

на рекламу в объеме 10 тыс. долл., объем

продаж изменяется в диапазоне от 10,5951

до 21,8361 тыс. долл. При этом:

10,5951=16,2156-5,6205 и 21,8361=16,2156+5,6205.

3. Стандартное отклонение для коэффициента регрессии Sb и t-статистика

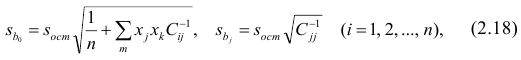

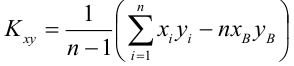

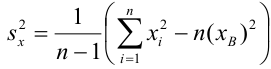

Значения

стандартного отклонения для коэффициентов

регрессии Sb

и значение статистики тесно взаимосвязаны.

Sb

рассчитываются как

![]()

Или в сокращенной

форме:

![]()

Sb

задает интервал, в который попадают.

Все возможные значения коэффициента

регрессии. t-статистика

(или t-значение)

– мера статистической значимости

влияния независимой переменной Х на

зависимую переменную Y

определяется путем деления оценки

коэффициента b

на его стандартное отклонение Sb.

Полученное значение затем сравнивается

с табличным (см. табл. В Приложении II).

Таким

образом, t-статистика

показывает, насколько велики величина

стандартного отклонения для коэффициента

регрессии (насколько оно больше нуля).

Практика показывает, что любое t-значение,

не принадлежащее интервалу [-2;2], является

приемлемым. Чем выше t-значение,

тем выше достоверность коэффициента

(т.е. точнее прогноз на его основе). Низкое

t-значение

свидетельствует о низкой прогнозирующей

силе коэффициента регрессии.

Вариант

7. Sb

для нашего примера равно:

![]()

t-статистика

определяется:

![]()

Так

как t=3,94>2,

можно заключить,

что

коэффициент

b

является

статистически

значимым.

Как

отмечалось раньше,

табличное

критическое

значение (уровень отсечения)

для 10 степеней свободы равно

2,228

(см.

табл.

в

Приложении

11).

Обратите

внимание:

—

t-значения

играют большую

роль для коэффициентов

множественной регрессии

(множественная

модель описывается

с помощью

нескольких

коэффициентов

b);

—

R2

характеризует

общее согласие (всего

«леса»

невязок

на

диаграмме

разброса),

в

то время как

t-значение

характеризует

отдельную

независимую переменную

(отдельное

«дерево»

невязок).

В

общем случае

табличное

t-значение

для

заданных

числа

степеней свободы и уровня

значимости используется,

чтобы:

—

установить

диапазон

предсказания:

верхнюю

и нижнюю границы

для прогнозируемого

значения при заданном значении

независимой

переменной;

-установить

доверительные

интервалы

для

коэффициентов

регрессии;

—

определить

уровень

отсечения

для t-теста.

РЕГРЕССИОННЫЙ

АНАЛИЗ С ПРИМЕНЕНИЕМ ЭЛЕКТРОННЫХ ТАБЛИЦ

MS EXCEL

Электронные

таблицы,

такие

как Excel,

имеют

встроенную

процедуру

регрессионного

анализа,

легкую

в

применении.

Регрессионный

анализ

с помощью

MS Ехсеl

требует

выполнения

следующих

действий:

—

выберите

пункт

меню

«Сервис

— Надстройки»;

—

в

появившемся

окне отметьте

галочкой

надстройку

Analysis

ToolPak

–

VBA нажмите

кнопку

ОК.

Если

в списке Analysis

ToolPak

—

VВА

отсутствует,

выйдите

из MS Ехсеl

и добавьте эту надстройку,

воспользовавшись

программой

установки Мiсrosоft

Office.

Затем

запустите Ехсеl

снова

и повторите

эти действия.

Убедившись,

что

надстройка

Analysis

ToolPak

—

VВА

доступна,

запустите

инструмент

регрессионного

анализа,

выполнив

следующие

действия:

—

выберите

пункт меню «Сервис

—

Анализ»

данных;

—

в появившемся окне выберите

пункт

«Регрессия»

и

нажмите

кнопку

ОК.

На

рисунке 16.3

показано окно ввода данных для

регрессионного

анализа.

Рисунок 16.3 – Окно

ввода данных для регрессионного анализа

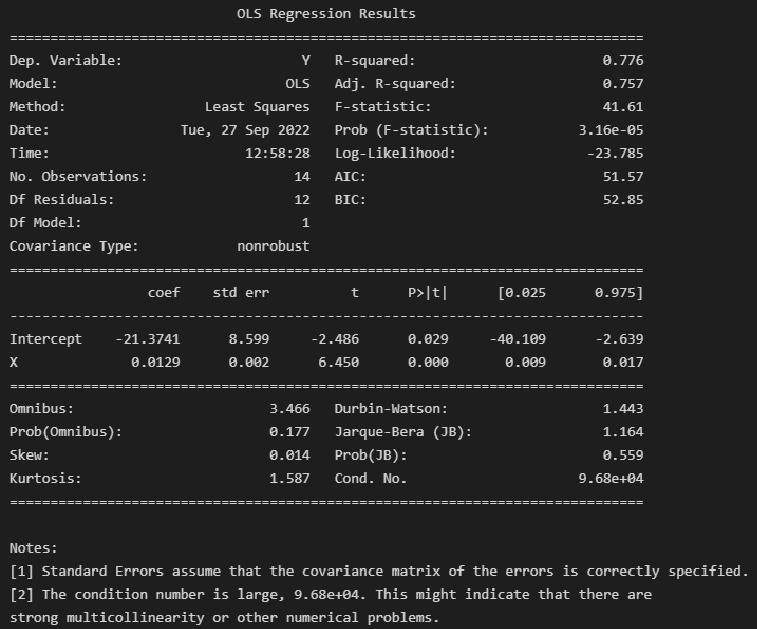

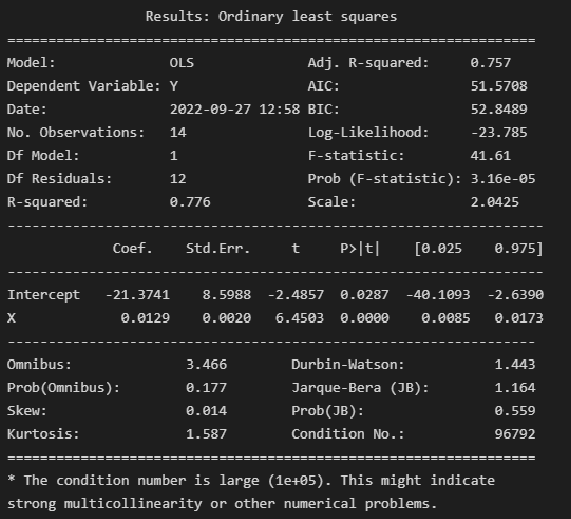

Таблица

16.2

показывает

выходной

результат

регрессии,

содержащий

описанные

выше статистические

данные.

Примечание:

для

того чтобы получить

поточечный

график

(ХY график),

используйте

«Мастер

Диаграмм»

MS

Excel.

Получаем:

Y’

= 10,5386

+ 0,563197

Х (d

виде

Y’

=

а

+

bХ)

с R2=0,608373=60,84%.

Все

полученные

данные

ответствуют

данным,

рассчитанным

вручную.

Таблица 16.2 –

Результаты регрессионного анализа

в

электронных таблицах MS

Excel

|

Вывод |

||||||

|

Регрессионная |

||||||

|

Множественный |

0,7800 |

|||||

|

R-квадрат |

0,6084 |

|||||

|

Нормированный |

0,5692 |

|||||

|

Стандартная |

2,3436 |

|||||

|

Наблюдения |

12 |

|||||

|

Дисперсионный |

||||||

|

df |

SS |

MS |

F |

Значимость |

||

|

Регрессия |

1 |

85,3243 |

85,3243 |

15,5345 |

0,0028 |

|

|

Остаток |

10 |

54,9257 |

5,4926 |

|||

|

Итого |

11 |

140,2500 |

||||

|

Коэффи-циенты |

Стандарт-ная |

t-статистика |

Р- |

Нижние |

Верхние |

|

|

Свободный |

10,5836 |

2,1796 |

4,8558 |

0,0007 |

5,7272 |

15,4401 |

|

Линейный |

0,563197 |

0,1429 |

3,9414 |

0,0028 |

0,2448 |

0,8816 |

|

*Р |

Таблица

16.3 показывает выходной результат

регрессии, полученный с применением

популярного программного обеспечения

Minitab

для статистического анализа.

Таблица

16.3 – Результаты регрессионного анализа

Minitab

|

Анализ регрессии

Уравнение FO=10,6+0,563DLH |

|||||

|

Прогнозируемые |

Коэффициент |

Стандартное |

t-значение |

P |

|

|

Константа |

10,584 |

2,180 |

4,86 |

0,000 |

|

|

DLH |

0,5632 |

0,1429 |

3,94 |

0,003 |

|

|

s=2,344 |

R-квадрат=60,8% |

R-квадрат |

|||

|

Анализ |

|||||

|

Показатель |

DF |

SS |

MS |

F |

P |

|

Регрессия |

1 |

85,324 |

85,324 |

15,53 |

0,003 |

|

Отклонение |

10 |

54,926 |

5,493 |

||

|

Итого |

11 |

140,250 |

ВЫВОДЫ

C

помощью регрессионного анализа

устанавливается

зависимость

между

изменениями

независимых

переменных

и

значениями зависимой

переменной.

Регрессионный

анализ

— популярный

метод для прогнозирования

продаж.

В

этой

главе обсуждался

широко

распространенный

способ

оценки значений,

так

называемый

метод

наименьших

квадратов.

Метод

наименьших

квадратов

рассматривался

применительно

к

модели

простой

регрессии

Y

=

а

+ bх.

Обсуждались

различные

статистические

коэффициенты,

характеризующие

добротность

и надежность

уравнения

(согласие

модели)

и помогающие установить

доверительный

интервал.

Показано

применение

электронных

таблиц MS Ехсеl для

проведения

регрессионного

анализа

шаг за шагом.

С

помощью электронных

таблиц

можно не только составить

уравнение

регрессии,

но

и рассчитать статистические

коэффициенты.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

From Wikipedia, the free encyclopedia

In statistics, the mean squared error (MSE)[1] or mean squared deviation (MSD) of an estimator (of a procedure for estimating an unobserved quantity) measures the average of the squares of the errors—that is, the average squared difference between the estimated values and the actual value. MSE is a risk function, corresponding to the expected value of the squared error loss.[2] The fact that MSE is almost always strictly positive (and not zero) is because of randomness or because the estimator does not account for information that could produce a more accurate estimate.[3] In machine learning, specifically empirical risk minimization, MSE may refer to the empirical risk (the average loss on an observed data set), as an estimate of the true MSE (the true risk: the average loss on the actual population distribution).

The MSE is a measure of the quality of an estimator. As it is derived from the square of Euclidean distance, it is always a positive value that decreases as the error approaches zero.

The MSE is the second moment (about the origin) of the error, and thus incorporates both the variance of the estimator (how widely spread the estimates are from one data sample to another) and its bias (how far off the average estimated value is from the true value).[citation needed] For an unbiased estimator, the MSE is the variance of the estimator. Like the variance, MSE has the same units of measurement as the square of the quantity being estimated. In an analogy to standard deviation, taking the square root of MSE yields the root-mean-square error or root-mean-square deviation (RMSE or RMSD), which has the same units as the quantity being estimated; for an unbiased estimator, the RMSE is the square root of the variance, known as the standard error.

Definition and basic properties[edit]

The MSE either assesses the quality of a predictor (i.e., a function mapping arbitrary inputs to a sample of values of some random variable), or of an estimator (i.e., a mathematical function mapping a sample of data to an estimate of a parameter of the population from which the data is sampled). The definition of an MSE differs according to whether one is describing a predictor or an estimator.

Predictor[edit]

If a vector of

In other words, the MSE is the mean

In matrix notation,

where

The MSE can also be computed on q data points that were not used in estimating the model, either because they were held back for this purpose, or because these data have been newly obtained. Within this process, known as statistical learning, the MSE is often called the test MSE,[4] and is computed as

Estimator[edit]

The MSE of an estimator

This definition depends on the unknown parameter, but the MSE is a priori a property of an estimator. The MSE could be a function of unknown parameters, in which case any estimator of the MSE based on estimates of these parameters would be a function of the data (and thus a random variable). If the estimator

The MSE can be written as the sum of the variance of the estimator and the squared bias of the estimator, providing a useful way to calculate the MSE and implying that in the case of unbiased estimators, the MSE and variance are equivalent.[5]

Proof of variance and bias relationship[edit]

An even shorter proof can be achieved using the well-known formula that for a random variable

But in real modeling case, MSE could be described as the addition of model variance, model bias, and irreducible uncertainty (see Bias–variance tradeoff). According to the relationship, the MSE of the estimators could be simply used for the efficiency comparison, which includes the information of estimator variance and bias. This is called MSE criterion.

In regression[edit]

In regression analysis, plotting is a more natural way to view the overall trend of the whole data. The mean of the distance from each point to the predicted regression model can be calculated, and shown as the mean squared error. The squaring is critical to reduce the complexity with negative signs. To minimize MSE, the model could be more accurate, which would mean the model is closer to actual data. One example of a linear regression using this method is the least squares method—which evaluates appropriateness of linear regression model to model bivariate dataset,[6] but whose limitation is related to known distribution of the data.

The term mean squared error is sometimes used to refer to the unbiased estimate of error variance: the residual sum of squares divided by the number of degrees of freedom. This definition for a known, computed quantity differs from the above definition for the computed MSE of a predictor, in that a different denominator is used. The denominator is the sample size reduced by the number of model parameters estimated from the same data, (n−p) for p regressors or (n−p−1) if an intercept is used (see errors and residuals in statistics for more details).[7] Although the MSE (as defined in this article) is not an unbiased estimator of the error variance, it is consistent, given the consistency of the predictor.

In regression analysis, «mean squared error», often referred to as mean squared prediction error or «out-of-sample mean squared error», can also refer to the mean value of the squared deviations of the predictions from the true values, over an out-of-sample test space, generated by a model estimated over a particular sample space. This also is a known, computed quantity, and it varies by sample and by out-of-sample test space.

Examples[edit]

Mean[edit]

Suppose we have a random sample of size

which has an expected value equal to the true mean

where

For a Gaussian distribution, this is the best unbiased estimator (i.e., one with the lowest MSE among all unbiased estimators), but not, say, for a uniform distribution.

Variance[edit]

The usual estimator for the variance is the corrected sample variance:

This is unbiased (its expected value is

where

However, one can use other estimators for

then we calculate:

This is minimized when

For a Gaussian distribution, where

Further, while the corrected sample variance is the best unbiased estimator (minimum mean squared error among unbiased estimators) of variance for Gaussian distributions, if the distribution is not Gaussian, then even among unbiased estimators, the best unbiased estimator of the variance may not be

Gaussian distribution[edit]

The following table gives several estimators of the true parameters of the population, μ and σ2, for the Gaussian case.[9]

| True value | Estimator | Mean squared error |

|---|---|---|

|

= the unbiased estimator of the population mean, = the unbiased estimator of the population mean,  |

|

|

= the unbiased estimator of the population variance, = the unbiased estimator of the population variance,  |

|

|

= the biased estimator of the population variance, = the biased estimator of the population variance,  |

|

|

= the biased estimator of the population variance, = the biased estimator of the population variance,  |

|

Interpretation[edit]

An MSE of zero, meaning that the estimator

Values of MSE may be used for comparative purposes. Two or more statistical models may be compared using their MSEs—as a measure of how well they explain a given set of observations: An unbiased estimator (estimated from a statistical model) with the smallest variance among all unbiased estimators is the best unbiased estimator or MVUE (Minimum-Variance Unbiased Estimator).

Both analysis of variance and linear regression techniques estimate the MSE as part of the analysis and use the estimated MSE to determine the statistical significance of the factors or predictors under study. The goal of experimental design is to construct experiments in such a way that when the observations are analyzed, the MSE is close to zero relative to the magnitude of at least one of the estimated treatment effects.

In one-way analysis of variance, MSE can be calculated by the division of the sum of squared errors and the degree of freedom. Also, the f-value is the ratio of the mean squared treatment and the MSE.

MSE is also used in several stepwise regression techniques as part of the determination as to how many predictors from a candidate set to include in a model for a given set of observations.

Applications[edit]

- Minimizing MSE is a key criterion in selecting estimators: see minimum mean-square error. Among unbiased estimators, minimizing the MSE is equivalent to minimizing the variance, and the estimator that does this is the minimum variance unbiased estimator. However, a biased estimator may have lower MSE; see estimator bias.

- In statistical modelling the MSE can represent the difference between the actual observations and the observation values predicted by the model. In this context, it is used to determine the extent to which the model fits the data as well as whether removing some explanatory variables is possible without significantly harming the model’s predictive ability.

- In forecasting and prediction, the Brier score is a measure of forecast skill based on MSE.

Loss function[edit]

Squared error loss is one of the most widely used loss functions in statistics[citation needed], though its widespread use stems more from mathematical convenience than considerations of actual loss in applications. Carl Friedrich Gauss, who introduced the use of mean squared error, was aware of its arbitrariness and was in agreement with objections to it on these grounds.[3] The mathematical benefits of mean squared error are particularly evident in its use at analyzing the performance of linear regression, as it allows one to partition the variation in a dataset into variation explained by the model and variation explained by randomness.

Criticism[edit]

The use of mean squared error without question has been criticized by the decision theorist James Berger. Mean squared error is the negative of the expected value of one specific utility function, the quadratic utility function, which may not be the appropriate utility function to use under a given set of circumstances. There are, however, some scenarios where mean squared error can serve as a good approximation to a loss function occurring naturally in an application.[10]

Like variance, mean squared error has the disadvantage of heavily weighting outliers.[11] This is a result of the squaring of each term, which effectively weights large errors more heavily than small ones. This property, undesirable in many applications, has led researchers to use alternatives such as the mean absolute error, or those based on the median.

See also[edit]

- Bias–variance tradeoff

- Hodges’ estimator

- James–Stein estimator

- Mean percentage error

- Mean square quantization error

- Mean square weighted deviation

- Mean squared displacement

- Mean squared prediction error

- Minimum mean square error

- Minimum mean squared error estimator

- Overfitting

- Peak signal-to-noise ratio

Notes[edit]

- ^ This can be proved by Jensen’s inequality as follows. The fourth central moment is an upper bound for the square of variance, so that the least value for their ratio is one, therefore, the least value for the excess kurtosis is −2, achieved, for instance, by a Bernoulli with p=1/2.

References[edit]

- ^ a b «Mean Squared Error (MSE)». www.probabilitycourse.com. Retrieved 2020-09-12.

- ^ Bickel, Peter J.; Doksum, Kjell A. (2015). Mathematical Statistics: Basic Ideas and Selected Topics. Vol. I (Second ed.). p. 20.

If we use quadratic loss, our risk function is called the mean squared error (MSE) …

- ^ a b Lehmann, E. L.; Casella, George (1998). Theory of Point Estimation (2nd ed.). New York: Springer. ISBN 978-0-387-98502-2. MR 1639875.

- ^ Gareth, James; Witten, Daniela; Hastie, Trevor; Tibshirani, Rob (2021). An Introduction to Statistical Learning: with Applications in R. Springer. ISBN 978-1071614174.

- ^ Wackerly, Dennis; Mendenhall, William; Scheaffer, Richard L. (2008). Mathematical Statistics with Applications (7 ed.). Belmont, CA, USA: Thomson Higher Education. ISBN 978-0-495-38508-0.

- ^ A modern introduction to probability and statistics : understanding why and how. Dekking, Michel, 1946-. London: Springer. 2005. ISBN 978-1-85233-896-1. OCLC 262680588.

{{cite book}}: CS1 maint: others (link) - ^ Steel, R.G.D, and Torrie, J. H., Principles and Procedures of Statistics with Special Reference to the Biological Sciences., McGraw Hill, 1960, page 288.

- ^ Mood, A.; Graybill, F.; Boes, D. (1974). Introduction to the Theory of Statistics (3rd ed.). McGraw-Hill. p. 229.

- ^ DeGroot, Morris H. (1980). Probability and Statistics (2nd ed.). Addison-Wesley.

- ^ Berger, James O. (1985). «2.4.2 Certain Standard Loss Functions». Statistical Decision Theory and Bayesian Analysis (2nd ed.). New York: Springer-Verlag. p. 60. ISBN 978-0-387-96098-2. MR 0804611.

- ^ Bermejo, Sergio; Cabestany, Joan (2001). «Oriented principal component analysis for large margin classifiers». Neural Networks. 14 (10): 1447–1461. doi:10.1016/S0893-6080(01)00106-X. PMID 11771723.

From Wikipedia, the free encyclopedia

In statistics, the mean squared error (MSE)[1] or mean squared deviation (MSD) of an estimator (of a procedure for estimating an unobserved quantity) measures the average of the squares of the errors—that is, the average squared difference between the estimated values and the actual value. MSE is a risk function, corresponding to the expected value of the squared error loss.[2] The fact that MSE is almost always strictly positive (and not zero) is because of randomness or because the estimator does not account for information that could produce a more accurate estimate.[3] In machine learning, specifically empirical risk minimization, MSE may refer to the empirical risk (the average loss on an observed data set), as an estimate of the true MSE (the true risk: the average loss on the actual population distribution).

The MSE is a measure of the quality of an estimator. As it is derived from the square of Euclidean distance, it is always a positive value that decreases as the error approaches zero.

The MSE is the second moment (about the origin) of the error, and thus incorporates both the variance of the estimator (how widely spread the estimates are from one data sample to another) and its bias (how far off the average estimated value is from the true value).[citation needed] For an unbiased estimator, the MSE is the variance of the estimator. Like the variance, MSE has the same units of measurement as the square of the quantity being estimated. In an analogy to standard deviation, taking the square root of MSE yields the root-mean-square error or root-mean-square deviation (RMSE or RMSD), which has the same units as the quantity being estimated; for an unbiased estimator, the RMSE is the square root of the variance, known as the standard error.

Definition and basic properties[edit]

The MSE either assesses the quality of a predictor (i.e., a function mapping arbitrary inputs to a sample of values of some random variable), or of an estimator (i.e., a mathematical function mapping a sample of data to an estimate of a parameter of the population from which the data is sampled). The definition of an MSE differs according to whether one is describing a predictor or an estimator.

Predictor[edit]

If a vector of

In other words, the MSE is the mean

In matrix notation,

where

The MSE can also be computed on q data points that were not used in estimating the model, either because they were held back for this purpose, or because these data have been newly obtained. Within this process, known as statistical learning, the MSE is often called the test MSE,[4] and is computed as

Estimator[edit]

The MSE of an estimator

This definition depends on the unknown parameter, but the MSE is a priori a property of an estimator. The MSE could be a function of unknown parameters, in which case any estimator of the MSE based on estimates of these parameters would be a function of the data (and thus a random variable). If the estimator

The MSE can be written as the sum of the variance of the estimator and the squared bias of the estimator, providing a useful way to calculate the MSE and implying that in the case of unbiased estimators, the MSE and variance are equivalent.[5]

Proof of variance and bias relationship[edit]

An even shorter proof can be achieved using the well-known formula that for a random variable

But in real modeling case, MSE could be described as the addition of model variance, model bias, and irreducible uncertainty (see Bias–variance tradeoff). According to the relationship, the MSE of the estimators could be simply used for the efficiency comparison, which includes the information of estimator variance and bias. This is called MSE criterion.

In regression[edit]

In regression analysis, plotting is a more natural way to view the overall trend of the whole data. The mean of the distance from each point to the predicted regression model can be calculated, and shown as the mean squared error. The squaring is critical to reduce the complexity with negative signs. To minimize MSE, the model could be more accurate, which would mean the model is closer to actual data. One example of a linear regression using this method is the least squares method—which evaluates appropriateness of linear regression model to model bivariate dataset,[6] but whose limitation is related to known distribution of the data.

The term mean squared error is sometimes used to refer to the unbiased estimate of error variance: the residual sum of squares divided by the number of degrees of freedom. This definition for a known, computed quantity differs from the above definition for the computed MSE of a predictor, in that a different denominator is used. The denominator is the sample size reduced by the number of model parameters estimated from the same data, (n−p) for p regressors or (n−p−1) if an intercept is used (see errors and residuals in statistics for more details).[7] Although the MSE (as defined in this article) is not an unbiased estimator of the error variance, it is consistent, given the consistency of the predictor.

In regression analysis, «mean squared error», often referred to as mean squared prediction error or «out-of-sample mean squared error», can also refer to the mean value of the squared deviations of the predictions from the true values, over an out-of-sample test space, generated by a model estimated over a particular sample space. This also is a known, computed quantity, and it varies by sample and by out-of-sample test space.

Examples[edit]

Mean[edit]

Suppose we have a random sample of size

which has an expected value equal to the true mean

where

For a Gaussian distribution, this is the best unbiased estimator (i.e., one with the lowest MSE among all unbiased estimators), but not, say, for a uniform distribution.

Variance[edit]

The usual estimator for the variance is the corrected sample variance:

This is unbiased (its expected value is

where

However, one can use other estimators for

then we calculate:

This is minimized when

For a Gaussian distribution, where

Further, while the corrected sample variance is the best unbiased estimator (minimum mean squared error among unbiased estimators) of variance for Gaussian distributions, if the distribution is not Gaussian, then even among unbiased estimators, the best unbiased estimator of the variance may not be

Gaussian distribution[edit]

The following table gives several estimators of the true parameters of the population, μ and σ2, for the Gaussian case.[9]

| True value | Estimator | Mean squared error |

|---|---|---|

|

= the unbiased estimator of the population mean, = the unbiased estimator of the population mean,  |

|

|

= the unbiased estimator of the population variance, = the unbiased estimator of the population variance,  |

|

|

= the biased estimator of the population variance, = the biased estimator of the population variance,  |

|

|

= the biased estimator of the population variance, = the biased estimator of the population variance,  |

|

Interpretation[edit]

An MSE of zero, meaning that the estimator

Values of MSE may be used for comparative purposes. Two or more statistical models may be compared using their MSEs—as a measure of how well they explain a given set of observations: An unbiased estimator (estimated from a statistical model) with the smallest variance among all unbiased estimators is the best unbiased estimator or MVUE (Minimum-Variance Unbiased Estimator).

Both analysis of variance and linear regression techniques estimate the MSE as part of the analysis and use the estimated MSE to determine the statistical significance of the factors or predictors under study. The goal of experimental design is to construct experiments in such a way that when the observations are analyzed, the MSE is close to zero relative to the magnitude of at least one of the estimated treatment effects.

In one-way analysis of variance, MSE can be calculated by the division of the sum of squared errors and the degree of freedom. Also, the f-value is the ratio of the mean squared treatment and the MSE.

MSE is also used in several stepwise regression techniques as part of the determination as to how many predictors from a candidate set to include in a model for a given set of observations.

Applications[edit]

- Minimizing MSE is a key criterion in selecting estimators: see minimum mean-square error. Among unbiased estimators, minimizing the MSE is equivalent to minimizing the variance, and the estimator that does this is the minimum variance unbiased estimator. However, a biased estimator may have lower MSE; see estimator bias.

- In statistical modelling the MSE can represent the difference between the actual observations and the observation values predicted by the model. In this context, it is used to determine the extent to which the model fits the data as well as whether removing some explanatory variables is possible without significantly harming the model’s predictive ability.

- In forecasting and prediction, the Brier score is a measure of forecast skill based on MSE.

Loss function[edit]

Squared error loss is one of the most widely used loss functions in statistics[citation needed], though its widespread use stems more from mathematical convenience than considerations of actual loss in applications. Carl Friedrich Gauss, who introduced the use of mean squared error, was aware of its arbitrariness and was in agreement with objections to it on these grounds.[3] The mathematical benefits of mean squared error are particularly evident in its use at analyzing the performance of linear regression, as it allows one to partition the variation in a dataset into variation explained by the model and variation explained by randomness.

Criticism[edit]

The use of mean squared error without question has been criticized by the decision theorist James Berger. Mean squared error is the negative of the expected value of one specific utility function, the quadratic utility function, which may not be the appropriate utility function to use under a given set of circumstances. There are, however, some scenarios where mean squared error can serve as a good approximation to a loss function occurring naturally in an application.[10]

Like variance, mean squared error has the disadvantage of heavily weighting outliers.[11] This is a result of the squaring of each term, which effectively weights large errors more heavily than small ones. This property, undesirable in many applications, has led researchers to use alternatives such as the mean absolute error, or those based on the median.

See also[edit]

- Bias–variance tradeoff

- Hodges’ estimator

- James–Stein estimator

- Mean percentage error

- Mean square quantization error

- Mean square weighted deviation

- Mean squared displacement

- Mean squared prediction error

- Minimum mean square error

- Minimum mean squared error estimator

- Overfitting

- Peak signal-to-noise ratio

Notes[edit]

- ^ This can be proved by Jensen’s inequality as follows. The fourth central moment is an upper bound for the square of variance, so that the least value for their ratio is one, therefore, the least value for the excess kurtosis is −2, achieved, for instance, by a Bernoulli with p=1/2.

References[edit]

- ^ a b «Mean Squared Error (MSE)». www.probabilitycourse.com. Retrieved 2020-09-12.

- ^ Bickel, Peter J.; Doksum, Kjell A. (2015). Mathematical Statistics: Basic Ideas and Selected Topics. Vol. I (Second ed.). p. 20.

If we use quadratic loss, our risk function is called the mean squared error (MSE) …

- ^ a b Lehmann, E. L.; Casella, George (1998). Theory of Point Estimation (2nd ed.). New York: Springer. ISBN 978-0-387-98502-2. MR 1639875.

- ^ Gareth, James; Witten, Daniela; Hastie, Trevor; Tibshirani, Rob (2021). An Introduction to Statistical Learning: with Applications in R. Springer. ISBN 978-1071614174.

- ^ Wackerly, Dennis; Mendenhall, William; Scheaffer, Richard L. (2008). Mathematical Statistics with Applications (7 ed.). Belmont, CA, USA: Thomson Higher Education. ISBN 978-0-495-38508-0.

- ^ A modern introduction to probability and statistics : understanding why and how. Dekking, Michel, 1946-. London: Springer. 2005. ISBN 978-1-85233-896-1. OCLC 262680588.

{{cite book}}: CS1 maint: others (link) - ^ Steel, R.G.D, and Torrie, J. H., Principles and Procedures of Statistics with Special Reference to the Biological Sciences., McGraw Hill, 1960, page 288.

- ^ Mood, A.; Graybill, F.; Boes, D. (1974). Introduction to the Theory of Statistics (3rd ed.). McGraw-Hill. p. 229.

- ^ DeGroot, Morris H. (1980). Probability and Statistics (2nd ed.). Addison-Wesley.

- ^ Berger, James O. (1985). «2.4.2 Certain Standard Loss Functions». Statistical Decision Theory and Bayesian Analysis (2nd ed.). New York: Springer-Verlag. p. 60. ISBN 978-0-387-96098-2. MR 0804611.

- ^ Bermejo, Sergio; Cabestany, Joan (2001). «Oriented principal component analysis for large margin classifiers». Neural Networks. 14 (10): 1447–1461. doi:10.1016/S0893-6080(01)00106-X. PMID 11771723.

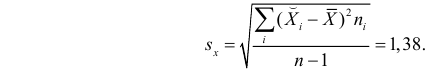

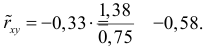

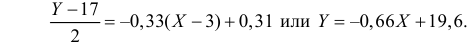

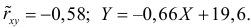

Содержание:

Регрессионный анализ:

Регрессионным анализом называется раздел математической статистики, объединяющий практические методы исследования корреляционной зависимости между случайными величинами по результатам наблюдений над ними. Сюда включаются методы выбора модели изучаемой зависимости и оценки ее параметров, методы проверки статистических гипотез о зависимости.

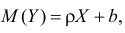

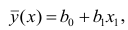

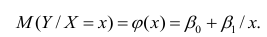

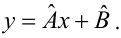

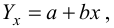

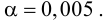

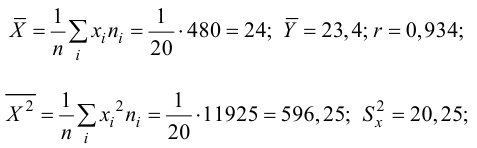

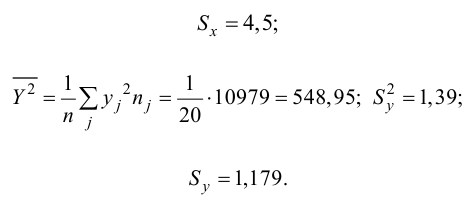

Пусть между случайными величинами X и Y существует линейная корреляционная зависимость. Это означает, что математическое ожидание Y линейно зависит от значений случайной величины X. График этой зависимости (линия регрессии Y на X) имеет уравнение

Линейная модель пригодна в качестве первого приближения и в случае нелинейной корреляции, если рассматривать небольшие интервалы возможных значений случайных величин.

Пусть параметры линии регрессии  неизвестны, неизвестна и величина коэффициента корреляции

неизвестны, неизвестна и величина коэффициента корреляции  Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:

Над случайными величинами X и Y проделано n независимых наблюдений, в результате которых получены n пар значений:  Эти результаты могут служить источником информации о неизвестных значениях

Эти результаты могут служить источником информации о неизвестных значениях  надо только уметь эту информацию извлечь оттуда.

надо только уметь эту информацию извлечь оттуда.

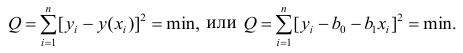

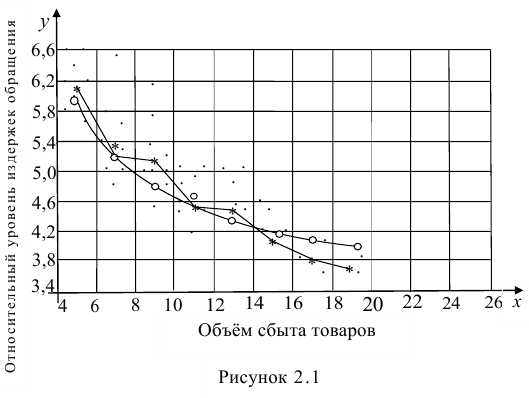

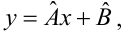

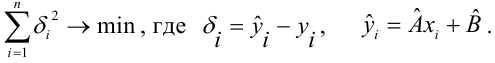

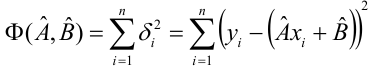

Неизвестная нам линия регрессии  как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для

как и всякая линия регрессии, имеет то отличительное свойство, что средний квадрат отклонений значений Y от нее минимален. Поэтому в качестве оценок для  можно принять те их значения, при которых имеет минимум функция

можно принять те их значения, при которых имеет минимум функция

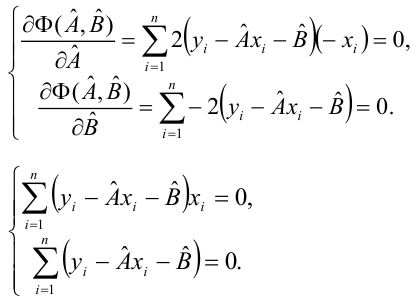

Такие значения  , согласно необходимым условиям экстремума, находятся из системы уравнений:

, согласно необходимым условиям экстремума, находятся из системы уравнений:

Решения этой системы уравнений дают оценки называемые оценками по методу наименьших квадратов.

и

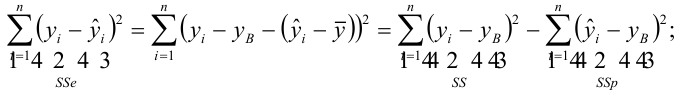

Известно, что оценки по методу наименьших квадратов являются несмещенными и, более того, среди всех несмещенных оценок обладают наименьшей дисперсией. Для оценки коэффициента корреляции можно воспользоваться тем, что  где

где  средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через

средние квадратические отклонения случайных величин X и Y соответственно. Обозначим через  оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

оценки этих средних квадратических отклонений на основе опытных данных. Оценки можно найти, например, по формуле (3.1.3). Тогда для коэффициента корреляции имеем оценку

По методу наименьших квадратов можно находить оценки параметров линии регрессии и при нелинейной корреляции. Например, для линии регрессии вида  оценки параметров

оценки параметров  находятся из условия минимума функции

находятся из условия минимума функции

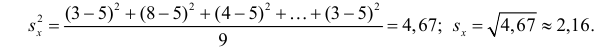

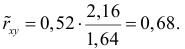

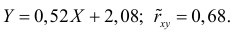

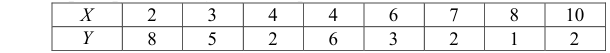

Пример:

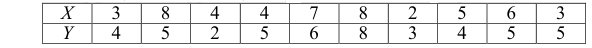

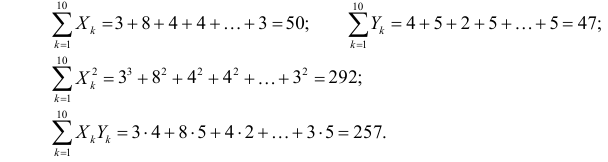

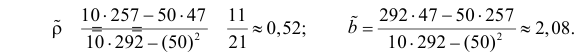

По данным наблюдений двух случайных величин найти коэффициент корреляции и уравнение линии регрессии Y на X

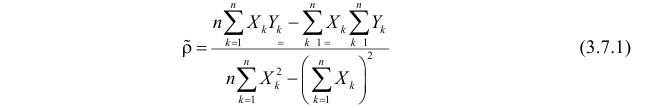

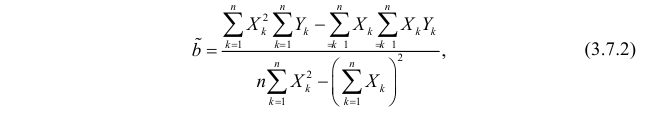

Решение. Вычислим величины, необходимые для использования формул (3.7.1)–(3.7.3):

По формулам (3.7.1) и (3.7.2) получим

Итак, оценка линии регрессии имеет вид  Так как

Так как  то по формуле (3.1.3)

то по формуле (3.1.3)

Аналогично,  Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Поэтому в качестве оценки коэффициента корреляции имеем по формуле (3.7.3) величину

Ответ.

Пример:

Получена выборка значений величин X и Y

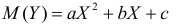

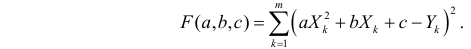

Для представления зависимости между величинами предполагается использовать модель  Найти оценки параметров

Найти оценки параметров

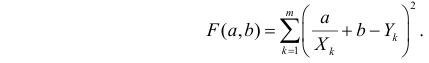

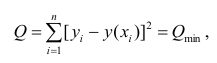

Решение. Рассмотрим сначала задачу оценки параметров этой модели в общем виде. Линия  играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

играет роль линии регрессии и поэтому параметры ее можно найти из условия минимума функции (сумма квадратов отклонений значений Y от линии должна быть минимальной по свойству линии регрессии)

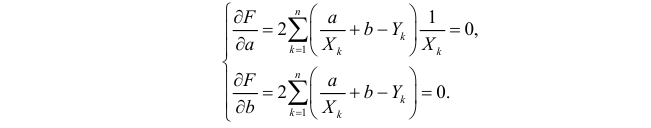

Необходимые условия экстремума приводят к системе из двух уравнений:

Откуда

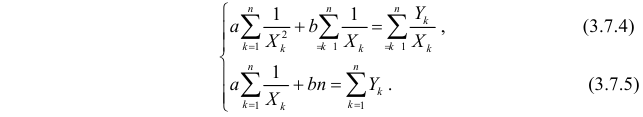

Решения системы уравнений (3.7.4) и (3.7.5) и будут оценками по методу наименьших квадратов для параметров

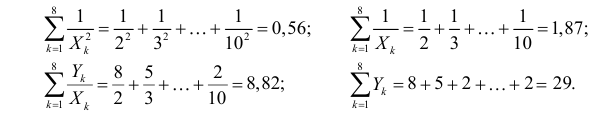

На основе опытных данных вычисляем:

В итоге получаем систему уравнений (?????) и (?????) в виде

Эта система имеет решения

Ответ.

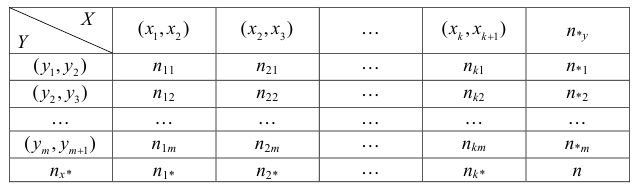

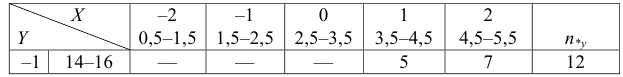

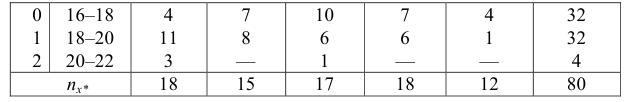

Если наблюдений много, то результаты их обычно группируют и представляют в виде корреляционной таблицы.

В этой таблице  равно числу наблюдений, для которых X находится в интервале

равно числу наблюдений, для которых X находится в интервале  а Y – в интервале

а Y – в интервале  Через

Через  обозначено число наблюдений, при которых

обозначено число наблюдений, при которых  а Y произвольно. Число наблюдений, при которых

а Y произвольно. Число наблюдений, при которых  а X произвольно, обозначено через

а X произвольно, обозначено через

Если величины дискретны, то вместо интервалов указывают отдельные значения этих величин. Для непрерывных случайных величин представителем каждого интервала считают его середину и полагают, что  и

и  наблюдались

наблюдались  раз.

раз.

При больших значениях X и Y можно для упрощения вычислений перенести начало координат и изменить масштаб по каждой из осей, а после завершения вычислений вернуться к старому масштабу.

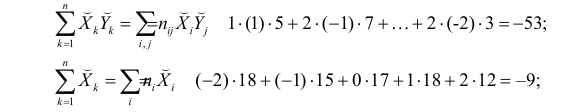

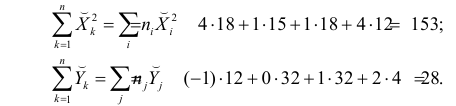

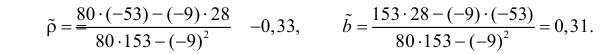

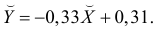

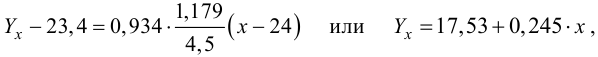

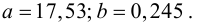

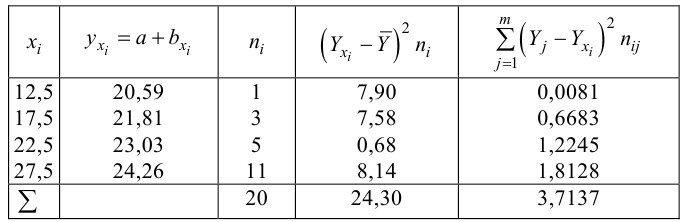

Пример:

Проделано 80 наблюдений случайных величин X и Y. Результаты наблюдений представлены в виде таблицы. Найти линию регрессии Y на X. Оценить коэффициент корреляции.

Решение. Представителем каждого интервала будем считать его середину. Перенесем начало координат и изменим масштаб по каждой оси так, чтобы значения X и Y были удобны для вычислений. Для этого перейдем к новым переменным  Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

Значения этих новых переменных указаны соответственно в самой верхней строке и самом левом столбце таблицы.

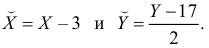

Чтобы иметь представление о виде линии регрессии, вычислим средние значения  при фиксированных значениях

при фиксированных значениях  :

:

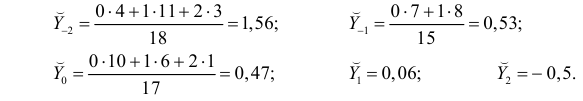

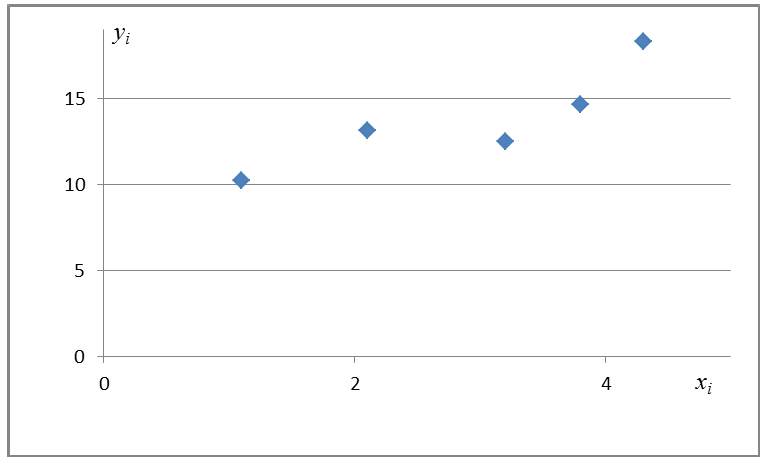

Нанесем эти значения на координатную плоскость, соединив для наглядности их отрезками прямой (рис. 3.7.1).

По виду полученной ломанной линии можно предположить, что линия регрессии Y на X является прямой. Оценим ее параметры. Для этого сначала вычислим с учетом группировки данных в таблице все величины, необходимые для использования формул (3.31–3.33):

Тогда

В новом масштабе оценка линии регрессии имеет вид  График этой прямой линии изображен на рис. 3.7.1.

График этой прямой линии изображен на рис. 3.7.1.

Для оценки  по корреляционной таблице можно воспользоваться формулой (3.1.3):

по корреляционной таблице можно воспользоваться формулой (3.1.3):

Подобным же образом можно оценить  величиной

величиной  Тогда оценкой коэффициента корреляции может служить величина

Тогда оценкой коэффициента корреляции может служить величина

Вернемся к старому масштабу:

Коэффициент корреляции пересчитывать не нужно, так как это величина безразмерная и от масштаба не зависит.

Ответ.

Пусть некоторые физические величины X и Y связаны неизвестной нам функциональной зависимостью  Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то

Для изучения этой зависимости производят измерения Y при разных значениях X. Измерениям сопутствуют ошибки и поэтому результат каждого измерения случаен. Если систематической ошибки при измерениях нет, то  играет роль линии регрессии и все свойства линии регрессии приложимы к

играет роль линии регрессии и все свойства линии регрессии приложимы к  . В частности,

. В частности,  обычно находят по методу наименьших квадратов.

обычно находят по методу наименьших квадратов.

Регрессионный анализ

Основные положения регрессионного анализа:

Основная задача регрессионного анализа — изучение зависимости между результативным признаком Y и наблюдавшимся признаком X, оценка функции регрессий.

Предпосылки регрессионного анализа:

- Y — независимые случайные величины, имеющие постоянную дисперсию;

- X— величины наблюдаемого признака (величины не случайные);

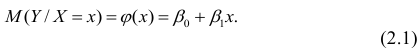

- условное математическое ожидание

можно представить в виде

можно представить в виде

Выражение (2.1), как уже упоминалось в п. 1.2, называется функцией регрессии (или модельным уравнением регрессии) Y на X. Оценке в этом выражении подлежат параметры  называемые коэффициентами регрессии, а также

называемые коэффициентами регрессии, а также  — остаточная дисперсия.

— остаточная дисперсия.

Остаточной дисперсией называется та часть рассеивания результативного признака, которую нельзя объяснить действием наблюдаемого признака; Остаточная дисперсия может служить для оценки точности подбора вида функции регрессии (модельного уравнения регрессии), полноты набора признаков, включенных в анализ. Оценки параметров функции регрессии находят, используя метод наименьших квадратов.

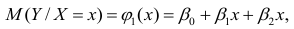

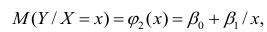

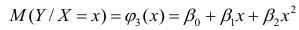

В данном вопросе рассмотрен линейный регрессионный анализ. Линейным он называется потому, что изучаем лишь те виды зависимостей которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

которые линейны по оцениваемым параметрам, хотя могут быть нелинейны по переменным X. Например, зависимости

линейны относительно параметров

линейны относительно параметров

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости

хотя вторая и третья зависимости нелинейны относительно переменных х. Вид зависимости  выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

выбирают, исходя из визуальной оценки характера расположения точек на поле корреляции; опыта предыдущих исследований; соображений профессионального характера, основанных и знании физической сущности процесса.

Важное место в линейном регрессионном анализе занимает так называемая «нормальная регрессия». Она имеет место, если сделать предположения относительно закона распределения случайной величины Y. Предпосылки «нормальной регрессии»:

- Y — независимые случайные величины, имеющие постоянную дисперсию и распределенные по нормальному закону;

- X— величины наблюдаемого признака (величины не случайные);

- условное математическое ожидание

можно представить в виде (2.1).

можно представить в виде (2.1).

В этом случае оценки коэффициентов регрессии — несмещённые с минимальной дисперсией и нормальным законом распределения. Из этого положения следует что при «нормальной регрессии» имеется возможность оценить значимость оценок коэффициентов регрессии, а также построить доверительный интервал для коэффициентов регрессии и условного математического ожидания M(YX=x).

Линейная регрессия

Рассмотрим простейший случай регрессионного анализа — модель вида (2.1), когда зависимость  линейна и по оцениваемым параметрам, и

линейна и по оцениваемым параметрам, и

по переменным. Оценки параметров модели (2.1)  обозначил

обозначил  Оценку остаточной дисперсии

Оценку остаточной дисперсии  обозначим

обозначим  Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии

Подставив в формулу (2.1) вместо параметров их оценки, получим уравнение регрессии  коэффициенты которого

коэффициенты которого  находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака

находят из условия минимума суммы квадратов отклонений измеренных значений результативного признака от вычисленных по уравнению регрессии

от вычисленных по уравнению регрессии

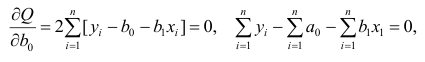

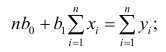

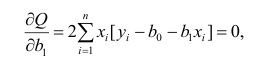

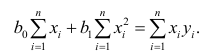

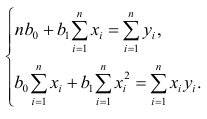

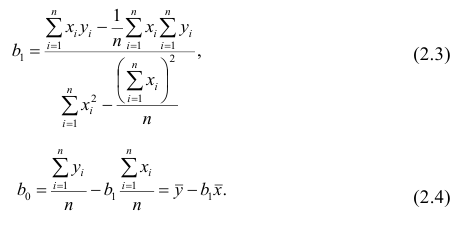

Составим систему нормальных уравнений: первое уравнение

откуда

второе уравнение

откуда

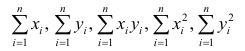

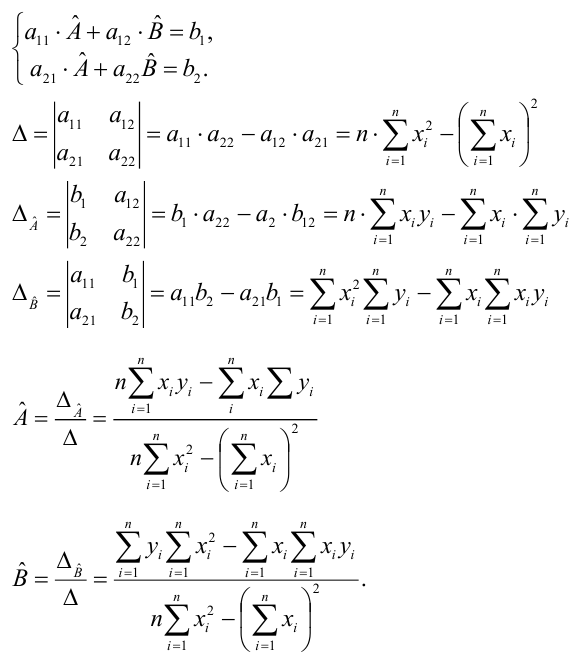

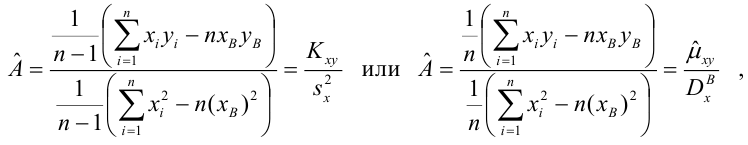

Итак,

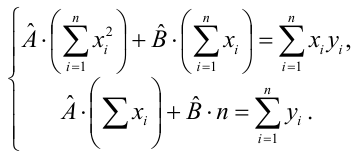

Оценки, полученные по способу наименьших квадратов, обладают минимальной дисперсией в классе линейных оценок. Решая систему (2.2) относительно найдём оценки параметров

найдём оценки параметров

Остаётся получить оценку параметра  . Имеем

. Имеем

где т — количество наблюдений.

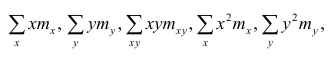

Еслит велико, то для упрощения расчётов наблюдавшиеся данные принята группировать, т.е. строить корреляционную таблицу. Пример построения такой таблицы приведен в п. 1.5. Формулы для нахождения коэффициентов регрессии по сгруппированным данным те же, что и для расчёта по несгруппированным данным, но суммы заменяют на

заменяют на

где  — частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

— частоты повторений соответствующих значений переменных. В дальнейшем часто используется этот наглядный приём вычислений.

Нелинейная регрессия

Рассмотрим случай, когда зависимость нелинейна по переменным х, например модель вида

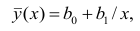

На рис. 2.1 изображено поле корреляции. Очевидно, что зависимость между Y и X нелинейная и её графическим изображением является не прямая, а кривая. Оценкой выражения (2.6) является уравнение регрессии

где  —оценки коэффициентов регрессии

—оценки коэффициентов регрессии

Принцип нахождения коэффициентов тот же — метод наименьших квадратов, т.е.

или

Дифференцируя последнее равенство по  и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

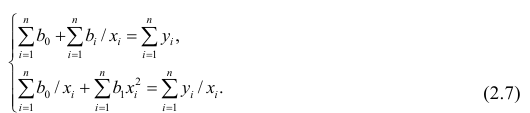

и приравнивая правые части нулю, получаем так называемую систему нормальных уравнений:

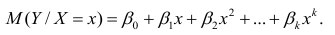

В общем случае нелинейной зависимости между переменными Y и X связь может выражаться многочленом k-й степени от x:

Коэффициенты регрессии определяют по принципу наименьших квадратов. Система нормальных уравнений имеет вид

Вычислив коэффициенты системы, её можно решить любым известным способом.

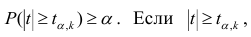

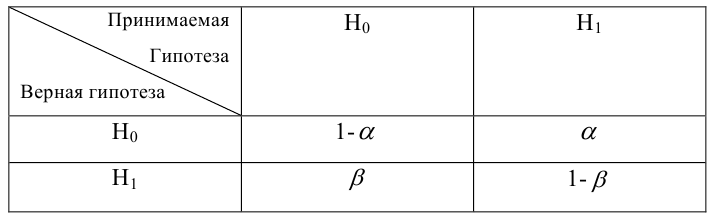

Оценка значимости коэффициентов регрессии. Интервальная оценка коэффициентов регрессии

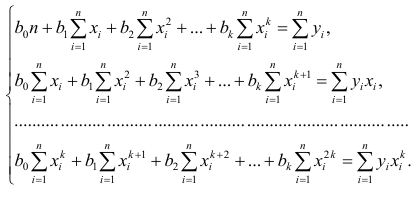

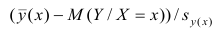

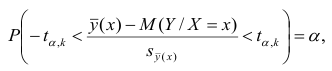

Проверить значимость оценок коэффициентов регрессии — значит установить, достаточна ли величина оценки для статистически обоснованного вывода о том, что коэффициент регрессии отличен от нуля. Для этого проверяют гипотезу о равенстве нулю коэффициента регрессии, соблюдая предпосылки «нормальной регрессии». В этом случае вычисляемая для проверки нулевой гипотезы  статистика

статистика

имеет распределение Стьюдента с к= n-2 степенями свободы (b — оценка коэффициента регрессии,  — оценка среднеквадратического отклонения

— оценка среднеквадратического отклонения

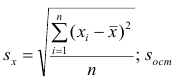

коэффициента регрессии, иначе стандартная ошибка оценки). По уровню значимости а и числу степеней свободы к находят по таблицам распределения Стьюдента (см. табл. 1 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают, коэффициент считают значимым. При нет оснований отвергать нулевую гипотезу.

нет оснований отвергать нулевую гипотезу.

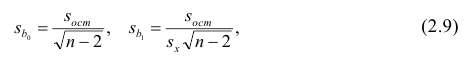

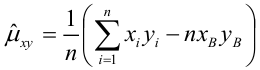

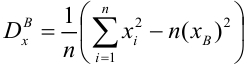

Оценки среднеквадратического отклонения коэффициентов регрессии вычисляют по следующим формулам:

где  — оценка остаточной дисперсии, вычисляемая по

— оценка остаточной дисперсии, вычисляемая по

формуле (2.5).

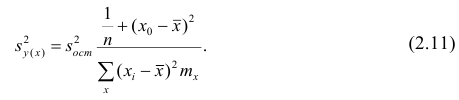

Доверительный интервал для значимых параметров строят по обычной схеме. Из условия

где а — уровень значимости, находим

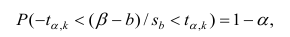

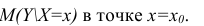

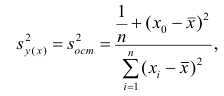

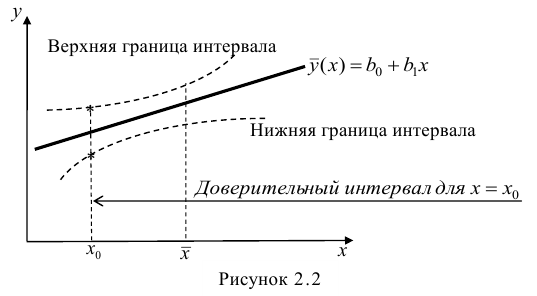

Интервальная оценка для условного математического ожидания

Линия регрессии характеризует изменение условного математического ожидания результативного признака от вариации остальных признаков.

Точечной оценкой условного математического ожидания  является условное среднее

является условное среднее  Кроме точечной оценки для

Кроме точечной оценки для  можно

можно

построить доверительный интервал в точке

Известно, что  имеет распределение

имеет распределение

Стьюдента с k=n—2 степенями свободы. Найдя оценку среднеквадратического отклонения для условного среднего, можно построить доверительный интервал для условного математического ожидания

Оценку дисперсии условного среднего вычисляют по формуле

или для интервального ряда

Доверительный интервал находят из условия

где а — уровень значимости. Отсюда

Доверительный интервал для условного математического ожидания можно изобразить графически (рис, 2.2).

Из рис. 2.2 видно, что в точке  границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

границы интервала наиболее близки друг другу. Расположение границ доверительного интервала показывает, что прогнозы по уравнению регрессии, хороши только в случае, если значение х не выходит за пределы выборки, по которой вычислено уравнение регрессии; иными словами, экстраполяция по уравнению регрессии может привести к значительным погрешностям.

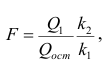

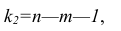

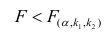

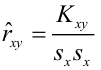

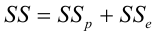

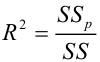

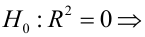

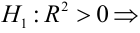

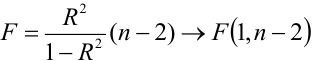

Проверка значимости уравнения регрессии

Оценить значимость уравнения регрессии — значит установить, соответствует ли математическая, модель, выражающая зависимость между Y и X, экспериментальным данным. Для оценки значимости в предпосылках «нормальной регрессии» проверяют гипотезу  Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением

Если она отвергается, то считают, что между Y и X нет связи (или связь нелинейная). Для проверки нулевой гипотезы используют основное положение дисперсионного анализа о разбиении суммы квадратов на слагаемые. Воспользуемся разложением  — Общая сумма квадратов отклонений результативного признака

— Общая сумма квадратов отклонений результативного признака

разлагается на

разлагается на  (сумму, характеризующую влияние признака

(сумму, характеризующую влияние признака

X) и  (остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

(остаточную сумму квадратов, характеризующую влияние неучтённых факторов). Очевидно, чем меньше влияние неучтённых факторов, тем лучше математическая модель соответствует экспериментальным данным, так как вариация У в основном объясняется влиянием признака X.

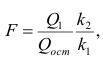

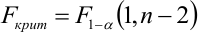

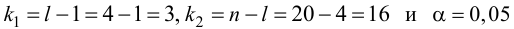

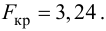

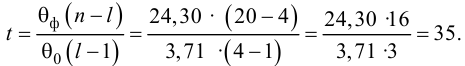

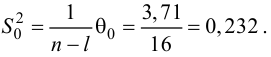

Для проверки нулевой гипотезы вычисляют статистику  которая имеет распределение Фишера-Снедекора с А

которая имеет распределение Фишера-Снедекора с А степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы

степенями свободы (в п — число наблюдений). По уровню значимости а и числу степеней свободы  находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение

находят по таблицам F-распределение для уровня значимости а=0,05 (см. табл. 3 приложений) критическое значение удовлетворяющее условию

удовлетворяющее условию  . Если

. Если  нулевую гипотезу отвергают, уравнение считают значимым. Если

нулевую гипотезу отвергают, уравнение считают значимым. Если  то нет оснований отвергать нулевую гипотезу.

то нет оснований отвергать нулевую гипотезу.

Многомерный регрессионный анализ

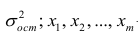

В случае, если изменения результативного признака определяются действием совокупности других признаков, имеет место многомерный регрессионный анализ. Пусть результативный признак У, а независимые признаки  Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним

Для многомерного случая предпосылки регрессионного анализа можно сформулировать следующим образом: У -независимые случайные величины со средним  и постоянной дисперсией

и постоянной дисперсией  — линейно независимые векторы

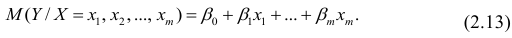

— линейно независимые векторы  . Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

. Все положения, изложенные в п.2.1, справедливы для многомерного случая. Рассмотрим модель вида

Оценке подлежат параметры  и остаточная дисперсия.

и остаточная дисперсия.

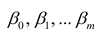

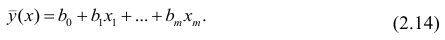

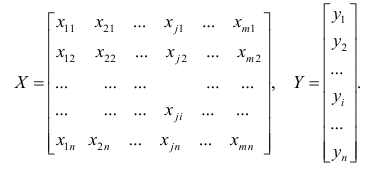

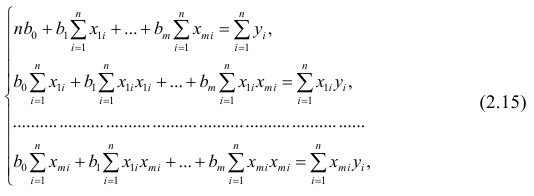

Заменив параметры их оценками, запишем уравнение регрессии

Коэффициенты в этом выражении находят методом наименьших квадратов.

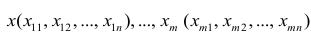

Исходными данными для вычисления коэффициентов  является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

является выборка из многомерной совокупности, представляемая обычно в виде матрицы X и вектора Y:

Как и в двумерном случае, составляют систему нормальных уравнений

которую можно решить любым способом, известным из линейной алгебры. Рассмотрим один из них — способ обратной матрицы. Предварительно преобразуем систему уравнений. Выразим из первого уравнения значение  через остальные параметры:

через остальные параметры:

Подставим в остальные уравнения системы вместо  полученное выражение:

полученное выражение:

Пусть С — матрица коэффициентов при неизвестных параметрах

— матрица, обратная матрице С;

— матрица, обратная матрице С;  — элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы

— элемент, стоящий на пересечении i-Й строки и i-го столбца матрицы — выражение

— выражение

. Тогда, используя формулы линейной алгебры,

. Тогда, используя формулы линейной алгебры,

запишем окончательные выражения для параметров:

Оценкой остаточной дисперсии является

является

где  — измеренное значение результативного признака;

— измеренное значение результативного признака; значение результативного признака, вычисленное по уравнению регрессий.

значение результативного признака, вычисленное по уравнению регрессий.

Если выборка получена из нормально распределенной генеральной совокупности, то, аналогично изложенному в п. 2.4, можно проверить значимость оценок коэффициентов регрессии, только в данном случае статистику вычисляют для каждого j-го коэффициента регрессии

вычисляют для каждого j-го коэффициента регрессии

где  —элемент обратной матрицы, стоящий на пересечении i-й строки и j-

—элемент обратной матрицы, стоящий на пересечении i-й строки и j-

го столбца; —диагональный элемент обратной матрицы.

—диагональный элемент обратной матрицы.

При заданном уровне значимости а и числе степеней свободы к=n— m—1 по табл. 1 приложений находят критическое значение  Если

Если то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если

то нулевую гипотезу о равенстве нулю коэффициента регрессии отвергают. Оценку коэффициента считают значимой. Такую проверку производят последовательно для каждого коэффициента регрессии. Если то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

то нет оснований отвергать нулевую гипотезу, оценку коэффициента регрессии считают незначимой.

Для значимых коэффициентов регрессии целесообразно построить доверительные интервалы по формуле (2.10). Для оценки значимости уравнения регрессии следует проверить нулевую гипотезу о том, что все коэффициенты регрессии (кроме свободного члена) равны нулю:

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики

— вектор коэффициентов регрессии). Нулевую гипотезу проверяют, так же как и в п. 2.6, с помощью статистики  , где

, где  — сумма квадратов, характеризующая влияние признаков X;

— сумма квадратов, характеризующая влияние признаков X;  — остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

— остаточная сумма квадратов, характеризующая влияние неучтённых факторов;

Для уровня значимости а и числа степеней свободы

Для уровня значимости а и числа степеней свободы  по табл. 3 приложений находят критическое значение

по табл. 3 приложений находят критическое значение  Если

Если  то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При

то нулевую гипотезу об одновременном равенстве нулю коэффициентов регрессии отвергают. Уравнение регрессии считают значимым. При  нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

нет оснований отвергать нулевую гипотезу, уравнение регрессии считают незначимым.

Факторный анализ

Основные положения. В последнее время всё более широкое распространение находит один из новых разделов многомерного статистического анализа — факторный анализ. Первоначально этот метод

разрабатывался для объяснения многообразия корреляций между исходными параметрами. Действительно, результатом корреляционного анализа является матрица коэффициентов корреляций. При малом числе параметров можно произвести визуальный анализ этой матрицы. С ростом числа параметра (10 и более) визуальный анализ не даёт положительных результатов. Оказалось, что всё многообразие корреляционных связей можно объяснить действием нескольких обобщённых факторов, являющихся функциями исследуемых параметров, причём сами обобщённые факторы при этом могут быть и неизвестны, однако их можно выразить через исследуемые параметры.

Один из основоположников факторного анализа Л. Терстоун приводит такой пример: несколько сотен мальчиков выполняют 20 разнообразных гимнастических упражнений. Каждое упражнение оценивают баллами. Можно рассчитать матрицу корреляций между 20 упражнениями. Это большая матрица размером 20><20. Изучая такую матрицу, трудно уловить закономерность связей между упражнениями. Нельзя ли объяснить скрытую в таблице закономерность действием каких-либо обобщённых факторов, которые в результате эксперимента непосредственно, не оценивались? Оказалось, что обо всех коэффициентах корреляции можно судить по трём обобщённым факторам, которые и определяют успех выполнения всех 20 гимнастических упражнений: чувство равновесия, усилие правого плеча, быстрота движения тела.

Дальнейшие разработки факторного анализа доказали, что этот метод может быть с успехом применён в задачах группировки и классификации объектов. Факторный анализ позволяет группировать объекты со сходными сочетаниями признаков и группировать признаки с общим характером изменения от объекта к объекту. Действительно, выделенные обобщённые факторы можно использовать как критерии при классификации мальчиков по способностям к отдельным группам гимнастических упражнений.

Методы факторного анализа находят применение в психологии и экономике, социологии и экономической географии. Факторы, выраженные через исходные параметры, как правило, легко интерпретировать как некоторые существенные внутренние характеристики объектов.

Факторный анализ может быть использован и как самостоятельный метод исследования, и вместе с другими методами многомерного анализа, например в сочетании с регрессионным анализом. В этом случае для набора зависимых переменных наводят обобщённые факторы, которые потом входят в регрессионный анализ в качестве переменных. Такой подход позволяет сократить число переменных в регрессионном анализе, устранить коррелированность переменных, уменьшить влияние ошибок и в случае ортогональности выделенных факторов значительно упростить оценку значимости переменных.

Представление, информации в факторном анализе

Для проведения факторного анализа информация должна быть представлена в виде двумерной таблицы чисел размерностью  аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений

аналогичной приведенной в п. 2.7 (матрица исходных данных). Строки этой матрицы должны соответствовать объектам наблюдений  столбцы — признакам

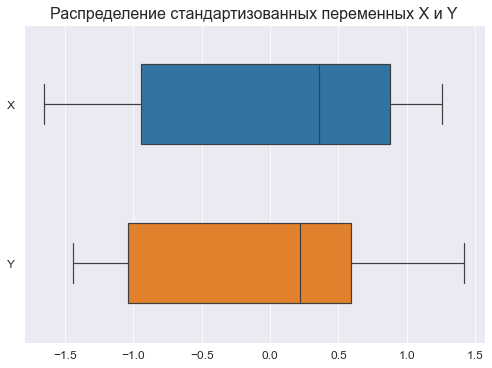

столбцы — признакам таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных

таким образом, каждый признак является как бы статистическим рядом, в котором наблюдения варьируют от объекта к объекту. Признаки, характеризующие объект наблюдения, как правило, имеют различную размерность. Чтобы устранить влияние размерности и обеспечить сопоставимость признаков, матрицу исходных данных обычно нормируют, вводя единый масштаб. Самым распространенным видом нормировки является стандартизация. От переменных  переходят к переменным

переходят к переменным  В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

В дальнейшем, говоря о матрице исходных переменных, всегда будем иметь в виду стандартизованную матрицу.

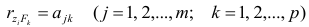

Основная модель факторного анализа. Основная модель факторного анализа имеет вид

где  -j-й признак (величина случайная);

-j-й признак (величина случайная);  — общие факторы (величины случайные, имеющие нормальный закон распределения);

— общие факторы (величины случайные, имеющие нормальный закон распределения);  — характерный фактор;

— характерный фактор;  — факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению);

— факторные нагрузки, характеризующие существенность влияния каждого фактора (параметры модели, подлежащие определению); — нагрузка характерного фактора.

— нагрузка характерного фактора.

Модель предполагает, что каждый из j признаков, входящих в исследуемый набор и заданных в стандартной форме, может быть представлен в виде линейной комбинации небольшого числа общих факторов  и характерного фактора

и характерного фактора

Термин «общий фактор» подчёркивает, что каждый такой фактор имеет существенное значение для анализа всех признаков , т.е.

, т.е.

Термин «характерный фактор» показывает, что он относится только к данному j-му признаку. Это специфика признака, которая не может быть, выражена через факторы

Факторные нагрузки  . характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

. характеризуют величину влияния того или иного общего фактора в вариации данного признака. Основная задача факторного анализа — определение факторных нагрузок. Факторная модель относится к классу аппроксимационных. Параметры модели должны быть выбраны так, чтобы наилучшим образом аппроксимировать корреляции между наблюдаемыми признаками.

Для j-го признака и i-го объекта модель (2.19) можно записать в. виде

где  значение k-го фактора для i-го объекта.

значение k-го фактора для i-го объекта.

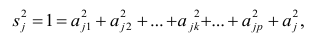

Дисперсию признака  можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность

можно разложить на составляющие: часть, обусловленную действием общих факторов, — общность  и часть, обусловленную действием j-го характера фактора, характерность

и часть, обусловленную действием j-го характера фактора, характерность  Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака

Все переменные представлены в стандартизированном виде, поэтому дисперсий у-го признака  Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Дисперсия признака может быть выражена через факторы и в конечном счёте через факторные нагрузки.

Если общие и характерные факторы не коррелируют между собой, то дисперсию j-го признака можно представить в виде

где  —доля дисперсии признака

—доля дисперсии признака  приходящаяся на k-й фактор.

приходящаяся на k-й фактор.

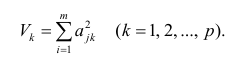

Полный вклад k-го фактора в суммарную дисперсию признаков

Вклад общих факторов в суммарную дисперсию

Факторное отображение

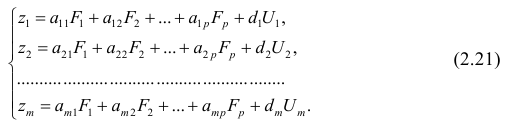

Используя модель (2.19), запишем выражения для каждого из параметров:

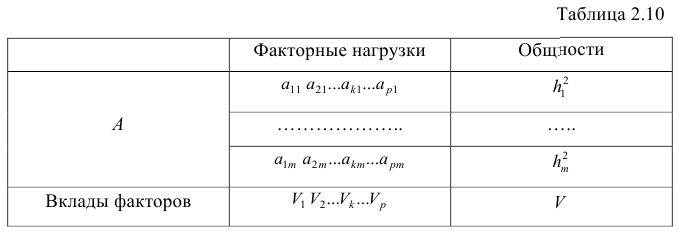

Коэффициенты системы (2,21) — факторные нагрузки — можно представить в виде матрицы, каждая строка которой соответствует параметру, а столбец — фактору.

Факторный анализ позволяет получить не только матрицу отображений, но и коэффициенты корреляции между параметрами и

факторами, что является важной характеристикой качества факторной модели. Таблица таких коэффициентов корреляции называется факторной структурой или просто структурой.

Коэффициенты отображения можно выразить через выборочные парные коэффициенты корреляции. На этом основаны методы вычисления факторного отображения.

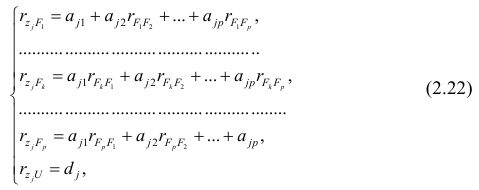

Рассмотрим связь между элементами структуры и коэффициентами отображения. Для этого, учитывая выражение (2.19) и определение выборочного коэффициента корреляции, умножим уравнения системы (2.21) на соответствующие факторы, произведём суммирование по всем n наблюдениям и, разделив на n, получим следующую систему уравнений:

где — выборочный коэффициент корреляции между j-м параметром и к-

— выборочный коэффициент корреляции между j-м параметром и к-

м фактором; — коэффициент корреляции между к-м и р-м факторами.

— коэффициент корреляции между к-м и р-м факторами.

Если предположить, что общие факторы между собой, не коррелированы, то уравнения (2.22) можно записать в виде

, т.е. коэффициенты отображения равны

, т.е. коэффициенты отображения равны

элементам структуры.

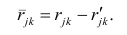

Введём понятие, остаточного коэффициента корреляции и остаточной корреляционной матрицы. Исходной информацией для построения факторной модели (2.19) служит матрица выборочных парных коэффициентов корреляции. Используя построенную факторную модель, можно снова вычислить коэффициенты корреляции между признаками и сравнись их с исходными Коэффициентами корреляции. Разница между ними и есть остаточный коэффициент корреляции.

В случае независимости факторов имеют место совсем простые выражения для вычисляемых коэффициентов корреляции между параметрами: для их вычисления достаточно взять сумму произведений коэффициентов отображения, соответствующих наблюдавшимся признакам:

где  —вычисленный по отображению коэффициент корреляции между j-м

—вычисленный по отображению коэффициент корреляции между j-м

и к-м признаком. Остаточный коэффициент корреляции

Матрица остаточных коэффициентов корреляции называется остаточной матрицей или матрицей остатков

где  — матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

— матрица остатков; R — матрица выборочных парных коэффициентов корреляции, или полная матрица; R’— матрица вычисленных по отображению коэффициентов корреляции.

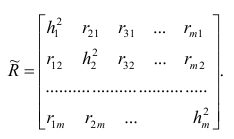

Результаты факторного анализа удобно представить в виде табл. 2.10.

Здесь суммы квадратов нагрузок по строкам — общности параметров, а суммы квадратов нагрузок по столбцам — вклады факторов в суммарную дисперсию параметров. Имеет место соотношение

Определение факторных нагрузок

Матрицу факторных нагрузок можно получить различными способами. В настоящее время наибольшее распространение получил метод главных факторов. Этот метод основан на принципе последовательных приближений и позволяет достичь любой точности. Метод главных факторов предполагает использование ЭВМ. Существуют хорошие алгоритмы и программы, реализующие все вычислительные процедуры.

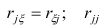

Введём понятие редуцированной корреляционной матрицы или просто редуцированной матрицы. Редуцированной называется матрица выборочных коэффициентов корреляции у которой на главной диагонали стоят значения общностей

у которой на главной диагонали стоят значения общностей  :

:

Редуцированная и полная матрицы связаны соотношением

где D — матрица характерностей.

Общности, как правило, неизвестны, и нахождение их в факторном анализе представляет серьезную проблему. Вначале определяют (хотя бы приближённо) число общих факторов, совокупность, которых может с достаточной точностью аппроксимировать все взаимосвязи выборочной корреляционной матрицы. Доказано, что число общих факторов (общностей) равно рангу редуцированной матрицы, а при известном ранге можно по выборочной корреляционной матрице найти оценки общностей. Числа общих факторов можно определить априори, исходя из физической природы эксперимента. Затем рассчитывают матрицу факторных нагрузок. Такая матрица, рассчитанная методом главных факторов, обладает одним интересным свойством: сумма произведений каждой пары её столбцов равна нулю, т.е. факторы попарно ортогональны.

Сама процедура нахождения факторных нагрузок, т.е. матрицы А, состоит из нескольких шагов и заключается в следующем: на первом шаге ищут коэффициенты факторных нагрузок при первом факторе так, чтобы сумма вкладов данного фактора в суммарную общность была максимальной:

Максимум  должен быть найден при условии

должен быть найден при условии

где  —общность

—общность параметра

параметра

Затем рассчитывают матрицу коэффициентов корреляции с учётом только первого фактора Имея эту матрицу, получают первую матрицу остатков:

Имея эту матрицу, получают первую матрицу остатков:

На втором шаге определяют коэффициенты нагрузок при втором факторе так, чтобы сумма вкладов второго фактора в остаточную общность (т.е. полную общность без учёта той части, которая приходится на долю первого фактора) была максимальной. Сумма квадратов нагрузок при втором факторе

Максимум  находят из условия

находят из условия

где  — коэффициент корреляции из первой матрицы остатков;

— коэффициент корреляции из первой матрицы остатков;  — факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

— факторные нагрузки с учётом второго фактора. Затем рассчитыва коэффициентов корреляций с учётом второго фактора и вычисляют вторую матрицу остатков:

Факторный анализ учитывает суммарную общность. Исходная суммарная общность Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на

Итерационный процесс выделения факторов заканчивают, когда учтённая выделенными факторами суммарная общность отличается от исходной суммарной общности меньше чем на  — наперёд заданное малое число).

— наперёд заданное малое число).

Адекватность факторной модели оценивается по матрице остатков (если величины её коэффициентов малы, то модель считают адекватной).

Такова последовательность шагов для нахождения факторных нагрузок. Для нахождения максимума функции (2.24) при условии (2.25) используют метод множителей Лагранжа, который приводит к системе т уравнений относительно m неизвестных

Метод главных компонент

Разновидностью метода главных факторов является метод главных компонент или компонентный анализ, который реализует модель вида

где m — количество параметров (признаков).

Каждый из наблюдаемых, параметров линейно зависит от m не коррелированных между собой новых компонент (факторов)  По сравнению с моделью факторного анализа (2.19) в модели (2.28) отсутствует характерный фактор, т.е. считается, что вся вариация параметра может быть объяснена только действием общих или главных факторов. В случае компонентного анализа исходной является матрица коэффициентов корреляции, где на главной диагонали стоят единицы. Результатом компонентного анализа, так же как и факторного, является матрица факторных нагрузок. Поиск факторного решения — это ортогональное преобразование матрицы исходных переменных, в результате которого каждый параметр может быть представлен линейной комбинацией найденных m факторов, которые называют главными компонентами. Главные компоненты легко выражаются через наблюдённые параметры.