Микроядра, от которых давно отказались из-за их слишком низкой производительности по сравнению с монолитными ядрами, могут снова вернуться в операционные системы, поскольку потенциально они обеспечивают более высокую надежность, которую сейчас многие разработчики считают важнее производительности.Когда последний раз ваш телевизор внезапно отключался или требовал, чтобы вы срочно загрузили из Web какую-нибудь программную заплатку, исправляющую критическую ошибку?

Микроядра, от которых давно отказались из-за их слишком низкой производительности по сравнению с монолитными ядрами, могут снова вернуться в операционные системы, поскольку потенциально они обеспечивают более высокую надежность, которую сейчас многие разработчики считают важнее производительности.

Когда последний раз ваш телевизор внезапно отключался или требовал, чтобы вы срочно загрузили из Web какую-нибудь программную заплатку, исправляющую критическую ошибку? В конце концов, если у вас не совсем уж древний телевизор, то, по сути, он тот же компьютер — с центральным процессором, большим монитором, какой-то аналоговой электроникой для декодирования радиосигналов, парочкой специальных устройств ввода/вывода (пульт, встроенный дисковод для кассет или DVD-дисков) и с программным обеспечением, прописанным в оперативной памяти. Этот риторический вопрос возвращает нас к одной неприятной проблеме, о которой так не любят говорить в компьютерной индустрии. Почему телевизоры, DVD-проигрыватели, MP3-плейеры, сотовые телефоны и другие электронные устройства с программным обеспечением вполне надежны и хорошо защищены, а компьютеры — нет? Конечно, тому есть немало «объяснений»: компьютеры — это гибкие системы, пользователи могут менять программное обеспечение, отрасль информационных технологий еще недостаточно развита и так далее. Но, поскольку мы живем в эпоху, когда подавляющее большинство компьютерных пользователей мало сведущи в технических вопросах, то подобные «объяснения» им не кажутся убедительными.

Чего потребитель ждет от компьютера? Того же самого, что и от телевизора. Вы его покупаете, подключаете, и он прекрасно работает следующие десять лет. ИТ-специалистам следует принять во внимание эти ожидания и сделать компьютеры такими же надежными и защищенными, как телевизоры.

Самой слабым местом в плане надежности и защиты остается операционная система. Несмотря на то, что прикладные программы содержат немало дефектов, если бы операционная система была безошибочной, то некорректность прикладных программ не имела бы столь серьезных последствий, как сейчас, поэтому мы остановимся в данной статье именно на операционных системах.

Но прежде, чем перейти к деталям, несколько слов о связи между надежностью и защитой. Проблемы, возникающие в каждой из этих сфер, зачастую имеют общие корни: ошибки в программном обеспечении. Ошибка переполнения буфера может вызвать сбой в системе (проблема надежности), но она также позволяет хитроумно написанному вирусу проникнуть на компьютер (проблема защиты). Несмотря на то, что в данной статье мы, прежде всего, будем говорить о надежности, следует иметь в виду, что увеличение надежности может привести к усилению защиты.

Почему системы ненадежны?

Современные операционные системы имеют две особенности, из-за которых они теряют как в надежности, так и в защищенности. Во-первых, эти ОС огромны по размеру, а, во-вторых, в них очень плохо обеспечена изоляция ошибок. Ядро Linux имеет свыше 2,5 млн. строк кода, а ядро Windows XP как минимум в два раза больше.

Одно из исследований, посвященных изучению надежности программного обеспечения, показало, что программы содержат от 6 до 16 ошибок на каждые 1000 строк исполняемого кода. Согласно результатам другого исследования, частота ошибок в программах находится в пределах от 2 до 75 на каждые 1000 строк исполняемого кода [2], в зависимости от размера модуля. Даже если исходить из самой скромной оценки (6 ошибок на 1000 строк кода), ядро Linux, по всей видимости, содержит примерно 15 тыс. ошибок; Windows XP — как минимум в два раза больше.

Хуже того, как правило, около 70% операционной системы составляют драйверы устройств, уровень ошибок в которых в три-семь раз выше, чем в обычном коде [3], поэтому приведенная выше оценка числа ошибок в ОС, скорее всего, сильно занижена. Понятно, что найти и исправить все эти ошибки просто невозможно. Более того, при исправлении одних ошибок зачастую вносятся новые.

Из-за огромного размера современных операционных систем никто в одиночку не может знать их досконально. Действительно, крайне трудно создать хорошую систему, если никто в действительности ее себе полностью не представляет.

Этот факт приводит нас ко второй проблеме: изоляции ошибок. Ни один человек в мире не знает все о том, как функционирует авианосец, но подсистемы авианосца хорошо изолированы друг от друга, и его засорившийся туалет никак не повлияет на работу подсистемы запуска ракет.

Операционные системы не имеют такого рода изоляции между компонентами. Современная операционная система содержит сотни или даже тысячи процедур, объединенных друг с другом в одну бинарную программу, работающую в режиме ядра. Каждая из миллионов строк кода ядра может переписать основные структуры данных, которые используют не связанные с этим кодом компоненты, что приводит к сбою системы, выяснить причины которого крайне сложно. Кроме того, если вирус инфицировал одну процедуру ядра, невозможно предотвратить его стремительное распространение на другие процедуры и заражение всей машины целиком.

Вернемся к аналогии с кораблем. Корпус современного судна разделен на множество отсеков. Если в одном из отсеков возникает течь, то затапливается только он, а не весь трюм. Современные операционные системы подобны кораблям, существовавшим до изобретения переборок: корабль может потопить любая пробоина.

К счастью, ситуация не столь бесперспективна. Разработчики стремятся создать более надежные операционные системы. Существует четыре различных подхода, которые применяются для того, чтобы в будущем сделать ОС более надежными и защищенными. Мы изложим их в нашей статье в «возрастающем» порядке, от менее радикальных к более радикальным.

Укрепленные операционные системы

Самый консервативный подход, Nooks [4], был разработан для того, чтобы увеличить надежность существующих операционных систем, таких как Windows и Linux. Технология Nooks поддерживает монолитную структуру ядра, в которой сотни или тысячи процедур связаны вместе в одном адресном пространстве и работают в режиме ядра. Этот подход сосредоточен на том, чтобы сделать драйверы устройств (основная причина всех проблем) менее опасными.

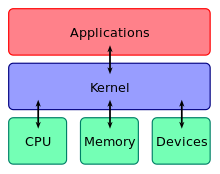

|

Рис. 1. Модель Nooks. Каждый драйвер заключен в оболочку и размещается на уровне защищенного программного обеспечения. Этот уровень ведет мониторинг всех взаимодействий между драйвером и ядром |

В частности, как показывает рис. 1, Nooks защищает ядро от некорректных драйверов устройств за счет того, что каждый драйвер заключается в оболочку и размещается на уровне защищенного программного обеспечения, который формирует домен упрощенной защиты. Такую технологию иногда называют «песочницей». Оболочка вокруг каждого драйвера тщательно отслеживает все взаимодействия между драйвером и ядром. Кроме того, данная технология может использоваться для других расширений ядра, таких как загружаемые операционные системы, но для простоты мы будем говорить о ней только применительно к драйверам.

Цели проекта Nooks заключаются в следующем:

- защитить ядра от ошибок в драйверах;

- обеспечить автоматическое восстановление в случае сбоя в драйвере;

- сделать все это путем минимальных изменений в существующих драйверах и ядре.

Защита ядра от некорректных драйверов — не главная цель. Впервые технология Nooks была реализована на Linux, но эти идеи в равной степени применимы к другим унаследованным ядрам.

Изоляция

Основное средство, позволяющее уберечь структуры данных ядра от уничтожения некорректными драйверами — это карта страниц виртуальной памяти. При работе драйвера все внешние для него страницы переводятся в режим «открыты только для чтения», благодаря чему создается отдельный домен упрощенной защиты для каждого драйвера. Таким образом, драйвер может читать структуры данных ядра, которые ему необходимы, но любая попытка напрямую изменить структуры данных ядра вызовет исключение центрального процессора, которое перехватывает менеджер изоляции Nooks. Доступ к частной памяти драйвера, где хранятся стеки, куча, структуры частных данных и копии объектов ядра, разрешен на чтение и на запись.

Посредничество

Каждый класс драйверов экспортирует набор функций, которые может вызвать ядро. Например, аудиодрайверы могут предоставить вызов для записи блока образцов звучания на звуковую карту, другой — для регулирования громкости и так далее. Когда драйвер загружен, заполняется массив указателей на функции драйвера, благодаря чему ядро может найти любую из них. Кроме того, драйвер импортирует набор функций, предоставляемых ядром, например, для резервирования буфера данных.

Nooks предоставляет оболочки как для экспортируемых, так и для импортируемых функций. Теперь, когда ядро вызывает функцию драйвера или драйвер вызывает функцию ядра, вызов на самом деле направляется оболочке, которая проверяет корректность параметров и управляет вызовом. Несмотря на то, что суррогаты (stubs) оболочки (на рис. 1 они изображаются как линии, указывающие как внутрь, так и наружу драйвера) генерируются автоматически на основе прототипов функций, тело оболочки разработчикам приходится писать вручную. В целом группа Nooks написала 455 оболочек: 329 для функций, которые ядро экспортирует, и 126 — для функций, которые экспортируют драйверы устройств.

Когда драйвер пытается модифицировать объект ядра, его оболочка копирует объект в домен защиты драйвера, то есть в его частные страницы, открытые для чтения и записи. Затем драйвер меняет копию. Если запрос был выполнен успешно, менеджер изоляции копирует модифицированные объекты обратно в ядро. Таким образом, сбой в работе драйвера или ошибка во время вызова всегда оставляют объекты ядра в корректном состоянии. Операции контроля за импортируемыми объектами специфические для каждого объекта, в силу чего группе Nooks пришлось вручную писать код для контроля 43 классов объектов, которые используют драйверы Linux.

Восстановление

В случае сбоя в режиме пользователя запускается агент восстановления, который обращается к базе данных конфигурации для того, чтобы выяснить, что нужно делать. Во многих случаях освобождения всех занятых ресурсов и перезапуска драйвера оказывается достаточно, поскольку самые распространенные алгоритмические ошибки, как правило, находят при тестировании, и в коде в основном остаются ошибки синхронизации и специфические дефекты.

Эта технология позволяет восстановить систему, но работавшие в момент сбоя приложения могут оказаться в некорректном состоянии. В результате работы [5] группа Nooks добавила концепцию дублирующих драйверов (shadow driver) для того, чтобы приложения могли выполняться корректно даже после сбоя драйвера.

Одним словом, во время нормальной работы дублирующий драйвер регистрирует взаимодействия между каждым драйвером и ядром, если это взаимодействие может потребоваться для восстановления. После перезапуска драйвера дублирующий драйвер передает перезапущенному драйверу все данные из журнала регистрации, например, повторяя вызов системы управления вводом/выводом (IOCTL) для того, чтобы установить параметры, такие как громкость звука. Ядру ничего не известно о процессе возвращения драйвера в то состояние, в котором находился старый драйвер. Как только этот процесс завершается, драйвер начинает обрабатывать новые запросы.

Ограничения

Несмотря на то, что, согласно экспериментам, Nooks может обнаруживать 99% фатальных ошибок драйвера и 55% не фатальных, он далеко не совершенен. Например, драйверы могут выполнять привилегированные команды, которые они выполнять не должны; они могут записывать данные в некорректные порты ввода/вывода и выполнять бесконечные циклы. Более того, группе Nooks большое количество оболочек пришлось написать вручную, и эти оболочки могут содержать ошибки. Наконец, при данном подходе невозможно запретить драйверам записывать данные в любое место памяти. Тем не менее это потенциально весьма полезный шаг к повышению надежности унаследованных ядер.

Паравиртуальные машины

Второй подход создан на основе концепции виртуальной машины. Эта концепция была разработана в конце 60-х годов. Идея заключается в том, чтобы использовать специальную управляющую программу, называемую монитором виртуальной машины, которая работает непосредственно с аппаратным обеспечением, а не с операционной системой. Виртуальная машина создает несколько экземпляров реальной машины. Каждый экземпляр может поддерживать работу любой программы, которая способна выполняться на данном аппаратном обеспечении.

Этот метод часто применяется для того, чтобы две или несколько операционных систем, скажем, Linux и Windows, могли работать на одной и той же машине одновременно, причем так, что каждая из ОС считает, что в ее распоряжении находится вся машина. Использование виртуальных машин имеет заслуженную репутацию средства, обеспечивающего хорошую изоляцию ошибок. В конце концов, если ни одна из виртуальных машин не подозревает о существовании других, проблемы, возникающие на одной машине, никак не могут распространиться на другие.

Была предпринята попытка адаптировать данную концепцию для организации защиты в одной операционной системе, а не между различными ОС [7]. Более того, поскольку Pentium не полностью поддерживает виртуализацию, пришлось отступить от принципа запускать в виртуальной машине операционную систему без каких-либо ее изменений. Эта уступка позволяет вносить изменения в операционную систему для того, чтобы гарантировать, что она не может делать ничего, что невозможно виртуализировать. Для того чтобы данную технологию отличать от истинной виртуализации, ее называют паравиртуализацией.

В частности, в 90-х годах группа разработчиков из университета Карлсруэ создала микроядро L4 [8]. Они смогли запустить слегка модифицированную версию Linux (L4Linux) на L4 в режиме, который можно называть видом виртуальной машины [9]. Позже разработчики выяснили, что вместо того чтобы запускать только одну копию Linux на L4, они могут запускать несколько копий. Как показано на рис. 2, эта мысль привела к идее использования одной из виртуальных машин Linux для работы прикладных программ, а другой или нескольких — для работы драйверов устройств.

Если драйверы устройств работают в одной или в нескольких виртуальных машинах, изолированных от основной виртуальной машины, где работает остальная операционная система и прикладные программы, то в случае сбоя в драйвере выходит из строя только его виртуальная машина, а не основная. Дополнительное преимущество такого подхода заключается в том, что драйверы устройств не нужно модифицировать, поскольку они видят обычную среду ядра Linux. Конечно, само ядро Linux придется менять для того, чтобы оно поддерживало паравиртуализацию, но это однократное изменение. Кроме того, нет необходимости повторять эту процедуру для каждого драйвера устройства.

Поскольку драйверы устройств работают на аппаратном обеспечении в режиме пользователя, основной вопрос заключается в том, как они будут выполнять ввод/вывод и обрабатывать прерывания. Физический ввод/вывод поддерживается за счет добавления примерно 3 тыс. строк кода к ядру Linux, на котором работают драйверы, благодаря чему драйверы могли использовать сервисы L4 для ввода/вывода вместо того, чтобы делать это самостоятельно. Дополнительные 5 тыс. строк кода поддерживают взаимодействия между тремя изолированными драйверами (диска, сети и шины PCI) и виртуальной машиной, в которой выполняются прикладные программы.

В принципе, этот подход должен обеспечить более высокую надежность, чем единая операционная система, поскольку в том случае, если в виртуальной машине, содержащей один или несколько драйверов, возникает сбой, то виртуальную машину можно перезапустить — и драйверы вернутся в свое исходное состояние. В отличие от Nooks при данном подходе не предпринимается никаких попыток вернуть драйверы в предыдущее состояние (то состояние, в котором они находились до того, как возник сбой). Таким образом, если аудиодрайвер выйдет из строя, он будет восстановлен со значением уровня звука по умолчанию, а не с тем, что было до того, как возник сбой.

Параметры производительности показывают, что накладные расходы при использовании паравиртуализованных машин составляют около 3-8%.

Мультисерверные операционные системы

Первые два подхода предусматривают модификацию унаследованных систем. Следующие два посвящены будущим системам.

Один из этих подходов напрямую касается сути проблемы: работы всей операционной системы как единой гигантской бинарной программы в режиме ядра. Вместо этого в данном случае предлагается иметь несколько небольших микроядер, работающих в режиме ядра, в то время как остальная часть операционной системы представляет собой набор полностью изолированных сервера и процессов драйвера, работающих в режиме пользователя. Эта идея была предложена 20 лет назад, но тогда она так и не была полностью воплощена из-за более низкой производительности мультисерверной ОС по сравнению с монолитным ядром. В 80-х годах производительность считалась самым важным показателем, а о надежности и защите даже не задумывались. Конечно, в свое время инженеры самолетов не задумывались о расходе топлива или о создании дверей кабины, способной выдерживать вооруженное нападение. Времена меняются, и представление людей о том, что действительно важно, меняются тоже.

Мультисерверная архитектура

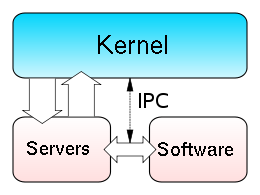

Для того чтобы лучше понять, в чем состоит идея мультисерверной операционной системы, обратимся к современному примеру. Как показано на рис. 3, в Minix 3, микроядро обрабатывает прерывания, предоставляет базовые механизмы для управления процессами, реализует взаимодействия между процессами и выполняет планирование процессов. Оно также предоставляет небольшой набор вызовов ядра для авторизованных драйверов и серверов, такие как чтение избранной части адресного пространства конкретного пользователя или запись в авторизованные порты ввода/вывода. Драйвер часов использует то же адресное пространство, что и микроядро, но он планируется как отдельный процесс. Ни один другой драйвер в режиме ядра не работает.

Над микроядром находится уровень драйверов устройств [10]. Каждое устройство ввода/вывода имеет свой собственный драйвер, который функционирует как отдельный процесс в своем собственном частном адресном пространстве, защищенном с помощью аппаратного модуля управления памятью (MMU). Этот уровень включает в себя процессы драйверов для диска, терминала (клавиатуры и дисплея), Ethernet, принтера, аудио и так далее. Эти драйверы работают в режиме пользователя и не могут выполнять привилегированные команды или операции чтения и записи на портах ввода/вывода компьютера. Для того чтобы получить эти сервисы, драйверы должны обратиться к ядру. Хотя такая архитектура увеличивает накладные расходы, она значительно повышает надежность.

Над уровнем драйверов устройств находится уровень сервера. Сервер файлов представляет собой программу (4,5 тыс. строк исполняемого кода), которая принимает запросы от пользовательских процессов на системные вызовы Posix, касающиеся файлов, таких как, read, write, lseek и stat, и выполняет их. Кроме того, на этом уровне расположен менеджер процессов, который управляет процессами и памятью и выполняет вызовы Posix и другие системные вызовы, такие как fork, exec и brk.

Несколько необычной особенностью является сервер реинкарнации, который играет роль родительского процесса для всех остальных серверов и всех драйверов. Если в драйвере или в сервере возникает сбой, они завершают свою работу или не отвечают на периодически посылаемые команды ping, сервер реинкарнации удаляет эти процессы, если необходимо, а затем перезапускает их с копии на диске или из оперативной памяти. Таким образом можно перезапустить драйверы, но сейчас из серверов можно перезапустить только те, внутреннее состояние которых ограничено.

К числу других серверов относятся сетевой сервер, который содержит: полный стек TCP/IP; хранилище данных, простой сервер имен, который используют другие серверы; информационный сервер, который используется при отладке. Наконец, над серверным уровнем расположены пользовательские процессы. Единственное отличие между этой и другими системами Unix заключается в том, что библиотечные процедуры для чтения, записи и других системных вызовов выполняется посредством посылки сообщений серверам. За исключением данного отличия (скрытого в системных библиотеках) это обычные пользовательские процессы, которые могут использовать POSIX API.

Взаимодействия между процессами

Поскольку именно механизм взаимодействия между процессами (Interprocess Communication, IPC) позволяет всем процессам работать вместе, он критически важен в мультисерверной операционной системе. Однако так как все серверы и драйверы в Minix 3 выполняются как физически изолированные процессы, они не могут напрямую вызывать функции друг друга или совместно использовать структуры данных. Вместо этого Minix 3 поддерживает IPC за счет передачи сообщений фиксированной длины на так называемом принципе рандеву (когда и отправитель, и получатель готовы к обмену, система копирует сообщение непосредственно от отправителя к получателю). Кроме того, имеется механизм асинхронных уведомлений о событиях. События, которые не могут быть реализованы, в таблице процессов помечаются как отложенные.

Minix 3 элегантно объединяет прерывания с системой передачи сообщений. Обработчики прерываний используют механизм уведомлений для сигнализации о завершении ввода/вывода. Этот механизм позволяет обработчику устанавливать бит в битовой карте «отложенных прерываний», а затем продолжать работу без блокировки. Когда драйвер готов к получению прерывания, ядро преобразует его в обычное сообщение.

Характеристики надежности

Причин высокой надежности Minix 3 несколько. Во-первых, в ядре выполняется код размером не более 4 тыс. строк, поэтому, исходя из скромной оценки 6 ошибок на 1000 строк, общее число ошибок в ядре, скорее всего, около 24. Сравните это число с 15 тыс. ошибок в Linux и намного большим их количеством в Windows. Поскольку все драйверы устройств, за исключением часов, — это пользовательские процессы, никакой посторонний код никогда не будет работать в режиме ядра. Кроме того, небольшой размер ядра позволяет более эффективно проверить его корректность либо вручную, либо с помощью формальных методов.

Архитектура IPC в Minix 3 не требует поддержки очередей или буферизации сообщений, что избавляет от необходимости управления буфером в ядре. Более того, поскольку IPC — это мощная конструкция, IPC-возможности каждого сервера и драйвера строго ограничены. Для каждого процесса строго определены используемые примитивы IPC, доступные адресаты и уведомления о пользовательских событиях. Пользовательские процессы, например, могут взаимодействовать только по принципу рандеву или посылать сообщения только серверам Posix.

Кроме того, все структуры данных ядра являются статичными. Все эти особенности значительно упрощают код и избавляют от ошибок ядра, связанных с переполнением буфера, утечкой памяти, несвоевременными прерываниями, ненадежным кодом ядра и так далее. Конечно, перевод большей части операционной системы в режим пользователя не избавляет от неизбежных ошибок в драйверах и серверах, но делает их значительно менее опасными. Из-за ошибки ядро может уничтожить критически важные структуры ядра, записать мусор на диск и так далее. Ошибка в большинстве драйверов и серверов не может нанести значительного ущерба, поскольку эти процессы четко разделены и операции, которые они могут выполнять, строго ограничены.

Драйверы и серверы в режиме пользователя не могут работать с привилегиями суперпользователя. Они не могут получать доступ к областям памяти, находящимся за пределами их собственных адресных пространств, за исключением вызовов ядра (проверку корректности которых выполняет ядро). Более того, битовые карты и диапазоны внутри таблицы процессов ядра управляют набором допустимых вызовов ядра, возможностей IPC и допустимых портов ввода/вывода для каждого процесса в отдельности. Например, ядро может не допустить, чтобы драйвер принтера записывал информацию в пользовательские адресные пространства, обращался к портам ввода/вывода диска или посылал сообщения аудиодрайверу. В традиционных монолитных системах любой драйвер может делать что угодно.

Еще одна причина надежности — использование отдельных пространств команд и данных. Если следствием ошибки или действия вируса станет ошибка переполнения буфера драйвера или сервера и запись постороннего кода в пространство данных, инфицированный код нельзя будет выполнить за счет передачи ему управления или с помощью процедуры, указывающей на него, поскольку ядро не будет выполнять код, если он не находится в пространстве команд процесса, открытом только на чтение.

К числу других специфических особенностей, обеспечивающих более высокую надежность, самым важным является свойство самовосстановления. Если драйвер пытается сохранить данные по некорректному указателю, входит в бесконечный цикл или пытается выполнить другие некорректные операции, сервер реинкарнации автоматически заменит этот драйвер, причем, как правило, в этом случае не будут затронуты другие выполняемые процессы.

Несмотря на то, что перезапуск логически некорректного драйвера не устранит ошибку, на практике некорректная синхронизация и аналогичные ошибки вызывают множество проблем, и перезапуск драйвера часто дает возможность привести систему в корректное состояние.

Параметры производительности

В течение десятилетий разработчики критиковали мультисерверные архитектуры, базирующиеся на принципе микроядер, за их более низкую по сравнению с монолитными архитектурами производительность. Однако различные проекты подтверждают, что модульная архитектура на самом деле может обеспечивать сравнимую производительность. Несмотря на тот факт, что Minix 3 не была оптимизирована по производительности, система работает достаточно быстро. Потери производительности, которые возникают из-за того, что драйверы работают в режиме пользователя, по сравнению с драйверами в режиме ядра составляют менее 10%, и система может создаваться, в том числе ядро, общие драйверы и все серверы (112 компиляций и 11 ссылок), менее чем за 6 с на машине с процессором Athlon/2,2 ГГц.

Тот факт, что мультисерверные архитектуры позволяют поддерживать достаточно надежную Unix-подобную среду при весьма небольших потерях производительности, делает такой подход практически приемлемым. Minix 3 для Pentium можно загрузить бесплатно на условиях лицензии Berkeley с сайта www.minix3.org. Сейчас разрабатываются версии для других архитектур и встроенных систем.

Защита на базе языка

Самый радикальный подход, что весьма неожиданно, предложили в Microsoft Research, отказавшись от операционной системы как единой программы, выполняющейся в режиме ядра, и некоторого набора пользовательских процессов, функционирующих в режиме пользователя. Вместо этого предлагается система, написанная на совершенно новых, обеспечивающих безопасность типов языках, которые избавлены от всех проблем с указателями и других ошибок, связанных с Си и C++. Как и предыдущие два подхода, этот подход был предложен несколько десятилетий назад и был реализован в компьютере Burroughs B5000. Тогда существовал только язык Алгол, и защита поддерживалась не с помощью MMU (которого вообще не было в машине), а благодаря тому, что компилятор Алгол просто не генерировал «опасный» код. Подход, предложенный Microsoft Research, адаптирует эту идею к условиям XXI века.

Общее описание

Эта система, получившая название Singularity, практически полностью написана на Sing#, новом языке, гарантирующим безопасность типов. Этот язык основан на C#, но дополнен примитивами передачи сообщений, семантика которых определяется формальными, описанными средствами языка контрактами. Поскольку язык жестко ограничивает системные и пользовательские процессы, все процессы могут работать вместе в едином виртуальном адресном пространстве. Это увеличивает как безопасность (поскольку компилятор не позволит одному процессу менять данные другого процесса), так и эффективность (поскольку это избавляет от перехватов вызовов ядра (kernel trap) и переключений контекста.

Более того, архитектура Singularity является гибкой, поскольку каждый процесс — это замкнутая сущность и поэтому она может иметь свой собственный код, структуры данных, структуру памяти, систему времени исполнения, библиотеки и сборщик мусора. MMU поддерживается, но он только распределяет страницы, а не устанавливает отдельный защищенный домен для каждого процесса.

Основной принцип архитектуры Singularity состоит в том, чтобы запретить динамические расширения процессов. Кроме того, эта архитектура не поддерживает загружаемые модули, такие как драйверы устройств и подключаемые элементы браузера, поскольку они могли бы внести посторонний и непроверенный код, который может повредить родительскому процессу. Вместо этого такие расширения должны работать как отдельные процессы, полностью изолированные и взаимодействующие с помощью стандартного механизма IPC.

Микроядро

Операционная система Singularity состоит из процесса микроядра и набора пользовательских процессов, которые обычно работают в общем виртуальном адресном пространстве. Микроядро контролирует доступ к аппаратному обеспечению, резервирует и освобождает память, создает, закрывает и планирует цепочки, поддерживает синхронизацию цепочек с помощью семафоров, поддерживает синхронизацию между процессами с помощью каналов, контролирует ввод/вывод. Каждый драйвер устройств работает как отдельный процесс.

Хотя большая часть микроядра написана на Sing#, отдельные компоненты созданы на C#, C++ или assembler и должны быть надежными, поскольку проверить их корректность невозможно. К надежному коду относятся уровень аппаратной абстракции и сборщик мусора. Уровень аппаратной абстракции скрывает низкоуровневое аппаратное обеспечение от системы, инкапсулируя такие концепции, как порты ввода/вывода, линии запросов на прерывания, каналы прямого доступа к памяти и таймеры для того, чтобы предоставить остальной части операционной системы интероперабельные абстракции.

Взаимодействие между процессами

Пользовательские процессы получают системные сервисы, посылая строго типизированные сообщения микроядру по двунаправленным каналам точка-точка. Фактически эти каналы используются для всех взаимодействий между процессами. В отличие от других систем передачи сообщений, имеющих библиотеку с функциями send и receive, Sing# полностью поддерживает каналы на уровне языка, в том числе формальные спецификации типизации и протоколов. Для того чтобы прояснить это, рассмотрим спецификацию канала.

contract C1 {

in message Request(int x) requires x > 0;

out message Reply(int y);

out message Error();

state Start:

Request? -> Pending;

state Pending: one {

Reply! -> Start;

Error! -> Stopped;

}

state Stopped: ;

}

Этот контракт утверждает, что канал принимает три сообщения: Request, Reply и Error. Первый имеет в качестве параметра положительное целое, второй — целое, а третий параметров не имеет. Когда для доступа к серверу используется канал, сообщения Request передаются от клиента к серверу, а другие два сообщения пересылаются иным путем. Машина состояний описывает протокол для канала.

В состоянии Start клиент посылает сообщение Request, переводя канал в состояние Pending. Сервер может в ответ послать либо сообщение Reply, либо сообщение Error. Сообщение Reply переводит канал обратно в состояние Start, в котором взаимодействие может продолжаться. Сообщение Error переводит канал в состояние Stopped, завершая взаимодействие по каналу.

Куча

Если все данные, такие как блоки файлов, считываемые с диска, должны передаваться по каналам, система будет работать очень медленно, поэтому делается исключение из основного правила о том, что данные каждого процесса полностью частные и внутренние для этого процесса. Singularity поддерживает разделяемую кучу объектов, но каждый экземпляр каждого объекта в куче принадлежит одному процессу. Однако владение объектом можно передавать по каналу.

В качестве примера работы кучи рассмотрим ввод/вывод. Когда драйвер диска считывает блок данных, он помещает этот блок в кучу. Затем система передает дескриптор этого блока пользователю, запросившему данные, придерживаясь принципа «единственного владельца», но позволяя передавать данные с диска пользователю без создания дополнительных копий.

Файловая система

Singularity поддерживает единое иерархическое пространство имен для всех сервисов. Корневой сервер имен использует вершину дерева, но другие серверы имен могут монтироваться на своих собственных узлах. В частности, файловая система, которая представляет собой всего лишь процесс, монтируется на /fs, поэтому, например, имя /fs/users/linda/foo может быть файлом пользователя. Файлы реализуются как B-деревья, в которых номера блоков служат ключами. Когда пользовательский процесс запрашивает файл, файловая система отдает драйверу диска команду поместить запрашиваемые блоки в кучу. Владение затем передается так, как описано выше.

Проверка

Каждый компонент системы имеет метаданные, описывающие его зависимости, экспорты, ресурсы и поведение. Эти метаданные используются для проверки. Образ системы состоит из микроядра, драйверов и приложений, необходимых для работы системы, а также их метаданных. Внешние модули проверки (верификаторы) могут выполнять множество проверок в образе системы прежде, чем система будет его использовать, в частности для того, чтобы убедиться, что драйверы не конфликтуют по ресурсам. Проверка состоит из трех этапов:

- компилятор проверяет безопасность типов, владение объектами, протоколы каналов и так далее;

- компилятор генерирует Microsoft Intermediate Language, переносимый JVM-подобный байт-код, который может проверять верификатор;

- MSIL компилируется в код x86 для базового компьютера, который может добавлять в код проверки времени исполнения (однако существующий компилятор этого не делает).

Добиться более высокой надежности можно с помощью средств, позволяющих обнаружить ошибки в самих верификаторах.

Каждая из четырех разных попыток повысить надежность операционной системы ставит своей целью не допустить, чтобы некорректные драйверы устройств вызывали сбой в системе.

В подходе Nooks каждый драйвер по отдельности заключен в программную оболочку для того, чтобы тщательно контролировать его взаимодействия с остальной операционной системой, но при таком подходе все драйверы находятся в ядре. В реализации подхода паравиртуальной машины эта идея получила дальнейшее развитие. В данном случае драйверы перенесены в одну или несколько машин, отделенных от главной машины, что еще больше ограничивает возможности драйверов. Оба эти подхода призваны увеличить надежность существующих (унаследованных) операционных систем.

Два других подхода заменяют унаследованные операционные системы на более надежные и защищенные. Мультисерверный подход предусматривает работу каждого драйвера и компонента операционной системы в отдельном пользовательском процессе и позволяет им взаимодействовать с помощью механизма IPC микроядра. Наконец, Singularity, самый радикальный подход, использует язык, обеспечивающий безопасность типов, единое адресное пространство и формальные контракты, которые строго ограничивают возможности каждого модуля.

Три из четырех исследовательских проектов — паравиртуализация на базе L4, Minix 3 и Singularity — используют микроядра. Пока не известно, какой из этих подходов в перспективе получит широкое распространение (если это не будет какое-то иное решение). Тем не менее интересно отметить, что микроядра, долгое время считавшиеся неприемлемыми из-за их более низкой производительности по сравнению с монолитными ядрами, могут снова вернуться в операционные системы из-за их потенциально более высокой надежности, что многие считают важнее производительности. Колесо истории повернулось.

Эндрю Таненбаум (ast@cs.vu.nl) — профессор информатики Vrije Universiteit (Амстердам, Голландия). Джоррит Хердер (jnherder@cs.vu.nl) — аспирант отделения компьютерных систем факультета информатики Vrije Universiteit. Хербер Бос (bos@cs.vu.nl)- доцент отделения компьютерных систем факультета информатики Vrije Universiteit.

Литература

- V. Basili, B. Perricone, Software Errors and Complexity: An Empirical Investigation, Comm. ACM, Jan. 1984.

- T. Ostrand, E. Weyuker, The Distribution of Faults in a Large Industrial Software System, Proc. Int?l Symp. Software Testing and Analysis, ACM Press, 2002.

- A. Chou et al., An Empirical Study of Operating System Errors, Proc. 18th ACM Symp. Operating System Principles, ACM Press, 2001.

- M. Swift, B. Bershad, H. Levy, Improving the Reliability of Commodity Operating Systems, ACM Trans. Computer Systems, vol. 23, 2005.

- M. Swift et al., Recovering Device Drivers, Proc. 6th Symp. Operating System Design and Implementation, ACM Press, 2003.

- R. Goldberg, Architecture of Virtual Machines, Proc. Workshop Virtual Computer Systems, ACM Press, 1973.

- J. LeVasseur et al., Unmodified Device Driver Reuse and Improved System Dependability via Virtual Machines, Proc. 6th Symp. Operating System Design and Implementation, 2004.

- J. Liedtke, On Microkernel Construction, Proc. 15th ACM Symp. Operating System Principles, ACM Press, 1995.

- H. Hartig et al., The Performance of Microkernel-Based Systems, Proc. 16th ACM Symp. Operating System Principles, ACM Press, 1997.

- J.N. Herder et al., Modular System Programming in MINIX 3, Usenix; www.usenix.org/publications/login/2006-04/openpdfs/herder.pdf.

Andrew Tanenbaum, Jorrit Herder, Herbert Bos, Can We Make Operating Systems Reliable and Secure?, IEEE Computer, May, 2006. IEEE Computer Society, 2006, All rights reserved. Reprinted with permission.

- 2019

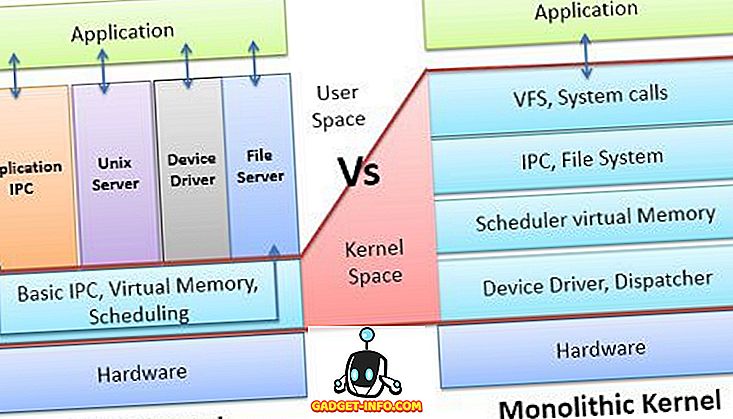

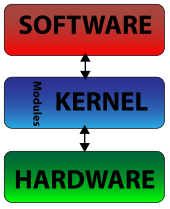

Ядро является основной частью операционной системы; он управляет системными ресурсами. Ядро — это мост между приложением и оборудованием компьютера. Ядро можно разделить на две категории: микроядро и монолитное ядро. Микроядро — это то, в котором пользовательские службы и службы ядра хранятся в отдельном адресном пространстве. Однако в монолитном ядре пользовательские службы и службы ядра находятся в одном и том же адресном пространстве. Давайте обсудим некоторые различия между микроядром и монолитным ядром с помощью сравнительной таблицы, показанной ниже.

Сравнительная таблица

| Основа для сравнения | Microkernel | Монолитное ядро |

|---|---|---|

| основной | В пользовательских службах и ядре микроядра службы хранятся в отдельном адресном пространстве. | В монолитном ядре и пользовательские службы, и службы ядра хранятся в одном и том же адресном пространстве. |

| Размер | Микроядро меньше по размеру. | Монолитное ядро крупнее микроядра. |

| выполнение | Медленное исполнение. | Быстрое исполнение. |

| растяжимый | Микроядро легко расширяется. | Монолитное ядро сложно расширить. |

| Безопасность | В случае сбоя службы это влияет на работу микроядра. | В случае сбоя службы вся система падает в монолитном ядре. |

| Код | Чтобы написать микроядро, требуется больше кода. | Чтобы написать монолитное ядро, требуется меньше кода. |

| пример | QNX, Symbian, L4Linux, Singularity, K42, Mac OS X, Integrity, PikeOS, HURD, Minix и Coyotos. | Linux, BSD (FreeBSD, OpenBSD, NetBSD), Microsoft Windows (95, 98, Me), Solaris, OS-9, AIX, HP-UX, DOS, OpenVMS, XTS-400 и т. Д. |

Определение микроядра

Микроядро как ядро управляет всеми системными ресурсами. Но в микроядре пользовательские сервисы и сервисы ядра реализованы в разных адресных пространствах. Пользовательские сервисы хранятся в пользовательском адресном пространстве, а сервисы ядра — в адресном пространстве ядра . Это уменьшает размер ядра и еще больше уменьшает размер операционной системы.

Помимо взаимодействия между приложением и оборудованием системы, микроядро предоставляет минимальные услуги управления процессами и памятью. Связь между клиентской программой / приложением и службами, работающими в адресном пространстве пользователя, устанавливается посредством передачи сообщений. Они никогда не взаимодействуют напрямую. Это снижает скорость выполнения микроядра.

В микроядре пользовательские сервисы изолированы от сервисов ядра, поэтому, если какой-либо пользовательский сервис выходит из строя, это не влияет на сервис ядра и, следовательно, операционная система остается неизменной . Это одно из преимуществ в микроядре. Микроядро легко расширяется . Если новые службы должны быть добавлены, они добавляются в адресное пространство пользователя и, следовательно, пространство ядра не требует каких-либо изменений. Микроядро также легко переносимо, безопасно и надежно.

Определение монолитного ядра

Монолитное ядро управляет системными ресурсами между приложением и оборудованием системы. Но в отличие от микроядра, пользовательские сервисы и сервисы ядра реализованы в одном и том же адресном пространстве. Это увеличивает размер ядра, еще больше увеличивает размер операционной системы.

Монолитное ядро обеспечивает планирование ЦП, управление памятью, управление файлами и другие функции операционной системы через системные вызовы. Поскольку пользовательские службы и службы ядра находятся в одном и том же адресном пространстве, это приводит к быстродействующей операционной системе.

Один из недостатков монолитного ядра заключается в том, что в случае сбоя одного из сервисов происходит сбой всей системы. Если новый сервис должен быть добавлен в монолитное ядро, вся операционная система должна быть изменена.

Ключевые различия между микроядром и монолитным ядром

- Основным моментом, по которому различается микроядро и монолитное ядро, является то, что микроядро реализует пользовательские службы и службы ядра в разных адресных пространствах, а монолитное ядро реализует как пользовательские службы, так и службы ядра в одном и том же адресном пространстве .

- Размер микроядра невелик, поскольку в адресном пространстве ядра находятся только службы ядра. Однако размер монолитного ядра сравнительно больше, чем у микроядра, поскольку и сервисы ядра, и пользовательские сервисы находятся в одном и том же адресном пространстве.

- Выполнение монолитного ядра происходит быстрее, поскольку связь между приложением и оборудованием устанавливается с помощью системного вызова . С другой стороны, выполнение микроядра происходит медленно, поскольку связь между приложением и оборудованием системы устанавливается посредством передачи сообщений .

- Микроядро легко расширить, поскольку новый сервис должен быть добавлен в адресное пространство пользователя, изолированное от пространства ядра, поэтому ядро не требует модификации. Противоположным является случай с монолитным ядром, если новый сервис должен быть добавлен в монолитное ядро, то необходимо изменить все ядро.

- Микроядро является более безопасным, чем монолитное ядро, так как в случае сбоя службы в микроядре операционная система остается неизменной. С другой стороны, в случае сбоя службы в монолитном ядре происходит сбой всей системы.

- Монолитное проектирование ядра требует меньше кода, что приводит к меньшему количеству ошибок. С другой стороны, для проектирования микроядра требуется больше кода, что приводит к большему количеству ошибок.

Заключение:

Микроядро медленнее, но более безопасно и надежно, чем монолитное ядро. Монолитное ядро быстрое, но менее безопасное, так как любой сбой службы может привести к сбою системы.

Выбор

количества слоев ядра является

ответственным и сложным делом: увеличение

числа слоев ведет к некоторому замедлению

работы ядра за счет дополнительных

накладных расходов на межслойное

взаимодействие, а уменьшение числа

слоев ухудшает расширяемость и логичность

системы. Обычно операционные системы,

прошедшие долгий путь эволюционного

развития, например многие версии UNIX,

имеют неупорядоченное ядро с небольшим

числом четко выделенных слоев, а у

сравнительно «молодых» операционных

систем, таких как Windows NT, ядро разделено

на большее число слоев и их взаимодействие

формализовано в гораздо большей степени.

Аппаратная

зависимость и переносимость ОС

Многие

операционные системы успешно работают

на различных аппаратных платформах без

существенных изменений в своем составе.

Во многом это объясняется тем, что,

несмотря на различия в деталях, средства

аппаратной поддержки ОС большинства

компьютеров приобрели сегодня много

типовых черт, а именно эти средства в

первую очередь влияют на работу

компонентов операционной системы. В

результате в ОС можно выделить достаточно

компактный слой машинно-зависимых

компонентов ядра и сделать остальные

слои ОС общими для разных аппаратных

платформ.

Типовые

средства аппаратной поддержки ОС

Четкой

границы между программной и аппаратной

реализацией функций ОС не существует

— решение о том, какие функции ОС будут

выполняться программно, а какие аппаратно,

принимается разработчиками аппаратного

и программного обеспечения компьютера.

Тем не менее практически все современные

аппаратные платформы имеют некоторый

типичный набор средств аппаратной

поддержки ОС, в который входят следующие

компоненты:

-

средства

поддержки привилегированного режима; -

средства

трансляции адресов; -

средства

переключения процессов; -

система

прерываний; -

системный

таймер; -

средства

защиты областей памяти.

Средства

поддержки привилегированного режима

обычно основаны на системном регистре

процессора, часто называемом «словом

состояния» машины или процессора. Этот

регистр содержит некоторые признаки,

определяющие режимы работы процессора,

в том числе и признак текущего режима

привилегий. Смена режима привилегий

выполняется за счет изменения слова

состояния машины в результате прерывания

или выполнения привилегированной

команды. Число градаций привилегированности

может быть разным у разных типов

процессоров, наиболее часто используются

два уровня (ядро-пользователь) или четыре

(например, ядро- супервизор- выполнение-

пользователь у платформы VAX или 0-1-2-3 у

процессоров Intel x86/Pentium). В обязанности

средств поддержки привилегированного

режима входит выполнение проверки

допустимости выполнения активной

программой инструкций процессора при

текущем уровне привилегированности.

Средства

трансляции адресов выполняют операции

преобразования виртуальных адресов,

которые содержатся в кодах процесса, в

адреса физической памяти. Таблицы,

предназначенные при трансляции адресов,

обычно имеют большой объем, поэтому для

их хранения используются области

оперативной памяти, а аппаратура

процессора содержит только указатели

на эти области. Средства трансляции

адресов используют данные указатели

для доступа к элементам таблиц и

аппаратного выполнения алгоритма

преобразования адреса, что значительно

ускоряет процедуру трансляции по

сравнению с ее чисто программной

реализацией.

Средства

переключения процессов предназначены

для быстрого сохранения контекста

приостанавливаемого процесса и

восстановления контекста процесса,

который становится активным. Содержимое

контекста обычно включает содержимое

всех регистров общего назначения

процессора, регистра флагов операций

(то есть флагов нуля, переноса, переполнения

и т. п.), а также тех системных регистров

и указателей, которые связаны с отдельным

процессом, а не операционной системой,

например указателя на таблицу трансляции

адресов процесса. Для хранения контекстов

приостановленных процессов обычно

используются области оперативной

памяти, которые поддерживаются указателями

процессора.

Переключение

контекста выполняется по определенным

командам процессора, например по команде

перехода на новую задачу. Такая команда

вызывает автоматическую загрузку данных

из сохраненного контекста в регистры

процессора, после чего процесс продолжается

с прерванного ранее места.

Система

прерываний позволяет компьютеру

реагировать на внешние события,

синхронизировать выполнение процессов

и работу устройств ввода-вывода, быстро

переходить с одной программы на другую.

Механизм прерываний нужен для того,

чтобы оповестить процессор о возникновении

в вычислительной системе некоторого

непредсказуемого события или события,

которое не синхронизировано с циклом

работы процессора. Примерами таких

событий могут служить завершение

операции ввода-вывода внешним устройством

(например, запись блока данных контроллером

диска), некорректное завершение

арифметической операции (например,

переполнение регистра), истечение

интервала астрономического времени.

При возникновении условий прерывания

его источник (контроллер внешнего

устройства, таймер, арифметический блок

процессора и т. п.) выставляет определенный

электрический сигнал. Этот сигнал

прерывает выполнение процессором

последовательности команд, задаваемой

исполняемым кодом, и вызывает автоматический

переход на заранее определенную

процедуру, называемую процедурой

обработки прерываний. В большинстве

моделей процессоров отрабатываемый

аппаратурой переход на процедуру

обработки прерываний сопровождается

заменой слова состояния машины (или

даже всего контекста процесса), что

позволяет одновременно с переходом по

нужному адресу выполнить переход в

привилегированный режим. После завершения

обработки прерывания обычно происходит

возврат к исполнению прерванного кода.

Прерывания

играют важнейшую роль в работе любой

операционной системы, являясь ее движущей

силой. Действительно, большая часть

действий ОС инициируется прерываниями

различного типа. Даже системные вызовы

от приложений выполняются на многих

аппаратных платформах с помощью

специальной инструкции прерывания,

вызывающей переход к выполнению

соответствующих процедур ядра (например,

инструкция int

в процессорах Intel или SVC в мэйнфреймах

IBM).

Системный

таймер, часто реализуемый в виде

быстродействующего регистра-счетчика,

необходим операционной системе для

выдержки интервалов времени. Для этого

в регистр таймера программно загружается

значение требуемого интервала в условных

единицах, из которого затем автоматически

с определенной частотой начинает

вычитаться по единице. Частота «тиков»

таймера, как правило, тесно связана с

частотой тактового генератора процессора.

(Не следует путать таймер ни с тактовым

генератором, который вырабатывает

сигналы, синхронизирующие все операции

в компьютере, ни с системными часами —

работающей на батареях электронной

схеме, — которые ведут независимый

отсчет времени и календарной даты.) При

достижении нулевого значения счетчика

таймер инициирует прерывание, которое

обрабатывается процедурой операционной

системы. Прерывания от системного

таймера используются ОС в первую очередь

для слежения за тем, как отдельные

процессы расходуют время процессора.

Например, в системе разделения времени

при обработке очередного прерывания

от таймера планировщик процессов может

принудительно передать управление

другому процессу, если данный процесс

исчерпал выделенный ему квант времени.

Средства

защиты областей памяти обеспечивают

на аппаратном уровне проверку возможности

программного кода осуществлять с данными

определенной области памяти такие

операции, как чтение, запись или выполнение

(при передачах управления). Если аппаратура

компьютера поддерживает механизм

трансляции адресов, то средства защиты

областей памяти встраиваются в этот

механизм. Функции аппаратуры по защите

памяти обычно состоят в сравнении

уровней привилегий текущего кода

процессора и сегмента памяти, к которому

производится обращение.

Машинно-зависимые

компоненты ОС

Одна

и та же операционная система не может

без каких-либо изменений устанавливаться

на компьютерах, отличающихся типом

процессора или/и способом организации

всей аппаратуры. В модулях ядра ОС не

могут не отразиться такие особенности

аппаратной платформы, как количество

типов прерываний и формат таблицы ссылок

на процедуры обработки прерываний,

состав регистров общего назначения и

системных регистров, состояние которых

нужно сохранять в контексте процесса,

особенности подключения внешних

устройств и многие другие.

Однако

опыт разработки операционных систем

показывает: ядро можно спроектировать

таким образом, что только часть модулей

будут машинно-зависимыми, а остальные

не будут зависеть от особенностей

аппаратной платформы. В хорошо

структурированном ядре машинно-зависимые

модули локализованы и образуют программный

слой, естественно примыкающий к слою

аппаратуры, как это и показано на рис.

3.8. Такая локализация машинно-зависимых

модулей существенно упрощает перенос

операционной системы на другую аппаратную

платформу.

Объем

машинно-зависимых компонентов ОС зависит

от того, насколько велики отличия в

аппаратных платформах, для которых

разрабатывается ОС. Например, ОС,

построенная на 32-битовых адресах, для

переноса на машину с 16-битовыми адресами

должна быть практически переписана

заново. Одно из наиболее очевидных

отличий — несовпадение системы команд

процессоров — преодолевается достаточно

просто. Операционная система программируется

на языке высокого уровня, а затем

соответствующим компилятором

вырабатывается код для конкретного

типа процессора. Однако во многих случаях

различия в организации аппаратуры

компьютера лежат гораздо глубже и

преодолеть их таким образом не удается.

Например, однопроцессорный и

двухпроцессорный компьютеры требуют

применения в ОС совершенно разных

алгоритмов распределения процессорного

времени. Аналогично отсутствие аппаратной

поддержки виртуальной памяти приводит

к принципиальному различию в реализации

подсистемы управления памятью. В таких

случаях не обойтись без внесения в код

операционной системы специфики аппаратной

платформы, для которой эта ОС

предназначается.

Для

уменьшения количества машинно-зависимых

модулей производители операционных

систем обычно ограничивают универсальность

машинно-независимых модулей. Это

означает, что их независимость носит

условный характер и распространяется

только на несколько типов процессоров

и созданных на основе этих процессоров

аппаратных платформ. По этому пути

пошли, например, разработчики ОС Windows

NT, ограничив количество типов процессоров

для своей системы четырьмя и поставляя

различные варианты кодов ядра для

однопроцессорных и многопроцессорных

компьютеров.

Особое

место среди модулей ядра занимают

низкоуровневые драйверы внешних

устройств. С одной стороны эти драйверы,

как и высокоуровневые драйверы, входят

в состав менеджера ввода-вывода, то есть

принадлежат слою ядра, занимающему

достаточно высокое место в иерархии

слоев. С другой стороны, низкоуровневые

драйверы отражают все особенности

управляемых внешних устройств, поэтому

их можно отнести и к слою машинно-зависимых

модулей. Такая двойственность

низкоуровневых драйверов еще раз

подтверждает схематичность модели ядра

со строгой иерархией слоев.

Для

компьютеров на основе процессоров Intel

x86/Pentium разработка экранирующего

машинно-зависимого слоя ОС несколько

упрощается за счет встроенной в постоянную

память компьютера базовой системы

ввода-вывода — BIOS. BIOS содержит драйверы

для всех устройств, входящих в базовую

конфигурацию компьютера: жестких и

гибких дисков, клавиатуры, дисплея и т.

д. Эти драйверы выполняют весьма

примитивные операции с управляемыми

устройствами, например чтение группы

секторов данных с определенной дорожки

диска, но за счет этих операций экранируются

различия аппаратных платформ персональных

компьютеров и серверов на процессорах

Intel разных производителей. Разработчики

операционной системы могут пользоваться

слоем драйверов BIOS как частью

машинно-зависимого слоя ОС, а могут и

заменить все или часть драйверов BIOS

компонентами ОС.

Переносимость

операционной системы

Если

код операционной системы может быть

сравнительно легко перенесен с процессора

одного типа на процессор другого типа

и с аппаратной платформы одного типа

на аппаратную платформу другого типа,

то такую ОС называют переносимой

(portable), или мобильной.

Хотя

ОС часто описываются либо как переносимые,

либо как непереносимые, мобильность —

это не бинарное состояние, а понятие

степени. Вопрос не в том, может ли быть

система перенесена, а в том, насколько

легко можно это сделать. Для того чтобы

обеспечить свойство мобильности ОС,

разработчики должны следовать следующим

правилам.

-

Большая

часть кода должна быть написана на

языке, трансляторы которого имеются

на всех машинах, куда предполагается

переносить систему. Такими языками

являются стандартизованные языки

высокого уровня. Большинство переносимых

ОС написано на языке С, который имеет

много особенностей, полезных для

разработки кодов операционной системы,

и компиляторы которого широко доступны.

Программа, написанная на ассемблере,

является переносимой только в тех

случаях, когда перенос операционной

системы планируется на компьютер,

обладающий той же системой команд. В

остальных случаях ассемблер используется

только для тех непереносимых частей

системы, которые должны непосредственно

взаимодействовать с аппаратурой

(например, обработчик прерываний), или

для частей, которые требуют максимальной

скорости (например, целочисленная

арифметика повышенной точности). -

Объем

машинно-зависимых частей кода, которые

непосредственно взаимодействуют с

аппаратными средствами, должен быть

по возможности минимизирован. Так,

например, следует всячески избегать

прямого манипулирования регистрами и

другими аппаратными средствами

процессора. Для уменьшения аппаратной

зависимости разработчики ОС должны

также исключить возможность использования

по умолчанию стандартных конфигураций

аппаратуры или их характеристик.

Аппаратно-зависимые параметры можно

«спрятать» в программно- задаваемые

данные абстрактного типа. Для осуществления

всех необходимых действий по управлению

аппаратурой, представленной этими

параметрами, должен быть написан набор

аппаратно-зависимых функций. Каждый

раз, когда какому-либо модулю ОС требуется

выполнить некоторое действие, связанное

с аппаратурой, он манипулирует

абстрактными данными, используя

соответствующую функцию из имеющегося

набора. Когда ОС переносится, то

изменяются только эти данные и функции,

которые ими манипулируют. Например, в

ОС Windows NT диспетчер прерываний преобразует

аппаратные уровни прерываний конкретного

типа процессора в стандартный набор

уровней прерываний IRQL, с которыми

работают остальные модули операционной

системы. Поэтому при переносе Windows NT на

новую платформу нужно переписать, в

частности, те коды диспетчера прерываний,

которые занимаются отображением уровней

прерывания на абстрактные уровни IRQL,

а те модули ОС, которые пользуются этими

абстрактными уровнями, изменений не

потребуют. -

Аппаратно-зависимый

код должен быть надежно изолирован в

нескольких модулях, а не быть распределен

по всей системе. Изоляции подлежат все

части ОС, которые отражают специфику

как процессора, так и аппаратной

платформы в целом. Низкоуровневые

компоненты ОС, имеющие доступ к

процессорно — зависимым структурам

данных и регистрам, должны быть оформлены

в виде компактных модулей, которые

могут быть заменены аналогичными

модулями для других процессоров. Для

снятия платформенной зависимости,

возникающей из-за различий между

компьютерами разных производителей,

построенными на одном и том же процессоре

(например, MIPS R4000), должен быть введен

хорошо локализованный программный

слой машинно-зависимых функций.

В

идеале слой машинно-зависимых компонентов

ядра полностью экранирует остальную

часть ОС от конкретных деталей аппаратной

платформы (кэши, контроллеры прерываний

ввода-вывода и т. п.), по крайней мере для

того набора платформ, который поддерживает

данная ОС. В результате происходит

подмена реальной аппаратуры некой

унифицированной виртуальной машиной,

одинаковой для всех вариантов аппаратной

платформы. Все слои операционной системы,

которые лежат выше слоя машинно-зависимых

компонентов, могут быть написаны для

управления именно этой виртуальной

аппаратурой. Таким образом, у разработчиков

появляется возможность создавать один

вариант машинно-независимой части ОС

(включая компоненты ядра, утилиты,

системные обрабатывающие программы)

для всего набора поддерживаемых платформ

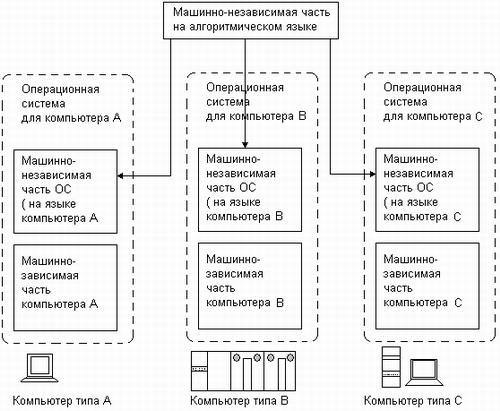

(рис. 3.9).

Рис.

3.9. Перенос

операционной системы на разные аппаратные

платформы

Микроядерная

архитектура

Концепция

Микроядерная

архитектура является альтернативой

классическому способу построения

операционной системы. Под классической

архитектурой в данном случае понимается

рассмотренная выше структурная

организация ОС, в соответствии с которой

все основные функции операционной

системы, составляющие многослойное

ядро, выполняются в привилегированном

режиме. При этом некоторые вспомогательные

функции ОС оформляются в виде приложений

и выполняются в пользовательском режиме

наряду с обычными пользовательскими

программами (становясь системными

утилитами или обрабатывающими

программами). Каждое приложение

пользовательского режима работает в

собственном адресном пространстве и

защищено тем самым от какого-либо

вмешательства других приложений. Код

ядра, выполняемый в привилегированном

режиме, имеет доступ к областям памяти

всех приложений, но сам полностью от

них защищен. Приложения обращаются к

ядру с запросами на выполнение системных

функций.

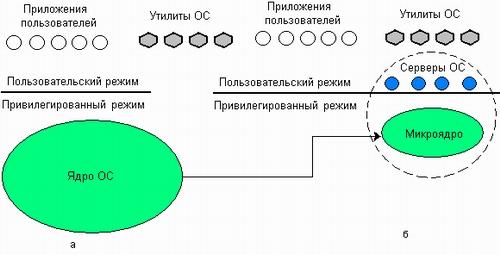

Суть

микроядерной архитектуры состоит в

следующем. В привилегированном режиме

остается работать только очень небольшая

часть ОС, называемая микроядром (рис.

3.10). Микроядро защищено от остальных

частей ОС и приложений. В состав микроядра

обычно входят машинно-зависимые модули,

а также модули, выполняющие базовые (но

не все!) функции ядра по управлению

процессами, обработке прерываний,

управлению виртуальной памятью, пересылке

сообщений и управлению устройствами

ввода-вывода, связанные с загрузкой или

чтением регистров устройств. Набор

функций микроядра обычно соответствует

функциям слоя базовых механизмов

обычного ядра. Такие функции операционной

системы трудно, если не невозможно,

выполнить в пространстве пользователя.

Рис.

3.10. Перенос

основного объема функций ядра в

пользовательское пространство

Все

остальные более высокоуровневые функции

ядра оформляются в виде приложений,

работающих в пользовательском режиме.

Однозначного решения о том, какие из

системных функций нужно оставить в

привилегированном режиме, а какие

перенести в пользовательский, не

существует. В общем случае многие

менеджеры ресурсов, являющиеся

неотъемлемыми частями обычного ядра —

файловая система, подсистемы управления

виртуальной памятью и процессами,

менеджер безопасности и т. п., — становятся

«периферийными» модулями, работающими

в пользовательском режиме.

Работающие

в пользовательском режиме менеджеры

ресурсов имеют принципиальные отличия

от традиционных утилит и обрабатывающих

программ операционной системы, хотя

при микроядерной архитектуре все эти

программные компоненты также оформлены

в виде приложений. Утилиты и обрабатывающие

программы вызываются в основном

пользователями. Ситуации, когда одному

приложению требуется выполнение функции

(процедуры) другого приложения, возникают

крайне редко. Поэтому в операционных

системах с классической архитектурой

отсутствует механизм, с помощью которого

одно приложение могло бы вызвать функции

другого.

Совсем

другая ситуация возникает, когда в форме

приложения оформляется часть операционной

системы. По определению, основным

назначением такого приложения является

обслуживание запросов других приложений,

например создание процесса, выделение

памяти, проверка прав доступа к ресурсу

и т. д. Именно поэтому менеджеры ресурсов,

вынесенные в пользовательский режим,

называются серверами ОС, то есть модулями,

основным назначением которых является

обслуживание запросов локальных

приложений и других модулей ОС. Очевидно,

что для реализации микроядерной

архитектуры необходимым условием

является наличие в операционной системе

удобного и эффективного способа вызова

процедур одного процесса из другого.

Поддержка такого механизма и является

одной из главных задач микроядра.

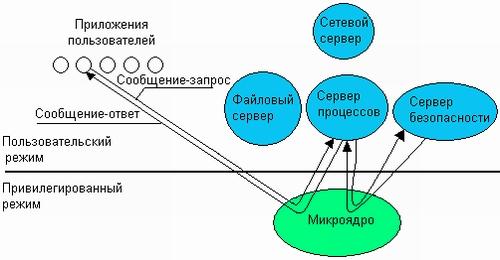

Схематично

механизм обращения к функциям ОС,

оформленным в виде серверов, выглядит

следующим образом (рис. 3.11). Клиент,

которым может быть либо прикладная

программа, либо другой компонент ОС,

запрашивает выполнение некоторой

функции у соответствующего сервера,

посылая ему сообщение. Непосредственная

передача сообщений между приложениями

невозможна, так как их адресные

пространства изолированы друг от друга.

Микроядро, выполняющееся в привилегированном

режиме, имеет доступ к адресным

пространствам каждого из этих приложений

и поэтому может работать в качестве

посредника. Микроядро сначала передает

сообщение, содержащее имя и параметры

вызываемой процедуры нужному серверу,

затем сервер выполняет запрошенную

операцию, после чего ядро возвращает

результаты клиенту с помощью другого

сообщения. Таким образом, работа

микроядерной операционной системы

соответствует известной модели

клиент-сервер, в которой роль транспортных

средств выполняет микроядро.

Рис.

3.11.

Реализация системного вызова в

микроядерной архитектуре

Преимущества

и недостатки микроядерной архитектуры

Операционные

системы, основанные на концепции

микроядра, в высокой степени удовлетворяют

большинству требований, предъявляемых

к современным ОС, обладая переносимостью,

расширяемостью, надежностью и создавая

хорошие предпосылки для поддержки

распределенных приложений. За эти

достоинства приходится платить снижением

производительности, и это является

основным недостатком микроядерной

архитектуры.

Высокая

степень переносимости обусловлена тем,

что весь машинно-зависимый код изолирован

в микроядре, поэтому для переноса системы

на новый процессор требуется меньше

изменений и все они логически сгруппированы

вместе.

Расширяемость

присуща микроядерной ОС в очень высокой

степени. В традиционных системах даже

при наличии многослойной структуры

нелегко удалить один слой и поменять

его на другой по причине множественности

и размытости интерфейсов между слоями.

Добавление новых функций и изменение

существующих требует хорошего знания

операционной системы и больших затрат

времени. В то же время ограниченный

набор четко определенных интерфейсов

микроядра открывает путь к упорядоченному

росту и эволюции ОС. Добавление новой

подсистемы требует разработки нового

приложения, что никак не затрагивает

целостность микроядра. Микроядерная

структура позволяет не только добавлять,

но и сокращать число компонентов

операционной системы, что также бывает

очень полезно. Например, не всем

пользователям нужны средства безопасности

или поддержки распределенных вычислений,

а удаление их из традиционного ядра

чаще всего невозможно. Обычно традиционные

операционные системы позволяют

динамически добавлять в ядро или удалять

из ядра только драйверы внешних устройств

— ввиду частых изменений в конфигурации

подключенных к компьютеру внешних

устройств подсистема ввода-вывода ядра

допускает загрузку и выгрузку драйверов

«на ходу», но для этого она разрабатывается

особым образом (например, среда STREAMS в

UNIX или менеджер ввода-вывода в Windows NT).

При микроядерном подходе конфигурируемость

ОС не вызывает никаких проблем и не

требует особых мер — достаточно изменить

файл с настройками начальной конфигурации

системы или же остановить не нужные

больше серверы в ходе работы обычными

для остановки приложений средствами.

Использование

микроядерной модели повышает надежность

ОС. Каждый сервер выполняется в виде

отдельного процесса в своей собственной

области памяти и таким образом защищен

от других серверов операционной системы,

что не наблюдается в традиционной ОС,

где все модули ядра могут влиять друг

на друга. И если отдельный сервер терпит

крах, то он может быть перезапущен без

останова или повреждения остальных

серверов ОС. Более того, поскольку

серверы выполняются в пользовательском

режиме, они не имеют непосредственного

доступа к аппаратуре и не могут

модифицировать память, в которой хранится

и работает микроядро. Другим потенциальным

источником повышения надежности ОС

является уменьшенный объем кода микроядра

по сравнению с традиционным ядром —

это снижает вероятность появления

ошибок программирования.

Модель

с микроядром хорошо подходит для

поддержки распределенных вычислений,

так как использует механизмы, аналогичные

сетевым: взаимодействие клиентов и

серверов путем обмена сообщениями.

Серверы микроядерной ОС могут работать

как на одном, так и на разных компьютерах.

В этом случае при получении сообщения

от приложения микроядро может обработать

его самостоятельно и передать локальному

серверу или же переслать по сети

микроядру, работающему на другом

компьютере. Переход к распределенной

обработке требует минимальных изменений

в работе операционной системы — просто

локальный транспорт заменяется на

сетевой.

Производительность.

При классической организации ОС (рис.

3.12, а) выполнение системного вызова

сопровождается двумя переключениями

режимов, а при микроядерной организации

(рис. 3.12, 6) — четырьмя. Таким образом,

операционная система на основе микроядра

при прочих равных условиях всегда будет

менее производительной, чем ОС с

классическим ядром. Именно по этой

причине микроядерный подход не получил

такого широкого распространения, которое

ему предрекали.

Рис.

3.12.

Смена режимов при выполнении системного

вызова

Серьезность

этого недостатка хорошо иллюстрирует

история развития Windows NT. В версиях 3.1 и

3.5 диспетчер окон, графическая библиотека

и высокоуровневые драйверы графических

устройств входили в состав сервера

пользовательского режима, и вызов

функций этих модулей осуществлялся в

соответствии с микроядерной схемой.

Однако очень скоро разработчики Windows

NT поняли, что такой механизм обращений

к часто используемым функциям графического

интерфейса существенно замедляет работу

приложений и делает данную операционную

систему уязвимой в условиях острой

конкуренции. В результате в версию

Windows NT 4.0 были внесены существенные

изменения — все перечисленные выше

модули были перенесены в ядро, что

отдалило эту ОС от идеальной микроядерной

архитектуры, но зато резко повысило ее

производительность.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

Ошибка на странице данных ядра — это код ошибки Windows, отображаемый на синем экране . При возникновении этой ошибки ваш компьютер обычно собирает некоторые диагностические данные и затем перезагружается. Если проблема не исчезнет, ваш компьютер в конечном итоге снова выйдет из строя с тем же сообщением об ошибке на странице данных ядра.

Ошибки ввода данных ядра обычно связаны с аппаратными сбоями, связанными с модулями памяти и жесткими дисками . В других случаях эта же ошибка появится из-за воздействия вируса.

Как появляется ошибка ввода данных ядра

Когда возникает эта ошибка, вы обычно видите сообщение, подобное одному из следующих:

Ваш компьютер столкнулся с проблемой и нуждается в перезагрузке. Мы просто собираем информацию об ошибке и перезапустим для вас. Если вы хотите узнать больше, вы можете найти эту ошибку позже в Интернете: KERNEL_DATA_INPAGE_ERROR

KERNEL_DATA_INPAGE_ERROR

Причины ошибок ввода данных ядра

Ошибка на странице данных ядра — это код остановки, отображаемый во время сбоев синего экрана, который обычно вызывается проблемой с оперативной памятью (RAM) или жестким диском.

Вот некоторые дополнительные коды, связанные с этой ошибкой, и конкретные проблемы, к которым они относятся:

- 0x0000007A : Ошибки доступа к файлу

- 0xC000009C : плохие сектора жесткого диска

- 0xC000009D : Слабые кабели или сбой жесткого диска

- 0xC000016A : плохие сектора жесткого диска

- 0xC0000185 : Нерассеянные или поврежденные кабели

Как исправить ошибку ввода данных ядра

Поскольку большинство ошибок на входе данных ядра вызваны неисправными модулями памяти или жесткими дисками, исправление обычно включает в себя поиск неисправного компонента и его замену.

В других случаях вы обнаружите, что модуль памяти или жесткий диск не подключен должным образом, или вся проблема была вызвана вирусом. Выполните следующие действия по устранению неполадок, чтобы исправить ошибку на странице данных Kernal:

Сделайте резервную копию ваших данных . Если это проблема с вашим жестким диском, вы можете потерять важные данные. Если у вас есть что-то, хранящееся на вашем компьютере, которое вы не хотите потерять, вы должны выполнить резервное копирование перед началом процесса диагностики. Сделайте копии любых файлов, которые вы не можете себе позволить потерять, и сохраните их на USB-накопителе , SD-карте или в облачном хранилище

-

В некоторых случаях проблема может быть вызвана неправильно установленными модулями памяти. Чтобы исключить это и предотвратить любые ненужные расходы, откройте компьютер и проверьте свою оперативную память. Если какой-либо из модулей не установлен должным образом или вышел из строя, переустановите их и проверьте, по-прежнему ли возникает ошибка на странице данных ядра.

Соблюдайте осторожность при открытии компьютера и настройке компонентов. Без правильно настроенного антистатического браслета статическое электричество может привести к повреждению таких компонентов, как ОЗУ.

-

Эта ошибка обычно указывает, что диск имеет физические дефекты, такие как поврежденные сектора . В некоторых случаях вы можете столкнуться с этой проблемой из-за неправильно уложенного кабеля жесткого диска.

Чтобы исключить эту возможность, откройте компьютер, найдите жесткий диск и снова подключите соединительный кабель. Вам также необходимо проверить и повторно подключить кабель, к которому он подключается к материнской плате .

Когда ваш жесткий диск работает, внимательно слушайте любые громкие щелчки. Если вы слышите их, возможно, ваш жесткий диск находится в процессе сбоя, что может вызвать этот тип ошибки. Исправление заключается в резервном копировании всех ваших данных и замене жесткого диска .

-

Проверь свою память.

Windows 10 имеет встроенный инструмент диагностики памяти. Есть также некоторые бесплатные опции, доступные для Windows 7, Windows 8 и Windows 10. Если у вас Windows 10, введите « память » в поле поиска на панели задач, затем выберите « Диагностика памяти Windows» > « Перезагрузить сейчас» и проверьте наличие проблем .

Возможно, вы захотите запустить более одного инструмента диагностики памяти. Если какой-либо из этих инструментов сообщит о проблеме с вашей памятью, подумайте о замене вашей оперативной памяти . Это, вероятно, исправит ошибку на странице данных вашего ядра, но в любом случае ваша RAM может выйти из строя в любом случае, если один из этих инструментов обнаружит проблему.

-